1.本发明涉及医学领域,尤其涉及医学图像目标区域的识别方法、神经网络模型及应用。

背景技术:

2.目前,对于图像处理尤其是对mri图像进行识别,多采用图像的分割的技术。如专利申请201911243400.4公开的一种磁共振图像分割方法、装置、终端设备及存储介质,又如专利申请202011164826.3公开的一种采用跨序列核磁共振图像生成改进胶质瘤分割方法。

3.然而,传统的分割网络模型存在目标区域分割不精准,易受周围目标的干扰,以及推理速度较慢的情况的缺陷。同时,也存在需要消耗显存大而难以进行网络模型的训练,且训练的迭代周期较长,超参数较多,导致调整困难。此外,随着网络模型其网络深度的加深,会导致其对较小的目标识别的敏感度发生下降。

技术实现要素:

4.本发明所要解决的技术问题在于如何提供一种优化网络模型的非线性表达能力、减少网络模型的参数量、提高网络模型的计算速度、提升网络模型的精确度和鲁棒性以及对不同大小的目标均具有很好的敏感度,能精准识别目标的医学图像目标区域的识别方法、神经网络模型及应用。

5.本发明主要通过以下技术手段解决上述技术问题的:一种医学图像目标区域的识别方法,包括以下步骤:

6.步骤一、读取当前dicom文件的信息,若所述信息包括目标关键词,则对所述dicom文件进行处理,得到待识别的图像;

7.步骤二、将所述待识别的图像输入至基于残差结构的神经网络模型中,能通过不同的检测头输出,分别得到具有不同感受野的目标图像;

8.所述基于残差结构的神经网络模型包括骨干网络结构、spp层、检测头;

9.每一个骨干网络结构均包括有残差结构,所述残差结构包括以1

×

1conv层在先处理、3

×

3的conv层在后处理的方式形成的基本单位;同一个残差结构中的基本单位至少为一个;

10.多个骨干网络结构按照处理图像的顺序依次配合;每一个骨干网络结构的输出端均与一个对应的检测头的输入端相配合;在最后处理图像的骨干网络结构与同其对应的检测头之间设置有所述spp层。

11.优选地:在所述步骤一中,所述信息包括mri图像权重信息,目标关键词为t2;

12.步骤一的具体为:使用开源工具pydicom依次读取每个dicom文件的序列信息,并判断序列信息中是否包含关键词t2,如果当前的dicom文件包含关键词t2,则确定所述dicom文件为目标文件,则使用pydicom第三方库读取dicom文件中的矩阵信息,并将矩阵信息另存为jpg格式的图像,如果当前的dicom文件不包含关键词t2,则识别下一件dicom文

件。

13.优选地:还包括以下步骤:

14.数据的预处理,用以将dicom的数据大小统一调整为412

×

412以及对图像的像素值进行归一化处理。

15.优选地:所述骨干网络结构包括浅层骨干网络结构、中层骨干网络结构、深层骨干网络结构;所述检测头包括第一检测头、第二检测头、第三检测头;

16.每一个骨干网络结构均包括有残差结构,所述残差结构包括以1

×

1conv层在先处理、3

×

3的conv层在后处理的方式形成的基本单位;同一个残差结构中的基本单位至少为一个;当待识别的图像经所述浅层骨干网络结构处理后输入至第一检测头,能输出得到具有第一感受野的目标图像;当待识别的图像依次经所述经浅层骨干网络结构、中层骨干网络结构处理后输入至第二检测头,能输出得到具有第二感受野的目标图像;当待识别的图像依次经浅层骨干网络结构、中层骨干网络结构、深层骨干网络结构、spp层处理后,输入至第三检测头,能输出得到具有第三感受野的目标图像。

17.优选地:在所述浅层骨干网络结构中,按照对图像处理的顺序依次包括第一残差结构、第二残差结构、第三残差结构;所述第一残差结构包括一个基本单位;所述第二残差结构包括两个贯序配合的基本单位;所述第三残差结构包括八个贯序配合的基本单位;所述中层骨干网络结构包括第四残差结构,所述第四残差结构包括八个贯序配合的基本单位;所述深层骨干网络结构包括第五残差结构,所述第五残差结构包括四个贯序配合的基本单位。

18.优选地:在每一个残差结构中,1

×

1conv层的通道数均小于3

×

3conv层的通道数。

19.优选地:所述浅层骨干网络结构按照对图像的处理顺序依次包括两个3

×

3的conv层、一个第一残差结构、一个3

×

3的conv层、一个第二残差结构、一个3

×

3的conv层、一个第三残差结构;所述中层骨干网络结构按照对图像的处理顺序依次包括一个3

×

3的conv层、一个第四残差结构;所述深层骨干网络结构按照对图像的处理顺序依次包括一个3

×

3的conv层、一个第五残差结构。

20.优选地:所述spp层包括并列设置的5

×

5的max pooling层、9

×

9的max pooling层和13

×

13的max pooling层;待识别的图像经过深层骨干网络结构处理后,分别输入至5

×

5的max pooling层、9

×

9的max pooling层、13

×

13的max pooling层中进行压缩后,再进行融合输出。

21.优选地:在每一个骨干网络结构与同其配合的检测头之间还设置有convolution set;其中,与最后处理图像的骨干网络结构配合的convolution set位于所述spp层与对应的检测头之间;所述convolution set包括1

×

1conv层和3

×

3conv层交替堆叠的结构,并保证1

×

1conv层位于结尾。

22.优选地:在最后每一个conv层都包括一层conv2d层和一层batch normalization层。

23.优选地:所述基于残差结构的神经网络模型(以下简称网络模型)在对待识别的图像进行处理之前还进行所述网络模型的训练,包括以下步骤:将训练集中的图像输入到所述网络模型中,对所述网络模型进行训练,当所述网络模型的参数使得损失函数收敛时,完成所述网络模型的训练。

24.优选地:对于训练集中的图像,在输入至所述网络模型之前,还进行了数据增强处理,所述数据增强处理包括随机对比度的调整、随机角度的旋转、mosaic增强方法的至少一种。

25.优选地:所述网络模型的训练采用的优化器为adam优化器,损失函数为focal loss损失函数;

26.focal loss损失函数的表达式:

[0027][0028]

其中表达式(1)中的p表示置信度,α=0.25,γ=2;若y=0,表示负样本,y=1表示正样本。

[0029]

本发明还公开一种基于残差结构的神经网络模型,包括浅层骨干网络结构、中层骨干网络结构、深层骨干网络结构、spp层、第一检测头、第二检测头、第三检测头;

[0030]

每一个骨干网络结构均包括有残差结构,所述残差结构包括以1

×

1conv层在先处理、3

×

3的conv层在后处理的方式形成的基本单位;同一个残差结构中的基本单位至少为一个;当待识别的图像经所述浅层骨干网络结构处理后输入至第一检测头,能输出得到具有第一感受野的目标图像;当待识别的图像依次经所述经浅层骨干网络结构、中层骨干网络结构处理后输入至第二检测头,能输出得到具有第二感受野的目标图像;当待识别的图像依次经浅层骨干网络结构、中层骨干网络结构、深层骨干网络结构、spp层处理后,输入至第三检测头,能输出得到具有第三感受野的目标图像;其中,第一感受野、第二感受野、第三感受野均不相同。

[0031]

本发明还公开一种使用上述的基于残差结构的神经网络在对非医学图像中感兴趣区域进行识别的应用。

[0032]

本发明的优点在于:本发明通过大幅度减少输出项的信息量,从而提高本发明的网络模型的计算速度,同时为了尽可能的提高本发明的网络模型的鲁棒性,本发明的网络模型存在多个不同大小的检测头,从而使其能够对大目标和小目标的敏感程度。本发明的网络模型的结构的基本单元包括一层卷积核大小为3

×

3的conv层和一层卷积核大小为1

×

1的conv层交替组合而成的残差结构组成,能够大幅度的提升网络模型的精确度,保证本发明的网络模型在拥有一定深度的情况下不会出现网络模型退化的情况。

[0033]

进一步,采用本发明的残差结构,将图像信息的特征矩阵经过两次conv层的运算后,将结果与原特征矩阵进行一次叠加操作。传统的残差结构其基本单位的两个conv层都使用conv层大小为3

×

3conv的方式,而本发明的残差结构包括以一层conv核大小为1

×

1的conv层和一层conv核大小为3

×

3的conv层为一个基本单元,且每一conv层都包括一层2维conv(conv2d)层即图4中的2d convolutional layer和一层batch normalizationlayer,并通过relu layer的relu激活函数进行处理,通过使用1

×

1的conv层先进行降维,再通过一层3

×

3conv层进行升维,相比于传统的两层都为3

×

3conv的残差结构设计,本发明网络的权值将得到充分的激活,满足更深层次的网络模型的建立。通过建立更深的网络模型,能够大大的提升本发明的网络模型的性能,使其提取到更深层次的数据的细节特征,使目标类别的判断和目标位置的定位变得更加精准。本发明的网络模型将会使参数量减小将近80%以上。

[0034]

进一步,在本发明中,每一残差结构中的1

×

1conv层的通道数要小于3

×

3的conv层的通道数,通过先在1

×

1卷积进行降维再通过3

×

3卷积进行升维的操作,从而能够减少参数量。

[0035]

进一步,本发明使用的spp结构,包括大小为5

×

5、9

×

9和13

×

13的max pooling层,使最后的准确率提高了3.8%。与常规结构的spp结构采用大小为6

×

6,3

×

3和2

×

2的max pooling层相比,本发明的实验结果拥有更强的鲁棒性。若采用常规结构的spp结构,则对最后的结果提升只有2.1%的提升。

[0036]

进一步,每一个检测头之前都会设置一个包括1

×

1conv层和3

×

3conv层交替堆叠组合而成的convolution set(即卷积输出端)进行降维并提高本发明的网络模型的非线性拟合能力。

[0037]

进一步,本发明的三个检测头分别从较浅的26层,中间的43层和较深的52层进行输出,从而能够获得大小不同的感受野,其作用为,浅层网络由于感受野较小,从而适合预测较小的目标;而深层网络由于感受野较大,因此适合预测较大的目标。从而解决了传统目标检测算法对于小目标的检测非常不敏感的痛点。本发明通过不同尺度检测头的建立,本发明的网络模型对于不同大小的目标的敏感程度将会大大提高。

附图说明

[0038]

图1为本发明中四种权重mri图像对比图。

[0039]

图2为本发明中残差结构的基本单元的结构示意图;

[0040]

图3为本发明中spp结构示意图

[0041]

图4为本发明中卷积层的结构示意图;

[0042]

图5为本发明中基于残差结构的神经网络模型的结构示意图;

[0043]

图6为本发明图5中包含

×

2标记的虚线框图中的残差结构的具体结构示意图;

[0044]

图7为本发明中convolution set的结构示意图;

[0045]

图8为本发明中目标图像的示意图;

[0046]

图9为本发明中未经本发明的网络模型处理的待识别的图像的示意图;

[0047]

图10为本发明中图9的待识别的图像经本发明的网络模型输出的目标图像的示意图;

[0048]

图11为本发明中拼接后图像的示意图;

[0049]

图12为本发明的网络模型应用在人体动作识别时输出的目标图像的示意图。

具体实施方式

[0050]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0051]

实施例1

[0052]

本实施例公开一种图像目标区域的识别方法,其中,本实施例的图像以mri图像为例进行介绍,本实施例识别的目标区域以mri图像中的脑肿瘤为例进行介绍。dicom文件中

包括mri图像权重信息,目标关键词为t2;

[0053]

包括以下步骤:

[0054]

步骤一、遍历所有的dicom文件,使用开源工具pydicom读取每个dicom文件的序列信息,并判断序列信息中是否包含关键词t2,如果包含关键词t2,则确定所述dicom文件为目标文件,并使用pydicom第三方库读取所述dicom文件中的矩阵信息,并将矩阵信息另存为jpg格式的图像。

[0055]

医院中核磁共振仪拍摄的图片的格式皆为dicom格式。所谓dicom格式(digital imaging and communications in medicine),即医学数字成像和通信,是医学图像和相关信息的国际标准(iso 12052)。它定义了质量能满足临床需要的可用于数据交换的医学图像格式。dicom格式文件并不只是包括了患者的mri图像信息,除了包括患者的姓名、年龄等患者的基本信息,还包括了mri图像的权重等图像的基本信息。

[0056]

由于dicom文件并不能够直接作为图像文件送入模型进行识别,因此需要使用格式转换模块进行格式上的转换。

[0057]

如图1所示,mri图像都是由很多断层组成的,而每一断层的图像都会分为四种不同的权重,分别为flair,t1权重,t1ce(即图1中的t1c)权重和t2权重。

[0058]

每一断层的mri图像权重信息都会保存在dicom文件里面,t2权重的脑肿瘤信号为高信号,较为容易分辨出肿瘤的位置,为了减少系统的工作量并节省工作时间,只需要找到每一断层的t2权重的dicom图像,并将其转换为jpg格式的图像文件即可,得到待识别的图像。其方式为通过读取该dicom文件中的权重信息,并通过判断其是否为t2权重,若是则保留并转换格式,若不是则不转换格式。

[0059]

步骤二、将所述待识别的图像输入至基于残差结构的神经网络模型中处理,并能通过不同的检测头输出,分别得到具有不同感受野的目标图像;

[0060]

本实施例的基于残差结构的神经网络模型包括浅层骨干网络结构、中层骨干网络结构、深层骨干网络结构、spp层、第一检测头(detection head 1)、第二检测头(detection head2)、第三检测头(detection head 3);

[0061]

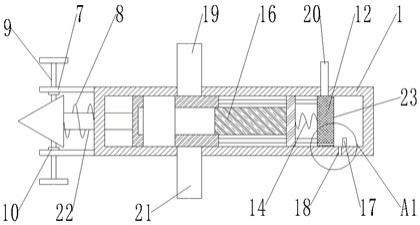

如图2所示,每一个骨干网络结构均包括有残差结构,所述残差结构包括以1

×

1conv层在先处理、3

×

3的conv层(conv层即convolutional layer或卷积层)在后处理的方式形成的基本单位;同一个残差结构中的基本单位至少为一个;图2中的

×

1表示一个基本单元。

[0062]

对于深度学习算法而言,往往使用拥有更深层数的网络,能够获得更好的结果。其原因为,更深层的网络能够提取到图像中的更深层次的细节。但是如果使用一般的线性结构的卷积神经网络,很容易出现网络退化的情况,即有个别几层的权值由于得不到激活而为0。

[0063]

采用本发明的残差结构,将feature map即图像信息的特征矩阵经过两次conv层的运算后,将结果与原特征矩阵进行一次叠加操作。传统的残差结构其基本单位的两个conv层都使用conv层大小为3

×

3conv的方式,而本发明的残差结构包括以一层conv核大小为1

×

1的conv层和一层conv核大小为3

×

3的conv层为一个基本单元,且每一conv层都包括一层2维conv(conv2d)层即图4中的2d convolutional layer和一层batch normalizationlayer,并通过relu layer的relu激活函数进行处理,通过使用1

×

1的conv

层先进行降维,再通过一层3

×

3conv层进行升维,相比于传统的两层都为3

×

3conv的残差结构设计,本发明网络的权值将得到充分的激活,满足更深层次的网络模型的建立。通过建立更深的网络模型,能够大大的提升本发明的网络模型的性能,使其提取到更深层次的数据的细节特征,使目标类别的判断和目标位置的定位变得更加精准。本发明的网络模型将会使参数量减小将近80%以上。

[0064]

进一步,在每一个残差结构中,1

×

1conv层的通道数均小于3

×

3conv层的通道数。

[0065]

在本发明中,每一残差结构中的1

×

1conv层的通道数要小于3

×

3的conv层的通道数,通过先在1

×

1卷积进行降维再通过3

×

3卷积进行升维的操作,从而能够减少参数量。若上一层的卷积核大小为3

×

3,通道数为c1,当前层的通道数为c2,则其计算量为3

×3×

c1×

c2。若采取先用1

×

1卷积进行降维到通道数为c3,再用3

×

3进行升维到通道数为c2的操作,其计算量为1

×1×

c1×

c3 3

×3×

c3×

c2=c3×

(c1 9c2)。

[0066]

因此,若设定上一层的通道数c1为192,当前层通道数c2为128,则其计算量应为3

×3×

192

×

128=221184,若先用1

×

1一层卷积进行降维到通道数c3为96,再升维至128,则其计算量应为96

×

(192 9

×

128)=129024,其计算量可以看出来减少了将近一倍,且由于增加了一层conv层的缘故,可以进一步增加本发明的网络模型的非线性拟合能力。因此,使用1

×

1卷积先降维再升维的操作,不仅使本发明的网络模型的大小得到了压缩,推理速度得到了提升,同时还提高了本发明的网络模型的性能。

[0067]

在本发明中,当待识别的图像经所述浅层骨干网络结构处理后输入至第一检测头,能输出得到具有第一感受野的目标图像;当待识别的图像依次经所述经浅层骨干网络结构、中层骨干网络结构处理后输入至第二检测头,能输出得到具有第二感受野的目标图像;当待识别的图像依次经浅层骨干网络结构、中层骨干网络结构、深层骨干网络结构、spp层处理后,输入至第三检测头,能输出得到具有第三感受野的目标图像;

[0068]

如图3所示,所述spp层包括并列设置的5

×

5的maxpooling层、9

×

9的max pooling层和13

×

13的max pooling层;待识别的图像经过深层骨干网络结构处理后,分别输入至5

×

5的max pooling层、9

×

9的max pooling层、13

×

13的max pooling层中进行压缩后,再进行融合输出。此处的融合,是指将上述的三层max pooling层输出的特征矩阵在channel维度上进行拼接。如此时输入spp结构的特征矩阵大小为16

×

16

×

512,则最终拼接后的大小为16

×

16

×

1536。

[0069]

为了进一步增加网络模型的非线性拟合能力,同时提高网络模型对于严重空间性失真的数据的鲁棒性,本发明在骨干网络的末端加入了spp层,即spatial pyramid pooling层。由于本发明面向mri图像,其特点为在进行形状上的变化之后,极易出现空间上的失真,因此需要使用spp结构进行网络模型算法上的优化。

[0070]

本发明使用的spp结构,包括大小为5

×

5、9

×

9和13

×

13的max pooling层,使最后的准确率提高了3.8%。与常规结构的spp结构采用大小为6

×

6,3

×

3和2

×

2的max pooling层相比,本发明的实验结果拥有更强的鲁棒性。若采用常规结构的spp结构,则对最后的结果提升只有2.1%的提升。

[0071]

如图5所示,本发明的浅层骨干网络结构按照对图像由先至后的处理顺序依次包括两个3

×

3的conv层、一个第一残差结构、一个3

×

3的conv层、一个第二残差结构、一个3

×

3的conv层、一个第三残差结构;所述第一残差结构包括一个基本单位;在所述第二残差结

构包括两个贯序配合的基本单位;所述第三残差结构包括八个贯序配合的基本单位;

[0072]

所述中层骨干网络结构按照对图像由先至后的处理顺序依次包括一个3

×

3的conv层、一个第四残差结构;所述第四残差结构包括八个贯序配合的基本单位;

[0073]

所述深层骨干网络结构按照对图像由先至后的处理顺序依次包括一个3

×

3的conv层、一个第五残差结构;所述第五残差结构包括四个贯序配合的基本单位。

[0074]

当残差结构包括多个贯序配合的基本单位时,如两个贯序配合的基本单位时,为1

×

1的conv层和3

×

3的conv层为一个基本单元经过一次循环堆叠而成;四个贯序配合的基本单位时,为1

×

1的conv层和3

×

3的conv层为一个基本单元经过三次循环堆叠而成;八个贯序配合的基本单位时,为1

×

1的conv层和3

×

3的conv层为一个基本单元经过七次循环堆叠而成。图5中虚线框内的数字即表示有几个相同结构的残差结构进行堆叠。随着网络模型的层数逐渐增多,为了能够使网络模型学习到图像的细节特征,其每一层的通道数将会增加,并且将会有更多个相同结构的残差结构进行堆叠。

[0075]

图5中的

×

1表示该残差结构只有一个基本单元、

×

4表示该残差结构有四个基本单元、

×

8表示该残差结构有八个基本单元;图5中未标识步长的convolutional其卷积步长均为1;图5中虚线框中的residual表示该虚线框中的结构为残差结构。

[0076]

图6表示图5中包含

×

2标记的虚线框内的残差结构的具体结构,即该残差结构包括两个贯序配合的基本单位,图5中其他包括多个贯序配合的基本单位的残差结构的具体结构参照图6公开的具体结构的方式。

[0077]

进一步,在使用spp进行空间失真的矫正之后,即为本发明的基于残差结构的神经网络模型(简称网络模型)的输出端。本发明的网络模型包括三个不同大小的输出端作为检测头,分别为第一检测头、第二检测头、第三检测头。

[0078]

进一步,每一个检测头之前都会设置一个包括1

×

1conv层和3

×

3conv层堆叠组合而成的convolution set(即卷积输出端)进行降维并提高网络模型的非线性拟合能力。其中,与最后处理图像的骨干网络结构(即深层骨干网络结构)配合的convolution set位于所述spp层与对应的检测头(第三检测头)之间,即所述spp层与所述第三检测头之间设置有convolution set;

[0079]

convolution set的结构如图7所示,即由1

×

1conv层和3

×

3conv层交替组合两次,并由1

×

1conv层结尾。

[0080]

如图5所示,进一步,在convolution set之后还依次包括3

×

3conv层、1

×

1conv层,检测头即为所述convolution set之后的1

×

1conv层。

[0081]

如图5所示,三个检测头分别从较浅的26层,中间的43层和较深的52层进行输出,从而能够获得大小不同的感受野,其作用为,浅层网络由于感受野较小,从而适合预测较小的目标;而深层网络由于感受野较大,因此适合预测较大的目标。从而解决了传统目标检测算法对于小目标的检测非常不敏感的痛点。本发明通过不同尺度检测头的建立,网络模型对于不同大小的目标的敏感程度将会大大提高。

[0082]

反之,若网络模型只使用一个检测头去输出目标的位置信息,则往往会出现小目标(在图像中占比较小的区域的目标)的信息无法被检测出来的情况。若使用多检测头,较浅的检测头拥有较小的感受野的情形,该情况下对小目标较为敏感,可有效的检测出小目标。较深的检测头拥有较大的感受野的情形,该情形下对大目标(在图像中占比较大的区域

的目标)较为敏感,因此可有效的检测出大目标。

[0083]

如图8所示,检测头的输出内容包括方框的位置和目标的类别信息。

[0084]

其中,方框的位置信息即为方框的中心点坐标(x,y)、方框的宽和高(w,h),且数值皆为相对于原始图像(即待识别的图像)大小的位置。若图像的原大小为w

×

h,则需要做如下的变换,即可得到方框的实际坐标参数。x

real

=x

×

w、y

real=

y

×

h、w

real

=w

×

w、h

real=

h

×

h。其中,方框的实际中心点坐标为(x

real

,y

real

),方框的实际宽为w

real

、方框的实际高为h

real

;图像的原大小中,图像的宽用w表示、图像的高用h表示。

[0085]

如设定输入的待识别的图像为412

×

412

×

3,则三个检测头的输出矩阵大小分别为52

×

52

×

6,26

×

26

×

6和13

×

13

×

6。此处的第三维的6可拆解为4 1 1,即输出的内容可以分解为:4个数用来表示图中方框的信息,即左上角的坐标(x,y)以及框的宽width和高height,1个数表示类别,1个数表示置信度。在遍历了所有的框的信息后,取置信度高于0.5的框在图像上进行绘制,并同时输出类别。

[0086]

如图8所示输出的结果,肿瘤的位置将会使用方框标注出,并在方框上方标注出brain tumor字样,表示方框区域内为脑肿瘤。

[0087]

进一步,本发明在将待识别的图像输入至残差结构的神经网络模型之前,还进行数据的预处理。

[0088]

数据的预处理包括了对数据大小的统一。dicom数据的大小为512

×

512,本发明在将其统一转变为412

×

412的大小,从而减小图像的输入大小,减少本发明的网络模型的参数量。

[0089]

进一步,为了能够让本发明的网络模型更好的进行收敛,本发明对所有的图像进行了像素值的归一化,即将所有像素值除以127.5后再减去1。

[0090]

综上所示,不同于传统的医学图像处理算法使用分割算法的输出项为肿瘤区域的掩膜,本发明的网络模型的输出项为肿瘤的位置和类别,通过大幅度减少输出项的信息量,从而提高模型的计算速度,同时,本发明的网络模型具有很好的非线性表达能力、提升网络模型的精确度和鲁棒性以及能对不同大小的目标均具有很好的敏感度,具有能精准识别目标的优点。

[0091]

表1中的p和n分别表示positive samples(正样本)和negative samples(负样本),解读为:在300张测试图片中,医生人工标注出401颗肿瘤,而本发明的网络模型共成功找出脑肿瘤的数量有396颗,有45颗为本发明的网络模型误检所得,并且其中有5颗肿瘤本发明的网络模型没有成功识别,故本发明的网络模型共检测出来441颗肿瘤。

[0092]

表1

[0093][0094]

表2

[0095]

识别结果正确识别漏识误识

数量396545

[0096]

由表2可知:tp=396、fn=5、fp=45、tn=0。因此当阈值设置为0.4时,本发明的网络模型的精确率为:precision=tp

÷

(tp fp)=89.80%;本发明的网络模型的召回率为:recall=tp

÷

(tp fn)=98.75%;

[0097]

为了更好的突出本发明的网络模型的优越性,分别选择了经典的双阶段算法faster

‑

rcnn和单阶段算法yolo对该数据集进行训练后,使用相同的测试数据进行测试。测试结果如表3所示,本发明的网络模型无论是在精确率还是在召回率上的表现都要优于faster

‑

rcnn和yolo。

[0098]

表3

[0099][0100]

在完成脑肿瘤的筛查工作时,需要保证召回率尽量高,即有较多的脑肿瘤被检测出来,可以看到,本发明的网络模型的召回率高达98.75%,因此本发明的网络模型能够尽可能不遗漏的找出脑肿瘤的患者。召回率和精确率往往是一对互相矛盾的值,但是本发明的网络模型能够保证在召回率较高的情况下,仍然拥有将近90%的精确率。可以看出,本发明的网络模型能够很好的应用于脑肿瘤的识别中。

[0101]

通过测试本发明的网络模型的检测速度,来判断本发明的网络模型的计算量和用户友好性。

[0102]

使用的计算平台为nvidia rtx2070,本发明的网络模型在测试数据集上的平均计算时间为20.81ms,即48.05fps。同时也做了本发明的网络模型与faster

‑

rcnn和yolo的推理速度的对比,如表4所示。

[0103]

表4

[0104]

算法名称faster

‑

rcnnyolo本发明的网络模型推理时间(ms)164.1627.8320.81

[0105]

众所周知,如果模型的参数量过大,一定程度上会引起模型的推理速度变慢,这对医生和患者来说都是非常不友好的,得益于合理且具有创新的骨干网络的设计,使得本发明的网络模型不仅在保证拥有较高的精确率和召回率的前提下,尽可能保证了推理速度的迅速,其推理速度已经超过了目前主流的单阶段算法和双阶段算法,能够在20ms左右完成一张图像的识别,从而有效的节约了医生等待的时间。

[0106]

进一步,所述基于残差结构的神经网络模型在对待识别的图像进行处理之前还进行所述网络模型的训练,包括以下步骤:将训练集中的图像输入到所述网络模型中,对所述网络模型进行训练,当所述网络模型的参数使得损失函数收敛时,完成所述网络模型的训练。

[0107]

进一步,所述网络模型的训练优选采用的优化器为adam优化器,优选采用的损失函数为focal loss损失函数;

[0108]

本发明的网络模型在训练时,会首先进行正向传播,即将数据代入本发明的网络

模型中进行计算并得到结果,并使用损失函数计算loss的值。在loss计算完毕后,进行反向传播从而完成每一卷积层的参数的更新和优化。优化器adam即提供了一种参数优化的算法,该算法拥有比传统优化算法,如随机梯度下降算法更快的优化速度。

[0109]

focalloss能够有效的缓解训练数据中正负样本不平衡的情况。在实际的数据集中,往往一张图片中只有一个目标是我们需要进行检测的(即正样本),而大多数的都是跟目标无关的背景(即负样本),因此,正样本远远小于负样本。使用focal loss损失函数时,若y=0,即负样本,则其置信度p会非常高,则1

‑

p的值则会非常小,从而使负样本的loss值大大的减小,而会让本发明的网络模型更加专注的去优化正样本的loss。

[0110]

focal loss损失函数的表达式:

[0111][0112]

其中表达式(1)中p表示置信度,α=0.25、γ=2;若y=0,表示负样本,y=1表示正样本。此处的正样本指预测正确的样本,负样本为预测错误的样本。

[0113]

进一步,训练集中的图像在训练前,同样进行数据预处理。

[0114]

进一步,训练集中的图像还进行了数据的增强处理,数据的增强处理发生在数据预处理之后。

[0115]

本发明使用的数据增强处理包括图像的随机对比度的调整、图像的随机角度的旋转、mosaic增强方法的至少一种。

[0116]

mosaic增强方法即在将图像的对比度进行随机的调整后,将多张图像拼接为一张图进行训练,其效果如图11所示。可以看到,多张图片被拼接到了一张图片之中,理解为,强行为本发明的网络模型增加小目标的学习。相比于市面上已有的单阶段算法而言,正是因为图像没有采用mosaic增强方法,才会让本发明的网络模型对小目标的识别非常吃力。进一步提高本发明精准的对小目标进行识别的能录。

[0117]

当然,本发明的优化器、损失函数也可以采用其他现有技术,还可以采用反向传播算法和梯度下降算法使损失函数的损失值收敛,完成本发明的网络模型的训练。

[0118]

当然,本发明的图像可以是其他医学图像或者非医学图像,识别的目标区域也不限于肿瘤,如图像中其他细胞或者组织的识别,或者离体组织图像中的细胞组织识别,或者扩展至非医学图像中感兴趣的部分的识别。如对图像中人脸、口罩和火灾隐患的识别、检测等。

[0119]

实施例2

[0120]

本实施例公开一种基于残差结构的神经网络模型,包括浅层骨干网络结构、中层骨干网络结构、深层骨干网络结构、spp层、第一检测头、第二检测头、第三检测头;

[0121]

每一个骨干网络结构均包括有残差结构,所述残差结构包括以1

×

1conv层在先处理、3

×

3的conv层在后处理的方式形成的基本单位;同一个残差结构中的基本单位至少为一个;当待识别的图像经所述浅层骨干网络结构处理后输入至第一检测头,能输出得到具有第一感受野的目标图像;当待识别的图像依次经所述经浅层骨干网络结构、中层骨干网络结构处理后输入至第二检测头,能输出得到具有第二感受野的目标图像;当待识别的图像依次经浅层骨干网络结构、中层骨干网络结构、深层骨干网络结构、spp层处理后,输入至第三检测头,能输出得到具有第三感受野的目标图像;其中,第一感受野、第二感受野、第三

感受野均不相同。

[0122]

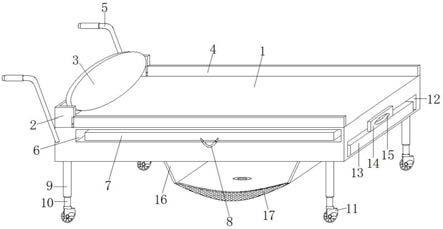

本发明的基于残差结构的神经网络模型通过tensorrt部署于jetson nano。为了能够更好的方便进行相关操作,本发明将由jetson nano与核磁共振仪使用usb进行连接,核磁共振仪在采集数据完毕后,将数据由usb数据线传输至jetson nano内。jetson nano能够外接触摸显示屏,操作人员可通过触摸屏对该系统进行操作。具体操作为:浏览数据存放的路径,系统将会自动对所有数据自动转化格式为图片格式,并对所有图片进行识别,识别完毕后,图片显示区会显示出标注出目标区域的图片。当目标为肿瘤时,图像左上角会显示患者的姓名,系统的详细信息展示区会显示出肿瘤的大小和数量。

[0123]

本发明的tensorrt是基于cuda的神经网络模型推理加速工具。tensorrt对神经网络模型的结构进行了重构,将所有能够合并的计算进行合并,并使其支持gpu加速。这一操作大大的加快了神经网络模型的推理速度,并且使神经网络在进行计算时占用的显存大大降低,从而极大程度上节约了计算资源。由于本产品在实际使用中,需要在满足高准确性的同时满足实时性,因此使用tensorrt加速工具来加速本发明的网络模型在jetsonnano上的推理速度。

[0124]

jetsonnano是一款计算机,现在可供嵌入式设计人员,研究人员和diy制造商使用,在紧凑,易用的平台上提供现代ai的强大功能,具有体积小,性能高,功能全的特点。jetsonnano采用四核64位armcpu和128核集成nvidia gpu,可提供472gflops的计算性能。它还包括4gblpddr4存储器,采用高效,低功耗封装,具有5w/10w功率模式和5v dc输入。jetsonnano同时提供了完整的桌面linu

×

环境,支持nvidia cuda toolkit 10.0,以及cudnn 7.3和tensorrt等库,支持图形运算的加速。该开发套件还包括本机安装流行的功能开源机器学习框架,如tensorflow,pytorch,caffe,keras等,以及计算机视觉和机器人开发的框架,如opencv和ros,对于人工智能的开发人员来说,jetson nano提供了完整且高效的解决方案,能够帮助人工智能的开发人员在短时间内开发复杂的ai应用。

[0125]

尽管已经示出和描述了本发明的实施例,对于本领域的普通技术人员而言,可以理解在不脱离本发明的原理和精神的情况下可以对这些实施例进行多种变化、修改、替换和变型,本发明的范围由所附权利要求及其等同物限定。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。