1.本发明属于电力巡检技术领域,具体涉及一种基于强化学习的变电站内巡检机器人路径规划方案。

背景技术:

2.作为电力运维保障的重要组成部分,变电站巡检可以实时掌握电气设备的运行情况,及时发现故障和异常,防止因突发事故造成变电站功能瘫痪,保障电网的安全稳定运行。传统变电站巡检主要采用人工方式,往往存在巡检人员主观能动性差、漏检现象严重、难以建立电子化档案等问题,在电力物联网广泛建设的当下已然不能完全满足要求。目前,许多变电站已采用先进的电力巡检机器人实现对站内地面设施的常态化巡检,以确保及时发现故障并报告。

3.然而,变电站无人巡检也往往存在难以进行有效路径规划的问题。

4.1)变电站中,各类电气设备分布情况复杂,部分变电站地面年久失修,无法供机器人安全通行,而需要进行巡检的点位往往呈随机分布,且与各类电气设备在地理位置上高度相关。因此,在进行巡检路径规划时,如何实现安全避障是一个亟待解决的问题。

5.2)受限于有限的电池容量,机器人需要合理规划巡检路径的同时尽可能保证巡检路径最短,减少对某一巡检点位多次重复的巡检,造成不必要的资源浪费。因此,如何实现巡检路径的最短和巡检任务的快速完成是另一个亟待解决的问题。

6.传统巡检路径规划方案往往采用遗传算法、蚁群算法、模拟退火算法等启发式算法,此类算法对场景参数的要求较高,存在算法复杂度高、性能收敛慢、优化结果不稳定等问题,容易发生陷入局部最优的情况,且适应性差,难以应对灵活多变的变电站场景。而采用强化学习算法可以实现以巡检机器人为主体的自主路径选择与安全避障,通过在模拟场景中不断“试错”,以达到性能的快速高效收敛,相较于传统方式对场景的适应能力更强。

技术实现要素:

7.有鉴于此,本发明的目的在于提出一种基于强化学习的变电站内巡检机器人路径规划方案,以实现有效的安全避障和路径规划。

8.为达到上述目的,本发明提供如下技术方案。

9.一种基于强化学习的变电站内巡检机器人路径规划方案,该方案针对变电站巡检场景,通过栅格法对实际变电站环境建模,并采用sarsa算法设计巡检机器人路径规划方案,在解决巡检机器人安全避障问题的同时合理规划巡检路径,适应实际变电站的复杂环境。该方案具体包括以下步骤。

10.s1:获取实际变电站环境信息,建立变电站环境模型。

11.s2:设计基于sarsa算法的变电站内巡检机器人路径规划方案。

12.s3:简述具体方案流程,并将其在变电站环境模型中进行重复训练。

13.s4:通过仿真实例验证本发明所提方案的有效性。

14.进一步的,所述步骤s1中,利用栅格法对变电站环境进行建模,将其抽象为的栅格图。在变电站环境模型中,白色区域表示变电站内的可通行道路,乘号区域表示障碍物。巡检机器人、巡检点位及充电仓分别用五角星、加号和正五边形表示。

15.进一步的,所述步骤s2中,设计基于sarsa算法的巡检机器人路径规划方案,主要包括智能体、环境、状态、动作以及奖赏的设计。其中,在奖赏的设计过程中,当巡检机器人再次经过已到达的巡检点位时,无法重复获得奖励值,从而引导巡检机器人减少到达同一个巡检点位的次数。

16.进一步的,所述步骤s3中,具体方案流程包括初始化阶段、学习阶段和终止阶段。其中,在学习阶段,巡检机器人采用贪婪策略进行动作的选取,该策略使机器人得到的巡检路径更为保守,即巡检路径较短但不易与障碍物发生碰撞,由此大大延长巡检机器人的使用寿命。

17.与现有技术相比,本发明具有以下优点。

18.1)本发明以贪婪策略代替q

‑

learning中的贪婪策略,通过更为保守的路径规划,解决了巡检机器人易与障碍物发生碰撞的问题。此外,通过对sarsa算法中奖赏的设计,减少巡检机器人到达同一个巡检点位的次数,解决了资源浪费问题。

19.2)本发明采用sarsa算法实现以巡检机器人为主体的自主路径选择与避障,通过在变电站环境模型中不断学习,保证机器人高效地完成所有点位的巡检任务的同时实现安全避障。

附图说明

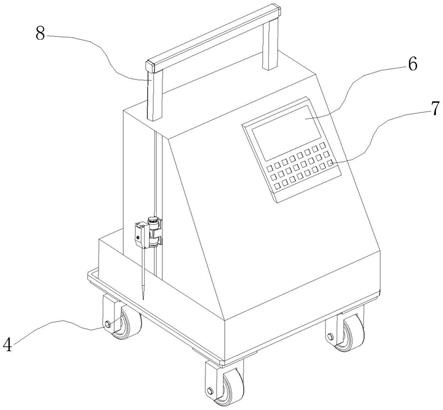

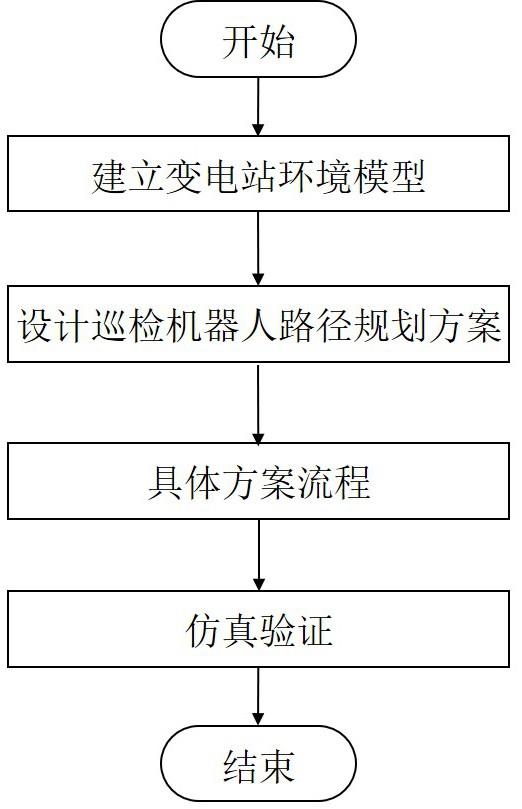

20.图1为本发明实施例所述的巡检机器人路径规划方案流程示意图。

21.图2为本发明实施例所述的变电站环境模型图。

22.图3为本发明实施例所述的累计平均回报随学习周期变化示意图。

具体实施方式

23.下面结合附图和具体实施例对本发明进行详细说明。本实施例以本发明技术方案为前提进行实施,给出了详细的实施方式和具体的操作过程。需要说明的是,在不冲突的情况下,本发明中的实施例及实施例中的特征可以相互组合。

24.图1为本实施例所述的巡检机器人路径规划方案流程示意图,具体包括以下步骤。

25.1)建立变电站环境模型。

26.变电站实景地图完全应用于路径规划所需计算量和存储量过于庞大,不利于存储与定点识别。巡检机器人能够实现故障检测和自主导航的基本前提是建立一个适当的环境模型,从而使巡检机器人对变电站环境有更好的认知,减少决策路径时需要的计算量。变电站环境建模的过程就是将具体信息转换为巡检机器人可以识别的环境信息。在本发明中,采用栅格法建立变电站环境模型。在此过程中,如何描述障碍物至关重要,需注意以下几点。

27.(1)障碍物的位置和大小等信息经计算机处理后,转化为二值信息栅格。

28.(2)障碍物实体向地面的最大投影面积即为二维栅格地图中的障碍物面积。

29.(3)障碍物占据的栅格面积不足一个栅格时按照一个栅格处理。这是由于在实际的变电站环境中,各个障碍物并非都是规则的,所有障碍物在栅格图中不一定能够完整的用整数倍的栅格单元表示。因此,需要对不规则障碍物进行边缘膨化处理,使得膨化之后的障碍物边界一定是安全区域。

30.为了方便数学建模,本发明将变电站环境简单分为可通行道路、充电仓、巡检点位以及障碍物,其中,障碍物具体包括变电站内的变压器、隔离开关、断路器、电抗器、杆塔等多种电气设备以及标志牌、草坪、绿化带、栅栏等其它设施。

31.图2为本发明实施例所述的变电站环境模型图。在变电站环境模型中,白色区域表示变电站内的可通行道路,乘号区域表示障碍物。其中,变压器、隔离开关等矩形电气设备可用图中的块状部分代替,绿化带、墙壁、栅栏等条状障碍物用图中带状部分代替,点状部分能够代表杆塔、路标、标志牌等占地面积较小的电气设备或障碍物。巡检机器人、巡检点位及充电仓分别用五角星、加号和正五边形表示。

32.此外,为实现以巡检机器人为主体的智能路径规划与安全避障,本发明设置个学习周期,在上述变电站环境模型中重复训练,以便科学有效地规划出巡检路径的同时尽可能保证巡检路径最短,适应实际变电站的复杂环境。在每个学习周期开始时,巡检机器人从起点出发,并在上、下、左、右四个方向中选取其中一个进行移动,若该动作执行后机器人未与障碍物发生碰撞,则巡检机器人到达下一个栅格,否则退回巡检机器人未执行动作前的栅格。若巡检机器人遍历完所有巡检点位后到达充电仓,该学习周期结束,进入下一个学习周期。

33.2)设计巡检机器人路径规划方案。

34.本发明基于sarsa算法设计了一种变电站内巡检机器人路径规划方案,其中sarsa算法通过学习状态和动作对奖赏函数的影响以求解最优策略,即智能体感知环境的状态,并且根据环境提供的回报,通过学习选择一个合适的动作,来最大化长期的回报值。该方案中主要包含智能体(agent)、环境(environment)、状态(state)、动作(action)、奖赏(reward)等要素,具体分析如下。

35.智能体:巡检机器人为算法中的智能体,可通过传感器系统探测一定范围内的变电站环境,获取动作执行后的结果反馈,通过学习制定最优路径规划策略。此外,智能体能够将每个状态、动作及其相应的回报保存在一个表格数据结构中,即q表。

36.环境:环境指智能体之外一切组成的、与之交互的事物。在本发明中,环境为变电站内变压器、隔离开关、断路器、电抗器、杆塔等电气设备以及标志牌、草坪、绿化带、栅栏等其它设备的分布情况,巡检点位和充电仓的位置信息等。

37.状态:指巡检机器人当前所处的栅格单元。

38.动作:指巡检机器人在当前状态下根据某种策略选择下一个栅格单元的行为。本发明以巡检机器人为中心,定义机器人可执行的动作空间为a={上,下,左,右}。

39.奖赏:指环境给巡检机器人的立即反馈,也是巡检机器人在当前状态下执行某一动作后的好坏评价,对巡检机器人进行最优路径规划有导向性作用。在本发明中,巡检机器人执行一次动作后,若未与障碍物发生碰撞或未到达巡检点位,将会得到

‑

1的奖励值;若与障碍物发生碰撞,就会得到奖励值

‑

50;若巡检机器人第一次到达某个巡检点位,得到50的

奖励值,之后再次经过已到达的巡检点位则无法重复获得该奖励,从而引导巡检机器人减少到达同一个巡检点位的次数。

40.3)具体方案流程。

41.基于sarsa算法的变电站内巡检机器人路径规划具体方案流程包括初始化阶段、学习阶段和终止阶段。具体如下所述。

42.初始化阶段:初始化q表,即。

43.学习阶段:本发明设置1000个学习周期以实现巡检机器人智能路径规划与安全避障。在每个学习周期中,巡检机器人从起点出发,采用贪婪策略进行动作的选取。给定概率,设随机数。若,则巡检机器人在当前状态下随机选取某个动作;若,巡检机器人选择当前状态下q值最大的动作。接着,巡检机器人观察所选动作的回报以及巡检机器人执行动作后的下个状态,依据贪婪策略选取下一个动作,同时根据下式更新q表:。

44.其中为学习率,为奖赏的衰变系数,表示执行动作后的下个状态,为进入状态后根据sarsa算法所制定策略采取的下一步动作。

45.此外,若巡检机器人执行动作后与障碍物发生碰撞,则退回巡检机器人未执行动作前的栅格。最后,若巡检机器人遍历完所有巡检点位并到达充电仓,该学习周期结束,进入下一个学习周期。

46.终止阶段:当巡检机器人完成所有学习周期后,算法终止。

47.4)仿真验证。

48.为说明本发明所提方案的优越性,在图2所述的变电站环境模型中进行仿真验证。其中,学习率和奖赏衰减系数分别被设置为0.5和1,概率被设置为0.1,学习周期为1000。

49.图3为本发明实施例所述的累计平均回报随学习周期变化示意图。从图中可以看出,本发明所提算法相较于采用贪婪策略的q

‑

learning算法具有明显的优越性。这是因为sarsa算法是一种更为保守的策略。当巡检机器人认识到选择最短路径易与障碍物发生碰撞并获得一个极小的回报后,会更加倾向于选择保守的策略,而q

‑

learning算法每次都选择当前状态下q值最大的动作进入下一跳,与障碍物发生碰撞的概率更大。

50.尽管为说明目的公开了本发明的具体实施和附图,其目的在于帮助理解本发明的内容并据以实施,但是本领域的技术人员可以理解:在不脱离本发明及所附的权利要求的精神和范围内,各种替换、变化和修改都是可能的。因此,本发明不应局限于最佳实施例和附图所公开的内容,本发明要求保护的范围以权利要求书界定的范围为准。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。