1.本发明属于计算机辅助设计领域,具体涉及一种用于设计高性能闪耀光栅结构的神经网络。

背景技术:

2.光栅耦合器是目前最受关注的耦合器件类型之一,已广泛应用于微电子电路,光网络和光电器件等领域。传统周期性光栅结构虽然已广泛应用于光子学设计中,在实际应用中依然存在较大的限制,例如在多缝衍射过程中,周期性光栅光强主要集中在零级,而多数情况下零级方向的衍射光并不能满足导模传输条件。闪耀光栅耦合器由两个或多个周期性非刻蚀部分模拟了阶梯状闪耀光栅,可以有效的克服传统周期性光栅结构遇到的诸多问题,具备在多个角度获得大光强的潜力。然而闪耀光栅耦合器设计需要经过困难的建模和电磁仿真过程,预测其远场结果时间消耗巨大。

3.针对闪耀光栅耦合器设计上的各种不足已经提出多种解决办法,例如利用时域有限差分法进行计算,利用机器学习方法等;然而很少有人注意到利用自动编码器训练神经网络也是提高光栅耦合器设计效率的重要途径。

技术实现要素:

4.本发明的目的在于提供一种利用神经网络预测远场光谱、合成远场模式,并有效地预测与远场模式相对应的参数值,将电弧光栅耦合器的电磁模拟速度降低到毫秒数量级的预测网络。

5.为实现上述目的,本发明提供如下技术方案:

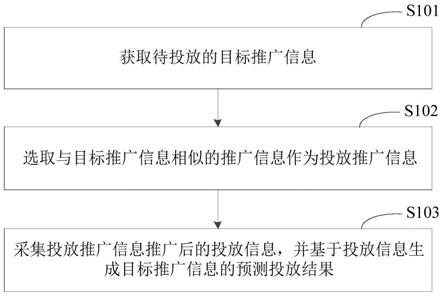

6.一种用于设计高性能闪耀光栅结构的预测网络的构建方法,包括如下步骤:

7.1)利用时域有限差分法计算出768个不同刻蚀参数的闪耀光栅远场模式;

8.2)在所述闪耀光栅远场模式的中间切割51

×

200像素,展开为10200维的原始数据;

9.3)将所述原始数据作为输入向量y

i

放入一个自动编码器中,经过1000次迭代训练,使得输出向量无限接近输入向量y

i

,获得最终隐向量z和训练后的解码器;

10.4)将光栅的结构参数α、l、d、w0、w1、w2、w3以及入射光波长λ共8个参数作为输入向量放入一个前馈神经网络中,以3)中得到对应相同远场模式的最终隐向量z作为目标,进行1000次迭代训练,使输出向量y无限接近最终隐向量z,获得训练后的神经网络;

11.5)将3)中训练后的解码器连接到4)中训练后的神经网络之后,形成的新的神经网络即为最终的预测网络。

12.在上述技术方案中,所述自动编码器由编码器(encoder)和初始解码器(decoder)两部分组成;所述编码器用于对输入向量y

i

进行编码得到100维的隐向量z,所述初始解码器用于对隐向量z重构成输出向量使输出向量无限接近输入向量y

i

即得最终隐向量z。在上述技术方案中,所述自动编码器中训练过程中的损失函数表达式为:

[0013][0014]

其中,m表示向量维度,上述公式中的mse无限接近0。

[0015]

在上述技术方案中,所述自动编码器和前馈神经网络中均固定有一个输入层、一个输出层和数个隐藏层;每一层均由最小单位神经元组成。所述神经元的参数为:输入向量x={x1,x2,...,x

n

},权重向量a={a1,a2,...,a

n

},偏置量b,输出值y,激活函数σ(y),激活函数表达式如下:

[0016][0017]

其中e为自然常数。

[0018]

在上述技术方案中,所述自动编码器的输入层的神经元数量为10200;输出层的神经元数量为10200;隐藏层的数量为5层,每一层的神经元数量分别为2000,2000,1000,2000,2000。

[0019]

在上述技术方案中,所述前馈神经网络的输入层的神经元数量为8;输出层的神经元数量为1000;隐藏层数量为3层,每一层的神经元数量分别为100,100,100。

[0020]

在上述技术方案中,所述前馈神经网络训练过程中使用梯度下降算法,依据损失函数l的梯度更新每一层的参数θ,损失函数及参数θ的公式为:

[0021][0022][0023]

其中,上角标n表示前馈神经网络的最后一层,即第n层,上角标i表示前馈神经网络的第i层,学习速率η的值为0.01。

[0024]

与现有技术相比,本发明的有益效果是:

[0025]

与传统的电磁仿真过程相比,本发明中的用于预测远场模式的神经网络在实际测试中有95%以上的精度,同时将闪耀光栅耦合器仿真速度缩小到毫秒量级,相比传统计算方法提高了数万倍,可以极大地提高相关逆向设计的效率,因而具有广泛的应用价值和应用前景。

附图说明

[0026]

图1为本发明实施例1的闪耀光栅结构设计图。

[0027]

图2为本发明实施例1的优化前后光栅的远场强度对比图。

[0028]

图3为本发明实施例1的自动编码器示意图。

[0029]

图4为本发明实施例1的预测网络的构建示意图。

[0030]

图5为本发明实施例1的预测网络与实际结果的预测对比图。

具体实施方式

[0031]

下面将结合附图对本发明的技术方案进行清楚、完整地描述,显然,所描述的实施例是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0032]

此外,下面所描述的本发明不同实施方式中所涉及的技术特征只要彼此之间未构成冲突就可以相互结合。

[0033]

实施例1:

[0034]

步骤1、使用lumerical公司的fdtd软件计算出图1中闪耀光栅的远场模式,并通过改变光波长λ以及w0、w1、w2、w3四项结构参数收集训练数据,其中:

[0035]

λ=[1.50,1.55,1.60]微米

[0036]

w0=[0.2,0.3,0.4,0.5]微米

[0037]

w1=[0.5,0.6,0.7,0.8]微米

[0038]

w2=[0.2,0.3,0.4,0.5]微米

[0039]

w3=[0.5,0.6,0.7,0.8]微米。

[0040]

图1中incident代表入射光,λ代表光的波长,α代表扇角,l代表光栅在刻槽前的长度,d代表刻蚀深度,w0、w1、w2、w3代表刻槽宽度。

[0041]

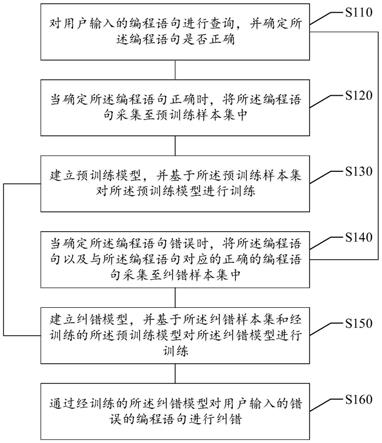

步骤2、在所述闪耀光栅远场模式的中间切割51x200像素,展开为10200维的原始数据;如图3所示,将原始数据作为输入向量y

i

放入一个自动编码器中,经过1000次迭代训练,使得输出向量无限接近输入向量y

i

,获得最终隐向量z(latent vector)和训练后的解码器。

[0042]

所述自动编码器由编码器(encoder)和初始解码器(decoder)两部分组成,原始数据(输入向量y

i

)在通过编码器后被编码为100维的隐向量z,隐向量z再通过初始解码器重构成训练数据(输出向量);使训练数据(输出向量)无限接近原始数据(输入向量y

i

)即得最终隐向量z。自动编码器训练过程中的损失函数表达式为:

[0043][0044]

其中,m表示向量维度,上述公式中的mse无限接近0。

[0045]

步骤3、将光栅的结构参数α、l、d、w0、w1、w2、w3以及入射光波长λ共8个参数作为输入向量放入一个前馈神经网络中,以步骤2中得到的相同远场模式的最终隐向量z作为目标,进行1000次迭代训练,使输出向量y无限接近最终隐向量z,获得训练后的神经网络;前馈神经网络训练过程中使用梯度下降算法,依据损失函数l的梯度更新每一层的参数θ,损失函数及参数θ的公式为:

[0046][0047][0048]

其中,上角标n表示前馈神经网络的最后一层,即第n层,上角标i表示前馈神经网

络的第i层,学习速率η的值为0.01。

[0049]

在上述实施例中,所述自动编码器和前馈神经网络中均固定有一个输入层、一个输出层和数个隐藏层;每一层均由最小单位神经元组成;神经元的参数为:输入向量x={x1,x2,...,x

n

},权重向量a={a1,a2,...,a

n

},偏置量b,输出值y,激活函数σ(y),激活函数表达式如下:

[0050][0051]

其中e为自然常数。

[0052]

所述自动编码器的输入层的神经元数量为10200;输出层的神经元数量为10200;隐藏层的数量为5层,每一层的神经元数量分别为2000,2000,1000,2000,2000。

[0053]

所述前馈神经网络的输入层的神经元数量为8;输出层的神经元数量为1000;隐藏层数量为3层,每一层的神经元数量分别为100,100,100。

[0054]

步骤4、将步骤2)中训练后的解码器连接到步骤3)中训练后的神经网络之后,形成的新的神经网络即为最终的预测网络(图4)。

[0055]

本发明的原理是:利用神经网络通过训练样本迭代参数进行学习的特性,以及自动编码器将输入向量编码为低维的隐向量,再通过解码器将隐向量重构回输入向量的特点。通过对该自动编码器进行迭代训练,将训练后的解码器部分作为预测网络使用,设计出了一种新型方案用于快速得到光栅远场模式的算法,大大的降低了单次计算所需的时间。

[0056]

图2为优化前的光栅(a~c)和优化后光栅(d~f)远场强度对比图,可以看出在1500nm、1550nm、1600nm三种波长下,优化后光栅的远场强度比优化前的光栅大约20倍。

[0057]

图5为本发明所述的实施例1的神经网络预测与fdtd计算的实际结果的对比图,从图中可以看到,与实际结果相比,预测结果达到了很高的精度(95%以上),成功构建的预测网络可以将单次计算提升至毫秒级。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。