1.本发明涉及模式识别与计算机视觉领域,特别是一种基于姿态估计的线上考试学生行为分析方法。

背景技术:

2.近些年来,在计算机视觉领域中,基于深度学习的姿态估计方法也层出不穷,在公开数据集上不断创造新的记录并取得了很大的发展。此外,在各个计算机视觉会议里也有越来越多的研究者发表与姿态估计有关的论文。利用好姿态识别技术,方便人们的日常生活,也成了一个重要的研究课题。去年以来,由于疫情影响,线上考试的数量越来越多,如何对线上考试进行监控,是一个很大的难题。借助于姿态估计以及动作识别在计算机视觉领域的发展,越来越多的人在做这方面的研究。

3.尽管对此问题有所研究,但在真实在线考试情况下,总会出现难以预测的情况,影响异常行为识别的准确率。

技术实现要素:

4.本发明的目的在于提供一种基于姿态估计的线上考试学生行为分析方法,该方法能够有效地对视频中的异常行为进行识别。

5.为实现上述目的,本发明的技术方案是:一种基于姿态估计的线上考试学生行为分析方法,包括如下步骤:

6.步骤s1、通过对上半身以及脸部进行针对性预训练,得到针对上半身以及脸部关键点的姿态估计模型;

7.步骤s2、采用已训练好的姿态估计模型,对线上考试监控视频进行检测分析,设计异常行为判断依据;

8.步骤s3、对考生屏幕答题过程,以及二机位监考范围内有无手机通讯设备进行识别分析;

9.步骤s4、结合视频、音频以及对屏幕进行监控,判断考生是否有异常行为。

10.在本发明一实施例中,所述步骤s1具体包括以下步骤:

11.步骤s11、从网络上获取公开的上半身人体以及人脸数据集,并获得训练数据的相关标注;

12.步骤s12、采用resnet

‑

101作为特征提取主干网络,并将每个上采样阶段改成应用单个5

×

5的深度可分离卷积来构建一个轻量级的模块,设置步长为2;

13.步骤s13、在没有可微分匹配的情况下,先将最小batchsize设置为32,初始学习率α0设置为5e

‑

4,学习率α0以如下公式指数衰减:

14.α=0.95

epoch_num

*α015.其中epoch_num是指经历的时期数,当学习率衰减到预定数值时,再使用固定1e

‑

3的学习率对整个姿态估计模型训练60个时期,将姿态估计模型进行微调。

16.在本发明一实施例中,所述步骤s2具体包括以下步骤:

17.步骤s21、将步骤s1中训练好的针对上半身以及脸部关键点的姿态估计模型运用于线上考试监控视频,提取出每帧骨骼关键点数据,以json文件进行保存;

18.步骤s22、利用脸部68个关键点进行估计,经过世界坐标系到相机坐标系、平面坐标系的转换,当满足在一段连续帧中,yaw>t

head

时,即判断为一次转头异常,其中yaw和t

head

分别代表头部偏航角以及头部转动的阈值;

19.步骤s23、利用识别的脸部图像,对图像人脸检测后进行灰度化以及二值化的处理,提取出眼部区域的图像信息,并根据巩膜以及瞳孔的分布计算出斜视比,斜视比计算如下:

[0020][0021]

其中r

ratio

是指右边单眼斜视比,leftwhite表示眼部左半部分巩膜的数量,rightwhite代表眼部右半部分巩膜的数量,c

l

、c

r

为左、右眼巩膜不同的比例系数,根据左右眼平均斜视比对是否斜视进行判断,当在预定帧内,总凝视比小于右侧阈值或者大于左侧阈值时,则可判定这段时间内为考生眼睛向右斜视或者向左斜视,对检测出来的异常帧进行记录;

[0022]

步骤s24、根据嘴部的18个骨骼点信息,提取出关键点,设关键点d

i

‑

j

为点i到点j之间的距离,xi、yi表示点i的横坐标以及纵坐标,xj、yj表示点j的横坐标以及纵坐标,根据公式:

[0023][0024]

对关键点之间的距离进行计算,从而得出嘴部开合比mouth的计算公式:

[0025][0026]

其中,d

i

‑

j

为点i到点j之间的距离,数字为关键点序号,为嘴部高度系数,为嘴部宽度系数;计算出嘴部开合度之后,若在一段连续帧内,嘴部开合度大于阈值,则判断为有讲话的嫌疑;

[0027]

步骤s25、通过对上半身手部骨骼关键点的位置信息,对异常伸手行为进行判定;设定x

relbow

、y

relbow

为右手手肘处关键点横坐标以及纵坐标,x

rwriet

、y

rwriet

为右手手腕处关键点横坐标以及纵坐标,angle

e

‑

w

为手肘以及手腕处连线与水平线的角度,tan为正切值,具体计算公式如:

[0028][0029]

通过对手肘手腕处正切角进行计算,当在预定帧数中,角度大于阈值时,或者关键点置信度小于0.05,判定为手部伸手异常行为;

[0030]

步骤s26、通过对上半身手部骨骼关键点的位置信息,对异常手部消失行为进行判定;设定x

reye

、y

reye

为右眼关键点横坐标以及纵坐标,x

rear

、y

rear

为右耳关键点横坐标以及纵坐标,angle

e

‑

e

为眼部与耳朵处连线与水平线的角度,tan为正切值,具体计算公式如:

[0031][0032]

通过连线角度angle

e

‑

e

进行计算,并结合单手或者双手手腕处关键点置信度是否小于0.05,对手部消失情况进行判定。

[0033]

在本发明一实施例中,所述步骤s3具体包括以下步骤:

[0034]

步骤s31、首先通过javascript的插件对网页考试端的鼠标数据进行监控,对考生离开网页、进入网页以及复制粘贴操作进行监控;

[0035]

步骤s32、获取二机位监控摄像头,使用yolov5检测模型对视频中是否出现手机进行检测,当出现手机后,发出警告。

[0036]

在本发明一实施例中,所述步骤s4具体包括以下步骤:

[0037]

步骤s41、提前收集包括咳嗽、打嗝、椅子移动的环境噪音作为负样本,将考生低声说话的语音作为正样本,通过短时间傅里叶变换,提取音频转换成128维的特征;

[0038]

步骤s42、将音频数据作为输入,使用改进的样本级卷积神经网络进行分类,将该卷积神经网络的第一层改成使用128的大核,并在该卷积神经网络的最后一个连接层之前,再加上一个全连接层,进行训练,以提高对掺杂在噪音中的说话声的检测率;将训练后的模型用于检测,并结合步骤s2中的嘴部关键点活动进行进一步判断;

[0039]

步骤s43、通过视频、音频、以及屏幕监控三种不同异常行为检测方式,将每种类型的异常行为分别用表示,k代表第k帧,eye,hand,mouth,head,mouse,voice分别代表眼部、手部、嘴部、头部、鼠标以及声音,并将其统一归一化为0至1;通过对每个种类异常概率使用以下公式进行计算,获得该生第k帧的异常率

[0040][0041]

其中,w

eye

,w

haad

,w

mouth

,w

head

,w

mouth

,w

voice

是指眼部、手部、嘴部、头部、鼠标以及声音所占的权重,通过上述公式对考生作弊的风险进行评估。

[0042]

本发明还提供了一种计算机可读存储介质,其上存储有能够被处理器运行的计算机程序指令,当处理器运行该计算机程序指令时,能够实现如上述所述的方法步骤。

[0043]

相较于现有技术,本发明具有以下有益效果:

[0044]

1、能够有效地对视频中的上半身包括脸部姿态进行识别,提升了姿态估计的准确率,并降低了仅有上半身人体图像的影响。

[0045]

2、能够针对线上考试情况,设计出多种针对姿态估计的异常行为种类,不仅对上半身手肘手腕处异常行为进行检测,还分别对头部、眼部、嘴部的表情进行检测,提高了检测成功率,降低了考生投机取巧利用各种方式进行作弊的可能性。

[0046]

3、通过对音频数据构建网络并训练,能有效识别出掺杂在环境噪音中的说话声,极大的提高了检测率。

[0047]

4、针对传统仅根据骨骼点,对考试进行判断的情况,该方法有更广的适用性。该方法利用了多方面的数据,并对音频,视频以及屏幕监控的行为都进行监控,提高了容错率,

降低了漏检以及错检的次数。

附图说明

[0048]

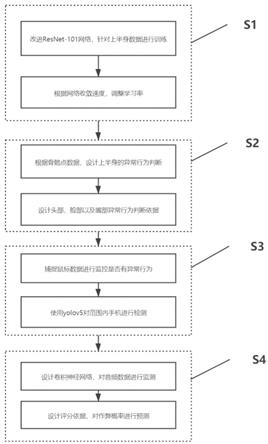

图1为本发明实施例的方法实现流程图。

具体实施方式

[0049]

下面结合附图,对本发明的技术方案进行具体说明。

[0050]

应该指出,以下详细说明都是例示性的,旨在对本技术提供进一步的说明。除非另有指明,本文使用的所有技术和科学术语具有与本技术所属技术领域的普通技术人员通常理解的相同含义。

[0051]

需要注意的是,这里所使用的术语仅是为了描述具体实施方式,而非意图限制根据本技术的示例性实施方式。如在这里所使用的,除非上下文另外明确指出,否则单数形式也意图包括复数形式,此外,还应当理解的是,当在本说明书中使用术语“包含”和/或“包括”时,其指明存在特征、步骤、操作、器件、组件和/或它们的组合。

[0052]

本发明一种基于姿态估计的线上考试学生行为分析方法,包括如下步骤:

[0053]

步骤s1、通过对上半身以及脸部进行针对性预训练,得到针对上半身以及脸部关键点的姿态估计模型;

[0054]

步骤s2、采用已训练好的姿态估计模型,对线上考试监控视频进行检测分析,设计异常行为判断依据;

[0055]

步骤s3、对考生屏幕答题过程,以及二机位监考范围内有无手机通讯设备进行识别分析;

[0056]

步骤s4、结合视频、音频以及对屏幕进行监控,判断考生是否有异常行为。

[0057]

以下为本发明具体实现过程。

[0058]

如图1所示,本发明提供了一种基于姿态估计的线上考试学生行为分析与识别方法,包括以下步骤:

[0059]

步骤s1、通过对上半身以及脸部进行针对性预训练,得到相应检测模型。具体包括以下步骤:

[0060]

步骤s11、从网络上获取公开的上半身人体以及人脸数据集,并获得训练数据的相关标注;

[0061]

步骤s12、采用resnet

‑

101作为特征提取主干网络,并将每个上采样阶段改成应用单个5

×

5的深度可分离卷积来构建一个轻量级的模块,设置步长为2;

[0062]

步骤s13、在没有可微分匹配的情况下,先将最小batchsize设置为32,初始学习率α0设置为5e

‑

4,学习率α0以如下公式指数衰减:

[0063]

α=0.95

epoch_num

*α0[0064]

其中epoch_num是指经历的时期数,当学习率衰减到一定数值时,我们再使用固定1e

‑

3的学习率对整个模型训练60个时期,将模型进行微调。这样进行训练可以更好的检测半身人像,减少误差。

[0065]

步骤s2、采用已训练好的姿态估计模型,对线上考试监控视频进行检测分析,设计异常行为判断依据。具体包括以下步骤:

[0066]

步骤s21、将步骤s1中训练好的针对上半身以及脸部关键点的姿态估计模型运用于监考视频,提取出每帧骨骼关键点数据,以json文件进行保存;

[0067]

步骤s22、利用脸部68个关键点进行估计,经过世界坐标系到相机坐标系,到平面坐标系的转换,当满足在一段连续帧中,yaw>t

head

时,即可以判断为一次转头异常,其中yaw和t

head

分别代表了头部偏航角以及头部转动的阈值;

[0068]

步骤s23、利用识别的脸部图像,对图像人脸检测后进行灰度化以及二值化的处理,提取出眼部区域的图像信息,并根据巩膜以及瞳孔的分布计算出斜视比,其中,斜视比计算如下:

[0069][0070]

其中r

ratio

是指右边单眼斜视比,leftwhite表示眼部左半部分巩膜的数量,rightwhite代表眼部右半部分巩膜的数量,c

l

、c

r

为左、右眼巩膜不同的比例系数,根据左右眼平均斜视比对是否斜视进行判断,当在一定帧内,总凝视比小于右侧阈值或者大于左侧阈值时,我们则可以判定这段时间内为考生眼睛向右斜视或者向左斜视,我们会对检测出来的异常帧进行记录;

[0071]

步骤s24、根据嘴部的18个骨骼点信息,提取出主要的关键点,设关键点d

i

‑

j

为点i到点j之间的距离,xi、yi表示点i的横坐标以及纵坐标,xj、yj表示点j的横坐标以及纵坐标,根据公式:

[0072][0073]

对关键点之间的距离进行计算,从而得出嘴部开合比mouth的计算公式:

[0074][0075]

其中,d

i

‑

j

为点i到点j之间的距离,数字为关键点序号,为嘴部高度系数,为嘴部宽度系数。计算出嘴部开合度之后,若在一段连续帧内,嘴部开合度大于阈值,则判断为有讲话的嫌疑。

[0076]

步骤s25、通过对上半身手部骨骼关键点的位置信息,对异常伸手行为进行判定。我们设定x

relbow

,y

relbow

为右手手肘处关键点横坐标以及纵坐标,x

rwriet

,y

rwriet

为右手手腕处关键点横坐标以及纵坐标,angle

e

‑

w

为手肘以及手腕处连线与水平线的角度,tan为正切值,具体计算公式如:

[0077][0078]

通过对手肘手腕处正切角进行计算,当在一定帧数中,角度大于阈值时,或者关键点置信度小于0.05,判定为手部伸手异常行为;

[0079]

步骤s26、通过对上半身手部骨骼关键点的位置信息,对异常手部消失行为进行判定,我们设定x

reye

,y

reye

为右眼关键点横坐标以及纵坐标,x

rear

,y

rear

为右耳关键点横坐标以及纵坐标,angle

e

‑

e

为眼部与耳朵处连线与水平线的角度,tan为正切值,具体计算公式如:

[0080][0081]

通过连线角度angle

e

‑

e

进行计算,并结合单手或者双手手腕处关键点置信度是否小于0.05,对手部消失情况进行判定。

[0082]

步骤s3、对考生屏幕答题过程,以及二机位监考范围内有无手机通讯设备进行识别分析,具体包括以下步骤:

[0083]

步骤s31、首先通过javascript的插件对网页考试端的鼠标数据进行监控,对考生离开网页、进入网页以及复制粘贴操作进行监控;

[0084]

步骤s32、获取二机位监控摄像头,使用yolov5检测模型对视频中是否出现手机进行检测,当出现手机后,发出警告。

[0085]

步骤s4、结合视频、音频以及对屏幕进行监控,判断考生是否有异常行为,其具体包括以下步骤:

[0086]

步骤s41、提前收集咳嗽、打嗝、椅子移动等环境噪音作为负样本,将考生低声说话的语音作为正样本,通过短时间傅里叶变换,提取音频转换成128维的特征。

[0087]

步骤s42、将音频数据作为输入,使用改进的样本级卷积神经网络(sample

‑

level cnn)进行分类,将该卷积神经网络的第一层改成使用128的大核,并在该卷积神经网络的最后一个连接层之前,再加上一个全连接层,进行训练,这样可以提高对掺杂在噪音中的说话声的检测率。将训练后的模型用于检测,并结合步骤s2中的嘴部关键点活动进行进一步判断;

[0088]

步骤s43、通过视频、音频、以及屏幕监控三种不同异常行为检测方式,我们将每种类型的异常行为分别用表示,k代表第k帧,eye,hand,mouth,head,mouse,voice分别代表眼部、手部、嘴部、头部、鼠标以及声音,并将其统一归一化为0至1。通过对每个种类异常概率使用以下公式进行计算,获得该生第k帧的异常率率

[0089]

其中,w

eye

,w

hand

,w

mouth

,w

head

,w

mouth

,w

voice

是指眼部、手部、嘴部、头部、鼠标以及声音所占的权重,我们可以对考生作弊的风险进行评估。

[0090]

本发明还提供了一种计算机可读存储介质,其上存储有能够被处理器运行的计算机程序指令,当处理器运行该计算机程序指令时,能够实现如上述所述的方法步骤。

[0091]

本领域内的技术人员应明白,本技术的实施例可提供为方法、系统、或计算机程序产品。因此,本技术可采用完全硬件实施例、完全软件实施例、或结合软件和硬件方面的实施例的形式。而且,本技术可采用在一个或多个其中包含有计算机可用程序代码的计算机可用存储介质(包括但不限于磁盘存储器、cd

‑

rom、光学存储器等)上实施的计算机程序产品的形式。

[0092]

本技术是参照根据本技术实施例的方法、设备(系统)、和计算机程序产品的流程图和/或方框图来描述的。应理解可由计算机程序指令实现流程图和/或方框图中的每一流程和/或方框、以及流程图和/或方框图中的流程和/或方框的结合。可提供这些计算机程序

指令到通用计算机、专用计算机、嵌入式处理机或其他可编程数据处理设备的处理器以产生一个机器,使得通过计算机或其他可编程数据处理设备的处理器执行的指令产生用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的装置。

[0093]

这些计算机程序指令也可存储在能引导计算机或其他可编程数据处理设备以特定方式工作的计算机可读存储器中,使得存储在该计算机可读存储器中的指令产生包括指令装置的制造品,该指令装置实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能。

[0094]

这些计算机程序指令也可装载到计算机或其他可编程数据处理设备上,使得在计算机或其他可编程设备上执行一系列操作步骤以产生计算机实现的处理,从而在计算机或其他可编程设备上执行的指令提供用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的步骤。

[0095]

以上所述,仅是本发明的较佳实施例而已,并非是对本发明作其它形式的限制,任何熟悉本专业的技术人员可能利用上述揭示的技术内容加以变更或改型为等同变化的等效实施例。但是凡是未脱离本发明技术方案内容,依据本发明的技术实质对以上实施例所作的任何简单修改、等同变化与改型,仍属于本发明技术方案的保护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。