1.本公开涉及计算机技术领域,尤其涉及一种动画生成方法与动画生成装置、计算机可读存储介质及电子设备。

背景技术:

2.在电商、游戏和动漫等领域,虚拟数字人的应用越来越广泛,影响力也逐渐扩大,尤其是3d(3

‑

dimension,三维)虚拟数字人。而且,3d虚拟数字人等虚拟偶像也都有着广泛的粉丝群体。在电商领域,通过虚拟数字人进行直播可以极大的节省人力,商家无需专业的主播也可以全天候直播;在客服环节,通过虚拟数字人与用户进行沟通,可以拉近与用户之间的距离,安抚用户情绪;在导购环节,通过虚拟数字人进行商品讲解,可以让用户更快的了解商品卖点,提升引单转化。

3.目前,基于虚拟数字人的内容制作大体可以分为三类,分别是通过专业的美术制作人员基于文本内容进行模型与动画制作;通过专业的演员佩戴动作捕捉设备和面部表情捕捉设备,结合文本内容进行内容的录制,再将动作和表情等应用到虚拟数字人的模型上进行后期渲染;通过ai(artificial intelligence,人工智能)算法智能分析文本内容,以生成相应的视频。

4.但是,前两类制作方式都需要专业的人士参与,导致虚拟数字人的内容生产成本高、周期长。而第三类制作方式需要大量的训练数据,对每一个新形象的虚拟数字人往往都需要进行重新训练,而且对于计算设备的性能要求高,生成的虚拟数字人的视频一般只能提前渲染好保存下来,再进行播放,制约了虚拟数字人的应用场景。

5.鉴于此,本领域亟需开发一种新的动画生成方法及装置。

6.需要说明的是,在上述背景技术部分公开的信息仅用于加强对本公开的背景的理解,因此可以包括不构成对本领域普通技术人员已知的现有技术的信息。

技术实现要素:

7.本公开的目的在于提供一种动画生成方法、动画生成装置、计算机可读存储介质及电子设备,进而至少在一定程度上克服由于相关技术的限制而导致的制作周期长和成本高的技术问题。

8.本公开的其他特性和优点将通过下面的详细描述变得显然,或部分地通过本公开的实践而习得。

9.根据本发明实施例的第一个方面,提供一种动画生成方法,所述方法包括:获取制作好的虚拟数字人,并获取所述虚拟数字人播报的语音信息;

10.对所述语音信息进行口形动画生成处理得到口形动画,并对所述语音信息进行表情动画生成处理得到表情动画;

11.对所述语音信息进行肢体动画生成处理得到肢体动画,并根据所述口形动画、所述表情动画和所述肢体动画对所述虚拟数字人进行同步渲染。

12.在本发明的一种示例性实施例中,所述对所述语音信息进行口形动画生成处理得到口形动画,包括:

13.对所述语音信息进行音素转换处理得到与时间信息对齐的音素,并对所述音素进行视位转换处理得到与所述时间信息对齐的语音视位;

14.对所述语音视位和所述时间信息进行线性插值处理得到口形动画。

15.在本发明的一种示例性实施例中,所述对所述语音信息进行音素转换处理得到与时间信息对齐的音素,包括:

16.对所述语音信息进行特征提取处理得到声学特征和单帧时长,并利用训练好的声学模型确定与所述声学特征对应的声学状态;

17.对所述声学状态进行组合处理得到音素,并利用所述单帧时长对所述音素进行对齐处理得到与单帧时长的时间信息对齐的音素。

18.在本发明的一种示例性实施例中,所述训练好的声学模型按照如下方式进行训练:

19.对语音样本进行训练得到声学特征与声学状态之间的原始概率值,并对所述原始概率值进行语音解码处理得到声学状态网络;

20.对所述声学状态网络进行路径搜索处理得到目标概率值,以得到表示所述声学特征与所述声学状态的映射关系的声学模型。

21.在本发明的一种示例性实施例中,所述对所述音素进行视位转换处理得到与所述时间信息对齐的语音视位,包括:

22.获取所述音素与语音视位之间的第一映射关系;

23.基于所述第一映射关系,对所述音素进行视位转换处理得到与所述时间信息对齐的语音视位。

24.在本发明的一种示例性实施例中,所述对所述语音视位和所述时间信息进行线性插值处理得到口形动画,包括:

25.在所述语音视位中确定当前语音视位,并利用虚拟网格权重表示所述当前语音视位;

26.对所述虚拟网格权重表示的当前语音视位和所述时间信息进行线性插值处理得到口形动画。

27.在本发明的一种示例性实施例中,所述对所述虚拟网格权重表示的当前语音视位和所述时间信息进行线性插值处理得到口形动画,包括:

28.利用虚拟网格权重表示所述语音视位中的目标语音视位,对所述虚拟网格权重表示的当前语音视位和虚拟网格权重表示的所述目标语音视位进行视位计算得到视位计算结果;

29.根据所述时间信息确定单帧时长、所述目标语音视位的结束时间以及与所述当前语音视位对应的消耗时长,并对所述单帧时长、所述结束时间和所述消耗时长进行时长计算得到时长计算结果;

30.对所述虚拟网格权重表示的当前语音视位、所述视位计算结果和所述时长计算结果进行权重计算得到下一网格权重,以根据所述下一网格权重确定待渲染的口形动画。

31.在本发明的一种示例性实施例中,所述获取所述虚拟数字人播报的语音信息,包

括:

32.获取所述虚拟数字人播报的文本信息;

33.对所述文本信息进行合成语音转换处理得到语音信息。

34.在本发明的一种示例性实施例中,所述对所述语音信息进行表情动画生成处理得到表情动画,包括:

35.对所述语音信息进行表情动画配置得到默认表情动画和触发表情动画;

36.以预设时间为间隔设置所述默认表情动画中的第一默认动画,并对所述触发表情动画进行第一触发配置确定所述触发表情动画中的第一触发动画;

37.基于所述第一触发配置,利用所述第一触发动画替换所述第一默认动画,得到待渲染的表情动画。

38.在本发明的一种示例性实施例中,所述对所述触发表情动画进行第一触发配置确定所述触发表情动画中的第一触发动画,包括:

39.在所述文本信息中确定第一文本信息,并利用所述第一文本信息对所述触发表情动画进行文本触发配置确定所述触发表情动画中的第一触发动画;和/或

40.对所述文本信息进行文本情感计算得到情感分值,并利用所述情感分值对所述触发表情动画进行分值触发配置确定所述触发表情动画中的第一触发动画。

41.在本发明的一种示例性实施例中,所述对所述语音信息进行肢体动画生成处理得到肢体动画,包括:

42.对所述语音信息进行肢体动画配置得到默认肢体动画和触发肢体动画;

43.以预设时间为间隔设置所述默认肢体动画中的第二默认动画,并对所述触发肢体动画进行第二触发配置确定所述触发肢体动画中的第二触发动画;

44.基于所述第二触发配置,利用所述第二触发动画替换所述第二默认动画,得到待渲染的肢体动画。

45.在本发明的一种示例性实施例中,所述对所述触发肢体动画进行第二触发配置确定所述触发肢体动画中的第二触发动画,包括:

46.在所述文本信息中确定第二文本信息,并利用所述第二文本信息对所述触发肢体动画进行标签触发配置确定所述触发肢体动画中的第二触发动画;和/或

47.对所述文本信息进行语义分析处理得到语义信息,并利用所述语义信息对所述触发肢体动画进行语义触发配置确定所述触发肢体动画中的第二触发动画。

48.根据本发明实施例的第二个方面,提供一种动画生成装置,所述装置包括:信息获取模块,被配置为获取制作好的虚拟数字人,并获取所述虚拟数字人播报的语音信息;

49.动画生成模块,被配置为对所述语音信息进行口形动画生成处理得到口形动画,并对所述语音信息进行表情动画生成处理得到表情动画;

50.同步渲染模块,被配置为对所述语音信息进行肢体动画生成处理得到肢体动画,并根据所述口形动画、所述表情动画和所述肢体动画对所述虚拟数字人进行同步渲染。

51.根据本发明实施例的第三个方面,提供一种电子设备,包括:处理器和存储器;其中,存储器上存储有计算机可读指令,所述计算机可读指令被所述处理器执行时实现上述任意示例性实施例的动画生成方法。

52.根据本发明实施例的第四个方面,提供一种计算机可读存储介质,其上存储有计

算机程序,所述计算机程序被处理器执行时实现上述任意示例性实施例中的动画生成方法。

53.由上述技术方案可知,本发明示例性实施例中的动画生成方法、动画生成装置、计算机存储介质及电子设备至少具备以下优点和积极效果:

54.在本公开的示例性实施例提供的方法及装置中,根据语音信息生成渲染虚拟数字人的口形动画、表情动画和肢体动画,并根据口形动画、表情动画和肢体动画对虚拟数字人进行同步渲染。一方面,减少渲染虚拟数字人过程中的人工参与度,提升虚拟数字人动画内容的生成速度和效率;另一方面,虚拟数字人的动画能够即时生成,无需根据新形象的虚拟数字人重新训练算法,丰富了虚拟数字人的应用场景。

55.应当理解的是,以上的一般描述和后文的细节描述仅是示例性和解释性的,并不能限制本公开。

附图说明

56.此处的附图被并入说明书中并构成本说明书的一部分,示出了符合本公开的实施例,并与说明书一起用于解释本公开的原理。显而易见地,下面描述中的附图仅仅是本公开的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

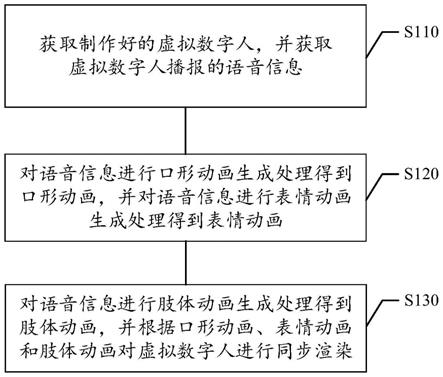

57.图1示意性示出本公开示例性实施例中一种动画生成方法的流程示意图;

58.图2示意性示出本公开示例性实施例中获取语音信息的方法的流程示意图;

59.图3示意性示出本公开示例性实施例中生成口形动画的方法的流程示意图;

60.图4示意性示出本公开示例性实施例中音素转换处理的方法的流程示意图;

61.图5示意性示出本公开示例性实施例中声学模型的训练方法的流程示意图;

62.图6示意性示出本公开示例性实施例中视位转换处理的方法的流程示意图;

63.图7示意性示出本公开示例性实施例中线性插值处理的方法的流程示意图;

64.图8示意性示出本公开示例性实施例中利用虚拟网格权重表示当前语音视位的界面示意图;

65.图9示意性示出本公开示例性实施例中进一步进行线性插值处理的方法的流程示意图;

66.图10示意性示出本公开示例性实施例中生成表情动画的方法的流程示意图;

67.图11示意性示出本公开示例性实施例中第一触发配置的方法的流程示意图;

68.图12示意性示出本公开示例性实施例中生成肢体动画的方法的流程示意图;

69.图13示意性示出本公开示例性实施例中第二触发配置的方法的流程示意图;

70.图14示意性示出本公开示例性实施例中应用场景下动画生成方法的流程示意图;

71.图15示意性示出本公开示例性实施例中应用场景下口形动画生成处理的方法的流程示意图;

72.图16示意性示出本公开示例性实施例中应用场景下音素对齐的方法的流程示意图;

73.图17示意性示出本公开示例性实施例中一种动画生成装置的结构示意图;

74.图18示意性示出本公开示例性实施例中一种用于实现动画生成方法的电子设备;

75.图19示意性示出本公开示例性实施例中一种用于实现动画生成方法的计算机可读存储介质。

具体实施方式

76.现在将参考附图更全面地描述示例实施方式。然而,示例实施方式能够以多种形式实施,且不应被理解为限于在此阐述的范例;相反,提供这些实施方式使得本公开将更加全面和完整,并将示例实施方式的构思全面地传达给本领域的技术人员。所描述的特征、结构或特性可以以任何合适的方式结合在一个或更多实施方式中。在下面的描述中,提供许多具体细节从而给出对本公开的实施方式的充分理解。然而,本领域技术人员将意识到,可以实践本公开的技术方案而省略所述特定细节中的一个或更多,或者可以采用其它的方法、组元、装置、步骤等。在其它情况下,不详细示出或描述公知技术方案以避免喧宾夺主而使得本公开的各方面变得模糊。

77.本说明书中使用用语“一个”、“一”、“该”和“所述”用以表示存在一个或多个要素/组成部分/等;用语“包括”和“具有”用以表示开放式的包括在内的意思并且是指除了列出的要素/组成部分/等之外还可存在另外的要素/组成部分/等;用语“第一”和“第二”等仅作为标记使用,不是对其对象的数量限制。

78.此外,附图仅为本公开的示意性图解,并非一定是按比例绘制。图中相同的附图标记表示相同或类似的部分,因而将省略对它们的重复描述。附图中所示的一些方框图是功能实体,不一定必须与物理或逻辑上独立的实体相对应。

79.针对相关技术中存在的问题,本公开提出了一种动画生成方法。图1示出了动画生成方法的流程图,如图1所示,动画生成方法至少包括以下步骤:

80.步骤s110.获取制作好的虚拟数字人,并获取虚拟数字人播报的语音信息。

81.步骤s120.对语音信息进行口形动画生成处理得到口形动画,并对语音信息进行表情动画生成处理得到表情动画。

82.步骤s130.对语音信息进行肢体动画生成处理得到肢体动画,并根据口形动画、表情动画和肢体动画对虚拟数字人进行同步渲染。

83.在本公开的示例性实施例中,根据语音信息生成渲染虚拟数字人的口形动画、表情动画和肢体动画,并根据口形动画、表情动画和肢体动画对虚拟数字人进行同步渲染。一方面,减少渲染虚拟数字人过程中的人工参与度,提升虚拟数字人动画内容的生成速度和效率;另一方面,虚拟数字人的动画能够即时生成,无需根据新形象的虚拟数字人重新训练算法,丰富了虚拟数字人的应用场景。

84.下面对动画生成方法的各个步骤进行详细说明。

85.在步骤s110中,获取制作好的虚拟数字人,并获取虚拟数字人播报的语音信息。

86.在本公开的示例性实施例中,虚拟数字人可以是3d虚拟数字人。

87.3d虚拟数字人的制作方式有多种。例如,由专业的建模人员通过maya(三维建模和动画软件)/3d max(三维建模渲染和动画制作)/blender(三维图形图像软件)等专业的建模软件进行手工设计和制作,一般用于卡通形象或拟人形象;也可以通过相机阵列进行扫描重建,一般用于写实真人形象的还原。除此之外,近年来也有基于单张照片进行模型自动生成算法的研究。

88.值得说明的是,无论哪种制作方法,得到的3d虚拟数字人模型都需要进行面部blendshape和骨骼蒙皮的绑定。blendshape用于生成表情和口形动画,骨骼蒙皮用于生成肢体动画。

89.其中,blendshape是基于单个网格变形实现多个预定义形状网格,通过多个blendshape组合实现变形动画。blendshape在maya/3d max等软件中也可以被称为morph target。

90.在获取到制作好的3d虚拟数字人之后,还可以获取用于3d虚拟数字人播报的语音信息。

91.在可选的实施例中,图2示出了获取语音信息的方法的流程示意图,如图2所示,该方法至少包括以下步骤:在步骤s210中,获取虚拟数字人播报的文本信息。

92.该文本信息是给定的虚拟数字人播报的文本内容的信息,用来生成虚拟数字人播报的语音信息。文本信息的来源可以是由用户进行编辑的,也可以是对接智能对话系统的,以实现与虚拟数字人的智能对话。

93.在步骤s220中,对文本信息进行合成语音转换处理得到语音信息。

94.在得到文本信息之后,可以利用语音合成算法将文本信息进行合成语音转换处理,从而生成该文本信息的语音信息。其中,语音合成算法可以是系统预设的用于合成语音的工具。具体的,语音合成算法可以采用语音合成算法和平台,例如互联网公司的开放平台、ai语音合成软件或者cool editor等。

95.绝大多数的语音合成算法都能够支持音色、语速、多语种的合成。因此,在具体实施过程中,可以兼容不同的语音合成算法,以及根据实际情况的需求选择对应的语音合成算法。

96.在本示例性实施例中,通过合成语音转换处理可以将文本信息转换成语音信息,实现为虚拟数字人提供播报语音的功能,避免因没有文本信息对应的语音信息而出现无法与渲染动画同时播放语音信息的情况,提高渲染虚拟数字人的智能化程度和自动化程度。

97.在步骤s120中,对语音信息进行口形动画生成处理得到口形动画,中,语音信息进行表情动画生成处理得到表情动画。

98.在本公开的一种示例性实施例中,在得到虚拟数字人播报的语音信息之后,可以对语音信息进行口形动画生成处理得到对应的口形动画。

99.在可选的实施例中,图3示出了生成口形动画的方法的流程示意图,如图3所示,该方法至少包括以下步骤:在步骤s310中,对语音信息进行音素转换处理得到与时间信息对齐的音素,并对音素进行视位转换处理得到与时间信息对齐的语音视位。

100.在可选的实施例中,图4示出了音素转换处理的方法的流程示意图,如图4所示,该方法至少包括以下步骤:在步骤s410中,对语音信息进行特征提取处理得到声学特征和单帧时长,并利用训练好的声学模型确定与声学特征对应的声学状态。

101.原始的语音信息为时域波形,这种输入几乎没有描述能力,因此需要对波形做变换,例如提取mfcc(mel frequency cepstrum coefficient,梅尔频率倒谱系数)特征。根据人耳的特性,把每一帧波形转换为一个多维向量,这个过程就是特征提取处理。常用的声学特征除了mfcc特征之外,还可以有plp(perceptual linear prediction,感知线性预测)特征、pitch特征等。

102.其中,mel频率是基于人耳听觉特性提出来的,它与hz(赫兹)频率成非线性对应关系。mel频率倒谱系数(mfcc)则是利用它们之间的这种关系,计算得到的hz频谱特征,mfcc已经广泛地应用在语音识别领域。由于mel频率与hz频率之间非线性的对应关系,使得mfcc随着频率的提高,其计算精度随之下降。因此,在应用中常常只使用低频mfcc,而丢弃中高频mfcc。

103.特征提取处理以帧为单位,在语音处理过程中,通常以一定的帧长和帧移进行分帧。其中,帧长是指每帧的长度,帧移是每两帧开头之间的时延。如果以帧长25ms、帧移10ms进行分帧,则每两帧之间有15ms的重叠。通过特征提取处理可以得到一个m

×

n的矩阵,其中,m表示声学特征的维度,n表示总帧数。

104.进一步的,可以利用训练好的声学模型确定与声学特征对应的声学状态。

105.在可选的实施例中,图5示出了声学模型的训练方法的流程示意图,如图5所示,该方法至少包括以下步骤:在步骤s510中,对语音样本进行训练得到声学特征与声学状态之间的原始概率值,并对原始概率值进行语音解码处理得到声学状态网络。

106.声学模型(acoustic modeling)是语音系统中最重要的部分之一,在进行语音识别等过程中,将语音信号转换为声学特征,再利用声学模型确定出声学特征对应的各个声学状态,由各个声学状态组合即可获得因素或者文字。

107.其中,声学状态是构成文字发音的基本单位,通常是指将音素进一步划分获得的更小单位。而音素是发音的最小单元。

108.声学模型的训练就是通过大量的语料得到帧特征和状态对应的概率p(o|s

i

),亦即声学特征与声学状态之间的原始概率值。其中,o是某一帧的特征,s

i

是状态i,某一帧对应的状态就是概率最大的状态。实际中,相邻帧的状态在大多数情况下应该都是相同的,因为每一帧的时间都很短。

109.为了达到这个目的,采用hmm(hidden markov model,隐含马尔柯夫模型)构建声学状态网络。除此之外,也可以利用其他模型构建声学状态网络,本示例性实施例对此不做特殊限定。

110.在步骤s520中,对声学状态网络进行路径搜索处理得到目标概率值,以得到表示声学特征与声学状态的映射关系的声学模型。

111.在得到声学状态网络之后,还可以从声学状态网络中进行路径搜索处理得到最佳路径。该最佳路径即为概率最大的路径,并将该路径的概率确定为目标概率值,以此形成声学模型,并用该声学模型表示声学特征与声学状态之间的映射关系。

112.在本示例性实施例中,通过语音解码处理和路径搜索处理训练得到声学模型,训练方式简单准确,为确定与声学特征对应的声学状态提供了数据基础。

113.在训练好声学模型之后,可以利用该声学模型确定将声学特征转换为相应的声学状态。具体的,可以设置多个单位语音信号(例如5个)组成的语音向量对应一个声学状态,亦即若干帧语音对应一个声学状态。

114.在步骤s420中,对声学状态进行组合处理得到音素,并利用单帧时长对音素进行对齐处理得到与单帧时长的时间信息对齐的音素。

115.由于多个声学状态对应一个音素,因此可以将每三个声学状态组合成一个音素。进一步的,再将该音素结合单帧时长的时间信息得到音素与时间信息对齐的结果。

116.在本示例性实施例中,将语音信息转换为音素与时间信息对齐的结果,为后续生成口形动画提供音素基础,在生成音素环节减少人工参与,提高虚拟数字人的生成速度和渲染效率。

117.在得到与时间信息对齐的音素之后,可以对音素进行视位转换处理得到与时间信息对齐的语音视位。

118.在可选的实施例中,图6示出了视位转换处理的方法的流程示意图,如图6所示,该方法至少包括以下步骤:在步骤s610中,获取音素与语音视位之间的第一映射关系。

119.其中,语音视位是每个音素发音时对应的口腔形状。某些音素虽然发音不同,但是发音时对应的口形是相同的。举例而言,汉语拼音中的b、p、m就对应同一个语音视位。因此,可以获取到音素与语音视位之间的第一映射关系,以进一步将音素转换为对应的语音视位。

120.在步骤s620中,基于第一映射关系,对音素进行视位转换处理得到与时间信息对齐的语音视位。

121.通过音素与语音视位之间的第一映射关系可以得到语音视位和时间轴的对应信息。亦即,对于一段语音有一系列对应的语音视位,每个语音视位都对应一个开始时间和一个结束时间。

122.在本示例性实施例中,对因素进行视位转换处理得到对齐的语音视位,转换方式简单准确,为后续生成口形动画提供语音视位基础,在生成语音视位的环节减少人工参与,提高虚拟数字人的生成速度和渲染效率。

123.在步骤s320中,对语音视位和时间信息进行线性插值处理得到口形动画。

124.在得到语音视位之后,可以对语音视位和时间信息进行线性插值处理得到对应的口形动画。

125.在可选的实施例中,图7示出了线性插值处理的方法的流程示意图,如图7所示,该方法至少包括以下步骤:在步骤s710中,在语音视位中确定当前语音视位,并利用虚拟网格权重表示当前语音视位。

126.其中,虚拟网格权重可以是blendshape。blendshape即为基于网格变形实现多个预定义形状网格,通过多个blendshape组合实现变形动画,在maya或者3d max等软件中也被称为morph target。

127.图8示出了利用虚拟网格权重表示当前语音视位的界面示意图,如图8所示,利用虚拟网格权重表示语音视位就是预先按照每个语音视位对应的口形,通过调整blendshape的权重得到对应的口形。一般的,设虚拟数字人模型共有k个blendshape,用每个blendshape权重组成的向量来表示语音视位,记为w=[w0,w1,

…

,w

k

]。

[0128]

具体的,当口形从当前形状切换到下一语音视位时,为了得到流畅平滑的口形动画,在语音视位中确定当前语音视位,并设当前语音视位对应的权重向量为w

current

。

[0129]

在步骤s720中,对虚拟网格权重表示的当前语音视位和时间信息进行线性插值处理得到口形动画。

[0130]

在可选的实施例中,图9示出了进一步进行线性插值处理的方法的流程示意图,如图9所示,该方法至少包括以下步骤:在步骤s910中,利用虚拟网格权重表示语音视位中的目标语音视位,对虚拟网格权重表示的当前语音视位和虚拟网格权重表示的目标语音视位

进行视位计算得到视位计算结果。

[0131]

在确定当前语音视位之后,还可以在语音视位中确定目标语音视位。进一步的,利用虚拟网络权重表示该目标语音权重,例如w

target

。

[0132]

进一步的,可以对利用虚拟网络权重表示的当前语音视位和目标语音视位进行视位计算,例如求差计算得到视位计算结果。

[0133]

在步骤s920中,根据时间信息确定单帧时长、目标语音视位的结束时间以及与当前语音视位对应的消耗时长,并对单帧时长、结束时间和消耗时长进行时长计算得到时长计算结果。

[0134]

根据时间信息确定单帧时长δt,目标语音视位的结束时间t

end

,从第一帧到当前帧消耗的消耗时间t。进一步的,对单帧时长、结束时间和消耗时长进行求差和除法计算得到对应的时长计算结果。

[0135]

在步骤s930中,对虚拟网格权重表示的当前语音视位、视位计算结果和时长计算结果进行权重计算得到下一网格权重,以根据下一网格权重确定待渲染的口形动画。

[0136]

在得到视位计算结果和时长计算结果之后,可以对虚拟网格权重表示的当前语音视位、视位计算结果和时长计算结果进行权重计算,例如求和与乘积计算得到下一帧对应的权重向量,亦即下一网格权重,以在渲染时将每帧的权重设置给相应的blendshape得到平滑的口形动画。

[0137]

具体的,权重计算结果可以参照公式(1):

[0138][0139]

其中,w

next

‑

w

next

表示视位计算结果,表示时长计算结果。

[0140]

在本示例性实施例中,对语音视位进行线性差值能够得到平滑的口形动画,保障虚拟数字人渲染效果的平滑度和生动性。

[0141]

在生成口形动画之后,为了得到更加生动的虚拟数字人,还需要表情动画的配合。因此,可以对语音信息进行表情动画生成处理得到对应的表情动画。

[0142]

在可选的实施例中,图10示出了生成表情动画的方法的流程示意图,如图10所示,该方法至少包括以下步骤:在步骤s1010中,对语音信息进行表情动画配置得到默认表情动画和触发表情动画。

[0143]

在对语音信息进行表情动画配置时,考虑到虚拟数字人始终有类似真人的微表情,不至于太过呆板,因此可以对应配置默认表情动画。该默认表情动画可以包括眨眼、挑眉和眼球小幅度的转动等。

[0144]

另一方面,考虑到要让虚拟数字人配合语音信息作出开心、惊讶等情绪相关的表情,还可以对应配置触发表情动画。

[0145]

并且,可以预先将需要的默认表情动画和触发表情动画制作好并保存下来,在需要的时候触发渲染即可。值得说明的是,两类表情动画的触发逻辑并不相同。

[0146]

在步骤s1020中,以预设时间为间隔设置默认表情动画中的第一默认动画,并对触发表情动画进行第一触发配置确定触发表情动画中的第一触发动画。

[0147]

具体的,默认表情动画可以随机触发。每隔一段预设时间,可以从默认表情动画的

素材库中随机抽取一个或者若干个默认表情动画作为第一默认动画进行渲染。为了使渲染效果与真人的微表情接近,还可以根据真人眨眼、挑眉和眼球小浮动转动的频率,将预设时间的间隔控制在0.5

‑

4s之间。

[0148]

另外的,对触发表情动画进行第一触发配置可以有文本触发和分值触发两种触发逻辑。

[0149]

在可选的实施例中,图11示出了第一触发配置的方法的流程示意图,如图11所示,该方法至少包括以下步骤:在步骤s1110中,在文本信息中确定第一文本信息,并利用第一文本信息对触发表情动画进行文本触发配置确定触发表情动画中的第一触发动画。

[0150]

第一文本信息可以是文本信息中,用户指定在某个字或者词触发相应的第一触发动画的文本信息。具体的,可以在该第一文本信息处利用#等符号作为标签进行标记,并在该第一文本信息对应的时间信息位置插入对应的第一触发动画,以实现第一触发配置。

[0151]

在步骤s1120中,对文本信息进行文本情感计算得到情感分值,并利用情感分值对触发表情动画进行分值触发配置确定触发表情动画中的第一触发动画。

[0152]

通过nlp(natural language processing,自然语言处理)进行文本情感计算得到文本信息对应的情感分值,以分析当前的文本信息对应的情绪信息。

[0153]

进一步的,通过情感分值触发对应的第一触发动画的渲染。

[0154]

举例而言,情感分值可以是在

‑

1到1之间的分值。其中,情感分值=0表示中性情绪信息,情感分值>0表示正向情绪信息,情感分值<0表示负向情绪信息。进而,通过与正向情绪信息对应的触发表情动画确定开心、微笑等正向的第一触发动画。

[0155]

在本示例性实施例中,通过第一触发配置可以为触发表情动画配置两种触发逻辑,不仅贴合了数字虚拟人的真人渲染效果,还能够动画渲染与文本信息对应的情绪动画,渲染效果更佳。

[0156]

在步骤s1030中,基于第一触发配置,利用第一触发动画替换第一默认动画,得到待渲染的表情动画。

[0157]

基于第一触发配置的触发逻辑,以及考虑到数字虚拟人的表情真实性,可以将需要渲染第一触发动画的位置的第一默认动画替换为第一触发动画,以得到对应的待渲染的表情动画。

[0158]

在本示例性实施例中,通过表情动画生成方式可以得到渲染虚拟数字人时需要的表情动画,丰富了表情动画的渲染维度,提升了虚拟数字人的表情真实度和丰富性,渲染效果更佳。

[0159]

在步骤s130中,对语音信息进行肢体动画生成处理得到肢体动画,并根据口形动画、表情动画和肢体动画对虚拟数字人进行同步渲染。

[0160]

在本公开的一种示例性实施例中,图12示出了生成肢体动画的方法的流程示意图,如图12所示,该方法至少包括以下步骤:在步骤s1210中,对语音信息进行肢体动画配置得到默认肢体动画和触发肢体动画。

[0161]

在对语音信息进行肢体动画配置时,考虑到虚拟数字人始终有类似真人的肢体动画才更加真实,因此可以对应配置默认肢体动画。该默认肢体动画可以包括呼吸、身体小幅度的摆动等。

[0162]

另一方面,考虑到要让虚拟数字人配合语音信息作出招手、鞠躬、比心等文本相关

的动作,还可以对应配置触发肢体动画。

[0163]

更进一步的,根据虚拟数字人的应用场景,也可以提前制作相关的默认肢体动画和触发肢体动画,并进行分类和保存,在需要的时候触发渲染即可。值得说明的是,两类肢体动画的触发逻辑并不相同。

[0164]

在步骤s1220中,以预设时间为间隔设置默认肢体动画中的第二默认动画,并对触发肢体动画进行第二触发配置确定触发肢体动画中的第二触发动画。

[0165]

具体的,默认肢体动画可以随机触发,并且持续循环播放。每隔一段预设时间,可以从默认肢体动画的素材库中抽取一个或者若干个默认肢体动画作为第二默认动画进行渲染。并且该预设时间间隔也可以按照实际情况的需求进行设置,本示例性实施例对此不做特殊限定。

[0166]

另外的,对触发肢体动画进行第二触发配置的方式可以有文本触发和语义触发两种触发逻辑。

[0167]

在可选的实施例中,图13示出了第二触发配置的方法的流程示意图,如图13所示,该方法至少包括以下步骤:在步骤s1310中,在文本信息中确定第二文本信息,并利用第二文本信息对触发肢体动画进行标签触发配置确定触发肢体动画中的第二触发动画。

[0168]

第二文本信息可以是文本信息中,用户指定在某个字或者词触发相应的第二触发动画的文本信息。具体的,可以在该第一文本信息处利用#等符号作为标签进行标记,并在该第二文本信息对应的时间信息位置插入对应的第二触发动画,以实现第二触发配置。

[0169]

在步骤s1320中,对文本信息进行语义分析处理得到语义信息,并利用语义信息对触发肢体动画进行语义触发配置确定触发肢体动画中的第二触发动画。

[0170]

通过nlp进行语义分析处理得到表征文本信息的语义的语义信息,以分析当前的文本信息对应的内容,从而触发相应的第二触发动画。

[0171]

举例而言,当语义信息表征“打招呼”的语义时,可以确定第二触发动画中打招呼的肢体动画为第二触发动画。

[0172]

在本示例性实施例中,通过第二触发配置可以为触发肢体动画配置两种触发逻辑,不仅贴合了数字虚拟人的真人渲染效果,还能够动画渲染与文本信息对应的动作动画,渲染效果更佳。

[0173]

在步骤s1230中,基于第二触发配置,利用第二触发动画替换第二默认动画,得到待渲染的肢体动画。

[0174]

基于第二触发配置的触发逻辑,以及考虑到数字虚拟人的肢体真实性,可以将需要渲染第二触发动画的位置的第二默认动画替换为第二触发动画,以得到对应的待渲染的肢体动画。

[0175]

在本示例性实施例中,通过肢体动画生成方式可以得到渲染虚拟数字人时需要的肢体动画,丰富了肢体动画的渲染维度,提升了虚拟数字人的肢体真实度和丰富性,渲染效果更佳。

[0176]

在得到口形动画、表情动画和肢体动画之后,可以将虚拟数字人的口型动画、表情动画和肢体动画与对应的时间信息同步渲染,以得到完整的虚拟数字人动画。虚拟数字人在播报用户输入的文本信息或者语音信息的同时,能够协调搭配合适的表情动画和肢体动画。

[0177]

下面结合一应用场景对本公开实施例中的动画生成方法做出详细说明。

[0178]

图14示出了应用场景下动画生成方法的流程示意图,如图14所示,在步骤s1410中,获取文本信息。

[0179]

该文本信息是给定的虚拟数字人播报的文本内容的信息,用来生成虚拟数字人播报的语音信息。

[0180]

在步骤s1420中,合成语音转换处理。

[0181]

在得到文本信息之后,可以利用语音合成算法将文本信息进行合成语音转换处理,从而生成该文本信息的语音信息。其中,语音合成算法可以是系统预设的用于合成语音的工具。具体的,语音合成算法可以采用语音合成算法和平台,例如互联网公司的开放平台、ai(artificial intell igence,人工智能)语音合成软件或者cool editor等。

[0182]

绝大多数的语音合成算法都能够支持音色、语速、多语种的合成。因此,在具体实施过程中,可以兼容不同的语音合成算法,以及根据实际情况的需求选择对应的语音合成算法。

[0183]

在步骤s1430中,口形动画合成。

[0184]

图15示出了应用场景下口形动画生成处理的方法的流程示意图,如图15所示,在步骤s1510中,音素对齐。

[0185]

图16示出了应用场景下音素对齐的方法的流程示意图,如图16所示,在步骤s1610中,特征提取。

[0186]

原始的语音信息为时域波形,这种输入几乎没有描述能力,因此需要对波形做变换,例如提取mfcc(mel frequency cepstrum coefficient,梅尔频率倒谱系数)特征。根据人耳的特性,把每一帧波形转换为一个多维向量,这个过程就是特征提取处理。常用的声学特征除了mfcc特征之外,还可以有plp(perceptual linear prediction,感知线性预测)特征、pitch特征等。

[0187]

其中,mel频率是基于人耳听觉特性提出来的,它与hz(赫兹)频率成非线性对应关系。mel频率倒谱系数(mfcc)则是利用它们之间的这种关系,计算得到的hz频谱特征,mfcc已经广泛地应用在语音识别领域。由于mel频率与hz频率之间非线性的对应关系,使得mfcc随着频率的提高,其计算精度随之下降。因此,在应用中常常只使用低频mfcc,而丢弃中高频mfcc。

[0188]

特征提取处理以帧为单位,在语音处理过程中,通常以一定的帧长和帧移进行分帧。其中,帧长是指每帧的长度,帧移是每两帧开头之间的时延。如果以帧长25ms、帧移10ms进行分帧,则每两帧之间有15ms的重叠。通过特征提取处理可以得到一个m

×

n的矩阵,其中,m表示声学特征的维度,n表示总帧数。

[0189]

在步骤s1620中,声学模型训练。

[0190]

进一步的,可以利用训练好的声学模型确定与声学特征对应的声学状态。

[0191]

声学模型(acoustic modeling)是语音系统中最重要的部分之一,在进行语音识别等过程中,将语音信号转换为声学特征,再利用声学模型确定出声学特征对应的各个声学状态,由各个声学状态组合即可获得因素或者文字。

[0192]

其中,声学状态是构成文字发音的基本单位,通常是指将音素进一步划分获得的更小单位。而音素是发音的最小单元。

[0193]

声学模型的训练就是通过大量的语料得到帧特征和状态对应的概率p(o|s

i

),亦即声学特征与声学状态之间的原始概率值。其中,o是某一帧的特征,s

i

是状态i,某一帧对应的状态就是概率最大的状态。实际中,相邻帧的状态在大多数情况下应该都是相同的,因为每一帧的时间都很短。

[0194]

在步骤s1630中,语音解码和搜索算法。

[0195]

为了达到这个目的,采用hmm(hidden markov model,隐含马尔柯夫模型)构建声学状态网络。除此之外,也可以利用其他模型构建声学状态网络,本示例性实施例对此不做特殊限定。

[0196]

在得到声学状态网络之后,还可以从声学状态网络中进行路径搜索处理得到最佳路径。该最佳路径即为概率最大的路径,并将该路径的概率确定为目标概率值,以此形成声学模型,并用该声学模型表示声学特征与声学状态之间的映射关系。

[0197]

在步骤s1640中,音素与时间轴信息。

[0198]

在训练好声学模型之后,可以利用该声学模型确定将声学特征转换为相应的声学状态。具体的,可以设置多个单位语音信号(例如5个)组成的语音向量对应一个声学状态,亦即若干帧语音对应一个声学状态。

[0199]

由于多个声学状态对应一个音素,因此可以将每三个声学状态组合成一个音素。进一步的,再将该音素结合单帧时长的时间信息得到音素与时间信息对齐的结果。

[0200]

除此之外,口形动画的生成还可以结合文本信息和语音信息,通过语音文本对齐算法得到音素与时间轴对齐的结果。

[0201]

在步骤s1520中,视位映射。

[0202]

语音视位是每个音素发音时对应的口腔形状。某些音素虽然发音不同,但是发音时对应的口形是相同的。举例而言,汉语拼音中的b、p、m就对应同一个语音视位。因此,可以获取到音素与语音视位之间的第一映射关系,以进一步将音素转换为对应的语音视位。

[0203]

通过音素与语音视位之间的第一映射关系可以得到语音视位和时间轴的对应信息。亦即,对于一段语音有一系列对应的语音视位,每个语音视位都对应一个开始时间和一个结束时间。

[0204]

在步骤s1530中,blendshape权重插值。

[0205]

在得到语音视位之后,可以对语音视位和时间信息进行线性插值处理得到对应的口形动画。

[0206]

其中,虚拟网格权重可以是blendshape。blendshape即为基于网格变形实现多个预定义形状网格,通过多个blendshape组合实现变形动画,在maya或者3d max等软件中也被称为morph target。

[0207]

利用虚拟网格权重表示语音视位就是预先按照每个语音视位对应的口形,通过调整blendshape的权重得到对应的口形。一般的,设虚拟数字人模型共有k个blendshape,用每个blendshape权重组成的向量来表示语音视位,记为w=[w0,w1,

…

,w

k

]。

[0208]

具体的,当口形从当前形状切换到下一语音视位时,为了得到流畅平滑的口形动画,在语音视位中确定当前语音视位,并设当前语音视位对应的权重向量为w

current

。

[0209]

在确定当前语音视位之后,还可以在语音视位中确定目标语音视位。进一步的,利用虚拟网络权重表示该目标语音权重,例如w

target

。

[0210]

进一步的,可以对利用虚拟网络权重表示的当前语音视位和目标语音视位进行视位计算,例如求差计算得到视位计算结果。

[0211]

根据时间信息确定单帧时长δt,目标语音视位的结束时间t

end

,从第一帧到当前帧消耗的消耗时间t。进一步的,对单帧时长、结束时间和消耗时长进行求差和除法计算得到对应的时长计算结果。

[0212]

在得到视位计算结果和时长计算结果之后,可以对虚拟网格权重表示的当前语音视位、视位计算结果和时长计算结果进行权重计算,例如求和与乘积计算得到下一帧对应的权重向量,亦即下一网格权重,以在渲染时将每帧的权重设置给相应的blendshape得到平滑的口形动画。

[0213]

在步骤s1440中,表情动画合成。

[0214]

在对语音信息进行表情动画配置时,考虑到虚拟数字人始终有类似真人的微表情,不至于太过呆板,因此可以对应配置默认表情动画。该默认表情动画可以包括眨眼、挑眉和眼球小幅度的转动等。

[0215]

另一方面,考虑到要让虚拟数字人配合语音信息作出开心、惊讶等情绪相关的表情,还可以对应配置触发表情动画。

[0216]

并且,可以预先将需要的默认表情动画和触发表情动画制作好并保存下来,在需要的时候触发渲染即可。值得说明的是,两类表情动画的触发逻辑并不相同。

[0217]

具体的,默认表情动画可以随机触发。每隔一段预设时间,可以从默认表情动画的素材库中随机抽取一个或者若干个默认表情动画作为第一默认动画进行渲染。为了使渲染效果与真人的微表情接近,还可以根据真人眨眼、挑眉和眼球小浮动转动的频率,将预设时间的间隔控制在0.5

‑

4s之间。

[0218]

另外的,对触发表情动画进行第一触发配置可以有文本触发和分值触发两种触发逻辑。

[0219]

第一种,在文本信息中确定第一文本信息,并利用第一文本信息对触发表情动画进行文本触发配置确定触发表情动画中的第一触发动画。

[0220]

第一文本信息可以是文本信息中,用户指定在某个字或者词触发相应的第一触发动画的文本信息。具体的,可以在该第一文本信息处利用#等符号作为标签进行标记,并在该第一文本信息对应的时间信息位置插入对应的第一触发动画,以实现第一触发配置。

[0221]

第二种,对文本信息进行文本情感计算得到情感分值,并利用情感分值对触发表情动画进行分值触发配置确定触发表情动画中的第一触发动画。

[0222]

通过步骤s1450中的nlp进行文本情感计算得到文本信息对应的情感分值,以分析当前的文本信息对应的情绪信息。

[0223]

进一步的,通过情感分值触发对应的第一触发动画的渲染。

[0224]

举例而言,情感分值可以是在

‑

1到1之间的分值。其中,情感分值=0表示中性情绪信息,情感分值>0表示正向情绪信息,情感分值<0表示负向情绪信息。进而,通过与正向情绪信息对应的触发表情动画确定开心、微笑等正向的第一触发动画。

[0225]

基于第一触发配置的触发逻辑,以及考虑到数字虚拟人的表情真实性,可以将需要渲染第一触发动画的位置的第一默认动画替换为第一触发动画,以得到对应的待渲染的表情动画。

[0226]

不仅如此,口形动画和表情动画的生成部分,也可以基于深度学习进行训练,将语音信息转换为完整的脸部动画,包括口形和动画。

[0227]

在步骤s1460中,肢体动画合成。

[0228]

在对语音信息进行肢体动画配置时,考虑到虚拟数字人始终有类似真人的肢体动画才更加真实,因此可以对应配置默认肢体动画。该默认肢体动画可以包括呼吸、身体小幅度的摆动等。

[0229]

另一方面,考虑到要让虚拟数字人配合语音信息作出招手、鞠躬、比心等文本相关的动作,还可以对应配置触发肢体动画。

[0230]

更进一步的,根据虚拟数字人的应用场景,也可以提前制作相关的默认肢体动画和触发肢体动画,并进行分类和保存,在需要的时候触发渲染即可。值得说明的是,两类肢体动画的触发逻辑并不相同。

[0231]

默认肢体动画可以随机触发,并且持续循环播放。每隔一段预设时间,可以从默认肢体动画的素材库中抽取一个或者若干个默认肢体动画作为第二默认动画进行渲染。并且该预设时间间隔也可以按照实际情况的需求进行设置,本示例性实施例对此不做特殊限定。

[0232]

另外的,对触发肢体动画进行第二触发配置的方式可以有文本触发和语义触发两种触发逻辑。

[0233]

第一种,在文本信息中确定第二文本信息,并利用第二文本信息对触发肢体动画进行标签触发配置确定触发肢体动画中的第二触发动画。

[0234]

第二文本信息可以是文本信息中,用户指定在某个字或者词触发相应的第二触发动画的文本信息。具体的,可以在该第一文本信息处利用#等符号作为标签进行标记,并在该第二文本信息对应的时间信息位置插入对应的第二触发动画,以实现第二触发配置。

[0235]

第二种,通过步骤s1450中的nlp进行语义分析处理得到表征文本信息的语义的语义信息,以分析当前的文本信息对应的内容,从而触发相应的第二触发动画。

[0236]

举例而言,当语义信息表征“打招呼”的语义时,可以确定第二触发动画中打招呼的肢体动画为第二触发动画。

[0237]

基于第二触发配置的触发逻辑,以及考虑到数字虚拟人的肢体真实性,可以将需要渲染第二触发动画的位置的第二默认动画替换为第二触发动画,以得到对应的待渲染的肢体动画。

[0238]

在步骤s1470中,数字人模型及动画渲染。

[0239]

在得到口形动画、表情动画和肢体动画之后,可以将虚拟数字人的口型动画、表情动画和肢体动画与对应的时间信息同步渲染,以得到完整的虚拟数字人动画。虚拟数字人在播报用户输入的文本信息或者语音信息的同时,能够协调搭配合适的表情动画和肢体动画。

[0240]

在本公开的应用场景中,根据语音信息生成渲染虚拟数字人的口形动画、表情动画和肢体动画,并根据口形动画、表情动画和肢体动画对虚拟数字人进行同步渲染。一方面,减少渲染虚拟数字人过程中的人工参与度,提升虚拟数字人动画内容的生成速度和效率;另一方面,虚拟数字人的动画能够即时生成,无需根据新形象的虚拟数字人重新训练算法,丰富了虚拟数字人的应用场景。

[0241]

此外,在本公开的示例性实施例中,还提供一种动画生成装置。图17示出了动画生成装置的结构示意图,如图17所示,动画生成装置1700可以包括:信息获取模块1710、动画生成模块1720和同步渲染模块1730。

[0242]

其中:

[0243]

信息获取模块1710,被配置为获取制作好的虚拟数字人,并获取虚拟数字人播报的语音信息;动画生成模块1720,被配置为对语音信息进行口形动画生成处理得到口形动画,并对语音信息进行表情动画生成处理得到表情动画;同步渲染模块1730,被配置为对语音信息进行肢体动画生成处理得到肢体动画,并根据口形动画、表情动画和肢体动画对所述虚拟数字人进行同步渲染。

[0244]

在本发明的一种示例性实施例中,对语音信息进行口形动画生成处理得到口形动画,包括:

[0245]

对语音信息进行音素转换处理得到与时间信息对齐的音素,并对音素进行视位转换处理得到与时间信息对齐的语音视位;

[0246]

对语音视位和时间信息进行线性插值处理得到口形动画。

[0247]

在本发明的一种示例性实施例中,对语音信息进行音素转换处理得到与时间信息对齐的音素,包括:

[0248]

对语音信息进行特征提取处理得到声学特征和单帧时长,并利用训练好的声学模型确定与声学特征对应的声学状态;

[0249]

对声学状态进行组合处理得到音素,并利用单帧时长对音素进行对齐处理得到与单帧时长的时间信息对齐的音素。

[0250]

在本发明的一种示例性实施例中,训练好的声学模型按照如下方式进行训练:

[0251]

对语音样本进行训练得到声学特征与声学状态之间的原始概率值,并对原始概率值进行语音解码处理得到声学状态网络;

[0252]

对声学状态网络进行路径搜索处理得到目标概率值,以得到表示声学特征与声学状态的映射关系的声学模型。

[0253]

在本发明的一种示例性实施例中,对音素进行视位转换处理得到与时间信息对齐的语音视位,包括:

[0254]

获取音素与语音视位之间的第一映射关系;

[0255]

基于第一映射关系,对音素进行视位转换处理得到与时间信息对齐的语音视位。

[0256]

在本发明的一种示例性实施例中,对语音视位和时间信息进行线性插值处理得到口形动画,包括:

[0257]

在语音视位中确定当前语音视位,并利用虚拟网格权重表示当前语音视位;

[0258]

对虚拟网格权重表示的当前语音视位和时间信息进行线性插值处理得到口形动画。

[0259]

在本发明的一种示例性实施例中,对虚拟网格权重表示的当前语音视位和时间信息进行线性插值处理得到口形动画,包括:

[0260]

利用虚拟网格权重表示语音视位中的目标语音视位,对虚拟网格权重表示的当前语音视位和虚拟网格权重表示的目标语音视位进行视位计算得到视位计算结果;

[0261]

根据时间信息确定单帧时长、目标语音视位的结束时间以及与当前语音视位对应

的消耗时长,并对单帧时长、结束时间和消耗时长进行时长计算得到时长计算结果;

[0262]

对虚拟网格权重表示的当前语音视位、视位计算结果和时长计算结果进行权重计算得到下一网格权重,以根据下一网格权重确定待渲染的口形动画。

[0263]

在本发明的一种示例性实施例中,获取所述虚拟数字人播报的语音信息,包括:

[0264]

获取虚拟数字人播报的文本信息;

[0265]

对文本信息进行合成语音转换处理得到语音信息。

[0266]

在本发明的一种示例性实施例中,对语音信息进行表情动画生成处理得到表情动画,包括:

[0267]

对语音信息进行表情动画配置得到默认表情动画和触发表情动画;

[0268]

以预设时间为间隔设置默认表情动画中的第一默认动画,并对触发表情动画进行第一触发配置确定触发表情动画中的第一触发动画;

[0269]

基于第一触发配置,利用第一触发动画替换第一默认动画,得到待渲染的表情动画。

[0270]

在本发明的一种示例性实施例中,对触发表情动画进行第一触发配置确定触发表情动画中的第一触发动画,包括:

[0271]

在文本信息中确定第一文本信息,并利用第一文本信息对触发表情动画进行文本触发配置确定所述触发表情动画中的第一触发动画;和/或

[0272]

对文本信息进行文本情感计算得到情感分值,并利用情感分值对触发表情动画进行分值触发配置确定触发表情动画中的第一触发动画。

[0273]

在本发明的一种示例性实施例中,对语音信息进行肢体动画生成处理得到肢体动画,包括:

[0274]

对语音信息进行肢体动画配置得到默认肢体动画和触发肢体动画;

[0275]

以预设时间为间隔设置默认肢体动画中的第二默认动画,并对触发肢体动画进行第二触发配置确定触发肢体动画中的第二触发动画;

[0276]

基于第二触发配置,利用第二触发动画替换第二默认动画,得到待渲染的肢体动画。

[0277]

在本发明的一种示例性实施例中,对触发肢体动画进行第二触发配置确定触发肢体动画中的第二触发动画,包括:

[0278]

在文本信息中确定第二文本信息,并利用第二文本信息对触发肢体动画进行标签触发配置确定触发肢体动画中的第二触发动画;和/或

[0279]

对文本信息进行语义分析处理得到语义信息,并利用语义信息对触发肢体动画进行语义触发配置确定触发肢体动画中的第二触发动画。

[0280]

上述动画生成装置1700的具体细节已经在对应的动画生成方法中进行了详细的描述,因此此处不再赘述。

[0281]

应当注意,尽管在上文详细描述中提及动画生成装置1700的若干模块或者单元,但是这种划分并非强制性的。实际上,根据本公开的实施方式,上文描述的两个或更多模块或者单元的特征和功能可以在一个模块或者单元中具体化。反之,上文描述的一个模块或者单元的特征和功能可以进一步划分为由多个模块或者单元来具体化。

[0282]

此外,在本公开的示例性实施例中,还提供了一种能够实现上述方法的电子设备。

[0283]

下面参照图18来描述根据本发明的这种实施例的电子设备1800。图18显示的电子设备1800仅仅是一个示例,不应对本发明实施例的功能和使用范围带来任何限制。

[0284]

如图18所示,电子设备1800以通用计算设备的形式表现。电子设备1800的组件可以包括但不限于:上述至少一个处理单元1810、上述至少一个存储单元1820、连接不同系统组件(包括存储单元1820和处理单元1810)的总线1830、显示单元1840。

[0285]

其中,所述存储单元存储有程序代码,所述程序代码可以被所述处理单元1810执行,使得所述处理单元1810执行本说明书上述“示例性方法”部分中描述的根据本发明各种示例性实施例的步骤。

[0286]

存储单元1820可以包括易失性存储单元形式的可读介质,例如随机存取存储单元(ram)1821和/或高速缓存存储单元1822,还可以进一步包括只读存储单元(rom)1823。

[0287]

存储单元1820还可以包括具有一组(至少一个)程序模块1825的程序/实用工具1824,这样的程序模块1825包括但不限于:操作系统、一个或者多个应用程序、其它程序模块以及程序数据,这些示例中的每一个或某种组合中可能包括网络环境的实现。

[0288]

总线1830可以为表示几类总线结构中的一种或多种,包括存储单元总线或者存储单元控制器、外围总线、图形加速端口、处理单元或者使用多种总线结构中的任意总线结构的局域总线。

[0289]

电子设备1800也可以与一个或多个外部设备2000(例如键盘、指向设备、蓝牙设备等)通信,还可与一个或者多个使得用户能与该电子设备1800交互的设备通信,和/或与使得该电子设备1800能与一个或多个其它计算设备进行通信的任何设备(例如路由器、调制解调器等等)通信。这种通信可以通过输入/输出(i/o)接口1850进行。并且,电子设备1800还可以通过网络适配器1860与一个或者多个网络(例如局域网(lan),广域网(wan)和/或公共网络,例如因特网)通信。如图所示,网络适配器1860通过总线1830与电子设备1800的其它模块通信。应当明白,尽管图中未示出,可以结合电子设备1800使用其它硬件和/或软件模块,包括但不限于:微代码、设备驱动器、冗余处理单元、外部磁盘驱动阵列、raid系统、磁带驱动器以及数据备份存储系统等。

[0290]

通过以上的实施例的描述,本领域的技术人员易于理解,这里描述的示例实施例可以通过软件实现,也可以通过软件结合必要的硬件的方式来实现。因此,根据本公开实施例的技术方案可以以软件产品的形式体现出来,该软件产品可以存储在一个非易失性存储介质(可以是cd

‑

rom,u盘,移动硬盘等)中或网络上,包括若干指令以使得一台计算设备(可以是个人计算机、服务器、终端装置、或者网络设备等)执行根据本公开实施例的方法。

[0291]

在本公开的示例性实施例中,还提供了一种计算机可读存储介质,其上存储有能够实现本说明书上述方法的程序产品。在一些可能的实施例中,本发明的各个方面还可以实现为一种程序产品的形式,其包括程序代码,当所述程序产品在终端设备上运行时,所述程序代码用于使所述终端设备执行本说明书上述“示例性方法”部分中描述的根据本发明各种示例性实施例的步骤。

[0292]

参考图19所示,描述了根据本发明的实施例的用于实现上述方法的程序产品1900,其可以采用便携式紧凑盘只读存储器(cd

‑

rom)并包括程序代码,并可以在终端设备,例如个人电脑上运行。然而,本发明的程序产品不限于此,在本文件中,可读存储介质可以是任何包含或存储程序的有形介质,该程序可以被指令执行系统、装置或者器件使用或者

与其结合使用。

[0293]

所述程序产品可以采用一个或多个可读介质的任意组合。可读介质可以是可读信号介质或者可读存储介质。可读存储介质例如可以为但不限于电、磁、光、电磁、红外线、或半导体的系统、装置或器件,或者任意以上的组合。可读存储介质的更具体的例子(非穷举的列表)包括:具有一个或多个导线的电连接、便携式盘、硬盘、随机存取存储器(ram)、只读存储器(rom)、可擦式可编程只读存储器(eprom或闪存)、光纤、便携式紧凑盘只读存储器(cd

‑

rom)、光存储器件、磁存储器件、或者上述的任意合适的组合。

[0294]

计算机可读信号介质可以包括在基带中或者作为载波一部分传播的数据信号,其中承载了可读程序代码。这种传播的数据信号可以采用多种形式,包括但不限于电磁信号、光信号或上述的任意合适的组合。可读信号介质还可以是可读存储介质以外的任何可读介质,该可读介质可以发送、传播或者传输用于由指令执行系统、装置或者器件使用或者与其结合使用的程序。

[0295]

可读介质上包含的程序代码可以用任何适当的介质传输,包括但不限于无线、有线、光缆、rf等等,或者上述的任意合适的组合。

[0296]

可以以一种或多种程序设计语言的任意组合来编写用于执行本发明操作的程序代码,所述程序设计语言包括面向对象的程序设计语言

‑

诸如java、c 等,还包括常规的过程式程序设计语言

‑

诸如“c”语言或类似的程序设计语言。程序代码可以完全地在用户计算设备上执行、部分地在用户设备上执行、作为一个独立的软件包执行、部分在用户计算设备上部分在远程计算设备上执行、或者完全在远程计算设备或服务器上执行。在涉及远程计算设备的情形中,远程计算设备可以通过任意种类的网络,包括局域网(lan)或广域网(wan),连接到用户计算设备,或者,可以连接到外部计算设备(例如利用因特网服务提供商来通过因特网连接)。

[0297]

本领域技术人员在考虑说明书及实践这里公开的发明后,将容易想到本公开的其他实施例。本技术旨在涵盖本公开的任何变型、用途或者适应性变化,这些变型、用途或者适应性变化遵循本公开的一般性原理并包括本公开未公开的本技术领域中的公知常识或惯用技术手段。说明书和实施例仅被视为示例性的,本公开的真正范围和精神由权利要求指出。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。