1.本发明属于计算机视觉风格迁移领域,具体涉及一种通过位姿自监督对抗生成网络对图片进行风格迁移。

背景技术:

2.图像风格迁移赋予了机器人对环境更高层次的理解,帮助机器人适应不同的场景。因此,在一个场景上训练或配置的任务,通过这种迁移学习可以很容易地在其他场景上进行。这种设置对多种机器人任务极有帮助,例如将在晴天训练的探测器转移到雨夜,以及地点重识别,和跨领域的语义分割。

3.目前,在图像风格迁移网络的的训练过程中,大多数工作集中在完全配对的图像风格迁移或完全未配对的图像风格迁移。在配对图像迁移中,来自两个风格的两个图像的内容是完全相同的。为了处理这个任务,pix2pix提出了一个基于生成对抗网络(gan)的解决方案,并取得了良好的性能。然而,在大多数机器人应用中,获得完全配对的数据是不现实的。为了解决这个问题,cyclegan 能够用未配对的图像训练风格转移模型,然而其缺点也是显而易见的,主要是以下两方面:(1)学习到的内容和风格之间的界限可能是模糊的,导致风格迁移的失败,因为这些无监督的方法忽略了监督方法所带来的准确性;(2)大量使用循环一致性导致训练的困难。

4.然而,介于完全配对和完全未配对的数据之间有一个中间的可利用领域,可以弥补上述的缺陷。在机器人任务中,通过各种类型的传感器,即使很难收集到完全配对的数据,但收集到有大量重叠的数据是可行的,本发明将其称为弱配对数据。由于机器人采集的数据一般是图像,因此对于机器人传感器采集数据,弱配对数据即弱配对图像。考虑到弱配对数据的定义,在弱配对数据上训练的风格迁移器可以有效提升不同域之间的机器人任务的完成度。

5.对于已配对的数据,两张具有不同风格的图片,有完美的对齐内容。对于未配对的数据,两张图片在数据中是不相关的。对于弱配对的数据,内容相似,但在位姿上错位。由于机器人携带多传感器来感知几何测量,不同风格的图像的粗略对齐是合理的,因此,我们认为这样的设定是值得处理的。

6.我们将弱配对图像风格迁移表述为利用原始图像i

o

对目标图像i

t

进行生成的过程。

7.i

t

=t(f(i

o

),ξ)

8.其中f和t是风格迁移过程,以及图像的几何变换过程,ξ是两幅图像之间的相对位姿,它是t的参数。

9.弱配对数据风格迁移的目的是学习一个网络n

t

,从数据集i

o

,i

t

中近似f,从而用n

t

迁移原始图像。这个问题的挑战在于如何保持所学函数n

t

只迁移风格,而不改变原始图像的位姿。简单地学习两个图像之间的网络n

t

显然会导致风格、位姿和内容纠缠在一起。另一方面,将图像对视为未配对,并没有利用有界的ξ的信息,留下了很大的改进空间。抛开成对

图像的完全监督方法,无监督方法很容易被弱配对图像之间复杂的相对位姿所迷惑,并错过了像素级对应所带来的优势。

技术实现要素:

10.本发明的目的在于解决现有技术中风格迁移时无法迁移风格,而不改变原始图像位姿的问题,并提供一种基于位姿自监督对抗生成网络的弱配对图像风格迁移方法。

11.为了解决弱配对图像风格迁移,本发明中提出了随机位姿估计的对抗神经网络(pregan)。gan的平衡点是生成数据的分布与目标数据的分布之间的匹配。通过利用位姿注入和位姿恢复作为域随机化和自我监督,生成式对抗过程有望对位姿不敏感,并专注于风格的学习。

12.本发明所采用的具体技术方案如下:

13.一种基于位姿自监督对抗生成网络的弱配对图像风格迁移方法,其步骤如下:

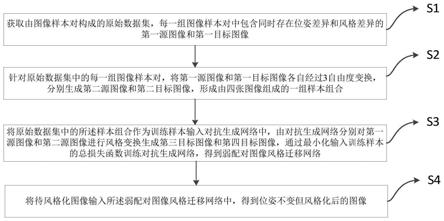

14.s1、获取由图像样本对构成的原始数据集,每一组图像样本对中包含同时存在位姿差异和风格差异的第一源图像o1和第一目标图像t1;

15.s2、针对原始数据集中的每一组图像样本对,将第一源图像o1和第一目标图像t1各自经过3自由度变换p

r

,分别生成第二源图像o2和第二目标图像t2,形成由四张图像组成的一组样本组合;所述3自由度变换p

r

中包含随机生成的横竖平移以及旋转三种位姿变换,且同一组图像样本对中的第一源图像o1和第一目标图像t1所采用的3自由度变换p

r

保持相同;

16.s3、将原始数据集中的所述样本组合作为训练样本输入对抗生成网络中,由对抗生成网络分别对第一源图像o1和第二源图像o2进行风格变换生成第三目标图像faket1和第四目标图像gaket2,通过最小化输入训练样本的总损失函数训练对抗生成网络,得到弱配对图像风格迁移网络;

17.所述总损失函数中,单个训练样本的损失函数l由三部分组成:

18.l=l

d

l

s

l

m

19.其中第一部分损失l

d

=(t1‑

faket1) (t2‑

faket2),第二部分损失 l

s

=p3‑

p4,第三部分损失l

m

=p

r

‑

p

e

;

20.式中:p3为第三目标图像faket1与第一目标图像t1之间的相对位姿,p4为第四目标图像faket2与第二目标图像t2之间的相对位姿,p

e

为第三目标图像faket1与第四目标图像faket2之间的相对位姿;

21.s4、将待风格化图像输入所述弱配对图像风格迁移网络中,得到位姿不变但风格化后的图像。

22.作为优选,所述原始数据集中的图像均为机器人运行路径上的鸟瞰图。

23.进一步的,所述原始数据集的构建方法如下:

24.在第一图像采集环境下,在机器人运行路径上的随机地点a采集第一鸟瞰图;然后在与第一图像采集环境不同的第二图像采集环境下,对随机地点a施加随机平移得到随机地点b,通过对采集视角随机施加水平旋转后再次对随机地点b采集第二鸟瞰图,然后将采集的第一鸟瞰图和第二鸟瞰图分别作为第一源图像o1和第一目标图像t1,从而构成一组图像样本对;不断重复,将得到的一系列图像样本对构建为原始数据集。

25.进一步的,所述第一图像采集环境和第二图像采集环境之间的差别为天气不同或

采集图像所用传感器不同。

26.进一步的,所述原始数据集通过在仿真环境中获取鸟瞰图构建。

27.作为优选,任意两个图像之间的所述相对位姿由可微分的位姿求解器进行求解。

28.作为优选,所述可微分的位姿求解器包含8个不同的u

‑

net网络,在可微分的位姿求解器中对第一图像和第二图像进行图像位姿估计的步骤如下:

29.s101:以预先经过训练的第一u

‑

net网络和第二u

‑

net网络作为两个特征提取器,分别以第一图像和第二图像作为两个特征提取器各自的原始输入图片,提取两张原始输入图片中的同构特征,得到同构的第一特征图和第二特征图;

30.s102:将s101中得到的第一特征图和第二特征图分别进行傅里叶变换后取各自的幅度谱;

31.s103:将s102中得到的两个幅度谱分别进行对数极坐标变换,使其从笛卡尔坐标系转换到对数极坐标系中,从而使两个幅度谱之间笛卡尔坐标系下的旋转变换被映射成对数极坐标系中y方向上的平移变换;

32.s104:将s103中两个坐标变换后的幅度谱进行相位相关求解,得到二者之间的平移变换关系,再按照s103中笛卡尔坐标系和对数极坐标系之间的映射关系重新转换,得到所述第一图像和所述第二图像之间的旋转变换关系;

33.s105:以预先经过训练的第三u

‑

net网络和第四u

‑

net网络作为两个特征提取器,分别以第一图像和第二图像作为两个特征提取器各自的原始输入图片,提取两张原始输入图片中的同构特征,得到同构的第三特征图和第四特征图;

34.s106:将s105中得到的第三特征图和第四特征图分别进行傅里叶变换后取各自的幅度谱;

35.s107:将s106中得到的两个幅度谱分别进行对数极坐标变换,使其从笛卡尔坐标系转换到对数极坐标系中,从而使两个幅度谱之间笛卡尔坐标系下的缩放变换被映射成对数极坐标系中x方向上的平移变换;

36.s108:将s107中两个坐标变换后的幅度谱进行相位相关求解,得到二者之间的平移变换关系,再按照s107中笛卡尔坐标系和对数极坐标系之间的映射关系重新转换,得到所述第一图像和所述第二图像之间的缩放变换关系;

37.s109:将所述第二图像按照s104和s108中得到的旋转变换关系和缩放变换关系进行对应的旋转和缩放变换,得到一张新的第二图像;

38.s1010:以预先经过训练的第五u

‑

net网络和第六u

‑

net网络作为两个特征提取器,分别以第一图像和新的第二图像作为两个特征提取器各自的原始输入图片,提取两张原始输入图片中的同构特征,得到同构的第五特征图和第六特征图;

39.s1011:将s1010中得到的第五特征图和第六特征图进行相位相关求解,得到所述第一图像和所述第二图像之间的x方向上的平移变换关系;

40.s1012:以预先经过训练的第七u

‑

net网络和第八u

‑

net网络作为两个特征提取器,分别以第一图像和新的第二图像作为两个特征提取器各自的原始输入图片,提取两张原始输入图片中的同构特征,得到同构且仅保留有原始输入图片之间的平移变换关系的第七特征图和第八特征图;

41.s1013:将s1012中得到的第七特征图和第八特征图进行相位相关求解,得到所述

第一图像和所述第二图像之间的y方向上的平移变换关系,完成第一图像和第二图像之间包含旋转、缩放和平移三种变换关系的相对位姿估计。

42.进一步的,所述可微分的位姿求解器中,8个u

‑

net网络均预先进行训练,训练的总损失函数为所述第一图像和第二图像之间的旋转变换关系损失、缩放变换关系损失、x方向上的平移变换关系损失和y方向上的平移变换关系损失的加权和。

43.作为优选,所述的原始数据集分批次输入对抗生成网络中进行训练。

44.作为优选,所述对抗生成网络在训练过程中利用adam优化器进行梯度下降以优化网络参数。

45.本发明相对于现有技术而言,具有以下有益效果:

46.首先,本发明适用于弱配对图像的风格迁移,其利用有一定重叠的不同风格图片进行对抗神经网络的模型训练,使其对位姿不敏感并专注于风格的学习,由此在实际应用过程中可以将源风格转换为目标风格但保持位姿不变,实现弱配对数据的风格迁移,为机器人自定位技术提供支撑。

47.其次,本发明在上述对抗神经网络的模型训练过程中,引入了一种能够对任意两张图像的相对位姿进行估计的可微分的位姿求解器。该可微分的位姿求解器将相位相关算法优化为为可微分,并将其嵌入到端到端学习网络框架中实现位姿估计。该可微分的位姿求解器能够针对图像匹配的结果找到最优的特征提取器,不需要详尽的评估就能得到解,又具有良好的可解释性和泛化能力。

附图说明

48.图1为本方法的步骤分解图。

49.图2为本方法的网络流程图。

50.图3为弱配对图像与完全配对图像、未配对图像的对比。

51.图4为采用该方法进行图像风格迁移的效果图。

52.图5为可微分的位姿求解器结构示意图。

具体实施方式

53.下面结合附图和具体实施方式对本发明做进一步阐述和说明。本发明中各个实施方式的技术特征在没有相互冲突的前提下,均可进行相应组合。

54.如图1所示,本发明提供了一种基于位姿自监督对抗生成网络的弱配对图像风格迁移方法,其步骤如下:

55.s1、获取由一系列图像样本对构成的原始数据集,每一组图像样本对中由两张同时存在位姿差异和风格差异的图像组成,分别为第一源图像o1和第一目标图像t1。原始数据集中的图像样本对数量应满足后续的网络训练要求,具体根据实际进行调整。

56.s2、为了满足后续的训练需求,针对原始数据集中的每一组图像样本对进行一个位姿变换操作,具体做法为:对于每一组图像样本,将其中的第一源图像o1和第一目标图像t1各自经过一个3自由度变换p

r

,第一源图像o1经过3自由度变换 p

r

后生成的图像记为第二源图像o2,第一目标图像t1经过3自由度变换p

r

后生成的图像记为第二目标图像t2,由此第一源图像o1、第一目标图像t1、第二源图像 o2和第二目标图像t2一起形成了由四张图像组

成的一组样本组合。原始数据集中的每一组图像样本对均进行这样的位姿变换操作后,原始数据集被扩展成了包含一系列样本组合的数据集。

57.需要注意的是,上述3自由度变换p

r

应当包含3个不同的自由度,分别为两个平移自由度和一个旋转自由度,而且为了保证模型训练的可靠性,这些施加的变换应当使随机的。即3自由度变换p

r

包含了随机生成的横竖平移以及旋转三种位姿变换。而且,同一组图像样本对中的第一源图像o1和第一目标图像t1所采用的3自由度变换p

r

应当保持相同,即随机生成一个3自由度变换p

r

后将其同时应用于第一源图像o1和第一目标图像t1上。但是由于3自由度变换p

r

是随机生成的,因此不同的图像样本对中所施加的3自由度变换p

r

一般是不同的。

58.经过上述s2的操作,输入的第一源图像o1和第一目标图像t1经过统一的随机生成的横竖平移、以及旋转这3自由度变换p

r

,得到了第二源图像o2以及第二目标图像t2。此时对于任意一个样本组合,第一源图像o1与第二源图像o2风格一致,第一目标图像t1与第二目标图像t2风格一致。假设第一源图像o1与第一目标图像t1之间的相对位姿为p1,输入的第一源图像o1与第一目标图像t1之间的相对位姿p1是未知的。第二源图像o2与第二目标图像t2之间的相对位姿为p2,则 p1=p2。而且由于施加的3自由度变换是相同的,因此第一源图像o1与第二源图像o2、第一目标图像t1与第二目标图像t2之间的相对位姿均为p

r

。可依据这些样本组合中四个图像之间的风格和位姿差异特性,对后续的对抗生成网络进行训练,使其专注于识别风格而不会改变位姿。

59.s3、将原始数据集中的样本组合作为训练样本,按照设定的训练方式输入对抗生成网络(gan)中,对于每一个训练样本而言,当其输入对抗生成网络后由对抗生成网络分别对第一源图像o1和第二源图像o2进行风格变换,并对应的由第一源图像o1生成第三目标图像faket1,由第二源图像o2生成第四目标图像 faket2,通过最小化输入训练样本的总损失函数训练对抗生成网络,得到弱配对图像风格迁移网络。

60.在对抗生成网络中,第一源图像o1和第二源图像o2作为内容图像,而第三目标图像faket1和第四目标图像faket2则作为风格图像。对抗生成网络是一种深度学习模型,其通过两个模块即生成模型(generative model)和判别模型 (discriminative model)的互相博弈学习产生满足要求的输出,具体结构属于现有技术,对此不再赘述。

61.训练样本的总损失函数由输入对抗生成网络的所有训练样本的损失加和得到。本发明中,优选将原始数据集分批次输入对抗生成网络中进行迭代训练,在每一轮训练过程中利用adam优化器进行梯度下降以优化网络参数。因此,总损失函数值为每一轮输入的所有训练样本的损失值之和。

62.整个对抗生成网络的结构和训练过程可参见图2所示,对于单个训练样本而言,其损失函数l由三部分构成,分别详细描述如下:

63.1)将第一源图像o1和第二源图像o2同时经过用来进行风格变换的对抗生成网络gan后得到第三目标图像faket1和第四目标图像faket2,因此理论上来讲,此时第三目标图像faket1、第四目标图像faket2中的图像中内容的位姿应当与第一源图像o1和第二源图像o2相同,但他们内容的风格应当与第一目标图像t1、第二目标图像t2的风格一致。由此得到第一部分损失是第一目标图像t1和第三目标图像faket1的误差损失与第二目标图像t2和第四目标图像faket2的误差损失之和,公式如下:

64.l

d

=(t1‑

faket1) (t2‑

faket2)

65.2)为了训练上述对抗生成神经网络,使之可以合理的将第一源图像o1和第二源图像o2的风格转换成第一目标图像t1、第二目标图像t2的风格,而不受复杂位姿的干扰,可求解出第三目标图像faket1与第一目标图像t1之间的相对位姿p3以及第三目标图像faket2与第二目标图像t2之间的相对位姿p4。此时,若对抗生成神经网络能够成功的转换风格而不受位姿变换的干扰的话,理论上p3=p4。由此得到第二部分损失是两组目标图像间相对位姿的误差损失,公式如下:

66.l

s

=p3‑

p467.式中:p3为第三目标图像faket1与第一目标图像t1之间的相对位姿,p4为第四目标图像faket2与第二目标图像t2之间的相对位姿

68.3)即使p1是未知的,但是对每一组图像样本对随机生成的p

r

是已知的,即o1与o2,t1与t2,faket1与faket2之间的相对位姿都应该为p

r

。若faket1与faket2之间的相对位姿p

e

仍等于p

r

则说明该对抗神经网络抵抗掉了o1与t1,o2与t2之间的相对位姿的干扰。由此得到了第三部分损失为:

69.l

m

=p

r

‑

p

e

70.式中:p

e

为第三目标图像faket1与第四目标图像faket2之间的相对位姿。

71.最终单个训练样本的损失函数l由三部分组成:

72.l=l

d

l

s

l

m

73.经过上述损失函数下的网络训练,待其训练完毕后即可用对抗生成网络作为弱配对图像风格迁移网络,执行配对图像的风格迁移任务。

74.s4、将待风格化图像输入上述训练得到的弱配对图像风格迁移网络中,得到位姿不变但风格化后的图像。

75.上述s1~s4的方法理论上可应用于任意的弱配对图像的风格迁移工作中,使得内容图像被风格化的同时保证图像位姿不变。其中一个有价值的应用场景是对机器人上搭载的传感器采集图像进行风格化。下面对该具体场景中上述方法的应用进行详细展开描述,以便于理解。

76.机器人移动过程中,需要融合多传感器获取的不同数据对环境进行理解。但机器人上搭载的传感器采集的图像受限于传感器类型或者环境中光线、干扰物等因素的影响,必然存在多种多样的风格差异或者位姿差异。因此,需要通过图像风格迁移学习赋予了机器人对周边环境的深层理解,帮助机器人适应不同的场景变换,使得在一个场景上训练或配置的机器人任务能够适用于其他场景。

77.图3显示了完全配对、未配对以及本发明所提出的弱配对图像的一个典型例子,其中左侧部分的三组图像中,上方一组为完全匹配数据,中间一组和下方一组为无匹配数据,右侧部分的s1.a~s1.c、s2.a~s2.c、s2.a~s2.c为弱配对数据从图中可以看到,对于已配对的数据,两张具有不同风格的图片,有完美的对齐内容。对于未配对的数据,两张图片在数据中是不相关的。对于弱配对的数据,内容相似,但在位姿上错位。上述s1~s4所描述的方法,能够学习一个对抗生成网络对原始图像进行迁移,而且该迁移过程中只迁移风格,而不改变原始图像的位姿。

78.在机器人自定位任务中,机器人移动过程中需要获取的一种典型图像为机器人运

行路径上的鸟瞰图。因此,本发明中原始数据集中的图像可以是机器人运行路径上的鸟瞰图,通过上述弱配对图像风格迁移形成获得位姿不变但风格化的图像,使得机器人能够通过训练适应不同的环境。对于鸟瞰图而言,原始数据集的构建方法可以采用如下步骤实现:

79.(1)首先,在第一图像采集环境下,在机器人运行路径上的随机地点a采集第一鸟瞰图;

80.(2)然后在与第一图像采集环境不同的第二图像采集环境下,对随机地点 a施加随机平移得到随机地点b,通过对采集视角随机施加水平旋转后再次对随机地点b采集第二鸟瞰图;

81.(3)最后,然后将采集的第一鸟瞰图和第二鸟瞰图分别作为第一源图像o1和第一目标图像t1,从而构成一组图像样本对。

82.不断重复上述(1)~(3)过程,即可得到一系列图像样本对,进而构建为原始数据集。

83.需要注意的是,上述第一图像采集环境和第二图像采集环境之间的差别可以是多样的,一般可以设置为天气不同或采集图像所用传感器不同。例如,在图4 中给出了五种不同的差别设置形式下得到的五组图像样本对,从上到下分别为:1)双目视图迁移至无人机视角(传感器不同);2)激光雷达迁移至无人机视角 (传感器不同);3)雾天迁移至晴天(天气不同);4)夜晚迁移至晴天(天气不同);5)雨天迁移至晴天(天气不同)。

84.由于在真实场景中此类数据获取存在困难,因此本发明优选在仿真环境中进行仿真,以此来获取鸟瞰图构建成为原始数据集。仿真的优点在于能够无限制的获取大量的样本对,提高模型的训练精度。

85.当然,鸟瞰图仅仅是其中一种图像形式,本发明亦可以用于其他类型的图像弱配对图像风格迁移任务中,对此不做限定。

86.另外,上述损失函数l计算过程中,相对位姿p3、p4、p

e

均需要通过估计得到,并不能直接进行计算,此类估计可以通过可微分的位姿求解器实现。

87.在本发明的一个较佳实施例中,进一步提供了对任意两个图像之间的相对位姿进行求解的一种可微分的位姿求解器,其本质是一种可微分的相位相关算法。相位相关是一种基于相似性的匹配器,它对具有相同模态的输入表现良好,但只能在小的高频噪声情况下完成匹配。我们将相位相关算法优化为为可微分,并将其嵌入到我们的端到端学习网络框架中,形成可微分的位姿求解器。这种架构使得我们的系统能够针对图像匹配的结果找到最优的特征提取器。具体来说,本发明采用了传统的相位相关,并赋予快速傅里叶变换层(fft)、对数极性变换层 (lpt)和相位相关层(dc)以可微分性质,从而使其可用于端到端可微分的位姿求解器的训练。

88.如图5所示,该可微分的位姿求解器包含8个不同的u

‑

net网络,为了便于描述将需要进行相对位姿求解的两个图像记为第一图像sample1和第二图像 sample2,这两张图像存在内容差异和位姿差异,因此属于异构图像。其核心是 8个独立的u

‑

net网络以及傅里叶变换层(fft)、对数极性变换层(lpt)和相位相关层(dc),该可微分的位姿求解器的输入是上述异构的第一图像和第二图像,其最终输出是第一图像和第二图像之间的三种位姿变换关系,即平移、旋转和缩放。

89.在可微分的位姿求解器中对第一图像和第二图像进行图像位姿估计的步骤如下:

90.在传统的相位相关算法中,利用高通滤波器来抑制两个输入的随机随机噪声,而这一过程可以看作是一个特征提取器。但是对于一对输入的异构图像而言,两者之间存在比较明显的变化,一个高通滤波器是远远不够的。考虑到没有共同的特征来直接监督特征提取器,本发明利用端到端学习来解决这个问题。本发明中对第一图像和第二图像在旋转缩放阶段和平移阶段分别构建了8个独立的可训练u

‑

net网络(记为u

‑

net1~u

‑

net8),这8个u

‑

net网络在平移、旋转和缩放三类损失的监督下预先经过训练后,能够从异构图像中提取出图片中的同构特征即共同特征,从而估计出将两张异构图像转换为两张同构的特征图所需的相对位姿。本发明中,假如仅设4个u

‑

net网络,那么旋转与缩放两种变换的求解需要被偶合起来的,x方向平移与y方向平移的求解也需要被偶合起来,这样训练得到的特征提取器所提取的特征存在效果不佳的情况;因此,我们将旋转、缩放、 x平移、y平移解耦,分别训练各自的u

‑

net网络,一共得到8个u

‑

net网络,以达到提升精度的效果。

91.在本实施例中,对于8个独立的u

‑

net网络,其输入和输出大小分别为 256

×

256。每个u

‑

net网络由4个下采样的编码器层和4个上采样的解码器层来提取特征。随着训练的进行,8个u

‑

net的参数会被调整。请注意,这个网络是轻量级的,所以它具有足够高效的实时性,能够满足应用场景的要求。

92.另外,傅里叶变换层(fft)的作用是对u

‑

net网络提取的特征图进行傅里叶变换,去掉图像之间的平移变换关系但保留旋转和缩放变换关系。因为根据傅里叶变换的特性,只有旋转和比例对频谱的幅度有影响,但对频谱的幅度对平移不敏感。因此引入fft后就得到了对平移不敏感但对缩放和旋转尤其敏感的表示方法,因此在后续求解缩放和旋转时可以忽略平移。

93.另外,对数极性变换层(lpt)的作用是对fft变换后的图像进行对数极坐标变换,将图像从笛卡尔坐标系映射至对数极坐标系。在该映射过程中,笛卡尔坐标系下的缩放和旋转可以转换成对数极坐标系下的平移。该坐标系变换,可以得出关于缩放和旋转的交叉相关形式,消除整个可微分的位姿求解器中的所有穷尽性评价。

94.另外,相位相关层(dc)的作用是进行相位相关求解,即计算两个幅度谱之间的交叉相关性。根据求解得到的相关性,可以得到二者之间的平移变换关系。交叉相关性的具体计算过程属于现有技术,不再赘述。

95.下面对该可微分的位姿求解器的具体结构以及位姿估计流程进行详细展开描述,其步骤如下:

96.s101:以预先经过训练的第一u

‑

net网络u

‑

net1和第二u

‑

net网络u

‑

net2 作为两个特征提取器,分别以异构的第一图像和第二图像作为两个特征提取器 u

‑

net1和u

‑

net2各自的原始输入图片(即第一图像输入u

‑

net1中,而第二图像输入u

‑

net2中,下同),提取两张原始输入图片中的同构特征,得到同构的第一特征图和第二特征图。此时,第一特征图和第二特征图中同时保留有原始输入图片之间的平移、旋转和缩放变换关系。

97.s102:将s101中得到的第一特征图和第二特征图分别进行第一次傅里叶变换操作(记为fft1)后取各自的幅度谱,此时两个幅度谱之间保留有原始输入图片之间的旋转和缩放变换关系,但平移变换关系已在fft1中被滤掉。

98.s103:将s102中得到的两个幅度谱分别进行第一次对数极坐标变换操作(记为lpt1),使其从笛卡尔坐标系转换到对数极坐标系中,从而使两个幅度谱之间笛卡尔坐标系

下的旋转变换被映射成对数极坐标系中y方向上的平移变换(记为 y)。

99.s104:将s103中两个坐标变换后的幅度谱在相位相关层(dc)中进行相位相关求解,得到二者之间的平移变换关系。需注意,在s103的lpt1中,笛卡尔坐标系下的旋转变换与对数极坐标系中y方向上的平移变换y之间存在映射关系,因此可以再将该平移变换关系按照s103中笛卡尔坐标系和对数极坐标系之间的映射关系重新转换,得到前述第一图像和第二图像之间的旋转变换关系。

100.上述旋转变换关系本质上是第二图像要实现与第一图像的配准,所需要被旋转的角度theta,该角度可作为相对位姿估计的一部分。

101.s105:同样的,以预先经过训练的第三u

‑

net网络u

‑

net3和第四u

‑

net网络u

‑

net4作为两个特征提取器,分别以异构的第一图像和第二图像作为两个特征提取器u

‑

net3和u

‑

net4各自的原始输入图片,提取两张原始输入图片中的同构特征,得到同构的第三特征图和第四特征图。此时,第三特征图和第四特征图中也同时保留有原始输入图片之间的平移、旋转和缩放变换关系。

102.s106:将s105中得到的第三特征图和第四特征图分别进行第二次傅里叶变换操作(记为fft2)后取各自的幅度谱。同样的,这两个幅度谱之间保留有原始输入图片之间的旋转和缩放变换关系而平移变换关系已在已在fft2中被滤掉。

103.s107:将s106中得到的两个幅度谱分别进行第二次对数极坐标变换操作(记为lpt2),使其从笛卡尔坐标系转换到对数极坐标系中,从而使两个幅度谱之间笛卡尔坐标系下的缩放变换被映射成对数极坐标系中x方向上的平移变换x。

104.s108:将s107中两个坐标变换后的幅度谱在相位相关层(dc)中进行相位相关求解,得到二者之间的平移变换关系。同样的,在s107的lpt2中,笛卡尔坐标系下的旋转变换与对数极坐标系中x方向上的平移变换x之间存在映射关系,因此可以再按照s107中笛卡尔坐标系和对数极坐标系之间的映射关系重新转换,得到前述第一图像和前述第二图像之间的缩放变换关系。

105.上述缩放变换关系本质上是第二图像要实现与第一图像的配准,所需要被缩放的比例scale,该比例可作为相对位姿估计的一部分。

106.由此,通过上述步骤,已获得了第一图像和第二图像之间的旋转变换关系和缩放变换关系。

107.s109:将前述第二图像按照s104和s108中得到的旋转变换关系和缩放变换关系进行对应的旋转和缩放变换,得到一张新的第二图像。由于通过旋转和缩放变换后,第一图像和第二图像之间已不存在角度和比例的差异,因此新的第二图像与输入的第一图像之间目前仅包含平移变换关系,而不存在旋转变换关系和缩放变换关系,后续仅需要通过平移变换消除两者之间的平移差异即可。对于平移变换关系,只需要通过相位相关求解,就可以获取其x和y方向上的平移变换关系。

108.s1010:以预先经过训练的第五u

‑

net网络u

‑

net5和第六u

‑

net网络u

‑

net6 作为两个特征提取器,分别以第一图像和新的第二图像作为两个特征提取器 u

‑

net5和u

‑

net6各自的原始输入图片,提取两张原始输入图片中的同构特征,得到同构的第五特征图和第六特征图。此时,第五特征图和第六特征图中仅保留有原始输入图片之间的平移变换关系,而不存在旋转和缩放变换关系。

109.s1011:将s1010中得到的第五特征图和第六特征图在相位相关层(dc)中进行相位相关求解,得到第一图像和第二图像之间的x方向上的平移变换关系。

110.s1012:以预先经过训练的第七u

‑

net网络u

‑

net7和第八u

‑

net网络u

‑

net8 作为两个特征提取器,分别以第一图像和新的第二图像作为两个特征提取器u

‑

net7和u

‑

net8各自的原始输入图片,提取两张原始输入图片中的同构特征,得到同构的第七特征图和第八特征图。此时,第七特征图和第八特征图中仅保留有原始输入图片之间的平移变换关系,而不存在旋转和缩放变换关系。

111.s1013:将s1012中得到的第七特征图和第八特征图在相位相关层(dc)中进行相位相关求解,得到第一图像和第二图像之间的y方向上的平移变换关系。

112.上述x方向上的平移变换关系和y方向上的平移变换关系本质上是第二图像要实现与第一图像的配准,分别需要在x方向上平移的距离x和在y方向上平移的距离y,这两个距离也可作为相对位姿估计的一部分。

113.由此可见,本发明的位姿估计是分为两个阶段来实现的,一共得到了四个自由度(x、y、theta、scale)的估计值。首先,通过s101~s109的旋转缩放阶段实现旋转和缩放变换关系的估计,然后再通过s1010~s1013平移阶段实现平移变换关系的估计。

114.综合上述s104、s108、s1011和s1013的结果,就可以得到异构的第一图像和第二图像之间旋转、缩放和平移三种变换关系的位姿估计值,从而完成两者的位姿估计过程,后续可以根据相应的估计值进行损失函数l的计算。

115.需注意,上述可微分的位姿求解器中,8个u

‑

net网络均预先进行训练,为了保证每一个u

‑

net网络均可以准确提取同构特征,需要设置合理的损失函数。训练的总损失函数应当为第一图像和所述第二图像之间的旋转变换关系损失、缩放变换关系损失、x方向上的平移变换关系损失和y方向上的平移变换关系损失的加权和,具体加权值可根据实际进行调整。

116.在本实施例中,总损失函数中四种损失的加权权值均为1,且四种损失均采用l1损失,四种损失函数分别如下:

117.将s104中预测的旋转关系theta记为theta_predict,将s108中预测的缩放关系scale记为scale_predict,将s1011中预测的x方向上的平移变换x记为x_predict,将s1013中预测的y方向上的平移变换y记为y_predict。因此,每一轮训练过程中求得两个异构图片之间的平移(x_predict,y_predict),旋转(theta_predict),缩放(scale_predict)关系。

118.1)在模型中将所求得的theta_predict与其真值theta_gt做1范数距离损失, l_theta=(theta_gt

‑

theta_predict),将l_theta回传用以训练u

‑

net1、u

‑

net2,使其能够提取到更好的用于求theta_predict的特征。

119.2)将所求得的scale_predict与其真值scale_gt做1范数距离损失,l_scale= (scale_gt

‑

scale_predict),将l_scale回传用以训练u

‑

net3、u

‑

net4,使其能够提取到更好的用于求scale_predict的特征。

120.3)将所求得的x_predict与其真值x_gt做1范数距离损失,l_x= (x_gt

‑

x_predict),将l_x回传用以训练u

‑

net5、u

‑

net6,使其能够提取到更好的用于求x_predict的特征。

121.4)将所求得的y_predict与其真值y_gt做1范数距离损失,l_y= (y_gt

‑

y_

predict),将l_y回传用以训练u

‑

net7、u

‑

net8,使其能够提取到更好的用于求y_predict的特征。

122.因此,总损失函数为l*=l_x l_y l_theta l_scale,训练过程中通过梯度下降方法对8个u

‑

net网络的模型参数进行优化,使总损失函数l*最小。训练完毕后的8个u

‑

net网络组成了用于对实际的异构图像进行位姿估计的可微分的位姿求解器,该可微分的位姿求解器中可按照上述s101~s1013的方法进行两张异构图像的位姿估计。需注意该可微分的位姿求解器的训练需要超前于前述对抗生成网络的训练。

123.在引入上述可微分的位姿求解器的基础上,为了验证上述s1~s4提出的弱匹配图像风格迁移方法的效果,本发明在图4所展示的三种不同天气差别设置形式下采集了三种不同的图像样本对,进而构成了图三个原始数据集。在这三个原始数据集基础上,进行了本发明前述对抗生成网络的训练。然后在晴天训练了车辆识别网络以及道路分割网络,并在雨天,夜晚,雾天三个天气以及其分别对应的通过风格迁移得到的晴天下测试了车辆识别网络以及道路分割网络的准确率。测试结果如表1所示,其中map为平均准确率,iou为重叠区域。具体测试方法为,1)车辆识别:在一套含有1000组弱匹配图像的数据集中(每组包含一张晴天,以及其对应的天气条件为雨天,雾天,夜晚的弱匹配图片)将在晴天下用 yolov3训练的车辆识别网络分别在i)晴天ii)雨天iii)雨天迁移至晴天iv)雾天v) 雾天迁移至晴天vi)夜晚vii)夜晚迁移至晴天这七种天气条件下的图像中进行车辆识别,得到不同条件下的车辆识别平均准确率map(mean average precision)。 1)道路分割:在一套含有1000组弱匹配图像的数据集中(每组包含一张晴天,以及其对应的天气条件为雨天,雾天,夜晚的弱匹配图片)将在晴天下用kittiseg 训练的车辆识别网络分别在i)晴天ii)雨天iii)雨天迁移至晴天iv)雾天v)雾天迁移至晴天vi)夜晚vii)夜晚迁移至晴天这七种天气条件下的图像中进行道路分割,得到不同条件下的分割成功区域百分比iou(intersection over union)。

124.表1

[0125][0126]

由此可见,本发明的弱匹配图像风格迁移方法能够很好地实现图像保持位姿不变情况下的风格迁移。

[0127]

以上所述的实施例只是本发明的一种较佳的方案,然其并非用以限制本发明。有关技术领域的普通技术人员,在不脱离本发明的精神和范围的情况下,还可以做出各种变

化和变型。因此凡采取等同替换或等效变换的方式所获得的技术方案,均落在本发明的保护范围内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。