1.本发明涉及数字孪生技术领域,具体涉及一种基于数字孪生的虚拟现实交互方法。

背景技术:

2.数字孪生是充分利用物理模型、传感器更新、运行历史等数据,集成多学科、多物理量、多尺度、多概率的仿真过程,在虚拟空间中完成映射从而反映相对应的实体装备的全生命周期过程。数字孪生是一种超越现实的概念,可以被视为一个或多个重要的、彼此依赖的装备系统的数字映射系统。数字孪生是个普遍适应的理论技术体系,可以在众多领域应用,目前在产品设计、产品制造、医学分析、工程建设等领域应用较多。数字孪生是在mbd基础上深入发展起来的,企业在实施基于模型的系统工程(mbse)的过程中产生了大量的物理的、数学的模型,这些模型为数字孪生的发展奠定了基础。数字孪生体是指在计算机虚拟空间存在的与物理实体完全等价的信息模型,可以基于数字孪生体对物理实体进行仿真分析和优化。数字孪生是技术、过程、方法,数字孪体是对象、模型和数据。目前在国内应用最深入的是工程建设领域,关注度最高、研究最热的是智能制造领域。虚拟现实(含增强现实、混合现实等,以下简称vr)是学科高度交叉的科学技术领域,也是辐射性强大的应用技术。随着vr技术的不断发展,vr在许多行业得到应用,vr 成为发展趋势,为人类生产带来新模态,产生颠覆性影响。近年来更快速进入大众生活,为人类生活带来新体验。

技术实现要素:

3.本发明的目的是提供一种基于数字孪生的虚拟现实交互方法,借助数字孪生技术再现真实生活场景的动态虚拟,利用来自传感器数据和物理模型的综合知识来模拟生活场景的动态。

4.为了实现上述任务,本发明采用以下技术方案:

5.一种基于数字孪生的虚拟现实交互方法,包括以下步骤:

6.步骤1,根据所要模拟的场景,进行场景搭建,搭建建筑模型,传感器模型以及需要控制的对象模型;

7.所述需要控制的对象模型为无人机模型,将建立的场景和无人机模型进行标注,并且设置无人机模型以及室内室外场景的建筑物模型的3d刚体、角色控制器并对所有的场景进行位置设置,然后着色背景,针对无人机模型加碰撞器,设置旋翼,对无人机模型进行位置布控以及无人机模型局部渲染和贴图;

8.步骤2,针对于无人机模型进行虚拟端的控制,首先要在虚拟端绑定无人机对象,编写脚本,设置无人机模型的重量,速度,俯仰角,偏航角,滚转角,还需要定义摄像头跟随,光线,并且在无人机模型中加入碰撞器,同时还需要多传感器模拟,利用红外传感器进行红外避障,信息传递;利用超声波传感器进行超声波避障;利用相机传感器模拟机器视觉;利用imu传感器进行无人机模型姿态信息以及无人机模型运行信息获取;利用高度传感器获

取无人机模型的高度信息及速度信息;利用接触式传感器获得无人机模型的感知范围,利用深度相机传感器和激光雷达传感器,获取环境深度信息,进行自主定位导航;利用深度相机检测位姿,深度相机坐标系下的三维坐标需要由图像中的像素点坐标计算得到,借助于虚拟现实、数字孪生和智能操控技术进行三维重建,实现无人机模型的精准定位;

9.步骤3,连接vr设备虚拟现实头盔连接到电脑,并且在虚拟端中配置环境,实现虚拟端的连接;

10.步骤4,标定激光雷达传感器和相机传感器的内部参数,使标定后的相机传感器符合针孔成像模型后,对gps/imu组合导航系统、相机传感器以及激光雷达传感器之间的相对位姿进行配准,为数据融合做准备;

11.在机载测量系统中,gps/imu组合导航系统提供了无人机模型在世界大地测量坐标系下的位置;利用april tag得到相对于相机传感器的6自由度位姿;建立相机传感器与激光雷达传感器、gps/imu组合导航系统的相对关系,以及机载测量系统的定位方程;

12.步骤5,在虚拟现实头盔设备上进行控制,利用投影机,将虚拟内容呈现于物理空间,达到虚实融合的效果,无人机模型作为输入和输出信息的双载体,实现交互输入与视觉呈现完全一致化;

13.步骤6,通过云平台进行命令发布,当无人机模型在虚拟端进行仿真模拟飞行的同时,实际的无人机接收到云平台发布的命令,按照接收信息进行定点飞行,实现虚拟现实交互,在实现交互的同时,实际的无人机搭载激光雷达,

14.摄像头,借助5g模块将当下环境传输到虚拟端,虚拟端接收数据进行三维重建,达到虚拟现实高度一致化。

15.进一步地,所述建立相机传感器与激光雷达传感器、gps/imu组合导航系统的相对关系,具体包括3个坐标系,分别为:

16.传感器坐标系,惯性坐标系和世界坐标系;传感器坐标系与惯性坐标系之间的关系刚性固定,它们之间的旋转平移关系分别用和表示,标定物在惯性坐标系下的坐标x

imu

可通过下式得到:

[0017][0018]

式中,x

imu

为标定物点p在惯性坐标系下的坐标;为传感器坐标系到惯性坐标系的平移参数;为传感器坐标系到惯导坐标的旋转参数构成的旋转矩阵,x

sensor

为标定物点在传感器坐标系下的坐标;

[0019]

机载测量系统在无人机模型移动过程中,传感器高频率记录测量数据,经后处理得到无人机模型的位置和姿态信息。在惯性坐标系下的任一扫描点坐标可通过下式得到:

[0020][0021]

式中,为惯性坐标系到世界坐标系的平移参数;为惯性坐标系到世界坐标系的旋转参数构成的旋转矩阵,为传感器坐标系到世界坐标系的平移参数,x

l

为惯性坐标系下的坐标,从而可以得到机载测量系统的定位方程。

[0022]

进一步地,利用虚拟现实头盔的手柄进行控制,运行虚拟端环境,即可看到虚拟端

场景的模型,当手柄点击场景内的某一点的时候,无人机模型会飞向该位置,当达到该位置的时候,无人机模型保持悬停状态,从而实现人机交互,还可以在虚拟现实头盔中导入手动模型脚本,实现用手指控制。

[0023]

进一步地,所述虚拟端采用unity,虚拟现实头盔采用oculus quest设备。

[0024]

进一步地,所述命令与虚拟端中对于无人机模型进行控制的命令相对应。

[0025]

与现有技术相比,本发明具有以下技术特点:

[0026]

1.本发明通过使用数字孪生技术,进行模型场景搭建仿真深度渲染现实场景,进行模型优化和渲染,将无人机航空遥感及遥感影像自动处理技术、倾斜摄影三维建模、地理信息系统技术(gis)、建筑信息模型(bim)和大数据应用等交叉学科进行深度融合,构建了空地一体,集数据采集、处理、决策辅助分析的完善体系采用vr设备进行人机交互,实现在vr设备进行已一体交互。

[0027]

2.本发明多传感器融合达到更加真实的虚拟现实交互,实现精确交互,仿真与现实对应,结合目前主流的联合卡尔曼滤波技术,在gps/视觉多传感器融合定位算法基础上,增加超宽带uwb无线定位技术,弥补gps和视觉传感器无法提供有效位置数据的不足。为保证多传感器融合算法的容错性和鲁棒性,采用基于卡尔曼滤波测量值与预测值间马氏距离的卡方检验对传感器数据进行有效性检验。

附图说明

[0028]

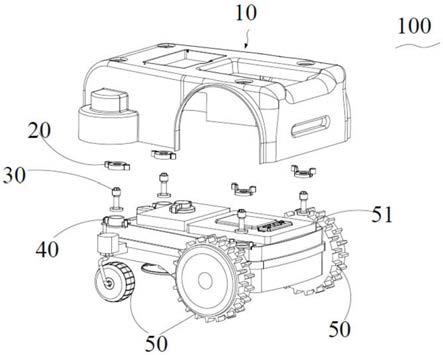

图1为无人机场景模型示意图;

[0029]

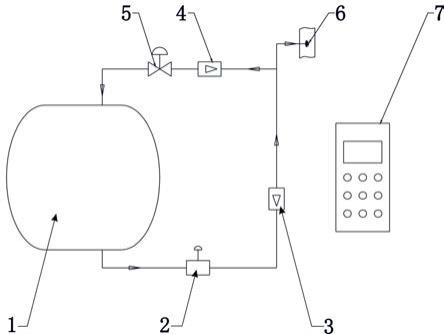

图2为传感器标定的位置关系示意图;

[0030]

图3为unity平台传感器模拟示意图;

[0031]

图4为oculus quest连接图;

[0032]

图5为oculus quest手柄控制场景;

[0033]

图6为unity 3d内四旋翼飞行器到达指定位置的示意图。

具体实施方式

[0034]

本发明提出一种基于数字孪生的虚拟现实交互方法,首先开场景模型数据库,以确保场景模型中的虚拟物体与物理实体的一致性,然后基于传感器数据和物理模型构建虚拟场景,最后在模拟器中对构建的虚拟场景进行渲染。传感器驱动的虚拟场景物体可以进行实时监控,物理模型预测。在完成物理模型的基础上,连接vr设备(采用的是oculus quest)进行虚拟现实交互。

[0035]

参见附图,本发明方法主要包含构建虚拟场景,vr测试交互两部分,具体实现的步骤如下:

[0036]

步骤1,根据所要模拟的场景,进行场景搭建,搭建建筑模型,传感器模型,以及需要控制的对象模型,这里采用的是无人机模型;将建立的场景模型进行标注,并且设置无人机模型以及室内室外场景的建筑物模型的3d刚体rigidbody、角色控制器character controller以及所有的场景设置位置,着色背景,针对无人机模型加碰撞器,设置旋翼,对无人机模型进行位置布控以及无人机模型局部渲染和贴图,使之更加具有科技感、真实感,达到unity场景美观,并且接近真实的场景。

[0037]

步骤2,针对于无人机进行虚拟端的控制,首先要在虚拟端unity中绑定无人机对象,编写脚本,设置无人机模型的重量,速度,俯仰角,偏航角,滚转角等,还需要定义摄像头跟随,光线等,并且在无人机模型中加入碰撞器,同时还需要多传感器模拟,利用红外传感器进行红外避障,信息传递;利用超声波传感器进行超声波避障;利用普通相机传感器模拟机器视觉;利用imu传感器进行无人机姿态信息以及无人机运行信息获取;利用高度传感器获取无人机模型的高度信息及速度信息;利用接触式传感器获得无人机模型的感知范围,利用深度相机传感器和激光雷达传感器,获取环境深度信息,进行自主定位导航,利用深度相机检测位姿,位姿检测设备坐标系下的三维坐标p

l

(x,y,z)需要由图像中的像素点坐标计算得到,借助于虚拟现实、数字孪生和智能操控等技术进行三维重建,实现无人机模型的精准定位。

[0038]

步骤3,连接vr设备oculus quest连接到电脑端,并且在unity中配置环境,实现虚拟端的连接。

[0039]

步骤4,在标定激光雷达传感器和相机传感器的内部参数,修正设备内部因素引起的畸变等,使标定后的相机符合针孔成像模型后,对gps/imu组合导航系统、相机传感器以及激光雷达传感器之间的相对位姿进行配准,为数据融合做准备。在机载测量系统中,gps/imu组合导航系统提供了无人机模型在世界大地测量坐标系下的位置。利用april tag得到了april tag相对于相机传感器的6自由度位姿。相机传感器与激光雷达传感器、gps/imu组合导航系统的相对关系,对应的关系图如图1所示,其涉及3个坐标系,分别为传感器坐标系,惯性坐标系和世界坐标系。传感器坐标系与惯性坐标系之间的关系刚性固定,它们之间的旋转平移关系分别用和表示,标定物在惯性坐标系下的坐标x

imu

可通过下式得到:

[0040][0041]

式中,x

imu

为标定物点p在惯性坐标系下的坐标;为传感器坐标系到惯性坐标系的平移参数;为传感器坐标系到惯导坐标的旋转参数构成的旋转矩阵。机载测量系统在无人机模型移动过程中,传感器高频率记录测量数据,经后处理得到无人机模型的位置和姿态信息。在惯性坐标系下的任一扫描点坐标可通过下式得到:

[0042][0043][0044]

式中,为惯性坐标系到世界坐标系的平移参数;为惯性坐标系到世界坐标系的旋转参数构成的旋转矩阵,为传感器坐标系到世界坐标系的平移参数,x

l

为惯性坐标系下的坐标,从而可以得到机载测量系统的定位方程。

[0045]

步骤5,在oculus quest设备上进行控制,目前增强现实根据显示装置位置不同,可以分为头戴式增强现实、手持式增强现实和空间增强现实三大形式,空间增强现实作为增强现实最重要形式,利用投影机等装置,将虚拟内容呈现于物理空间,达到虚实融合的效果,交互对象,即无人机模型作为输入和输出信息的双载体,实现交互输入与视觉呈现完全

一致化,在实时性,匹配精度方面给与保证。

[0046]

本实施例中,利用oculus quest的手柄进行控制,头戴quest设备,连接电脑,运行unity环境,即可看到unity场景的模型,当手柄点击场景内的某一点的时候,无人机模型会飞向该位置,当达到该位置的时候,无人机保持悬停状态,从而实现人机交互,还可以在quest设备中导入手动模型脚本,实现用手指控制。

[0047]

步骤6,针对上一步实现的人机交互基础上,进行实际场景中利用云平台对无人机控制,建立实际场景与虚拟端场景中无人机的交互:

[0048]

通过实际环境下云平台进行命令发布,该命令与虚拟端中对于无人机模型进行控制的命令相对应;当无人机模型在虚拟端进行仿真模拟飞行的同时,实际的无人机接收到云平台发布的命令,按照接收信息进行定点飞行,实现虚拟现实交互,在实现交互的同时,实际的无人机搭载激光雷达,摄像头等,借助5g模块将当下环境传输到虚拟端,虚拟端接收数据进行三维重建,达到虚拟现实高度一致化。

[0049]

以上实施例仅用以说明本技术的技术方案,而非对其限制;尽管参照前述实施例对本技术进行了详细的说明,本领域的普通技术人员应当理解:其依然可以对前述各实施例所记载的技术方案进行修改,或者对其中部分技术特征进行等同替换;而这些修改或者替换,并不使相应技术方案的本质脱离本技术各实施例技术方案的精神和范围,均应包含在本技术的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。