1.本发明涉及人机协作及计算机视觉技术领域,特别是涉及一种基于深度视觉的人机协作安全预警方法及系统。

背景技术:

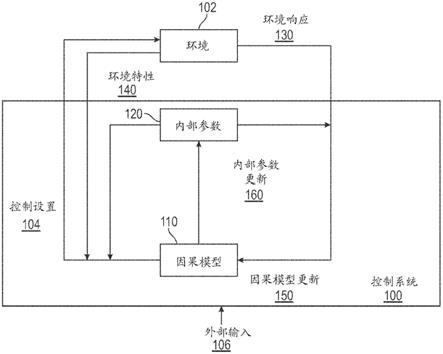

2.随着制造业的自动化和智能化生产程度不断提高,大量的机器人被投放到自动化生产线上,并配备一定的专业人员共同协作完成装配、焊接、搬运等工序,整个过程中难免发生机械臂与人碰撞使人受伤的情况。传统的在机械臂周围加装栅栏、人工穿戴防护器具等方法不仅需要占据额外的空间,还很难根据任务需求快速的改变工作区域的边界。且上述方法均不能从根本上解决人机协作的安全问题。

技术实现要素:

3.本发明的目的是提供一种基于深度视觉的人机协作安全预警方法及系统,用以解决现有人机协作安全预警方法效率低、实时性差的问题,从根本上提高人机协作中的人员安全性。

4.为实现上述目的,本发明提供了如下方案:

5.一种基于深度视觉的人机协作安全预警方法,包括:

6.实时采集机器人生产环境区域的图像,得到图像序列;

7.利用训练好的yolov5网络模型实时处理所述图像序列,定位图像中所有行人并标记;

8.计算定位且标记后的所有行人与所述机器人的相对距离;

9.将所述相对距离与设定的安全防护等级距离进行比较,根据比较结果发出不同等级的预警信号。

10.可选的,上述基于深度视觉的人机协作安全预警方法还包括根据所述比较结果确定是否驱动机器人控制系统控制机器人做出运动规避动作;

11.若否,则只根据所述比较结果发出不同等级的预警信号;若是,则根据比较结果发出不同等级预警信号的同时,驱动机器人做出运动规避动作,避免机器人与行人发生碰撞。

12.可选的,利用yolov5网络模型的输入端对所述图像序列进行预处理,所述预处理的过程具体包括:

13.利用mosaic对所述图像序列的数据进行增强,得到增强后的图像;

14.利用自适应锚框算法处理增强后的图像,得到具有最佳锚框值的图像;

15.利用自适应图片缩放算法对具有最佳锚框值的图像进行缩放,得到预处理图像。

16.可选的,利用yolov5网络模型的backbone部分处理所述图像序列,获取图像特征;

17.利用yolov5网络模型的neck部分对所述图像特征进行混合和组合,得到混合和组合后的图像特征;

18.利用yolov5网络模型的head部分对所述混合和组合后的图像特征进行预测,定位

生成所有行人的边界框,并将所述边界框显示在原图片上。

19.yolov5网络模型定位生成所有行人的边界框时利用giou_loss函数解决边界框不重合的问题,giou_loss函数如下所示:

[0020][0021]

其中,iou为交并比,表示预测框与真实框的交集与并集的比值,c表示预测框与真实框的最小外接矩形面积,δ=b

‑

c,b表示预测框与真实框的并集。

[0022]

可选的,利用训练好的行人检测网络模型实时处理所述图像序列,定位图像中所有行人并标记包括:

[0023]

对图像中所有行人进行定位,得到输出数据(x,y,w,h,c),其中x,y分别表示行人预测框在图像坐标系上x轴上的坐标值和y轴上的坐标值,w,h分别表示行人预测框的宽和高,c表示行人预测框的置信度;

[0024]

对图像中所有行人进行标记,将所述行人预测框以及置信度显示在原图片上。

[0025]

可选的,计算定位且标记后的所有行人与所述机器人的相对距离包括:

[0026]

利用双目测距基本原理计算定位且标记后的所有行人与所述机器人的相对距离,双目测距基本原理的计算公式如下:

[0027][0028]

其中,f表示相机焦距,通过相机标定得到,b表示相机中心距离,通过相机标定得到,x

l

‑

x

r

表示目标点在相机左右两幅视图上的成像视差。

[0029]

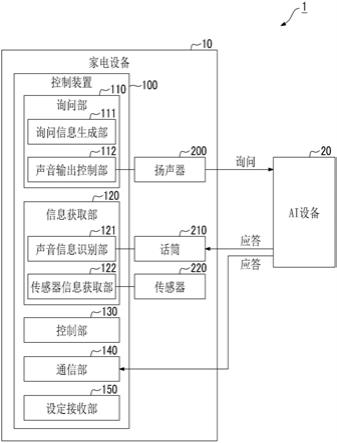

本发明该提供一种基于深度视觉的人机协作安全预警系统,包括:

[0030]

图像采集模块,用于实时采集机器人生产环境区域的图像,得到图像序列;

[0031]

行人检测模块,用于利用训练好的yolov5网络模型实时处理所述图像序列,定位图像中所有行人并标记;

[0032]

深度测距模块,用于计算定位且标记后的所有行人与所述机器人的相对距离;

[0033]

安全预警模块,用于将所述相对距离与设定的安全防护等级距离进行比较,根据比较结果发出不同等级的预警信号。

[0034]

可选的,上述基于深度视觉的人机协作安全预警系统还包括:

[0035]

运动规避模块,用于根据所述比较结果确定是否驱动机器人控制系统控制机器人做出运动规避动作;若否,则只根据所述比较结果发出不同等级的预警信号;若是,则根据比较结果发出不同等级预警信号的同时,驱动机器人做出运动规避动作,避免机器人与行人发生碰撞。

[0036]

可选的,行人检测模块包括:

[0037]

图像增强单元,用于利用mosaic对所述图像序列的数据进行增强,得到增强后的图像;

[0038]

图像锚框单元,用于利用自适应锚框算法处理所述增强后的图像,得到具有最佳锚框值的图像;

[0039]

图像缩放单元,用于利用自适应图片缩放算法对所述具有最佳锚框值的图像进行缩放,得到预处理图像。

xavier nx开发板上,得到训练好的yolov5网络模型。nvidia深度学习嵌入式ai平台性能卓越、体型小巧,满足yolov5网络模型的训练需求。nvidia深度学习嵌入式ai平台可通过usb接口与双目相机相连。

[0055]

yolov5网络模型的输入端使用了mosaic数据增强方法,且增加了自适应锚框算法和自适应图片缩放算法。在对yolov5网络模型的训练过程中,可利用mosaic的随机缩放、随机裁剪、随机排布的图像处理方式对自制的行人数据集进行拼接,对自制的行人数据集进行增强,提高yolov5网络模型的训练精度。且还可以利用自适应锚框算法处理所述增强后的图像,得到具有最佳锚框值的图像。yolov5网络模型将自适应锚框算法嵌入到了代码中,每次训练时,自适应计算不同训练集中的最佳锚框值。当然,如果觉得计算的锚框效果不是很好,也可以在代码中将自动计算锚框功能关闭。最后,利用自适应图片缩放算法对所述具有最佳锚框值的图像进行缩放,得到预处理图像。上述对自制行人数据集中图像进行预处理的过程可丰富数据集,提升yolov5网络模型的训练速度和精度。

[0056]

具体的,yolov5网络模型实时处理所述图像序列的步骤包括:

[0057]

s21:利用所述yolov5网络模型的backbone部分处理所述图像序列,获取图像特征。

[0058]

具体的,backbone为卷积神经网络,由focus结构和csp结构组成,可在不同图像细粒度上聚合并形成图像特征,而cspnet可将梯度的变化从头到尾地集成到图像特征上,在减少了计算量的同时保证了准确率。

[0059]

s22:利用所述yolov5网络模型的neck部分对所述图像特征进行混合和组合,得到混合和组合后的图像特征。

[0060]

具体的,neck部分由fpn结构和pan结构组合而成,可用于混合和组合图像特征,并将图像特征传递到预测层。

[0061]

s23:利用所述yolov5网络模型的head部分对所述混合和组合后的图像特征进行预测,定位生成所有行人的边界框,并将所述边界框显示在原图片上。

[0062]

具体的,head网络部分采用非极大值抑制方法筛选掉了重复的边界框,且在定位生成所有行人的边界框时利用giou_loss函数解决边界框不重合的问题,giou_loss函数如下所示:

[0063][0064]

其中,iou为交并比,表示预测框与真实框的交集与并集的比值,c表示预测框与真实框的最小外接矩形面积,δ=b

‑

c,b表示预测框与真实框的并集。由上述公式可以看出giou_loss函数中增加了相交尺度的衡量方式来解决边界框不重合的问题,提升了yolov5网络模型的收敛速度以及模型表现。

[0065]

yolov5网络模型实时处理所述图像序列的作用为标记出视频图像中的所有人员,并进行可视化输出。简单来说就是对图像中所有行人进行定位,得到输出数据(x,y,w,h,c),其中x,y分别表示行人预测框在图像坐标系上x轴上的坐标值和y轴上的坐标值,w,h分别表示行人预测框的宽和高,c表示行人预测框的置信度;对图像中所有行人进行标记,将所述行人预测框以及置信度显示在原图片上。

[0066]

yolov5网络模型一共包括四种,分别是yolov5s网络模型、yolov5l网络模型、

yolov5m网络模型以及yolov5x网络模型。由于yolov5s网络模型可在不同光照、视角条件下准确快速的检测出机器人工作区域内的所有行人,满足人机协作安全性的实时性要求。因此,在本实施例当中使用yolov5s网络模型实时处理所述图像序列。需要另说明的是,使用yolov5s网络模型实时处理所述图像序列只是本实施例提供的一种优选的实施方式,本领域技术人员也可以使用其他类型的网络模型实时处理所述图像序列,本发明对此不做具体限定。

[0067]

s3:计算定位且标记后的所有行人与机器人的相对距离。

[0068]

具体的,利用双目立体视觉的视差原理,计算从不同位置获取的目标行人两幅图像对应点之间的位置偏差,从而准确的计算出目标行人与机器人的相对距离。如图2所示,假设p为检测网络形成的行人矩形框中心点,x

l

‑

x

r

为目标点在左右两幅图上的成像视差,b为相机中心距离,f为相机焦距,z为所求的目标行人与机器人的相对距离,o

l

与o

r

分别为左右相机的光心,p

l

与p

r

分别为左右相机感光器上的成像点。

[0069]

那么依据相似三角形原理可得:

[0070][0071]

对其进行变形可得:

[0072][0073]

其中,f表示相机焦距,通过相机标定得到,b表示相机中心距离,通过相机标定得到,x

l

‑

x

r

表示目标点在相机左右两幅视图上的成像视差。

[0074]

s4:将所述相对距离与设定的安全防护等级距离进行比较,根据比较结果发出不同等级的预警信号。

[0075]

具体的,nvidia深度学习嵌入式ai平台可通过电缆与红、黄色报警灯相连。安全防护等级距离分为黄色安全预警距离以及红色安全预警距离。

[0076]

如图3所示,当相对距离大于黄色安全预警距离时,红、黄色报警灯均不闪烁;当相对距离小于黄色安全预警距离且大于红色安全预警距离时,黄色报警灯闪烁;当相对距离小于红色安全预警距离时,红色报警灯闪烁。

[0077]

本发明提供的种基于深度视觉的人机协作安全预警方法还包括根据比较结果确定是否驱动机器人控制系统控制机器人做出运动规避动作;

[0078]

若否,则只根据比较结果发出不同等级的预警信号;若是,则根据比较结果发出不同等级预警信号的同时,驱动机器人做出运动规避动作,避免机器人与行人发生碰撞。例如,黄色预警时,驱动机器人控制系统降低机器人的运行速度,红色预警时,驱动机器人控制系统体质机器人运动。

[0079]

本实施例提供的基于深度视觉的人机协作安全预警方法通过对机器人整体工作区域的实时监控,可以有效地避免机器人对工作区域的行人的碰撞。且该方法适用性,可适用于不同形式的机器人工作环境。

[0080]

实施例2

[0081]

本实施例提供一种与实施例1相对应的基于深度视觉的人机协作安全预警系统,

该系统包括:

[0082]

图像采集模块,用于实时采集机器人生产环境区域的图像,得到图像序列;

[0083]

行人检测模块,用于利用训练好的yolov5网络模型实时处理所述图像序列,定位图像中所有行人并标记;

[0084]

深度测距模块,用于计算定位且标记后的所有行人与所述机器人的相对距离;

[0085]

安全预警模块,用于将所述相对距离与设定的安全防护等级距离进行比较,根据比较结果发出不同等级的预警信号。

[0086]

具体的,该系统还包括:

[0087]

运动规避模块,用于根据所述比较结果确定是否驱动机器人控制系统控制机器人做出运动规避动作;若否,则只根据所述比较结果发出不同等级的预警信号;若是,则根据比较结果发出不同等级预警信号的同时,驱动机器人做出运动规避动作,避免机器人与行人发生碰撞。

[0088]

可选的,行人检测模块包括:

[0089]

图像增强单元,用于利用mosaic对所述图像序列的数据进行增强,得到增强后的图像;

[0090]

图像锚框单元,用于利用自适应锚框算法处理所述增强后的图像,得到具有最佳锚框值的图像;

[0091]

图像缩放单元,用于利用自适应图片缩放算法对所述具有最佳锚框值的图像进行缩放,得到预处理图像。

[0092]

视觉传感器可获得更加丰富的图像颜色、纹理等特征信息,能够很好的复现周围环境场景,而且它不需要主动发射信号,更加适用于一些对实时性要求高的环境。基于深度视觉的人机协作安全预警系统引入计算机视觉后,当有人员靠近机器人工作区域时,系统能够及时警示区域外的人员停止靠近,能在人员闯入时,实现区域分级报警,同时可控制机器人能够及时降低运行速度甚至停止运动,尽可能的减少安全事故的发生。利用机器视觉技术实现对机器人整体工作区域的监控,将人员与机器人隔离、为工作人员建立安全的工作区域,从而有效避免人机碰撞的发生。

[0093]

本说明书中各个实施例采用递进的方式描述,每个实施例重点说明的都是与其他实施例的不同之处,各个实施例之间相同相似部分互相参见即可。对于实施例公开的系统而言,由于其与实施例公开的方法相对应,所以描述的比较简单,相关之处参见方法部分说明即可。

[0094]

本文中应用了具体个例对本发明的原理及实施方式进行了阐述,以上实施例的说明只是用于帮助理解本发明的方法及其核心思想;同时,对于本领域的一般技术人员,依据本发明的思想,在具体实施方式及应用范围上均会有改变之处。综上所述,本说明书内容不应理解为对本发明的限制。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。