1.本发明主要涉及神经网络和信息压缩技术,具体涉及一种深度特征压缩方法。

背景技术:

2.深度特征压缩旨在将神经网络处理图像产生的深度特征进行压缩,以接近其在完成视觉分析任务时所需要的信息量下界。

3.现有方法中处理以上问题有两类方案:混合编码器方案和基于学习的方案。前者首先将深度特征进行量化,然后使用例如高效率视频编码(hevc)等编码器对量化后的特征进行有损编码。该方案的缺点在于,混合编码器的有损压缩降质与特征在进行视觉分析任务时性能的降质不一致,会导致特征无法提供视觉分析需要的重要信息。同时,该方案假设特征与图像具有类似的性质,这一假设在多种视觉任务中并不成立。

4.基于学习的方案亦可分为两条路线:第一种路线需要在产生特征时施加额外的信息量约束,从而使得特征具有易于压缩的性质;另一种路线采用基于学习的图像压缩方案对特征进行压缩。此类方案仍然具有局限性:第一种路线依赖庞大的数据集,无法直接使用预训练模型;第二种路线仍然假设特征与图像具有类似的性质,压缩效率较低。

技术实现要素:

5.本发明在上述技术背景的前提下,提出一种新型深度特征信息压缩方法及系统。该系统具有以下特性:能够在保持视觉任务执行准确度和效果维持不变的条件下,对深度特征进行有效地压缩;不但能够分别对与不同任务相关的特征进行分别压缩,还能够对多个任务的特征进行协同压缩;压缩后的特征不但能够支持在训练时指明的多项任务,还能够支持训练时未见的新任务。

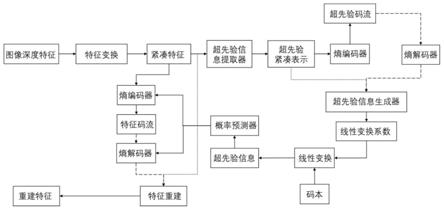

6.本发明对特征的压缩方法基于码本超先验模型,该模型首先对神经网络提取的图像特征表示进行变换,产生变换后的紧凑表示,其特点是具有便于概率估计的数据结构,即该表示中各个元素倾向于在下述的超先验码流的条件下,各自独立分布;此外,提取变换后的表示的超先验码流;特别地,超先验码流用于产生码本各个基元素的线性组合系数;其中,码本从特征中学习获得。根据线性组合系数和对应的码本,模型产生超先验概率估计,该概率估计用于确定变换后的表示每个元素的概率分布,从而使用熵编码器进行熵编码,产生码流。码流通过熵解码和解码变换,产生输出的特征表示。该模型能够对深度特征进行有效压缩。

7.该系统能够对多个任务特征进行协同压缩。多个神经网络提取多个深度特征,深度特征在变换中进行融合,使用码本超先验模型进行压缩和解压缩重建。重建时,对特征进行分离操作,分别产生对应不同任务的重建特征。

8.该系统能够支持训练时未见的新任务。基于上述压缩后的特征或压缩后的融合特征,训练新的解码器,产生新的重建特征,可以使得新重建特征支持原训练过程中未见的新任务。

9.接下来描述本发明的主要处理流程:

10.首先给出针对单个多层神经网络的处理流程。

11.步骤1:获得经过训练的一个多层神经网络和对应的有标注的图像数据集(例如imagenet,coco,taskonomy等),数据集包含多组图像

‑

标签对{(x

i

,y

i

)},其中每个x

i

是图像,y

i

是x

i

对应的标签。该神经网络可以由对应训练数据集训练得到,或可以采用已有的已经训练完成的神经网络,但要求该训练完成的神经网络能够完成该数据集对应的任务,即给定神经网络输入x

i

,神经网络能够给出预测使得给定的失真函数较小,其中失真函数通常已由数据集对应的任务确定。假设该多层神经网络包含m层。

12.步骤2:基于步骤1给定的m层神经网络,选取其中一层,假定为第m层,获得该层的输出维度,构建压缩模型。压缩模型包含特征变换模块、超先验信息提取器、可学习码本、超先验信息生成器、概率预测器、熵编码器、特征重建模块。

13.步骤3:获得步骤1中选定的数据集,训练压缩模型。对于数据集中的图像

‑

标签对{(x

i

,y

i

)},将x

i

输入步骤1给定的m层神经网络,提取其第m层输出h,送入特征变换模块,得到紧凑特征z,然后送入超先验信息提取器以及公知的超先验信息熵编码器,得到超先验紧凑表示v和超先验码流b

v

,以及计算得到码流b

v

的信息熵h

v

。超先验紧凑表示v经过超先验信息生成器,得到n组线性变换系数每组线性变换系数个数为τ。模型中包含码本{c1,c2,

…

,c

τ

},码本为可学习参数,在训练过程中经过优化过程获得。根据所得n组线性变换系数和模型内存储的码本,经过线性变换得到变换结果并且组成超先验信息送入概率预测器,得到对紧凑特征z的概率预测p(z|v)。利用该概率预测和公知的算术编码器,对于紧凑特征中的每个元素,根据其概率预测结果,使用算数编码器将该元素编码为二进制码流,紧凑特征中所有元素的码流拼接后,得到紧凑特征码流b

z

,该过程同时计算得到码流b

z

的信息熵h

z

。紧凑特征z经过特征重建模块,产生重建特征从第m 1层送入m层神经网络,得到最后的输出结果计算损失函数其中控制率失真权衡的拉格朗日乘子λ根据实际需要给定,使用反向传播算法,更新特征变换模块、超先验信息提取器、可学习码本、超先验信息生成器、概率预测器、熵编码器、特征重建模块中的可学习参数,迭代进行训练,直到损失函数l在迭代中收敛,或达到最大训练次数时停止。

14.步骤4:基于步骤3获得的压缩模型,针对图像输入x,基于步骤1中给定的一个神经网络,选取步骤2中确定的层,获得该输入图像对应层的特征表示h'。

15.步骤5:基于步骤4的特征表示,使用步骤3训练后的压缩模型进行压缩。将图像x在该m层神经网络第m层的输出特征h'作为待压缩特征输入训练后的压缩模型,得到对应的超先验码流b

v

'和紧凑特征码流b

z

'。

16.步骤6:基于步骤5得到的码流b

v

'和b

z

'。对于b

v

',使用熵解码器进行解码,得到v',以v'为超先验紧凑表示,如步骤3描述,在经过训练后的压缩模型内存储的码本参与下,依次经过超先验信息生成器、线性变换、概率预测器,得到对紧凑特征z'的概率预测p(z'|v')。利用该概率预测和公知的算术解码器,将概率预测和解码码流b

z

'输入解码器中,进行

熵解码得到紧凑特征z',经过特征重建模块,产生重建特征从第m 1层送入m层神经网络,得到步骤一所描述的视觉分析任务(例如图像分类、图像语义分割、图像平面法向量估计等任务)的结果

17.接下来给出针对多个多层神经网络的处理流程。

18.步骤1:获得经过训练的n个多层神经网络和对应的有多项标注的图像数据集(例如taskonomy),数据集包含多组图像

‑

多标签对{(x

i

,y

i1

,

…

,y

in

)},表示该数据集支持n个任务,每个x

i

是图像,y

in

是该数据集支持第n个任务时,x

i

对应的标签。每个神经网络可以由对应训练数据集分别针对每个任务训练得到,或可以采用已有的已经训练完成的神经网络,但要求该训练完成的神经网络能够分别完成该数据集对应的任务1到n,即对于第n个任务,给定第n个神经网络输入x

i

,神经网络能够给出预测使得给定的失真函数较小,其中失真函数通常已由数据集对应的任务确定。假设第n个神经网络包含m

n

层。

19.步骤2:基于步骤1给定的n个神经网络,每个神经网络选取其中一层,假定第n个神经网络选择了第m

n

层,分别获得该层的输出维度。为这些选定层提取的特征构建统一的一个压缩模型,包含特征融合模块、特征变换模块、超先验信息提取器、可学习码本、超先验信息生成器、概率预测器、熵编码器、特征重建模块、特征分离模块。其中特征融合模块包含n个子网络,第n个子网络对应第n个神经网络的第m

n

层输出的特征。这n个子网络分别将特征作为输入,使用卷积神经网络进行变换,使得变换之后的特征能够进行沿着通道维度的拼接。即,假设第n个变换后的特征形状为(b

n

,c

n

,h

n

,w

n

),其中b是p大小,c是通道数,h和w是长和宽,则对于第1,2,

…

,n,

…

,n个变换后的特征,它们具有相同的b、h和w。此外,特征分离模块包含n个子网络,每个子网络均接受特征重建模块产生的重建特征作为输入,其中,第n个子网络接收重建特征作为输入,产生与第n个神经网络第m

n

层输出的特征形状一致的,第n个重建特征输出。

20.步骤3:获得步骤1中选定的数据集,训练压缩模型。对于数据集中的图像

‑

标签对{(x

i

,y

i1

,y

i2

,

…

,y

in

)},将x

i

输入步骤1给定的n个神经网络,分别提取第n个神经网络第m

n

层输出h

n

。将h1,

…

,h

n

分别送入特征融合模块的第1,

…

,n个子网络,产生变换后的特征,然后沿着通道维度进行拼接,得到拼接后的特征张量h

*

,将其送入特征变换模块,得到紧凑特征z。接下来,与单任务流程类似地,将z送入超先验信息提取器以及公知的超先验信息熵编码器,得到超先验紧凑表示v和超先验码流b

v

,以及计算得到码流b

v

的信息熵h

v

。超先验紧凑表示v经过超先验信息生成器,得到n组线性变换系数每组线性变换系数个数为τ。模型中包含码本{c1,c2,

…

,c

τ

},码本为可学习参数,在训练过程中经过优化过程获得。根据所得n组线性变换系数和模型内存储的码本,经过线性变换得到变换结果并且组成超先验信息送入概率预测器,得到对紧凑特征z的概率预测p(z|v)。利用该概率预测和公知的算术编码器,得到紧凑特征码流b

z

,并且计算得到码流b

z

的信息熵h

z

。紧凑特征z经过特征重建模块,产生重建特征使用特征分离模块,将重建特征分离为其中从第n个网络的第m

n

1层送入第n个神经网络,得到最后的输出结果计算损失函数

其中λ1到λ

n

分别表示第1个到第n个任务,及其对应的第1个到第n个神经网络,在损失函数计算中应当采用的,用于控制率失真权衡的拉格朗日乘子,其中各个λ

n

的值按实际需要给定。使用反向传播算法,更新特征融合模块、特征变换模块、超先验信息提取器、可学习码本、超先验信息生成器、概率预测器、熵编码器、特征重建模块、特征分离模块中的可学习参数,迭代进行训练。

21.步骤4:基于步骤3获得的压缩模型,针对图像输入x,基于步骤1中给定的n个神经网络,选取步骤2中确定的层,获得该输入图像对应层的特征表示h1',

…

,h

n

'。

22.步骤5:基于步骤4的特征表示,使用步骤3训练后的压缩模型进行压缩。将h1',

…

,h

n

'送入特征融合网络,得到h

*

',将其作为拼接后的特征张量,作为待压缩特征输入训练后的压缩模型,得到对应的超先验码流b

v

'和紧凑特征码流b

z

'。

23.步骤6:基于步骤5得到的码流b

v

'和b

z

'。对于b

v

',使用熵解码器进行解码,得到v',以v'为超先验紧凑表示,如步骤3描述,在经过训练后的压缩模型内存储的码本参与下,依次经过超先验信息生成器、线性变换、概率预测器,得到对紧凑特征z'的概率预测p(z'|v')。利用该概率预测和公知的算术解码器,由b

z

'获得紧凑特征z',经过特征重建模块,产生重建特征并经过特征分离模块,产生其中从第n个网络的第m

n

1层送入第n个神经网络,得到最后的输出结果得到步骤一所描述的n个视觉分析任务(例如图像分类、图像语义分割、图像平面法向量估计等任务)中,第n个任务的结果。

24.最后介绍支持压缩模型训练时未曾专门优化的新任务的处理流程。

25.步骤1:假设已有前述针对单个神经网络或多个神经网络的处理流程的步骤1

‑

3获得训练完成的压缩模型,记为f,以及对应选定的一个神经网络的前m层,或者多个神经网络的前m1,

…

,m

n

,

…

,m

n

层,记为g,其中图像x经过g得到特征,该特征经过f得到码流和重建特征。针对一个新任务,获得经过训练的一个多层神经网络和对应的有标注的图像数据集(例如imagenet,coco,taskonomy等),数据集包含多组图像

‑

标签对{(x

i

,y

i

)},其中每个x

i

是图像,y

i

是x

i

对应的标签。该神经网络可以由对应训练数据集训练得到,或可以采用已有的已经训练完成的神经网络,但要求该训练完成的神经网络能够完成该数据集对应的任务,即给定神经网络输入x

i

,神经网络能够给出预测使得给定的失真函数较小,其中失真函数通常已由数据集对应的任务确定。假设该多层神经网络包含k层,选取其中一层,假定为第k层,获得该层的输出维度。

26.步骤2:基于步骤1给定的压缩模型f,将该模型f中的特征重建模块中的参数重置为随机值,并使得其输出维度与步骤1获得的输出维度相同。若存在特征分离模块,将其删除,得到模型f

*

。

27.步骤3:基于步骤1中得到的处理过程g,和步骤2中得到的模型f

*

,进行特征重建模块的训练。具体来说,对于数据集中的图像

‑

标签对{(x

i

,y

i

)},将x

i

输入g后得到特征输入模型f

*

,得到紧凑特征z

″

,紧凑特征z

″

经过特征重建模块,产生重建特征从第k 1层送入步骤1中选定的k层神经网络,得到最后的输出结果计算损失函数使用反向传播算法,更新特征重建模块中的可学习参数,迭代进行训练。与前述训练流程的不同之处在于,不需要计算超先验表示v,也不需要计算各项信息熵;此外,仅需要训练重置参数后的特

征重建模块,损失函数也有所不同。

28.步骤4:基于步骤3获得的训练完成的模型f

*

,以及处理过程g,针对图像输入x,可由f

*

(g(x))获得压缩后的特征码流b

v

″

和b

z

″

。

29.步骤5:基于步骤4得到的码流b

v

″

和b

z

″

。使用模型f

*

,按照前述针对单个多层神经网络的处理流程步骤6,可得到表示紧凑特征z

″

,再经过模型f

*

中由步骤3训练得到的特征重建模块,产生重建特征从第k 1层送入步骤1中选定的k层神经网络,得到最后的输出结果即为压缩模型训练时未曾专门优化新任务(例如图像分类、图像语义分割、图像平面法向量估计等任务)上的分析结果。

30.与现有技术相比,本发明的积极效果为:

31.本发明能够在保持视觉任务执行准确度和效果维持不变的条件下,对深度特征进行有效地压缩;不但能够分别对与不同任务相关的特征进行分别压缩,还能够对多个任务的特征进行协同压缩;压缩后的特征不但能够支持在训练时指明的多项任务,还能够支持训练时未曾专门优化的新任务。

附图说明

32.图1为本发明特征编解码流程图;

33.图2为本发明特征提取分析流程图;

34.图3为本发明码本超先验压缩模型结构图;

35.图4为本发明支持多任务以及新任务流程图。

具体实施方式

36.为了对本发明的技术方法进一步阐述,下面结合说明书附图和具体实例,对本发明中的训练以及特征编码压缩以及解码流程进行进一步的详细说明。需说明的是,以下实施例所给出的任务选择、特征提取网络结构参数、特征维度、特征及任务数量、任务具体采用的失真函数形式以及参数等仅为一种较佳的实施方式,而不用于限制,本领域技术人员可以根据实际需要来选取,应可理解。

37.实例一为一种针对1000类图像分类任务的视觉深度特征压缩和重建方法,具体说明如下:

38.步骤1:针对该任务,准备数据集。数据集中包含图像x和图像对应的真实标签y,并定义失真函数具体形式可以为交叉熵函数,表示某一输出与真实标签y的差异大小。

39.步骤2:以如图2所示流程,以及表1所示结构,其中b为批大小,h和w为图像尺寸,构建m层的特征提取分析网络。使用步骤1中的数据集和失真函数训练网络,直到收敛。

40.表1用于图像分类任务的多层神经网络结构示例

[0041][0042]

步骤3:选取步骤2得到的网络中的第m层,对于图像x,输出h作为待编码特征,其形状为b,8,h/64,w/64。m=1对应于输入层。

[0043]

步骤4:以如图1所示流程以及图3实线以及点状虚线所示结构和流程构建特征压缩模型,包括特征变换模块、超先验信息提取器、可学习码本、超先验信息生成器、概率预测器、熵编码器、特征重建模块、特征分离模块。其中,h首先经过特征变换模块,得到紧凑特征z。其中,紧凑特征z可由训练后的表2所示结构,从h中得到,第7层的输出结果即为z,为离散张量,具有易于进行概率估计的数据结构。

[0044]

表2由h产生紧凑特征z的神经网络结构示例

[0045][0046][0047]

由z经过超先验信息提取器模块,得到超先验紧凑表示v。超先验信息提取模块示例结构如表3所示。

[0048]

表3超先验信息提取模块示例结构

[0049]

层号操作输入形状输出形状激活函数1卷积b,128,h/64,w/64b,64,h/64,w/64relu2卷积b,64,h/64,w/64b,512,h/64,w/64relu3全局池化b,512,h/64,w/64b,512无4全连接b,512b,512relu5全连接b,512b,128无

[0050]

超先验紧凑表示v由熵编码器得到超先验码流b

v

,计算得到码流b

v

的信息熵h

v

。

[0051]

超先验紧凑表示v经过超先验信息生成器,得到n组线性变换系数每组线性变换系数个数为τ。超先验信息生成器示例结构如表4所示。技术人员可根据需要设置n和τ,本实例中,设置n=128,τ=512。其中,表示所示结构,重整之后,产生128组线性变换系数,每组有512个系数。

[0052]

表4超先验信息生成器的示例结构

[0053]

层号操作输入形状输出形状激活函数1全连接b,128b,512relu2全连接b,512b,512relu

3全连接b,512b,512relu4全连接b,512b,128*512无5重整b,128*512b,128,512无

[0054]

根据所得n=128组,每组τ=512个线性变换系数,和模型内存储的τ=512个码本{c1,c2,

…

,c

τ

},经过线性变换得到变换结果并且组成超先验信息送入概率预测器,得到对紧凑特征z的概率预测p(z|v)。其中,概率预测器的示例结构如表5展示。

[0055]

表5概率预测器的示例结构

[0056][0057][0058]

重整之后,产生形状为b,2,128,h/64,w/64的张量,由将第二维拆分,形成两组b,128,h/64,w/64的张量。每个张量形状与z一致,其中一个张量表示均值,另外一个经过exp操作后表示标准差,使用预测z的概率。其中,q

f

和q

g

对应表5中各层的可学习参数。利用该概率预测和公知的算术编码器,得到紧凑特征码流b

z

,并且计算得到码流b

z

的信息熵h

z

。紧凑特征z经过特征重建模块,产生重建特征特征重建模块示例结构如表6所示。

[0059]

表6特征重建模块示例结构

[0060]

层号操作输入形状输出形状激活函数1卷积b,128,h/64,w/64b,1024,h/64,w/64relu2卷积b,1024,h/64,w/64b,1024,h/64,w/64relu3卷积b,1024,h/64,w/64b,512,h/64,w/64relu4卷积b,512,h/64,w/64b,256,h/64,w/64relu5卷积b,256,h/64,w/64b,128,h/64,w/64relu6卷积b,128,h/64,w/64b,8,h/64,w/64无

[0061]

步骤5:使用特征提取分析网络剩余层处理步骤4所得的重建特征即将重建特征从表1所示第m 1层送入神经网络,得到最后的输出结果

[0062]

步骤6:以步骤1收集得到的训练集,固定特征提取分析网络所有层的参数,计算损失函数其中λ根据实际需要选取多个取值,训练特征压缩模型,直到收敛。固定特征提取分析网络的目的是节省训练时需要更新的参数量,并且利用预训练的特征提取分析网络指导压缩模型的训练,在实际实现中,也可以在训练时更新所有参数。损失函数的形式使得训练能够权衡模型压缩后的码率h

z

h

v

和实际执行任务的误差率

技术人员可选择不同的λ取值来调整不同应用场景下的权衡。

[0063]

步骤7:训练完成后,针对任意图像,经过如图1所示流程,可获得压缩后的特征。同时,压缩后的特征经过如图1所示流程,可实现对相应图像的分析。上述过程的实现与步骤4至5基本一致,区别在于在步骤4中应采用图3实线以及线段虚线所示流程。由于训练已完成,不再需要步骤2和步骤6的训练过程。

[0064]

注:步骤3中对层的选取不受限,具体实现方案中可根据需要,直接将图像作为特征进行压缩、选取若干层后的特征进行压缩、或是直接选取最后一层的输出作为待压缩特征,亦符合本发明的精神。此外,压缩模型输出的特征亦可经过任意层的剩余特征提取分析网络得到结果,或不经过剩余层直接作为分析结果,亦符合本发明的精神。

[0065]

实例二为一种同时支持1000类图像分类任务和图像平面法向量估计任务的,视觉深度特征压缩和重建方法,具体说明如下:

[0066]

步骤1:如实例一步骤1所描述,区别在于数据集中包含图像和对应的分类任务以及平面法向量估计任务的真实标签。对于每一张图像,均包含两个任务的标签。

[0067]

步骤2:如实例一步骤2所描述,区别在于多个任务分别训练特征提取分析网络。其中,图像分类任务特征提取分析网络如表1所示;平面法向量估计任务的特征提取分析网络如表7所示。

[0068]

表7平面法向量估计任务的特征提取分析网络结构示意

[0069]

层号操作输入形状输出形状作用1,

…

,m卷积b,3,h,wb,8,h/64,w/64图像特征提取m 1卷积b,8,h/64,w/64b,128,h/64,w/64图像特征处理m 2反卷积b,128,h/64,w/64b,64,h/32,w/32图像特征处理m 3,

…

,m反卷积b,64,h/32,w/32b,3,h,w将特征重建为平面法向量图

[0070]

步骤3:选取两个网络各自的第m层,以及对应的输出特征一h1,和特征二h2。技术人员实现时可根据需要为不同网络选取不同的m取值。

[0071]

步骤4:如图4所示,首先由神经网络构建特征融合压缩模型,包括特征融合模块、特征变换模块、超先验信息提取器、可学习码本、超先验信息生成器、概率预测器、熵编码器、特征重建模块、特征分离模块。其中,特征融合模块包含2个子网络,分别处理特征一和特征二。子网络结构均如表8所示。子网络处理后,输出的2个特征张量在通道维度上拼接,产生形状为b,16,h/64,w/64的拼接后的特征张量h

*

。接下来地处理方法与实例一步骤3到4类似,区别在于实例一中被压缩地张量为h,此处替换为h

*

,对应的输入形状也稍作改变;同时,实例一中重建的特征为此处为对应的输出形状改为b,16,h/64,w/64。

[0072]

表8特征融合模块2个子网络的示例结构

[0073]

层号操作输入形状输出形状激活函数1卷积b,8,h/64,w/64b,512,h/64,w/64relu2卷积b,512,h/64,w/64b,256,h/64,w/64relu3卷积b,256,h/64,w/64b,128,h/64,w/64relu4卷积b,128,h/64,w/64b,8,h/64,w/65无

[0074]

步骤5:由神经网络构建特征拆分模块,拆分步骤4构建的模型输出的重建特征,为每一个任务构建其单独的重建特征。其中,拆分模块包含2个子网络,每个子网络的结构如

表9所示。拆分后,产生重建特征和使用步骤1中描述的2个特征提取分析网络剩余层处理重建特征和得到最后的输出结果和

[0075]

表9特征拆分模块子网络的示例结构

[0076]

层号操作输入形状输出形状激活函数1卷积b,16,h/64,w/64b,512,h/64,w/64relu2卷积b,512,h/64,w/64b,256,h/64,w/64relu3卷积b,256,h/64,w/64b,128,h/64,w/64relu4卷积b,128,h/64,w/64b,8,h/64,w/65无

[0077]

步骤6:以步骤1收集得到的训练集,固定特征提取分析网络所有层的参数,计算损失函数其中λ1和λ2根据实际需要选取多个取值,训练特征压缩模型,直到收敛。固定特征提取分析网络的目的是节省训练时需要更新的参数量,并且利用预训练的特征提取分析网络指导压缩模型的训练,在实际实现中,也可以在训练时更新所有参数。损失函数的形式使得训练能够权衡模型压缩后的码率h

z

h

v

和实际执行任务的误差率,技术人员可选择不同的λ1和λ2取值来调整不同应用场景下的权衡。

[0078]

步骤7:训练完成后,针对任意图像,经过如图1所示流程,可获得压缩后的特征。同时,压缩后的特征经过如图1所示流程,可实现对相应图像的多任务分析。上述过程的实现与步骤4至5基本一致,区别在于在步骤4中应采用图3实线以及线段虚线所示流程。由于训练已完成,不再需要步骤2和步骤6的训练过程。

[0079]

注:图4展示的实例为支持两个任务的流程,技术人员可进行简单改动以支持不同数量的不同任务,而不脱离本发明的精神和范围。

[0080]

实例三为一种针对一新任务(以图像语义分割为例)的视觉深度特征压缩和重建方法,具体说明如下:

[0081]

步骤1:由实例一步骤1至6或者实例二步骤1

‑

6获得特征编码压缩模型。

[0082]

步骤2:针对图像语义分割任务准备数据集。数据集中包含图像x和图像对应的真实标签y,并定义失真函数表示某一输出与真实标签y的差异大小。

[0083]

步骤3:以如图2所示流程构建m层的特征提取分析网络,示例结构如表10所示。使用步骤1中的数据集和失真函数训练网络,直到收敛。

[0084]

表10图像语义分割任务的特征提取分析网络结构示意

[0085]

层号操作输入形状输出形状作用1,

…

,m卷积b,3,h,wb,8,h/64,w/64图像特征提取m 1卷积b,8,h/64,w/64b,128,h/64,w/64图像特征处理m 2反卷积b,128,h/64,w/64b,64,h/32,w/32图像特征处理m 3,

…

,m反卷积b,64,h/32,w/32b,17,h,w将特征重建为图像分割结果

[0086]

步骤4:选取步骤3中特征提取分析网络第m层之后的层,层数m可由实际决定。

[0087]

步骤5:如图4构建新特征重建网络,替换步骤1的特征压缩模型中的特征重建网络,由融合压缩特征,经过新特征重建网络和步骤4中的m 1层至m层特征提取分析网络,产生针对新任务的分析结果。其中,新特征重建网络的结构如表6所示。

[0088]

步骤5:固定网络其他部分,在数据集上训练新特征重建网络,使用失真函数作为损失函数,直到收敛。

[0089]

步骤6:针对某一图像,如图4可由特征融合压缩获得码流,并且由新特征重建和对应的分析获得分析结果。

[0090]

显然,本领域的技术人员可以对本发明进行各种改动和变型而不脱离本发明的精神和范围。这样,倘若本发明的这些修改和变型属于本发明权利要求及其等同技术的范围之内,则本发明也意图包含这些改动和变型在内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。