一种基于普通视频流的3d人脸模型表情自动生成方法

技术领域

1.本发明涉及图像表情迁移技术领域,尤其涉及一种基于普通视频流的3d人脸模型表情自动生成方法。

背景技术:

2.如今cg技术越来越多地应用到影视创作当中来,而针对人脸的3d建模是最常见的应用场景之一。通过进行3d人脸建模,并且采集人脸表情数据进行合成,可以实现虚拟人物表演等目的。该应用场景中关键的一环是人脸表情的采集与导入,目前的解决方案主要包括如下两种:

3.(1)利用头盔式3d面部表情捕捉系统。系统采用视觉三维测量原理,对人脸表面的密布特征点集进行实时运动跟踪和重建,得到面部肌肉高度精细的三维空间运动轨迹,可直接用于驱动面部动画模型,生成表情动画;

4.(2)利用软件中的面部表情调整插件。专业的3d建模软件如maya等提供了面部表情调整插件,通过逐帧调节参数也可以模拟各种表情。

5.上述两种方案虽均能实现3d人脸模型表情的制作,但仍存在一定的缺陷,如第一种解决方案,其专业性需求较高,且运行成本较高,而运用第二种解决方案,对于诸如影视换脸的场景(通过cg等技术将已经拍摄好的视频中某个人物替换掉),由于素材已经拍摄处理完毕,如果想要进行3d人脸表情采集,需要演员重新进行表演,或者由后期人员逐帧手动调整模型的表情来还原,时间和人力成本都非常高。

技术实现要素:

6.本发明的目的在于提供一种基于普通视频流的3d人脸模型表情自动生成方法,实现低成本及在无需人员配合的条件下快速完成表情的采集工作。

7.本发明的实现流程如下:

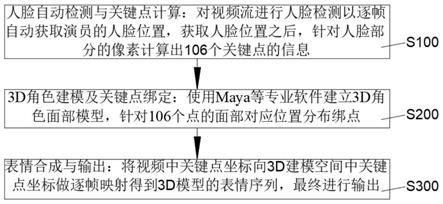

8.一种基于普通视频流的3d人脸模型表情自动生成方法,包括如下步骤:

9.s100、人脸自动检测与关键点计算:对视频流进行人脸检测以逐帧自动获取演员的人脸位置,获取人脸位置之后,针对人脸部分的像素计算出106个关键点的信息;

10.s200、3d角色建模及关键点绑定:使用maya等专业软件建立3d角色面部模型,针对106个点的面部对应位置分布绑点;

11.s300、表情合成与输出:将视频中关键点坐标向3d建模空间中关键点坐标做逐帧映射得到3d模型的表情序列,最终进行输出。

12.在步骤s100中,所述获取人脸位置的具体方法为:采用深度学习人脸检测算法s3fd获取人脸序列,用(x1,y1,x2,y2,t)五元组进行表示,其中:

13.t表示帧号,x1,y1表示人脸外接框的左上角坐标,x2,y2表示人脸外接框右下角坐标。

14.在步骤s100中,所述106个关键点的信息组成涵盖脸部轮廓,眼睛,口,鼻及表情动

作。

15.在步骤s100中,所述监测106个关键点信息的具体方法为:采用深度学习算法pfld检测出106个关键点的信息,用(x1,y1,x2,y2,...x

106

,y

106

,t)进行表示,其中:

16.x

i

,y

i

表示关键点i的坐标,t表示帧号。

17.所述得到3d模型的表情序列的具体步骤为:

18.s301、采用坐标转换算法对3d模型的关键点坐标进行转换,并对坐标转换算法进行优化,得到每帧的旋转参数;

19.s302、将旋转参数与3d模型中的参数进行相应位置的变换。

20.在步骤s301中,所述坐标转换算法的运算函数为:

[0021][0022]

其中,s表示缩放系数,r表示旋转矩阵,s是3d模型中关键点的坐标,t是位移,yi是视频中的像素坐标。r用以下九个参数表示:

[0023]

n表示所有关键点的个数。

[0024]

在步骤s301中,所述坐标转换算法采用非线性最小二乘的方法进行优化。

[0025]

通过上述技术方案,本发明具有如下有益效果:

[0026]

(1)本发明能够实现3d人脸模型表情的自动快速生成,无需人工配合,相对于现有技术中的利用maya面部表情调整插件的解决方案,大大降低了的人力成本以及大大节省了时间;

[0027]

(2)本发明通过普通的相机拍摄的视频流实现3d面部表情的采集,并且能够导入到主流的3d建模软件当中,相对于现有技术中利用头盔式3d面部表情捕捉系统的解决方案,专业性要求较低,同时运行陈本低。

附图说明

[0028]

图1是本发明基于普通视频流的3d人脸模型表情自动生成方法的流程示意图;

[0029]

图2是本发明基于普通视频流的3d人脸模型表情自动生成方法中得到3d模型的表情序列的流程示意图。

具体实施方式

[0030]

下面结合附图和具体实施例对本发明作进一步说明。

[0031]

请参见附图1,一种基于普通视频流的3d人脸模型表情自动生成方法,包括如下步骤:

[0032]

s100、人脸自动检测与关键点计算:对视频流进行人脸检测以逐帧自动获取演员的人脸位置,获取人脸位置之后,针对人脸部分的像素计算出106个关键点的信息;

[0033]

具体的,视频流导入后,首先需要对视频流进行人脸检测以逐帧获取演员的人脸位置,此处采用深度学习人脸检测算法s3fd,用(x1,y1,x2,y2,t)五元组进行表示,其中,t表示帧号,x1,y1表示人脸外接框的左上角坐标,x2,y2表示人脸外接框右下角坐标,获取人脸

位置之后,针对人脸部分的像素,单独采用深度学习算法pfld检测出106个关键点的信息,用(x1,y1,x2,y2,...x

106

,y

106

,t)进行表示,其中,x

i

,y

i

表示关键点i的坐标,t表示帧号,106个关键点的信息组成涵盖脸部轮廓,眼睛,口,鼻及表情动作。

[0034]

s200、3d角色建模及关键点绑定:使用maya等专业软件建立3d角色面部模型,针对106个点的面部对应位置分布绑点;

[0035]

具体的,使用maya专业软件建立3d角色面部模型以及关键点的绑定均为3d建模中常见的操作,在此不做赘述,通过对106个点的面部对应位置进行分布绑点,实现了对面部表情进行灵活控制。

[0036]

s300、表情合成与输出:将视频中关键点坐标向3d建模空间中关键点坐标做逐帧映射得到3d模型的表情序列,最终进行输出。

[0037]

具体的,实现了视频人脸关键点序列检测与3d模型建模和关键点绑定操作之后,为了实现视频中人脸表情向3d角色表情的导出,需要将视频中关键点坐标向3d建模空间中关键点坐标做逐帧映射,从而达成控制3d模型产生对应表情的效果,如图2所示,具体操作为:

[0038]

s301、采用坐标转换算法对3d模型的关键点坐标进行转换,并对坐标转换算法进行优化,得到每帧的旋转参数;

[0039]

具体的,坐标转换算法的运算函数为:

[0040][0041]

其中,s表示缩放系数,r表示旋转矩阵,s是3d模型中关键点的坐标,t是位移,yi是视频中的像素坐标。r用以下九个参数表示:

[0042]

n表示所有关键点的个数,可知该运算函数的目的是寻找旋转矩阵参数,缩放系数和t,使得3d模型坐标进行转换后和视频中的像素平面坐标匹配,为达到这个目的,使用非线性最小二乘的方法,进行优化,如高斯

‑

牛顿方法;

[0043]

s302、将旋转参数与3d模型中的参数进行相应位置的变换;

[0044]

具体的,在得到每帧的旋转参数后,对3d建模中的参数进行相应坐标变换,逐帧完成计算后即得到3d模型的表情序列。

[0045]

综上所述,本发明相对于现有技术,具有如下优势:

[0046]

(1)利用头盔式3d面部表情捕捉系统进行3d人脸模型表情的制作,其运行陈本及专业需求均较高,本发明提供的基于普通视频流的3d人脸模型表情自动生成方法,可通过普通的相机拍摄的视频流实现3d面部表情的采集,并且能够导入到主流的3d建模软件当中,运行成本低,且专业需求低;

[0047]

(2)利用maya面部表情调整插件手动进行3d人脸模型表情的制作,其人力陈本较大,同时较为费时,本发明提供的基于普通视频流的3d人脸模型表情自动生成方法,能够实现3d人脸模型表情的自动快速生成,无需人工配合,大大降低了人力陈本以及大大节省了时间。

[0048]

以上仅为本发明的较佳实施例而已,并非用于限定本发明的保护范围,因此,凡在

本发明的精神和原则之内所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。