1.本发明涉及无线胶囊内窥镜的定位,特别是涉及一种无线胶囊内窥镜的体内相对定位方法和装置。

背景技术:

2.无线胶囊内窥镜已经成为了对消化道检查的重要技术手段,特别是在小肠部分的检查尤其重要,这是普通胃镜和肠镜无法检查的区域。无线胶囊内窥镜是一颗胶囊般大小的机器人。它搭载了相机模块、图像处理模块、无线传输模块,能够在病人体内拍摄图像并实时传输到体外,医生可以根据传输出来的图像进行诊断。与此同时,病人也没有胃镜、肠镜检查时的痛苦。然而,如果医生在某张图片上发现了病变,医生并没有足够的信息来判断这个图片拍摄于体内哪个部位。如果能知道胶囊拍摄病变图片时所处的位置,那医生就能更快地做出诊断和后续的治疗方案。因此,计算判断出胶囊的位置是非常重要的。同时,医生更希望的是得到的是胶囊拍摄的病变图片的位置相对于某一个器官内的重要位置的距离,比如病变图片相对于胃的末端幽门多少厘米处,这样的相对距离描述更符合医生的需求。本发明将根据胶囊拍摄的图片通过基于非监督学习的视觉里程计算法来获取当前胶囊相对于生物解剖界标的相对位置。

3.现有的无线胶囊内窥镜定位系统主要有胶囊无线电信号定位、胶囊磁定位和胶囊视觉定位。胶囊无线电信号定位技术是用人体外的传感器阵列获取胶囊发出的无线电信号强度从而定位,但是这种方式定位的结果误差很高。胶囊磁定位技术是在胶囊内部放入一个小永磁铁,在人体外放置磁传感器阵列来获取磁场强度从而来计算胶囊姿态信息,这种方案的误差很小,精度很高。但是以上这两种方法得到的都是固定的三维坐标系下的六自由度的坐标信息,即空间位置信息(x,y,z),和空间旋转信息(α,β,γ),这样的坐标位置信息是“绝对定位”信息,不能得到“相对定位”信息,并不符合医生们的需求。同时,现有的一些胶囊视觉定位技术主要是用来作为无线电信号定位的辅助定位,这也是“绝对定位”,或者是仅进行了视觉特征提取和匹配。而他们的特征提取匹配技术都是在两幅整幅胶囊内镜图像之间进行的。主要利用sift、surf或orb等主流斑点特征提取匹配技术对两幅连续图像进行特征提取匹配,因为胶囊内镜拍到的图像的分辨率不高,比较模糊,而且人的肠道每时每刻都在运动中,肠道都是弹性形变,对两整幅图直接进行匹配很容易出现大量误匹配。另外,还有研究提出可以使用基于深度学习的视觉算法对胶囊进行定位,可以在一定程度上克服肠道的弹性形变,但是也主要是在猪胃这种比较膨大的器官中进行测试,并不是在大肠、小肠这种管状环境进行测试。

4.需要说明的是,在上述背景技术部分公开的信息仅用于对本技术的背景的理解,因此可以包括不构成对本领域普通技术人员已知的现有技术的信息。

技术实现要素:

5.本发明的主要目的在于克服上述背景技术的缺陷,提供一种无线胶囊内窥镜的体

内相对定位方法和装置,在对无线胶囊内窥镜进行体内相对定位时,提高定位准确度和实用性。

6.为实现上述目的,本发明采用以下技术方案:

7.一种无线胶囊内窥镜的体内相对定位方法,包括训练过程和测试过程;

8.其中,所述训练过程包括如下步骤:

9.s1、向基于非监督学习的视觉里程计网络输入无线胶囊内窥镜图片序列,其中,所述图片序列包括源图片和目标图片,所述视觉里程计网络包括“姿态网络”和“深度网络”;

10.s2、由所述“姿态网络”输出所述目标图片转换到所述源图片的位姿变换矩阵以及输出所述目标图片的信任度蒙版矩阵;

11.s3、由所述“深度网络”输出所述目标图片的像素深度预测矩阵;

12.s4、基于所述位姿变换矩阵、所述像素深度预测矩阵和所述信任度蒙版矩阵,根据相机模型将源图像重构投影到目标图像上,计算目标图像与重构图像之间的像素差,称为像素损失;

13.s5、计算信任度蒙版矩阵的交叉熵损失,称为蒙版损失;

14.s6、从目标图像直接估计像素相对深度,计算深度矩阵与所述像素深度预测矩阵之间的差值,称为深度损失;

15.s7、计算所述像素深度预测矩阵的平滑度损失;

16.s8、以所述像素损失、所述蒙版损失、所述深度损失和所述平滑度损失构成损失函数,优化该损失函数,更新网络参数,直到收敛;

17.其中,所述测试过程包括如下步骤:

18.t1、向已经训练完毕的所述视觉里程计网络中输入无线胶囊内窥镜图片序列,包括源图片和目标图片;

19.t2、由所述“姿态网络”输出目标图片转换到源图片的位姿变换矩阵;

20.t3、根据新计算出的位姿变换矩阵和之前从上一个生物解剖界标为起点累计的历史位姿变换矩阵,计算出无线胶囊内窥镜当前相对于上一个生物解剖界标的位姿。

21.进一步地:

22.所述图片序列包含连续的三张图片,其中第一张图片和第三张图片为所述源图片,第二张图片为所述目标图片。

23.所述信任度蒙版矩阵为所述目标图片在四种不同尺度下的信任度蒙版矩阵,所述像素深度预测矩阵为所述目标图片在四种不同尺度下的像素深度预测矩阵。

24.步骤s6中,根据shapefromshading算法从目标图片直接估计像素相对深度,称为sfs深度矩阵,然后计算所述sfs深度矩阵与所述像素深度预测矩阵之间的差值。

25.步骤s7中,计算所述像素深度预测矩阵的每个元素的导数的绝对值的和,作为所述像素深度预测矩阵的平滑度损失。

26.步骤s8中,将所述像素损失、所述蒙版损失、所述深度损失和所述平滑度损失相加,构成所述损失函数。

27.一种基于非监督学习的视觉里程计网络的训练方法,所述视觉里程计网络用于无线胶囊内窥镜的体内相对定位,所述训练方法包括如下步骤:

28.s1、向基于非监督学习的视觉里程计网络输入无线胶囊内窥镜图片序列,其中,所

述图片序列包括源图片和目标图片,所述视觉里程计网络包括“姿态网络”和“深度网络”;

29.s2、由所述“姿态网络”输出所述目标图片转换到所述源图片的位姿变换矩阵以及输出所述目标图片的信任度蒙版矩阵;

30.s3、由所述“深度网络”输出所述目标图片的像素深度预测矩阵;

31.s4、基于所述位姿变换矩阵、所述像素深度预测矩阵和所述信任度蒙版矩阵,根据相机模型将源图像重构投影到目标图像上,计算目标图像与重构图像之间的像素差,称为像素损失;

32.s5、计算信任度蒙版矩阵的交叉熵损失,称为蒙版损失;

33.s6、从目标图像直接估计像素相对深度,计算深度矩阵与所述像素深度预测矩阵之间的差值,称为深度损失;

34.s7、计算所述像素深度预测矩阵的平滑度损失;

35.s8、以所述像素损失、所述蒙版损失、所述深度损失和所述平滑度损失构成损失函数,优化该损失函数,更新网络参数,直到收敛。

36.一种无线胶囊内窥镜的体内相对定位方法,使用通过所述的训练方法训练的视觉里程计网络,所述体内相对定位方法包括如下步骤:

37.t1、向已经训练完毕的所述视觉里程计网络中输入无线胶囊内窥镜图片序列,包括源图片和目标图片;

38.t2、由所述“姿态网络”输出目标图片转换到源图片的位姿变换矩阵;

39.t3、根据新计算出的位姿变换矩阵和之前从上一个生物解剖界标为起点累计的历史位姿变换矩阵,计算出无线胶囊内窥镜当前相对于上一个生物解剖界标的位姿。

40.一种计算机可读存储介质,存储有计算机程序,所述计算机程序由处理器执行时,实现所述的无线胶囊内窥镜的体内相对定位方法。

41.一种无线胶囊内窥镜的体内相对定位装置,包括处理器和计算机可读存储介质,所述处理器执行所述计算机可读存储介质上存储的计算机程序时,实现所述的无线胶囊内窥镜的体内相对定位方法。

42.本发明具有如下有益效果:

43.本发明提供一种无线胶囊内窥镜的体内相对定位方法和装置,通过训练基于无监督学习的视觉里程计网络,可实现对体内可形变管状环境中的无线胶囊内窥镜的相对定位,无需更改无线胶囊内窥镜硬件,并且,利用训练好的视觉里程计网络,可根据给定的图像序列准确估计每个图像的位置和深度,提高定位准确度。本发明可以直接使用胶囊自带的相机的视觉信息来开发视觉里程计,不用另外增加传感器或改装胶囊,使用的基于非监督学习的视觉里程计不需要繁杂的人工标注过程,并且也能通过信任蒙版矩阵解决环境的非弹性形变问题。本发明利用视觉信息对体内的无线胶囊内窥镜进行相对定位,相比现有的方法在实际临床应用中更为实用。

44.本发明优选的方案采用基于阴影形状(shapefromshading,sfs)的深度约束,能够进一步提高深度预测精度和定位精度。基于shapefromshading理论的像素深度矩阵限制,提高了像素深度的估计精度,从而提高了定位精度。

附图说明

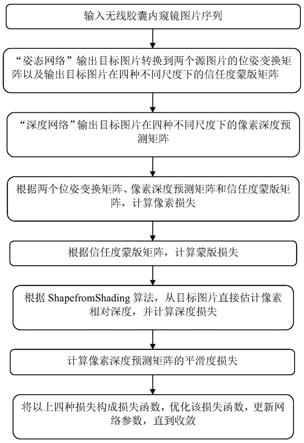

45.图1为本发明一种实施例的无线胶囊内窥镜的体内相对定位方法的训练过程的流程图。

46.图2为本发明一种实施例的无线胶囊内窥镜的体内相对定位方法的测试过程的流程图。

47.图3为本发明一种实施例的视觉里程计网络的结构图。

48.图4为本发明一种实施例的视觉里程计网络输入输出的关系图。

49.图5中(a)展示了胶囊在猪肠中运动过程中拍摄的一张图片,(b)展示这张图片输入“深度网络”后估计的像素深度预测矩阵。

具体实施方式

50.以下对本发明的实施方式做详细说明。应该强调的是,下述说明仅仅是示例性的,而不是为了限制本发明的范围及其应用。

51.参阅图1至图3,在一些实施例中,一种适于可形变管状环境中的无线胶囊内窥镜的基于非监督学习的相对定位方法,包括如下典型的但非限制性的训练过程和测试过程。

52.训练过程包括如下步骤:

53.第一步,向基于非监督学习的视觉里程计网络中输入无线胶囊内窥镜图片序列。视觉里程计网络包含两个子网络,分别为“姿态网络”和“深度网络”。图片序列包含连续的三张图片,其中第一张图片和第三张图片是两张源图片,分别被称为第一源图片,第二源图片,第二张图片被称为目标图片。

54.第二步,将连续的三张图片输入第一个子网络“姿态网络”中,该网络将输出目标图片转换到两个源图片的位姿变换矩阵,同时,该网络还将输出目标图片在四种不同尺度下的信任度蒙版矩阵。

55.第三步,将目标图片输入第二个子网络“深度网络”中,该网络将输出目标图片在四种不同尺度下的像素深度预测矩阵。

56.第四步,基于之前两步中的两个子网路输出的两个位姿变换矩阵、像素深度预测矩阵和信任度蒙版矩阵,根据相机模型将两个源图像重构投影到目标图像上。计算目标图像与两张重构图像之间像素差,称为像素损失。

57.第五步,计算信任度蒙版矩阵的交叉熵损失,称为蒙版损失。

58.第六步,根据shapefromshading算法,从目标图片直接估计像素相对深度,称为sfs深度矩阵。接下来计算sfs深度矩阵与网络输出的像素深度预测矩阵之间的差值,称为深度损失。

59.第七步,计算像素深度预测矩阵的平滑度,即计算该矩阵的每个元素的导数的绝对值的和,称为平滑度损失。

60.第八步,将以上四种损失相加,构成损失函数。优化该损失函数,更新网络参数,直到损失值收敛。

61.测试过程包括如下步骤:

62.第一步,向已经训练完毕的视觉里程计网络中输入无线胶囊内窥镜图片序列。视觉里程计网络包含两个子网络,分别为“姿态网络”和“深度网络”。图片序列包含连续的三

张图片,第一张图片和第三张图片是两张源图片,分别被称为第一源图片,第二源图片,第二张图片被称为目标图片。

63.第二步,将连续的三张图片输入第一个子网络“姿态网络”中,该网络将输出目标图片转换到两个源图片的位姿变换矩阵,同时,该网络还将输出目标图片在四种不同尺度下的信任度蒙版矩阵。

64.第三步,根据新计算出的两个位姿变换矩阵和之前从上一个生物解剖界标为起点累计的历史位姿变换矩阵,可以计算出胶囊目前相对于上一个生物解剖界标的位姿。

65.本发明可以用于无线胶囊内窥镜在人体消化道内检查时的相对定位。医生可以将无线胶囊内窥镜拍摄到的图像序列或视频传给该软件,该软件将对图像序列/视频进行分析,从而估计胶囊内窥镜相对于某个生物解剖界标的相对距离。

66.以下结合附图进一步描述本发明具体实施例的训练和测试的过程。

67.训练过程

68.第一步,向基于非监督学习的视觉里程计网络中输入无线胶囊内窥镜图片序列。如图3所示,视觉里程计网络包含两个子网络,分别为“姿态网络”和“深度网络”。图片序列包含连续的三张图片,第一张图片和第三张图片是两张源图片,分别被称为第一源图片,第二源图片,第二张图片被称为目标图片。

69.第二步,如图3中的(a),将连续的三张图片i

t

‑1,i

t

,i

t 1

输入第一个子网络“姿态网络”中,该网络将输出目标图片i

t

转换到两个源图片i

s

,s∈{t

‑

1,t 1}的位姿变换矩阵t1,t2,同时,该网络还将输出目标图片在四种不同尺度下的信任度蒙版矩阵m

s,l

,s∈{t

‑

1,t 1},l∈{0,1,2,3}。

70.第三步,如图3中的(b),将目标图片i

t

输入第二个子网络“深度网络”中,该网络将输出目标图片在四种不同尺度下的像素深度预测矩阵d

t,l

,l∈{0,1,2,3}。

71.第四步,基于之前两步中的两个子网路输出的两个位姿变换矩阵t1,t2、像素深度预测矩阵d

t,l

和信任度蒙版矩阵m

s,l

,根据相机模型将两个源图像重构投影到目标图像上。计算目标图像与两张重构图像之间像素差,称为像素损失。

72.由于使用非监督学习,所以整个训练过程中输入只有图像序列,没有标签输入,输出包含位姿变换,像素深度预测,和信任度蒙版。所有这些输入输出之间的关系如图4所示,这些量之间形成了自我监督限制。

73.相机模型被用来作为网络的自我监督。如果目标图片i

t

是源图片i

s

,s∈{t

‑

1,t 1}的重构目标,源图片的投影重构图片是i

′

s

,则目标图片和投影重构图片之间的像素差应该是0,所以像素损失被定义为:

[0074][0075]

i

t

(p)和m

′

s

(p)分别是目标图片和投影重构图片上任意对应的像素点的值。

[0076]

又因为动态的可变性环境和由液体导致的反光使一些像素违反了相机模型,忽略这些像素是有利的。故我们使用了“姿态网络”输出的信任度蒙版矩阵。在不同的尺度下,对应的蒙版矩阵都与对应尺度的源图像有相同的像素尺寸。信任度蒙版矩阵中的每一个元素对应投影重构图像m

′

s

(p)中每一个像素,如果信任度蒙版矩阵中的一个元素为1,则投影重构图像中对应的像素可以被信任,否则对应的像素就不可被信任。所以像素损失被重新定

义为:

[0077][0078]

第五步,计算信任度蒙版矩阵的交叉熵损失,称为蒙版损失。

[0079]

如果直接去最小化上一步中的损失,信任度蒙版矩阵m

s,l

一定会全变成0,因为这样可以使得l

pixel

最小至0。但是,这是没有意义的一个解,故对m

s,l

做交叉熵损失最小化,记为l

mask

(m

s

)。

[0080]

第六步,根据shapefromshading算法,从目标图片直接估计像素相对深度,称为sfs深度矩阵。接下来计算sfs深度矩阵与网络输出的像素深度预测矩阵之间的差值,称为深度损失。

[0081]

图5中(a)展示了胶囊在猪肠中运动过程中拍摄的一张图片,图5中(b)展示这张图片输入“深度网络”后估计的像素深度预测矩阵。观察可以得到,左上角没有纹理的猪肠壁表面是接近相机镜头的,且运动变化较小,但是深度预测结果却把这部分错误地估计成了较远的像素。换句话说,由于只有远处的景才有可能一段时间内变化不大,所以算法错误地将近处短时间不动的纹理较少的部分估计成了远处的景。

[0082]

针对此问题,我们使用了shape from shading(sfs)理论。sfs算法是用来从一张灰度图片中估计出景的相对深度。根据sfs算法,lambertian表面的反射方程为:

[0083][0084]

e

(x,y)

是在(x,y)像素处的灰度值。(p

s

,q

s

,1)是目标表面上方光源的位置。p和q分别是深度z在x和y方向的偏导数。以上方程可以重写为:

[0085][0086]

对于一个固定点(x,y)和一个给定的图片e,在一阶泰勒展开后,以上方程可以写为:

[0087][0088]

深度矩阵的所有值都初始化为0,随着迭代计算的进行,f的值会趋向于0,这是深度z收敛。因此,给定目标图片i

t

,基于sfs算法的深度矩阵可以被计算,记为d

sfs

(i

t

)。在归一化之后,sfs深度矩阵中的每一个元d

sfs

(p)与网络输出的像素深度预测矩阵中每个对应元d

t

(p)的差值应该为0。所以深度损失被定义为如下所示:

[0089][0090]

第七步,计算像素深度预测矩阵的平滑度,即计算该矩阵的每个元素的导数的绝对值的和,称为平滑度损失。

[0091]

平滑度损失定义为:

[0092][0093]

第八步,将以上四种损失相加,构成损失函数。优化该损失函数,更新网络参数,直到损失值收敛。

[0094]

总损失被定义为:

[0095][0096]

这里λ

m

,λ

d

,λ

s

分别表示信任度损失,深度损失和平滑度损失的权重。

[0097]

测试过程

[0098]

第一,向已经训练完毕的视觉里程计网络中输入无线胶囊内窥镜图片序列。

[0099]

第二,将连续的三张图片输入已经训练完毕的子网络“姿态网络”中,该网络将输出目标图片转换到两个源图片的位姿变换矩阵。

[0100]

第三,根据新计算出的两个位姿变换矩阵和之前从上一个生物解剖界标为起点累计的历史位姿变换矩阵,可以计算出胶囊目前相对于上一个生物解剖界标的位姿。

[0101]

本发明的背景部分可以包含关于本发明的问题或环境的背景信息,而不一定是描述现有技术。因此,在背景技术部分中包含的内容并不是申请人对现有技术的承认。

[0102]

以上内容是结合具体/优选的实施方式对本发明所作的进一步详细说明,不能认定本发明的具体实施只局限于这些说明。对于本发明所属技术领域的普通技术人员来说,在不脱离本发明构思的前提下,其还可以对这些已描述的实施方式做出若干替代或变型,而这些替代或变型方式都应当视为属于本发明的保护范围。在本说明书的描述中,参考术语“一种实施例”、“一些实施例”、“优选实施例”、“示例”、“具体示例”、或“一些示例”等的描述意指结合该实施例或示例描述的具体特征、结构、材料或者特点包含于本发明的至少一个实施例或示例中。在本说明书中,对上述术语的示意性表述不必须针对的是相同的实施例或示例。而且,描述的具体特征、结构、材料或者特点可以在任一个或多个实施例或示例中以合适的方式结合。在不相互矛盾的情况下,本领域的技术人员可以将本说明书中描述的不同实施例或示例以及不同实施例或示例的特征进行结合和组合。尽管已经详细描述了本发明的实施例及其优点,但应当理解,在不脱离专利申请的保护范围的情况下,可以在本文中进行各种改变、替换和变更。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。