技术特征:

1.服务机器人具有自主学习暂态运动时间的稳定控制方法,其特征在于包括以下步骤:1)利用坐垫机器人的运动学方程并加入质心偏移干扰量,通过坐标变换得到位姿误差方程,建立坐垫机器人的轨迹跟踪误差系统;2)指定暂态运动时间,使运动位姿和运动速度在指定时间同时实现稳定跟踪。系统的运动学方程描述如下其中d表示机器人的质心与几何中心的距离;θ表示机器人运动速度与x轴之间的夹角;p=(x y θ)

t

表示实际位姿,q=(v ω)

t

表示实际速度;设p

r

=(x

r y

r θ

r

)

t

表示参考位姿,q

r

=(v ω)

t

表示参考速度,p

e

=(x

e y

e θ

e

)

t

表示位姿误差;根据坐标变换,坐垫机器人位姿误差方程为:对方程(2)求导,并把(1)代入,得到坐垫机器人轨迹跟踪误差系统:对方程(2)求导,并把(1)代入,得到坐垫机器人轨迹跟踪误差系统:对方程(2)求导,并把(1)代入,得到坐垫机器人轨迹跟踪误差系统:2.根据权利要求1所述服务机器人具有自主学习暂态运动时间的稳定控制方法,其特征在于根据轨迹跟踪误差系统,设计速度和角速度控制器分别为征在于根据轨迹跟踪误差系统,设计速度和角速度控制器分别为其中速度控制器中的变量χ1=v

r cosθ

e

‑

dω

r sinθ

e

,且α2≥1,α3≥1为控制器调节参数;t

f

表示指定暂态运动时间;t0表示初始时刻;

将角速度控制器代入式(5)可得:设计lyapunov函数:v1(θ

e

)=θ

e2 (9)则有对式(9)求导得:令有对式(12)积分,得:其中α1≥1,常数由式(13)可知,当t=t

f

时,由可得,由此可得,v2=0,因此在指定暂态时间t

f

,角度跟踪误差θ

e

达到零;接下来,将xe视为式(4)的输入,设计x

e

使y

e

在指定暂态时间稳定;令设计lyapunov函数:v2(y

e

)=y

e2

(15)则有将式(14)代入式(4)得:

对式(15)求导得:令有对式(19)积分,得:其中由式(20)可知,当t=t

f

时,η≤0,由可得,η=0;由此可得,v2=0,因此在指定暂态时间t

f

,y轴跟踪误差y

e

达到零;进一步,令v=v1‑

v2,其中v1=y

e

ω v

r

cosθ

e

‑

dω

r

sinθ

e

,代入式(3)得:设变量代入式(3)

‑

(4)得到误差系统如下:(4)得到误差系统如下:记由式(6)和v1得:设计lyapunov函数:v3(x

e

,y

e

)=v2(y

e

) z2ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(26)由式(26)得:v3≥z2,对式(26)求导得:并将式(25)代入得:

取β=α2 α3,得:对式(29)积分,得:ζ≤ln(c3(t

f

‑

t)

β

1)(30)其中由式(30)可知,当t=t

f

时,ζ≤0,由式知,ζ=0;由此可得,v3=0,因此在指定暂态时间t

f

,x轴跟踪误差x

e

达到零;进一步,当t≥t

f

时,由式(7)、式(5)可知,ω=ω

r

,再由式(14)可知,x

e

=0,进而再通过式(4)可知,即t≥t

f

时,控制器(6)(7)使跟踪误差系统趋于渐近稳定;因此,由上述可知,坐垫机器人在运动过程中可实现稳定跟踪控制。3.根据权利要求1所述服务机器人具有自主学习暂态运动时间的稳定控制方法,其特征在于描述坐垫机器人暂态运动时间的学习状态state1,state2,state3,state4如下:state1:|v|>v

max

and|ω|>ω

max

,t0≤t<t

f

state2:|v|>v

max

and|ω|≤ω

max

,t0≤t<t

f

state3:|v|≤v

max

and|ω|>ω

max

,t0≤t<t

f

state4:|v|≤v

max

and|ω|≤ω

max

,t0≤t<t

f

其中,v

max

表示坐垫机器人允许的最大安全速度,ω

max

表示坐垫机器人允许的最大安全角速度;暂态运动时间的学习动作a1,a2描述如下:a1:t

f

=t0 δta2:t

f

=t0‑

δt其中δt表示每次自主学习暂态运动时间的调整变化量;设计坐垫机器人自主学习暂态运动时间的奖赏值函数r为:坐垫机器人自主学习暂态运动时间的步骤如下:1)对坐垫机器人(s,a)进行初始化,其中s为坐垫机器人当前学习状态,a为机器人当前采取的动作;设置机器人更新状态学习速率α,衰减系数γ,学习动作的选择概率ε,其中α∈[0,1],γ∈[0,1],ε∈[0,1];2)获取坐垫机器人运动位姿误差,并判断机器人在state1,state2,state3,state4中所处的状态,将其记为s,坐垫机器人以概率ε选取a1,a2中的任意一个动作,并记为a,确定当前

时刻的状态行为对(s,a);进一步,根据r获得奖惩值,使坐垫机器人进入下一个状态,记为s',再利用概率ε选择新的动作a',获得新的行为对(s',a'),利用(s',a')并根据当前时刻r的奖惩值对(s,a)的价值进行更新,更新过程为:q(s,a)

←

q(s,a) α[r γq(s',a')

‑

q(s,a)]

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(31)其中,q(s,a)为当前状态行为对(s,a)获得的价值;q(s',a')为下一时刻状态行为对(s',a')的价值;这样根据式(31)的价值,可以完成一次暂态运动时间的自主学习;将(s',a')作为当前新的学习状态和学习动作,重复步骤2),机器人不断进行暂态运动时间自主学习,直到完成学习次数,使指定暂态运动时间达到最优。

技术总结

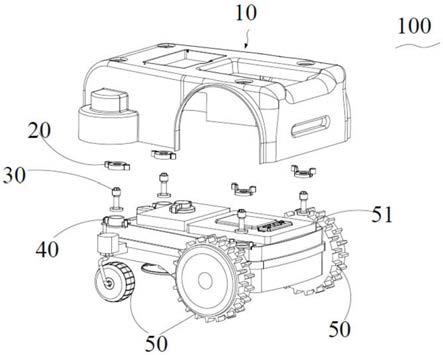

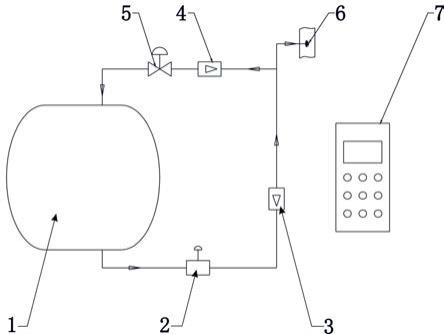

本发明公开了一种服务机器人具有自主学习暂态运动时间的稳定控制方法。其特征为:利用坐垫机器人的运动学方程并加入质心偏移干扰量,通过坐标变换得到位姿误差方程,建立坐垫机器人的轨迹跟踪误差系统;提出了一种指定暂态运动时间的稳定控制方法,使运动位姿和运动速度在指定时间同时实现稳定跟踪;进一步,提出了暂态运动时间的自主学习方法,有效优化了机器人的暂态运动时间,提高了系统的暂态运动性能和跟踪精度;基于STM32G4系列单片机将输出PWM信号提供给电机驱动模块,使机器人可帮助使用者跟踪指定的运动轨迹。帮助使用者跟踪指定的运动轨迹。帮助使用者跟踪指定的运动轨迹。

技术研发人员:孙平 郭永吉 李树江 王硕玉 常洪彬 唐非 谢静

受保护的技术使用者:沈阳工业大学

技术研发日:2021.07.05

技术公布日:2021/9/9

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。