一种基于qlearning的单点信号配时方案选择方法

技术领域

1.本发明涉及交通信号控制领域,具体涉及一种基于qlearning的单点信号配时方案选择方法。

背景技术:

2.当前,交叉口信号控制往往采用多时段固定配时方案,通过这种简单设计的多时段配时方案经常会随着交通环境的长期或短期变化无法适应交通的需求,引起不必要的延误甚至是部分时段的拥堵。因此,对时段内的方案进行实时优化非常必要,常见的实时优化方法未根据反馈进行学习,而且计算过程复杂,或变化过于灵活不安全,不利于实施和流程化操作,不能完全满足动态交通信号配时的需要。

3.现有技术下已有相关的专利情况,例如:

4.专利《基于交叉口过车记录的单点信号控制优化方法》(专利申请号:201610971018.5),根据车道通过流量及排队情况分析绿灯利用指数,存在绿灯时间剩余,则缩短绿灯时间。但该方法只适用于路口交通流量较小的情况,当出现突发大流量时则不能生成合适的信号控制方案。

5.专利《一种减少机动车尾气排放的交叉口信号配时优化方法》(专利申请号:201510628335.2),根据交通流理论与运筹学构建了最小化机动车排放量的信号配时优化模型,但此方案需要对排放因子进行标定及采用二次规划对模型求解。该方法实施及计算过程复杂,不利于实际应用。

技术实现要素:

6.根据背景技术提出的问题,本发明提供一种基于qlearning的单点信号配时方案选择方法来解决,该方法通过对时段内交通环境状态的判别,区分常规与异常状态,选择并执行相应状态下的配时方案动作行为,作用于当前交通环境,分析交叉口状态,并依据状态给出相应的奖励或惩罚反馈,该奖励或惩罚用于强化环境状态与最佳方案选择之间的映射关系。反复执行这个映射过程,学习模型即可获得时段内常规与异常环境状态下选择最佳方案的能力。接下来对本发明做进一步地阐述。

7.s1,状态空间定义;

8.为了能够描述常规状态与异常状态,将状态空间定义为s=(c,f),其中,c代表状态集,f代表状态开关。

9.为了使本发明能够快速收敛并能够迅速响应交通环境的变化,对状态集进行了简化设计。选取某一时段内运行的固定配时方案为基准方案,并向它的上下两个方向各拓展l

‑

1套方案,l的取值根据实际应用情况选择。状态集c共设置2l

‑

1套方案,c=(p1,p2,

…

pl,

…

,p(2l

‑

1)),其中,pl为原始基准方案,p1为向下拓展方案1,p(pl

‑

1)为向下拓展方案pl

‑

1,p(2l

‑

1)为向上拓展方案2l

‑

1。

10.为了区分交通状态的异常与否,设置了一个针对常规与异常状态的开关量f:

11.式中,y为交叉口的关键流量比。假设交叉口为j相位,式中,y为交叉口的关键流量比。假设交叉口为j相位,q

i

为相位i的关键车流的流量,s

i

为车道的饱和流量。y

now

为当前关键流量比,y

last

为数据分析得到的该时段公允关键流量比,与y

last

同比增大超过e可判定为异常状态,e可根据实际交叉口情况进行设置。

12.s2,动作空间定义;

13.在单点信号配时优化中,一个完整的动作空间包括交叉口在一个时间步内所有可能的动作,也就是所有可能的信号配时方案。考虑到动作空间太大会影响到算法的收敛速度,将动作简化为w套方案的选择。动作空间定义为:a=(a1,a2,

…

am,

…

,aw),其中,am为动作空间中的第m套信号配时方案。各方案中,周期是不一样的;各方案中的相位时长可根据各相位关键车流的流量比进行分配调节。

14.为简化算法,将异常状态下和常规状态下的动作空间设置成一样,动作空间需要同时覆盖到常规及异常状态下的配时方案空间;在实际应用中可以根据常规状态和异常状态分别设置动作空间,两者的动作空间可以设置成不一样。

15.s3,回报函数;

16.回报函数可选取延误时间、停车次数、排队长度等指标值计算得到,指标值可通过仿真软件直接获得,本发明选取交叉口车平均延误作为评价指标。

17.首先通过聚类算法分析得到交叉口该时段内不同类别延误变化范围的上限值d,如图3所示,纵坐标为聚类结果类别值,横坐标为车均延误值,单位为s;类别为0上的

“★”

代表正常延误类别的聚类中心点,“x”代表是80%分位上的正常延误值上限;纵坐标为1上的

“★”

代表异常延误类别的聚类中心点,“x”代表是80%分位上的异常延误值上限。

18.奖惩函数为:

19.式中:d

t0

为动作执行前的延误,d

tk

为动作执行后的延误。

20.为防止因交通自身的波动性导致延误突变及奖惩函数产生振荡,设置连续相同动作标志b,若连续两次相同的动作,则b=2;若连续三次相同的动作,则b=3;依此类推,每增加一次连续相同动作,b值加1;连续动作被中断,则b=1。

21.针对不同的b、r

t

(s,a)、dif调整反馈r

t

(s,a),规则如下:dif=d

tk

‑

d

t0

22.当b=2且r

t

(s,a)=

‑

1时,说明被选中的方案已经是连续第二次被选中,且本发明动作选择策略采取贪婪算法可知被选中的方案曾经是一套相对优秀的方案,或许由于交通的波动性,导致延误升高。当延误升高幅度不大,即dif<k时,可修正r

t

(s,a)=0;当延误升高幅度较大,即dif≥k时,可保持r

t

(s,a)=

‑

1。k的值可依据经验进行设置。

23.当b>2且r

t

(s,a)=

‑

1时,说明被选中的方案已经是连续三次以上被选中,可知被选中的方案已经是比较优秀的方案,或许由于交通的波动性,或许是交通环境出现了变化,导致延误升高。当延误升高幅度不大,即dif<k时,可保持r

t

(s,a)=

‑

1;当延误升高幅度较大,即dif≥k时,可修正r

t

(s,a)=

‑

b 1,加强环境变化的反馈值。r

t

(s,a)=2,当r

t

(s,a)=1且b=2;

24.当r

t

(s,a)=2,b=2时,重新设置b=1,防止紧接着出现相同动作时,随着b的升高,出现修正r

t

(s,a)=

‑

1,甚至是更小的负值,出现强烈振荡,导致出现不收敛的情况。

25.s4,q值表的更新;

26.q值的更新选取bellman最优方程:q

t 1

(s

t

,a

t

)=(1

‑

α

t

)q

t

(s

t

,a

t

) α

t

(r

t 1

γmaxq

t

(s

t 1

,a

t 1

));

27.本发明中需要建立两张q值表,一张用于记录常规交通,另一张用于记录异常交通,其他参数可以统一设置。α为学习速率,γ为折扣因子,学习速率越大,保留之前训练的效果就越少。折扣因子γ越大,之前训练的效果所起到的作用就越大。α、γ可根据具体交叉口特性进行确定。

28.动作选择策略采取贪婪算法,即ε

‑

greedy探索策略,通过设置自增加的ε值与随机生成数r∈[0,1]比较大小来进行学习动作的选取。选取规则:当r<ε时,选取当前状态下q值最大的动作;当r>=ε时,在当前状态下随机选取一个动作执行。ε∈[ε1,ε2],ε自增加规则:当迭代次数n<=n1时,ε=ε1 (ε2‑

ε1)/n1*n;当n>n1时,ε=ε2。

[0029]

依据qlearning的规则,q值表为(2l

‑

1)

×

w的矩阵,根据bellman方程,在迭代中更新各状态下不同行为的q值。其目的是让各状态下最优行为的q值取得最大值,那样最优行为的选择概率也越来越大,而非最优行为的概率则越来越小,在q值矩阵最终收敛之后,确保在每个状态下都能大概率的选择最优行为。

[0030]

有益效果:与现有技术相比,1)以交叉口时段内原始固定配时方案为基准,向它的上下两个安全搜索区域进行方案的探索和选择,实现控制的稳定性;2)同时对时段内相对长久缓慢或异常的的变化做出及时的响应,体现控制的灵活性。兼顾信号配时优化的稳定性和灵活性,实现稳定灵活改善路口运行状况的目的。

附图说明

[0031]

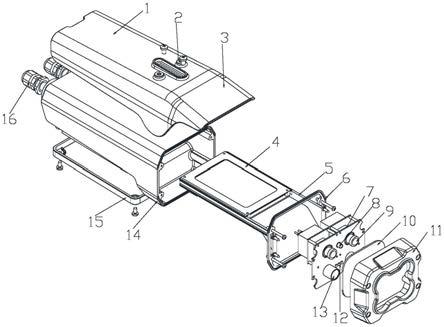

图1:本发明配时方案选择方法的示意图;

[0032]

图2:本发明方案选择原理图;

[0033]

图3:交叉口车均延误聚类结果图;

[0034]

图4:q值表初值图;

[0035]

图5:训练收敛中的q值表;

[0036]

图6:本算法与固定配时延误对比曲线。

具体实施方式

[0037]

接下来结合附图对本发明的一个具体实施例来做详细地阐述。

[0038]

一种基于qlearning的单点信号配时方案选择方法,兼顾信号配时优化的稳定性和灵活性,以交叉口时段内原始固定配时方案为基准,向它的上下两个安全搜索区域进行方案的探索和选择,实现控制的稳定性;同时对时段内相对长久缓慢或异常的的变化做出及时的响应,实现控制的灵活性。通过不断训练,依据最终得到的q值表选择出与当前交通环境状态匹配的信号配时方案。

[0039]

本发明方法包括以下步骤:

[0040]

步骤1,确定状态空间;

[0041]

将状态空间定义为s=(c,f),其中,c代表状态集,f代表状态开关。

[0042]

为便于理解,选取城市主干道上三相位十字交叉口为例,选取交叉口某一时段内运行的固定配时方案为基准方案,并向它的上下两个方向各拓展两套方案,状态集c共设置5套方案,c=(p1,p2,p3,p4,p5),其中,p3为原始基准方案,p1为向下拓展方案1,p2为向下拓展方案2,p4为向上拓展方案4,p5为向上拓展方案5。

[0043]

状态集5套方案的设置展示:p3方案各相位时长分别设置为周期为cycle3;p1为拓展方案1,各相位时长分别设置为周期为cycle1;p2为拓展方案2,各相位时长分别设置为周期为cycle2;p4为拓展方案4,各相位时长分别设置为周期为cycle4;p5为拓展方案5,各相位时长分别设置为周期为cycle5。

[0044]

为了区分交通状态的异常与否,本实施例设置了一个针对常规与异常状态的开关量f。

[0045]

式中,y为交叉口的关键流量比,以三相位交叉口为例,y=(q1 q2 q3)/s,q1、q2、q3分别为相位1、相位2、相位3中关键车流的流量,s为车道的饱和流量,这里假设各车道的饱和流量为相同值。y

now

为当前关键流量比,y

last

为数据分析得到的该时段公允关键流量比,与y

last

同比增大超过e可判定为异常状态,e可根据实际交叉口情况进行设置。

[0046]

步骤2,确定动作空间;

[0047]

考虑到动作空间太大会影响到算法的收敛速度,将动作简化为5套方案的选择。动作空间定义为:a=(p1,p2,p3,p4,p5),其中p1,p2,p3,p4,p5与状态空间中的p1,p2,p3,p4,p5完全相同。将异常状态下和常规状态下的动作空间设置成一样,动作空间需要同时覆盖到常规及异常状态下的配时方案空间。

[0048]

步骤3,确定回报函数;

[0049]

选取交叉口车平均延误作为评价指标;

[0050]

首先通过聚类算法分析得到交叉口该时段内不同类别延误变化范围的上限值d,如图3所示,采用正常延误上限d=44s,异常延误上限d=66s;

[0051]

奖惩函数为:

[0052]

式中:d

t0

为动作执行前的延误,d

tk

为动作执行后的延误。

[0053]

为防止因交通自身的波动性导致延误突变及奖惩函数产生振荡,设置连续相同动作标志b:若连续两次相同的动作,则b=2;若连续三次相同的动作,则b=3;依此类推,每增加一次连续相同动作,b值加1;连续动作被中断,则b=1;

[0054]

针对不同的b、r

t

(s,a)、dif调整反馈r

t

(s,a),规则如下(这里将k设置为10):dif=d

tk

‑

d

t0

[0055]

当b=2且r

t

(s,a)=

‑

1时,说明被选中的方案已经是连续第二次被选中,且本算法动作选择策略采取贪婪算法可知被选中的方案曾经是一套相对优秀的方案,或许由于交通的波动性,导致延误升高:当延误升高幅度不大,即dif<10时,可修正r

t

(s,a)=0;当延误升高幅度较大,即dif≥10时,可保持r

t

(s,a)=

‑

1。

[0056][0057]

当b>2且r

t

(s,a)=

‑

1时,说明被选中的方案已经是连续三次以上被选中,可知被选中的方案已经是比较优秀的方案,或许由于交通的波动性,或许是交通环境出现了变化,导致延误升高:当延误升高幅度不大,即dif<10时,可保持r

t

(s,a)=

‑

1;当延误升高幅度较大,即dif≥10时,可修正r

t

(s,a)=

‑

b 1,加强环境变化的反馈值。

[0058]

r

t

(s,a)=2,当r

t

(s,a)=1且b=2;

[0059]

当r

t

(s,a)=2,b=2时,重新设置b=1,防止紧接着出现相同动作时,随着b的升高,出现修正r

t

(s,a)=

‑

1,甚至是更小的负值,出现强烈振荡,导致出现不收敛的情况。

[0060]

步骤4,确定q值表的更新;

[0061]

q值的更新选取bellman最优方程:q

t 1

(s

t

,a

t

)=(1

‑

α

t

)q

t

(s

t

,a

t

) α

t

(r

t 1

γmaxq

t

(s

t 1

,a

t 1

));

[0062]

n1取值500,ε∈[0.7,0.9],ε自增加规则:当迭代次数n<=500时,ε=0.7 0.2/500*n;当n>500时,ε=0.9。

[0063]

q值表为5

×

5的矩阵,如图4所示,行标s1、s2、s3、s4、s5代表5种状态(为了便于理解,这里采用传统强化学习中状态表示字母s,文中对应的采用的状态为p1、p2、p3、p4、p5),列表a1、a2、a3、a4、a5代表5种动作(为了便于理解,这里采用传统强化学习中动作表示字母a,文中对应的采用的动作为p1、p2、p3、p4、p5)。

[0064]

下面结合实施例对本发明的单点方案选择方法进一步说明:

[0065]

实施例1:以某省某市的某交叉口为例。

[0066]

状态集5套方案的设置展示:p3方案各相位时长分别设置为54s、34s、44s,周期为132s;p1为拓展方案1,各相位时长分别设置为30s、24s、32s,周期为86s;p2为拓展方案2,各相位时长分别设置为43s、29s、40s,周期为112s;p4为拓展方案4,各相位时长分别设置为56s、35s、46s,周期为137s;p5为拓展方案5,各相位时长分别设置为59s、36s、47s,周期为

142s。

[0067]

时段内流量统计结果及车道数如下表所示:进口东进口南进口西进口北进口流量300800300400车道数2424

[0068]

单点交叉口的算法程序q值数表初始值设置如图4所示,通过运行本算法代码对q值表进行更新,学习结果同样是5

×

5的矩阵,如图5所示。

[0069]

本算法的交叉口方案在迭代中依据学习规则进行不断切换,通过设置不同学习次数n的值,可以获取不同收敛情况的q值表。n取值越大,q值表格收敛情况越好,但相应耗时也会增加。实验中选取n值为540,每迭代30次统计一次总平均延误d

i

,迭代540次,共会统计18(540/30=18)次总平均延误进行对比。

[0070]

式中,m为迭代次数(m∈[1,540]),i为统计次数标记(i∈[1,18]),为每次迭代的车均延误,d

i

为第i个30次迭代车均延误的和。

[0071]

图6为本发明与固定配时延误对比曲线图,横坐标为迭代次数标记i,纵坐标为总车均延误d_i,如附图所示,

[0072]

由附图结果可以看出,本发明相比于其他方法的优势在于,无论是常规q值表还是异常q值表都能在收敛后,依据本发明制定的回报函数及选择策略,迅速响应交通环境出现的长期缓慢变化。因为收敛后最优行为将会被大概率的连续选中,若最优行为此时已经与交通环境不再匹配,将会因为被连续选中,而受到不断加重的惩罚,迅速减小被选中的概率,直到达到新的收敛状态。

[0073]

本发明能够兼顾信号配时优化的稳定性和灵活性,以交叉口时段内原始固定配时方案为基准,向它的上下两个安全搜索区域进行方案的探索和选择,实现控制的稳定性;同时对时段内相对长久缓慢或异常的的变化做出及时的响应,体现控制的灵活性。从而,最终达到稳定灵活改善路口运行状况的目的。

[0074]

以上所述仅为本发明的优选实施例而已,并不用于限制本发明,对于本领域的技术人员来说,本发明可以有各种更改和变化。凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。