1.本发明涉及工业生产控制领域,具体的,涉及一种对非线性离散 时间系统的在线学习控制方法。

背景技术:

2.在工业生产的过程中,工程技术人员往往需要对机器人、无人机、 无人车等控制对象的控制器进行优化设计,以满足一定的控制指标要 去。由于上述控制对象往往表现出很强的非线性,使得控制器的优化 面临很大困难。从最优控制的角度来看,获得最优控制控制器需要求 解复杂的哈密顿

‑

雅可比

‑

贝尔曼方程(hjb方程),但hjb方程为非 线性的偏微分方程,非常难求解。传统的动态规划、变分法、谱方法 等由于具有极高的计算复杂度,在实际应用过程中往往面临很大的局 限性。

3.自适应动态规划作为近年来兴起的一种新型的智能控制算法,通 过将强化学习、神经网络近似、动态规划以及自适应控制等技术进行 融合,可实现对最优控制器的在线学习,有效克服了传统方法计算复 杂度高的问题。针对非线性离散时间系统的最优控制问题,jennie si 和yu

‑

tsung wang在论文“online learning control by associationand reinforcement”中首次提出了直接启发式动态规划算法,该算 法采用广义策略迭代的基本思想,通过引入两个神经网络(即执行网 络和评价网络),可实现对最优控制器和最优值函数的实时在线学习。 经过近些年的不断发展,算法的收敛性和稳定性分析目前也具有一定 的理论基础。虽然直接启发式动态规划算法可实现在线自适应最优控 制,该算法仍存在以下不足:1)该算法采用了在轨策略(on

‑

policy) 学习机制,存在对状态

‑

策略空间探索不足的问题,容易陷入局部最 优解;2)执行网络和评价网络的激活函数均采用的双曲正切函数, 并且目前所有的收敛性和稳定性分析结果均以双曲正切函数为基础, 对于其他类型的激活函数则不再适用。

4.因此,如何克服上述的直接启发式动态规划方法存在的以上不足, 使得收敛性和稳定性分析结果不再局限双曲正切函数,成为现有技术 亟需解决的技术问题。

技术实现要素:

5.本发明的目的在于提出一种非线性离散时间系统的在线学习控 制方法,能够对状态

‑

策略空间具有更好的探索能力,使得执行网络 和评价网络的激活函数类型可任意选择,不再局限于双曲正切函数; 相比于策略迭代或值迭代等迭代式方法,该方法可实现对最优控制器 的在线学习,并且无需系统模型,仅需要行为策略产生的状态数据。

6.为达此目的,本发明采用以下技术方案:

7.一种非线性离散时间系统的在线学习控制方法,包括如下步骤:

8.行为策略选择步骤s110:

9.根据被控对象的特点,利用已有经验选择行为策略u,行为策略 为学习过程中实际应用到被控对象的控制策略,其主要作用是用来产 生学习过程中需要用到的系统状态

数据;

10.最优q

‑

函数定义步骤s120:

11.定义如下的最优q

‑

函数:

[0012][0013]

其物理意义为:在k时刻,采取行为策略u,而在之后的所有时 刻,均采取最优控制策略u

*

,即目标策略,由最优q

‑

函数定义可知, 上式可等价表示为:

[0014][0015]

最优控制可表示为:

[0016]

对于线性系统,q

*

(x

k

,u

k

)和分别是关于(x

k

,u

k

)和x

k

的非线性函数;

[0017]

评价网络和执行网络引入步骤s130:

[0018]

引入评价网络和执行网络分别对q

*

(x

k

,u

k

)和进行在线逼近,所 述评价网络和执行网络为神经网络;

[0019]

评价网络用来学习最优q

‑

函数q

*

(x

k

,u

k

),执行网络用来学习最优 控制器u

*

,假设评价网络中神经网络激活函数的数量为n

c

,并记为最小二乘意义下评价网络对q

*

(x

k

,u

k

)的最佳逼近,则可表示为:

[0020][0021]

其中,w

c

为隐藏层到输出层的权重,φ

c

(

·

)为评价网络中隐藏层中 所有激活函数构成的集合,为评价网络输 入层到隐藏层的权重,其中,为第i个激活函数对应的权重,表示(x

k

,u

k

)对应的各激活函数的输入值,表示第i个激活函数的输入值;

[0022]

设执行网络激活函数的数量为n

a

,并记为最小二乘意义下执行 网络对的最佳逼近,则可表示为:

[0023][0024]

执行网络的输入为系统状态,其中,w

a

为隐藏层到输入层的权重, φ

a

(

·

)为执行网络隐藏层激活函数构成的集合, 为输入层到隐藏层的权重,其中,为第 i个激活函数对应的权重,代表x

k

对应 的各激活函数的输入值,表示第i个激活函数的输入值, 对于x

k 1

,则有

[0025]

估计误差计算步骤s140:

[0026]

最优近似值和代替精确值q

*

(x

k

,u

k

)和可得如下的 估计误差:

[0027][0028]

其中,表示输入为时,评价网络中各激活函数 的输入值,即

[0029]

最优权重计算步骤s150:

[0030]

对评价网络的最优权重w

c

和执行网络的最优权重w

a

进行在线学 习,假设在k时刻,评价网络和执行网络对w

c

和w

a

的估计值分别为 和其中,l≤k,即学习过程要在行为策略开始产生状态数 据之后进行,则执行网络在k时刻的输出可表示为:

[0031][0032]

在行为策略u

k

生成下一个状态x

k 1

之前,执行网络还无法给出k 1 时刻对w

a

的估计,因此,k 1时刻执行网络对w

a

的估计值仍采用则k 1时刻执行网络的输出为:

[0033][0034]

同理,当输入为(x

k

,u

k

)时,评价网络的输出为:

[0035][0036]

当输入为时,评价网络的输出为:

[0037][0038]

其中,同样,在生成状态x

k 1

之前,评价网络 也无法给出k 1时刻对w

c

的估计,所以k 1时刻评价网络对w

c

的估计 值同样取因此有:

[0039][0040]

用估计值代替真实值得到如下的估计误差:

[0041][0042]

对于评价网络的权重采用梯度下降法进行调节,

[0043]

对于执行网络的权重则采用重要性加权法进行训练,并采 用改进的梯度下降法对进行在线调节,

[0044]

当评价网络的权重和执行网络的权重收敛之后,执行 网络的输出即为最优控制器的近似值。

[0045]

可选的,在评价网络和执行网络引入步骤s130中,

[0046]

对于评价网络,将w

c0

设为常值,只需调节隐藏层到输出层的权 重;

[0047]

对于执行网络,将w

a0

设为常值,仅调节隐藏层到输出层的权重。

[0048]

可选的,在最优权重计算步骤s150中:

[0049]

对于评价网络的权重,采用如下的梯度下降法进行调节具体为:

[0050][0051]

其中,α>0评价网络的学习率,δφ

c

(k)=φ

c

(θ2(k 1))

‑

φ

c

(θ1(k))为回 归向量,φ

c

(k)=(1 δφ

c

(k)

t

δφ

c

(k))2为归一化项;

[0052]

对于执行网络的权重,则采用重要性加权法进行训练,并采用改 进的梯度下降法对进行在线调节具体为:

[0053]

可选的,行为策略选择步骤s110中,所述行为策略为:u

k

=u

′

k

n

k

, 其中u

′

为任意的一个可行控制策略,根据被控系统的特征和经验选择, n

k

为探索噪声,n

k

是包含较多,例如足够多频率的正弦、余弦信号或 者幅值有限的随机信号。

[0054]

可选的,所述评价网络和所述执行网络为单隐藏层的前馈神经网 络,用于近似q

‑

函数的评价网络的输入为状态和控制输入,执行网 络的输入为系统状态,输出为多m维向量。

[0055]

可选的,所述评价网络和所述执行网络只调节隐藏层到输出层的 权重,输入层到隐藏层的权重在学习过程开始之前随机生成,在学习 的过程中保持不变。

[0056]

可选的,所述评价网络和所述执行网络的激活函数为双曲正切函 数、sigmoid函数、线性整流器、多项式函数中的一个。

[0057]

本发明进一步公开了一种存储介质,用于存储计算机可执行指令, 其特征在于:

[0058]

所述计算机可执行指令在被处理器执行时执行所述的非线性离 散时间系统的在线学习控制方法。

[0059]

本发明具有如下的优点:

[0060]

1、本发明提出了适用于一般非线性离散时间系统的在线学习控 制方法,该方法无需在策略评估和策略提高之间反复迭代,可实现对 最优控制器的实时在线学习;

[0061]

2、本发明采用离轨策略学习机制,有效克服了直接启发式动态 规划方法对状态

‑

策略空间探索不足的问题;另外,执行网络和评价 网络可使用任意形式的激活函数。

[0062]

3、与经典的直接启发式动态规划方法相比,此项专利提出的在 线学习方法对状态

‑

策略空间具有更好的探索能力,并且执行网络和 评价网络的激活函数类型可任意选择,不再局限于双曲正切函数;相 比于策略迭代或值迭代等迭代式方法,该方法可实现对最优控制器的 在线学习,并且无需系统模型,仅需要行为策略产生的状态数据。

附图说明

[0063]

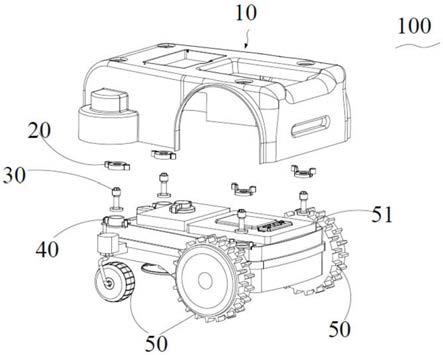

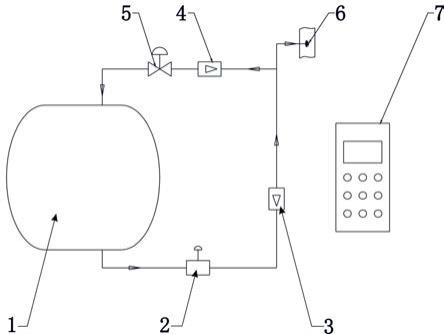

图1是根据本发明具体实施例的非线性离散时间系统的在线学 习控制方法的流程图;

[0064]

图2是根据本发明具体实施例的非线性离散时间系统的在线学 习控制方法的评价网络的示意图;

[0065]

图3是根据本发明具体实施例的非线性离散时间系统的在线学 习控制方法的执行网络的示意图;

[0066]

图4是根据本发明具体实施例的非线性离散时间系统的在线学 习控制方法的算法示意图。

具体实施方式

[0067]

下面结合附图和实施例对本发明作进一步的详细说明。可以理解 的是,此处所描述的具体实施例仅仅用于解释本发明,而非对本发明 的限定。另外还需要说明的是,为了便于描述,附图中仅示出了与本 发明相关的部分而非全部结构。

[0068]

本发明首先需要考虑如下的非线性离散时间系统最优控制问题。 考虑如下的离散时间系统:

[0069]

x

k 1

=f(x

k

,u

k

),x0=x(0)

[0070]

其中,x

k

为系统状态,u

k

为系统输入。系统函数f(x

k

,u

k

)在紧集上是lipschitz连续的,并且满足f(0,0)=0。假设系统在ω上 是可镇定的,即存在一个控制序列u1,

…

,u

k

,

…

,使得x

k

→

0。另外,假 设系统函数f(x

k

,u

k

)是未知的。非线性系统的最优控制的目标是找到 一个可行控制策略,使得系统镇定,并同时最小化如下的值函数:

[0071][0072]

根据贝尔曼最优性原理,最优控制策略u

*

应满足如下的贝尔曼方 程:

[0073][0074]

s.t.x

k 1

=f(x

k

,u

k

)

[0075]

因此,最优控制器u

*

有如下表达:

[0076][0077]

将上式带入贝尔曼方程便得到如下的hjb方程:

[0078][0079]

因此,参见图1,示出了根据本发明的非线性离散时间系统的在 线学习控制方法,包括如下步骤:

[0080]

行为策略选择步骤s110:

[0081]

根据被控对象的特点,利用已有经验选择行为策略u,行为策略 为学习过程中实际应用到被控对象的控制策略,其主要作用是用来产 生学习过程中需要用到的系统状态数据。

[0082]

在选择了行为策略以后,即将对最优控制器进行在线学习。

[0083]

最优q

‑

函数定义步骤s120:

[0084]

定义如下的最优q

‑

函数:

[0085]

[0086]

其物理意义为:在k时刻,采取行为策略u,而在之后的所有时 刻,均采取最优控制策略u

*

,即目标策略,由最优q

‑

函数定义可知, 上式可等价表示为:

[0087][0088]

最优控制可表示为:

[0089]

对于线性系统,q

*

(x

k

,u

k

)和分别是关于(x

k

,u

k

)和x

k

的非线性函数。

[0090]

评价网络和执行网络引入步骤s130:

[0091]

考虑到当前馈神经网络中激活函数的数量足够多时,前馈神经网 络可对光滑或者连续的非线性函数实现任意精度的逼近,故引入评价 网络和执行网络分别对q

*

(x

k

,u

k

)和进行在线逼近,所述评价网络和 执行网络为神经网络;

[0092]

评价网络用来学习最优q

‑

函数q

*

(x

k

,u

k

),执行网络则用来学习最 优控制器u

*

,假设评价网络中神经网络激活函数的数量为n

c

,并记为最小二乘意义下评价网络对q

*

(x

k

,u

k

)的最佳逼近,则可表示为:

[0093][0094]

其中,w

c

为隐藏层到输出层的权重,φ

c

(

·

)为评价网络中隐藏层中 所有激活函数构成的集合,为评价网络输 入层到隐藏层的权重,其中,为第i个激活函数对应的权重,表示(x

k

,u

k

)对应的各激活函数的输入值,表示第i个激活函数的输入值;

[0095]

本发明将w

c0

设为常值,因此,只需调节隐藏层到输出层的权重。

[0096]

同样地,设执行网络激活函数的数量为n

a

,并记为最小二乘意 义下执行网络对的最佳逼近,则可表示为:

[0097][0098]

执行网络的输入为系统状态,其中,w

a

为隐藏层到输入层的权重, φ

a

(

·

)为执行网络隐藏层激活函数构成的集合, 为输入层到隐藏层的权重,其中,为第 i个激活函数对应的权重,代表x

k

对应 的各激活函数的输入值,表示第i个激活函数的输入值, 对于x

k 1

,则有

[0099]

本发明也将w

a0

设为常值,仅调节隐藏层到输出层的权重。

[0100]

估计误差计算步骤s140:

[0101]

最优近似值和代替精确值q

*

(x

k

,u

k

)和可得如下的 估计误差:

[0102][0103]

其中,表示输入为时,评价网络中各激活函数 的输入值,即

[0104]

最优权重计算步骤s150:

[0105]

对评价网络的最优权重w

c

和执行网络的最优权重w

a

进行在线学 习,假设在k时刻,评价网络和执行网络对w

c

和w

a

的估计值分别为 和其中,l≤k,即学习过程要在行为策略开始产生状态数 据之后进行,则执行网络在k时刻的输出可表示为:

[0106][0107]

在行为策略u

k

生成下一个状态x

k 1

之前,执行网络还无法给出k 1 时刻对w

a

的估计,因此,k 1时刻执行网络对w

a

的估计值仍采用则k 1时刻执行网络的输出为:

[0108][0109]

同理,当输入为(x

k

,u

k

)时,评价网络的输出为:

[0110][0111]

当输入为时,评价网络的输出为:

[0112][0113]

其中,同样,在生成状态x

k 1

之前,评价网络 也无法给出k 1时刻对w

c

的估计,所以k 1时刻评价网络对w

c

的估计 值同样取因此有:

[0114][0115]

用估计值代替真实值可得如下的估计误差:

[0116][0117]

对于评价网络,其目标是通过在线学习使得估计误差e

k

趋于0, 因此,对于评价网络的权重,采用如下的梯度下降法进行调节:

[0118][0119]

其中,α>0评价网络的学习率,为回 归向量,φ

c

(k)=(1 δφ

c

(k)

t

δφ

c

(k))2为归一化项。

[0120]

对于执行网络的权重则采用重要性加权法进行训练。执行 网络的目标函数定义为:其中,执行网络的预测误差 e

a

(k)定义为:u

c

为期望的最终 目标函数,本发明中u

c

=0,即执行网络要在学习的过程中尽可能最 小化同样,采用如下改进的梯度下降法对进行在线调 节:

[0121][0122]

β>0为执行网络的学习率,φ

a

(k)=(1 φ

a

(θ4(k))

t

φ

a

(θ4(k)))2为归一 项。

[0123]

由评价网络和执行网络的训练过程可以看出,学习过程中用到的 所有状态数据均由行为策略u产生,当评价网络的权重和执行网 络的权重收敛之后,执行网络的输出即为最优控制器的近似值。

[0124]

对于行为策略:

[0125]

在一个具体的实施例中,在对最优控制器的在线学习过程中,用 到的所有状态数据均由行为策略u产生,为了确保算法对策略空间具 有一定的探测能力,行为策略产生的状态数据需要足够丰富并满足一 定的持续激励条件,以确保算法的收敛性。本发明中行为策略为: u

k

=u

′

k

n

k

,其中u

′

为任意的一个可行控制策略,通常根据被控系统的 特征和经验选择,n

k

为探索噪声,n

k

可以是包含较多,例如足够多的 频率的正弦、余弦信号或者幅值有限的随机信号。

[0126]

对于评价网络和执行网络:

[0127]

本发明中的评价网络和执行网络均采用具有单隐藏层的前馈神 经网络,其中,用于近似q

‑

函数的评价网络的输入为状态和控制输 入,其输出为标量。执行网络的输入同样为系统状态,其输出为多m 维向量。在学习的过程中,三个神经网络均只调节隐藏层到输出层的 权重,输入层到隐藏层的权重在学习过程开始之前随机生成,在学习 的过程中保持不变。三个神经网络隐藏层的激活函数可以选择为常用 的双曲正切函数、sigmoid函数、线性整流器、多项式函数等。

[0128]

参见图2、图3,分别示出了评价网络和神经网络的示意图。

[0129]

当然本发明的评价网络和执行网络也可以选为具有多个隐藏层 的前馈神经网络,在学习的过程中也可以调节所有连接层的权重。

[0130]

参见图4,示出了本发明的在线学习控制方法的原理示意图。

[0131]

本发明进一步公开了一种存储介质,用于存储计算机可执行指令, 其特征在于:

[0132]

所述计算机可执行指令在被处理器执行时执行上述的非线性离 散时间系统的在线学习控制方法。

[0133]

本发明具有如下的优点:

[0134]

1、本发明提出了适用于一般非线性离散时间系统的在线学习控 制方法,该方法无需在策略评估和策略提高之间反复迭代,可实现对 最优控制器的实时在线学习;

[0135]

2、本发明采用离轨策略学习机制,有效克服了直接启发式动态 规划方法对状态

‑

策略空间探索不足的问题;另外,执行网络和评价 网络可使用任意形式的激活函数。

[0136]

3、与经典的直接启发式动态规划方法相比,此项专利提出的在 线学习方法对状态

‑

策略空间具有更好的探索能力,并且执行网络和 评价网络的激活函数类型可任意选择,不再局限于双曲正切函数;相 比于策略迭代或值迭代等迭代式方法,该方法可实现对最优控制器的 在线学习,并且无需系统模型,仅需要行为策略产生的状态数据。

[0137]

显然,本领域技术人员应该明白,上述的本发明的各单元或各步 骤可以用通用的计算装置来实现,它们可以集中在单个计算装置上, 可选地,他们可以用计算机装置可执行的程序代码来实现,从而可以 将它们存储在存储装置中由计算装置来执行,或者将它们分别制作成 各个集成电路模块,或者将它们中的多个模块或步骤制作成单个集成 电路模块来实现。这样,本发明不限制于任何特定的硬件和软件的结 合。

[0138]

以上内容是结合具体的优选实施方式对本发明所作的进一步详 细说明,不能认定本发明的具体实施方式仅限于此,对于本发明所属 技术领域的普通技术人员来说,在不脱离本发明构思的前提下,还可 以做出若干简单的推演或替换,都应当视为属于本发明由所提交的权 利要求书确定保护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。