1.本发明属于视频摘要技术领域,尤其是针对用户的“随手拍”视频,基于视觉和语义特征协作调制与强化学习的无监督视频摘要方法。

背景技术:

2.视频摘要的目的是通过一段简短的剪辑视频来表示原始的视频内容,该技术能够方便视频的预览、存储、检索和管理。自从youtube、instagram等自媒体平台快速发展以来,普通用户创建并上传了大量的视频数据。然而,传统的基于人工浏览视频,挑选出关键片段的模式需要耗费大量的人力和时间、效率低下,无法高效及时地处理海量视频。自动视频摘要技术能够自动分析原始视频中的内容,并提炼出关键的片段组成时长更短的视频。便于自媒体平台快速的浏览,存储,检索,传播视频信息,对信息的流通具有重要的意义。

3.现有的视频摘要方法(文献1,文献2)主要解决特定类别的视频,如监控视频,关注的是在背景不变,或者有额外辅助信息的条件下度量视频帧的关键程度。然而,“随手拍”视频,场景在短时间内频繁变化,大大增加了视频内容的语义信息复杂度,同时干扰信息也更多。因此,传统的方法并不能很好的解决“随手拍”视频的摘要问题。

4.[1].h.

‑

c.shih:a novel attention

‑

based key

‑

frame determination method.ieee transactions on broadcasting,vol.59,no.3,pp.556

–

562(2013)

[0005]

[2].m.paul and m.m.salehin:spatial and motion saliency prediction method using eye tracker data for video summarization.ieee transactions on circuits and systems for video technology,vol.29,no.6,pp.1856

–

1867(2018)

技术实现要素:

[0006]

针对现有技术存在的不足,本发明提供了一种基于视觉和语义特征协作调制与强化学习的双向lstm模型的无监督视频摘要方法。该方法的主要特点是提出将语义信息和视觉信息融合,并以空域关注度模型(sam)调制双向长短期记忆模型(bi

‑

lstm)的形式来细化当前图像被选为关键帧的概率,称为vsfb模型。最后,根据摘要结果计算选中帧和其他帧之间的差异性和代表性,依据强化学习奖励机制,利用一个索引调整的差异性和代表性奖励来调整初始概率,加强vsfb模型在视频摘要中的学习。

[0007]

本发明提供一种基于视觉和语义特征协作与强化学习的视频摘要方法,包括以下步骤,

[0008]

步骤1,将视频文件分解成帧序列,按照帧的时间顺序依次使用深度神经网络提取语义特征和视觉显著性特征;

[0009]

步骤2,语义特征经过bi

‑

lstm模型处理预测出各视频帧被选择为关键帧的初始概率;根据视觉显著性特征提取出空间注意力得分,归一化后作为bi

‑

lstm模型初始概率的调整因子,利用调整因子对bi

‑

lstm模型产生的初始概率进行调制得到调制概率;

[0010]

步骤3,根据调制概率,确定语义特征与视觉显著性特征均重要的关键帧,实现

vsfb模型;

[0011]

步骤4,将原始视频分为帧数为k的多个独立片段clip,k为预设值;计算选择的关键帧与相应clip中其他帧之间索引调整的差异性奖励和代表性奖励,依据强化学习奖励机制,动态调整初始概率,加强vsfb模型在视频摘要中的学习,最后得到理想模型,采用理想模型实现从任意待处理视频中的摘要提取。

[0012]

而且,所述步骤2中,根据视觉显著性特征提取出空间注意力得分,实现方式如下,

[0013]

1)如果图像的显著域的显著水平大于预设等于的阈值,则该显著域被判定为能够吸引观众的注意力的核心显著域,判定出的核心显著域用来重新定义视觉显著性特征为空域关注度特征;

[0014]

2)计算显著域占比;

[0015]

3)将显著水平大于阈值的核心显著域像素面积占比之和作为视觉重要性得分λ

t

;

[0016]

4)将视觉重要性得分归一化后作为调整因子。

[0017]

而且,所述步骤2中,利用调整因子对bi

‑

lstm模型产生的初始概率进行调制得到调制概率,实现方式如下,

[0018]

视频帧的语义特征经过bi

‑

lstm模型为每一帧预测一个初始概率p

t

,并用调整因子l

t

加以调整,得到调制概率β

t

,

[0019]

β

t

=w

p

·

n(r

t

×

p

t

) w

l

·

n(l

t

)

[0020]

其中,n(

·

)=exp(

·

)/∑exp(

·

),w

p

和w

l

为权重,r

t

为强化学习奖励函数值,用来调整初始概率。

[0021]

而且,步骤4中,关键帧的调整的差异性奖励div

k

计算如下,

[0022][0023]

其中,k

′

代表视频摘要的关键帧,k代表原视频该clip中的其他帧;α

index

(k,k

′

)表示帧之间的差异,α

c

(k,k

′

)表示视觉特征的差异,α

v

(k,k

′

)表示语义特征的差异。

[0024]

而且,步骤4中,视觉特征和语义特征结合的代表性奖励rep

k

计算如下,

[0025][0026]

其中,表示视觉特征和语义特征结合;[‖]符号表示两个特征向量矩阵的连接操作,n(

·

)=exp(

·

)/∑exp(

·

)为归一化操作。

[0027]

而且,步骤4中,将差异性奖励div

k

和代表性奖励rep

k

相结合,计算结合结果r

k

=0.5

×

(div

k

rep

k

),作为强化学习的奖励函数值。

[0028]

而且,步骤4中,采用ddpg强化学习算法训练实现加强vsfb模型。

[0029]

本发明还提供一种基于视觉和语义特征协作与强化学习的视频摘要系统,用于执行如上所述基于视觉和语义特征协作与强化学习的视频摘要方法。

[0030]

与现有视频摘要技术相比,本发明具有以下优点和有益效果:

[0031]

1)与现有技术相比,本发明解决了一个新问题,即针对用户“随手拍”视频的视频摘要问题。

[0032]

2)与现有技术相比,本发明提出了一种全新的基于视觉和语义特征协作调制与强

化学习的bi

‑

lstm模型的无监督视频摘要技术。

[0033]

3)与现有技术相比,本发明利用视频帧的视觉信息和语义信息,计算视频帧的视觉显著性和语义特征重要性及其相关性来展开“随手拍”视频下的视频摘要工作。

附图说明

[0034]

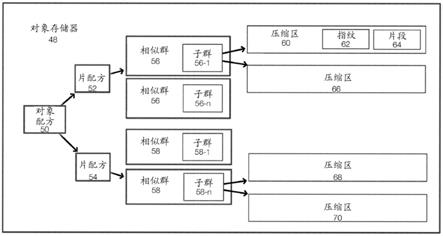

图1是本发明实施例的系统框架图。

[0035]

图2是本发明实施例的视频摘要流程图。

具体实施方式

[0036]

为了便于本领域普通技术人员理解和实施本发明,下面结合附图对本发明作进一步的详细描述,应当理解,此处所描述的实施示例仅用于说明和解释本发明,并不用于限定本发明。

[0037]

本发明提供了一种针对手持设备拍摄的视频,自动生成视频摘要的技术。

[0038]

本发明提出的vsfb方法,是指视觉和语义特征协作调制bi

‑

lstm(visual and semantic feature coordinated bi

‑

lstm),将视频的语义特征经过bi

‑

lstm模型处理预测出每一帧被选择为关键帧的初始概率;然后,将视频的视觉显著性特征输入sam中提取出空间注意力得分,归一化后作为初始概率的调整因子,细化每一帧被选择为关键帧的概率。可以视为建立vsfb模型,用于提取摘要。

[0039]

本发明实施例提供的一种基于视觉和语义特征协作与强化学习的视频摘要方法针对“随手拍”视频,提出将语义信息和视觉信息融合,并以空域关注度模型(sam)调制双向长短期记忆模型(bi

‑

lstm)的形式来细化当前图像被选为关键帧的概率,最后根据摘要结果计算选中帧和其他帧之间的差异性和代表性,依据强化学习奖励机制,利用一个索引调整的差异性和代表性奖励来调整初始概率,加强vsfb模型在视频摘要中的学习。

[0040]

本实施例采用vs2013作为仿真实验平台,在公共的数据集summe和tvsum上进行测试。summe数据集包含25个由普通用户拍摄的原始视频,每段视频时长在1

‑

10min不等。tvsum数据集含有50段时长在1

‑

10min的长视频,包含了纪录片,采访等形式的视频。

[0041]

框架图请见图1,总体流程见附图2。具体步骤如下:

[0042]

步骤1:将视频文件分解成帧序列,按照帧的时间顺序依次使用深度神经网络提取语义特征和视觉显著性特征。

[0043]

实施例中的步骤1优选实现方式如下

[0044]

步骤1.1,给定一段视频序列其中,视频帧其中,视频帧w,h,3是视频帧的长,宽,通道数,是实数集,t为视频帧时间序号,t表示帧序列的视频帧总数。视频帧的信息由视觉信息(z

t

)、语义信息(v

t

)两种信息进行描述。

[0045]

第t帧x

t

的视觉显著性特征信息用z

t

表示,视频帧x

t

的语义特征信息用v

t

表示,d与语义特征的长度有关。

[0046]

步骤1.2,采用文献1的显著性检测方法获取视频帧的视觉信息,通过vgg卷积神经网络提取特征向量,然后从显着性检测器生成的显着性图中呈现显着性直方图,得到视觉显著性特征其中z

t

={z

t

(u,v)∈[0,255]|u∈[0,w],v∈[0,h]},(u,v)表示显著值

z

t

(u,v)的像素坐标,w和h表示图像的宽度和高度,显著值z

t

(u,v)的取值范围是0~255。由于是现有技术,本发明不予赘述。

[0047]

步骤1.3,语义信息的获取方式采用文献2中imagenet上预训练的googlenet算法学习获得。由于是现有技术,本发明不予赘述。

[0048]

具体实施时,步骤1.2和步骤1.3可以并列执行。

[0049]

步骤2:语义特征经过bi

‑

lstm模型处理预测出各视频帧被选择为关键帧的初始概率;将视觉显著性特征输入基于显著区域大小的空域关注度模型(sam)中提取出空间注意力得分,归一化后作为bi

‑

lstm模型初始概率的调整因子;利用调整因子对bi

‑

lstm模型产生的初始概率进行调制得到调制概率。

[0050]

实施例中,步骤2的具体子步骤如下:

[0051]

步骤2.1,利用空域关注度模型(sam)得到初始概率的调整因子:

[0052]

本发明方法发现这样的现象:“视觉显著区域的人眼关注效应”。“视觉显著区域的人眼关注效应”指视频帧图像中出现的大型或运动的物体会引起观众的更多关注。因此步骤二中提出了一种基于显著区域大小的新型空间注意力模型(sam)。将视觉显著性特征输入基于显著区域大小的空域关注度模型(sam)中提取出空间注意力得分,归一化后作为bi

‑

lstm模型初始概率的调整因子。

[0053]

具体实现如下:

[0054]

步骤1.2中提取的视觉显著性特征值z

t

取值范围为0~255,将其划分为26个显著水平等级,表示为其中每级的间隔为10(除了特殊情况r

25

的间隔是5),即r0=[0,10],r1=[10,20],r2=[20,30],

……

,r

25

=[250,255]。

[0055]

1)设空域关注度特征记为

[0056]

如果图像的显著域的显著水平大于等于预设的阈值(本实施例中r

21

,是经过大量模拟实验选取的最佳阈值,具体实施时可以根据情况计算),则该显著域被判定为能够吸引观众的注意力的核心显著域。

[0057]

判定出的核心显著域用来重新定义视觉显著性特征为空域关注度特征计算公式为其中(u,v)表示显著值z

t

(u,v)的像素坐标,则表示该像素坐标的显著水平。

[0058]

2)显著域占比计算如下:

[0059]

其中表示显著水平为的显著区域的像素数。

[0060]

3)由此,将显著水平大于阈值的核心显著域占比相加作为视觉重要性得分λ

t

,计算公式为:也即显著水平大于阈值的核心显著域像素面积占比之和。

[0061]

4)最后,将视觉重要性得分归一化后作为调整因子l

t

,计算公式为:l

t

=n(λ

t

),l

t

∈[0,1]。

[0062]

步骤2.2,利用bi

‑

lstm模型预测出各视频帧被选择为关键帧的初始概率:整个的

语义特征作为顶层是全连接层(fc)的双向bi

‑

lstm网络的输入,经处理产生隐藏状态以sigmoid函数结束的全连接层为每一帧预测一个概率p

t

,计算公式为p

t

=σ(fc(h

t

))。其中σ()是sigmoid函数,fc()是全连接层。

[0063]

每个h

t

都是前向隐藏状态和后向隐藏状态的连结,它封装了前后向视频帧的语义信息。

[0064]

步骤2.3,利用调整因子l

t

对bi

‑

lstm模型产生的初始概率p

t

进行调制得到调制概率β

t

:

[0065]

本发明提出了一种全新的空域关注度模型调制的bi

‑

lstm方法:视频帧的语义特征经过bi

‑

lstm模型为每一帧预测一个初始概率p

t

,并用sam得到的调整因子l

t

加以调整,得到调制概率β

t

,以提高预测关键帧的准确度。

[0066]

具体实现如下:

[0067]

调制的概率表示为β

t

=w

p

·

n(r

t

×

p

t

) w

l

·

n(l

t

)。其中n(

·

)=exp(

·

)/∑exp(

·

)是归一化操作,exp()是以自然常数e为底的指数函数,w

p

和w

l

分别为语义特征和视觉特征的权重,本实施例均设为0.5,具体实施时使用者可根据情况自行调整。r

t

为强化学习奖励函数值,用来调整初始概率。调制概率利用加权求和融合了语义特征和视觉显著性特征的重要性。

[0068]

步骤3:根据调制概率,确定语义特征与视觉显著性特征均重要的关键帧,

[0069]

实现vsfb模型。

[0070]

实施例中选择关键帧具体实现如下:

[0071]

关键帧选择集合y

t

∈[0,1]表示第t帧是否被选为关键帧,“1”表示为选中,“0”为没选中。生成的摘要表示为x

sub

={x

t

|t∈e},e={t∈[1,t]|y

t

=1}。其中,x

t

为前文所述视频帧,e表示为被选为关键帧的时间序列的集合。

[0072]

根据视觉显著度模型调制的预测概率β

t

的大小,选择语义特征与视觉显著性特征均重要(概率大)的关键帧,关键帧的选择服从伯努利分布bernoulli(),,即y

t

=bernoulli(β

t

),y

t

∈{0,1}。

[0073]

步骤4:用内核时间分割算法(kts)将原始视频分为帧数为k的多个独立片段clip。计算选择的关键帧与该clip中其他帧之间索引调整的差异性奖励和代表性奖励,依据强化学习奖励机制,利用该奖励来动态调整初始概率,加强vsfb模型在视频摘要中的学习,利用深度确定性策略梯度算法(ddpg)强化学习训练得到理想模型,然后采用理想模型实现从任意待处理视频中的摘要提取。

[0074]

具体实施时,k可根据视频摘要所选择的帧数预设,原则上k

×

所选择的帧数=总视频帧数。

[0075]

本步骤根据摘要结果计算选中帧和相应clip中其他帧之间的差异性和代表性,依据强化学习奖励机制,利用一个索引调整的差异性和代表性奖励r

t

来调整初始概率,加强vsfb模型在视频摘要中的学习,使得摘要结果更具有代表性。最后利用ddpg强化学习方法训练得到理想模型。

[0076]

具体实现如下:

[0077]

步骤4.1,计算关键帧的调整的差异性奖励:计算某clip中的关键帧和该clip中其

他帧之间的差异性,差异性越小,差异性奖励越大。计算公式为

[0078][0079]

其中,k

′

代表视频摘要的关键帧,k代表原视频该clip中的其他帧。

[0080]

α

index

(k,k

′

)表示帧之间的差异,计算公式为α

index

(k,k

′

)=‖ind

k

‑

ind

k

′

‖/k

‑

1;其中ind

k

′

表示视频摘要的关键帧的索引,ind

k

表示原视频该clip中其他帧的索引。

[0081]

α

c

(k,k

′

)表示视觉特征的差异,计算公式为)表示视觉特征的差异,计算公式为其中表示视频摘要的关键帧的视觉特征向量,表示原视频该clip中其他帧的视觉特征向量。

[0082]

α

v

(k,k

′

)表示语义特征的差异,计算公式为)表示语义特征的差异,计算公式为其中表示视频摘要的关键帧的语义特征向量,表示原视频该clip中其他帧的语义特征向量。

[0083]

步骤4.2,计算视觉特征和语义特征结合的代表性奖励:计算关键帧和该clip中其他帧之间comb的差异性的最小值,差异性越小,意味着该帧在clip中具有更强的代表性,代表性奖励就越大。计算公式为:

[0084][0085]

其中,表示视觉特征和语义特征结合;[‖]符号表示两个特征向量矩阵的连接操作,n(

·

)=exp(

·

)/∑exp(

·

)为归一化操作。

[0086]

步骤4.3,首先,计算索引调整的差异性奖励和代表性奖励的结合:将差异性奖励和代表性奖励相结合,作为强化学习的奖励函数值,用于加强vsfb模型在视频摘要中的学习,然后采用理想模型实现从任意待处理视频中的摘要提取。计算公式为:

[0087]

r

k

=0.5

×

(div

k

rep

k

)

[0088]

然后,采用ddpg强化学习算法来训练最终的模型:将上述的vsfb方法作为actor(动作估计网络),如公式所示,θ

μ

是策略函数的参数,ρ

β

是状态访问分布,s是网络中的隐藏状态,是actor的价值函数。基于强化学习的奖励机制,每次根据当前状态选择动作a,执行a后,获得新状态s和奖励r,对参数进行更新。采用确定性策略梯度算法来计算j(μ)的导数。本模型的最终目标是学习一种策略通过最小化预测和预期动作值之间的smooth

‑

l1损失来更新参数θ

μ

,使得各状态s在ρ

β

的状态分布下执行该策略的分值(q值)的期望j(μ)达到最大,将最优的策略作为最终的模型。

[0089]

具体实施时,本发明技术方案提出的方法可由本领域技术人员采用计算机软件技术实现自动运行流程,实现方法的系统装置例如存储本发明技术方案相应计算机程序的计算机可读存储介质以及包括运行相应计算机程序的计算机设备,也应当在本发明的保护范围内。

[0090]

在一些可能的实施例中,提供一种基于视觉和语义特征协作与强化学习的视频摘要系统,包括以下模块,

[0091]

第一模块,用于将视频文件分解成帧序列,按照帧的时间顺序依次使用深度神经网络提取语义特征和视觉显著性特征;

[0092]

第二模块,用于语义特征经过bi

‑

lstm模型处理预测出各视频帧被选择为关键帧的初始概率;根据视觉显著性特征提取出空间注意力得分,归一化后作为bi

‑

lstm模型初始概率的调整因子,利用调整因子对bi

‑

lstm模型产生的初始概率进行调制得到调制概率;

[0093]

第三模块,用于根据调制概率,确定语义特征与视觉显著性特征均重要的关键帧,实现vsfb模型;

[0094]

第四模块,用于将原始视频分为帧数为k的多个独立片段clip,k为预设值;计算选择的关键帧与相应clip中其他帧之间索引调整的差异性奖励和代表性奖励,依据强化学习奖励机制,动态调整初始概率,加强vsfb模型在视频摘要中的学习,最后得到理想模型,采用理想模型实现从任意待处理视频中的摘要提取。

[0095]

在一些可能的实施例中,提供一种基于视觉和语义特征协作与强化学习的视频摘要系统,包括处理器和存储器,存储器用于存储程序指令,处理器用于调用存储器中的存储指令执行如上所述的一种基于视觉和语义特征协作与强化学习的视频摘要方法。

[0096]

在一些可能的实施例中,提供一种基于视觉和语义特征协作与强化学习的视频摘要系统,包括可读存储介质,所述可读存储介质上存储有计算机程序,所述计算机程序执行时,实现如上所述的一种基于视觉和语义特征协作与强化学习的视频摘要方法。

[0097]

视频摘要效果评价

[0098]

f

‑

score评价指标:为了和其他的方法公平比较,我们采用目前最为通用的测评标准f

‑

score作为我们方法的测试指标。a表示自动生成摘要的长度,b表示真值摘要长度。p为精确度,r为召回率。

[0099][0100]

f

‑

score计算自动生成摘要与真值摘要间的相似度:

[0101][0102]

本方法与其他前沿方法在tvsum和summe上的f

‑

score结果见表1。从表1中可以发现,本发明的视频摘要方法性能明显高于其他前沿方法,也证明了基于视觉和语义特征协作调制与强化学习的bi

‑

lstm模型的无监督视频摘要技术的有效性。

[0103]

表1与其它前沿方法比较

[0104][0105]

从表1可以看出,本发明提出的vsfb模型在summe和tvsum数据集上的f

‑

score分别

比cycle

‑

lstm[4]高出23.67%和2.07%。

[0106]

[3].k.zhou,y.qiao,and t.xiang,“deep reinforcement learning for unsupervised video summarization with diversity

‑

representativeness reward,”aaai,pp.7582

‑

7589,february 2018.

[0107]

[4].y.li,f.tay,c.yao,and s.chen,“unsupervised video summarization with cycle

‑

consistent adversarial lstm networks,”ieee trans.multimedia,vol.22,no.10,pp.2711

‑

2722,2020.

[0108]

应当理解的是,本说明书未详细阐述的部分均属于现有技术。

[0109]

应当理解的是,上述针对较佳实施例的描述较为详细,并不能因此而认为是对本发明专利保护范围的限制,本领域的普通技术人员在本发明的启示下,在不脱离本发明权利要求所保护的范围情况下,所做出的替换或变形,均落入本发明的保护范围之内,本发明的请求保护范围应以所附权利要求为准。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。