1.本发明涉及家庭能量管理领域,具体是一种基于近端策略优化的用户实时自治能量管理优化方法。

背景技术:

2.近年来,随着分布式光伏、电动汽车等柔性负荷及储能等分布式资源在居民智能用电的广泛普及,居民的能量管理和优化控制面临着由各类不确定性因素带来的挑战。与此同时,智能电表和通信等技术的快速发展为监测和控制居民用户分布式设备提供了关键的技术支撑,大数据和人工智能技术的发展则为能量管理优化提供了由数据驱动的新途径。

3.家庭能量管理系统作为能量管理技术在用户侧的体现,能够有效管理用户电能的生产、使用及存储过程。现有大部分文献采用基于模型的优化方法作为家庭能量管理优化问题的技术路线。然而,基于模型的能量管理优化方法的性能依赖于对各类der(distributed energy resource,der)设备运行模型构建的精度;而追求精细化建模易使得优化问题具有非凸和非光滑特性,增大求解难度与计算负担,使得所得策略多适用于线下的应用,难以实现实时能量管理优化的目标。

技术实现要素:

4.本发明的目的在于提供一种基于近端策略优化的用户实时自治能量管理优化方法,不依赖对未来信息准确预测,仅靠实时感知环境状态进行自趋优式策略学习;所采用的长短期记忆神经网络通过挖掘智能电表所采集多源时序数据的时序特征,准确感知未来走势;此外,近端策略优化算法赋能在离散与连续动作空间中学习能量管理优化决策,在最小化用电成本的同时提升策略对不确定性的适应性。

5.本发明的目的可以通过以下技术方案实现:

6.一种基于近端策略优化的用户实时自治能量管理优化方法,管理优化方法包括以下步骤:

7.s1:对用户der设备进行分类和建模,统一的三元组描述各类der设备的运行特性,确定相应的能量管理动作;

8.s2:基于s1中对用户der设备的分类及建模,将用户实时自治能量管理优化问题建模为序贯决策问题;

9.s3:利用长短期记忆神经网络提取实时的时序数据的未来走势,辅助步骤s4和s5中深度强化学习进行策略优化;

10.s4:将s3中提取的未来走势和能量管理智能体观测的内部状态特征输入到基于深度神经网络的策略函数,赋能能量管理智能同时学习离散与连续动作,实现对各设备的控制;

11.s5:采用基于近端策略优化算法赋能在s4中的离散与连续动作中学习能量管理优

化策略。

12.进一步的,所述步骤s1具体包括以下步骤:

13.用户der设备分为分布式光伏、储能、柔性负荷和刚性负荷,柔性负荷又分为具备功率连续调节功能的负荷和具备延迟功率周期功能的负荷;对于任意设备n∈{1,...,n},其t时刻运行状态用以下三元组进行描述:

[0014][0015]

式中:ω

n,t

∈{0,1}表示设备n的运行状态,其值为1表示设备n在t时刻处于允许运行时段,为0则表示设备n在t时刻不允许运行;ρ

n,t

∈[0,1]表示设备n在t时刻任务的完成进度;π

n,t

描述设备n的特有属性;

[0016]

暖通空调和电动汽车为具备功率连续调节功能的负荷,智能家电为具备延迟功率周期功能的负荷;

[0017]

暖通空调在t时刻的状态根据三元组的定义表示为:

[0018][0019]

式中:n为t时刻的室内温度;为t时刻暖通空调的温度设定值;由于暖通空调的允许运行时段为全天,设为1,以当前室温与设定值的差表示暖通空调的运行进度;以用户设定的温度值表示暖通空调的特有属性;

[0020]

暖通空调在t时刻的负荷功率为p

tac

,其大小在式(3)所示范围内连续调节,其中为暖通空调的最大额定功率;

[0021][0022]

在给定p

tac

影响下,t 1时刻室内温度表示为:

[0023][0024]

式中:η

ac

为热转化效率,其值为正代表制冷,为负则为制热;t

tout

为t时刻的室外温度;r

ac

与c

ac

分别为热阻抗与热容量;

[0025]

电动汽车在t时刻的状态根据三元组的定义表示为:

[0026][0027]

式中:与分别为电动汽车接入与断开电网时间;由于电动汽车接入电网时才允许运行,因此当允许运行,因此当为1;表示电动汽车电池t时刻荷电状态,表示电动汽车的运行进度;t用来判断电动汽车在t时刻是否接入电网,为电动汽车特有属性;

[0028]

电动汽车在t时刻的净负荷功率为p

tev

,正值表示充电,负值表示放电;p

tev

大小在式(6)所示范围内调节,其中为电动汽车功率最大值;p

tev

的取值还受制于电动汽车当前荷电状态与电池可用容量的上下限,如式(7)所示:

[0029]

[0030][0031]

式中:为电动汽车电池容量;η

evc

和η

evd

分别为电动汽车的充电与放电效率;和ψ

ev

分别为电动汽车的最高与最低荷电状态;

[0032]

基于式(7),电动汽车电池t 1时刻的荷电状态表示为:

[0033][0034]

储能的运行状态按照上述方式类似描述;

[0035]

智能家电运行周期总时长为t

sa

,包含k个固定次序的用电步骤τ=1,...,k,对应固定的k个用电功率智能家电的允许运行时段由启始与截止时间与描述,智能家电在t时刻的状态根据三元组的定义表示为:

[0036][0037]

式中:智能家电的允许运行时段为因此在该时段内设定为1,在其余时段设定为0;表示任务当前完成进度;表示完成允许运行时段的剩余时间;

[0038]

智能家电的负荷功率t时刻对应的控制变量表示是否执行当前运行步骤,被定义为:

[0039][0040]

给定之后智能家电的负荷功率按式(11)描述:

[0041][0042]

式中:

[0043]

进一步的,所述步骤s2具体为马尔科夫决策过程,包括以下步骤:

[0044]

能量管理智能体与环境:能量管理系统作为能量管理智能体与环境交互学习经验并对能量管理策略进行优化;环境为s1中所有der设备构成的用电系统;

[0045]

有限状态集(s):t时刻环境状态定义为:

[0046]

[0047]

式中:s

1:n,t

为所有设备t时刻的三元组状态;和分别为过去m时段售电商提供的售电和购电价格;为过去m时段室外温度;

[0048]

有限动作集(a):t时刻的动作定义为:

[0049][0050]

式中:p

tev

、p

tev

与p

tac

分别是对电动汽车、储能与暖通空调的连续控制动作;为n

d

个智能家电的离散控制动作;

[0051]

马尔可夫决策过程问题核心是在最大化奖励函数r

t

下给出最优策略,由于能量管理的优化目标是在保证用户舒适度和满足各设备运行约束下的用能费用最少。

[0052]

进一步的,所述步骤奖励函数r

t

具体包括:

[0053]

1)用能费用:

[0054][0055][0056]

式中:l

t

为用户的净负荷;p

tnd

为刚性负荷的功率;p

tpv

为光伏发电功率;和分别为售电商提供的t时刻的售电和购电价格;

[0057]

2)舒适度:用户舒适度同当前室内温度与设定的暖通空调温度上下限有关:

[0058][0059]

式中:为温度距离最佳设定温度的差值阈值;为舒适度权重;

[0060]

3)惩罚项:针对电动汽车用户而言,出行前需保证电池能量足够出行,对于违反该运行约束的部分通过惩罚项施加在奖励函数上,该项表示为式(17):

[0061][0062]

式中:为电动汽车出行需要的总用电量;w2为惩罚项权重;

[0063]

综上,t时刻的奖励函数r

t

表示为:

[0064][0065]

能量管理智能体学习的目标在于求解最优策略使t个运行时段的总期望折扣奖励j(π)最大,目标函数表示为:

[0066][0067]

式中:π:s

t

→

p(a

t

)表示能量管理智能体所采用的策略,反应环境状态到选择动作概率的映射关系;π为策略集;γ

t

∈[0,1]为折扣因子,以平衡短期与长期回报;τ=(s0,a0,r0,s1,...)为能量管理智能体与环境不断交互所产生的状态、动作和奖励序列;t为控制周期总数。

[0068]

进一步的,所述步骤s3中,利用长短期记忆神经网络提取实时电价、光伏发电、室

外温度时序数据的未来走势,具体包括以下步骤:

[0069]

长短期记忆神经网络记忆与预测模块计算流程为:在t时刻时,t

‑

1时刻的记忆单元模块状态c

t

‑1、输入向量x

t

、t

‑

1时刻的隐含层状态h

t

‑1作为记忆单元模块的输入量,相应地,其3个门的内部输出计算公式如下式(20

‑

22)所示;

[0070]

f

t

=σ(w

hf

h

t

‑1 w

xf

x

t

b

f

)

ꢀꢀ

(20)

[0071]

i

t

=σ(w

hi

h

t

‑1 w

xi

x

t

b

i

)

ꢀꢀ

(21)

[0072]

o

t

=σ(w

ho

h

t

‑1 w

xo

x

t

b

o

)

ꢀꢀ

(22)

[0073]

式中:f

t

、i

t

、o

t

分别表示遗忘门、输入门、输出门的输出矩阵;w

hf

、w

xf

、w

hi

、w

xi

、w

ho

、w

xo

分别表示遗忘门、输入门、输出门与h

t

‑1、x

t

的连接权值矩阵;bf、b

i

、b

o

分别表示表示遗忘门、输入门、输出门的偏置向量;σ表示sigmoid激励函数;

[0074]

外部记忆模块最终的输出值h

t

的具体计算公式如下:

[0075]

z

t

=tanh(w

hc

h

t

‑1 w

hx

x

t

b

c

)

ꢀꢀ

(23)

[0076]

c

t

=f

t

⊙

c

t

‑1 i

t

⊙

z

t

ꢀꢀ

(24)

[0077]

h

t

=tanh(c

t

)

⊙

o

t

ꢀꢀ

(25)

[0078]

式中:z

t

为t时刻输入到记忆单元模块的预处理信息;w

hc

与w

hx

表示h

t

‑1、x

t

与z

t

的连接权值矩阵;b

c

为偏置向量;tanh表示双曲正切函数;

⊙

表示矩阵的哈达玛乘积。

[0079]

进一步的,所述步骤s4具体包括以下步骤:

[0080]

式(26)为离散与连续动作策略函数,其中离散动作服从伯努利分布b(p),连续动作则服从高斯分布n(μ,σ2);

[0081][0082]

式中:p为是否执行智能家电用电步骤的概率,即μ与σ2分别表示对应暖通空调、电动汽车和储能功率调节动作的均值与标准差。

[0083]

进一步的,所述步骤s5中,采用基于近端策略优化算法,赋能在离散与连续动作空间中高效学习能量管理优化策略,主要包括以下步骤:

[0084]

近端策略优化算法采用执行器

‑

评判器架构,训练时从经验回放库中抽取一个小批量经验样本供网络参数更新;评判器网络通过时序差分误差的学习方法更新网络参数φ,计算公式如式(27):

[0085][0086]

式中:v

φ

(s

t

)为状态值函数;

[0087]

置信域策略优化算法最终目标函数为式(28):

[0088][0089]

约束:

[0090]

式中:和分别代表新策略与旧策略;为基于旧策略的状态访问概率;为优势函数,用来表征策略下动作a

t

相对平均动作的优势;为新策略

和旧策略之间kl散度;δ为置信域,用以限制kl散度的范围。

[0091]

进一步的,对所述目标函数进行一阶近似并采用蒙特卡罗方法近似期望后为:

[0092][0093][0094][0095]

式中:为动作a

t

在状态s

t

下采用b步回报价值估计法得到的优势函数;ξ

t

为新旧策略比率;

[0096]

为简化计算过程,对式(30)进行了裁剪,进而得到新的目标函数l

clip

;l

clip

为算法规定了两个约束,从而使新旧策略比率ξ

t

约束到[1

‑

ε,1 ε]之间,确保能起到置信域策略优化算法中置信域δ的作用:

[0097][0098][0099]

因此,l

clip

实现了一种与随机梯度下降兼容的置信域修正方法,并通过消除kl损失来简化算法以及降低适应性修正的需求。

[0100]

本发明的有益效果:

[0101]

本发明管理优化方法不依赖对未来信息准确预测,仅靠实时感知环境状态进行自趋优式策略学习;所采用的长短期记忆神经网络通过挖掘智能电表所采集多源时序数据的时序特征,准确感知未来走势;此外,近端策略优化算法赋能在离散与连续动作空间中学习能量管理优化决策,在最小化用电成本的同时提升策略对不确定性的适应性。

附图说明

[0102]

下面结合附图对本发明作进一步的说明。

[0103]

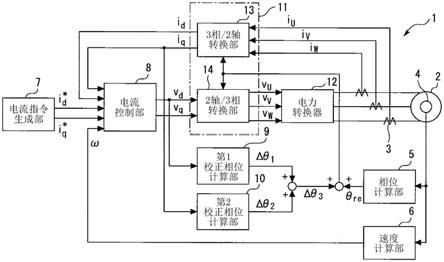

图1是本发明基于长短期记忆神经网络和深度神经网络的时序特征提取以及策略拟合示意图;

[0104]

图2是本发明近端策略优化算法训练流程示意图;

[0105]

图3是本发明分时电价示意图;

[0106]

图4是本发明四种深度强化学习算法下的平均日用电成本示意图;

[0107]

图5是本发明der设备的运行情况示意图;

[0108]

图6是本发明室内与室外温度变化示意图;

[0109]

图7是本发明用户净负荷与发电变化示意图;

[0110]

图8是本发明der设备的运行情况示意图;

[0111]

图9是本发明室内与室外温度变化示意图;

[0112]

图10是本发明用户净负荷与发电变化示意图。

具体实施方式

[0113]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有作出创造性劳动前提下所获得的所有其它实施例,都属于本发明保护的范围。

[0114]

本实施例依据某配电公司所提供的数据作场景分析。数据包含2011年7月1日到2012年6月30日期间以半小时为采集周期与控制时段的用户刚性负荷以及光伏发电的数据,室外温度数据来自澳大利亚政府的公开数据集。如图2所示,售电商的售电价采取区分夏季与冬季的分时电价,而购电价则采用全年统一的光伏上网电价4美分/千瓦。各柔性负荷的运行参数见下表:

[0115]

柔性负荷运行参数

[0116][0117]

注:

°

f=℃*1.8 32

[0118]

本实施例将每日初始室内温度、电动汽车的出行时刻与时长、电动汽车和储能的初始荷电状态、智能家电的启始与截止运行时刻做差异化处理。上述与温度、电量相关的参数通过截断正态分布采样获得,与运行时间相关的参数通过离散均匀分布采样获得,参数取值如下表所示:

[0119]

用户主导的柔性负荷运行参数的概率分布

[0120][0121]

本实施例具体包括以下步骤:

[0122]

s1:对用户der(distributed energy resource,der)设备进行分类,并用统一的三元组描述各类der设备的运行特性,确定相应的能量管理动作,具体包括:

[0123]

所述s1对用户der设备进行分类,并用统一的三元组描述各类der设备的运行特性,确定相应的能量管理动作,包括以下步骤:

[0124]

用户der设备分为分布式光伏、储能、柔性负荷和刚性负荷,柔性负荷再分为具备功率连续调节功能的负荷和具备延迟功率周期功能的智能家电。对于任意设备n∈{1,...,n},其t时刻运行状态s

n,t

用以下三元组进行描述:

[0125][0126]

式中:ω

n,t

∈{0,1}表示设备n的运行状态,其值为1表示设备n在t时刻处于允许运行时段,为0则表示设备n在t时刻不允许运行;ρ

n,t

∈[0,1]表示设备n在t时刻任务的完成进度;π

n,t

描述设备n的特有属性。

[0127]

暖通空调和电动汽车为具备功率连续调节功能的负荷,智能家电为具备延迟功率周期功能的负荷;

[0128]

暖通空调在t时刻的状态根据三元组的定义表示为:

[0129][0130]

式中:t

tac

为t时刻的室内温度;为t时刻暖通空调的温度设定值;由于暖通空调的允许运行时段为全天,为暖通空调的运行状态,其值设为1,以当前室温与设定值的差表示暖通空调的运行进度;以用户设定的温度值表示暖通空调的特有属性。

[0131]

暖通空调在t时刻的负荷功率为p

tac

,其大小在式(3)所示范围内连续调节,其中为暖通空调的最大额定功率。

[0132][0133]

在给定p

tac

影响下,t 1时刻室内温度表示为:

[0134][0135]

式中:η

ac

为热转化效率,其值为正代表制冷,为负则为制热;t

tout

为t时刻的室外温度;r

ac

与c

ac

分别为热阻抗与热容量。

[0136]

电动汽车在t时刻的状态根据三元组的定义表示为:

[0137][0138]

式中:与分别为电动汽车接入与断开电网时间。由于电动汽车接入电网时才允许运行,因此当允许运行,因此当为1;表示电动汽车电池t时刻荷电状态,表示电动汽车的运行进度;t用来判断电动汽车在t时刻是否接入电网,为电动汽车特有属性。

[0139]

电动汽车在t时刻的净负荷功率为p

tev

,正值表示充电,负值表示放电。p

tev

大小在式(6)所示范围内调节,其中为电动汽车功率最大值。p

tev

的取值还受制于电动汽车当前荷电状态与电池可用容量的上下限,如式(7)所示:

[0140][0141][0142]

式中:为电动汽车电池容量;η

evc

和η

evd

分别为电动汽车的充电与放电效率;和分别为电动汽车的最高与最低荷电状态。

[0143]

基于式(7),电动汽车电池t 1时刻的荷电状态表示为:

[0144][0145]

储能的运行状态按照上述方式类似描述。

[0146]

智能家电运行周期总时长为t

sa

,包含k个固定次序的用电步骤τ=1,...,k,对应固定的k个用电功率智能家电的允许运行时段由启始与截止时间与描述,智能家电在t时刻的状态根据三元组的定义表示为:

[0147][0148]

式中:智能家电的允许运行时段为因此在该时段内设定为1,在其余时段设定为0;表示任务当前完成进度;表示完成允许运行时段的剩余时间。

[0149]

智能家电的负荷功率t时刻对应的控制变量表示是否执行当前运行步

骤,被定义为:

[0150][0151]

给定之后智能家电的负荷功率按式(11)描述:

[0152][0153]

式中:

[0154]

s2:基于s1中对der设备的分类及建模,将用户实时自治能量管理优化问题建模为序贯决策问题,具体包括:

[0155]

能量管理智能体与环境:家庭能量管理系统(home energy management system,hems)作为本发明中的能量管理智能体与环境交互学习经验并对能量管理策略进行优化。环境为s1中所有der设备构成的用电系统。

[0156]

有限状态集(s):t时刻环境状态定义为:

[0157][0158]

式中:s

1:n,t

为所有设备t时刻的状态(由各设备的三元组状态组成);和分别为过去m时段售电商提供的售电和购电价格;为过去m时段室外温度。

[0159]

有限动作集(a):t时刻的动作定义为:

[0160][0161]

式中:p

tev

、p

tes

与p

tac

分别是对电动汽车、储能与暖通空调的连续控制动作;为n

d

个智能家电的离散控制动作。

[0162]

马尔可夫决策过程问题核心是在最大化奖励函数r

t

下给出最优策略,由于能量管理的优化目标是在保证用户舒适度和满足各设备运行约束下的用能费用最少;因此奖励函数r

t

的设置包含以下三部分:

[0163]

1)用能费用:

[0164][0165][0166]

式中:l

t

为用户的净负荷;p

tnd

为刚性负荷的功率;p

tpv

为光伏发电功率;和分别为售电商提供的t时刻的售电和购电价格。

[0167]

2)舒适度:用户舒适度同当前室内温度与设定的暖通空调温度上下限有关:

[0168]

[0169]

式中:为温度距离最佳设定温度的差值阈值;w1为舒适度权重。

[0170]

3)惩罚项:针对电动汽车用户而言,出行前需保证电池能量足够出行,对于违反该运行约束的部分通过惩罚项施加在奖励函数上,该项表示为式(17):

[0171][0172]

式中:为电动汽车出行需要的总用电量;w2为惩罚项权重。

[0173]

综上,t时刻的奖励函数r

t

表示为:

[0174][0175]

能量管理智能体学习的目标在于求解最优策略使t个运行时段的总期望折扣奖励j(π)最大,目标函数表示为:

[0176][0177]

式中:π:s

t

→

p(a

t

)表示能量管理智能体所采用的策略,反应环境状态到选择动作概率的映射关系;π为策略集;γ

t

∈[0,1]为折扣因子,以平衡短期与长期回报;τ=(s0,a0,r0,s1,...)为能量管理智能体与环境不断交互所产生的状态、动作和奖励序列;t为控制周期总数。

[0178]

s3:利用长短期记忆神经网络提取实时电价、光伏发电、室外温度等时序数据的未来走势,辅助s4和s5中深度强化学习进行策略优化,具体包括:

[0179]

长短期记忆神经网络记忆与预测模块计算流程为:在t时刻时,t

‑

1时刻的记忆单元模块状态c

t

‑1、输入向量x

t

、t

‑

1时刻的隐含层状态h

t

‑1作为记忆单元模块的输入量,相应地,其3个门的内部输出计算公式如下式(20

‑

21)所示。

[0180]

f

t

=σ(w

hf

h

t

‑1 w

xf

x

t

b

f

)

ꢀꢀ

(20)

[0181]

i

t

=σ(w

hi

h

t

‑1 w

xi

x

t

b

i

)

ꢀꢀ

(21)

[0182]

o

t

=σ(w

ho

h

t

‑1 w

xo

x

t

b

o

)

ꢀꢀ

(22)

[0183]

式中:f

t

、i

t

、o

t

分别代表遗忘门、输入门、输出门的输出矩阵;w

hf

、w

xf

、w

hi

、w

xi

、w

ho

、w

xo

表示遗忘门、输入门、输出门分别与h

t

‑1、x

t

的连接权值矩阵;b

f

、b

i

、b

o

表示遗忘门、输入门、输出门的偏置向量;σ表示sigmoid激励函数。

[0184]

外部记忆模块最终的输出值h

t

的具体计算公式如下:

[0185]

z

t

=tanh(w

hc

h

t

‑1 w

hx

x

t

b

c

)

ꢀꢀ

(23)

[0186]

c

t

=f

t

⊙

c

t

‑1 i

t

⊙

z

t

ꢀꢀ

(24)

[0187]

h

t

=tanh(c

t

)

⊙

o

t

ꢀꢀ

(25)

[0188]

式中:z

t

为t时刻输入到记忆单元模块的预处理信息;w

hc

与w

hc

表示h

t

‑1、x

t

与z

t

的连接权值矩阵;b

c

为偏置向量;tanh表示双曲正切函数;

⊙

表示矩阵的哈达玛乘积。

[0189]

s4:将s3中提取时序数据的未来走势和能量管理智能体观测的内部状态特征输入到基于深度神经网络的策略函数,赋能能量管理智能体同时学习离散与连续动作,实现对各设备的良好控制,具体包括:

[0190]

基于深度神经网络的策略函数:式(26)为离散与连续动作策略函数,其中离散动作服从伯努利分布b(p),连续动作则服从高斯分布n(μ,σ2)。

[0191][0192]

式中:p为是否执行智能家电用电步骤的概率,即μ与σ2分别表示对应暖通空调、电动汽车和储能功率调节动作的均值与标准差。

[0193]

s5:采用基于近端策略优化算法赋能在s4中的离散与连续动作空间中学习能量管理优化策略,具体包括:

[0194]

近端策略优化算法采用执行器

‑

评判器架构,训练时从经验回放库中抽取一个小批量经验样本供网络参数更新。评判器网络通过时序差分误差的学习方法更新网络参数φ,计算公式如式(27):

[0195][0196]

式中:v

φ

(s

t

)为状态值函数。

[0197]

置信域策略优化算法最终目标函数为式(28):

[0198][0199]

约束:

[0200]

式中:和分别代表新策略与旧策略;为基于旧策略的状态访问概率;为优势函数,用来表征策略下动作a

t

相对平均动作的优势;为新策略和旧策略之间kl散度;δ为置信域,用以限制kl散度的范围。

[0201]

对式(28)中的目标函数进行一阶近似并采用蒙特卡罗方法近似期望后为:

[0202][0203][0204][0205]

式中:为动作a

t

在状态s

t

下采用b步回报价值估计法得到的优势函数;ξ

t

为新旧策略比率。

[0206]

为简化计算过程,对式(30)进行了裁剪,进而得到新的目标函数l

clip

。l

clip

为算法规定了两个约束,从而使新旧策略比率ξ

t

约束到[1

‑

ε,1 ε]之间,确保能起到置信域策略优化算法中置信域δ的作用:

[0207]

[0208][0209]

因此,l

clip

实现了一种与随机梯度下降兼容的置信域修正方法,并通过消除kl损失来简化算法以及降低适应性修正的需求。

[0210]

为评估所提基于近端策略优化(proximal policy optimization,ppo)的能量管理优化方法,实施例中先以现有广泛采用的dqn(deep q network,dqn)、dpg(deep policy gradient,dpg)和ddpg(deep deterministic policy gradient,ddpg)三种深度强化学习算法方法作对比;然后以两种基于模型的优化方法作为对比:

[0211]

1)在假设能够对刚性负荷、光伏、温度等进行完美预测的前提下,求解最小化用户日用电成本对应混合整数线性规划问题(mixed integer linear programming,milp),以此作为理论最优解;

[0212]

2)模型预测控制mpc在每个控制时段对未来一段时间(即控制时域)的负荷和光伏等进行预测,进而在该时段上求解成本最小化问题,以所得控制序列的第一个元素作为当前时段的控制策略,该优化过程随时间不断向后滚动。本实施例以8小时为控制时域,利用长短期记忆神经网络网络进行时序数据预测。

[0213]

为降低结果的偶然性,每次生成10个random seeds,每个random seed中每个算法训练20,000epochs,每个epoch代表训练数据集中的一个随机日。训练过程中,每200epoch在测试数据集上对各深度强化学习算法的表现进行评估。图3中线条与阴影分别代表对应各深度强化学习算法在10个random seed上用测试数据集计算所得的日用电成本的平均值与标准差。

[0214]

如图3所示,近端策略优化在能量管理策略的训练过程中成本效益不断提升,日用电成本的标准差不断下降。最终近端策略优化算法下的收敛结果为372.35美分,为四种基于深度强化学习算法的无模型能量管理优化方法中的最低值,相比于dqn与dpg两种算法,平均日用电成本降低了约15.52%与8.37%,标准差方面分别降低了约29.35%与44.50%。其次,相较dqn算法,近端策略优化赋能对电动汽车,储能和暖通空调功率的连续调节,平均日用电成本显著降低。因dpg算法中缺少策略评估环节,策略梯度估计结果不准确且方差较大,因此导致了收敛速度较低的次优策略。此外,ddpg算法由于无法处理离散动作导致策略次优,性能依赖于对大量超参数的调节,因此存在收敛困难且不稳定的现象。相较之下,近端策略优化因具备“执行器

‑

评价器”的架构,在策略优化过程中通过计算优势值进行评估,稳定性更强。近端策略优化还通过式(32)将策略更新的目标函数做了裁剪,简化需要满足的置信域约束,因此收敛性能更稳定,训练速度更快。

[0215]

为验证所提长短期记忆神经网络数据特征提取技术的有效性,采用该技术前后所得到的平均日用电成本如下表所示。对比于仅基于当前时段所感知的原始时序数据的策略优化,所拟时序数据未来走势提取技术基于时段t之前m个时段的历史数据的时域特征,挖掘时序数据的未来趋势,更有效地辅助能量管理智能体的序贯决策,进而提升了应对不确定性时的鲁棒性。

[0216]

有无未来走势特征提取的平均日用电成本

[0217]

方法提取未来走势不提取未来走势平均日用电成本(美分)372.35381.83

[0218]

通过求解milp问题得到,364.54美分为53个测试日平均日用电成本的理论最优值。如下表所示,ppo和mpc的平均日用电成本较理论最优解分别高出2.14%和5.41%。这是由于mpc虽然能够一定程度上降低预测不确定性对成本的影响,但优化性能仍然受预测误差所影响。ppo算法不依赖对未来信息的精准预测,并能够对数据未来走势准确感知,因此所得策略更好地应对不确定性。

[0219]

milp,mpc和ppo下平均日用电成本

[0220]

方法milpmpcppo平均日用电成本(美分)64.54384.25372.35

[0221]

为进一步验证近端策略优化下能量管理策略对未来场景的泛化性,在近端策略优化算法训练完成后,实施例选取了测试数据集中夏季与冬季两个典型日来分析能量管理策略的成本效益,分别如图5

‑

7和图8

‑

10所示。图5和图6中的夏季典型日呈现出较高的室外温度以及充足的光伏发电特征。如图5所示,因早晨温度较低,hems并未启动暖通空调而在8:30以后启动,由于室外温度超过阈值,暖通空调尽可能吸收光伏发电量,在保持室内温度刚好低于24℃的同时减小用电成本。此外在11:00

‑

14:30间,售电商购电价格仍高于售电价格时,hems尽可能选择利用储能的充电来吸收剩余的光伏发电量,而非将其出售。此外,智能家电的运行周期被转移到了售电价格较低的时段22:30

‑

24:00。如图7所示,所得的能量管理策略通过利用der设备的互补性(如电动汽车与储能),在9:00

‑

20:30间实现了用户净负荷为0,完成了光伏的充分消纳,最大程度上挖掘了der设备的灵活性。

[0222]

如图8和图9所示,冬季典型日与夏季典型日的区别在于较低的室外温度与稀少的光伏发电量。在图8中,因早晨温度过低,hems启动暖通空调的制热功能以保证温度略高于19℃,7:00之后电价升高后关闭暖通空调以降低成本。与夏季典型日相同的是,智能家电的运行周期同样被转移到了售电价格较低的时段。hems选择在用电低谷时段向储能与电动汽车充电,在7:30

‑

11:30与14:00

‑

20:30这两个用电高峰时段通过储能与电动汽车放电以满足用户电能需求,在7:30

‑

22:00间实现了用户净负荷接近为0。

[0223]

实施例结果表明所提方法能够综合考虑电价、室外温度、光伏出力、用户行为等不确定因素,充分挖掘柔性负荷的灵活性,实现对多类型der设备的实时能量管理优化。与此同时,在对比其它三种无模型深度强化学习算法和两种基于模型的最优化方法后,近端策略优化算法在收敛性、最小化用户成本以及应对不确定性表现等方面均具有更好的表现。

[0224]

在本说明书的描述中,参考术语“一个实施例”、“示例”、“具体示例”等的描述意指结合该实施例或示例描述的具体特征、结构、材料或者特点包含于本公开的至少一个实施例或示例中。在本说明书中,对上述术语的示意性表述不一定指的是相同的实施例或示例。而且,描述的具体特征、结构、材料或者特点可以在任何的一个或多个实施例或示例中以合适的方式结合。

[0225]

在本说明书的描述中,参考术语“一个实施例”、“示例”、“具体示例”等的描述意指结合该实施例或示例描述的具体特征、结构、材料或者特点包含于本发明的至少一个实施例或示例中。在本说明书中,对上述术语的示意性表述不一定指的是相同的实施例或示例。而且,描述的具体特征、结构、材料或者特点可以在任何的一个或多个实施例或示例中以合

适的方式结合。

[0226]

以上显示和描述了本发明的基本原理、主要特征和本发明的优点。本行业的技术人员应该了解,本发明不受上述实施例的限制,上述实施例和说明书中描述的只是说明本发明的原理,在不脱离本发明精神和范围的前提下,本发明还会有各种变化和改进,这些变化和改进都落入要求保护的本发明范围内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。