基于cpu和gpu协同处理的全色和多光谱影像实时融合方法

技术领域

1.本发明属于图像处理领域,具体涉及一种基于cpu和gpu协同处理的全色和多光谱影像实时融合方法。

背景技术:

2.从传感器的工作方式的角度看,影像数据分为多光谱影像和全色波段图像。全色波段图像数据具有比较高的空间分辨率,而光谱分辨率较低;多光谱影像数据由于采用窄波段光源进行成像,光谱分辨率较高而空间分辨率很低。全色多光谱融合方法就是将这两者的优点结合起来,使融合后图像既具有高的空间分辨能力又具有高的光谱分辨能力,以利于后期的判读和处理。

3.对于相机而言,探测像元,简称探元,只有接受到足够的能量才能维持信噪比,采用多光谱单波段成像时,传感器接收能量弱,只能增大探元尺寸,从而导致多光谱影像的空间分辨率低于全色波段图像;而全色波段图像的空间分辨率虽然高于多光谱,但是为了增加接收能量的强度,其传感器波谱范围较宽,其图像的光谱分辨能力低于多光谱。在相等的条件下,提高空间分辨率必然会降低光谱分辨率,这是不可调和的矛盾。因此在相机实际设计的过程中,高频空间信息与光谱信息相分离,一般的光学传感器只提供高分辨率全色影像和低分辨率多光谱影像。如何得到光谱信息与多光谱影像的融合影像是研究的重点。

4.随着社会、经济和科技的发展,影像分辨率已经达到米级或亚米级,其单景一级全色影像数据量也逐步增加,全色数据量的增加也会导致融合数据的迅速增加,最高可达上百gb。当任务对时效性的要求非常高,甚至到分钟级响应需求时,对光谱图像的融合处理算法提出了很高的要求,传统的融合处理方法延时较高,难以满足快速处理的需求。

技术实现要素:

5.为了突破全色多光谱快速融合的瓶颈,满足不同任务快速反应的重大需求,迫切需要研究新的全色多光谱影像融合高性能处理的方法,本发明公开了一种基于cpu和gpu协同处理的全色和多光谱影像实时融合方法,在保障融合效果的前提下,有效地提升了大数据量融合的效率,具有一定理论价值与实际意义。

6.为了解决大数据量的全色和多光谱融合过程中效率较低的问题,本发明主要基于cpu/gpu协同处理,整个处理流程都在内存当中进行,cpu负责流程控制与并行规则划分,gpu负责并行处理。本发明提出了一种基于cpu和gpu协同处理的全色和多光谱影像实时融合方法,其具体步骤包括:

7.s101,通过有理函数模型计算全色影像和多光谱影像的重叠区域;

8.通过有理函数模型rfm确定全色影像与多光谱影像各自的物方坐标,物方坐标表达式为(b,l,h),其包括大地纬度b、大地经度l、大地高h,h为平均的大地高程。

9.对物方坐标进行归一化处理,得到归一化后的物方坐标(u,v,w),其计算公式为:

[0010][0011]

其中,lonoff,latoff,heioff分别为物方坐标(b,l,h)的平移值,lonscale,latscale,heiscale分别为物方坐标(b,l,h)的缩放值。

[0012]

对于每一景影像,归一化后的物方坐标(u,v,w)与像方坐标(s

n

,l

n

)的关系用多项式比值形式表示为:

[0013][0014]

其中,等号右边的多项式分子、分母的表达式分别为:

[0015]

num

l

(u,v,w)=a1 a2v a3u a4w a5vu a6vw a7uw a8v2 a9u2 a

10

w2 a

11

vuw a

12

v3 a

13

vu2 a

14

vw2 a

15

v2u a

16

u3 a

17

uw2 a

18

v2w a

19

u2w a

20

w3,

[0016]

den

l

(u,v,w)=b1 b2v b3u b4w b5vu b6vw b7uw b8v2 b9u2 b

10

w2 b

11

vuw b

12

v3 b

13

vu2 b

14

vw2 b

15

v2u b

16

u3 b

17

uw2 b

18

v2w b

19

u2w b

20

w3,

[0017]

num

s

(u,v,w)=c1 c2v c3u c4w c5vu c6vw c7uw c8v2 c9u2 c

10

w2 c

11

vuw c

12

v3 c

13

vu2 c

14

vw2 c

15

v2u c

16

u3 c

17

uw2 c

18

v2w c

19

u2w c

20

w3,

[0018]

den

s

(u,v,w)=d1 d2v d3u d4w d5vu d6vw d7uw d8v2 d9u2 d

10

w2 d

11

vuw d

12

v3 d

13

vu2 d

14

vw2 d

15

v2u d

16

u3 d

17

uw2 d

18

v2w d

19

u2w d

20

w3,

[0019]

其中,a

i

,b

i

,c

i

,d

i

,i=1,2,

…

,20,为有理多项式系数(rational polynomial coefficients,rpcs)。

[0020]

得到全色影像与多光谱影像的地理范围之后,计算出全色影像与多光谱影像的重叠区域的地理范围,并且分别将两张影像各自重叠区域的地理范围通过rfm模型,得到其在各自影像的像方坐标系下的坐标值。

[0021]

s102,读取全色影像与多光谱影像的重叠区域中的全色影像,并且以其为基准,通过gpu对多光谱影像进行虚拟化,得到虚拟化后的多光谱影像,即虚拟影像;

[0022]

将步骤s101中计算得到的全色影像与多光谱影像的重叠区域中的全色影像读入cpu内存当中,以该重叠区域中的全色影像为基准,通过gpu对多光谱影像进行虚拟化,其具体步骤包括:

[0023]

s1021,以全色影像的像方坐标为基准,将虚拟影像划分为均匀的规则格网,并且计算每个格网的四个角点的像方坐标;

[0024]

s1022,对虚拟影像的每个格网的四个角点的像方坐标(s,l),通过rfm模型计算其对应的物方坐标;

[0025]

s1023,对虚拟影像的每个格网的四个角点的物方坐标,通过rfm模型计算多光谱影像中对应点的像方坐标(s

′

,l

′

);

[0026]

s1024,利用虚拟影像每个格网的四个角点的像方坐标,构建虚拟影像像方坐标与多光谱影像像方坐标的变换模型g(),其变换过程表示为(s,l)=g(s

′

,l

′

),该变换模型g

()采用线性变换模型、仿射变换模型或透视变换模型中的一种。

[0027]

s1025,对虚拟影像像素进行重采样;将虚拟影像像素重采样的过程映射到gpu进行处理,将gpu计算过程中的每一个cuda线程设置为仅对一个像素进行计算。具体来说,将虚拟影像上的每个像素点的坐标通过变换模型g(),计算得到多光谱影像上的像素点坐标,并且选用最近邻近采样、双线性采样或双三次重采样方法中的一种。

[0028]

s103,将虚拟化后的多光谱影像转成虚拟全色影像,通过gpu将虚拟全色影像与真实的全色影像进行格网点匹配,得到同名网格点;

[0029]

首先将虚拟化后的多光谱影像中的每个像素转换成与全色影像光学特性一致的虚拟全色单一波段像素,该过程表示为:

[0030]

mss

p

=e1*band

b

e2*band

g

e3*band

r

e4*band

nir

,

[0031]

上式中,mss

p

为转换后的与全色影像光学特性一致的虚拟全色单一波段像素值,e1、e2、e3、e4分别为蓝光波段b、绿光波段g、红光波段r、近红外波段nir对应的波段范围占全色波段范围的比例,band

b

、band

g

、band

r

、band

nir

分别代表多光谱虚拟影像中的蓝光波段、绿光波段、红光波段以及近红外波段影像的像素值。

[0032]

提取全色影像与虚拟全色影像的同名点,该同名点作为多光谱虚拟影像进行数字微分纠正的输入。所述的提取全色影像与虚拟全色影像的同名点,采用相关系数法,以全色影像与虚拟全色影像的相关系数作为影像匹配的匹配测度,在指定的影像搜索范围中计算相关系数,而后选取相关系数最大的点作为同名点,相关系数是标准化的协方差函数。

[0033]

选择m波段的全色影像上的某一像素点为初值点,以该初值点为中心,建立m

×

n个像素的匹配窗口,并在n波段的虚拟全色影像上建立与m波段的全色影像的初值点上同样大小和形状的匹配窗口,计算两个匹配窗口的相关系数,其计算公式为:

[0034][0035]

其中,r(c,r)表示两个匹配窗口在行和列上的坐标差分别为c和r时的相关系数,m,n分别表示匹配窗口的行和列大小,i,j分别表示匹配窗口内的行序号和列序号,g

i,j

表示m波段的全色影像和n波段的虚拟全色影像的匹配窗口内第i行、第j列的灰度值,g

i r,j c

表示上述的两个影像的匹配窗口内第i r行、第j c列的灰度值,c,r分别是n波段的虚拟全色影像的匹配窗口对于m波段的全色影像的匹配窗口中的同名点在行、列上的坐标差。对于已经进行了格网点匹配处理的多光谱影像,取c=r=0;对于未进行格网点匹配的影像,c和r的取值则根据相机的硬件参数值来确定。

[0036]

在全色影像上从设定的格网点中确定控制点,采用相关系数法,依次获取每个格网点在虚拟全色影像上的同名点。将相关系数的计算过程映射到gpu上进行,gpu上的每个线程块对应一个格网点,线程块中的每个线程实现一组相关系数的计算,每个线程块计算完毕之后获取相关系数最大的同名点,并且利用抛物线法对相关系数最大的同名点相邻的四个点进行拟合,得到该相关系数最大的同名点的亚像素值。

[0037]

s104,获取同名格网点之后,通过gpu对多光谱虚拟影像进行数字微分纠正,得到数字微分纠正后的多光谱影像;

[0038]

对多光谱虚拟影像进行数字微分纠正,多光谱虚拟影像中的每个格网包括四组同名点,数字微分纠正过程f(x',y')的数学表达式为:

[0039][0040]

式中,(x,y)为所述的同名点在数字微分纠正前的像方坐标,(x',y')为所述的同名点在数字微分纠正后的像方坐标,g1、f1、g2、f2、g3、f3、g4、f4分别为数字微分纠正过程的8个变换系数,该8个变换系数通过对4组同名点联合建立的8个数字微分纠正过程方程进行解算得到。分别解算每个格网的变换系数,从而对多光谱虚拟影像进行数字微分纠正,再进行最近邻近采样、双线性采样或双三次重采样。将数字微分纠正的过程映射到gpu进行处理,将gpu计算过程中的每一个cuda线程设置为仅对一个像素进行计算。

[0041]

s105,对数字微分纠正后的多光谱影像以及全色影像进行快速融合,得到最终的融合结果。

[0042]

所述的步骤s105,通过两种方式实施,一是利用基于多尺度的平滑滤波亮度变换模型sfim的融合算法(mssfim)实现,二是利用基于全色光谱分解的影像融合方法(psd)实现。

[0043]

所述的基于多尺度的sfim模型的融合算法,是基于多尺度原理与sfim模型的影像融合算法;sfim模型的融合过程表示为,

[0044][0045]

其中,ms是多光谱影像的像素值,pan是全色影像的像素值,pan

′

是低分辨率全色影像像素值,fusion是融合结果。pan和pan

′

的比值只保留了高分辨率图像的边缘细节信息。

[0046]

对全色影像利用高斯金字塔方法,生成不同尺度的低分辨率全色影像,并向sfim模型得到的融合影像中添加不同清晰程度的高频信息,以增强融合后的图像的清晰度。

[0047]

所述的基于全色光谱分解的影像融合方法,利用了同时拍摄的全色影像与多光谱影像之间的强相关性,通过线性变换加残差消减的方式将全色影像像元亮度值dn分解为多光谱影像波段像元亮度值dn,再利用比值变换法进行影像融合。在比值变换法中,全色影像与所生成不同尺度的低分辨率全色影像的像素值比值等于融合图像与低质量多光谱影像的像素值的比值,即:

[0048][0049]

其中,pan

hq

为高质量全色影像,即原始全色影像,pan

hq

(i,j)表示原始全色影像的第i行、第j列像素点的像素值;pan

lq

为所生成不同尺度的低质量全色影像,pan

lq

(i,j)表示所生成不同尺度的低质量全色影像的第i行、第j列像素点的像素值;为理想的高质量多光谱影像,即融合图像,表示融合图像的g波段图像第i行、第j列像素点的像素值;为低质量多光谱影像,其通过对原始多光谱影像进行采样得到,

表示低质量多光谱影像的g波段图像第i行、第j列像素点的像素值;i,j,g分别是行、列、波段的序号。全色影像与多光谱影像之间的数学关系描述为:

[0050]

pan=k

(g)

ms

(g)

b

(g)

t e

(g)

,

[0051]

其中,b

(g)

是多光谱影像第g波段对应的偏置系数,k

(g)

为多光谱影像第g波段对应的比例系数,t为维度与pan相同、且其元素都为1的矩阵,e

(g)

是多光谱影像第g波段对应的残差矩阵,pan是全色影像的像素值,ms

(g)

是g波段多光谱影像的像素值。通过低分辨率的全色多光谱影像拟合得到比例系数、偏置系数及残差矩阵,并利用这些系数得到融合的高分辨率全色影像。

[0052]

本发明的有益效果为:

[0053]

相对于传统的分步骤融合方法,本方法将全色与多光谱融合的所有步骤都在内存中完成,并且将计算量较大的步骤都映射到gpu进行,能够在保障融合精度的同时极大地提高融合效率。并且该方法不仅通过rfm考虑了全色多光谱之间严密的几何对应关系,而且还通过微分纠正最大限度地限制了全色多光谱之间可能存在的几何偏差,使得全色与多光谱的配准效果能够达到最优。最后该方法通过基于多尺度的sfim融合方法与全色光谱分解的影像融合方法获取效果最优的融合图像。本发明适用于大数据量的传感器影像快速融合处理需求。

附图说明

[0054]

图1是本发明一种基于cpu/gpu协同处理的全色多光谱近实时融合方法的流程示意图。

[0055]

图2为全色多光谱的原始影像和虚拟影像坐标映射流程图。

具体实施方式

[0056]

为了更好的了解本发明内容,这里给出一个实施例。

[0057]

本发明公开了一种基于cpu和gpu协同处理的全色和多光谱影像实时融合方法,在保障融合效果的前提下,有效地提升了大数据量融合的效率,具有一定理论价值与实际意义。图1是本发明一种基于cpu/gpu协同处理的全色多光谱近实时融合方法的流程示意图。

[0058]

为了解决大数据量的全色和多光谱融合过程中效率较低的问题,本发明主要基于cpu/gpu协同处理,整个处理流程都在内存当中进行,cpu负责流程控制与并行规则划分,gpu负责并行处理。本发明提出了一种基于cpu和gpu协同处理的全色和多光谱影像实时融合方法,其具体步骤包括:

[0059]

s101,通过有理函数模型计算全色影像和多光谱影像的重叠区域;

[0060]

通过有理函数模型rfm确定全色影像与多光谱影像各自的物方坐标,物方坐标表达式为(b,l,h),其包括大地纬度b、大地经度l、大地高h,h为平均的大地高程。

[0061]

对物方坐标进行归一化处理,得到归一化后的物方坐标(u,v,w),其计算公式为:

[0062][0063]

其中,lonoff,latoff,heioff分别为物方坐标(b,l,h)的平移值,lonscale,latscale,heiscale分别为物方坐标(b,l,h)的缩放值。

[0064]

对于每一景影像,归一化后的物方坐标(u,v,w)与像方坐标(s

n

,l

n

)的关系用多项式比值形式表示为:

[0065][0066]

其中,等号右边的多项式分子、分母的表达式分别为:

[0067]

num

l

(u,v,w)=a1 a2v a3u a4w a5vu a6vw a7uw a8v2 a9u2 a

10

w2 a

11

vuw a

12

v3 a

13

vu2 a

14

vw2 a

15

v2u a

16

u3 a

17

uw2 a

18

v2w a

19

u2w a

20

w3,

[0068]

den

l

(u,v,w)=b1 b2v b3u b4w b5vu b6vw b7uw b8v2 b9u2 b

10

w2 b

11

vuw b

12

v3 b

13

vu2 b

14

vw2 b

15

v2u b

16

u3 b

17

uw2 b

18

v2w b

19

u2w b

20

w3,

[0069]

num

s

(u,v,w)=c1 c2v c3u c4w c5vu c6vw c7uw c8v2 c9u2 c

10

w2 c

11

vuw c

12

v3 c

13

vu2 c

14

vw2 c

15

v2u c

16

u3 c

17

uw2 c

18

v2w c

19

u2w c

20

w3,

[0070]

den

s

(u,v,w)=d1 d2v d3u d4w d5vu d6vw d7uw d8v2 d9u2 d

10

w2 d

11

vuw d

12

v3 d

13

vu2 d

14

vw2 d

15

v2u d

16

u3 d

17

uw2 d

18

v2w d

19

u2w d

20

w3,

[0071]

其中,a

i

,b

i

,c

i

,d

i

,i=1,2,

…

,20,为有理多项式系数(rational polynomial coefficients,rpcs)。一般情况下,b1,d1均取值为1。

[0072]

得到全色影像与多光谱影像的地理范围之后,计算出全色影像与多光谱影像的重叠区域的地理范围,并且分别将两张影像各自重叠区域的地理范围通过rfm模型,得到其在各自影像的像方坐标系下的坐标值。

[0073]

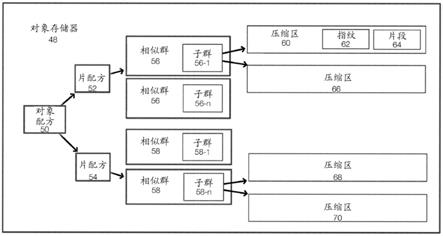

s102,读取全色影像与多光谱影像的重叠区域中的全色影像,并且以其为基准,通过gpu对多光谱影像进行虚拟化,得到虚拟化后的多光谱影像,即虚拟影像;图2为全色多光谱的原始影像和虚拟影像坐标映射流程图。

[0074]

将步骤s101中计算得到的全色影像与多光谱影像的重叠区域中的全色影像读入cpu内存当中,以该重叠区域中的全色影像为基准,通过gpu对多光谱影像进行虚拟化,其具体步骤包括:

[0075]

s1021,以全色影像的像方坐标为基准,将虚拟影像划分为均匀的规则格网,并且计算每个格网的四个角点的像方坐标;

[0076]

s1022,对虚拟影像的每个格网的四个角点的像方坐标(s,l),通过rfm模型计算其对应的物方坐标;

[0077]

s1023,对虚拟影像的每个格网的四个角点的物方坐标,通过rfm模型计算多光谱影像中对应点的像方坐标(s',l');

[0078]

s1024,利用虚拟影像每个格网的四个角点的像方坐标,构建虚拟影像像方坐标与

多光谱影像像方坐标的变换模型g(),其变换过程表示为(s,l)=g(s',l'),该变换模型g()采用线性变换模型、仿射变换模型或透视变换模型中的一种,本发明从精度和效率的角度,优先考虑选用透视变换模型。

[0079]

s1025,对虚拟影像像素进行重采样;前面所述的步骤已经完成了原始影像与虚拟影像坐标的映射工作,后续将要进行像素的重采样工作,值的一提的是像素重采样是天然并行的工作,为了提高效率,加快处理速度,将虚拟影像像素重采样的过程映射到gpu进行处理,将gpu计算过程中的每一个cuda线程设置为仅对一个像素进行计算。具体来说,将虚拟影像上的每个像素点的坐标通过变换模型g(),计算得到多光谱影像上的像素点坐标,并且选用最近邻近采样、双线性采样或双三次重采样方法中的一种,本发明从精度和效率的角度考虑优先选用双线性重采样,每次同时处理的像素数即可由不同的gpu的性能所决定。

[0080]

s103,将虚拟化后的多光谱影像转成虚拟全色影像,通过gpu将虚拟全色影像与真实的全色影像进行格网点匹配,得到同名网格点;

[0081]

通过步骤s102计算即可在内存中得到全色影像与多光谱的虚拟影像,在步骤s103中,为了更好地与全色影像计算同名点,首先将虚拟化后的多光谱影像中的每个像素转换成与全色影像光学特性一致的虚拟全色单一波段像素,该过程表示为:

[0082]

mss

p

=e1*band

b

e2*band

g

e3*band

r

e4*band

nir

,

[0083]

上式中,mss

p

为转换后的与全色影像光学特性一致的虚拟全色单一波段像素值,e1、e2、e3、e4分别为蓝光波段b、绿光波段g、红光波段r、近红外波段nir对应的波段范围占全色波段范围的比例,该比例可由传感器的设计参数得到,band

b

、band

g

、band

r

、band

nir

分别代表多光谱虚拟影像中的蓝光波段、绿光波段、红光波段以及近红外波段影像的像素值。

[0084]

提取全色影像与虚拟全色影像的同名点,该同名点作为多光谱虚拟影像进行数字微分纠正的输入。所述的提取全色影像与虚拟全色影像的同名点,采用相关系数法,以全色影像与虚拟全色影像的相关系数作为影像匹配的匹配测度,在指定的影像搜索范围中计算相关系数,而后选取相关系数最大的点作为同名点,相关系数是标准化的协方差函数,可以克服灰度的线性变形,保持相关系数的不变性,是影像匹配中最常使用的匹配测度。

[0085]

选择m波段的全色影像上的某一像素点为初值点,以该初值点为中心,建立m

×

n个像素的匹配窗口,并在n波段的虚拟全色影像上建立与m波段的全色影像的初值点上同样大小和形状的匹配窗口,计算两个匹配窗口的相关系数,其计算公式为:

[0086][0087]

其中,r(c,r)表示两个匹配窗口在行和列上的坐标差分别为c和r时的相关系数,m,n分别表示匹配窗口的行和列大小,i,j分别表示匹配窗口内的行序号和列序号,g

i,j

表示m波段的全色影像和n波段的虚拟全色影像的匹配窗口内第i行、第j列的灰度值,g

i r,j c

表示上述的两个影像的匹配窗口内第i r行、第j c列的灰度值,c,r分别是n波段的虚拟全色影像的匹配窗口对于m波段的全色影像的匹配窗口中的同名点在行、列上的坐标差。对于已经进行了格网点匹配处理的多光谱影像,取c=r=0;对于未进行格网点匹配的影像,c和r

的取值则根据相机的硬件参数值来确定。

[0088]

在全色影像上从设定的格网点中确定控制点,采用相关系数法,依次获取每个格网点在虚拟全色影像上的同名点。每个格网点的相关系数的计算可以并行进行,将相关系数的计算过程映射到gpu上进行,gpu上的每个线程块对应一个格网点,线程块中的每个线程实现一组相关系数的计算,每个线程块计算完毕之后获取相关系数最大的同名点,并且利用抛物线法对相关系数最大的同名点相邻的四个点进行拟合,得到该相关系数最大的同名点的亚像素值。

[0089]

s104,获取同名格网点之后,通过gpu对多光谱虚拟影像进行数字微分纠正,得到数字微分纠正后的多光谱影像;

[0090]

对多光谱虚拟影像进行数字微分纠正,多光谱虚拟影像中的每个格网包括四组同名点,数字微分纠正过程f(x',y')的数学表达式为:

[0091][0092]

式中,(x,y)为所述的同名点在数字微分纠正前的像方坐标,(x',y')为所述的同名点在数字微分纠正后的像方坐标,g1、f1、g2、f2、g3、f3、g4、f4分别为数字微分纠正过程的8个变换系数,该8个变换系数通过对4组同名点联合建立的8个数字微分纠正过程方程进行解算得到。分别解算每个格网的变换系数,从而对多光谱虚拟影像进行数字微分纠正,再进行最近邻近采样、双线性采样或双三次重采样。将数字微分纠正的过程映射到gpu进行处理,将gpu计算过程中的每一个cuda线程设置为仅对一个像素进行计算。具体来说,将多光谱虚拟影像上的每个点坐标(x,y)通过变换模型f(x

′

,y

′

)得到多光谱上的像素坐标(x

′

,y

′

),并且,每次同时处理的效率与像素数即可由不同的gpu的性能所决定。

[0093]

s105,对数字微分纠正后的多光谱影像以及全色影像进行快速融合,得到最终的融合结果。

[0094]

所述的步骤s105,通过两种方式实施,一是利用基于多尺度的sfim模型的融合算法(mssfim)实现,二是利用基于全色光谱分解的影像融合方法(psd)实现。

[0095]

所述的基于多尺度的sfim模型的融合算法,是基于多尺度原理与sfim模型的影像融合算法;改善了原始sfim模型中图像清晰度不佳的劣势,同时保留了其色彩偏差小的优点。sfim模型的融合过程表示为,

[0096][0097]

其中,ms是多光谱影像的像素值,pan是全色影像的像素值,pan

′

是低分辨率全色影像像素值,fusion是融合结果。pan和pan

′

的比值只保留了高分辨率图像的边缘细节信息,而基本消除了光谱与对比度信息。sfim模型可以被视为是在低分辨率图像中添加了高分辨率细节,其融合结果与高分辨率图像的光谱差异无关。

[0098]

但是,sfim模型虽然有较好的色彩保持能力,但是清晰度不佳,图像呈现发虚状态。为此,对全色影像利用高斯金字塔方法,生成不同尺度的低分辨率全色影像,并向sfim模型得到的融合影像中添加不同清晰程度的高频信息,以增强融合后的图像的清晰度。

[0099]

所述的基于全色光谱分解的影像融合方法,利用了同时拍摄的全色影像与多光谱

影像之间的强相关性,通过线性变换加残差消减的方式将全色影像像元亮度值dn分解为多光谱影像波段像元亮度值dn,再利用比值变换法进行影像融合。同时相的全色与多光谱影像之间存在很强的相关性,在比值变换法中,全色影像与所生成不同尺度的低分辨率全色影像的像素值比值等于融合图像与低质量多光谱影像的像素值的比值,即:

[0100][0101]

其中,pan

hq

为高质量全色影像,即原始全色影像,pan

hq

(i,j)表示原始全色影像的第i行、第j列像素点的像素值;pan

lq

为所生成不同尺度的低质量全色影像,pan

lq

(i,j)表示所生成不同尺度的低质量全色影像的第i行、第j列像素点的像素值;为理想的高质量多光谱影像,即融合图像,表示融合图像的g波段图像第i行、第j列像素点的像素值;为低质量多光谱影像,其通过对原始多光谱影像进行采样得到,表示低质量多光谱影像的g波段图像第i行、第j列像素点的像素值;i,j,g分别是行、列、波段的序号。比值变换法将相同的高频信息重复地添加入不同的波段,这是造成融合图像光谱畸变的重要原因。上式成立的基础是全色影像的每个像素与其对应质量的多光谱影像像素都具有无偏置的线性关系,即:

[0102]

pan(i,j)=k

(g)

*ms

(g)

(i,j),

[0103]

其中,k

(g)

为第g波段对应的比例系数。该前提在实际中并非完全符合,全色影像与多光谱影像具有一定的发散性。即,全色影像与多光谱影像之间的数学关系描述为:

[0104]

pan=k

(g)

ms

(g)

b

(g)

t ε

(g)

,

[0105]

其中,b

(g)

是多光谱影像第g波段对应的偏置系数,k

(g)

为多光谱影像第g波段对应的比例系数,t为维度与pan相同、且其元素都为1的矩阵,e

(g)

是多光谱影像第g波段对应的残差矩阵。通过低分辨率的全色多光谱影像拟合得到比例系数、偏置系数及残差矩阵,并利用这些系数得到融合的高分辨率全色影像,可以获得效果更好的融合影像。

[0106]

以上所述仅为本技术的实施例而已,并不用于限制本技术。对于本领域技术人员来说,本技术可以有各种更改和变化。凡在本技术的精神和原理之内所作的任何修改、等同替换、改进等,均应包含在本技术的权利要求范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。