1.本发明涉及教育技术领域,尤其是涉及一种基于深度学习的课堂教学质量复盘控制方法。

背景技术:

2.现有基于视频的教学质量评估系统在智能时代发展很迅速,一般使用图像处理中的姿态识别算法对授课视频进行处理,从而进行教师课堂行为分析、学生课堂行为分析、学生考勤分析。通过这些基本的分析进一步得到教师的信息、板书时长占比、教师课堂提问总次数、学生课堂举手总次数、学生出勤信息,从而帮助教师对教学质量进行辅助评估。但是目前的教学质量评估系统存在以下问题:

3.一、现有技术中由于视频采样时密集抽帧会产生大量的图片数据,再加上传统图像处理算法处理速度有限,导致现有技术在使用中速度慢且花费很高的计算资源;

4.二、现有技术中巨大时间成本的消耗使教师不能及时得到教学的反馈,从而丧失了本技术所需解决问题的部分价值;

5.三、现有技术中给出的评估数据都是离散的统计数据,只能让教师对自己整体的课程教学质量有个大致把握,不能让教师明确具体哪种教学方式能明显提高课堂的活跃度。

技术实现要素:

6.本发明的目的就是为了克服上述现有技术存在的缺陷而提供一种基于深度学习的课堂教学质量复盘控制方法,使教师可以直接定位到课堂教学质量高的时间段,查看自己的教学状态,从而更好的指导教师了解具体的教学方式对教学质量的影响,复盘自己的教学方法,更好的提高教学能力。

7.本发明的目的可以通过以下技术方案来实现:

8.一种基于深度学习的课堂教学质量复盘控制方法,具体包括以下步骤:

9.s1、通过基于时间片的视频采样方式,抽取固定时间段的图像信息和音频信息作为基本单元;

10.s2、所述基本单元输入课堂教学检测模型,输出学生的面部表情信息、肢体动作信息和语言情感信息;

11.s3、所述面部表情信息、肢体动作信息和语言情感信息输入教学活跃度评价模型,输出评价结果,根据所述评价结果,通过滑动窗口技术计算得到课堂教学热点图。

12.所述步骤s1中在图像信息中抽取起始帧、中位帧以及结束帧作为对应基本单元的图像样本,在音频信息中抽取预设时段的音频信息作为对应基本单元的音频样本。

13.进一步地,所述基本单元中的图像样本与基本单元音频样本进行组合,以时间信息作为索引,使用coco数据集格式制作完整的数据集。

14.所述肢体动作信息包括头部动作信息和手臂动作信息。

15.所述课堂教学检测模型包括基于图像的任务对象辨认模型、基于图像的图像区分模型、基于图像的面部表情辨别模型以及基于音频的情感分析模型。

16.所述基于图像的任务对象辨认模型采用基于课堂环境改进的yolo v3模型,采用较小的3个超参数作为先验框参数。

17.进一步地,所述基于图像的任务对象辨认模型将一个基本单元中的图像样本中人的位置全部标记出来,供后续模型使用。

18.所述基于图像的图像区分模型采用深度学习cnn分类网络,采用sigmoid作为cnn分类网络中输出层的激活函数。

19.所述基于图像的面部表情辨别模型采用多分类面部表情辨别深度学习模型。

20.进一步地,所述多分类面部表情辨别深度学习模型采集的表情类型包括生气、消沉、害怕、开心、悲伤、惊讶和紧张,。

21.进一步地,所述多分类面部表情辨别深度学习模型根据采集的表情进行聚类,聚类的结果对应的学生的状态包括学习认真状态、学习无关状态和学习消极状态。

22.所述基于音频的情感分析模型包括第一层分析和第二层分析。

23.进一步地,所述第一层分析保留高频人声信号,所述第二层分析首先将音频信息通过语音辨认转换成文本信息,转换过后的文本信息通过one

‑

hot编码,转换成神经网络可以处理的数据结构,再通过循环神经网络从左到右逐词学习文本的含义,完成对情绪的分类,情绪的分类包括正向、负向和其他。

24.进一步地,基于音频的情感分析模型将第一层分析的结果作为权重信息,来对第二次分析的结果进行加权分析,从而参与到最终的教学活跃度评价模型中。

25.与现有技术相比,本发明具有以下有益效果:

26.1.本发明使用基于时间片的连续采样方式,通过时间把图像信号和音频信号结合起来,获得更多可以发掘的信息,同时每个时间片使用3帧来代表整个时间片的状态,大大降低了后续图像处理的数据量。

27.2.本发明通过使用适应课堂教学环境的改进yolo

‑

v3深度学习任务对象辨认模型,提前聚类出更适合小任务对象辨认的超参数,更加适应课堂中小任务对象辨认的需求,与现有技术相比检测速度提升了一个数量级,可进行迁移学习,降低了本发明扩展使用的难度。

28.3.本发明通过使用更适配较短自然语言文本的循环神经网络,降低了神经网络的模型复杂度,降低了模型的训练难度,节约了训练与预测的时间,使教师能够在较短时间内,以接近于实时的体验快速复盘自己的教学过程。

29.4.本发明通过滑动窗口技术把离散的课堂评估数据基于时间轴平滑为连续的信息,得到课堂教学热点图,提供了一种全新的教学质量评估与指导模式,更直观的指导教师复盘教学过程。

附图说明

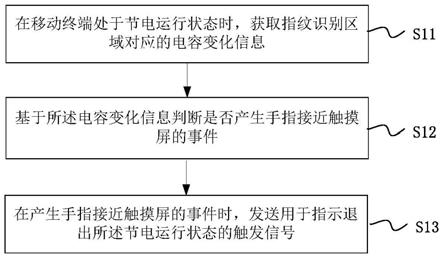

30.图1为本发明的流程示意图;

31.图2为本发明实施例中教学活跃度评价模型的框架示意图。

具体实施方式

32.下面结合附图和具体实施例对本发明进行详细说明。本实施例以本发明技术方案为前提进行实施,给出了详细的实施方式和具体的操作过程,但本发明的保护范围不限于下述的实施例。

33.实施例

34.如图1所示,一种基于深度学习的课堂教学质量复盘控制方法,具体包括以下步骤:

35.s1、通过基于时间片的视频采样方式,抽取固定时间段的图像信息和音频信息作为基本单元;

36.s2、基本单元输入课堂教学检测模型,输出学生的面部表情信息、肢体动作信息和语言情感信息;

37.s3、面部表情信息、肢体动作信息和语言情感信息输入教学活跃度评价模型,输出评价结果,根据评价结果,通过滑动窗口技术计算得到课堂教学热点图。

38.步骤s1中在图像信息中抽取起始帧、中位帧以及结束帧作为对应基本单元的图像样本,在音频信息中抽取完整1秒的音频信息作为对应基本单元的音频样本。

39.基本单元中的图像样本与基本单元音频样本进行组合,以时间信息作为索引,使用coco数据集格式制作完整的数据集。

40.本实施例中,将教学视频以每2.5秒作为一个时间片进行等距分割,作为一个基本的数据集单元,每个长度为2.5秒的基本视频单元中,随机采样三分之一的连续视频,将图像信号和音频信号拆分。

41.肢体动作信息包括头部动作信息和手臂动作信息。

42.课堂教学检测模型包括基于图像的任务对象辨认模型、基于图像的图像区分模型、基于图像的面部表情辨别模型以及基于音频的情感分析模型。

43.基于图像的任务对象辨认模型采用基于课堂环境改进的yolo v3模型,采用较小的3个超参数作为先验框参数,有利于加快运算速度。

44.本实施例中,基于图像的任务对象辨认模型使用resnet作为骨干网络,提取图片特征,得到3层不同尺寸的特征图,有利于检测不同尺度上的目标,提高检测的精度。

45.基于图像的任务对象辨认模型将一个基本单元中的图像样本中人的位置全部标记出来,供后续模型使用。

46.基于图像的图像区分模型采用深度学习cnn分类网络,采用sigmoid作为cnn分类网络中输出层的激活函数,把复杂的人脸辨认中人脸特征点提取的问题简化成多个二分类问题,大大降低了神经网络的预测时间和神经网络的训练复杂度。拆解后的二分类问题主要关注是否抬头和是否手臂放在课桌上,这为后续的教学评估模型提供底层数据支撑。基于图像的面部表情辨别模型是在检测到抬头的基础上工作的,这样减少了对不抬头学生进行面部表情辨别的不必要计算,节约了计算资源,减少了模型的运算时间。

47.基于图像的面部表情辨别模型采用多分类面部表情辨别深度学习模型。

48.多分类面部表情辨别深度学习模型采集的表情类型包括生气、消沉、害怕、开心、悲伤、惊讶和紧张,。

49.多分类面部表情辨别深度学习模型根据采集的表情进行聚类,聚类的结果对应的

学生的状态包括学习认真状态、学习无关状态和学习消极状态。

50.基于音频的情感分析模型包括第一层分析和第二层分析。

51.第一层分析保留高频人声信号,第二层分析首先将音频信息通过语音辨认转换成文本信息,转换过后的文本信息通过one

‑

hot编码,转换成神经网络可以处理的数据结构,再通过循环神经网络从左到右逐词学习文本的含义,完成对情绪的分类,情绪的分类包括正向、负向和其他。

52.循环神经网络保证了本发明计算资源占用少,运行时间花费短的特点。

53.基于音频的情感分析模型将第一层分析的结果作为权重信息,来对第二次分析的结果进行加权分析,从而参与到最终的教学活跃度评价模型中。

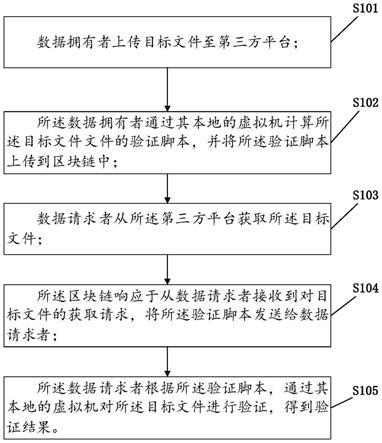

54.如图2所示,具体实施时,教学活跃度评价模型主要进行以下步骤:

55.s301、通过基于音频的情感分析模型第一层分析,得到当前课堂活跃状态权重x,权重x是一个在0.5到1区间内的浮点数,数值由模型根据状态给出;

56.s302、通过基于音频的情感分析模型第二层的分析,得到当前课堂整体情绪情况权重y,权重y是一个在0.5到1区间内的浮点数,数值由模型根据状态给出;

57.s303、通过基于音频的情感分析模型第二层的分析,获取教师是否在授课的状态,授课状态标记为m,非授课状态标记为n;

58.s304、通过基于图像的任务对象辨认模型得到的图像信息,每个基础单元内得到k张包含独立人体的图像信息;

59.s305、基于图像的图像区分模型会对每张独立人体图像信息进行分析,通过基于图像的图像区分模型得到的结果,判断本学生个体是否抬头以及是否出现手臂放在桌面姿态,通过状态组合,共产生四种状态,包括学生不抬头不出现手臂,标记为状态a;学生不抬头出现手臂,标记为状态b;学生抬头不出现手臂,标记为状态c;学生抬头出现手臂,标记为状态d;

60.s306、基于图像的面部表情辨别模型会对每张具有抬头状态的独立人体图像进行分析,通过基于图像的面部表情辨别模型得到结果,判断学生的表情状态,共产生三种状态,包括学生认真,标记为状态e;学生消极,标记为状态f;学生无关状态,标记为状态g;

61.s307、构建一个k*11的矩阵用来存储状态信息,其中k行分别存储k个独立个体的数据,11列分别为浮点数x和y占依次占用两列;状态m和n为布尔型依次占用两列,其中1代表该状态为真;状态a、b、c和d为布尔型依次占用四列,其中1代表该状态为真;状态e、f和g为布尔型依次占用三列,其中1代表该状态为真;共计占用11列,若授课视频时间为t秒,则基本单元的数量s为:

[0062][0063]

完成所有的信息处理后,构建一个s*k*11的矩阵存储所有处理后的信息;

[0064]

s308、从存储的s*k*11的矩阵中依次取出k*11的矩阵,来计算该基本单元上课堂活跃状态,其中该状态为真时,状态权重分配如下表1所示:

[0065]

表1状态权重分配表

[0066]

状态m0.8状态n0.2

状态a

‑

4状态b

‑

1状态c1状态d2状态e3状态f2状态g1

[0067]

基本单元教学活跃度评分o(k)为:

[0068][0069]

其中基本单元教学基础权重p(k)为:

[0070]

p(k)=x

k

*y

k

*(0.8*m

k

0.2*n

k

)

[0071]

完成所有的基本单元教学活跃度评分计算后,将结果存储在长度为s的一维数组中以供后续使用。

[0072]

步骤s3中计算课堂教学热点图具体包括以下步骤:

[0073]

s309、取出步骤s308中长度为s的一维数组的全部内容,找到其中最大致smax以及最小值smin,对s数组中所有数值进行归一化处理,完成归一化后进行10分制处理;

[0074]

s310、取间隔为3步长为2的滑动窗口,滑动窗口取到的数据分别标记为a1、a2、a3和a4,根据短时间内课堂活跃度很少发生突变的情况,使用滑动窗口对s中的数值进行平滑处理,滤除一些不合理的波动;

[0075]

s311、取出步骤s310中处理好的数据,根据索引与原视频时间轴对比进行还原处理,以转换后的时间轴索引作为x轴,以s一维数组作为y轴,做出图像曲线,将生成的图像曲线拟合到实际的教学视频的时间轴上,形成视频热点图。

[0076]

本发明通过基于时间片的连续采样,将音频信息通过时间与视频信息关联处理通过深度学习模型使用较低的时间成本和计算成本检测出的学生动作和情绪状态。通过教育学中课堂质量评估模型基于时间联系进行加权打分,从而得到基于时间轴的教学活跃度热点图。教师可以直接根据本技术生成的教学视频热点图直接定位到课堂教学质量高的时间段,查看自己的教学状态,从而更好的指导教师了解具体的教学方式对教学质量的影响,复盘自己的教学方法,更好的提高自己的教学能力。

[0077]

此外,需要说明的是,本说明书中所描述的具体实施例,所取名称可以不同,本说明书中所描述的以上内容仅仅是对本发明结构所做的举例说明。凡依据本发明构思的构造、特征及原理所做的等效变化或者简单变化,均包括于本发明的保护范围内。本发明所属技术领域的技术人员可以对所描述的具体实例做各种各样的修改或补充或采用类似的方法,只要不偏离本发明的结构或者超越本权利要求书所定义的范围,均应属于本发明的保护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。