1.本发明涉及的是一种交通声音识别处理领域的技术,具体是一种基于深度学习交通场景声音分类的方法及系统。

背景技术:

2.现有的声音分类技术采用计算声压级、频谱特征、mfcc特征等作为声音分类的依据,通常对声音信号要求较高,分类结果的准确率及召回率受使用场景影响较大。随着智能交通技术的发展和人们对交通管理需求的不断提高,以视频为核心的监控系统被广泛应用在了许多交通场景中,并且在交通管理、安防等应用中发挥了很关键的作用。

3.但现有的监控系统绝大部分仍然以视频监控为主,仅有部分监控系统具有声音监控的功能,但对声音的处理也仅限于存储和回放,并没有对声音信息加以利用,缺乏对声音事件的判断,将声音分类技术与视频监控技术结合,丰富监控信息维度是十分有必要的。对于目前出现的机动车违法鸣笛抓拍系统等,虽然该系统结合声音监控与视频监控,但是在声音分类方面仍然使用传统方法,并且通常只处理一类声音,对声音的处理上不具备声音分类的能力,在实际使中对声音的判决存在许多误判,直接导致了抓拍系统误抓误报,不利于交通管理人员执法。

技术实现要素:

4.本发明针对现有技术的缺陷,提出一种基于深度学习技术的交通场景声音分类方法及系统。

5.本发明是通过以下技术方案实现的:

6.本发明涉及一种基于深度学习技术的交通场景声音分类方法,通过声音采集装置实时获取并筛选声音信号后,从声音信号中提取信号时频特征并使用经训练的深度学习模型进行分析得到预测分类矩阵;经转换得到包括声音信号中所出现的所有声音事件类别及其对应发生的时间区间的置信度矩阵。

7.所述的筛选是指:为对声音信号进行小波包分解,计算低频部分小波包能量的占比,当低频部分小波包能量占比达到所设定的阈值,则进行后续计算分类,否则输出缺省计算结果。

8.所述的时频特征是指:对声音信号按照是指:定长度进行切片,对每段声音信号做归一化处理,声音信号经过归一化处理后再进行短时傅里叶变换,计算结果即声音信号的时频特征。

9.所述的深度学习模型的训练样本为多组带有标记的声音数据,该深度学习模型包括:特征输入层、三个卷积层、三个池化层、两个rnn层以及两个全连接输出层,其中:第二全连接输出层输出时频特征的预测分类矩阵。

10.所述的转换是指:使用sigmoid函数作为目标函数将深度学习模型输出的预测分类矩阵转化为置信度矩阵,其代表声音信号所在的时间区间t内各类声音在所有

时刻的置信度,置信度矩阵中每一行代表对一种分类的预测,通过设置阈值判定该预测值所在时刻是否发生该类声音事件。

11.所述的带有标记的声音数据包括:声音信号和声音信号标注结果,其中:标注结果包括声音的类别、每类声音发生的时间区间。

12.所述的深度学习训练是指:使用多组带有标签的声音数据按照有监督方法进行训练,训练迭代过程中使用交叉熵(cross-entropy)函数作为训练损失函数,具体为:h(p,q)=-∑

x

(p(x)logq(x) (1-p(x))log))),其中:p为期望输出,q为实际训练输出。

13.本发明涉及一种实现上述方法的监控识别系统,包括:多媒体监测单元、高分辨率图像采集单元、控制单元和执行单元,其中:多媒体监测单元实时采集监控区域内的声音信号、低分辨率视频图像和计算声压云图,并将声音信号、低分辨率视频图像、声音云图及敏感声音坐标输出至控制单元;高分辨率图像采集单元实时采集监控区域图像并以视频流的形式将图像数据输出至控制单元;控制单元使用深度学习模型对声音信号进行分析,判断声音信号中是否存在敏感声音事件,根据声压云图、敏感声源坐标、高清视频流及声音事件分类结果得到发出敏感声音事件的目标车辆;控制单元进一步通过图像匹配,将敏感声源坐标匹配至高分辨率图像上,当高分辨率图像中的坐标与高清图像中识别出的车辆重合时,即得出目标车辆在高清图像中的位置,获得捕获目标车辆的高分辨图像并识别出目标车辆的号牌,最终将声音、图像数据和相关捕获信息作为证据链通过控制单元进行格式化存储,通过执行单元进行展示和上报。

14.所述的多媒体监测单元包括:数字信号采集模块、低分辨摄像头和麦克风阵列,其中:多媒体监测单元的声源坐标与低分辨率摄像头采集图像坐标,通过预先设计的参数进行匹配。

15.所述的声压云图通过多媒体监测单元对采集到的声音信号计算得出,声压云图与多媒体监测单元的低分辨率图像匹配,可得出发出敏感声音目标在低分辨率图像中的位置。

16.所述的图像匹配是指:控制单元自动采集一帧来自多媒体监测单元的低分辨率图像和一帧来自高清视频流的图像,自动选取两幅图像中至少5个对应特征点,计算获取从低分辨率图像到高分辨率图像的坐标映射关系。

17.所述的控制单元为基于gpu的嵌入式处理模块设备,具备运算深度学习模型的功能,其具体包括:数据接收模块、视频编解码模块、gpu计算模块及数据识别模块,其中:数据接收模块与多媒体监测单元和高分辨率图像采集单元连接,接收并缓存声音信号、低分辨率视频图像、声音云图、敏感声音坐标和高分辨率视频流数据;视频编解码模块与数据接收模块连接,将高分辨率视频流解码为图像数据,图像数据输出到数据识别模块;gpu计算模块与数据接收模块相连,利用深度学习模型处理声音信号,将处理得出的声音事件分类结果传输到数据识别模块;数据识别模块与数据接收模块、视频编解码模块、gpu计算模块相连,利用声音云图、敏感声音坐标、图片数据及声音事件分类结果进行识别,结合声音云图,计算出产生目标声音事件的目标车辆在高清图像中的位置,匹配出目标车辆的高清图像,识别目标车辆的号牌信息。

18.所述的执行单元对证据进行展示和上报,展示可以为将目标车辆的号牌展示到led显示屏上,上报可以为将声音、图像及捕获信息输出至监控平台。

技术效果

19.本发明整体解决了现有的声音分类技术声音分类准确率较低,对特征类似的声音区分能力不强的问题。与现有技术相比,本发明利用深度学习训练模型分析声音信号,可准确地获取声音事件类别和各类声音事件发生的时间进行分析,显著提高与声音判别有关的监控抓拍系统的准确率及捕获率,对交通场景的声音进行分类具有更高的准确率、具备多类别声音分类的能力,有效的减少监控识别系统的误报。

附图说明

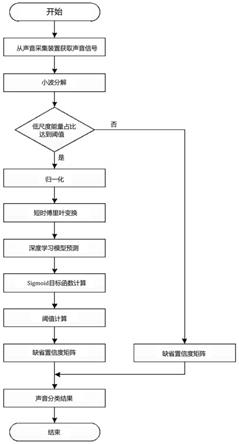

20.图1为本发明声音分类方法流程图;

21.图2本发明深度学习网络结构图;

22.图3为本发明基于深度学习交通场景声音分类的监控识别系统结构示意图;

23.图4为本发明基于深度学习交通场景声音分类的监控识别系统工作流程图;

24.图5实施例效果示意图。

具体实施方式

25.如图1所示,为本实施例涉及一种基于深度学习的交通场景声音分类方法,从声音采集装置实时获取声音信号,对声音信号进行筛选,对声音信号进行归一化和计算短时傅里叶变换得出声音特征,使用预先训练的深度学习模型对声音特征进行分析,深度学习模型中将输出声音特征的预测分类矩阵,使用目标函数将预测分类矩阵转化为置信度矩阵,再通过设置阈值确定该段声音信号中所出现的所有声音事件类别及声音事件发生的时间区间,具体步骤如下:

26.步骤1)将从声音采集装置中获取的实时声音信号进行筛选,使用小波包分解声音信号,使用db4小波作为分析小波,计算低频部分小波包能量的占比,当低频部分能量占比达到所设定的阈值,则进行后续计算分类,否则过滤当前信号,输出缺省置信度矩阵。

27.步骤2)将从声音采集装置中获取的实时声音信号进行归一化,具体为其中x为声音序列,x

min

为声音序列中的最小值,x

max

为声音序列中的最大值。

28.步骤3)将归一化后的声音信号使用短时傅里叶变换,设置每次计算的点数为1024,重叠点数为512,计算结果即声音特征。

29.步骤4)加载深度学习模型,将声音特征输入到模型中计算得出预测分类矩阵,再将预测分类矩阵使用目标函数sigmoid函数计算得出置信度矩阵,sigmoid函数具体为

30.步骤5)将置信度矩阵与阈值做比较,即可得出某类声音,具体为,取置信度矩阵中的某一行,例如该行代表机动车轰鸣声音的预测向量,当该向量中存在大于阈值的点,则说明在大于阈值的点的所在位置发生了机动车轰鸣声音事件,该点所在位置为机动车轰鸣事件发生的时刻,对置信度矩阵中所有行做相同处理即可分析出所有可预测分类的发生时间区间。

31.如图2所示,为所述的深度学习模型的网络结构,包括输入层、三个卷积层、三个池化层、两个rnn层以及两个全连接输出层。

32.步骤4)中所述的深度学习模型,通过以下方式进行训练:

33.4.1)制作带有标记的声音数据,具体为标记声音信号中出现的类别和每类声音出现的时间范围,声音类别包括:机动车鸣笛、机动车轰鸣、警笛声、音乐、人声等,标记后将标记信息保存为文本格式存储。

34.4.2)深度学习训练迭代过程中使用交叉熵(cross-entropy)函数作为训练损失函数,具体为:h(p,q)=-∑

x

(p(x)logq(x) (1-p(x))log))),其中p为期望输出,q为实际训练输出。

35.4.3)深度学习训练使用开源深度学习框架完成,具体为使用开源深度学习框架搭建深度学习网络,将带有标记的声音数据按批次输入到深度学习模型中,将深度学习模型输出值使用损失函数进行计算,并循环迭代,当损失函数输出值达到最小时,停止迭代,保存深度学习模型,结束训练。

36.如图3所示,为实现上述方法的实现系统,包括:多媒体监测单元、高清摄像机、控制单元和执行单元,其中:控制单元为具有gpu的嵌入式处理模块,具有运算深度学习模型的能力,执行单元包括现场led显示屏等。

37.如图4所示,为基于上述系统的取证流程,具体为:多媒体监测单元实时采集监控道路区域内的声音信号、低分辨率视频图像及计算声压云图;高清摄像机实时采集监控道路区域的高清图像和视频流数据;多媒体监测单元及高清摄像机产生的数据均实时发送到控制单元上;控制单元接收到多媒体监测单元的声音信号后,使用深度学习模型实时分析声音信号;当声音信号中存在违规声音事件,如机动车鸣笛、机动车轰鸣等,则控制单元结合多媒体监测单元的声压云图得出发出敏感声音事件的目标车辆在低分辨率图像中的坐标,通过图像匹配,将低分辨图像中的坐标映射到高清摄像机拍摄的高清图像中,当坐标与高清图像中识别出的某个车辆重合,即可得出目标车辆在高清图像中的位置,进而可得到目标车辆的高清图像,再识别目标车辆的号牌信息,完成目标车辆捕获;控制单元将捕获到的目标车辆信息及其发生违规事件时的声音、图像数据作为证据链进行存储,并通过4g模块或专用网路上报到管理执法平台;执行单元将目标车辆信息进行展示,如将目标车辆的号牌使用led显示屏展示。

38.本实施例中多媒体监测单元与高清摄像机安装在电警杆上,控制模块及网路连接设备放置在电箱中,电箱固定在电警杆上,led显示屏固定在电警杆上。

39.步骤4中使用深度学习模型获取声音信号的声音事件的置信度矩阵及以置信度矩阵的形式表示声音事件为本发明独创,与现有技术不同的是:现有技术对声音分类只输出类别,本发明以置信度矩阵的形式能够表示出声音信号中各类声音事件的类别及发生的时间区间。

40.所述的置信度矩阵,为深度学习模型计算得出,具体计算方式为:声音信号为有12800个点的声音序列,经过步骤3得出声音特征,声音特征的维度为[268,67],声音特征经过深度学习模型各网络层计算的输出维度为:第一卷积层输出维度为[64,268,67]、第一池化层输出维度为[64,26,67]、第二卷积输出维度为[64,26,67]、第二池化层输出维度为[64,5,67]、第三卷积层输出维度为[64,5,67]、第三池化层输出维度为[64,1,67],此处交换输出维度次序为[1,64,67],第一rnn层输出维度为[1,128,67]、第二rnn层输出维度为[1,128,67]、第一全连接层输出维度为[1,4n,67]、第二全连接层输出维度为[1,n,67],使

用sigmoid函数计算输出维度为[1,n,67],将输出维度降至二维即[n,67],该矩阵即置信度矩阵,在本实施例中n为5。

[0041]

经过具体实际实验,在交通道路场景中,如图5所示,机动车(图中救护车)发出警笛声,声音云图显示救护车为产生声音事件的目标车辆,控制单元使用深度学习模型分析声音信号,在分析出的置信度矩阵中发现目标车辆产生了警笛声音事件,警笛声音事件不在抓拍声音事件范围内,因此该笔数据不会产生抓拍。若抓拍系统未使用声音分类技术或使用传统方法判决,则会误将该笔数据判决为机动车鸣笛,产生误报。

[0042]

与现有技术相比,本发明可对多种声音进行分类,并能输出各个类别声音所发生的时间区间,且对特征类似的声音区分能力强,如区分机动车鸣笛声音与警笛声音。

[0043]

上述具体实施可由本领域技术人员在不背离本发明原理和宗旨的前提下以不同的方式对其进行局部调整,本发明的保护范围以权利要求书为准且不由上述具体实施所限,在其范围内的各个实现方案均受本发明之约束。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。