一种基于u型网络和音频指纹的音乐与人声分离方法

技术领域

1.本发明属于语音分离技术领域,具体涉及一种基于u型网络和音频指纹的音乐与人声分离方法。

背景技术:

2.在众多语音信号处理技术中,比较有代表性的技术有语音识别、语音合成以及语音分离,其中,语音分离是语音领域一个重要的研究方向。语音分离的任务是将目标语音与背景噪声分开。单通道语音分离近年来成为语音分离领域研究的热点。语音分离的传统方法有减谱法、自适应滤波器法以及维纳滤波器法等,这些方法比较简单,但是这些方法假设背景噪音是平稳的,如果不满足这个假设条件,那么往往无法得到理想的效果,尤其是当信噪比的值处于较低水平时,这些传统方法的表现较差。上述方法均为传统的信号处理的算法,除此之外还有一些其他的方法,比较有代表性的是基于模型的方法,这种方法是构建声源语音和带噪声语音的模型,并通过这个模型对带噪的语音信号进行分离,这类方法有非负矩阵分解、高斯混合模型、支持向量机等,在低信噪比的情况下可以得到效果比较好的分离信号,但是这种方法取决于已经构建好的各种声源的语音和其他噪声的关系模型,如果这个训练好的模型与需要分离带噪声的语音中的噪声和声源不匹配时,其性能往往会降低。其次,音频信号往往是一种非平稳的随时间变化的信号,具有非常明显的时间和空间结构,同时存在着很多非线性关系,但是这种层数比较浅的模型,由于模型内部的隐层数等条件的限制,很难在训练之中发现一些非线性的复杂关系。

3.随着深度学习的发展,深度神经网络被广泛应用于语音领域,例如语音合成、语音识别和语音增强等,并且取得了一些突破性的进展。深度学习的方法也可以在语音分离方面有所应用,而语音分离的任务在许多领域具有重大的用途,所以基于深度学习的语音分离是具有很大的研究价值的,同时也极具挑战。

4.音乐人声分离是语音分离中的一种,其研究将歌曲中的背景音乐各个部分以及人声进行分离。但是在现实情况下,由于一些条件的限制,单纯通过语音分离算法获得的模型不会获得非常纯净的语音。

技术实现要素:

5.本发明针对上述问题,提出了一种基于u型网络和音频指纹的音乐与人声分离方法,该方法考虑到背景音乐可以看作是加性噪声,可以通过音频检索技术找到背景音乐来自哪一首音乐的哪部分片段,进行适当调整,并将混合语音的信号减去调整后的检索出来的音乐片段,便有可能得到较为纯净的人声。同时,针对当前主流的音频检索是采用音频指纹技术,该方法对音频检索技术进行研究改进,并用于辅助语音分离,从而获得更好的音乐与人声分离效果。

6.本发明提供的一种基于u型网络和音频指纹的音乐与人声分离方法,包括如下步骤:

步骤1:将混合音频输入已经训练好的音乐人声分离模型,得到与人声分离的伴奏音频;步骤2:采用指纹提取算法提取出步骤1得到的伴奏音频中的音频指纹;步骤3:将步骤2得到的音频指纹送入音频指纹数据库中,检索出与所述指纹匹配的歌曲以及时间点offset;步骤4:将步骤3检索得到的匹配歌曲进行音量的调整,具体是计算步骤1得到的伴奏音频的平均音量,然后将检索得到的匹配歌曲的音量调至平均音量;步骤5:对匹配歌曲时间点offset前后一段时间内的音频进行采样,得到一段音频波形;步骤6:将所述音频波形与步骤1得到的伴奏音频的波形进行比较,进一步调整所述音频波形;步骤7:将所述混合音频减去步骤6调整后的音频波形,最终得到纯净的人声。

7.进一步的,所述音乐人声分离模型包括编码器、解码器以及起连接作用的中间层,所述音乐人声分离模型对混合音频进行分离得到伴奏音频的具体步骤包括:步骤11:对所述混合音频进行采样得到采样序列;步骤12:利用编码器对所述采样序列进行编码,提取所述采样序列的深层特征向量;步骤13:利用解码器对步骤12得到的深层特征向量进行解码,得到与人声分离的伴奏音频。

8.进一步的,所述编码器是一个时序卷积残差编码单元,由一个一维卷积层,一个非线性转换函数和第一残差模块组成,步骤12所述编码器对所述采样序列进行编码,提取所述采样序列的深层特征向量,具体为:步骤121:所述一维卷积层通过一组大小为k的一维卷积滤波器对所述采样序列进行卷积操作,获取局部特征向量;步骤122:利用所述非线性转换函数对所述局部特征向量进行转换,得到转换后的第二特征向量;步骤123:利用所述第一残差模块对第二特征向量进行深层特征提取,得到所述采样序列的深层特征向量。

9.进一步的,所述解码器是一个时序卷积残差解码单元,由一个一维反卷积层,一个非线性转换函数和第二残差模块组成,所述解码器对所述采样序列进行解码,实现音乐与人声的分离,具体为:步骤131:所述一维反卷积层通过一组大小为k的一维反卷积滤波器对编码器提取的深层特征向量进行反卷积操作,得到恢复后的原始特征向量;步骤132:利用所述非线性转换函数对步骤131恢复后的原始特征向量进行转换,得到第三特征向量;步骤133:利用所述第二残差模块对第三特征向量进一步恢复成分离的人声和伴奏音频。

10.进一步的,所述第一残差模块和所述第二残差模块结构相同,均包括一个批规范化层、一个非线性转换函数和一个一维卷积层,所述第一残差模块和所述第二残差模块的

实现步骤为:第1步:对输入数据经过所述批规范化层进行处理,得到第五特征向量;第2步:利用所述非线性转换函数对所述第五特征向量进行特征转换,得到第六特征向量;第3步:将所述第六特征向量经过一个一维卷积层或一维反卷积层得到第七特征向量;第4步:将所述第七特征向量与输入数据相加得到最后的输出特征向量。

11.进一步的,所述非线性转换函数为leakyrelu激活函数。

12.进一步的,步骤3中所述音频指纹数据库的搭建方法是提取所有原始音频的指纹进行入库操作,所述原始音频的指纹基于哈希值和时间值的组合,所述哈希值通过哈希函数作用于基点和目标点的频率以及两点之间时间差得到。

13.进一步的,步骤3中,“将步骤2得到的音频指纹送入音频指纹数据库中,检索出与所述指纹匹配的歌曲以及时间点offset”具体方法包括:s31:根据步骤2得到的音频指纹以及对应的第一时间计算指纹的哈希值;s32:将s31得到的哈希值与音频指纹数据库中的哈希值进行匹配,从音频指纹数据库中获得对应的音频id值和对应的第二时间,用第二时间减去第一时间得到一个时间差,然后将音频id值和时间差信息组合起来进行存储;s33:遍历步骤2得到的所有音频指纹进行s31—s32操作,得到音频id值和时间差信息组合的集合,对集合中的时间差信息进行统计,找到具有相同的时间差最多的音频id,即为匹配到的歌曲id。

14.现有的音乐与人声分离技术通常仅采用一个简单的音乐分离模型,无法得到纯净人声,本发明提供的一种基于u型网络和音频指纹的音乐与人声分离方法,在简单的音乐分离模型基础上进行改进,提供一种基于u型网络架构的音乐分离模型,同时,该方法在进行音乐分离模型后加入音频指纹检索再分离,所述再分离策略能有效提高语音分离效果,在分离效果差距较大的情况下引入检索再分离后,分离效果差距可以明显缩小,另外,基于音频指纹检索的音乐再分离策略具有很好鲁棒性。

附图说明

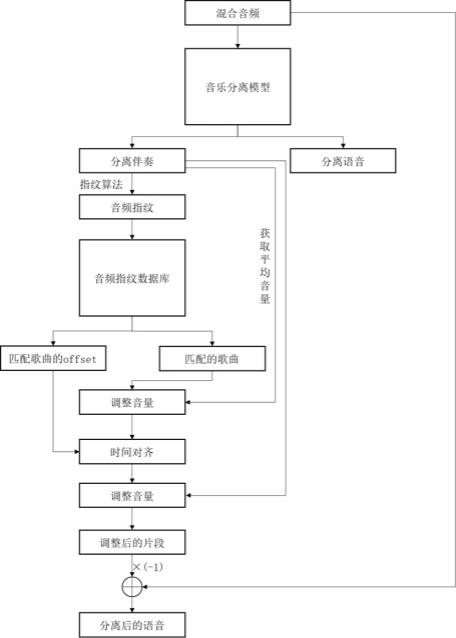

15.图1 为本发明方法的流程示意图;图2 为本发明的u型网络模型架构图;图3 为本发明卷积时序残差模块的编码器和解码器结构示意图;图4 为本发明音频指纹数据库的构建示意图;图5 为本发明音频匹配原理图;图6 为本发明指纹匹配算法的流程图。

具体实施方式

16.为进一步对本发明的技术方案作详细说明,本实施例在以本发明技术方案为前提下进行实施,给出了详细的实施方式和具体的步骤。

17.本发明提供的一种基于u型网络和音频指纹的音乐与人声分离方法,具体流程如

图1所示:步骤1:将混合音频输入已经训练好的音乐人声分离模型,得到分离的伴奏音频;所述音乐人声分离模型基于u型网络架构,如图2所示,所述u型网络架构包括编码器encoder、解码器decoder以及起连接作用的中间层,其中encoder和decoder个数均为6,实施例中encoder和decoder的具体设计比较灵活,在encoder和decoder部分的中间有一个中间层起连接作用,该层也可根据实际情况对其结构进行灵活选择,实施例中间层为bilstm,如图2中虚线部分表示在通道维度的拼接操作,所述音乐人声分离模型对混合音频进行分离得到伴奏音频的具体步骤包括:步骤11:对所述混合音频进行采样得到采样序列;步骤12:利用编码器对所述采样序列进行编码,提取所述采样序列的深层特征向量;步骤13:利用解码器对步骤12得到的深层特征向量进行解码,得到与人声分离的伴奏音频。

18.如图3所示,编码器是一个时序卷积残差编码单元,由一个一维卷积层(conv1d),一个非线性转换函数和第一残差模块组成,所述编码器对所述采样序列进行编码,提取所述采样序列的深层特征,具体为:步骤121:所述一维卷积层(conv1d)通过一组大小为k的一维卷积滤波器对所述采样序列进行卷积操作,获取局部特征向量;实施例中,假设混合音频采样得到的采样序列为s,通过一组大小为k的一维卷积滤波器c对f进行如下操作:其中,s(n

‑

t)表示s的第n

‑

t个元素,w是窗函数(如汉明窗等),c是卷积核,得到能描述采样序列局部特征的向量f。

19.步骤122:利用所述非线性转换函数对所述局部特征向量进行转换,得到转换后的第二特征向量;优选的,所述非线性转换函数可以是leakyrelu、tanh等激活函数,实施例以leaky relu激活函数对局部特征向量f进行如下转换:,其中,f(i)是f的第i个元素,a

i

是在(1, ∞)的固定参数。得到转换后的第二特征向量g。

20.步骤123:利用所述第一残差模块对第二特征向量进行深层特征提取,得到所述采样序列的深层特征向量。

21.所述解码器是一个时序卷积残差解码单元,由一个一维反卷积层(transconv1d),一个非线性转换函数和第二残差模块组成,所述解码器对所述采样序列进行解码,实现音乐与人声的分离,具体为:步骤131:所述一维反卷积层通过一组大小为k的一维反卷积滤波器对编码器提取的深层特征向量进行反卷积操作,得到恢复后的原始特征向量,实施例中,假设所述编码器提取的深层特征向量为h,通过一组大小为k的一维反卷积滤波器d对h进行如下操作:

其中,h(n

‑

t)表示s的第n

‑

t个元素,w是窗函数(如汉明窗等),c是卷积核。与编码器中的一维卷积层conv1d不同之处在于输出大小n的设置不同。

22.步骤132:利用所述非线性转换函数对步骤131恢复后的原始特征向量进行转换,得到第三特征向量,实施例非线性转换函数采用leakyrelu激活函数;步骤133:利用所述第二残差模块对第三特征向量进一步恢复成分离的人声和伴奏音频。

23.所述第一残差模块和所述第二残差模块结构相同,均包括一个批规范化层(batchnorm)、一个非线性转换函数和一个一维卷积层,所述第一残差模块和所述第二残差模块的实现步骤为:第1步:对输入数据经过所述批规范化层进行处理,得到第五特征向量;实施例以输入步骤122得到的转换后的第二特征向量g为例,批规范化层处理过程如下:输入步骤122得到的转换后的第二特征向量g为例,批规范化层处理过程如下:输入步骤122得到的转换后的第二特征向量g为例,批规范化层处理过程如下:输入步骤122得到的转换后的第二特征向量g为例,批规范化层处理过程如下:,其中,m是每批样本的个数,g

i

是第i个样本经步骤122得到的转换后的第二特征向量,、、均为批规范化参数,γ和β是可学习的缩放因子和位移,g

i’是g

i

经批规范化处理后的特征向量,即所述第五特征向量。

24.第2步:利用所述非线性转换函数对所述第五特征向量进行特征转换,得到第六特征向量;第3步:将所述第六特征向量经过一个一维卷积层conv1d或一维反卷积层transconv1d得到第七特征向量;第4步:将所述第七特征向量与输入数据相加得到最后的输出特征向量。

25.本发明的优选实施例中,所述非线性转换函数为leakyrelu激活函数。

26.步骤2:采用指纹提取算法提取出步骤1得到的伴奏音频中的音频指纹。

27.步骤3:将步骤2得到的音频指纹送入音频指纹数据库中,检索出与所述指纹匹配的歌曲以及时间点offset;搭建音频检索数据库,如图4所示,构建音频数据库的本质就是提取所有原始音频的指纹进行入库操作。音频指纹本质是哈希值和时间值的组合,其中哈希值是使用哈希函数作用于基点和目标点的频率以及两点之间时间差所得到的,这里采用的哈希函数为sha

‑

1函数。该函数所得到的值是一个40个字符的散列值,但是可以只采用前20个字符,这样,存储大小就缩小到一半。进一步考虑,这些字符其实是一些十六进制表示,这里可以将其进一

步用二进制进行存储,所得到的结果为10个字节大小的二进制数。这样,就可以将40个字节(320bit)大小的散列值转化为10字节(80bit)。另外,每个指纹需要附加信息,也就是offset值,一般是4字节,所以一个指纹的信息量大小为14字节,也就是112 bit的信息,即这些信息可以容纳2112个指纹,也就是大约可以容纳5.2

×

1033数量的指纹,虽然减少很大的存储空间,但是保证了拥有足够大的指纹空间。

28.检索出与所述指纹匹配的歌曲以及时间点offset,如图6所示,为本发明指纹匹配算法的流程图,首先要在样本中计算出所有的指纹以及所对应的时间,然后计算出指纹的哈希值,并与数据库中的哈希值进行匹配,从数据库中获得对应的音频id和时间,用这个时间减去样本对应的时间得到一个时间差,此时将音频的id值和这个时间信息组合起来进行存储。在对每个音频指纹都进行上面的操作之后,就会得到许多音频id和时间信息的组合,最后需要对这些时间信息进行统计,找到具有相同的时间差最多的音频id,即为匹配到的歌曲id。

29.步骤4:将步骤3检索得到的匹配歌曲进行音量的调整,具体是计算步骤1得到的伴奏音频的平均音量,然后将检索得到的匹配歌曲的音量调至平均音量。

30.步骤5:对匹配歌曲时间点offset前后一段时间内的音频进行采样,得到一段音频波形,实施例中时间段可为n=1, 2, 3, 4, 5, 10, 15, 20ms等。

31.步骤6:将所述音频波形与步骤1得到的伴奏音频的波形进行比较,进一步调整所述音频波形;步骤7:将所述混合音频减去步骤6调整后的音频波形,最终得到纯净的人声。

32.在本文中,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的步骤、方法不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种步骤、方法所固有的要素。

33.以上内容是结合具体的优选实施方式对本发明所作的进一步详细说明,不能认定本发明的具体实施只局限于这些说明。对于本发明所属技术领域的普通技术人员来说,在不脱离本发明构思的前提下,还可以做出若干简单推演或替换,都应当视为属于本发明的保护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。