1.本发明涉及一种数据生成装置及方法以及学习装置及方法。

背景技术:

2.使含有反应物的原料进行反应的手法有在将原料容纳于容器中的状态下使其反应的所谓的间歇式和一边使原料流动一边使其反应的连续式。连续式反应由于一边使原料流动一边使其反应,因此被称为流动反应。流动反应处理连续地实施反应,因此容易以均匀的性状获得产物。并且,流动反应处理具有生产率比间歇式高的优点。

3.提出有在化学反应处理中利用例如使用了神经网络的各种运算的手法。例如,在专利文献1中,通过预先学习存储于程序中的神经网络来运算化学反应装置的各计测器的异常状态下的数据。然后,在与设定有该运算值的正常允许带值背离的情况下,将异常信号输出至神经控制器,并向化学反应装置的各部发送纠正控制信号,从而控制异常反应。由此,快速检测化学反应装置的异常状态以进行迅速并准确的控制。

4.在专利文献2中,作为化合物的物性预测的手法,记载有将所制作的预测模型适用于未知样本来计算预测项目的技术。该技术根据针对未知样本和各个学习样本所获取的多个参数值来计算出未知样本与各个学习样本的类似度,并提取类似度为预先设定的阈值以上的学习样本来构成子样本集。然后,进行子样本集的数据解析以制作预测模型,并将该预测模型适用于未知样本来计算预测项目。并且,在专利文献3中,使用遗传算法来控制流动反应,由此产生目标产物。

5.以往技术文献

6.专利文献

7.专利文献1:日本特开2002

‑

301359号公报

8.专利文献2:国际公开第2009/025045号

9.专利文献3:日本特表2015

‑

520674号公报

技术实现要素:

10.发明要解决的技术课题

11.流动反应处理一边使原料流动一边使其反应,因此与间歇式反应处理相比,通常更难找出最佳的反应条件。这是因为流动反应具有流速或流量等流动反应所特有的条件参数。

12.如此条件参数多的流动反应在开始新的反应处理之前需要大量关于条件设定的试行及时间,尤其在新的反应系统中的条件搜索中较为显著。并且,即使在由于某些原因而例如不得不变更多个条件参数之一的情况下,也不能简单地决定如何变更其他条件参数中的哪一个。因此,可以考虑通过将已知反应结果的数据用作学习数据来进行神经网络的学习以进行更优选的条件设定。

13.另一方面,在学习神经网络的情况下,学习数据越多,越提高学习的精度。但是,在

如流动反应处理那样的用于产生产物的产生过程中,为了准备大量的学习数据,需要大量的原材料。并且,在准备学习数据时,生产设备被占用以准备学习数据。并且,反应处理需要很长时间。如此,在如流动反应处理那样的产生过程中,对原材料、设备及反应处理有限制,因此难以准备大量的学习数据。又一方面,若不准备规定数量的学习数据,则无法精确地进行神经网络的学习。若无法精确地进行神经网络的学习,则无法适当地进行产生过程的条件设定。

14.本发明是鉴于上述情况而完成的,其目的在于,能够适当地进行产生过程的条件设定。

15.用于解决技术课题的手段

16.基于本发明的数据生成装置生成包括用于学习神经网络的多个学习数据的数据集,所述神经网络为如下:在用于产生产物的过程中,若输入过程条件,则输出与过程条件对应的产生结果且由多个层通过多个耦合权重耦合而成,所述数据生成装置具备:

17.过程条件设定部,在将神经网络的耦合权重的总数设为m0时,设定2

×

m0个以上的多个过程条件;

18.产生结果获取部,获取通过根据多个过程条件中的每一个产生产物来导出且与多个过程条件中的每一个对应的产生结果;及

19.生成部,生成包括多个过程条件中的每一个和与每一个过程条件对应的产生结果的多个学习数据作为数据集。

20.另外,在基于本发明的数据生成装置中,过程条件设定部可以设定2

×

m0个以上且10

×

m0个以下的多个过程条件。

21.并且,在基于本发明的数据生成装置中,过程条件设定部可以设定过程条件的上限及下限。

22.并且,在基于本发明的数据生成装置中,过程可以为使原料流动并使原料进行反应而产生产物的流动反应处理。

23.基于本发明的第1学习装置学习神经网络,所述神经网络为如下:在用于产生产物的过程中,若输入过程条件,则输出与过程条件对应的产生结果且由多个层通过多个耦合权重耦合而成,所述第1学习装置具备:

24.第1运算部,使用由本发明的数据生成装置生成的数据集来进行导出神经网络的耦合权重的第1运算;

25.第2运算部,使用运算出耦合权重的神经网络来进行第2运算,所述第2运算为如下:通过按每个具有产生结果为未知的多个过程条件的条件数据集的过程条件计算出预测结果来生成将过程条件与预测结果建立关联的预测数据集,确定在所获得的多个预测结果中最接近预先设定的目标结果的预测结果,并提取与所确定的预测结果建立关联的过程条件作为提取过程条件;及

26.判定部,在将数据集的数量设为nj且将神经网络的耦合权重的数量设为mj时,进行在提取过程条件下产生产物的情况下的产生结果和与提取过程条件建立关联的预测结果的差异度是否在预先设定的允许范围内的判定,在判定被否定的情况下,通过将使提取过程条件与在提取过程条件下产生的情况下的产生结果建立关联的产生信息作为学习数据添加到数据集中来更新数据集的数量nj,并将神经网络的新的耦合权重的数量mj更新为

mj

‑

1≤mj<nj/2,在判定被肯定的情况下,将提取过程条件决定为用于过程的过程条件,

27.根据更新后的数据集及更新耦合权重后的神经网络,重复进行第1运算、第2运算及判定,直至判定被肯定为止。

28.基于本发明的第2学习装置学习神经网络,所述神经网络为如下:在用于产生产物的过程中,若输入过程条件,则输出与过程条件对应的产生结果且由多个层通过多个耦合权重耦合而成,所述第2学习装置具备:

29.第1运算部,使用包括多个学习数据的数据集来进行导出神经网络的耦合权重的第1运算,所述多个学习数据包括多个过程条件中的每一个和与每一个过程条件对应的产生结果;

30.第2运算部,使用运算出耦合权重的神经网络来进行第2运算,所述第2运算为如下:通过按每个具有产生结果为未知的多个过程条件的条件数据集的过程条件计算出预测结果来生成将过程条件与预测结果建立关联的预测数据集,确定在所获得的多个预测结果中最接近预先设定的目标结果的预测结果,并提取与所确定的预测结果建立关联的过程条件作为提取过程条件;及

31.判定部,在将数据集的数量设为nj且将神经网络的耦合权重的数量设为mj时,进行在提取过程条件下产生产物的情况下的产生结果和与提取过程条件建立关联的预测结果的差异度是否在预先设定的允许范围内的判定,在判定被否定的情况下,通过将使提取过程条件与在提取过程条件下产生的情况下的产生结果建立关联的产生信息作为学习数据添加到数据集中来更新数据集的数量nj,并将神经网络的新的耦合权重的数量mj更新为mj

‑

1≤mj<nj/2,在判定被肯定的情况下,将提取过程条件决定为用于过程的过程条件,

32.根据更新后的数据集及更新耦合权重后的神经网络,重复进行第1运算、第2运算及判定,直至判定被肯定为止。

33.另外,在基于本发明的第1学习装置或第2学习装置中,过程可以为使原料流动并使原料进行反应而产生产物的流动反应处理。

34.基于本发明的数据生成方法生成包括用于学习神经网络的多个学习数据的数据集,所述神经网络为如下:在用于产生产物的过程中,若输入过程条件,则输出与过程条件对应的产生结果且由多个层通过多个耦合权重耦合而成,其中,

35.在将神经网络的耦合权重的总数设为m0时,设定2

×

m0个以上的多个过程条件,

36.获取通过根据多个过程条件中的每一个产生产物来导出且与多个过程条件中的每一个对应的产生结果,

37.生成包括多个过程条件中的每一个和与每一个过程条件对应的产生结果的多个学习数据作为数据集。

38.基于本发明的第1学习方法学习神经网络,所述神经网络为如下:在用于产生产物的过程中,若输入过程条件,则输出与过程条件对应的产生结果且由多个层通过多个耦合权重耦合而成,其中,

39.使用由本发明的数据生成方法生成的数据集来进行导出神经网络的耦合权重的第1运算,

40.使用运算出耦合权重的神经网络来进行第2运算,所述第2运算为如下:通过按每个具有产生结果为未知的多个过程条件的条件数据集的过程条件计算出预测结果来生成

将过程条件与预测结果建立关联的预测数据集,确定在所获得的多个预测结果中最接近预先设定的目标结果的预测结果,并提取与所确定的预测结果建立关联的过程条件作为提取过程条件;及

41.在将数据集的数量设为nj且将神经网络的耦合权重的数量设为mj时,进行在提取过程条件下产生产物的情况下的产生结果和与提取过程条件建立关联的预测结果的差异度是否在预先设定的允许范围内的判定,在判定被否定的情况下,通过将使提取过程条件与在提取过程条件下产生的情况下的产生结果建立关联的产生信息作为学习数据添加到数据集中来更新数据集的数量nj,并将神经网络的新的耦合权重的数量mj更新为mj

‑

1≤mj<nj/2,在判定被肯定的情况下,将提取过程条件决定为用于过程的过程条件,

42.根据更新后的数据集及更新耦合权重后的神经网络,重复进行第1运算、第2运算及判定,直至判定被肯定为止。

43.基于本发明的第2学习方法学习神经网络,所述神经网络为如下:在用于产生产物的过程中,若输入过程条件,则输出与过程条件对应的产生结果且由多个层通过多个耦合权重耦合而成,其中,

44.使用包括多个学习数据的数据集来进行导出神经网络的耦合权重的第1运算,所述多个学习数据包括多个过程条件中的每一个和与每一个过程条件对应的产生结果,

45.使用运算出耦合权重的神经网络来进行第2运算,所述第2运算为如下:通过按每个具有产生结果为未知的多个过程条件的条件数据集的过程条件计算出预测结果来生成将过程条件与预测结果建立关联的预测数据集,确定在所获得的多个预测结果中最接近预先设定的目标结果的预测结果,并提取与所确定的预测结果建立关联的过程条件作为提取过程条件;及

46.在将数据集的数量设为nj且将神经网络的耦合权重的数量设为mj时,进行在提取过程条件下产生产物的情况下的产生结果和与提取过程条件建立关联的预测结果的差异度是否在预先设定的允许范围内的判定,在判定被否定的情况下,通过将使提取过程条件与在提取过程条件下产生的情况下的产生结果建立关联的产生信息作为学习数据添加到数据集中来更新数据集的数量nj,并将神经网络的新的耦合权重的数量mj更新为mj

‑

1≤mj<nj/2,在判定被肯定的情况下,将提取过程条件决定为用于过程的过程条件,

47.根据更新后的数据集及更新耦合权重后的神经网络,重复进行第1运算、第2运算及判定,直至判定被肯定为止。

48.发明效果

49.根据本发明,能够适当地进行产生过程的条件设定。

附图说明

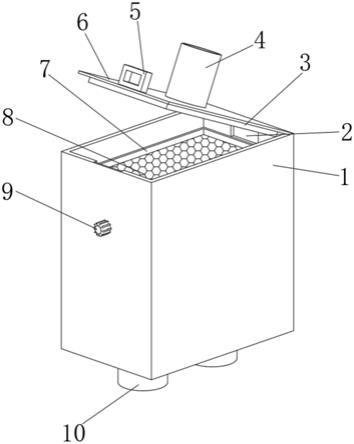

50.图1是流动反应处理设备的概略图

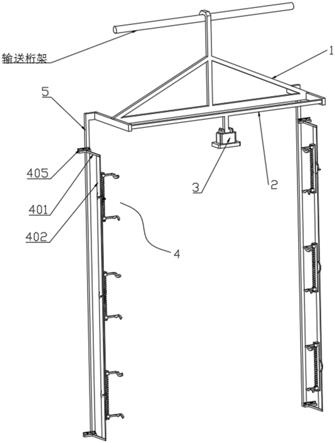

51.图2是另一个流动反应装置的概略图

52.图3是表示数据生成装置的结构的概略框图

53.图4是神经网络的层结构的概念图

54.图5是初始数据集的说明图

55.图6是表示流动反应辅助装置的结构的框图

56.图7是条件数据集的说明图

57.图8是预测数据集的说明图

58.图9是对比数据的说明图

59.图10是表示在本实施方式中进行的处理的流程图

60.图11是在本实施方式中进行的数据生成处理的流程图

61.图12是表示本实施方式中的神经网络的学习精度的验证结果的图

62.图13是表示本实施方式中的数据集中所包含的学习数据的数量与神经网络的耦合数的关系的图

具体实施方式

63.以下,参考附图对本发明的实施方式进行说明。图1是表示适用了基于本发明的实施方式的数据生成装置及学习装置的产生过程的设备的一方式的流动反应设备的图。如图1所示,流动反应设备10具备流动反应装置11、流动反应辅助装置(以下,简称为“辅助装置”)12、数据生成装置13、系统控制器15、设定部16及检测部17等。流动反应装置11为用于进行流动反应处理而获得产物的装置。

64.关于由流动反应装置11进行的流动反应,除了例如合成作为单体的化合物的合成反应及通过使单体彼此进行反应而生成聚合物的聚合反应以外,还可以为例如阴离子聚合反应等的开始反应及终止反应等基本反应(elementary reaction)。因此,成为流动反应的对象的反应物可以为例如成为终止反应的对象的生长(成长)阶段的化合物。在本实施方式中,通过流动反应进行用甲醇终止聚苯乙烯基锂的生长(成长)的终止反应。

65.流动反应装置11具备第1供给部21、第2供给部22、反应段23及回收段26。第1供给部21及第2供给部22分别通过配管连接到反应段23的上游侧端部,回收段26通过配管连接到反应段23的下游侧端部。

66.第1供给部21用于将流动反应的第1原料供给至反应段23。本实施方式的第1原料为将聚苯乙烯基锂溶解于溶剂中而获得的第1液,聚苯乙烯基锂为流动反应处理的反应物的一例。在本实施方式中,第1供给部21将第1液供给至反应段23,所述第1液是将聚苯乙烯基锂溶解于溶剂中而获得的。使用四氢呋喃(以下,称为thf)作为溶剂,在第1液中少量混合有甲苯及己烷。如此,流动反应的原料可以为反应物与其他物质的混合物,或者也可以仅由反应物构成。第1供给部21具备泵(未图示),通过调节泵的转速来调节向反应段23的第1原料的流量。

67.第2供给部22用于将流动反应的第2原料供给至反应段23。本实施方式的第2原料为甲醇与水的混合物即甲醇水溶液,并且将甲醇用作终止反应的终止剂。与第1供给部21同样地,第2供给部22也具备泵(未图示),通过调节泵的转速来调节向反应段23的甲醇的流量。在本实施方式中,第1供给部21及第2供给部22将液体供给至反应段23,但是供给物并不限定于液体,也可以为固体或气体。

68.反应段23用于进行作为流动反应的终止反应,并且具备汇合部31、反应部32及温度调节部33。汇合部31为t字形分支的管即t字管。汇合部31的第1管部31a连接到第1供给部21,第2管部31b连接到第2供给部22,第3管部31c连接到反应部32。由此,被引导的第1原料与第2原料汇合,并在混合的状态下输送至反应部32。

69.反应部32为将多个管状部件沿长度方向连接的管。通过改变管状部件的根数及所使用的各个管状部件的长度中的至少一个来变更反应部32的长度l32。并且,通过将管状部件改变为内径不同的其他管状部件来变更作为反应部32的内径的反应路径d32。

70.反应部32的内部被设为第1原料与第2原料的混合物(以下,称为混合原料)的流路,并且将管内的中空部划定为反应场。混合原料一边穿过反应部32一边进行阴离子聚合的终止反应而生成聚苯乙烯。在汇合部31的第3管部31c中也稍微进行反应,但是与反应部32的长度l32(在本实施方式中为8m)相比,汇合部31的第3管部31c的长度非常短,本实施方式的第3管部31c的长度约为0.03m。因此,忽略第3管部31c的长度,将反应部32的长度l32视为进行流动反应时的长度(以下,称为反应路径长度)。以下,将符号l32用作反应路径长度。同样地,将反应部32的内径d32视为进行流动反应时的直径(以下,称为反应路径),并将符号d32用作反应路径。

71.温度调节部33用于调节流动反应的温度(以下,称为反应温度)。温度调节部33经由汇合部31及反应部32来调节在这些之间流动的混合原料的温度(反应温度)。在通过设定部16设定的反应温度(以下,称为设定温度)与通过温度调节部33进行温度调节的混合原料的温度相同的情况下,将设定温度视为反应温度即可,在本实施方式中也如此。另外,在设定温度与混合原料的温度之差大的情况下等,例如在反应部32内等设置检测温度的温度检测器,并将该温度检测器的检测结果设为反应温度即可。

72.回收段26用于回收作为流动反应的产物的聚苯乙烯。回收段26均由未图示的析出部、采集部及干燥部等构成。析出部用于析出作为产物的聚苯乙烯。在本实施方式中,将具备搅拌机的容器用作析出部。在容器中容纳甲醇,并将从反应段引导的聚苯乙烯溶液放入正在搅拌的甲醇中,从而析出聚苯乙烯。

73.采集部用于从甲醇和thf等的混合液采集所析出的聚苯乙烯。在本实施方式中,将过滤器用作采集部。

74.干燥部用于干燥所采集的聚苯乙烯。在本实施方式中,作为干燥部,使用具有减压功能的恒温槽。通过在将恒温槽内部设成减压状态的状态下进行加热,可以获得聚苯乙烯。

75.反应段及回收段并不限于上述例,可以根据流动反应的种类及产物的种类等中的至少一个适当变更。例如,可以设置容器来代替回收段26,并将从反应段23引导的聚苯乙烯溶液暂时存储于该容器中。在这种情况下,将所存储的聚苯乙烯溶液引导至回收段26,并析出、采集及干燥聚苯乙烯而获得即可。

76.检测部17与回收段26及辅助装置12连接,检测作为流动反应的处理结果的反应结果,并将其输出至辅助装置12的判定部56(参考图6)。反应结果与本发明的产生结果对应。作为成为反应结果的参数(以下,称为结果参数),除了产物的纯度、分子量或分子量分散度(以下,简称为分散度)等产物的性状以外,还可以举出产率等。并且,在回收段26中,在产物例如在溶解于溶剂中的溶液状态下获得的情况下,也可以检测溶液中的产物的浓度(摩尔浓度等)作为结果参数。另外,除了产物的这些各种性状以外,检测部17还可以检测副产物的产率或纯度等各种性状作为结果参数。构成反应结果的结果参数可以为多个。

77.在本实施方式中,通过检测部17检测在回收段26中获得的聚苯乙烯的分子量及分散度。即,本实施方式中的结果参数为分子量及分散度这两个。所检测的分子量为数均分子量(mn)。关于分子量及分散度,通过将聚苯乙烯溶解于thf中来制作聚苯乙烯溶液,并使用

该聚苯乙烯溶液,通过凝胶渗透色谱(以下,称为gpc,gpc为gel permeation chromatography的缩写)来求出。另外,分散度为将重均分子量(mw)除以数均分子量而获得的mw/mn。结果参数的检测并不限于gpc。例如,可以通过红外光谱法(ir,infrared spectros copy)、核磁共振光谱法(nmr,nuclear magnetic resonance spectroscop y)、高效液相色谱法(hplc,high performance liquidchromatography)或气相色谱法(gc,gas chromatography)等各种手法来检测。

78.gpc在下述条件下进行测量。

79.装置:hlc

‑

8220gpc(tosoh corporation制)

80.检测器:示差折光计(ri(refractive index)检测器)

81.预柱:tskguardcolumn hxl

‑

l 6mm

×

40mm(tosoh corporation制)

82.样本侧管柱:按顺序直接连接以下(1)~(3)这三根(均为tosoh corp oration制)

83.(1)tsk

‑

gel gmhxl 7.8mm

×

300mm

84.(2)tsk

‑

gel g4000hxl 7.8mm

×

300mm

85.(3)tsk

‑

gel g2000hxl 7.8mm

×

300mm

86.参考试料侧管柱:tsk

‑

gel g1000hxl 7.8mm

×

300mm

87.恒温槽温度:40℃

88.移动层:thf

89.样本侧移动层流量:1.0ml/分钟

90.参考试料侧移动层流量:1.0ml/分钟

91.试样浓度:0.1质量%

92.试样注入量:100μl

93.数据采集时间:试样注入后5分钟~45分钟

94.采样间距:300msec

95.系统控制器15集中控制流动反应装置11。系统控制器15分别与第1供给部21及第2供给部22的各泵以及温度调节部33连接。系统控制器15通过调节第1供给部21及第2供给部22的各泵的转速来调节第1原料及第2原料中的每一个的流量,由此控制第1原料及第2原料朝向反应段23的各流速。另外,关于第1原料的流速,在将从第1供给部21输送至反应段23的第1原料的流量设为x1(单位为m3/秒钟)且将第1供给部21与反应段23之间的配管的截面积设为x2(单位为m2)时,通过x1/x2来求出。第2原料的流速也同样地,将从第2供给部22输送至反应段23的第2原料的流量设为x1且将第2供给部22与反应段23之间的配管的截面积设为x2(单位为m2),并通过x1/x2来求出。另外,关于第1原料及第2原料的各流量,在本实施方式中,根据作为市售品的各泵的目录数据并从转速求出。并且,系统控制器15通过调节温度调节部33来控制混合原料的温度。如此,系统控制器15通过调节流动反应装置11的各部来集中控制流动反应装置11。

96.设定部16用于设定流动反应装置11中的流动反应处理的处理条件(以下,称为反应条件)。另外,反应条件与本发明的过程条件对应。反应条件为多个条件参数的组合。设定部16具有未图示的操作部,通过来自操作部的操作信号的输入来设定反应条件,由此经由系统控制器15将流动反应装置11控制为所设定的反应条件。例如,通过用操作部的鼠标点击或选择和/或用键盘输入文字等来设定反应条件。设定部16与辅助装置12连接,除了上述

来自操作部的操作信号以外或者代替上述来自操作部的操作信号将反应条件设定为从辅助装置12的后述第3存储部51c读取的后述决定反应条件cs,由此经由系统控制器15将流动反应装置11控制为预先设定的反应条件。另外,本实施方式的设定部16也能够如后述对辅助装置12提供输入信号。

97.通过设定部16设定的条件参数根据所实施的流动反应处理的种类来决定即可,并无特别限定。例如,可以举出第1原料及第2原料等原料的流量、流速、送入反应段23的原料的温度、反应温度及反应时间等中的至少一个。在本实施方式中,将条件参数设为第1原料的流量、第2原料的流量、汇合部的形状、反应路径d32、反应路径长度l32及反应温度。

98.流动反应处理的条件参数可以具有固定为预先决定的规定值的条件参数(以下,称为固定参数)。本实施方式的固定参数为第1原料及第2原料中的反应物的浓度以及反应路径长度l32。在本实施方式中,预先决定第1原料及第2原料中的反应物的浓度以及反应路径长度l32,并且不进行经由系统控制器15的控制(例如,将浓度变更为更高或变更为更低等的控制)。如此,流动反应可以具有不进行基于系统控制器15的控制而例如在原料的制备工序及流动反应装置11的组装工序等中进行变更的条件参数。

99.另外,在流动反应设备10中,能够将流动反应装置11替换成其他流动反应装置。例如,在本实施方式中,能够将图2所示的流动反应装置41替换成图2所示的流动反应装置11。流动反应装置41具备将汇合部31替换成汇合部42的反应段43。另外,在图2中,对与图1相同的部件标注与图1相同的符号,并省略说明。

100.汇合部42为十字(cross)形分支的管即十字管(cross tube)。汇合部42的第1管部42a连接到第2供给部22,与第1管部42a交叉的第2管部42b及第3管部42c连接到第1供给部21,其余的第4管部42d连接到反应部32。由此,被引导的第1原料与第2原料汇合,并在混合的状态下输送至反应部32。

101.辅助装置12对于通过流动反应装置11进行的流动反应处理进行用于迅速地决定成为反应条件的多个条件参数的辅助。辅助装置12的详细内容将进行后述。

102.数据生成装置13生成包括用于学习神经网络的多个学习数据的数据集,所述神经网络为如下:对于通过流动反应装置11进行的流动反应处理,若输入反应条件,则输出与反应条件对应的反应结果且由多个层通过多个耦合权重耦合而成。

103.图3是表示数据生成装置的结构的概略框图。如图3所示,数据生成装置13具备反应条件设定部52、反应结果获取部53及生成部54。

104.反应条件设定部52及反应结果获取部53分别与本发明的过程条件设定部及产生结果获取部对应。

105.在将神经网络的耦合权重的总数设为m0时,反应条件设定部52设定2

×

m0个以上的多个反应条件。另外,反应条件设定部52还设定反应条件中所包含的各条件参数的上限及下限。图4是在本实施方式中所使用的神经网络的层结构的概念图。如图4所示,神经网络70具有输入层l1、中间层(隐藏层)l2及输出层l3这三层结构。输入层l1由作为说明变量的条件参数的值xi构成。在本实施方式中,条件参数为第1原料的流量、第2原料的流量、汇合部的形状、反应路径d32、反应路径长度l32及反应温度,因此为i=1~5。隐藏层l2由三个节点u1~u3构成,并且在本实施方式中成为一层。输出层l3由作为目标变量的结果参数的值ym构成。在本实施方式中,结果参数为分子量及分散度,因此为m=1、2。另外,对神经网络70

的详细结构将进行后述。

106.在使用如图4所示的神经网络70的情况下,神经网络的耦合权重的总数m0成为5

×

3 3

×

2=21个。因此,反应条件设定部52设定2

×

21=42个以上的反应条件。并且,作为反应条件的数量的上限,在本实施方式中,使用10

×

m0。在本实施方式中,将反应条件设定部52根据耦合权重的总数m0设定的反应条件用作初始反应条件。

107.另外,作为条件参数的第1原料的流量及第2原料的流量的上限根据第1供给部21及第2供给部所具备的泵的能力来决定即可。另一方面,流量的下限设为原料充满配管的速度即可。若流速变得过低,则原料没有充满配管,空气混入配管内而发生反应不均匀。因此,原料填充配管的速度表示能够以空气不混入配管中的方式供给原料的最低的速度。其中,在如流动反应装置那样反应路径小的情况下,每个流体体积的面积(比表面积)大,因此若原料没有充满配管,则显著地发生反应不均匀。如上所述,通过将第1原料的流量及第2原料的流量的下限决定为原料充满配管的速度,能够防止反应不均匀的发生。

108.另一方面,当收集连续的学习数据时,所收集的学习数据的质量变得重要。即,收集学习数据中所包含的条件参数的上限及下限在学习数据中均匀地分散的学习数据变得重要。根据收集学习数据时的条件参数的分配方法而学习数据会产生偏差,其结果,有可能仅获得质量差的学习数据。因此,当收集学习数据时,尤其在流动反应过程中,利用在流动反应的微尺度或毫米尺度上强烈表现的物理量来分配条件参数是有效的。即,在微尺度或毫米尺度的流路上的混合中,由于流动为致密的层流,因此首先通过流体的分割及混合来生成微小且有规则的流体块,若需要,则利用碰撞等强制性的对流混合,并且最终通过分子扩散而完成混合。因此,不会出现如宏观尺寸所见的由紊流引起的随机混合状态,能够在整体上进行均匀的混合操作。流量很大程度上取决于对流混合的促进。

109.因此,作为学习数据中所包含的条件参数,为了使流量具有偏差,首先导出相对于流量的上限及下限为50%的值作为中间值。然后,在流量的下限以上且小于中间值的第1范围内分配流量。接着,在流量的中间值以上且上限以下的第2范围内分配流量。另外,在第1范围和第2范围内,学习数据的数量优选设为相同,但是至少30%的数量的学习数据在第1范围内或第2范围内即可。由此,在流量的上限及下限的范围内,能够连续地收集没有偏差的学习数据。通过使用这种方法,能够生成条件参数具有偏差且优质的学习数据。并且,可以设为如下:首先在第2范围内分配流量,接着在第1范围内分配流量。

110.反应结果获取部53根据由反应条件设定部52设定的多个反应条件中的每一个获取通过使流动反应装置11进行流动反应处理来导出的反应结果。即,关于所设定的反应条件中的每一个,获取反应结果即结果参数。此时,各个反应条件与反应结果建立关联而生成一个反应信息。这一个反应信息成为学习数据。

111.生成部54生成包括反应条件与反应结果的组合的42个反应信息即学习数据作为数据集。所生成的数据集输入至辅助装置12。

112.图5是表示数据集的图。如图5所示,数据集包括42个学习数据。关于各学习数据,包含第1原料的流量、第2原料的流量、汇合部的形状、反应部中的反应路径及反应温度的反应条件与包含产物的分散度及分子量的反应结果相对应。

113.图6是表示辅助装置12的结构的概略框图。如图6所示,辅助装置12由运算段50、第1存储部51a~第3存储部51c及判定部56等构成。在本实施方式中,第1存储部51a~第3存储

部51c与运算段50分开构成,但是也可以构成为运算段50的一部分。另外,运算段50及判定部56构成本发明的学习装置。

114.第1存储部51a存储有包括由数据生成装置13生成的多个学习数据的数据集。并且,若通过数据集中没有的反应条件在流动反应装置11中获取反应结果,则存储包括该反应条件和反应结果的反应信息作为新的学习数据。第1存储部51a以在反应信息中仅通过反应条件能够读入的状态存储。例如,第1存储部51a将学习数据中所包含的反应条件及反应结果存储于相互不同的场中,并且存储反应条件及反应结果的关联信息。或者,可以设置一起存储反应条件及已知的反应结果的场和仅存储反应条件的场。

115.在初始学习时,由数据生成装置13生成的数据集中所包含的反应信息作为学习数据用于学习中。在本实施方式中,在初始状态下,包括图5所示的42个学习数据的数据集被存储于第1存储部51a中。

116.另外,如图5所示,在本实施方式中,存储于第1存储部51a中的数据集以表结构存储多个学习数据。具体而言,将学习数据的类别配置成沿纵栏排列的状态,并将学习数据的类别、反应条件和反应结果配置成沿横栏排列的状态。但是,纵栏和横栏也可以相反。第1存储部51a中的数据集的存储方式并不限于表结构,反应条件与反应结果建立关联即可。因此,例如设置并存储反应条件和反应结果中的每一个的场即可。

117.运算段50具有学习模式及计算模式,根据模式进行目标运算处理。运算段50具备第1运算部61~第3运算部63,第1运算部61在学习模式下进行运算处理,并在计算模式下如后述重复进行停止了运算的停止状态和读入第1存储部51a的状态。第2运算部62及第3运算部63在学习模式下成为停止状态,并在计算模式下进行运算处理。

118.第1运算部61读取存储于第1存储部51a中的数据集,并使用所读取的数据集中所包含的学习数据来学习反应条件与反应结果的相关性。然后,第1运算部61通过学习来生成将反应条件与反应结果建立关联的函数,并将所生成的函数写入第2存储部51b。构成反应条件的多个条件参数和构成反应结果的结果参数中的每一个为函数中的变量,在已经决定了条件参数及结果参数的情况下,函数的生成表示函数中的系数的生成。

119.在本实施方式中,第1运算部61通过将反应条件的各条件参数设为说明变量且将反应结果的结果参数设为目标变量来进行学习,导出表示神经网络的耦合权重的权重系数,并构建结束了第1次学习的学习完毕的神经网络。另外,说明变量对应于输入变量,目标变量对应于输出变量。在本实施方式中,通过在第1运算部61中构建的神经网络来生成例如以下函数(1a)及(1b)。

[0120][0121][0122]

在上述函数(1a)及(1b)中,xi(i为自然数)为条件参数的值,i的最大值为条件参

数的个数。在本实施方式中,使用图4所示的结构的神经网络,因此在本实施方式中,i为5。ym(m为自然数)为结果参数的值,m的最大值为结果参数的个数。因此,在本实施方式中,m为2。ul(1为自然数)为隐藏层l2的节点,l的最大值为节点的个数。在本实施方式中,l为3。w

xiul

、w

ulym

为表示神经网络的耦合权重的权重系数。具体而言,如下。关于下述流量,1ml(毫升)/min能够换算成1

×

10

‑6×

(1/60)m3/秒钟。

[0123]

y1;聚苯乙烯的分子量

[0124]

y2;聚苯乙烯的分散度

[0125]

x1(单位为ml/min);第1原料的流量(最小值0.5ml/min、最大值100ml/min)

[0126]

x5(单位为ml/min);第2原料的流量(最小值0.5ml/min、最大值100ml/min)

[0127]

x3(为无量纲值);将汇合部的形状为t字形的情况定义为“1”,并将十字形的情况定义为“2”[0128]

x4(单位为mm);反应路径(最小值1mm、最大值10mm)

[0129]

x5(单位为℃);反应温度(最小值0℃、最大值10℃)

[0130]

ul;节点

[0131]

w

xiul

;xi与ul之间的权重系数

[0132]

ym;结果参数的值

[0133]

w

ulym

;ul与ym之间的权重系数

[0134]

神经网络能够使用市售的神经网络拟合应用来构建。例如,在本实施方式中,使用mathworks公司制的matlab neural fitting tool来构建神经网络。神经网络拟合应用并不限定于上述,例如也能够使用能够以r语言动作的rstudjo公司制的keras包等。

[0135]

如上述图4所示,神经网络具有输入层l1、隐藏层l2和输出层l3这三层结构。输入层l1由作为说明变量的条件参数的值x1~x5构成。隐藏层l2由三个节点u1~u3构成,并且在本实施方式中成为一层。节点u1~u3中的每一个为通过与x1~x5中的每一个对应的权重系数w

xiul

对x1~x5进行加权而获得的值的总和。输出层l3由作为目标变量的结果参数的值y1、y2构成。结果参数的值y1、y2中的每一个为使用节点u1~u3并通过与节点u1~u3中的每一个对应的权重系数w

ulym

进行加权而求出的值。图4中的黑色圆圈

“●”

表示权重系数w

xiul

、w

ulym

。另外,神经网络的层结构并不限定于本实施方式。

[0136]

在通过第1运算部61将函数写入第2存储部51b的情况下,运算段50将学习模式切换成计算模式。第2运算部62在计算模式下从第1存储部51a读取学习数据的反应条件,根据所读取的反应条件来生成包含反应结果为未知的多个反应条件的条件数据集,并写入第2存储部51b。条件数据集可以包含所读取的反应结果已知的反应条件,在本实施方式中也如此。

[0137]

第2运算部62分配形成反应条件的多个条件参数中的至少一个条件参数的值并生成反应结果为未知的反应条件,从而生成条件数据集。例如,关于多个条件参数中的第1原料的流量,在由数据生成装置13生成的学习数据中的反应条件内的第1原料的流量包含1ml/min、10ml/min、11ml/min、20ml/min、100ml/min的情况下,例如在为2ml/min、5ml/min、6ml/min等的值时的反应结果为未知,因此生成关于这些值的反应条件。

[0138]

以成为反应结果为未知的反应条件的状态生成的条件参数的值设为从第1存储部51a读取的反应条件的条件参数中的最小值与最大值之间的值,除了这些以外还可以包含

最小值及最大值。例如,在上述例中,第1原料的流量的最小值为1ml/min且最大值为100ml/min,因此在这两个值之间生成多个条件参数的值。在本实施方式中,除了这些以外还可以包含最小值的1ml/min和最大值的100ml/min。而且,最大值与最小值之间的多个值优选设为以相等间隔刻出最大值与最小值之间的值,在本实施方式中,关于上述第1原料的流量,如后述设为1ml/min间隔的值(参考图7)。

[0139]

在形成反应条件的多个条件参数中分配值的条件参数设为能够判断为在流动反应装置11中可以变更的条件参数。在本实施方式中,生成对第1原料的流量、第2原料的流量、汇合部的类型(汇合部31和汇合部42)、反应路径d32及反应温度中的每一个分配了值的多个反应条件(参考图7)。

[0140]

第2存储部51b存储从第1运算部61输出的函数和从图7所示的第2运算部62输出的条件数据集。另外,在本实施方式中,第2运算部62生成条件数据集,但是条件数据集可以使用其他运算设备(例如,个人电脑等)来生成。并且,如图7所示,在本实施方式中,由第2运算部62生成的条件数据集也设为表结构,因此在第2存储部51b中存储有表结构的条件数据集。具体而言,将不同的反应条件配置成沿纵栏排列的状态,并将条件参数配置成沿横栏排列的状态。但是,纵栏和横栏也可以相反。并且,与学习数据同样地,条件数据集也并不限于表结构,按每个反应条件能够单独读取地生成,并存储于第2存储部51b中即可。

[0141]

如图7所示,在条件数据集中,如上所述,设为最大值及最小值以及以相等间隔刻出最大值与最小值之间的值。例如,第1原料的流量为以1ml/min间隔刻出从作为最小值的1ml/min至作为最大值的100ml/min的值,第2原料的流量为以0.1ml/min间隔刻出从作为最小值的0.6ml/min至作为最大值的55.0ml/min的值。并且,汇合部设成汇合部31和汇合部42这两个形状。反应路径d32为以1mm间隔刻出从作为最小值的1mm至作为最大值的10mm的值,反应温度设为以1℃间隔刻出从作为最小值(最低值)的1℃至作为最大值(最高值)的10℃的值。但是,在以相等间隔刻出值时的间隔并不限于此。

[0142]

第3运算部63从第2存储部51b读取函数及条件数据集并生成预测数据集,将所生成的预测数据集写入第3存储部51c。预测数据集由多个预测信息构成。预测信息按每个条件数据集的反应条件预测反应结果,并且为将所求出的预测结果与反应条件建立关联的预测数据。因此,预测信息的数量等于条件数据集中的反应条件的数量。预测为使用所读取的函数进行的运算处理。

[0143]

第3运算部63从多个预测信息中确定并提取表示最佳的预测结果的预测信息。然后,第3运算部63将所提取的预测信息的反应条件作为提取反应条件cp写入第3存储部51c,并且将所提取的预测信息的预测结果rp在与提取反应条件cp建立关联的状态下写入第3存储部51c。

[0144]

例如,在本实施方式中,通过设定部16的操作部中的输入而在第3运算部63中预先输入有目标反应结果(以下,称为目标结果)ra作为操作信号。第3运算部63将目标结果ra与预测数据集的各预测信息的预测结果进行对比,并将从多个预测结果中最接近目标结果ra的(与目标结果ra之差最小)预测结果确定为上述“最佳的预测结果”。在存在与目标结果ra相同的预测结果的情况下,将该预测结果确定为“最佳的预测结果”。

[0145]

并且,在最接近目标结果ra的预测结果存在多个的情况下,从第1存储部51a读取学习数据,参考反应结果最接近目标结果ra的学习数据的反应条件,并在以下过程中确定

“

最佳的预测结果”。首先,将预测数据集的各预测信息的条件参数设为x1~x5,将结果参数设为y1,将对y1的贡献度设为a1~a5,并由以下式(1c)~(1g)定义a1~a5。

[0146]

a1=w

x1u1×

w

u1y1

w

x1u2

×

w

u2y1

w

x1u3

×

w

u3y1

……

w

x1ul

×

w

uly1

……

(1c)

[0147]

a2=w

x2u1

×

w

u1y1

w

x2u2

×

w

u2y1

w

x2u3

×

w

u3y1

……

w

x2ul

×

w

uly1

……

(1d)

[0148]

a3=w

x3u1

×

w

u1y1

w

x3u2

×

w

u2y1

w

x3u3

×

w

u3y1

……

w

x3ul

×

w

uly1

……

(1e)

[0149]

a4=w

x4u1

×

w

u1y1

w

x4u2

×

w

u2y1

w

x4u3

×

w

u3y1

……

w

x4ul

×

w

uly1

……

(1f)

[0150]

a5=w

x5u1

×

w

u1y1

w

x5u2

×

w

u2y1

w

x5u3

×

w

u3y1

……

w

x5ul

×

w

uly1

……

(1g)

[0151]

其中,若分别求出a1~a5时的符号为正,则对预测结果具有正的贡献度,若符号为负,则对预测结果具有负的贡献度,表示绝对值越大,对预测结果的贡献度越高。

[0152]

然后,从学习数据中选择最接近目标结果ra的反应结果和反应条件,将该反应结果设为y1n,并通过式|ra

‑

y1n|/ra的公式来求出y1n与目标结果ra之差的绝对值。接着,着眼于a1~a5的绝对值的大小。例如,在a1~a5的各绝对值中a1的绝对值最大的情况下,通过以下<a>~<d>这四个情况来确定“最佳的预测结果”。

[0153]

<a>y1n与ra之差和y1ra

‑

y1n/y1ra均为正且a1为正的情况

[0154]

在向正方向增大y1n的情况下,y1n接近ra。因此,将具有比学习数据的最接近目标结果ra的反应条件的a1的条件参数的值在正方向上具有最大值的条件参数的预测结果确定为“最佳的预测结果”。

[0155]

<b>y1n与ra之差和y1ra

‑

y1n/y1ra均为正且a1为负的情况

[0156]

在向正方向增大y1n的情况下,y1n接近ra。因此,将具有比学习数据的最接近目标结果ra的反应条件的a1的条件参数的值在负方向上具有最大值的条件参数的预测结果确定为“最佳的预测结果”。

[0157]

<c>y1n与ra之差和y1ra

‑

y1n/y1ra均为负且a1为正的情况

[0158]

在向负方向增大y1n的情况下,y1n接近ra。因此,将具有比学习数据的最接近目标结果ra的反应条件的a1的条件参数的值在负方向上具有最大值的条件参数的预测结果确定为“最佳的预测结果”。

[0159]

<d>y1n与ra之差和y1ra

‑

y1n/y1ra均为负且a1为负的情况

[0160]

在向负方向增大y1n的情况下,y1n接近ra。因此,将具有比学习数据的最接近目标结果ra的反应条件的a1的条件参数的值在正方向上具有最大值的条件参数的预测结果确定为“最佳的预测结果”。

[0161]

在反应结果的结果参数存在多个的情况下,在对多个结果参数进行了加权的状态下输入目标结果ra,第3运算部63根据加权来确定“最佳的预测结果”。基于加权的确定例如可以为仅通过加权最大的结果参数来确定的第1手法,也可以为第2手法,所述第2手法为如下:通过加权最大的结果参数从最接近目标结果ra的预测结果例如限定多个候补,并将从所限定的预测结果中加权的顺序低的结果参数中最接近目标结果ra的预测结果确定为“最佳的预测结果”。在本实施方式中,通过第2手法来确定。另外,本实施方式中的目标结果ra的分子量在25200的

±

1%以内,分散度在1.03以内。

[0162]

第3存储部51c存储从第3运算部63输出的预测数据集、提取反应条件cp、与提取反应条件cp建立关联的预测结果rp。这些预测数据集、提取反应条件cp和预测结果rp以能够单独读取的状态存储。

[0163]

图8是表示由第3运算部63生成的预测数据集的图。如图8所示,在本实施方式中,由第3运算部63生成的预测数据集也设为表结构,因此在第3存储部51c中存储有表结构的预测数据集。具体而言,将预测信息的类别配置成沿纵栏排列的状态,并将反应条件的条件参数和作为预测结果的结果参数配置成沿横栏排列的状态。但是,纵栏和横栏也可以相反。与学习数据同样地,预测数据集也并不限于表结构,反应条件与预测结果建立关联且至少提取反应条件cp能够读取地生成,并存储于第3存储部51c中即可。

[0164]

在图8中示出根据图7的条件数据集所生成的预测数据集。

[0165]

在本实施方式中,对两个结果参数进行前述加权,并使分子量的加权大于分散度。在本实施方式中,如图8所示,关于加权大的分子量,预测信息编号(以下,记载为预测信息no.)6050与预测信息no.8000的分子量成为24870,与其他预测信息no.相比最接近目标结果ra且相互成为等值。然后,在预测信息no.6050和预测信息no.8000中,关于加权低于分子量的分散度,预测信息no.6050更接近目标结果ra。因此,第3运算部63将预测信息no.6050的预测结果确定为前述“最佳的预测结果”,并将预测信息no.6050的反应条件确定为提取反应条件cp。然后,第3运算部63在预测信息no.6050的反应条件中进行了为提取反应条件cp的记录的状态(在表6中,为了便于说明,在预测信息no.的旁边标注有“*”)下将提取反应条件cp和与该提取反应条件建立关联的预测结果存储于第3存储部51c中。

[0166]

设定部16从第3存储部51c读取提取反应条件cp。如此,将经由第3存储部51c从运算段50的第3运算部63输入的提取反应条件cp设定为输入信号,并将提取反应条件cp设定为流动反应装置11中的反应条件。如上所述,检测部17将在提取反应条件cp下进行的流动反应处理的反应结果(以下,称为实测结果)rr输出至判定部56。

[0167]

判定部56从第3存储部51c读取与提取反应条件cp建立关联的预测结果rp,将预测结果rp与从检测部17输入的实测结果rr进行对比,从而求出预测结果rp与实测结果rr的差异度dr。在本实施方式中,通过|rp

‑

rr|/rr的公式来求出差异度dr,但是若求出能够用作预测结果rp的准确性的指标的值,则差异度dr的求出方法并无特别限定。

[0168]

在进行预测结果rp与实测结果rr的对比运算的情况下,判定部56生成对比数据。然后,判定部56具有存储对比数据的对比数据存储部(未图示)。在图9中示出进行对比运算时的对比数据。对比数据以排列了预测结果rp的结果参数与实测结果rr的结果参数的状态的表结构生成。在本实施方式中,设成沿纵栏排列预测结果rp和实测结果rr的状态且沿横栏排列分散度和分子量这两个结果参数的状态,但是纵栏和横栏也可以相反。并且,若在能够读取实测结果rp与实测结果rr的相同的结果参数彼此的状态下存储于对比数据存储部中,则存储方式可以不是表结构。

[0169]

判定部56使用该对比数据并通过前述公式分别求出分子量的差异度dr和分散度的差异度dr。例如,在使用了图9所示的对比数据的情况下,分子量的差异度dr计算为9.9891,分散度的差异度dr计算为3.5107。

[0170]

例如,在本实施方式中,通过设定部16的操作部中的输入而在判定部56中预先输入有差异度的允许范围dt作为操作信号。判定部56判定差异度dr是否在允许范围dt内。另外,在本实施方式中,将允许范围dt设定为1%,但是允许范围能够根据结果参数的种类等适当设定。允许范围dt(单位为%)能够通过(|rp

‑

rr|/rr)

×

100的公式来求出。

[0171]

在判定为差异度dr在允许范围dt内的情况下,判定部56将存储于第3存储部51c中

的预测数据集的反应条件组中的提取反应条件cp设成由流动反应装置11进行以后的流动反应处理的反应条件(以下,称为决定反应条件)cs,并写入第3存储部51。包括将提取反应条件cp作为决定反应条件cs,并且可以将存储于第3存储部51c中的预测数据集的反应条件组作为用于流动反应装置11的流动反应处理中的反应数据集写入第3存储部51c,本实施方式中也如此。

[0172]

在本实施方式中,判定部56以按每个反应条件能够读取反应数据集的状态存储于第3存储部51c中。在本实施方式中,第3存储部51c具有存储预测数据集的区域及存储反应信息数据集的区域,但是在反应数据集中,若以按每个反应条件能够读取的状态存储,则判定部56可以将预测数据集的反应条件组重写为反应数据集。在此情况下,第3运算部63使第3存储部51c以按每个反应条件能够读取的状态预先存储预测数据集。并且,在本实施方式中,将反应条件数据集存储于第3存储部51c中,但是也可以进一步设置第4存储部(未图示)而存储于该第4存储部中。

[0173]

在判定为差异度dr不在允许范围dt内的情况下,判定部56从第3存储部51c读取提取反应条件cp,并生成将提取反应条件cp与实测结果rr建立关联的反应信息。然后,将所生成的反应信息作为新的学习数据写入第1存储部51a。通过该写入,存储于第1存储部51a中的数据集被重写,数据集中所包含的学习数据的数量发生变化。在本实施方式中,存储于第1存储部51a中的初始数据集包含42个学习数据,通过判定部56的1次写入而追加一个反应信息作为学习数据,从而数据集中所包含的学习数据的数量被更新为43个。

[0174]

并且,若数据集的数量被更新,则判定部56更新神经网络70的耦合权重的数量。其中,若将更新后的数据集的数量设为nj且将更新前后的神经网络70的耦合权重的数量分别设为mj

‑

1、mj,则判定部56将神经网络的新的耦合权重的数量mj更新为mj

‑

1≤mj<nj/2。例如,在数据集的数量被更新为43个的情况下,更新前的神经网络的耦合权重的数量mj

‑

1为21,因此更新后的耦合权重的数量mj维持21。

[0175]

另外,关于神经网络70的耦合权重的数量,能够通过增加隐藏层的数量或隐藏层l2中的节点ul的数量来增加。其中,若将隐藏层l2的节点的数量增加一个而成为4个,则耦合权重的总数成为5

×

4 4

×

2=28个。用于满足上述mj

‑

1≤mj<nj/2的关系以成为mj=28的数据集的数量nj的最小值成为57。因此,神经网络70的耦合权重的数量维持21直至数据集的数量成为57为止,若数据集的数量成为57,则通过追加一个隐藏层l2的节点而更新为28个。

[0176]

如上所述,在本实施方式中,第1运算部61在计算模式下重复进行停止状态和第1存储部51a的读入。具体而言,第1运算部61以预先设定的时间间隔读入第1存储部51a的学习数据,并判定上次读入的数据集是否重写为包含新的学习数据的数据集。

[0177]

在第1运算部61判定为存储于第1存储部51a中的数据集未被重写的情况下,运算段50继续计算模式。在判定为被重写的情况下,运算段50将计算模式切换成学习模式,第1运算部61使用被重写的数据集中所包含的新的学习数据进行下一次学习并生成新的函数,从而将存储于第2存储部51b中的函数重写为新的函数。另外,新的函数的生成及新的函数的重写表示函数中的新的权重系数的导出及函数中的权重系数的重写。例如,在前述(1a)及(1b)的函数中,权重系数w

xiu1

被重写为w2

xiul

。由此,生成下述(2a)及(2b)的函数。

[0178][0179][0180]

并且,第2运算部62在生成新的学习数据的情况下也同样地重新生成条件数据集。

[0181]

以下,对在将神经网络70的耦合权重的总数设为m0时,将反应条件的数量设为2

×

m0个以上的意义进行说明。据说为了学习神经网络,学习数据的数量越多越好,但是并不一定如此,并没有明确的定义。但是,需要神经网络能够充分学习程度的数量的学习数据,以便能够表现出对象的现象特征。

[0182]

在图像识别及计算机围棋等中所使用的神经网络中,为了提高正答率,使神经网络的结构复杂化,并使用大量的学习数据来进行学习。例如,在某个脸部识别的神经网络中,耦合权重的总数为1.2亿个,并使用400万个学习数据来进行学习。并且,在某个计算机围棋的神经网络中,耦合权重的总数为300万个,并将3000万个棋局的围棋盘面的数据用作学习数据来进行学习。

[0183]

另一方面,在本发明所涉及的生产过程中,难以生成这种非常大量的学习数据,并且不需要使神经网络的结构复杂化至图像识别及计算机围棋中使用的神经网络。

[0184]

本发明的发明人着眼于波形数据的采样定理而想到了本发明。其中,采样定理为在将模拟信号转换成数字信号时所需的最低频率。在将连续的模拟信号转换成数字信号的情况下,若以模拟信号中所包含的2倍以上的频率进行采样而生成数字信号,则能够完全再现原始模拟信号的形式(频率)。另一方面,在采样的频率小于模拟信号中所包含的频率的2倍的情况下,在原始模拟信号中出现假信号而失真并再现。该现象被称为别名效果。如此,若以模拟信号中所包含的2倍以上的频率进行采样,则能够将模拟信号精确地转换成数字信号。

[0185]

另一方面,在神经网络中,表示使用耦合权重来表现的输入层(说明变量)与输出层(目标变量)的关系的函数能够表示为上述式(1a)、(1b)。该函数类似于如正弦波形那样的波形函数。因此,本发明的发明人通过使用采样定理,想到了如下本发明:为了通过神经网络来表现对象数据的特征,准备耦合权重的总数m0的2倍以上的学习数据。

[0186]

另一方面,在流动反应处理中,若一个反应所需的时间为1小时,则若为耦合权重的数量的10倍程度,则能够通过实测来准备学习数据。例如,若耦合权重的数量为21个,则准备210个学习数据所需的时间成为210小时(约10天),是能够充分允许的时间。因此,在本实施方式中,将学习数据的数量的上限设为耦合权重的总数m0的10倍。

[0187]

接着,对在本实施方式中进行的处理进行说明。图10是表示在本实施方式中进行的处理的流程图。首先,在本实施方式中,设定目标结果ra(步骤st1)。如上所述,本实施方式的目标结果ra的分散度在1.03以内,分子量在25200的

±

1%以内。接着,生成包含多个学习数据的数据集(步骤st2)。目标结果ra的设定及学习数据的生成的顺序也可以相反。

[0188]

图11是表示在本实施方式中进行的学习数据的生成处理的流程图。首先,在将神经网络70的耦合权重的总数设为m0时,数据生成装置13的反应条件设定部52设定2

×

m0个以上的多个反应条件(步骤st21)。然后,反应结果获取部53根据由反应条件设定部52设定的多个反应条件中的每一个获取通过使流动反应装置11进行流动反应处理来导出的反应结果(步骤st22)。而且,生成部54生成包括反应条件与反应结果的组合的42个反应信息即学习数据作为数据集(步骤st23),并结束学习数据的生成处理。另外,数据集存储于第1存储部51a中。

[0189]

辅助装置12将模式设定为学习模式,由此第1运算部61从第1存储部51a读取第1次学习数据的数据集。另外,也可以不设置第1存储部51a(不插入)而从数据生成装置13向第1运算部61输出数据集。以这种方式输入有第1次数据集的第1运算部61根据第1次学习数据的数据集来进行学习反应条件与反应结果的相关性的运算。然后,第1运算部61生成条件参数与结果参数的函数,并将所生成的函数写入第2存储部51b(学习;步骤st3)。

[0190]

函数被写入第2存储部51b之后,辅助装置12将模式从学习模式切换成计算模式,由此第2运算部62从第1存储部51a读取学习数据的数据集。第2运算部62根据数据集中所包含的学习数据的反应条件、具体而言根据各条件参数的值来分配条件参数的值,从而生成由不同的多个反应条件构成的条件数据集(步骤st4)。所生成的条件数据集以按每个反应条件能够读取的状态写入第2存储部51b。

[0191]

在本实施方式中,如上所述,在最大值及最小值以及以相等间隔刻出最大值与最小值之间的值中通过条件参数生成条件数据集。第1原料的流量为100个,第2原料的流量为545个,汇合部的形状为两个,反应路径d32为10个,反应温度为11个,因此条件数据集的反应条件的个数为100

×

545

×2×

10

×

11共11990000个。

[0192]

另外,在辅助装置12能够同时进行学习和计算的情况下,可以同时进行第1运算部61中的学习(即,步骤st3)的处理和第2运算部62中的条件数据集的生成(即,步骤st4)的处理。

[0193]

函数及条件数据集被写入第2存储部51b之后,第3运算部63从第2存储部51b读取这些函数及条件数据集。另外,也可以不设置第2存储部51b(不插入)而从第1运算部61向第3运算部63输出函数,并从第2运算部62向第3运算部63输出条件数据集。以这种方式输入有函数和条件数据集的第3运算部63使用函数并按每个所读取的条件数据集的反应条件计算出预测结果。然后,生成由将反应条件与预测结果建立关联的多个预测信息构成的预测数据集(步骤st5)。第3运算部63将所生成的预测数据集写入第3存储部51c。

[0194]

按每个条件数据集的反应条件计算出预测结果,因此所生成的预测数据集的预测信息的个数与条件数据集的反应条件的个数相同,在本实施方式中为11990000个。

[0195]

第3运算部63通过预先输入的目标结果ra与预测数据集的各预测信息的预测结果的对比来确定表示“最佳的预测结果”的预测信息(步骤st6)。提取所确定的预测信息的反应条件作为提取反应条件cp(步骤st7),包括提取反应条件cp和与提取反应条件cp对应的预测结果rp的预测信息在预测数据集中作为提取反应条件cp和与提取反应条件cp建立关联的预测结果rp写入第3存储部51c。

[0196]

提取反应条件cp被写入第3存储部51c之后,设定部16从第3存储部51c读取提取反应条件cp。另外,也可以不设置第3存储部51c(不插入)而从第3运算部63向设定部16输出提

取反应条件cp。以这种方式输入有提取反应条件cp的设定部16使流动反应装置11、41试行提取反应条件cp下的流动反应处理(步骤st8)。然后,作为试行的反应结果的实测结果rr通过检测部17输出至判定部56。

[0197]

与写入第3存储部51c的提取反应条件cp建立关联的预测结果rp通过判定部56来读取。另外,不插入第3存储部51c而从第3运算部63向判定部56输出预测结果rp。通过以这种方式输入有预测结果rp的判定部56,将预测结果rp与实测结果rr进行对比(步骤st9),从而求出差异度dr。

[0198]

接着,通过判定部56并根据由没定部16预先输入的差异度的允许范围dt(在本实施方式中为1%)来判定差异度dr是否在允许范围dt内(步骤st10)。在判定为差异度dr在允许范围dt内的情况下(步骤st10;“是”),判定部56将提取反应条件cp作为决定反应条件cs写入第3存储部51c,本实施方式的判定部56进一步将存储于第3存储部51c中的预测数据集的反应条件组作为用于流动反应装置11的流动反应处理中的反应数据集写入第3存储部51c(步骤st11)。

[0199]

提取反应条件cp被写入为决定反应条件cs之后,设定部16将流动反应装置11中的反应条件设定为决定反应条件cs,并通过流动反应装置11进行流动反应(步骤st12)。决定反应条件cs为已经判定为可以获得非常接近实测结果rr的反应结果的反应条件,因此可以以目标分子量及分散度获得产物。并且,决定反应条件cs根据本实施方式中的例如11990000个的庞大数量的反应条件并使用运算来求出,并且与以往相比大大缩短流动反应处理的试行及时间。

[0200]

另一方面,在判定为差异度dr不在允许范围dt内的情况下(步骤st10;“否”),判定部56从第3存储部51c读取提取反应条件cp,并生成将提取反应条件cp与实测结果rr建立关联的反应信息。所生成的反应信息包含在存储于第1存储部51a中的数据集中作为学习数据(步骤st13),第1存储部51a的学习数据的数据集被重写为第2次数据集。通过该重写,在第1存储部51a中存储有学习数据的数量比上次数据集多一个的数据集。并且,判定部56将神经网络70的耦合权重的数量更新为mj

‑

1≤mj<nj/2(步骤st14)。然后,重复进行步骤st3~步骤st10的处理,直至步骤st10被肯定为止。

[0201]

图12是表示本实施方式中的神经网络的学习精度的验证结果的图。在图12中,在使用了图4所示的耦合权重的总数为21的神经网络的情况下,将数据集中所包含的学习数据的数量设为250、100、42时的学习精度的指标作为实施例1~实施例3而示出。并且,将数据集中所包含的学习数据的数量设为10时的学习精度的指标作为比较例而示出。作为学习精度的指标,使用了表示根据各例的数据集中所包含的学习数据并通过神经网络可以获得的反应结果的分散度及分子量中的每一个与通过学习数据的反应条件可以获得的实测的反应结果的分散度及分子量中的每一个相关的决定系数r2。在本实施方式中,将决定系数r2为0.8以上时设为合格。如图12所示,比较例的分散度及分子量中的任一个决定系数均不合格。另一方面,实施例1~实施例3的分散度及分子量中的任一个决定系数均合格。因此,通过图12可知,若将学习数据的数量设为神经网络的耦合权重的总数m0的2倍以上,则能够精确地进行神经网络的学习。

[0202]

图13是表示本实施方式中的数据集中所包含的学习数据的数量与神经网络的耦合数的关系的图。在图13中,j为学习的次数,0表示基于初始数据集的学习。如图13所示,在

本实施方式中,在第14次学习结束后,数据集中所包含的学习数据的数量被更新为57,并且神经网络的隐藏层的节点数被更新为4。第14次以后也继续学习,在第70次学习时,差异度dr在允许范围dt内,并在该第70次的提取反应条件下进行了流动反应处理。

[0203]

如此,在本实施方式中,通过适当地设定神经网络的耦合权重的总数m0,能够生成适当数量的学习数据。因此,根据本实施方式,通过使用所生成的数据集,能够效率良好地学习若输入未知的反应条件,则输出与其相对应的反应结果的神经网络。因此,根据本实施方式,能够适当地进行流动反应处理的条件设定。

[0204]

并且,在本实施方式中,在条件参数多的流动反应中能够容易地进行条件设定,因此能够更迅速地开始反应处理,或者即使在由于某些原因而不得不变更多个条件参数之一的情况下,也能够迅速地进行新的反应处理。

[0205]

另外,在上述实施方式中,使用第1原料和第2原料这两个作为原料,但是并不限定于此。原料可以为3种以上。在这种情况下,与原料的数量相对应的流量、与原料的数量相对应的汇合部的形状作为条件参数而被添加到反应条件中。因此,也变更神经网络70的耦合权重的总数及数据集中所包含的学习数据的数量。例如,在使用了三种原料的情况下,汇合部成为两个,并对其分别使用t字形分支的管及十字形分支的管。并且,反应管也使用2种。因此,神经网络70的输入层的节点数成为3(原料数量) 2

×

2(汇合部的数量

×

t字、十字) 2(反应路径) 1(反应温度)=10。若隐藏层的节点数为3而输出层的节点数为2,则神经网络的耦合权重的总数成为10

×

3 3

×

2=36。在这种情况下,初始数据集中所包含的学习数据的数量设定为36

×

2=72以上且36

×

10=360以下。

[0206]

并且,在上述实施方式中,在将神经网络的耦合权重的总数设为m0时,生成包含2

×

m0个以上的学习数据的数据集而进行神经网络的学习,但是并不限定于此。可以设为如下:生成包含任意数量的学习数据的数据集以进行神经网络的学习。

[0207]

并且,在上述实施方式中,将本发明适用于流动反应处理,但是并不限定于此。本发明能够适用于进行产物的产生的各种产生过程。具体而言,能够将本发明适用于日本特开2013

‑

129540号公报中所记载的薄膜输送过程、日本特开2007

‑

52049号中所记载的光学补偿片的制造过程中的光学各向异性层的涂布过程及日本特开2011

‑

006788号公报中所记载的阻气膜的制造过程中的真空成膜过程等。

[0208]

例如,在薄膜输送过程中存在薄膜卷绕工序,作为与流动反应处理中的反应条件对应的过程条件,能够使用(1)薄膜的卷绕张力、(2)卷绕时的张力变更时刻、(3)卷绕速度及(4)空气压力,作为与反应结果对应的产生结果,能够使用(1)卷偏量及(2)黑带。在这种情况下,作为神经网络的结构,输入层的节点数成为4而输出层的节点数成为2。在隐藏层为一层且具有三个节点的情况下,神经网络的耦合权重的总数成为4

×

3 3

×

2=18,因此初始数据集中所包含的学习数据的数量成为36以上且180以下。

[0209]

并且,在光学补偿片的制造过程中的光学各向异性层的涂布过程中,作为过程条件,能够使用(1)设定涂布膜厚度(线速度、线棒编号)、(2)摩擦旋转速度、(3)加热区温度、(4)紫外线照射输出及(5)照射紫外线时的薄膜表面温度,作为产生结果,能够使用(1)延迟的偏差。在这种情况下,作为神经网络的结构,输入层的节点数成为5而输出层的节点数成为1。在隐藏层为一层且具有三个节点的情况下,神经网络的耦合权重的总数成为5

×

3 3

×

1=18,因此初始数据集中所包含的学习数据的数量成为36以上且180以下。

[0210]

并且,在阻气膜的制造过程中的真空成膜过程中,作为过程条件,能够使用(1)原料气体供给流量、(2)施加功率及(3)成膜压力,作为产生结果,能够使用(1)水蒸气透过率。在这种情况下,作为神经网络的结构,输入层的节点数成为3而输出层的节点数成为1。

[0211]

在隐藏层为一层且具有三个节点的情况下,神经网络的耦合权重的总数成为3

×

3 3

×

1=12,因此初始数据集中所包含的学习数据的数量成为24以上且120以下。

[0212]

在上述各实施方式中,运算段50的第1运算部61~第3运算部63以及辅助装置12、数据生成装置13及系统控制器15等执行各种处理的处理部(processing unit)的硬件结构为如下所示的各种处理器(processor)。在各种处理器中包括执行软件(程序)并作为各种处理部而发挥功能的通用的处理器即cpu(central processing unit:中央处理器)、fpga(field programmable gate array:现场可编程门阵列)等在制造后能够变更电路结构的处理器即可编程逻辑设备(programmable logic device:pld)、asic(application specific integrated circuit:专用集成电路)等具有为了执行特定的处理而专门设计的电路结构的处理器即专用电路等。

[0213]

一个处理部可以由这些各种处理器中的一个构成,也可以由相同种类或不同种类的两个以上的处理器(例如,多个fpga或cpu与fpga的组合)构成。并且,可以由一个处理器构成多个处理部。作为由一个处理器构成多个处理部的例,第1有如下方式,即,如以客户端或服务器等计算机为代表,由一个以上的cpu和软件的组合构成一个处理器,且该处理器作为多个处理部而发挥功能。第2有如下方式,即,如以片上系统(system on chip:soc)等为代表,使用由一个ic(integrated circuit:集成电路)芯片实现包括多个处理部的系统整体的功能的处理器。如此,使用一个以上的上述各种处理器来作为硬件结构以构成各种处理部。

[0214]

而且,更具体而言,这些各种处理器的硬件结构为组合了半导体元件等电路元件的电路(circuitry)。

[0215]

符号说明

[0216]

10

‑

流动反应设备,11、41

‑

流动反应装置,12

‑

辅助装置,13

‑

数据生成装置,15

‑

系统控制器,16

‑

设定部,17

‑

检测部,21

‑

第1供给部,22

‑

第2供给部,23、43

‑

反应段,26

‑

回收段,31、42

‑

汇合部,31a~31c

‑

第1管部~第3管部,32

‑

反应部,33

‑

温度调节部,50

‑

运算段,51a~51c

‑

第1存储部~第3存储部,52

‑

反应条件设定部,53

‑

反应结果获取部,54

‑

生成部,56

‑

判定部,61~63

‑

第1运算部~第3运算部,70

‑

神经网络,cp

‑

提取反应条件,cs

‑

决定反应条件,dt

‑

允许范围,dr

‑

差异度,l1

‑

输入层,l2

‑

中间层,l3

‑

输出层,xi、x1~x5

‑

条件参数的值,ul、u1~u3

‑

节点值,ym、y1~y2

‑

结果参数的值,w

xiu1

、w

x1u1

~w

x5u3

、w

ulym

、w

u1y1

~w

u3y2

‑

权重系数,ra

‑

目标结果,rp

‑

预测结果,rr

‑

实测结果。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。