1.本发明涉及编辑支持程序、编辑支持方法和编辑支持装置。

背景技术:

2.已知如下情况:再现包括多个说话人的发言数据的声音数据,用户将每个说话人的发言数据写在文本中,为每个发言数据设定表示说话人的说话人名称。另外,还已知根据声音特征对声音数据进行分类,对分类后的每个声音数据求出任意的说话人识别信息(以上,例如参照专利文献1。)。

3.现有技术文献

4.专利文献

5.专利文献1:日本特开2014-38132号公报

技术实现要素:

6.发明所要解决的课题

7.然而,从声音特征获得的说话人识别信息可能根据说话人的身体状况等而改变。结果,说话人识别信息可能表示错误的说话人。在这种情况下,存在用户在说话人识别信息的编辑处理中花费时间的问题。

8.因此,在1个侧面中,其目的在于提高针对说话人的识别结果的编辑处理的便利性。

9.用于解决课题的手段

10.在1个实施方式中,编辑支持程序使计算机执行如下处理:将表示针对基于声音识别生成的句子识别出的说话人的信息和所述句子中的与识别出的所述说话人对应的区间相关联地显示在显示部上,在发生对所述说话人的识别结果进行编辑的第1编辑处理且相邻的2个以上区间的各说话人因所述第1编辑处理而相同的情况下,将相邻的所述2个以上区间以结合的状态显示在所述显示部上,针对所结合的所述2个以上区间内的特定区间,指定进行编辑所述说话人的识别结果的第2编辑处理的区间的起点,并且,在从所指定的所述起点到所结合的所述2个以上区间的终点之间存在与结合前的所述2个以上区间中的任意1个起点对应的位置的情况下,对从所指定的所述起点到与所述2个以上区间中的任意1个起点对应的位置为止的区间应用所述第2编辑处理。

11.发明效果

12.能够提高针对说话人的识别结果的编辑处理的便利性。

附图说明

13.图1是终端装置的一例。

14.图2是终端装置的硬件结构的一例。

15.图3是终端装置的框图的一例。

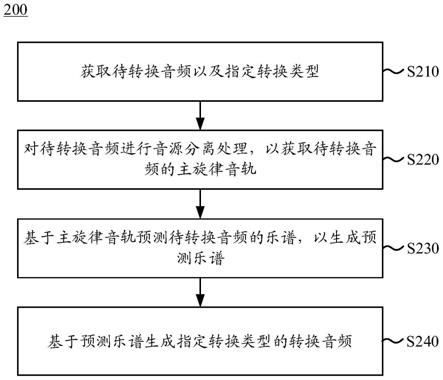

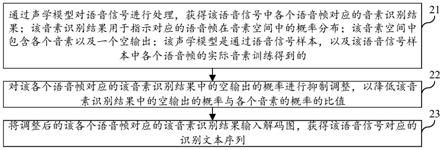

16.图4是表示终端装置的动作的一例的流程图(其1)。

17.图5是表示终端装置的动作的一例的流程图(其2)。

18.图6是门户画面的一例。

19.图7是说话人数据的一例。

20.图8是第1实施方式的更新前的句子数据的一例。

21.图9是编辑支持画面的一例。

22.图10(a)至图10(c)是用于说明实施例的编辑作业的一例的图(其1)。

23.图11是用于说明句子数据的更新例的图。

24.图12(a)至图12(c)是用于说明实施例的编辑作业的一例的图(其2)。

25.图13是划分起点处数据的一例。

26.图14(a)及图14(b)是用于说明实施例的编辑作业的一例的图(其3)。

27.图15是用于说明句子数据的其他更新例的图。

28.图16(a)及图16(b)是用于说明比较例的编辑作业的一例的图。

29.图17(a)是第2实施方式的更新前的句子数据的一例。

30.图17(b)是第2实施方式的更新后的句子数据的一例。

31.图18是编辑支持系统的一例。

具体实施方式

32.以下,参照附图对用于实施本发明的方式进行说明。

33.(第1实施方式)

34.图1是终端装置100的一例。终端装置100是编辑支持装置的一例。在图1中,作为终端装置100的一例而示出了个人计算机即personalcomputer(pc),但也可以是平板终端这样的智能设备。终端装置100具有键盘和指示设备(以下简称为键盘)100f。终端装置100具备显示器100g。显示器100g可以是液晶显示器,也可以是有机electro-luminescence(el)显示器。

35.显示器100g显示各种画面。例如,显示器100g显示编辑支持画面10,其细节将在后面描述。编辑支持画面10是支持对基于声音识别生成的句子识别出的说话人进行编辑的画面。说话人的识别由artificial intelligence(ai:人工智能),也可以不利用ai而利用事先定义的规定的声音模型。

36.利用终端装置100的用户确认显示在编辑支持画面10上的说话人的候选,操作键盘100f从说话人的候选中选择任意1个候选。由此,终端装置100将根据ai等识别出的编辑前的说话人编辑为所选择的候选说话人。因此,用户可以通过使用编辑支持画面10来容易地编辑说话人。另外,在本实施方式中,作为用户的一例,对会议的议事录的制作者进行说明,但用户并不特别限定于这样的制作者。例如,用户也可以是广播字幕的制作者或呼叫中心的声音记录担当者等。

37.接着,参照图2说明终端装置100的硬件结构。

38.图2是终端装置100的硬件结构的一例。如图2所示,终端装置100至少包括作为硬件处理器的central processing unit(cpu)100a、randomaccess memory(ram)100b、readonly memory(rom)100c以及网络i/f(接口)100d。此外,如上所述,终端装置100还包括

键盘100f和显示器100g。

39.而且,终端装置100根据需要也可以包括硬盘驱动器(hdd)100e、输入输出i/f100h,驱动装置100i以及近距离无线通信电路100j中的至少1个。从cpu100a到近距离无线通信电路100j通过内部总线100k相互连接。即,终端装置100可以通过计算机来实现。另外,也可以代替cpu100a而将microprocessing unit(mpu)用作硬件处理器。

40.在输入输出i/f100h上连接半导体存储器730。作为半导体存储器730,例如有universal serial bus(usb)存储器或闪存等。输入输出i/f100h读取存储在半导体存储器730中的程序或数据。输入输出i/f100h例如具备usb端口。便携式记录介质740被插入到驱动设备100i中。作为便携式记录介质740,例如有compactdisc(cd)-rom、digitalversatile disc(dvd)等可移动盘。驱动设备100i读取存储在便携式记录介质740中的程序或数据。近距离无线通信电路100j是实现wi-fi(注册商标)、bluetooth(注册商标)这样的近距离无线通信的电气电路或电子电路。在近距离无线通信电路100j上连接有天线100j'。也可以利用实现通信功能的cpu来代替近距离无线通信电路100j。网络i/f100d例如具备local area network(lan)端口。

41.通过cpu100a将存储在rom100c或hdd100e中的程序临时存储在ram100b中。cpu100a将存储在便携式存储介质740中的程序临时存储在ram100b中。通过cpu100a执行所存储的程序,cpu100a实现后述的各种功能,另外,执行后述的各种处理。另外,程序只要与后述的流程图对应即可。

42.接下来,将参照图3说明终端装置100的功能结构。

43.图3是终端装置100的框图的一例。在图3中示出了终端装置100的功能的主要部分。如图3所示,终端装置100具备存储部110、处理部120、输入部130以及显示部140。存储部110能够通过上述的ram100b、hdd100e来实现。处理部120能够通过上述的cpu100a来实现。输入部130可以由上述键盘100f实现。显示部140可以通过上述显示器100g来实现。因此,存储部110、处理部120、输入部130以及显示部140相互连接。

44.在此,存储部110作为构成要素包括声音存储部111、词典存储部112、句子存储部113、模型存储部114以及点存储部115。处理部120包括第1显示控制部121、声音识别部122、句子生成部123以及说话人识别部124作为构成要素。另外,处理部120包括声音再现部125、说话人编辑部126、点管理部127以及第2显示控制部128作为构成要素。

45.处理部120的各构成要素访问存储部110的各构成要素的至少1个,执行各种处理。例如,声音再现部125在检测到声音数据的再现指示时,访问声音存储部111,取得声音存储部111存储的声音数据。声音再现部125取得声音数据后,再现声音数据。另外,关于其他构成要素,在说明终端装置100的动作时进行详细记载。

46.接着,参照图4至图15,对终端装置100的动作进行说明。

47.首先,如图4所示,第1显示控制部121显示门户画面(步骤s101)。更详细地说,第1显示控制部121当检测到从输入部130输出的门户画面的启动指示时,将门户画面显示在显示部140上。由此,如图6所示,显示部140显示门户画面20。门户式画面20包括第1登记按钮21、第2登记按钮22、第3登记按钮23以及多个第4登记按钮24。

48.第1登记按钮21是登记会议的声音数据的按钮。在登记会议的声音数据的情况下,用户在终端装置100内准备事先录音的会议的声音数据。当用户进行了通过指针pt按下第1

登记按钮21的操作时,第1显示控制部121检测第1登记按钮21的按下。第1显示控制部121在检测到第1登记按钮21的按下时,将在终端装置100内准备的会议的声音数据保存到声音存储部111中。

49.第2登记按钮22是登记与会议资料有关的资料数据的按钮。在登记资料数据的情况下,用户事先在终端装置100内准备会议的资料数据。当用户进行通过指针pt按下第2登记按钮22的操作时,第1显示控制部121检测第2登记按钮22的按下。当第1显示控制部121检测到第2登记按钮22的按下时,将在终端装置100内准备的资料数据显示在门户画面20内的第1显示区域20a中。

50.第3登记按钮23是登记会议参加者的按钮。在登记会议的参加者的情况下,用户进行通过指针pt按下第3登记按钮23的操作。当用户进行了按下第3登记按钮23的操作时,第1显示控制部121检测到第3登记按钮23的按下。第1显示控制部121在检测到第3登记按钮23的按下时,在显示部140上显示用于将会议的参加者登记为说话人的登记画面(未图示)。当用户在登记画面上输入会议中的说话人(具体而言是表示说话人名称的信息)时,第1显示控制部121将包含所输入的说话人的参加者数据显示在门户画面20内的第2显示区域20b中。并且,第1显示控制部121生成说话人id,与所输入的说话人相关联地保存在模型存储部114中。说话人id是识别说话人的信息。由此,模型存储部114将说话人id和说话人相关联地存储。

51.第4登记按钮24均是登记说话人的声音数据的按钮。当登记说话人的声音数据时,用户在终端装置100中准备事先录音的说话人的各种声音数据。也可以在终端装置100上连接麦克风,利用从麦克风取得的声音数据。当用户进行了通过指针pt按下与登记对象的说话人有关的第4登记按钮24的操作时,第1显示控制部121检测第4登记按钮24的按下。第1显示控制部121在检测到第4登记按钮24被按下时,将在终端装置100内准备的声音数据输出到说话人识别部124。

52.说话人识别部124根据从第1显示控制部121输出的说话人的声音数据,生成对说话人的声音特征进行机器学习而得到的学习完成模型。说话人识别部124将所生成的学习完成模型与对应于学习对象的声音数据的说话人的说话人id相关联地保存在模型存储部114中。由此,如图7所示,模型存储部114存储将说话人id、说话人和学习完成模型关联起来的说话人数据。模型存储部114存储了说话人数据后,第1显示控制部121在与登记对象的说话人有关的参加者数据内显示登记标记rm。登记标记rm是表示通过模型存储部114存储了学习完成模型而登记了说话人的声音数据的标记。

53.返回图4,当步骤s101的处理完成时,接下来声音识别部122执行声音识别(步骤s102)。例如,声音识别部122参照声音存储部111,判断声音存储部111是否存储有会议的声音数据。声音识别部122在判断为声音存储部111存储有会议的声音数据时,对声音存储部111存储的会议的声音数据执行声音识别,生成字符串数据。更详细地说,声音识别部122根据会议的声音数据中包含的说话人的声音来确定多个字符,将所确定的字符按时间序列排列并对每个字符赋予字符id和时间代码来生成字符串数据。当声音识别部122生成字符串数据时,将所生成的字符串数据输出到句子生成部123。此外,声音识别部122具备多个声音识别引擎,生成分别对应的字符串数据。作为声音识别引擎,例如有amivoice(注册商标)等。

54.当步骤s102的处理完成时,接着,句子生成部123生成句子数据(步骤s103)。更详细地说,句子生成部123在接收到声音识别部122输出的字符串数据后,参照词典存储部112,对字符串数据执行词素分析。词典存储部112存储词素词典。在词素词典中保存有各种语句。例如,在词素词典中保存有[是]、[确实]、[资料]、[提问]等语句。因此,当句子生成部123参照词典存储部112对字符串数据执行词素分析时,生成将字符串数据分割为多个词块的句子数据。句子生成部123若生成句子数据,则将生成的句子数据与词块单位的标识符关联起来保存到句子存储部113中。因此,句子存储部113存储句子数据。

[0055]

当步骤s103的处理完成时,接下来,说话人识别部124识别说话人(步骤s104)。更详细地说,说话人识别部124参照模型存储部114,比较模型存储部114存储的学习完成模型和声音存储部111存储的会议的声音数据。说话人识别部124对学习完成模型和会议的声音数据进行比较,在会议的声音数据中检测出与学习完成模型对应(例如相同或类似等)的声音部分的情况下,确定与该学习完成模型相关联的说话人id和时间代码。这样,说话人识别部124识别会议的声音数据中包含的各种声音部分的各个说话人。说话人识别部124在确定了说话人id和时间代码后,根据时间代码,将所确定的说话人id与句子存储部113所存储的句子数据相关联起来。由此,如图8所示,句子存储部113存储与说话人id相关联的句子数据。

[0056]

如图8所示,文本数据包括作为构成要素的字符id、字符、词块、时间代码、说话人id(初始)和说话人id(当前)。特别是,在词块中登记词块的识别符。在说话人id(初始)中登记有说话人识别部124最初识别出的说话人的说话人id。在说话人id(当前)中登记有编辑说话人后的说话人id。在说话人识别部124识别出说话人之后,立即在说话人id(初始)和说话人id(当前)登记相同的说话人id。句子存储部113存储这样的句子数据。当赋予每个字符的时间代码与紧前的时间代码相同时,可以省略紧前的时间代码之后的时间代码。

[0057]

当步骤s104的处理完成时,接着,第1显示控制部121显示说话人和发话区间(步骤s105)。更详细地说,当步骤s104的处理完成时,第1显示控制部121中止门户画面20在显示部140上的显示,将编辑支持画面10显示在显示部140上。并且,第1显示控制部121在编辑支持画面10内将说话人和与该说话人对应的发话区间相关联地显示。

[0058]

因此,如图9所示,显示部140显示编辑支持画面10。编辑支持画面10包括脚本区域11、设定区域12、编辑区域13、再现按钮14等。第1显示控制部121根据句子数据和说话人数据,在编辑支持画面10的编辑区域13内关联显示各说话人和与句子中的各说话人对应的发话区间。

[0059]

在脚本区域11中,句子存储部113存储的句子数据的时间代码和字符以相互关联的状态被显示。特别是,在脚本区域11中的脚本栏中,以结合的状态按时间序列显示从说话人id切换的最初的时间代码到该说话人id的连续中断的最后的时间代码的字符。在设定区域12中显示与声音数据的再现形式有关的设定项目、与编辑了说话人后的句子数据的输出形式有关的设定项目等。

[0060]

如上所述,在编辑区域13中相互关联地显示说话人和讲话区间。例如,在编辑区域13内,说话人[小田]与发话区间[

……ですよね

]相关联地显示。同样地,说话人[木村]和发话区间[確

かにはいその

資料

について

質問

が

]相关联地显示。说话人[山田]和发话区间[質問

お

願

いします

]相关联地显示。

[0061]

另外,在编辑区域13中,除了显示说话人和发话区间之外,还显示进度标记16以及切换点17。进度标记16是表示声音数据的当前的再现位置的标记。切换点17是表示词块(图8参照)的切换的点。即,在词块切换为其他词块的2个词块之间的位置处显示切换点17。在本实施方式中,显示了1个切换点17,但例如也可以显示多个切换点,将多个切换点中的1个作为当前的切换点17,赋予与剩余的切换点不同的颜色。由此,用户能够确认在哪个位置处切换词块。

[0062]

切换点17能够根据对输入部130的操作而左右移动。例如,当用户进行按下表示右箭头的光标键的操作时,第1显示控制部121使切换点17向右移动。当用户进行按下表示左箭头的光标键的操作时,第1显示控制部121使切换点17向左移动。另外,在使切换点17向右侧一个方向移动的情况下,也可以将使切换点17移动的键作为空格键。使切换点17移动的键根据设计或实验等适当决定即可。

[0063]

当步骤s105的处理完成时,接着,声音再现部125等待到检测出再现指示(步骤s106:no)。当声音再现部125检测到再现指示时(步骤s106:是),再现声音数据(步骤s107)。更详细地说,当再现按钮14(图9参照)被指针pt按下时,声音再现部125检测出声音数据的再现指示,开始再现声音数据。当声音数据的再现开始时,进度标记16(图9参照)根据声音数据的再现速度向右方向移动。用户再现会议的声音数据并听取该声音,同时移动切换点17,进行确定编辑说话人的位置的操作。

[0064]

当步骤s107的处理完成时,第1显示控制部121等待到指定起点(步骤s108:no)。当第1显示控制部121指定了起点时(步骤s108:是),显示第1编辑画面(步骤s109)。更详细地说,如图10(a)所示,用户先使切换点17移动,在希望说话人编辑的规定位置处停止。当用户在该规定的位置进行例如按下回车(enter)键的操作时,第1显示控制部121判断为该规定的位置被指定为起点。当指定起点时,如图10(b)所示,第1显示控制部121将第1编辑画面30重叠显示在编辑区域13上。第1编辑画面30是向用户请求编辑处理的画面。另外,第1显示控制部121与第1编辑画面30的显示一起,在与该起点对应的发话区间中,确定与位于该起点之前的一个或多个词块相当的一部分发话区间。在本实施方式中,第1显示控制部121确定相当于一个词块[確

かに

]的一部分发话区间。另外,第1编辑画面30的显示和一部分发话区间的特定顺序也可以相反。

[0065]

当步骤s109的处理完成时,说话人编辑部126等待到检测出选择指示(步骤s110:no)。当说话人编辑部126检测到选择指示时(步骤s110:是),如图5所示,对说话人进行编辑(步骤s111)。更详细地说,如图10(b)所示,当用户操作输入部130而进行通过指针pt选择第1编辑画面30中包含的多个说话人中的任一个的操作时,说话人编辑部126检测出选择指示。用户也可以进行通过数字键选择第1编辑画面30中包含的多个数值的任一个的操作。

[0066]

这里,第1编辑画面30中包含的说话人按照与发话顺序和发话量中的至少一方对应的优先顺序来排列配置。例如,假设会议中的主持进行方的说话人的发话顺序大多比其他说话人早,且发话量也多。因此,在第1编辑画面30中,从编辑可能性高的说话人开始依次排列配置。由此,能够抑制说话人的编辑处理的麻烦。

[0067]

说话人编辑部126在检测到选择指示时,判断为发生了编辑处理,对由第1显示控制部121确定的一部分发话区间应用编辑处理,将该一部分发话区间的说话人编辑为所选择的说话人来进行显示。在本实施方式中,说话人编辑部126对与词块[確

かに

]相当的一部

分发话区间应用编辑处理,将该发话区间的说话人[木村]编辑成所选择的说话人[木村]来进行显示。另外,在该例中没有实质性的变更,因此详细的说明在后面叙述。

[0068]

当步骤s111的处理完成时,说话人编辑部126判断说话人是否为相同的(步骤s112)。更具体地,说话人编辑部126判断编辑后的说话人和位于与编辑后的说话人的词块相当的一部分发话区间紧前的发话区间中的说话人是否相同。在本实施方式中,说话人编辑部126判断编辑后的说话人[木村]和位于与编辑后的说话人[木村]的词块[確

かに

]相当的一部分发话区间紧前的发话区间[...

ですよね

]中的说话人[小田]是否相同。在这种情况下,由于说话人[木村]和说话人[小田]不相同,因此说话人编辑部126判断说话人不相同(步骤s112:no)。

[0069]

在说话人不相同的情况下,说话人编辑部126跳过步骤s113以及s114的处理,判断起点后是否处理完成(步骤s115)。在说话人编辑部126判断为起点后未处理完成的情况下(步骤s115:否),如图4所示,第1显示控制部121再次执行步骤s109的处理。即,在最初的步骤s109的处理中,如图10(b)所示,在与通过切换点17确定的起点对应的发话区间中,将相当于位于该起点之前的一个词块[確

かに

]的一部分发话区间作为说话人的编辑处理的对象。但是,在与切换点17所确定的起点对应的发话区间中,相当于位于该起点之后的多个词块[

はいその

資料

について

質問

が

]的剩余的发话区间不作为说话人的编辑处理的对象。因此,说话人编辑部126判断为起点后未处理完成,第1显示控制部121如图10(c)所示,再次将第1编辑画面30重叠显示在编辑区域13上。另外,第1显示控制部121与第1编辑画面30的显示一起,在与该起点对应的发话区间中,确定与位于该起点之后的一个或多个词块相当的剩余的发话区间。在本实施方式中,第1显示控制部121确定相当于多个词块[

はいその

資料

について

質問

が

]的剩余的发话区间。

[0070]

当第2次的步骤s109的处理完成,且在步骤s110的处理中,说话人编辑部126检测到选择指示时,在步骤s111(图5参照)的处理中,说话人编辑部126对说话人进行编辑。更详细地说,如图10(c)所示,当用户再次操作输入部130而进行通过指针pt选择第1编辑画面30中包含的多个说话人中的任一个的操作时,说话人编辑部126检测出选择指示。说话人编辑部126在检测出选择指示时,访问句子存储部113,如图11所示,将与所确定的词块对应的说话人的说话人id(当前)更新为编辑后的说话人的说话人id。当检测到选择指令时,说话人编辑部126确定发生了编辑处理,将编辑处理应用于特定的剩余发话区间,将剩余发话区间中的说话人编辑为所选择的说话人来进行显示。在本实施方式中,说话人编辑部126对与多个词块[

はいその

資料

について

質問

が

]相当的剩余发话区间应用编辑处理,将剩余发话区间的说话人[木村]编辑为所选择的说话人[山田]来进行显示。

[0071]

当步骤s111的处理完成时,在步骤s112的处理中,说话人编辑部126再次判断说话人是否相同。在本实施方式中,说话人编辑部126判断编辑后的说话人[山田]和位于与编辑后的说话人[山田]的多个词块[

はいその

資料

について

質問

が

]相当的剩余的发话区间紧后的发话区间[

はいその

資料

について

質問

が

]的说话人[山田]是否相同。这里,由于2个说话人[山田]是相同的,所以说话人编辑部126判断为说话人是相同的(步骤s112:yes)。

[0072]

如果说话人是相同的,则说话人编辑部126以结合状态显示发话区间(步骤s113)。更详细地说,说话人编辑部126在编将辑后相同的2个说话人的发话区间以结合的状态下进行显示。并且,说话人编辑部126将与结合前的2个发话区间分别对应的2个说话人中的任意

1个与结合后的发话区间对应起来进行显示。由此,说话人编辑部126将与多个词块[

はいその

資料

について

質問

が

]相当的剩余的发话区间和之后的发话区间[質問

お

願

いします

]结合,如图12(a)所示,以将新的发话区间[

はいその

資料

について

質問

が

質問

お

願

いします

]和2个发话区间结合的状态进行显示。另外,将1个说话人与所结合的发话区间对应起来进行显示。这样,说话人被编辑,发话区间被结合。特别是,在对由切换点17确定的起点之前的处理完成后,动态地要求对该起点之后的处理,所以成为沿着时间序列的编辑作业,抑制了编辑作业的麻烦。

[0073]

当步骤s113的处理完成时,接着,点管理部127保存划分起点处(步骤s114)。更详细而言,点管理部127将确定结合发话区间之前的2个发话区间的划分起点处作为划分起点处数据,与该处对应的起点及结合后的发话区间的终点一起保存到点存储部115中。由此,点存储部115存储划分起点处数据。

[0074]

在本实施方式中,如图10(c)所示,结合发话区间之前的2个发话区间的划分起点处相当于发话区间[確

かにはいその

資料

について

質問

が

]与发话区间[質問

お

願

いします

]之间的起点p1。因此,如图13所示,点存储部115将发话区间的末尾的词块[質問

が

]的识别符[08]和发话区间的开头的词块[質問]的识别符[09]相关联起来,作为划分起点处数据进行存储。另外,点存储部115与划分起点处数据的存储一起,存储能够确定与划分起点处对应的起点以及结合后的发话区间的终点的词块的识别符。例如,点数存储部115将词块[確

かに

]的识别符[03]以及词块[

はい

]的识别符[04]作为能够确定起点的词块进行存储。另外,点数存储部115将词块[

します

]的识别符[11]和规定的识别符[-]作为能够确定终点的词块的识别符进行存储。另外,也可以代替词块的识别符,与词块的标识符同样地利用字符id。

[0075]

当步骤s114的处理完成时,再次在步骤s115的处理中,说话人编辑部126判断起点后是否处理完成。在说话人编辑部126判断为起点后完成处理的情况下(步骤s115:是),接着,第2显示控制部128等待到指定其他起点(步骤s116:no)。当第2显示控制部128指定了其他起点时(步骤s116:是),显示第2编辑画面(步骤s117)。更详细地说,如图12(b)所示,当用户使切换点17移动而在与上述规定的位置不同的其他位置停止,并进行按下回车键的操作时,第2显示控制部128判断为该其他位置被指定为起点。当第2显示控制部128指定其他起点时,如图12(c)所示,将第2编辑画面40重叠显示在编辑区域13上。第2编辑画面40是向用户请求编辑处理的画面。第2编辑画面40中包含的说话人与第1编辑画面30同样地排列。另外,第2显示控制部128与第2编辑画面40的显示一起,在与该起点对应的发话区间中,确定与位于该起点之前的一个或多个词块相当的一部分发话区间。在本实施方式中,第2显示控制部128确定相当于一个词块[

はい

]的一部分发话区间。另外,第2编辑画面40的显示和一部分发话区间的特定顺序也可以相反。

[0076]

当步骤s117的处理完成时,说话人编辑部126等待到检测到选择指示(步骤s118:no)。当说话人编辑部126检测到选择指示时(步骤s118:是),编辑说话人(步骤s119)。更详细地说,如图12(c)所示,当用户操作输入部130而进行通过指针pt选择第2编辑画面40中包含的多个说话人中的任一个的操作时,说话人编辑部126检测出选择指示。用户也可以进行通过数字键选择第2编辑画面40中包含的多个数值的任意1个的操作。说话人编辑部126在检测到选择指示时,判断为发生了编辑处理,对所确定的一部分发话区间应用编辑处理,将

该一部分发话区间的说话人编辑显示为所选择的说话人。在本实施方式中,说话人编辑部126对相当于词块[

はい

]的一部分发话区间应用编辑处理,将该一部分发话区间的说话人[山田]编辑为所选择的说话人[山田]并进行显示。另外,在该例中没有实质性的变更,因此详细的说明在后面叙述。

[0077]

当步骤s119的处理完成时,第2显示控制部128再次显示第2编辑画面(步骤s120)。更详细地说,第2显示控制部128如图14(a)所示,将第2编辑画面40重叠在编辑区域13上再次显示。另外,第2显示控制部128与第2编辑画面40的再次显示一起,在与该其他起点对应的发话区间中,将与位于该其他起点之后的一个或多个词块相当的剩余部分的发话区间确定为特定的发话区间。在本实施方式中,第2显示控制部128将与多个词块[

その

資料

について

質問

が

質問

お

願

いします

]相当的剩余的发话区间确定为特定的发话区间。另外,第2编辑画面40的再次显示和剩余的发话区间的特定顺序也可以相反。

[0078]

当步骤s120的处理完成时,说话人编辑部126等待到检测出选择指示(步骤s121:no)。当说话人编辑部126检测到选择指示时(步骤s121:是),点管理部127确定是否存在划分起点处(步骤s122)。具体而言,点管理部127参照点存储部115,判断在点存储部115中是否存储有划分起点处数据。

[0079]

点管理部127在判断为存在划分起点处时(步骤s122:是),说话人编辑部126将说话人编辑到划分起点处(步骤s123),并结束处理。更详细地说,如图14(a)所示,当用户操作输入部130,进行通过指针pt选择第2编辑画面40中包含的多个说话人中的任一个的操作时,说话人编辑部126检测出选择指示。说话人编辑部126在检测出选择指示时,访问句子存储部113。然后,如图15所示,说话人编辑部126对与所确定的词块中的、从其他起点紧后的词块到划分起点处紧前的词块对应的说话人的说话人id(当前)应用编辑处理,将该说话人id更新为编辑后的说话人的说话人id。

[0080]

此外,当检测到选择指示时,说话人编辑部126判断已经发生了编辑处理,将编辑处理应用于特定发话区间,将该特定发话区间中的说话人编辑为所选择的说话人来进行显示。在本实施方式中,说话人编辑部126如图14(b)所示,对与多个词块[

その

資料

について

質問

が

]相当的特定的发话区间应用编辑处理,将该特定的发话区间的说话人[山田]编辑为所选择的说话人[木村]并进行显示。

[0081]

另一方面,当点管理部127判断为不存在划分起点处时(步骤s122:否),说话人编辑部126跳过步骤s123的处理而结束处理。当不存在划分起点处时,说话人编辑部126可以在结束处理之前执行错误处理。

[0082]

图16(a)及图16(b)是用于说明比较例的图。特别是,图16(a)及图16(b)是与上述图14(a)及图14(b)对应的图。如上所述,在第1实施方式中,说明了点管理部127将划分起点处数据保存在点存储部115中进行管理的情况。例如,在没有管理划分起点处数据的情况下,如图16(a)所示,当用户操作输入部130而进行通过指针pt选择第2编辑画面40中包含的多个说话人中的任一个的操作时,说话人编辑部126检测出选择指示。说话人编辑部126在检测到选择指示时,将由第2显示控制部128确定的与多个词块的全部相当的剩余的发话区间的说话人编辑为所选择的说话人并显示。在比较例中,说话人编辑部126如图16(b)所示,将与多个词块[

その

資料

について

質問

お

願

いします

]的全部相当的剩余的发话区间的说话人[山田]编辑为所选择的说话人[木村]来进行显示。因此,导致编辑到说话人没有错误

的多个词块[質問

お

願

いします

]的、就用户而言重新发生对于该部分的编辑作业。但是,根据第1实施方式,不发生这种无用的编辑作业。即,根据第1实施方式,与比较例相比,提高了针对说话人的识别结果的编辑处理的便利性。

[0083]

以上,根据第1实施方式,终端装置100包括处理部120,处理部120包括第1显示控制部121、说话人编辑部126以及第2显示控制部128。第1显示控制部121将表示针对基于声音识别生成的句子数据而识别出的说话人的信息和与句子数据中的与识别出的说话人对应的发话区间相关联地显示于显示部140。说话人编辑部126产生编辑说话人的识别结果的编辑处理,通过该编辑处理,在相邻的2个以上发话区间的各说话人相同的情况下,将相邻的2个以上发话区间以结合的状态显示在显示部140上。第2显示控制部128针对所结合的2个以上发话区间内的特定的发话区间,指定进行编辑说话人的识别结果的编辑处理的发话区间的起点,并且,在从所指定的起点到所结合的2个以上发话区间的终点之间存在与结合前的2个以上区间中的任意1个起点对应的位置的情况下,对从所指定的起点到该处为止的发话区间应用编辑处理。由此,能够提高针对说话人的识别结果的编辑处理的便利性。

[0084]

特别是,在说话人的识别中利用学习完成模型或规定的声音模型,说话人说出短的词块的情况下,有可能无法充分判别说话人的声音的特征,无法高精度地识别说话人。作为短的词块,例如相当于[

はい

]等几个字符程度的词块。当说话人不能被准确地识别时,终端装置100可能显示错误的识别结果。即使在这种情况下,根据本实施例,也可以提高对说话人的识别结果的编辑处理的便利性。

[0085]

(第2实施方式)

[0086]

接着,参照图17说明本发明的第2实施方式。图17(a)是第2实施方式的更新前的句子数据的一例。图17(b)是第2实施方式的更新后的句子数据的一例。在第1实施方式中,说话人编辑部126以一个或多个词块为单位对说话人进行编辑,但也可以以词块中包含的字符为单位对说话人进行编辑。此时,只要以字符为单位移动上述切换点17即可。

[0087]

例如,如图17(a)所示,关于词块的识别符[09]相同的字符[質]以及字符[問],如图17(b)所示,说话人编辑部126将字符[質]的说话人id(当前)从说话人id[03]更新为识别未图示的说话人[香川]的说话人id[04]。在这种情况下,说话人编辑部126分割词块的识别符,并重新赋予词块以后的识别符。具体而言,如图17(b)所示,说话人编辑部126将文字[問]的词块的识别符[09]重新赋予识别符[10]。对于以后的识别符也同样。说话人编辑部126可以基于原始词块的说话时间来估计新词块的发话时间。例如,说话人编辑部126可以将原始词块的说话时间 字符数

×

数毫秒估计为新词块的说话时间。

[0088]

这样,根据第2实施方式,即使在以字符为单位编辑说话人的情况下,也能够提高针对说话人的识别结果的编辑处理的便利性。

[0089]

(第3实施方式)

[0090]

接着,参照图18说明本发明的第3实施方式。图18是编辑支持系统st的一个例子。此外,对与图3所示的终端装置100的各部相同的结构标注相同的附图标记,省略其说明。

[0091]

编辑支持系统st包括终端装置100和服务器装置200。终端装置100和服务器装置200经由通信网络nw连接。作为通信网络nw,例如有local area network(lan)或互联网等。

[0092]

如图18所示,终端装置100具备输入部130、显示部140以及通信部150。另一方面,服务器装置200具备存储部110、处理部120以及通信部160。2个通信部150、160均能够通过

网络i/f100d或近距离无线通信电路100j来实现。这样,也可以代替终端装置100而由服务器装置200具备在第1实施方式中说明的存储部110以及处理部120。即,也可以将服务器装置200作为编辑支持装置。

[0093]

在此情况下,操作终端装置100的输入部130,将上述会议的声音数据经由2个通信部150、160存储在存储部110(更详细地说是声音存储部111)中。另外,操作输入部130,将上述的说话人的声音数据经由2个通信部150、160输入到处理部120(更详细地说是说话人识别部124)。

[0094]

处理部120访问存储部110,取得会议的声音数据,对会议的声音数据执行在第1实施方式中说明的各种处理而生成句子数据。另外,处理部120根据所输入的说话人的声音数据,生成对说话人的声音的特征进行机器学习而得到的学习完成模型。然后,处理部120基于会议的声音数据和学习完成模型来识别说话人。处理部120将编辑支持画面10的画面信息作为处理结果输出到通信部160,该画面信息将识别出的说话人和与该说话人对应的发话区间相关联地显示。通信部160将处理结果发送到通信部150,通信部150接收到处理结果后,将画面信息输出到显示部140。由此,显示部140显示编辑支持画面10。

[0095]

这样,也可以是终端装置100不具备存储部110和处理部120,而服务器装置200具备存储部110和处理部120。另外,也可以是服务器装置200具备存储部110,与通信网络nw连接的其他服务器装置(未图示)具备处理部120。也可以将这样的结构作为编辑支持系统。即使在该实施例中,也可以提高对说话人的识别结果的编辑处理的便利性。

[0096]

以上,对本发明的优选实施方式进行了详述,但并不限定于本发明的特定的实施方式,在权利要求书所记载的本发明的主旨的范围内,能够进行各种变形、变更。例如,在上述实施方式中,说明了连续动态地显示第1编辑画面30的情况。另一方面,也可以用光标键使切换点17移动,通过按下回车键,每次都显示第1编辑画面30。也可以将这样的控制应用于第2编辑画面40。如果没有登记参加者数据,则可以采用识别字符或识别符号来代替说话人作为识别结果。

[0097]

符号说明

[0098]

100 终端装置

[0099]

110 存储部

[0100]

115 点存储部

[0101]

120 处理部

[0102]

121 第1显示控制部

[0103]

122 声音识别部

[0104]

123 句子生成部

[0105]

124 说话人识别部

[0106]

125 声音再现部

[0107]

126 说话人编辑部

[0108]

127 点管理部

[0109]

128 第2显示控制部

[0110]

130 输入部

[0111]

140 显示部

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。