一种基于胶囊自

‑

导协同注意力机制的视觉问答方法

技术领域

1.本发明涉及问答系统、计算机视觉,尤其涉及一种基于胶囊自

‑

导协同注意力机制的视觉问答方法。

背景技术:

2.视觉问答任务通常会向计算机展示一些视觉信息(如图片或视频),并提出关于该视觉信息的问题让计算机回答。根据数据集和具体任务的不同,答案有很多种形式:一个词、一个短语、一个判断(是/否)、从提供的可能选项中选择或是一个填空。如今,随着5g、无人驾驶、ar/vr以及直播带货,短视频等领域的多点开花蓬勃发展,人们需要面对急速膨胀的视觉信息。一直以来,视觉问答都是计算机视觉和多媒体分析的热点。

3.与传统的文本问答相比,视觉问答方法的核心和难点是需要同时处理视觉数据和问题的文本数据。目前,主流的方法是采用协同注意力机制来对多种不同模态的特征进行融合。在仍然存在的问题中,其中之一就是为了追求更高的准确率和更强的性能,各模型的参数量开始剧增,造成了两大缺陷:第一,现有的模型越来越难以训练;第二,在比较小的数据集上,现有的模型容易过拟合。此外,由于深度学习模型的黑盒效应,导致视觉问答任务的可解释性往往难以给出。以上种种,极大限制了现有的视觉问答方法在更大范围内的推广和使用。

4.如何找到有效的方法从给定的视觉数据中获取信息、并结合给定的问题获取答案,是本发明亟待解决的问题。

技术实现要素:

5.为了改善视觉问答任务现有的不足,本发明提出一种基于胶囊自

‑

导协同注意力机制的视觉问答方法,基于胶囊自

‑

导协同注意力机制实现了更紧凑更高效的视觉问答,在一定程度上缓解现有技术存在的模型参数量庞大的问题。

6.本发明的一种基于胶囊自

‑

导协同注意力机制的视觉问答方法,该流程具体包括以下步骤:

7.步骤1,从互联网上下载图像数据,针对每个图像提出问题并给出答案,以此形成<图像,问答>对,构造视觉问答数据集;

8.步骤2,对图像数据进行预处理,然后由检测区域中的图像数据提取图像数据的平均池化卷积特征作为物体特征;该步骤具体包括:针对图像数据,对图像中能检测到的物体的概率设置置信度阈值,将输入图像特征集表示为m表示物体的数量,d

x

表示在x这个集合里每个特征的维度;

9.步骤3,对文本数据进行预处理,然后提取文本数据的深度特征,具体处理如下:

10.所述预处理具体包括:对文本数据进行去分隔词处理、词汇转换成小写、句子裁剪;

11.构成问题中的单词被送入一个300维的glove词嵌入,将词嵌入再送入含有d

y

个隐

藏单元的单层lstm网络,提取单层lstm网络的最后一个隐状态的输出作为整个问题的深度特征;

12.步骤4,进行基于胶囊自

‑

导协同注意力机制学习图像和问题文本的联合表征;该步骤具体包括以下处理:

13.构造两个组件即自注意力组件self

‑

attention和引导注意力组件guided

‑

attention;

14.给定一个输入图像集合特征多头注意力层捕捉成对的输入样本<x

i

,x

j

>之间的配对关系,然后计算出被关注的特征z∈r

n

×

d

;

15.接着,多头注意力层的输出特征被送入前馈神经网络,通过实现动态路由过程学习到联合表征;

16.步骤5,将该联合表征进行进一步多模态融合过程,最终得到预测的答案。

17.与现有技术相比,本发明的一种基于胶囊自

‑

导协同注意力机制的视觉问答方法,自注意力机制和引导注意力机制则这两大组件配合形成的协同注意力机制能够准确获取图像和文本之间的联合表征;改进传统的迭代式多步注意力操作带来的模型参数量庞大的问题;在一定程度上减少了模型的参数量,使得模型更加容易训练,且不容易过拟合。

附图说明

18.图1为本发明的一种基于胶囊自

‑

导协同注意力机制的视觉问答方法整体流程图。

19.图2为动态路由过程的算法模型示意图;

20.图3为本发明实施例的视觉问答效果图;

21.图4为本发明实施例的注意力权重的可视化示意图。

具体实施方式

22.下面结合附图和实施例对本发明的技术方案进行详细说明。

23.针对视觉数据和问题文本数据这两种异构跨模态的数据,本发明实现了自注意力机制通过对所有特征样本与目标特征之间的相似度进行归一化重建,引导注意力机制则通过问题文本的特征来指导图像特征注意力权重的学习。为了改进传统的迭代式多步注意力操作带来的模型参数量庞大的问题,采用胶囊网络中的动态路由思想,将底层注意力看作底层胶囊,将高层注意力看作高层胶囊,用一种动态的、紧凑的单步路由过程取代传统的多步迭代过程。在本发明中,构建了两个基础的注意力部件,通过一种特殊的动态路由过程,将其组合成协同注意力。在该动态路由过程中,低层的注意力被视作低层胶囊,高层的注意力被视作高层胶囊,以此在单步过程中完成多步注意力操作。本发明的创新之处在于采用胶囊网络的思想改进视觉问答方法中的注意力模块,使得模型更紧凑,在一定程度上减少了模型的参数量。

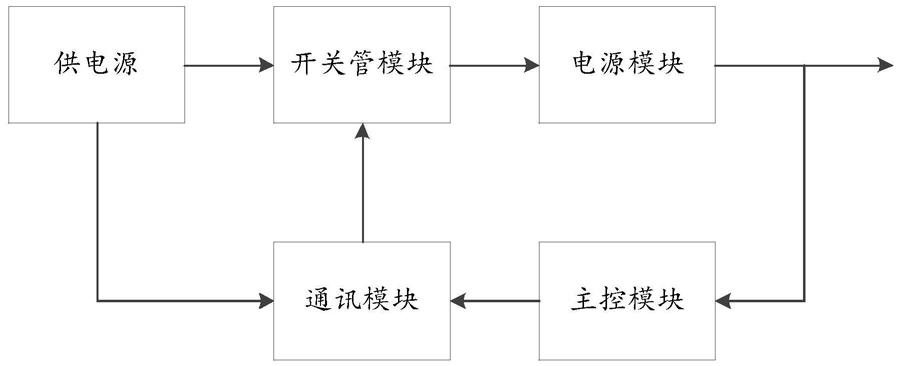

24.如图1所示,为本发明的一种基于胶囊自

‑

导协同注意力机制的视觉问答方法总体框架流程图,该流程具体包括以下步骤:

25.步骤1,从互联网上下载图像数据,针对每个图像提出问题并给出答案,以此形成<图像,问答>对,构造视觉问答数据集;

26.具体实施例如下:

27.1.1、在实施例中选择vqa 2.0数据集。数据集中的图像构成图像集合img={img1,img2,...,img

m

},其中m表示该数据集中图像的总数;

28.1.2、针对每张图像,存在若干个问答对。图像img

i

所对应的问答对为所对应的问答对为其中n表示该图像对应问答对的个数;

29.1.3、通过图像数据集img和其对应的问答对qa组成<图像,问答对>,构建视觉问答数据集;

30.步骤2,对图像数据进行预处理,然后提取图像数据的深度卷积特征;

31.具体实施例如下:

32.2.1、本实施例选择faster r

‑

cnn网络作为所要使用的图像特征提取网络,其特征维度为2048;

33.2.2、根据选定的图像特征提取网络的特点,将图像数据集缩放成224

×

224分辨率;

34.2.3、使用在visual genome数据集上预训练过的模型;

35.2.4、针对图像数据集,对图像中能检测到的物体的概率设置了一个置信度阈值,进而得到一个模糊的物体数量。物体的数量m∈[10,100]。对于第i个物体,其特征特征该特征由其检测区域中的平均池化卷积特征得到。由此,将输入的图像集合的特征表示为d

x

表示在x这个集合里每个特征的维度。

[0036]

步骤3,对文本数据进行预处理,然后提取文本数据的深度特征;

[0037]

具体实施例如下:

[0038]

3.1、对文本数据进行去分隔词处理,将所有词汇转换成小写形式;把句子裁剪成不超过14个单词;

[0039]

3.2、问题中的每个词被送入一个300维的glove词嵌入,该glove词嵌入是事先在大规模语料库中预训练过的。每个输出向量就是一个词的特征,共构成了一个大小为s

×

300的单词序列。s表示问题中的单词个数,其范围是s∈[1,14];

[0040]

3.3、将词嵌入送入含有d

y

个隐藏单元的单层lstm网络,取最后一个隐状态的输出作为整个问题的特征。在本实施例中设置其隐藏状态的大小为512,故问题的特征维度为512维;

[0041]

步骤4,基于胶囊自

‑

导协同注意力机制学习图像和问题文本的联合表征;

[0042]

具体实施例如下:

[0043]

4.1、以一张图像以及对应该图像的一个问题为例,设获得的整个问题特征为y,该图像所获得的图像特征是一个集合,其某一个局部特征为x

i

∈x

1,

...,x

n

,n表示局部特征的个数;

[0044]

4.2、构造两个组件:自注意力组件self

‑

attention和引导注意力组件guided

‑

attention。自注意力组件有两个子层,分别是多头注意力层和前馈神经网络层组成。而这两个子层,其每个子层后都加了一个残差连接(residual connection)和归一化(normalization);

[0045]

给定一个输入特征的集合多头注意力捕捉成对的输入样

本<x

i

,x

j

>之间的配对关系,然后提过对x中所有实例的加权求和,计算出被关注的特征z∈r

n

×

d

。z∈r

n

×

d

的具体含义:z是被关注的特征集合,该集合中的元素都是实数(集合z是个实数集);n表示集合中元素的个数,在这里,n由输入集合x=[x1,...,x

n

]来决定;而d表示集合z中每个元素的维度。多头注意力层的输出特征接着被送入前馈神经网络,该前馈神经网络由两层全连接层和relu函数和dropout组成(fc(4d)

‑

relu

‑

dropout(0.1)

‑

fc(d))。除此之外,为了促进优化效果,增加了带有layer normalization的残差连接。

[0046]

引导注意力组件和自注意力组件十分类似。相应地,引导注意力部件取两组输入特征和也就是说,自注意力的q,k,v三者相等,而引导注意力不是。一般说来,y用来帮助引导x的注意力学习。这两组输入特征x和y具有它们各自不同的,灵活的形状。引导注意力部件分别学习x和y的每个配对样本<x

i

,y

i

>之间的配对关系。

[0047]

4.3、如图2所示,为动态路由过程的算法模型示意图。动态路由过程如下,:

[0048]

初始化映射矩阵w

x

和w

y

,目的是将问题文本向量和图像特征向量集合映射到同一个空间维度,此时获得和y

p

,即

[0049][0050]

y

p

=w

y

·

y

[0051]

其中,表示映射后的问题文本向量,y

p

表示映射后的图像特征向量,x

i

表示集合x里的第i个元素,即第i个图像特征,y表示问题的文本特征向量,n表示输入的图像特征集x中的元素个数;

[0052]

分别对映射后的问题文本向量和图像特征向量使用自注意力机制,即

[0053][0054]

y

p

=selfattention(y

p

)

[0055]

其中,selfattention()表示自注意力函数,

[0056]

用映射后的问题文本向量得到胶囊的输出的初始化向量v0,即

[0057]

v0=y

p

[0058]

其中,v0表示v的初始值,即胶囊的输出的初始值,v表示胶囊的输出向量。

[0059]

进入循环体,设循环次数为n,t∈[1,n];

[0060]

令t=0;

[0061]

计算耦合系数c

i

=softmax(b

i

);

[0062]

其中,b

i

表示内部变量;

[0063]

计算加权求和后的图像特征

[0064]

其中,x表示输入的图像特征集合,x

i

表示集合x里的第i个元素,即第i个图像特征,表示映射后的第i个图像特征,y表示问题的文本特征向量,y

p

表示映射后的文本特征向量,c

i

表示在参考向量y的引导下,特征向量集中每个向量x

i

的权重参数,由模型习得并由动态路由协同注意力算法更新,c

i

∈c1,...,c

n

;

[0065]

将此时胶囊的输出与加权求和后的图像特征送入引导注意力组件,以此来更新胶

囊下一次的输出v

t

表示在路由协同注意力算法中胶囊的输出,即,参考向量集合和特征向量的联合表示。t是当前的迭代次数。

[0066]

更新内部变量

[0067]

结束循环体,获得胶囊最终的输出v;最终的v就表示参考向量和特征向量的联合表征。

[0068]

步骤5,将学到的联合表征进行拆分再学习,以获得更为精简的联合表征,并通过该联合表征预测出合适的答案;

[0069]

5.1、输入图像x和y的联合分布[x,y]

(t)

,;将其拆分成两部分x

(t)

和y

(t)

。;

[0070]

5.2、将这两部分分别送入两层的多层感知机(multi

‑

layer perceptron,简称mlp),来分别获得各自的有效特征x

attd

和y

attd

:

[0071]

α=softmax(mlp(x

(t)

))

[0072]

β=softmax(mlp(y

(t)

))

[0073][0074][0075]

其中,x

(t)

、y

(t)

表示输入图像x和y的联合分布根据路由过程的迭代次数拆分出来的两部分结果,t表示路由过程的迭代次数,t∈[1,n],这里的x

(t)

和y

(t)

并不是图像和问题各自的特征,而是互相融合了对方一些冗余信息的特征,mlp()表示多层感知函数,softmax()表示激活函数,表示y

(t)

中的第i个元素;和分别是x

(t)

、y

(t)

中的第i个元素。在计算过程中属于中间变量,最终的目的是计算出各自的有效特征x

attd

和y

attd

。这里α

i

和β

i

分别表示对两种特征进行加权求和时的权重,是获得最终结果的中间参数。

[0076]

5.3、再采用线性模型来融合两个特征,融合后的有效联合分布由以下表达式计算得到:

[0077][0078]

其中,w

x_attd

和w

y_attd

表示参考向量和特征向量集这两个线性投影矩阵,由模型习得并通过bp算法更新,使用layernorm来让训练过程更稳定,z表示后的有效联合分布,layernorm的全称是layer normalization,layernorm()表示适用于rnn等时序网络的归一化方法,分别表示w

x

和w

y

两个矩阵的转置。

[0079]

融合后的特征z被送入一个sigmoid函数用以投影成一个向量z

proj

∈r

k

,其中k表示训练集中最频繁答案的个数,在本实施例中,设置训练集中候选答案为3129个。使用adam优化器,其参数为:α=0.001,β1=0.9,β2=0.999。设置初始学习率为min(2.5ke

‑5,1e

‑4),其中k表示现在的epoch数。每训练2500步之后,学习率减半。训练过程中,设置的损失函数loss表达式如下:

[0080][0081][0082]

其中,p

i

表示第i类的概率分布。

[0083]

如图4所示,本发明实施例的注意力权重的可视化示意图。注意力图纵轴上的0

‑

15表示图像中的每个候选框,横轴表示问题中的每个单词。为了达到更好的视觉效果,用不同颜色的bounding box框出了图像中的六个物体,它们与答案(即“motorcycles”)有关。当把纵轴看作常量,即假设输入特定的图像信息,那么纵轴对应的每一个横轴上的数字都可以看作是问题对问题自己的自注意力。横向遍历横轴对应的每一个值,可以发现“how”和“many”获得了相对较高的注意力得分,表明模型通过上下文关系和短语的固定搭配,知道这是一个计数任务。而“motorcycles”这一列取得了最高的得分,表明模型通过问题的自注意力正确识别了问答的关键词。当把横轴看作常量,即假设单词的特征已经确定,那么横轴对应的每个纵轴上的值都可以看作是图像中的某个局部对该局部的自注意力。纵向遍历纵轴对应的每个值,可以发现第3、第7、第8、第10、第11和第15取得了最大的注意力得分。它们正好对应于图像的六辆摩托车各自boundingbox的编号。而在问题对图像的引导注意力之后,最后得到的联合分布中,由横轴上的“motorcycles”和纵轴上的3,7,8,10,11,15所定位的特征图块取得了最高的得分。这说明所有被关注的图像特征都倾向于使用“摩托车”这一特征进行重建。该联合分布显示,输入的图像特征被问题特征中的“motorcycles”这一个词所重构。换言之,经过问题特征的引导,该模型对图像特征有了更好的关注。

[0084]

应当理解的是,上述针对具体实施例的描述较为详细,但不能因此而理解为对本发明专利保护范围的限制,本发明的专利保护范围应以所附权利要求为准。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。