1.本发明涉及信息检索与推荐领域,具体涉及一种文本信息推荐方法、装置及可读介质。

背景技术:

2.社交网络已经成为了人们日常社交的主要渠道之一,微博等作为新兴一代的社交网络平台,有效改善了传统媒体扁平化、维度单一等缺点,因此深受广大网络用户的喜爱。面对网络上形形色色的海量数据,让人应接不暇,更无法及时消化,信息过载的问题成为网络时代网民们的主要困扰之一。要在合适的时间,通过合适的渠道,把合适的内容,推送给合适的用户,信息推荐就是一种有效缓解信息过载的方法。推荐系统本质上是一种信息过滤系统,面对海量数据时,推荐算法主动将用户不太可能会发生行为的信息过滤,只保留用户可能感兴趣的内容。常见的推荐方法都是先通过分析数据获取候选集,然后基于召回结果对候选集进行排序,最后根据排序结果对用户进行个性化信息推荐。文本推荐与物品推荐的不同在于,用户不仅有丰富的属性和文本特征数据,还有复杂的社交关系和互动行为,这确实为推荐算法提供了大量的额外信息,但同时也带来了巨大的挑战。

3.其中微博内容是一种社交短文本,具有更新快、信息含量稀疏、用词不规范等特点,要从嘈杂的数据中提取用户的有效特征,再加上涉及用户隐私的数据不能公开,相关数据信息因此变得有限,微博推荐领域的公开数据集也较为稀缺。所以亟需在有限的数据信息中寻找一种合适的方法,尽可能多地挖掘出用户的潜在特征,同时使用的算法必须对训练数据的这些特征具有鲁棒性。

技术实现要素:

4.针对上述提到的技术问题。本技术的实施例的目的在于提出了一种文本信息推荐方法、装置及可读介质,来解决以上背景技术部分提到的技术问题。

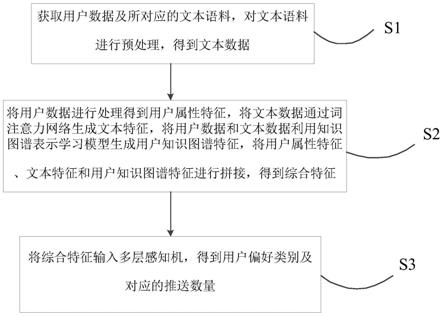

5.第一方面,本技术的实施例提供了一种文本信息推荐方法,包括以下步骤:

6.s1,获取用户数据及所对应的文本语料,对文本语料进行预处理,得到文本数据;

7.s2,将用户数据进行处理得到用户属性特征,将文本数据通过词注意力网络生成文本特征,将用户数据利用知识图谱表示学习模型生成用户知识图谱特征,将用户属性特征、文本特征和用户知识图谱特征进行拼接,得到综合特征;

8.s3,将综合特征输入多层感知机,得到用户偏好类别及对应的推送数量。

9.在一些实施例中,对文本语料进行预处理包括文本清洗、分词、去停用词和数据过滤。

10.在一些实施例中,步骤s2中的将用户数据进行处理得到用户属性特征具体包括:

11.针对用户数据中的离散型数据通过整数编码的方式得到稠密的向量表示的离散型数据集合;

12.针对所用户数据中的连续数据通过线性函数归一化得到连续型数据集合;

13.将离散型数据集合和连续型数据集合拼接得到用户属性特征。

14.在一些实施例中,步骤s2中的将文本数据通过词注意力网络生成文本特征具体包括:

15.在文本数据的第i个句子s

i

中总共有t个词,其分词序列表示为{w

1i

,w

2i

,

…

,w

it

},将分词序列转换成词向量表示:

16.x

it

=w

e

w

it

,t∈[1,t];

[0017]

其中,w

e

表示一个嵌入矩阵;

[0018]

将词向量表示利用双向gru网络结合正向、反向的上下文信息,通过隐藏层输出结果,得到w

it

在整个句子中正反两个方向的词向量表示:

[0019][0020][0021][0022]

通过注意力机制提取句子中词级别最重要的特征作为文本特征。

[0023]

在一些实施例中,将h

it

作为单层感知机的输入,获取其潜在特征表示:

[0024]

u

it

=tanh(w

w

h

it

b

w

);

[0025]

其中,w

w

表示权重,b

w

表示偏置向量,根据计算得到的潜在特征表示u

it

和一个随机初始化的上下文向量u

w

的相似度,挖掘出词w

it

的重要程度,其中上下文向量u

w

是在训练网络的过程中联合学习得到,通过softmax函数生成注意力权重矩阵α

it

,代表句子s

i

中第t个词的权重:

[0026][0027]

将词向量表示进行加权求和,得到句子s

i

的向量表示:

[0028][0029]

根据句子s

i

的向量表示得到整个文本的向量表示:

[0030]

v=[s1,s2,

…

,s

i

]∈r

i

×

n

;

[0031]

式中,i表示用户的总文本数量,n表示整个文本的向量维度。

[0032]

在一些实施例中,步骤s2中的将用户数据利用知识图谱表示学习模型生成用户知识图谱特征具体包括:

[0033]

将用户数据利用随机方式初始化实体和关系的嵌入表示,其中实体为用户信息,关系为用户关注关系,知识图谱表示学习模型的训练过程中的每次迭代都对实体进行规范化处理;从训练集中采样出小批量正例三元组集合,基于伯努利抽样算法对训练集进行负采样处理,得到负例三元组集合,具体为:对知识图谱中每一个关系r的三元组,计算出每个头实体对应尾实体数量的平均值r

tph

以及每个尾实体对应头实体数量的平均值r

hpt

,定义一个参数为p的抽样方法:

[0034]

[0035]

针对三元组(h,r,t)构建负例三元组集合,用概率p替换头实体,概率1

‑

p替换尾实体;

[0036]

优化训练目标,采用随机梯度下降算法不断迭代更新参数,当知识图谱表示学习模型收敛或达到最大迭代次数时停止训练,其中,定义所有样本的损失函数:

[0037]

l=∑

(h,r,t)∈s(h,r,t)

∑

(h',r,t')∈s'(h,r,t)

[f

r

(h,t) γ

‑

f

r

(h',t')]

;

[0038]

式中,s(h,r,t)表示知识图谱中的正例三元组集合,s'(h,r,t)表示负例三元组集合,[x]

表示当x大于0时取原值,x小于0时取0;γ表示正例三元组集合和负例三元组集合之间的边界值;

[0039]

将用户知识图谱中的实体和关系信息全部映射到同一个d维的向量空间中,最终可得到所有实体的向量表示:

[0040]

e=kge(e1,e2,

…

,e

v

)∈r

v

×

d

;

[0041]

式中,e

v

表示实体v的特征向量表示,v表示总共的实体数量。

[0042]

在一些实施例中,步骤s3具体包括:将综合特征输入深度神经网络进行模型训练,通过softmax函数对输出向量进行变换,得到用户偏好类别z的概率:

[0043][0044]

式中,x

z

表示输出向量中的第z个值,x

s

表示输入向量的所有值,t表示文本的总类别数,根据概率值大小对类别进行排序,基于打散策略的思想,选取得分最高的若干条多个类别的文本作为最终的推荐结果,假定n为文本推送总数,根据概率p

z

计算类别z的推送数量:

[0045]

n

z

=n

×

p

z

。

[0046]

第二方面,本技术的实施例提供了一种文本信息推荐装置,包括:

[0047]

预处理模块,被配置为获取用户数据及所对应的文本语料,对文本语料进行预处理,得到文本数据;

[0048]

综合特征生成模块,被配置为将用户数据进行处理得到用户属性特征,将文本数据通过词注意力网络生成文本特征,将用户数据利用表示学习生成用户知识图谱特征,将用户属性特征、文本特征和用户知识图谱特征进行拼接,得到综合特征;

[0049]

类别推送模块,被配置为将综合特征输入多层感知机,得到用户偏好类别及对应的推送数量。

[0050]

第三方面,本技术的实施例提供了一种电子设备,包括一个或多个处理器;存储装置,用于存储一个或多个程序,当一个或多个程序被一个或多个处理器执行,使得一个或多个处理器实现如第一方面中任一实现方式描述的方法。

[0051]

第四方面,本技术的实施例提供了一种计算机可读存储介质,其上存储有计算机程序,该计算机程序被处理器执行时实现如第一方面中任一实现方式描述的方法。

[0052]

与现有技术相比,本发明具有如下有益效果:

[0053]

本发明通过利用知识图谱表示学习为用户引入更多的结构信息和语义关系,加强对用户兴趣的识别度和扩展性,从而提高推荐结果的准确性和多样性。另一方面,鉴于深度学习优异的自动提取特征的能力,通过学习用户的综合特征可得到多个维度的抽象特征表

示,在一定程度上缓解了传统个性化信息推荐中的数据稀疏、冷启动等问题。同时,将注意力机制应用到文本推荐,有助于从文本中识别出最具有信息量的词,帮助推荐系统抓取出最重要的特征,进一步提高推荐结果的准确度。

附图说明

[0054]

为了更清楚地说明本发明实施例中的技术方案,下面将对实施例描述中所需要使用的附图作简要介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域的普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

[0055]

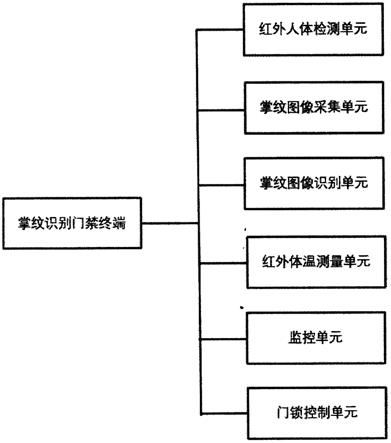

图1是本技术的一个实施例可以应用于其中的示例性装置架构图;

[0056]

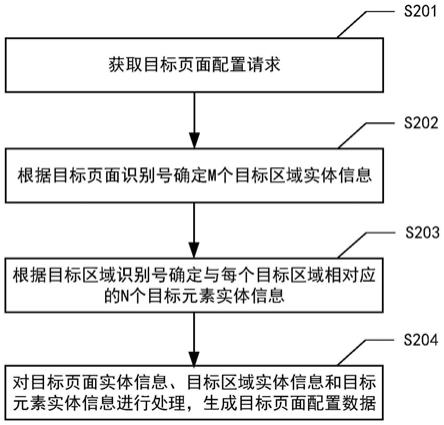

图2为本发明的实施例的微博文本信息推荐方法的示意图;

[0057]

图3为本发明的实施例的文本信息推荐方法的流程示意图;

[0058]

图4为本发明的实施例的文本信息推荐方法的transe模型图;

[0059]

图5为本发明的实施例的文本信息推荐方法的注意力网络的示意图;

[0060]

图6为本发明的实施例的文本信息推荐装置的示意图;

[0061]

图7为本发明的实施例的文本信息推荐方法的部分微博用户的知识图谱;

[0062]

图8为本发明的实施例的文本信息推荐方法与对比例中不同方法的总体性能对比图;

[0063]

图9是适于用来实现本技术实施例的电子设备的计算机装置的结构示意图。

具体实施方式

[0064]

为了使本发明的目的、技术方案和优点更加清楚,下面将结合附图对本发明作进一步地详细描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其它实施例,都属于本发明保护的范围。

[0065]

图1示出了可以应用本技术实施例的文本信息推荐方法或文本信息推荐装置的示例性装置架构100。

[0066]

如图1所示,装置架构100可以包括终端设备101、102、103,网络104和服务器105。网络104用以在终端设备101、102、103和服务器105之间提供通信链路的介质。网络104可以包括各种连接类型,例如有线、无线通信链路或者光纤电缆等等。

[0067]

用户可以使用终端设备101、102、103通过网络104与服务器105交互,以接收或发送消息等。终端设备101、102、103上可以安装有各种应用,例如数据处理类应用、文件处理类应用等。

[0068]

终端设备101、102、103可以是硬件,也可以是软件。当终端设备101、102、103为硬件时,可以是各种电子设备,包括但不限于智能手机、平板电脑、膝上型便携计算机和台式计算机等等。当终端设备101、102、103为软件时,可以安装在上述所列举的电子设备中。其可以实现成多个软件或软件模块(例如用来提供分布式服务的软件或软件模块),也可以实现成单个软件或软件模块。在此不做具体限定。

[0069]

服务器105可以是提供各种服务的服务器,例如对终端设备101、102、103上传的文

件或数据进行处理的后台数据处理服务器。后台数据处理服务器可以对获取的文件或数据进行处理,生成处理结果。

[0070]

需要说明的是,本技术实施例所提供的文本信息推荐方法可以由服务器105执行,也可以由终端设备101、102、103执行,相应地,文本信息推荐装置可以设置于服务器105中,也可以设置于终端设备101、102、103中。

[0071]

应该理解,图1中的终端设备、网络和服务器的数目仅仅是示意性的。根据实现需要,可以具有任意数目的终端设备、网络和服务器。在所处理的数据不需要从远程获取的情况下,上述装置架构可以不包括网络,而只需服务器或终端设备。

[0072]

本技术的实施例中以微博作为示例对文本信息推荐方法、装置及可读介质进行具体说明,如图2所示。在其他可选的实施例中,若存在于微博类似的社交短文本平台,同样也适用于本发明的文本信息推荐方法、装置及可读介质。

[0073]

图3示出了本技术的实施例提供的一种文本信息推荐方法,包括以下步骤:

[0074]

s1,获取用户数据及所对应的文本语料,对文本语料进行预处理,得到文本数据。

[0075]

在具体的实施例中,首先对微博语料中所有的用户和文本数据进行整合,并对微博内容进行文本预处理,包括文本清洗、分词、去停用词和数据过滤。对初始语料进行一系列预处理,主要包括文本清洗、结巴分词、去停用词等。利用正则表达式和停用词表(百度停用词表、中文停用词表、哈工大停用词表和四川大学机器智能实验室停用词表)过滤掉数据中的表情符号、相同词、分词后数据为空以及预处理后词数小于3的文本,还有一些常出现但无意义的词语,比如“转发微博”、“分享图片”、“repost”等,最终得到可用的文本数据。

[0076]

s2,将用户数据进行处理得到用户属性特征,将文本数据通过词注意力网络生成文本特征,将用户数据和文本数据利用知识图谱表示学习模型生成用户知识图谱特征,将用户属性特征、文本特征和用户知识图谱特征进行拼接,得到综合特征。

[0077]

知识图谱中的实体和关系都可以用来对用户进行刻画,丰富特征向量所包含的信息。将用户的知识图谱特征引入推荐系统中,进而增强对用户的属性挖掘。利用表示学习技术,在保留用户本身语义信息的基础上,提取知识图谱中用户的行为关系等信息,并通过低维稠密的实值向量表示出来,便于引入推荐算法中,完善用户的多维度特征,提高推荐的准确率。利用具有丰富语义信息的对象补充稀疏语义对象的表示,进而提高该类表示的精确性。这种表示方法不仅便于计算实体与关系之间的语义关联,量化它们之间的语义紧密程度,并且有助于缓解数据稀疏的问题,同时还可以增加推荐的多样性和可解释性。

[0078]

在具体的实施例中,步骤s2中的将用户数据进行处理得到用户属性特征具体包括:

[0079]

针对用户数据中的离散型数据通过整数编码的方式得到稠密的向量表示的离散型数据集合;

[0080]

针对所用户数据中的连续数据通过线性函数归一化得到连续型数据集合;

[0081]

将离散型数据集合和连续型数据集合拼接得到用户属性特征。

[0082]

具体地,用户数据中针对用户属性中省份、所在地、性别等离散型数据,可通过整数编码的方式得到稠密的向量表示,即利用唯一的整数数字,对每个词进行编码。而对于数据集中的粉丝数、关注数、微博数等连续型数据,可利用线性函数归一化的方法处理,将数值缩放到[0,1]内:

[0083][0084]

式中x为原始数据,x

max

和x

min

为数据中的最大值和最小值。

[0085]

最终可得到用户u的用户属性特征表示:

[0086]

u=concatenate(lookup(i),norm(j));

[0087]

式中,concatenate()是向量拼接操作,lookup(i)表示被整数编码的离散型数据集合,norm(j)表示被归一化的连续型数据集合。

[0088]

在具体的实施例中,基于这样一个假设,一个句子中并非所有的单词都对句子的本身含义具有同等的相关性,不同的词具备不同的信息量。通过注意力机制(attention)可以将一个句子中贡献最大、最能体现句子本身含义的词找出来,根据确定的相关信息与关键词的交互作用进行建模,再将这些关键词汇信息组合起来作为这个句子的向量表示。结构如图4所示。

[0089]

步骤s2中的将文本数据通过词注意力网络生成文本特征具体包括:

[0090]

将所有的微博文本看作一个文档,其中的每一条微博文本作为文档中的一个句子。在文本数据的第i个句子s

i

中总共有t个词,其分词序列表示为{w

1i

,w

2i

,

…

,w

it

},将分词序列转换成词向量表示:

[0091]

x

it

=w

e

w

it

,t∈[1,t];

[0092]

其中,w

e

表示一个嵌入矩阵;

[0093]

将词向量表示利用双向gru网络结合正向、反向的上下文信息,通过隐藏层输出结果,得到w

it

在整个句子中正反两个方向的词向量表示:

[0094][0095][0096][0097]

通过注意力机制提取句子中词级别最重要的特征作为文本特征。

[0098]

然后,通过attention提取句子中词级别最重要的特征。先利用字级向量构建句子级向量,再把各个句子向量组合成文档向量。在具体的实施例中,将h

it

作为单层感知机的输入,获取其潜在特征表示:

[0099]

u

it

=tanh(w

w

h

it

b

w

);

[0100]

其中,w

w

表示权重,b

w

表示偏置向量,根据计算得到的潜在特征表示u

it

和一个随机初始化的上下文向量u

w

的相似度,挖掘出词w

it

的重要程度,其中上下文向量u

w

是在训练网络的过程中联合学习得到,将它作为询问“哪些词包含了比较重要的信息”的一种抽象表示。通过softmax函数生成注意力权重矩阵α

it

,代表句子s

i

中第t个词的权重:

[0101][0102]

获得注意力权重矩阵后,将句子向量视为组成这些句子的词向量的加权求和,得到句子s

i

的向量表示:

[0103][0104]

根据句子s

i

的向量表示得到整个文本的向量表示:

[0105]

v=[s1,s2,

…

,s

i

]∈r

i

×

n

;

[0106]

式中,i表示用户的总文本数量,n表示整个文本的向量维度。

[0107]

在具体的实施例中,知识图谱通常以图结构的方法表示:g=(v,e),其中v表示实体集合,e表示边集合。知识图谱中存在大量关系三元组(h,r,t),包含了通过多个种类关系链接的实体以及实体与属性、属性值,其中h,t∈v分别表示头实体和尾实体,r∈e表示这两个实体之间的关系。transe模型思想如图5所示。

[0108]

经过transe训练后的模型,头实体向量加上关系向量后的值越接近尾实体向量,满足h r≈t,说明实体和关系的嵌入就越加准确。

[0109]

步骤s2中的将用户数据利用知识图谱表示学习模型生成用户知识图谱特征具体包括:

[0110]

将用户数据利用随机方式初始化实体和关系的嵌入表示,其中实体为用户信息,关系为用户关注关系,从训练集中采样出小批量正例三元组集合,基于伯努利抽样算法对训练集进行负采样处理,得到负例三元组集合。其中,伯努利抽样方法具体为:对知识图谱中每一个关系r的三元组,计算出每个头实体对应尾实体数量的平均值r

tph

以及每个尾实体对应头实体数量的平均值r

hpt

,定义一个参数为p的抽样方法:

[0111][0112]

针对三元组(h,r,t)构建负例三元组集合,用概率p替换头实体,概率1

‑

p替换尾实体;

[0113]

优化训练目标,采用随机梯度下降算法不断迭代更新参数,当知识图谱表示学习模型收敛或达到最大迭代次数时停止训练,其中,定义所有样本的损失函数:

[0114]

l=∑

(h,r,t)∈s(h,r,t)

∑

(h',r,t')∈s'(h,r,t)

[f

r

(h,t) γ

‑

f

r

(h',t')]

;

[0115]

式中,s(h,r,t)表示知识图谱中的正例三元组集合,s'(h,r,t)表示负例三元组集合,[x]

表示当x大于0时取原值,x小于0时取0;γ表示正例三元组集合和负例三元组集合之间的边界值;

[0116]

将用户知识图谱中的实体和关系信息全部映射到同一个d维的向量空间中,最终可得到所有实体的向量表示:

[0117]

e=kge(e1,e2,

…

,e

v

)∈r

v

×

d

;

[0118]

式中,e

v

表示实体v的特征向量表示,v表示总共的实体数量。

[0119]

s3,将综合特征输入多层感知机,得到用户偏好类别及对应的推送数量。

[0120]

在具体的实施例中,将综合特征作为深度神经网络的输入,利用softmax函数来预测用户对不同类别主题微博的兴趣程度,再根据概率值大小排序,筛选兴趣主题信息进行个性化信息推荐。深度学习具有强大的特征提取能力,将其应用到推荐系统中,避免了传统复杂的人工特征工程,可从非结构化数据中获取非线性、深层次、低维稠密的实值向量表征,并且能够融入多源异构数据进行推荐。

[0121]

多层感知机模型的输入层结构向量x

o

是由属性特征、文本特征和图谱特征拼接而

成:

[0122]

x

o

=concatenate(u,v,e);

[0123]

式中,concatenate()用于表示多个向量的拼接。

[0124]

x

o

经过第一个隐藏层,输出向量:

[0125]

x1=activation(w1x0 b1);

[0126]

式中,w1是输入层到第一个隐藏层的权重矩阵;activation()代表激活函数,鉴于relu简单高效,并且能够加速收敛梯度下降的特点,选择relu作为模型的激活函数;b1是偏置向量。

[0127]

获取第h层隐藏层的输出向量:

[0128]

x=relu(w

out

x

h

b

out

);

[0129]

式中,w

out

表示输出层的权重矩阵,x指最后一层的输出向量,h代表隐藏层的总数量,b

out

是输出层的偏置值。

[0130]

继而,通过softmax函数对输出向量进行变换,得到用户偏好类别z的概率:

[0131][0132]

式中,x

z

表示输出向量中的第z个值,x

s

表示函数的输入向量的所有值,t表示文本的总类别数。

[0133]

最后,假定一共给用户u推送n条微博,根据概率p

z

计算类别z的推送数量:

[0134]

n

z

=n

×

p

z

。

[0135]

进一步参考图6,作为对上述各图所示方法的实现,本技术提供了一种文本信息推荐装置的一个实施例,该装置实施例与图2所示的方法实施例相对应,该装置具体可以应用于各种电子设备中。

[0136]

本技术实施例提供了一种文本信息推荐装置,包括:

[0137]

预处理模块1,被配置为获取用户数据及所对应的文本语料,对文本语料进行预处理,得到文本数据;

[0138]

综合特征生成模块2,被配置为将用户数据进行处理得到用户属性特征,将文本数据通过词注意力网络生成文本特征,将用户数据利用表示学习生成用户知识图谱特征,将用户属性特征、文本特征和用户知识图谱特征进行拼接,得到综合特征;

[0139]

类别推送模块3,被配置为将综合特征输入多层感知机,得到用户偏好类别及对应的推送数量。

[0140]

本发明核心思想是将推荐问题转化为一个基于深度神经网络的分类问题,特征学习主要是提取了用户在微博上的个人属性、历史发博内容以及关注关系等信息,依此对用户的个人兴趣进行建模。分类推荐主要是通过多层感知机训练用户的多维度特征,利用softmax函数分类,最后输出每个用户所属类别的概率,根据概率值大小排序,并基于打散策略完成对用户个性且多样的文本信息推荐。

[0141]

以下通过具体的实施例和对比例的结果进行说明。

[0142]

本技术的实施例采用公开的新浪微博数据集,由2014

‑

05

‑

03至2014

‑

05

‑

11采集的包含63641名新浪微博用户发布的84113条微博信息,其中包含了12个主题,如表1所示。

[0143]

表1微博数据集

[0144]

序号主题数量序号主题数量1房价89357魅族32632公务员75728贪官68353韩剧75159同桌的你108864恒大808010雾霾59555火箭636411小米115696林书豪151412转基因5625

[0145]

此外,还有1391718条用户好友关系,以及27759条微博转发关系。知识图谱所采用的数据集是网络公开的新浪微博数据集,构建微博用户知识图谱,含有63641名微博用户信息以及1391718条用户关注关系,将实体和关系导出分别进行存储,其中每一个实体对应唯一的实体id,每一个关系对应唯一的关系id,再根据对应关系组合这份知识图谱中包含的所有三元组信息,总共提取出了63026个实体和6种关系。部分微博用户的知识图谱如图7所示。

[0146]

评估标准如下:本实验将信息推荐问题转换为文本分类问题,所以仍然沿用常用的四种评价指标,准确率acc(accuracy)、精准率p(precision)、召回率r(recall)和f1值作为衡量推荐模型效果的标准,计算表达式如下:

[0147][0148][0149][0150][0151]

式中,其中,用户历史发表的微博文本类别代表该用户喜欢的类别,分类结果预测的类别是指该用户所属的主题类别,对应了最终的推荐结果。

[0152]

本发明设计了五个对比例存在两个目的:一方面是选取推荐系统研究中的类似方法进行性能对比,以验证本发明总体性能的有效性;另一方面侧重比较使用不同的文本特征表示方法,对推荐效果的影响差别。图8是五个对比例中五种算法的性能对比结果。

[0153]

其中本技术的实施例采用的文本推荐方法(dnn att kg推荐方法)综合了知识图谱中的用户关系、文本内容中的关键信息以及用户的多个属性特征,再通过深度神经网络对用户特征进行深层次建模和表征,总体来看,该模型的推荐效果最好,准确率达到了0.801,优于对比例中所有其他模型。具体各个类别的实验结果如表1所示,其中最优的前两个结果用粗体字标记。

[0154]

表1dnn att kg推荐方法的分类结果

[0155][0156]

综上所述,本发明利用知识图谱表示学习为用户引入更多的结构信息和语义关系,加强对用户兴趣的识别度和扩展性,从而提高推荐结果的准确性和多样性,并且通过学习用户的综合特征可得到多个维度的抽象特征表示,在一定程度上缓解了传统个性化信息推荐中的数据稀疏、冷启动等问题。同时,将注意力机制应用到微博推荐,有助于从文本中识别出最具有信息量的词,帮助推荐系统抓取出最重要的特征,进一步提高推荐结果的准确度。

[0157]

下面参考图9,其示出了适于用来实现本技术实施例的电子设备(例如图1所示的服务器或终端设备)的计算机装置900的结构示意图。图9示出的电子设备仅仅是一个示例,不应对本技术实施例的功能和使用范围带来任何限制。

[0158]

如图9所示,计算机装置900包括中央处理单元(cpu)901和图形处理器(gpu)902,其可以根据存储在只读存储器(rom)903中的程序或者从存储部分909加载到随机访问存储器(ram)904中的程序而执行各种适当的动作和处理。在ram 904中,还存储有装置900操作所需的各种程序和数据。cpu 901、gpu902、rom 903以及ram 904通过总线905彼此相连。输入/输出(i/o)接口906也连接至总线905。

[0159]

以下部件连接至i/o接口906:包括键盘、鼠标等的输入部分907;包括诸如、液晶显示器(lcd)等以及扬声器等的输出部分908;包括硬盘等的存储部分909;以及包括诸如lan卡、调制解调器等的网络接口卡的通信部分910。通信部分910经由诸如因特网的网络执行通信处理。驱动器911也可以根据需要连接至i/o接口906。可拆卸介质912,诸如磁盘、光盘、磁光盘、半导体存储器等等,根据需要安装在驱动器911上,以便于从其上读出的计算机程序根据需要被安装入存储部分909。

[0160]

特别地,根据本公开的实施例,上文参考流程图描述的过程可以被实现为计算机软件程序。例如,本公开的实施例包括一种计算机程序产品,其包括承载在计算机可读介质上的计算机程序,该计算机程序包含用于执行流程图所示的方法的程序代码。在这样的实施例中,该计算机程序可以通过通信部分910从网络上被下载和安装,和/或从可拆卸介质912被安装。在该计算机程序被中央处理单元(cpu)901和图形处理器(gpu)902执行时,执行本技术的方法中限定的上述功能。

[0161]

需要说明的是,本技术所述的计算机可读介质可以是计算机可读信号介质或者计算机可读介质或者是上述两者的任意组合。计算机可读介质例如可以是——但不限于——电、磁、光、电磁、红外线、或半导体的装置、装置或器件,或者任意以上的组合。计算机可读介质的更具体的例子可以包括但不限于:具有一个或多个导线的电连接、便携式计算机磁盘、硬盘、随机访问存储器(ram)、只读存储器(rom)、可擦式可编程只读存储器(eprom或闪存)、光纤、便携式紧凑磁盘只读存储器(cd

‑

rom)、光存储器件、磁存储器件、或者上述的任意合适的组合。在本技术中,计算机可读介质可以是任何包含或存储程序的有形介质,该程序可以被指令执行装置、装置或者器件使用或者与其结合使用。而在本技术中,计算机可读的信号介质可以包括在基带中或者作为载波一部分传播的数据信号,其中承载了计算机可读的程序代码。这种传播的数据信号可以采用多种形式,包括但不限于电磁信号、光信号或上述的任意合适的组合。计算机可读的信号介质还可以是计算机可读介质以外的任何计算机可读介质,该计算机可读介质可以发送、传播或者传输用于由指令执行装置、装置或者器件使用或者与其结合使用的程序。计算机可读介质上包含的程序代码可以用任何适当的介质传输,包括但不限于:无线、电线、光缆、rf等等,或者上述的任意合适的组合。

[0162]

可以以一种或多种程序设计语言或其组合来编写用于执行本技术的操作的计算机程序代码,所述程序设计语言包括面向对象的程序设计语言—诸如java、smalltalk、c ,还包括常规的过程式程序设计语言—诸如“c”语言或类似的程序设计语言。程序代码可以完全地在用户计算机上执行、部分地在用户计算机上执行、作为一个独立的软件包执行、部分在用户计算机上部分在远程计算机上执行、或者完全在远程计算机或服务器上执行。在涉及远程计算机的情形中,远程计算机可以通过任意种类的网络——包括局域网(lan)或广域网(wan)—连接到用户计算机,或者,可以连接到外部计算机(例如利用因特网服务提供商来通过因特网连接)。

[0163]

附图中的流程图和框图,图示了按照本技术各种实施例的装置、方法和计算机程序产品的可能实现的体系架构、功能和操作。在这点上,流程图或框图中的每个方框可以代表一个模块、程序段、或代码的一部分,该模块、程序段、或代码的一部分包含一个或多个用于实现规定的逻辑功能的可执行指令。也应当注意,在有些作为替换的实现中,方框中所标注的功能也可以以不同于附图中所标注的顺序发生。例如,两个接连地表示的方框实际上可以基本并行地执行,它们有时也可以按相反的顺序执行,这依所涉及的功能而定。也要注意的是,框图和/或流程图中的每个方框、以及框图和/或流程图中的方框的组合,可以用执行规定的功能或操作的专用的基于硬件的装置来实现,或者可以用专用硬件与计算机指令的组合来实现。

[0164]

描述于本技术实施例中所涉及到的模块可以通过软件的方式实现,也可以通过硬件的方式来实现。所描述的模块也可以设置在处理器中。

[0165]

作为另一方面,本技术还提供了一种计算机可读介质,该计算机可读介质可以是上述实施例中描述的电子设备中所包含的;也可以是单独存在,而未装配入该电子设备中。上述计算机可读介质承载有一个或者多个程序,当上述一个或者多个程序被该电子设备执行时,使得该电子设备:获取用户数据及所对应的文本语料,对文本语料进行预处理,得到文本数据;将用户数据进行处理得到用户属性特征,将文本数据通过词注意力网络生成文本特征,将用户数据利用知识图谱表示学习模型生成用户知识图谱特征,将用户属性特征、

文本特征和用户知识图谱特征进行拼接,得到综合特征;将综合特征输入多层感知机,得到用户偏好类别及对应的推送数量。

[0166]

以上描述仅为本技术的较佳实施例以及对所运用技术原理的说明。本领域技术人员应当理解,本技术中所涉及的发明范围,并不限于上述技术特征的特定组合而成的技术方案,同时也应涵盖在不脱离上述发明构思的情况下,由上述技术特征或其等同特征进行任意组合而形成的其它技术方案。例如上述特征与本技术中公开的(但不限于)具有类似功能的技术特征进行互相替换而形成的技术方案。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。