1.本技术实施例涉及机器学习技术领域,特别涉及一种语言模型训练方法、装置、设备及存储介质。

背景技术:

2.随着机器学习技术的发展,出现了各种各样的语言模型,用于对语言或文本进行预测。

3.在相关技术中,采用全量预训练语料对模型进行训练,训练得到全量预训练后的学生语言模型后,若又获取了新增的预训练语料(即增量预训练语料),会将新增的预训练语料加入到原有的全量预训练语料中,得到个更新后的全量预训练语料,然后采用更新后的全量预训练语料重新训练该学生语言模型。

4.在上述相关技术中,由于更新后的全量预训练语料的数据量较大,训练较为耗时。

技术实现要素:

5.本技术实施例提供了一种语言模型训练方法、装置、设备及存储介质,能够节省语言模型训练的时间。所述技术方案如下:

6.根据本技术实施例的一个方面,提供了一种语言模型训练方法,所述方法包括:

7.基于全量预训练语料对初始的学生语言模型进行全量预训练,得到全量预训练后的学生语言模型;

8.基于增量预训练语料对所述全量预训练后的学生语言模型进行增量预训练,得到增量预训练后的学生语言模型;其中,所述增量预训练语料是在所述全量预训练语料的基础上新增的预训练语料;

9.采用教师语言模型对所述增量预训练后的学生语言模型进行知识蒸馏处理,得到蒸馏后的学生语言模型;其中,所述教师语言模型是采用目标任务的第一训练样本集进行训练得到的语言模型;

10.采用所述目标任务的第二训练样本集,对所述蒸馏后的学生语言模型进行参数调整处理,得到完成训练的学生语言模型。

11.根据本技术实施例的一个方面,提供了一种语言模型训练装置,所述装置包括:

12.全量预训练模块,用于基于全量预训练语料对初始的学生语言模型进行全量预训练,得到全量预训练后的学生语言模型;

13.增量预训练模块,用于基于增量预训练语料对所述全量预训练后的学生语言模型进行增量预训练,得到增量预训练后的学生语言模型;其中,所述增量预训练语料是在所述全量预训练语料的基础上新增的预训练语料;

14.模型蒸馏模块,用于采用教师语言模型对所述增量预训练后的学生语言模型进行知识蒸馏处理,得到蒸馏后的学生语言模型;其中,所述教师语言模型是采用目标任务的第一训练样本集进行训练得到的语言模型;

15.参数调整模块,用于采用所述目标任务的第二训练样本集,对所述蒸馏后的学生语言模型进行参数调整处理,得到完成训练的学生语言模型。

16.根据本技术实施例的一个方面,提供了一种计算机设备,所述计算机设备包括处理器和存储器,所述存储器中存储有至少一条指令、至少一段程序、代码集或指令集,所述至少一条指令、所述至少一段程序、所述代码集或指令集由所述处理器加载并执行以实现上述语言模型训练方法。

17.根据本技术实施例的一个方面,提供了一种计算机可读存储介质,所述计算机可读存储介质中存储有至少一条指令、至少一段程序、代码集或指令集,所述至少一条指令、所述至少一段程序、所述代码集或指令集由处理器加载并执行以实现上述语言模型训练方法。

18.本技术实施例提供的技术方案可以包括如下有益效果:

19.通过在获取了增量预训练语料之后,在全量预训练后的学生语言模型的基础上,仅使用增量预训练语料对学生语言模型进行增量预训练,原有的全量预训练语料无需参与增量预训练过程,节省了增量预训练时间,进而节省了学生语言模型整体的训练时间。

20.应当理解的是,以上的一般描述和后文的细节描述仅是示例性和解释性的,并不能限制本技术。

附图说明

21.为了更清楚地说明本技术实施例中的技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本技术的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

22.图1是本技术一个实施例提供的语言模型训练方法的流程图;

23.图2是本技术一个实施例提供的模型结构的示意图;

24.图3是本技术另一个实施例提供的语言模型训练方法的流程图;

25.图4是本技术另一个实施例提供的语言模型训练方法的流程图;

26.图5是本技术一个实施例提供的样本标注方法的示意图;

27.图6是本技术另一个实施例提供的语言模型训练方法的流程图;

28.图7是本技术一个实施例提供的语言模型训练装置的框图;

29.图8是本技术另一个实施例提供的语言模型训练装置的框图;

30.图9是本技术一个实施例提供的终端的框图。

具体实施方式

31.这里将详细地对示例性实施例进行说明,其示例表示在附图中。下面的描述涉及附图时,除非另有表示,不同附图中的相同数字表示相同或相似的要素。以下示例性实施例中所描述的实施方式并不代表与本技术相一致的所有实施方式。相反,它们仅是与如所附权利要求书中所详述的、本技术的一些方面相一致的方法的例子。

32.人工智能(artificial intelligence,ai)是利用数字计算机或者数字计算机控制的机器模拟、延伸和扩展人的智能,感知环境、获取知识并使用知识获得最佳结果的理

论、方法、技术及应用系统。换句话说,人工智能是计算机科学的一个综合技术,它企图了解智能的实质,并生产出一种新的能以人类智能相似的方式做出反应的智能机器。人工智能也就是研究各种智能机器的设计原理与实现方法,使机器具有感知、推理与决策的功能。

33.人工智能技术是一门综合学科,涉及领域广泛,既有硬件层面的技术也有软件层面的技术。人工智能基础技术一般包括如传感器、专用人工智能芯片、云计算、分布式存储、大数据处理技术、操作/交互系统、机电一体化等技术。人工智能软件技术主要包括计算机视觉技术、语音处理技术、自然语言处理技术以及机器学习/深度学习等几大方向。

34.自然语言处理(nature language processing,nlp)是计算机科学领域与人工智能领域中的一个重要方向。它研究能实现人与计算机之间用自然语言进行有效通信的各种理论和方法。自然语言处理是一门融语言学、计算机科学、数学于一体的科学。因此,这一领域的研究将涉及自然语言,即人们日常使用的语言,所以它与语言学的研究有着密切的联系。自然语言处理技术通常包括文本处理、语义理解、机器翻译、机器人问答、知识图谱等技术。

35.机器学习(machine learning,ml)是一门多领域交叉学科,涉及概率论、统计学、逼近论、凸分析、算法复杂度理论等多门学科。专门研究计算机怎样模拟或实现人类的学习行为,以获取新的知识或技能,重新组织已有的知识结构使之不断改善自身的性能。机器学习是人工智能的核心,是使计算机具有智能的根本途径,其应用遍及人工智能的各个领域。机器学习和深度学习通常包括人工神经网络、置信网络、强化学习、迁移学习、归纳学习、示教学习等技术。

36.随着人工智能技术研究和进步,人工智能技术在多个领域展开研究和应用,例如常见的智能家居、智能穿戴设备、虚拟助理、智能音箱、智能营销、无人驾驶、自动驾驶、无人机、机器人、智能医疗、智能客服等,相信随着技术的发展,人工智能技术将在更多的领域得到应用,并发挥越来越重要的价值。

37.本技术实施例提供的方案涉及人工智能的自然语言处理和机器学习技术,例如利用自然语言处理技术进行分词、确定文本的语义特征、对文本内容进行预测等等。

38.本技术实施例提供的方法,各步骤的执行主体可以是计算机设备,该计算机设备是指具备数据计算、处理和存储能力的电子设备。该计算机设备可以是诸如pc(personal computer,个人计算机)、平板电脑、智能手机、可穿戴设备、智能机器人等终端;也可以是服务器。其中,服务器可以是独立的物理服务器,也可以是多个物理服务器构成的服务器集群或者分布式系统,还可以是提供云计算服务的云服务器。

39.下面,通过几个实施例对本技术技术方案进行介绍说明。

40.请参考图1,其示出了本技术一个实施例提供的语言模型训练方法的流程图。在本实施例中,主要以该方法应用于上文介绍的计算机设备来举例说明。该方法可以包括如下几个步骤(101~104):

41.步骤101,基于全量预训练语料对初始的学生语言模型进行全量预训练,得到全量预训练后的学生语言模型。

42.其中,全量预训练语料是指所有能够用来进行预训练的语料。在本技术实施例中,采用全量预训练语料作为训练样本,对初始的学生语言模型进行全量预训练,从而得到全量预训练后的学生语言模型。

43.在一些实施例中,该步骤101还包括如下子步骤:

44.1、对全量预训练语料进行切分,得到多个全量预训练语料段。

45.可选地,全量预训练语料段的最大长度,小于或等于第一预设长度。其中,第一预设长度可以由相关技术人员根据实际情况进行设定,本技术实施例对此不作具体限定。

46.2、对于全量预训练语料中的第j个全量预训练语料段,将第j个全量预训练语料段中的部分语料片段进行遮盖,将第j个全量预训练语料段中的部分语料片段随机替换为其他文本,剩余的语料片段保持不变,j为正整数。

47.例如,在第j个全量预训练语料段中随机选取a1%的词语,将该a1%的词语中,b1%的词语进行遮盖,c1%的词语随机替换为其他词语,剩余的词语保持不变。其中,a1、b1、c1为正数,a1、b1、c1之和为100。例如:a1为10、b1为80、c1为10。可选地,a1、b1、c1的具体取值由相关技术人员根据实际情况进行设定,本技术实施例对此不作限定。

48.3、将第j个全量预训练语料段中的各个语料片段,映射为各个语料片段分别对应的语义向量和位置向量;其中,语义向量用于表示语料片段对应的语义特征,位置向量用于表示语料片段对应的位置特征。

49.4、对于第j个全量预训练语料段中的各个语料片段,将各自对应的语义向量和位置向量相加,得到第j个全量预训练语料段中的各个语料片段分别对应的向量和,并将其输入全量预训练中的学生语言模型中进行前向计算。

50.5、第j个全量预训练语料段中的各个语料片段分别对应的向量和,输入全量预训练中的学生语言模型,并通过全量预训练中的学生语言模型的全连接预测层映射到词表大小的向量空间中,得到第j个全量预训练语料段中,带遮盖的文本分别对应的预测概率分布,并确定对应的损失。

51.在一些实施例中,基于全量预训练语料的标签信息,以及全量预训练中的学生语言模型在所述全量预训练语料上的第三预测结果,确定第三损失。其中,第三损失与第三预测结果和全量预训练语料的标签信息之间的差异程度相关。可选地,第三预测结果包括带遮盖的文本对应的全量预测概率分布,全量预训练语料的标签信息为全量预训练语料中带遮盖的文本的实际概率分布,第三损失为全量预测概率分布与全量预训练语料中带遮盖的文本的实际概率分布之间的交叉熵。

52.在一个示例中,第三损失与第三预测结果和全量预训练语料的标签信息之间的差异程度正相关。也即,第三预测结果和全量预训练语料的标签信息之间的差异越大,第三损失越大;第三预测结果和全量预训练语料的标签信息之间的差异越小,第三损失越小。

53.在另一个示例中,第三损失与第三预测结果和全量预训练语料的标签信息之间的差异程度负相关。也即,第三预测结果和全量预训练语料的标签信息之间的差异越大,第三损失越小;第三预测结果和全量预训练语料的标签信息之间的差异越小,第三损失越大。

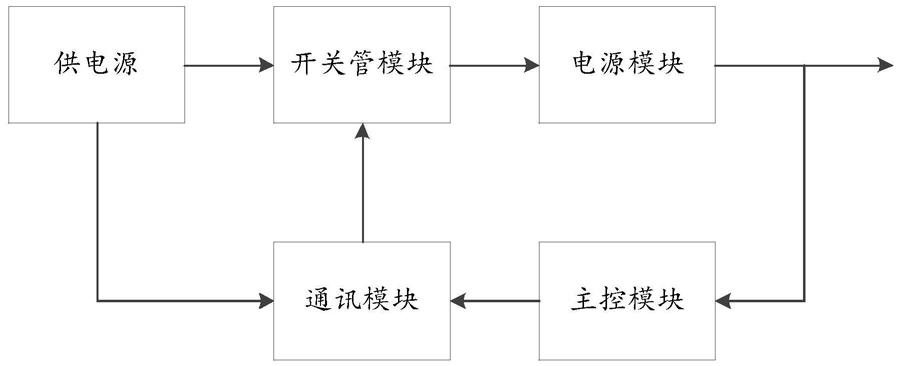

54.6、计算第j个全量预训练语料段对应的损失,对全量预训练中的学生语言模型参数的梯度,根据该梯度值调整全量预训练中的学生语言模型的参数。

55.7、采用其他全量预训练语料段,重复上述步骤1~6,直到满足第三停止训练条件,得到全量预训练后的学生语言模型。

56.可选地,第三停止训练条件包括:在全量预训练中的学生语言模型的参数更新次数达到目标预设次数、全量预训练中的学生语言模型的预测精度达到目标预设精度等等。

其中,目标预设次数的具体数值可以由相关技术人员根据实际情况进行设定,本技术实施例对此不作具体限定;目标预设精度可以由相关技术人员根据实际情况进行设定,本技术实施例对此不作具体限定。

57.以上仅是对第三停止训练条件的示例性说明,第三停止训练条件还可以包括其他条件,本技术实施例对此不作具体限定。

58.在一些实施例中,如图2所示,学生语言模型20包括多头注意力层21、transformer(卷积网络)层22以及隐层(图中未示出),多头注意力层21、transformer层22以及隐层的输出为隐层状态数据,属于学生语言模型20的中间输出。

59.步骤102,基于增量预训练语料对全量预训练后的学生语言模型进行增量预训练,得到增量预训练后的学生语言模型。

60.其中,增量预训练语料是在全量预训练语料的基础上新增的预训练语料。

61.在一些实施例中,增量预训练中的学生语言模型的初始模型,为全量预训练后的学生语言模型。通过全量预训练语料训练得到全量预训练后的学生语言模型后,又获取了增量预训练语料,则需要基于增量预训练语料对全量预训练后的学生语言模型进一步进行训练。本技术实施例中,仅采用增量预训练语料,在全量预训练后的学生语言模型的基础上进一步进行增量预训练,原有的全量预训练语料无需参与增量预训练过程,节省了增量预训练时间,进而节省了学生语言模型整体的训练时间。

62.步骤103,采用教师语言模型对增量预训练后的学生语言模型进行知识蒸馏处理,得到蒸馏后的学生语言模型。

63.其中,教师语言模型是采用目标任务的第一训练样本集进行训练得到的语言模型。

64.在一些实施例中,教师语言模型是与学生语言模型具有相同或相近的功能。在一个示例中,教师语言模型与学生语言模型都是用于对文本进行预测。例如,都是对相同语言(如汉语、英语、日语、德语、法语等)的文本中的词语进行预测;又例如,都是对同一类型的文本(如新闻类文本、小说类文本、百科介绍类文本等)中的词语进行预测;又例如,都是对同一领域相关的文本(如医学领域、生物领域、物理领域、化学领域、法律领域等)中的词语进行预测。可选地,学生语言模型的参数的量少于教师语言模型的参数的量;和/或,学生语言模型的网络层的数量少于教师语言模型的网络层的数量。

65.可选地,第一训练样本集中的训练样本是目标任务的标注数据;相应地,基于第一训练样本集训练出的教师语言模型,以及基于该教师语言模型得到的学生语言模型,用于在目标任务上进行自然语言处理。例如,目标任务是对一段文本中的空缺或模糊词语进行预测,则将标注了空缺或模糊处的正确词语的文本作为第一训练样本集中的训练样本。

66.在一些实施例中,通过增量预训练语料训练得到增量预训练后的学生语言模型后,采用教师语言模型的中间输出结果或最后输出结果,影响增量预训练后的学生语言模型的参数的调整。也可以理解为,是采用教师语言模型教导学生语言模型,从而将教师语言模型学习到的关于目标任务的“知识”传递到学生语言模型中,从而实现知识蒸馏,得到蒸馏后的学生语言模型。

67.步骤104,采用目标任务的第二训练样本集,对蒸馏后的学生语言模型进行参数调整处理,得到完成训练的学生语言模型。

68.上一步骤104中,学生语言模型通过教师语言模型间接学习到了目标任务的相关知识。可选地,在本步骤104中,直接采用目标任务的第二训练样本集对蒸馏后的学生语言模型进行参数调整处理,从而使学生语言模型直接学习目标任务的相关知识,得到完成训练的学生语言模型。

69.综上所述,本技术实施例提供的技术方案中,通过在获取了增量预训练语料之后,在全量预训练后的学生语言模型的基础上,仅使用增量预训练语料对学生语言模型进行增量预训练,原有的全量预训练语料无需参与增量预训练过程,节省了增量预训练时间,进而节省了学生语言模型整体的训练时间。

70.另外,本技术实施例中,采用教师语言模型对增量预训练后的学生语言模型进行知识蒸馏处理,且教师语言模型是采用目标任务的第一训练样本集进行训练得到的语言模型,从而在保证蒸馏后的学生语言模型针对目标任务的精度的前提下,节省了模型训练时间。

71.另外,本技术实施例中,采用目标任务的第二训练样本集对蒸馏后的学生语言模型进行参数调整处理,从而使学生语言模型直接学习目标任务的相关知识,进一步提升了完成训练的学生语言模型针对目标任务的精度。

72.请参考图3,其示出了本技术另一个实施例提供的语言模型训练方法的流程图。在本实施例中,主要以该方法应用于上文介绍的计算机设备来举例说明。该方法可以包括如下几个步骤(301~309):

73.步骤301,基于全量预训练语料对初始的学生语言模型进行全量预训练,得到全量预训练后的学生语言模型。

74.本步骤301与上文图1实施例的步骤101的内容相同或相近,此处不再赘述。

75.步骤302,获取第一预测结果和第二预测结果。

76.可选地,第一预测结果是指增量预训练中的学生语言模型在增量预训练语料上的预测结果,第二预测结果是指全量预训练后的学生语言模型在增量预训练语料上的预测结果。通过将处理后的增量预训练语料输入增量预训练中的学生语言模型,得到增量预训练中的学生语言模型在增量预训练语料上的预测结果;将处理后的增量预训练语料输入全量预训练后的学生语言模型,得到全量预训练后的学生语言模型在增量预训练语料上的预测结果。

77.可选地,预测结果是模型对指定的词语进行预测的预测概率分布。第一预测结果是增量预训练中的学生语言模型,对增量预训练语料中指定的词语进行预测的预测概率分布;第二预测结果是全量预训练后的学生语言模型,对增量预训练语料中指定的词语进行预测的预测概率分布。

78.在一些实施例中,该步骤302包括如下子步骤:

79.1、对增量预训练语料中的目标文本进行遮盖处理,生成带遮盖的增量预训练语料。

80.在一些实施例中,采用带遮盖的增量预训练语料对增量预训练中的学生语言模型进行增量预训练,从而检验增量预训练中的学生语言模型对带遮盖的增量预训练语料的进行预测的预测能力。可选地,目标文本是随机选取的、较为分散的文本。

81.在一些可能的实现方式中,该子步骤该还包括:

82.(1)对增量预训练语料进行切分,得到多个增量预训练语料段。

83.可选地,增量预训练语料段的最大长度,小于或等于第二预设长度。其中,第二预设长度可以由相关技术人员根据实际情况进行设定,本技术实施例对此不作具体限定。

84.(2)对于增量预训练语料中的第m个增量预训练语料段,将第m个增量预训练语料段中的部分语料片段进行遮盖,将第m个全量预训练语料段中的部分语料片段随机替换为其他文本,剩余的语料片段保持不变,m为正数。

85.例如,在第j个全量预训练语料段中随机选取a2%的词语,将该a2%的词语中,b2%的词语进行遮盖,c2%的词语随机替换为其他词语,剩余的词语保持不变。其中,a2、b2、c2为正数,a2、b2、c2之和为100。例如:a2为10、b2为80、c2为10。可选地,a2、b2、c2的具体取值由相关技术人员根据实际情况进行设定,本技术实施例对此不作限定。

86.2、通过增量预训练中的学生语言模型对带遮盖的增量预训练语料进行处理,得到第一预测结果。

87.可选地,第一预测结果包括增量预训练中的学生语言模型预测得到的被遮盖文本。

88.在一些实施例中,该子步骤还包括:

89.(1)将第m个增量预训练语料段中的各个语料片段,映射为各个语料片段分别对应的语义向量和位置向量;其中,语义向量用于表示语料片段对应的语义特征,位置向量用于表示语料片段对应的位置特征。

90.(2)对于第m个增量预训练语料段中的各个语料片段,将各自对应的语义向量和位置向量相加,得到第m个增量预训练语料段中的各个语料片段分别对应的向量和,并将其输入增量预训练中的学生语言模型中进行前向计算,得到第一预测结果。

91.3、通过全量预训练后的学生语言模型对带遮盖的增量预训练语料进行处理,得到第二预测结果,第二预测结果包括全量预训练后的学生语言模型预测得到的被遮盖文本。

92.其中,获取第二预测结果的具体方法,可以参考上述对获取第一预测结果的介绍,此处不再赘述。

93.步骤303,基于第一预测结果、第二预测结果和增量预训练语料的标签信息,确定第一损失。

94.可选地,第一损失与第一预测结果和增量预训练语料的标签信息之间的差异程度相关,且与第一预测结果和第二预测结果之间的差异程度相关。通过综合第一预测结果、第二预测结果和增量预训练语料的标签信息,能够确定出第一损失。

95.在一些实施例中,该步骤303还包括如下子步骤:

96.1、基于第一预测结果和增量预训练语料的标签信息,确定第一子损失,第一子损失与第一预测结果和增量预训练语料的标签信息之间的差异程度相关。

97.在一个示例中,第一子损失与第一预测结果和增量预训练语料的标签信息之间的差异程度正相关。也即,第一预测结果和增量预训练语料的标签信息之间的差异程度越大,第一子损失越大;第一预测结果和增量预训练语料的标签信息之间的差异程度越小,第一子损失越小。

98.在一个示例中,第一子损失与第一预测结果和增量预训练语料的标签信息之间的差异程度负相关。也即,第一预测结果和增量预训练语料的标签信息之间的差异程度越大,

第一子损失越小;第一预测结果和增量预训练语料的标签信息之间的差异程度越小,第一子损失越大。

99.可选地,如上述步骤302所示,第一预测结果是增量预训练中的学生语言模型,对增量预训练语料中指定的词语进行预测的预测概率分布。因而,第一预测结果对应有用于表示其概率分布的第一概率分布向量。增量预训练语料的标签信息也可以表示为概率分布的标签向量。可选地,第一子损失为第一概率分部向量与概率分布的标签向量之间的交叉熵。

100.在一个示例中,第一子损失的计算方式参考如下公式一:

101.公式一:

102.其中,为第一子损失,o

s

′

为第一概率分布向量,o为概率分布的标签向量。

103.2、基于第一预测结果和第二预测结果,确定第二子损失,第二子损失与第一预测结果和第二预测结果之间的差异程度相关。

104.在一个示例中,第二子损失与第一预测结果和第二预测结果之间的差异程度正相关。也即,第一预测结果和第二预测结果之间的差异程度越大,第二子损失越大;第一预测结果和第二预测结果之间的差异程度越小,第二子损失越小。

105.在另一个示例中,第二子损失与第一预测结果和第二预测结果之间的差异程度负相关。也即,第一预测结果和第二预测结果之间的差异程度越大,第二子损失越小;第一预测结果和第二预测结果之间的差异程度越小,第二子损失越大。

106.可选地,如上述步骤302所示,第二预测结果是全量预训练后的学生语言模型,对增量预训练语料中指定的词语进行预测的预测概率分布,第二预测结果对应有用于表示其概率分布的第二概率分布向量。可选地,第二子损失为第一概率分部向量与第二概率分布向量之间的交叉熵。

107.在一个示例中,第二子损失的计算方式参考如下公式二:

108.公式二:

109.其中,为第一子损失,o

s

′

为第一概率分布向量,o

s

为第二概率分布向量。

110.3、基于第一子损失和第二子损失,确定第一损失。

111.在另一些实施例中,该方法还包括如下步骤:

112.1、获取第一隐层状态数据和第二隐层状态数据,第一隐层状态数据是指增量预训练中的学生语言模型在生成第一预测结果时的隐层状态数据,第二隐层状态数据是指全量预训练后的学生语言模型在生成第二预测结果时的隐层状态数据;

113.2、基于第一隐层状态数据和第二隐层状态数据,确定第三子损失,第三子损失与第一隐层状态数据和第二隐层状态数据之间的差异程度相关。

114.在一些实施例中,通过计算第一隐层状态数据和第二隐层状态数据之间的均方误差,确定第三子损失。

115.在一个示例中,第三子损失与第一隐层状态数据和第二隐层状态数据之间的差异程度正相关。也即,第一隐层状态数据和第二隐层状态数据之间的差异程度越大,第三子损失越大;第一隐层状态数据和第二隐层状态数据之间的差异程度越小,第三子损失越小。

116.在另一个示例中,第三子损失与第一隐层状态数据和第二隐层状态数据之间的差异程度正相关。也即,第一隐层状态数据和第二隐层状态数据之间的差异程度越大,第三子损失越小;第一隐层状态数据和第二隐层状态数据之间的差异程度越小,第三子损失越大。

117.可选地,第三子损失的计算方式参考如下公式三:

118.公式三:

119.其中,h

s

为全量预训练后的学生语言模型在生成第二预测结果时的隐层变量,h

s

′

为增量预训练中的学生语言模型在生成第一预测结果时的隐层变量;a

s

为全量预训练后的学生语言模型在生成第二预测结果时的注意力权重,a

s

′

为增量预训练中的学生语言模型在生成第一预测结果时的注意力权重;e

s

为全量预训练后的学生语言模型在生成第二预测结果时的语义向量矩阵,e

s

′

为增量预训练中的学生语言模型在生成第一预测结果时的语义向量矩阵。

120.相应地,基于第一子损失和第二子损失,确定第一损失,包括:基于第一子损失、第二子损失和第三子损失,确定第一损失。

121.在一些实施例中,基于第一子损失、第二子损失和第三子损失,确定第一损失,包括如下步骤:

122.1、获取第一子损失、第二子损失和第三子损失分别对应的权重值;

123.2、基于权重值对第一子损失、第二子损失和第三子损失进行加权求和,得到第一损失。

124.可选地,第一损失的计算方式参考如下公式四:

125.公式四:

126.其中,λ

mlm

为第一子损失的权重值,λ

pred

为第二子损失的权重值,λhi

idn

为第三子损失的权重值。

127.在一些实施例中,第一子损失、第二子损失和第三子损失分别对应的权重值由相关技术人员根据实际情况进行设定,本技术实施例对此不作限定。

128.步骤304,基于第一损失调整增量预训练中的学生语言模型的参数,直至满足第一停止条件,得到增量预训练后的学生语言模型。

129.在一些实施例中,确定第一损失之后,根据第一损失的值调整增量预训练中的学生语言模型的参数,再对增量预训练中的学生语言模型进行下一轮的训练和参数调整;直至满足第一停止条件,停止训练,得到增量预训练后的学生语言模型。

130.可选地,第一停止训练条件包括:增量预训练中的学生语言模型的参数更新次数达到第一预设次数、增量预训练中的学生语言模型的预测精度达到第一预设精度等等。其中,第一预设次数的具体数值可以由相关技术人员根据实际情况进行设定,本技术实施例对此不作具体限定;第一预设精度可以由相关技术人员根据实际情况进行设定,本技术实施例对此不作具体限定。

131.以上仅是对第一停止训练条件的示例性说明,第一停止训练条件还可以包括其他条件,本技术实施例对此不作具体限定。

132.步骤305,如图4所示,基于教师语言模型41和知识蒸馏语料42,确定第一标签信息43。

133.在一些实施例中,将知识蒸馏语料42输入教师语言模型41,得到第一标签信息43。其中,第一标签信息43是指教师语言模型41在知识蒸馏语料42上推理得到的标签信息。可选地,标签信息为软标签信息,软标签信息是指模型在知识蒸馏语料42上进行推理过程中生成的特征图。因而,知识蒸馏语料42为无需人工标注的语料。

134.其中,软标签是相对于硬标签的一种标签,常见的人工标注一般为硬标签。本技术中的教师语言模型和/或学生语言模型在对文本“香港仍是全球最自由的经济体系”进行预测时,会输出每个词的标签概率分布情况,如“香港”对应的标签概率分布为[0.1,0,

…

,0,0.89,0,

…

,0,0.01],概率最大的标签为最终的标注结果。该分布通过对神经网络输出的分数进行softmax(逻辑回归)操作得到。本技术方案中的软标签为平滑后的神经网络输出,即softmax(z/t),其中z为神经网络输出的分数,t为控制平滑程度的超参数。

[0135]

可选地,知识蒸馏语料42是从全量预训练语料和/或增量预训练语料中选取的语料数据。

[0136]

步骤306,基于多个增量预训练后的学生语言模型44和知识蒸馏语料42,确定多个第二标签信息45。

[0137]

在一些实施例中,将知识蒸馏语料42分别输入多个增量预训练后的学生语言模型44,得到多个增量预训练后的学生语言模型44分别对应的第二标签信息45。其中,第二标签信息45是指增量预训练后的学生语言模型44在知识蒸馏语料42上推理得到的标签信息。

[0138]

可选地,该多个增量预训练后的学生语言模型44的复杂程度不相同。例如,多个增量预训练后的学生语言模型44的参数和/或结构不相同。在一个示例中,多个增量预训练后的学生语言模型44的结构不相同,是指多个增量预训练后的学生语言模型44的层级的数量不相同。

[0139]

在一个示例中,教师语言模型41的transformer层的层数为24,隐层维度为1024,多头注意力层的头数为16;而增量预训练后的学生语言模型44的transformer层的层数可以为12,隐层维度可以为512,多头注意力层的头数为8。

[0140]

步骤307,对于第i个增量预训练后的学生语言模型44,基于第一标签信息43、第i个增量预训练后的学生语言模型44对应的第二标签信息45以及其他增量预训练后的学生语言模型44对应的第二标签信息45,确定第i个增量预训练后的学生语言模型44对应的第二损失46。

[0141]

在一些实施例中,第i个增量预训练后的学生语言模型44对应的第二损失46与第一标签信息43和第i个增量预训练后的学生语言模型44对应的第二标签信息45之间的差异程度相关,且与第i个增量预训练后的学生语言模型44对应的第二标签信息45和其他增量预训练后的学生语言模型44对应的第二标签信息45之间的差异程度相关,i为正整数。

[0142]

可选地,通过计算第一标签信息43和第i个增量预训练后的学生语言模型44对应的第二标签信息45之间的交叉熵,以及第i个增量预训练后的学生语言模型44对应的第二标签信息45与其他增量预训练后的学生语言模型44对应的第二标签信息45之间的kl散度(relative entropy,相对熵),确定第i个增量预训练后的学生语言模型44对应的第二损失46。

[0143]

在一些实施例中,该步骤307还包括如下子步骤:

[0144]

1、基于第一标签信息43和第i个增量预训练后的学生语言模型44对应的第二标签

信息45,确定第四子损失。

[0145]

其中,第四子损失与第一标签信息43和第i个增量预训练后的学生语言模型44对应的第二标签信息45之间的差异程度相关。

[0146]

在一个示例中,第四子损失与第一标签信息43和第i个增量预训练后的学生语言模型44对应的第二标签信息45之间的差异程度正相关。也即,第一标签信息43和第i个增量预训练后的学生语言模型44对应的第二标签信息45之间的差异程度越大,第四子损失越大;第一标签信息43和第i个增量预训练后的学生语言模型44对应的第二标签信息45之间的差异程度越小,第四子损失越小。

[0147]

在另一个示例中,第四子损失与第一标签信息43和第i个增量预训练后的学生语言模型44对应的第二标签信息45之间的差异程度负相关。也即,第一标签信息43和第i个增量预训练后的学生语言模型44对应的第二标签信息45之间的差异程度越大,第四子损失越小;第一标签信息43和第i个增量预训练后的学生语言模型44对应的第二标签信息45之间的差异程度越小,第四子损失越大。

[0148]

2、基于第i个增量预训练后的学生语言模型44对应的第二标签信息45和其他增量预训练后的学生语言模型44对应的第二标签信息45,确定第五子损失,第五子损失与第i个增量预训练后的学生语言模型44对应的第二标签信息45和其他增量预训练后的学生语言模型44对应的第二标签信息45之间的差异程度相关。

[0149]

在一个示例中,第五子损失与第i个增量预训练后的学生语言模型44对应的第二标签信息45和其他增量预训练后的学生语言模型44对应的第二标签信息45之间的差异程度正相关。也即,第i个增量预训练后的学生语言模型44对应的第二标签信息45和其他增量预训练后的学生语言模型44对应的第二标签信息45之间的差异程度越大,第五子损失越大;第i个增量预训练后的学生语言模型44对应的第二标签信息45和其他增量预训练后的学生语言模型44对应的第二标签信息45之间的差异程度越小,第五子损失越小。

[0150]

在另一个示例中,第五子损失与第i个增量预训练后的学生语言模型44对应的第二标签信息45和其他增量预训练后的学生语言模型44对应的第二标签信息45之间的差异程度负相关。也即,第i个增量预训练后的学生语言模型44对应的第二标签信息45和其他增量预训练后的学生语言模型44对应的第二标签信息45之间的差异程度越大,第五子损失越小;第i个增量预训练后的学生语言模型44对应的第二标签信息45和其他增量预训练后的学生语言模型44对应的第二标签信息45之间的差异程度越小,第五子损失越大。

[0151]

在一些可能的实现方式中,该步骤包括:

[0152]

(1)确定第i个增量预训练后的学生语言模型44对应的第二标签信息45和其他增量预训练后的学生语言模型44对应的第二标签信息45之间的kl散度;

[0153]

(2)基于kl散度确定第五子损失。

[0154]

在该实现方式中,通过计算kl散度确定第五子损失,使得各个增量预训练后的学生语言模型44通过知识蒸馏处理,彼此之间的性能尽可能地接近,从而提升各个学生语言模型的精度。

[0155]

3、基于第四子损失和第五子损失,确定第i个增量预训练后的学生语言模型44对应的第二损失46。

[0156]

可选地,第i个增量预训练后的学生语言模型44对应的第二损失46的计算方式参

考如下公式五:

[0157]

公式五:

[0158]

其中,p

t

为第一标签信息43,p

i

为第i个增量预训练后的学生语言模型44对应的第二标签信息45,crossentropy(p

t

,p

i

)为第一标签信息43与第i个增量预训练后的学生语言模型44对应的第二标签信息45之间的交叉熵,p

k

为其他增量预训练后的学生语言模型44对应的第二标签信息45,为第i个增量预训练后的学生语言模型44对应的第二标签信息45,与其他增量预训练后的学生语言模型44对应的第二标签信息45之间的kl散度。

[0159]

步骤308,基于第i个增量预训练后的学生语言模型44对应的第二损失46,调整第i个增量预训练后的学生语言模型44的参数,直至满足第二停止条件,得到第i个蒸馏后的学生语言模型。

[0160]

在一些实施例中,确定第二损失46之后,根据第二损失46的值调整第i个增量预训练后的学生语言模型44的参数,再对第i个增量预训练后的学生语言模型44进行下一轮的训练和参数调整,知道满足第二停止条件,在停止训练,得到第i个蒸馏后的学生语言模型。

[0161]

可选地,第二停止训练条件包括:第i个增量预训练后的学生语言模型44的参数更新次数达到第二预设次数、第i个增量预训练后的学生语言模型44的预测精度达到第二预设精度等等。其中,第二预设次数的具体数值可以由相关技术人员根据实际情况进行设定,本技术实施例对此不作具体限定;第二预设精度可以由相关技术人员根据实际情况进行设定,本技术实施例对此不作具体限定。

[0162]

以上仅是对第二停止训练条件的示例性说明,第二停止训练条件还可以包括其他条件,本技术实施例对此不作具体限定。

[0163]

步骤309,采用目标任务的第二训练样本集,对蒸馏后的学生语言模型进行参数调整处理,得到完成训练的学生语言模型。

[0164]

该步骤309与上文图1实施例的步骤104的内容相同或相近,此处不再赘述。

[0165]

综上所述,本技术实施例提供的技术方案中,通过计算kl散度确定第五子损失,使得各个增量预训练后的学生语言模型44通过知识蒸馏处理,彼此之间的性能尽可能地接近,从而提升各个学生语言模型的精度,也增强了学生语言模型的泛化性能,可以根据实际需求,灵活选取所需的学生语言模型执行目标任务。

[0166]

另外,本技术实施例中,在采用教师语言模型对增量后的学生语言模型进行知识蒸馏处理之前,先采用目标任务的第三训练样本集,对教师语言模型控模型进一步进行微调,从而提升教师语言模型的精度,进而进一步提升由此得到的蒸馏后的学生语言模型的精度。

[0167]

在一些实施例中,该方法还包括:采用目标任务的第三训练样本集,对教师语言模型进行参数调整处理,得到调整后的教师语言模型41。其中,调整后的教师语言模型41用于对增量预训练后的学生语言模型44进行知识蒸馏处理。在采用教师语言模型41对增量后的学生语言模型进行知识蒸馏处理之前,先采用目标任务的第三训练样本集,对教师语言模型进一步进行微调,从而提升教师语言模型41的精度,进而进一步提升由此得到的蒸馏后的学生语言模型的精度。

[0168]

在一些实施例中,该方法还包括如下步骤:

[0169]

1、将目标任务的训练语料划分为至少一个训练语料片段;

[0170]

2、对训练语料片段进行映射处理,得到训练语料片段对应的分词向量、语义向量和位置向量;其中,分词向量用于指示训练语料片段的分词特征,语义向量用于指示训练语料片段的语义特征,位置向量用于指示训练语料片段的位置特征;

[0171]

3、基于训练语料片段对应的分词向量、语义向量和位置向量,生成训练语料片段对应的模型输入向量,模型输入向量用于输入至学生语言模型和/或教师语言模型进行模型训练。

[0172]

在该实现方式中,对训练语料片段进行标注的方法,是一种基于bioes(bbegin,inside,outside,end,single)编码的中文分词信息处理方法,除了映射得到训练语料片段对应的语义向量和位置向量,还通过映射得到了训练语料片段对应的分词向量,从而引入目标任务的训练语料的分词特征,进一步提升了基于目标任务的训练语料得到的学生语言模型和/或教师语言模型的精度。

[0173]

在一个示例中,如图5所示,对于“上海”一词,教师语言模型和/或学生语言模型会对“上”和“海”分别输出标注结果[nr,nr],然后再对[nr,nr]进行池化操作,如选择第一个字的标签信息或出现次数最多的标签信息作为整个词的标签信息。该标注方法包括如下步骤:

[0174]

1、将训练语料片段的分词信息以bioes的方式进行编码。

[0175]

其中,词的开头编码为b,词的结尾编码为e,词的中间部分编码为i,单字词编码为s,其他编码为o。

[0176]

2、将训练语料片段的bioes序列映射为分词向量51,并将训练语料片段分词向量51、语义向量52和位置向量53相加后得到的向量和输入到学生语言模型和/或教师语言模型中。

[0177]

3、得到学生语言模型和/或教师语言模型的中间输出后,将训练语料片段中,每个词的开头对应的标注结果作为整个词的标注结果,并基于此确定对应的损失并对学生语言模型和/或教师语言模型进行参数更新。

[0178]

下面,结合图6度本技术实施例进行总结介绍。如图6所示,若存在增量预训练语料,则该语言模型训练方法包括如下步骤(601~604):

[0179]

步骤601,获取经过全量预训练得到的全量训练后的学生语言模型。

[0180]

步骤602,采用增量预训练语料训练全量训练后的学生语言模型,得到增量预训练后的学生语言模型。

[0181]

步骤603,基于教师模型和知识蒸馏语料42对增量预训练后的学生语言模型进行知识蒸馏处理,得到蒸馏后的学生语言模型。

[0182]

步骤604,采用目标任务的第二训练样本集,对蒸馏后的学生语言模型进行参数调整处理,得到完成训练的学生语言模型。

[0183]

在一些实施例中,步骤601之后,若不存在增量预训练语料,则该语言模型训练方法还包括如下步骤(605~606):

[0184]

步骤605,基于教师模型和知识蒸馏语料42对全量预训练后的学生语言模型进行知识蒸馏处理,得到蒸馏后的全量学生语言模型。

[0185]

步骤606,采用目标任务的第二训练样本集,对蒸馏后的全量学生语言模型进行参数调整处理,得到完成全量训练的学生语言模型。

[0186]

在特定的测试环境下,使用本技术实施例提供的方法得到的完成训练的学生语言模型,其推理速度可达到教师语言模型的8至10倍,预测准确率为教师模型的97%左右。

[0187]

经过实际测试,本技术方案提供的完成训练后的学生语言模型,在公开测试集上的预测准确率与相关技术中的学生语言模型相比,提高了1%左右。

[0188]

下述为本技术装置实施例,可以用于执行本技术方法实施例。对于本技术装置实施例中未披露的细节,请参照本技术方法实施例。

[0189]

请参考图7,其示出了本技术一个实施例提供的语言模型训练装置的框图。该装置具有实现上述语言模型训练方法示例的功能,所述功能可以由硬件实现,也可以由硬件执行相应的软件实现。该装置可以是上文介绍的计算机设备,也可以设置在计算机设备上。该装置700可以包括:全量预训练模块710、增量预训练模块720、模型蒸馏模块730和参数调整模块740。

[0190]

所述全量预训练模块710,用于基于全量预训练语料对初始的学生语言模型进行全量预训练,得到全量预训练后的学生语言模型。

[0191]

所述增量预训练模块720,用于基于增量预训练语料对所述全量预训练后的学生语言模型进行增量预训练,得到增量预训练后的学生语言模型;其中,所述增量预训练语料是在所述全量预训练语料的基础上新增的预训练语料。

[0192]

所述模型蒸馏模块730,用于采用教师语言模型对所述增量预训练后的学生语言模型进行知识蒸馏处理,得到蒸馏后的学生语言模型;其中,所述教师语言模型是采用目标任务的第一训练样本集进行训练得到的语言模型。

[0193]

所述参数调整模块740,用于采用所述目标任务的第二训练样本集,对所述蒸馏后的学生语言模型进行参数调整处理,得到完成训练的学生语言模型。

[0194]

综上所述,本技术实施例提供的技术方案中,通过在获取了增量预训练语料之后,在全量预训练后的学生语言模型的基础上,仅使用增量预训练语料对学生语言模型进行增量预训练,原有的全量预训练语料无需参与增量预训练过程,节省了增量预训练时间,进而节省了学生语言模型整体的训练时间。

[0195]

在示例性实施例中,如图8所示,所述增量预训练模块720,包括:结果获取子模块721、损失确定子模块722和参数调整子模块723。

[0196]

所述结果获取子模块721,用于获取第一预测结果和第二预测结果,所述第一预测结果是指增量预训练中的学生语言模型在所述增量预训练语料上的预测结果,所述第二预测结果是指所述全量预训练后的学生语言模型在所述增量预训练语料上的预测结果。

[0197]

所述损失确定子模块722,用于基于所述第一预测结果、所述第二预测结果和所述增量预训练语料的标签信息,确定第一损失;其中,所述第一损失与所述第一预测结果和所述增量预训练语料的标签信息之间的差异程度相关,且与所述第一预测结果和所述第二预测结果之间的差异程度相关。

[0198]

所述参数调整子模块723,用于基于所述第一损失调整所述增量预训练中的学生语言模型的参数,直至满足第一停止条件,得到所述增量预训练后的学生语言模型。

[0199]

在示例性实施例中,如图8所示,所述损失确定子模块722,包括:损失确定单元

7221。

[0200]

所述损失确定单元7221,用于基于所述第一预测结果和所述增量预训练语料的标签信息,确定第一子损失,所述第一子损失与所述第一预测结果和所述增量预训练语料的标签信息之间的差异程度相关;

[0201]

所述损失确定单元7221,还用于基于所述第一预测结果和所述第二预测结果,确定第二子损失,所述第二子损失与所述第一预测结果和所述第二预测结果之间的差异程度相关。

[0202]

所述损失确定单元7221,还用于基于所述第一子损失和所述第二子损失,确定所述第一损失。

[0203]

在示例性实施例中,如图8所示,所述装置700,还包括:数据获取模块750和损失确定模块760。

[0204]

所述数据获取模块750,用于获取第一隐层状态数据和第二隐层状态数据,所述第一隐层状态数据是指所述增量预训练中的学生语言模型在生成所述第一预测结果时的隐层状态数据,所述第二隐层状态数据是指所述全量预训练后的学生语言模型在生成所述第二预测结果时的隐层状态数据。

[0205]

所述损失确定模块760,用于基于所述第一隐层状态数据和所述第二隐层状态数据,确定第三子损失,所述第三子损失与所述第一隐层状态数据和所述第二隐层状态数据之间的差异程度相关。

[0206]

所述损失确定单元7221,包括:损失确定子单元72211。

[0207]

所述损失确定子单元72211,用于基于所述第一子损失、所述第二子损失和所述第三子损失,确定所述第一损失。

[0208]

在示例性实施例中,如图8所示,所述损失确定子单元72211,用于:

[0209]

获取所述第一子损失、所述第二子损失和所述第三子损失分别对应的权重值;

[0210]

基于所述权重值对所述第一子损失、所述第二子损失和所述第三子损失进行加权求和,得到所述第一损失。

[0211]

在示例性实施例中,如图8所示,所述结果获取子模块721,用于:

[0212]

对所述增量预训练语料中的目标文本进行遮盖处理,生成带遮盖的增量预训练语料;

[0213]

通过所述增量预训练中的学生语言模型对所述带遮盖的增量预训练语料进行处理,得到所述第一预测结果,所述第一预测结果包括所述增量预训练中的学生语言模型预测得到的被遮盖文本;

[0214]

通过所述全量预训练后的学生语言模型对所述带遮盖的增量预训练语料进行处理,得到所述第二预测结果,所述第二预测结果包括所述全量预训练后的学生语言模型预测得到的被遮盖文本。

[0215]

在示例性实施例中,如图8所示,所述模型蒸馏模块730,包括:标签确定子模块731。

[0216]

所述标签确定子模块731,用于基于所述教师语言模型和知识蒸馏语料,确定第一标签信息;其中,所述第一标签信息是指所述教师语言模型在所述知识蒸馏语料上推理得到的标签信息。

[0217]

所述标签确定子模块731,还用于基于多个所述增量预训练后的学生语言模型和所述知识蒸馏语料,确定多个第二标签信息;其中,所述第二标签信息是指所述增量预训练后的学生语言模型在所述知识蒸馏语料上推理得到的标签信息。

[0218]

所述损失确定子模块722,还用于对于第i个增量预训练后的学生语言模型,基于所述第一标签信息、所述第i个增量预训练后的学生语言模型对应的第二标签信息以及其他增量预训练后的学生语言模型对应的第二标签信息,确定所述第i个增量预训练后的学生语言模型对应的第二损失;其中,所述第i个增量预训练后的学生语言模型对应的第二损失与所述第一标签信息和所述第i个增量预训练后的学生语言模型对应的第二标签信息之间的差异程度相关,且与所述第i个增量预训练后的学生语言模型对应的第二标签信息和所述其他增量预训练后的学生语言模型对应的第二标签信息之间的差异程度相关,所述i为正整数。

[0219]

所述参数调整子模块723,还用于基于所述第i个增量预训练后的学生语言模型对应的第二损失,调整所述第i个增量预训练后的学生语言模型的参数,直至满足第二停止条件,得到第i个蒸馏后的学生语言模型。

[0220]

在示例性实施例中,如图8所示,所述损失确定单元7221,还用于基于所述第一标签信息和所述第i个增量预训练后的学生语言模型对应的第二标签信息,确定第四子损失,所述第四子损失与所述第一标签信息和所述第i个增量预训练后的学生语言模型对应的第二标签信息之间的差异程度相关。

[0221]

所述损失确定单元7221,还用于基于所述第i个增量预训练后的学生语言模型对应的第二标签信息和所述其他增量预训练后的学生语言模型对应的第二标签信息,确定第五子损失,所述第五子损失与所述第i个增量预训练后的学生语言模型对应的第二标签信息和所述其他增量预训练后的学生语言模型对应的第二标签信息之间的差异程度相关。

[0222]

所述损失确定单元7221,还用于基于所述第四子损失和所述第五子损失,确定所述第i个增量预训练后的学生语言模型对应的第二损失。

[0223]

在示例性实施例中,如图8所示,所述损失确定单元7221,用于:

[0224]

确定所述第i个增量预训练后的学生语言模型对应的第二标签信息和所述其他增量预训练后的学生语言模型对应的第二标签信息之间的kl散度;

[0225]

基于所述kl散度确定所述第五子损失。

[0226]

在示例性实施例中,所述标签信息为软标签信息,所述软标签信息是指模型在所述知识蒸馏语料上进行推理过程中生成的特征图。

[0227]

在示例性实施例中,如图8所示,所述参数调整模块740,还用于采用所述目标任务的第三训练样本集,对所述教师语言模型进行参数调整处理,得到调整后的教师语言模型;其中,所述调整后的教师语言模型用于对所述增量预训练后的学生语言模型进行知识蒸馏处理。

[0228]

在示例性实施例中,如图8所示,所述参数调整模块740,用于:

[0229]

将所述目标任务的训练语料划分为至少一个训练语料片段;

[0230]

对所述训练语料片段进行映射处理,得到所述训练语料片段对应的分词向量、语义向量和位置向量;其中,所述分词向量用于指示所述训练语料片段的分词特征,所述语义向量用于指示所述训练语料片段的语义特征,所述位置向量用于指示所述训练语料片段的

位置特征;

[0231]

基于所述训练语料片段对应的分词向量、语义向量和位置向量,生成所述训练语料片段对应的模型输入向量,所述模型输入向量用于输入至所述学生语言模型和/或所述教师语言模型进行模型训练。

[0232]

需要说明的是,上述实施例提供的装置,在实现其功能时,仅以上述各功能模块的划分进行举例说明,实际应用中,可以根据需要而将上述功能分配由不同的功能模块完成,即将设备的内部结构划分成不同的功能模块,以完成以上描述的全部或者部分功能。另外,上述实施例提供的装置与方法实施例属于同一构思,其具体实现过程详见方法实施例,这里不再赘述。

[0233]

请参考图9,其示出了本技术一个实施例提供的计算机设备的结构框图。该计算机设备用于实施上述实施例中提供的语言模型训练方法。具体来讲:

[0234]

所述计算机设备900包括cpu(central processing unit,中央处理单元)901、包括ram(random access memory,随机存取存储器)902和rom(read

‑

only memory,只读存储器)903的系统存储器904,以及连接系统存储器904和中央处理单元901的系统总线905。所述计算机设备900还包括帮助计算机内的各个器件之间传输信息的基本i/o(input/output,输入/输出)系统906,和用于存储操作系统913、应用程序914和其他程序模块915的大容量存储设备907。

[0235]

所述基本输入/输出系统906包括有用于显示信息的显示器908和用于用户输入信息的诸如鼠标、键盘之类的输入设备909。其中所述显示器908和输入设备909都通过连接到系统总线905的输入输出控制器910连接到中央处理单元901。所述基本输入/输出系统906还可以包括输入输出控制器910以用于接收和处理来自键盘、鼠标、或电子触控笔等多个其他设备的输入。类似地,输入输出控制器910还提供输出到显示屏、打印机或其他类型的输出设备。

[0236]

所述大容量存储设备907通过连接到系统总线905的大容量存储控制器(未示出)连接到中央处理单元901。所述大容量存储设备907及其相关联的计算机可读介质为计算机设备900提供非易失性存储。也就是说,所述大容量存储设备907可以包括诸如硬盘或者cd

‑

rom(compact disc read

‑

only memory,只读光盘)驱动器之类的计算机可读介质(未示出)。

[0237]

不失一般性,所述计算机可读介质可以包括计算机存储介质和通信介质。计算机存储介质包括以用于存储诸如计算机可读指令、数据结构、程序模块或其他数据等信息的任何方法或技术实现的易失性和非易失性、可移动和不可移动介质。计算机存储介质包括ram、rom、eprom(erasable programmable read only memory,可擦除可编程只读存储器)、eeprom(electrically erasable programmable read only memory,可擦除可编程只读存储器)、闪存或其他固态存储其技术,cd

‑

rom、dvd(digital video disc,高密度数字视频光盘)或其他光学存储、磁带盒、磁带、磁盘存储或其他磁性存储设备。当然,本领域技术人员可知所述计算机存储介质不局限于上述几种。上述的系统存储器904和大容量存储设备907可以统称为存储器。

[0238]

根据本技术的各种实施例,所述计算机设备900还可以通过诸如因特网等网络连接到网络上的远程计算机运行。也即计算机设备900可以通过连接在所述系统总线905上的

网络接口单元911连接到网络912,或者说,也可以使用网络接口单元911来连接到其他类型的网络或远程计算机系统(未示出)。

[0239]

在示例性实施例中,还提供了一种计算机可读存储介质,所述存储介质中存储有至少一条指令、至少一段程序、代码集或指令集,所述至少一条指令、所述至少一段程序、所述代码集或指令集在被处理器执行时以实现上述语言模型训练方法。

[0240]

在示例性实施例中,还提供了一种计算机程序产品,当该计算机程序产品被处理器执行时,其用于实现上述语言模型训练方法。

[0241]

应当理解的是,在本文中提及的“多个”是指两个或两个以上。在本文中提及的“多个”是指两个或两个以上。“和/或”,描述关联对象的关联关系,表示可以存在三种关系,例如,a和/或b,可以表示:单独存在a,同时存在a和b,单独存在b这三种情况。字符“/”一般表示前后关联对象是一种“或”的关系。本领域技术人员在考虑说明书及实践这里公开的申请后,将容易想到本技术的其它实施方案。本技术旨在涵盖本技术的任何变型、用途或者适应性变化,这些变型、用途或者适应性变化遵循本技术的一般性原理并包括本技术未公开的本技术领域中的公知常识或惯用技术手段。说明书和实施例仅被视为示例性的,本技术的真正范围和精神由下面的权利要求指出。

[0242]

应当理解的是,本技术并不局限于上面已经描述并在附图中示出的精确结构,并且可以在不脱离其范围进行各种修改和改变。本技术的范围仅由所附的权利要求来限制。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。