技术特征:

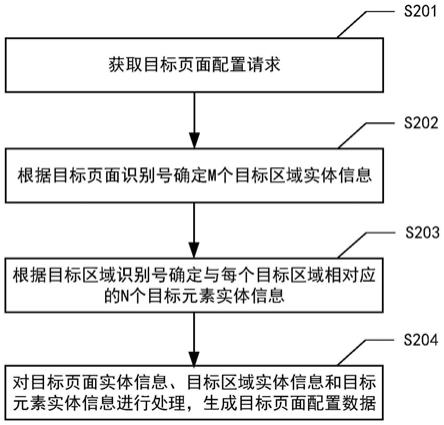

1.一种基于对比类别集中提升连续学习下图分类精度的方法,用于对已经过历史数据训练的图分类模型进行类增长学习,所述图分类模型由特征提取器和分类器组成,其特征在于:s1:获取加入新类别的图像分类数据集,图像分类数据集中每个样本均带有其类别标签;s2:获取所述图分类模型在上一轮训练过程中进行参数更新前的旧模型和参数更新后的新模型,然后利用加入新类别的图像分类数据集构建训练数据,按照s21~s25进行本轮训练;s21:将训练数据输入所述新模型的特征提取器中提取第一样本表征,在真实类别标签监督下计算对比误差损失,用于聚合相同类别样本的表征同时拉远不同类别样本的表征;s22:将训练数据输入所述旧模型的特征提取器中提取第二样本表征,对所述第一样本表征和第二样本表征进行表征层面的蒸馏并计算表征蒸馏误差损失,用于从表征层面保存模型知识的同时保证表征空间相对稳定;s23:基于所述的第一样本表征,通过所述新模型的分类器进行类别预测得到第一预测类别概率,并计算交叉熵损失;s24:基于所述的第一样本表征,通过所述旧模型的分类器进行类别预测得到第二预测类别概率,并计算第一预测类别概率和第二预测类别概率之间的均方误差损失;s25:以所述对比误差损失、表征蒸馏误差损失、交叉熵损失和均方误差损失之和作为对比类别集中误差损失,通过最小化该对比类别集中误差对所述新模型进行参数优化更新;s3:保存本轮参数更新前的旧模型和参数更新后的新模型,并在进行下一轮训练之前利用本轮参数更新后的新模型进行图分类任务。2.如权利要求1所述的基于对比类别集中提升连续学习下图分类精度的方法,其特征在于,通过内存存储所述图分类模型在训练过程中输入的不同类别的训练样本;其中每一轮训练开始时,将加入新类别的图像分类数据集与内存中存储的所有不同类别的训练样本一起作为训练数据对模型进行训练,每一轮训练结束后,通过随机采样的方式从本轮所输入的训练数据中选择部分属于新类别的样本放入内存中,同时从内存中的每个旧类别中移除固定数量的样本,从而保持内存总容量不变的同时增加类别数。3.如权利要求1所述的基于对比类别集中提升连续学习下图分类精度的方法,其特征在于,所述训练数据在用于本轮训练之前,预先经过数据增广以扩充样本量。4.如权利要求3所述的基于对比类别集中提升连续学习下图分类精度的方法,其特征在于,所述数据增广方式包括随机的切割、翻转、对比度和灰度调整。5.如权利要求1~3任一所述的基于对比类别集中提升连续学习下图分类精度的方法,其特征在于,所述s21的具体实现步骤如下:s211:将当前第t轮训练对应的训练数据d

(t)

输入所述新模型m

(t)

中,使用内部的特征提取器e

θ(t)

获得训练数据d

(t)

中每一个样本x

i(t)

的特征r

i(t)

,所有样本的特征构成第一样本表征r

(t)

;s212:基于第一样本表征r

(t)

中每个特征所对应的类别标签,计算每个特征与其他特征之间的相似性;所述相似性使用点乘之后取二范数来表示,任意两个特征r

i(t)

和r

j(t)

之间的

相似性s(x

i(t)

,x

j(t)

)计算公式为:式中:||

·

||表示二范数;s213:将相同类别样本的特征视为正样本,不同类别样本的特征作为负样本,通过计算对比误差损失来聚合相同类别样本的表征同时拉远不同类别样本的表征;所述对比误差损失函数公式为:其中:b为输入的训练数据d

(t)

中的样本个数,为训练数据d

(t)

中除样本x

i(t)

之外的其余样本的索引集合。6.如权利要求5所述的基于对比类别集中提升连续学习下图分类精度的方法,其特征在于,所述s22的具体实现步骤包括:s221:将当前第t轮训练对应的训练数据d

(t)

输入所述旧模型m

(t

‑

1)

中,使用内部的特征提取器e

θ(t

‑

1)

获得训练数据d

(t)

中每一个样本x

i(t)

的特征r

i(t

‑

1)

,所有样本的特征构成第二样本表征r

(t

‑

1)

;s222:结合所述第一样本表征r

(t)

和第二样本表征r

(t

‑

1)

进行表征层面的蒸馏,计算表征蒸馏误差损失计算公式为:其中:表示训练数据d

(t)

中所有样本的索引集合。7.如权利要求6所述的基于对比类别集中提升连续学习下图分类精度的方法,其特征在于,所述s23的具体实现步骤包括:s231:将前述的第一样本表征r

(t)

输入前述新模型m

(t)

中的分类器中进行分类预测,获得当前训练数据中各样本的第一预测类别概率;s232:结合训练数据d

(t)

中各样本的第一预测类别概率和真实标签,计算交叉熵损失8.如权利要求7所述的基于对比类别集中提升连续学习下图分类精度的方法,其特征在于,所述s24的具体实现步骤包括:s241:将第二样本表征r

(t

‑

1)

输入所述旧模型m

(t

‑

1)

中的分类器中进行分类预测,获得当前训练数据的第二预测类别概率;s242:基于训练数据d

(t)

中各样本的第一预测类别概率和第二预测类别概率,计算均方误差损失计算公式为:

式中:和分别表示样本x

i(t)

的第一预测类别概率和第二预测类别概率,n

(t)

表示引入本轮类增长学习后的图片分类类别总数,mse表示计算均方误差。9.如权利要求8所述的基于对比类别集中提升连续学习下图分类精度的方法,其特征在于,所述s25的具体实现步骤包括:s251:将s21~s24中的四种损失进行加和,得到总的对比类别集中误差损失得到总的对比类别集中误差损失s252:以最小化所述对比类别集中误差损失为目标,对所述新模型进行网络参数优化,完成本轮模型训练。10.如权利要求1所述的基于对比类别集中提升连续学习下图分类精度的方法,其特征在于,所述特征提取器为resnet32网络。

技术总结

本发明公开了一种基于对比类别集中提升连续学习下图分类精度的方法。该方法用于对已经过历史数据训练的图分类模型进行类增长学习,具体步骤如下:S1:获取加入新类别的图像分类数据集,图像分类数据集中每个样本均带有其类别标签;S2:获取所述图分类模型在上一轮训练过程中进行参数更新前的旧模型和参数更新后的新模型,然后利用加入新类别的图像分类数据集构建训练数据,进行本轮训练;S3:保存本轮参数更新前的旧模型和参数更新后的新模型,并在进行下一轮训练之前利用本轮参数更新后的新模型进行图分类任务。本发明结合对比学习和知识蒸馏的思想,能够帮助模型学习到更加聚合的数据表征,从而缓解表征覆盖,帮助模型减少灾难性遗忘。灾难性遗忘。灾难性遗忘。

技术研发人员:汤斯亮 倪子烜 庄越挺 史海舟 肖俊

受保护的技术使用者:浙江大学

技术研发日:2021.07.13

技术公布日:2021/10/26

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。