1.本技术涉及文本处理领域,特别涉及一种阅读理解模型的训练方法和装置、文本分析的方法和装置、计算设备以及计算机可读存储介质。

背景技术:

2.自然语言处理(natural language processing,nlp)是计算机科学领域与人工智能领域中的一个重要方向,它研究能实现人与计算机之间用自然语言进行有效通信的各种理论和方法。

3.对于自然语言处理任务,能够用双向注意力神经网络模型模型(bidirectional encoder representation from transformers,bert)进行处理。bert模型可以通过当前次的左、右两侧上下文来预测当前词,还可以通过当前句子预测下一个句子的语义,具体地,机器阅读理解包括抽取式阅读理解和生成式阅读理解,抽取式阅读理解是文章中有答案原句,模型通过确定答案的起点和终点可以确定答案;生成式阅读理解即文章中没有答案原句,模型需要理解问题和文章,然后生成答案。

4.现有技术中,bert模型在进行阅读理解任务时,使用额外的命名实体识别模型和词性识别模型提前分别对阅读理解数据进行命名实体识别和词性标注。再将识别的命名实体和词性标签转化成向量信息,直接加在bert模型输出的词向量上,或是拼接在bert输出的词向量上,给模型带来的参数和噪音比带来的词性信息更多,并且外部的命名实体识别和词性标注的模型准确率不高,导致bert模型的预测准确率下降。

技术实现要素:

5.有鉴于此,本技术实施例提供了一种阅读理解模型的训练方法和装置、文本分析的方法和装置、计算设备和计算机可读存储介质,以解决现有技术中存在的技术缺陷。

6.本技术实施例公开了一种阅读理解模型的训练方法,所述阅读理解模型包括编码器和阅读理解解码器,所述编码器还分别与命名实体解码器和词性解码器连接,所述训练方法包括:

7.获取阅读理解训练数据集、命名实体训练数据集和词性训练数据集,生成至少一个组合训练数据集,其中,每个组合训练数据集包括阅读理解训练数据、命名实体训练数据和词性训练数据;

8.将所述组合训练数据集输入至编码器中进行编码,获得所述编码器输出的编码向量;

9.将所述编码向量分别输入至阅读理解解码器、命名实体解码器和词性解码器进行解码,确定所述阅读理解解码器、命名实体解码器和词性解码器分别对应的损失值;

10.根据所述阅读理解解码器、命名实体解码器和词性解码器分别对应的损失值,调整所述阅读理解解码器、命名实体解码器、词性解码器和所述编码器的参数,完成当前次训练并进行下次训练直至达到训练停止条件。

11.本技术实施例还公开了一种文本分析的方法,包括:

12.接收原文本和问题;

13.将所述原文本和问题输入至阅读理解模型中,获取所述阅读理解模型输出的答案,其中,所述阅读理解模型通过所述阅读理解模型的训练方法训练得到的。

14.本技术实施例还公开了一种阅读理解模型的训练装置,所述阅读理解模型包括编码器和阅读理解解码器,所述编码器还分别与命名实体解码器和词性解码器连接,所述训练装置包括:

15.提取模块,被配置为获取阅读理解训练数据集、命名实体训练数据集和词性训练数据集,生成至少一个组合训练数据集,其中,每个组合训练数据集包括阅读理解训练数据、命名实体训练数据和词性训练数据;

16.编码模块,被配置为将所述组合训练数据集输入至编码器中进行编码,获得所述编码器输出的编码向量;

17.确定模块,被配置为将所述编码向量分别输入至阅读理解解码器、命名实体解码器和词性解码器进行解码,确定所述阅读理解解码器、命名实体解码器和词性解码器分别对应的损失值;

18.调整模块,被配置为根据所述阅读理解解码器、命名实体解码器和词性解码器分别对应的损失值,调整所述阅读理解解码器、命名实体解码器、词性解码器和所述编码器的参数,完成当前次训练并进行下次训练直至达到训练停止条件。

19.本技术实施例还公开了一种文本分析的装置,包括:

20.接收模块,被配置为接收原文本和问题;

21.获取模块,被配置为将所述原文本和问题输入至阅读理解模型中,获取所述阅读理解模型输出的答案,其中,所述阅读理解模型通过所述阅读理解模型的训练方法训练得到的。

22.本技术实施例公开了一种计算设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机指令,所述处理器执行所述指令时实现如上所述的阅读理解模型的训练方法或文本分析的方法的步骤。

23.本技术实施例公开了一种计算机可读存储介质,其存储有计算机指令,该指令被处理器执行时实现如上所述的阅读理解模型的训练方法或文本分析的方法的步骤。

24.本技术提供的一种阅读理解模型的训练方法和装置、文本分析的方法和装置,通过在编码器分别连接命名实体解码器和词性解码器,并提取所述阅读理解训练数据集、命名实体训练数据集和词性训练数据集进行组合以生成至少一个组合训练数据集,实现阅读理解训练任务、命名实体识别训练任务以及词性识别训练任务,换言之在阅读理解模型进行阅读理解训练任务的基础上,再加上预测命名实体识别训练任务和词性标注的训练任务,使得阅读理解模型能够学习命名实体识别以及词性标注的知识,最终根据所述阅读理解解码器、命名实体解码器和词性解码器分别对应的损失值,调整所述阅读理解解码器、命名实体解码器、词性解码器和所述编码器的参数,也就是使用多任务学习的方法增强阅读理解模型的语法知识,提高阅读理解模型的泛化效果,进而提高阅读理解模型在做机器阅读理解时的准确率。

附图说明

25.图1是本技术实施例的计算设备的结构示意图;

26.图2是本技术第一实施例阅读理解模型的训练方法的流程示意图;

27.图3是本技术第一实施例阅读理解模型的结构示意图;

28.图4是本技术第二实施例阅读理解模型的训练方法的流程示意图;

29.图5是本技术第三实施例文本分析的方法的流程示意图;

30.图6是本技术实施例阅读理解模型的训练装置结构示意图;

31.图7是本技术实施例文本分析的装置结构示意图。

具体实施方式

32.在下面的描述中阐述了很多具体细节以便于充分理解本技术。但是本技术能够以很多不同于在此描述的其它方式来实施,本领域技术人员可以在不违背本技术内涵的情况下做类似推广,因此本技术不受下面公开的具体实施的限制。

33.在本说明书一个或多个实施例中使用的术语是仅仅出于描述特定实施例的目的,而非旨在限制本说明书一个或多个实施例。在本说明书一个或多个实施例和所附权利要求书中所使用的单数形式的“一种”、“所述”和“该”也旨在包括多数形式,除非上下文清楚地表示其他含义。还应当理解,本说明书一个或多个实施例中使用的术语“和/或”是指并包含一个或多个相关联的列出项目的任何或所有可能组合。

34.应当理解,尽管在本说明书一个或多个实施例中可能采用术语第一、第二等来描述各种信息,但这些信息不应限于这些术语。这些术语仅用来将同一类型的信息彼此区分开。例如,在不脱离本说明书一个或多个实施例范围的情况下,第一也可以被称为第二,类似地,第二也可以被称为第一。取决于语境,如在此所使用的词语“如果”可以被解释成为“在

……

时”或“当

……

时”或“响应于确定”。

35.首先,对本发明一个或多个实施例涉及的名词术语进行解释。

36.机器阅读理解(machine reading comprehension):主要是根据问题通过对应的段落给出该问题的答案,对于自然语言处理中的阅读理解模型,其训练方法通常包括两个阶段,其一为使用大量的无监督文本对模型进行预训练,其二是使用预训练的模型在具体的下游任务即阅读理解任务中进行微调。微调阶段主要对与编码层连接的线性网络层进行训练。其中,预训练的模型的网络架构由多层的transformer的编码器组成,线性网络对编码器最后一层的输出进行线性变换,得到模型最后的输出结果。

37.抽取式阅读理解:文章中有答案原句,模型通过确定答案的起点和终点可以确定答案。

38.生成式阅读理解:文章中没有答案原句,模型需要理解问题和文章,然后生成答案。

39.transformer:transformer中抛弃了传统的cnn和rnn,整个网络结构完全是由attention机制组成。更准确地讲,transformer由且仅由self-attenion和feed forward neural network组成。一个基于transformer的可训练的神经网络可以通过堆叠transformer的形式进行搭建,比如通过搭建编码器和解码器各6层,总共12层的encoder-decoder。

40.阅读理解模型(bidirectional encoder representations from transformers,bert):一种双向注意力神经网络模型,一种通用预训练语言表示模型。bert模型可以通过当前次的左、右两侧上下文来预测当前词,还可以通过当前句子预测下一个句子的语义。bert模型的目标是利用大规模无标注语料训练、获得包含丰富语义信息的文本语义表示,然后将文本的语义表示在特定nlp任务中作微调,最终应用于该nlp任务。

41.阅读理解训练数据集:在阅读理解训练任务中用于训练bert模型的训练数据的集合,可以是斯坦福发布的机器阅读理解数据集(squad)。

42.命名实体训练数据集:在命名实体识别训练任务中用于训练bert模型的训练数据的集合。

43.词性训练数据集:在词性标注训练任务中用于训练bert模型的训练数据的集合。

44.组合训练数据集:包括至少一个阅读理解训练数据、至少一个命名实体训练数据和至少一个词性训练数据的集合。

45.标签:网络模型训练阶段,每个训练数据对应的真实结果。

46.编码器:将输入词序列转化成一个固定维度的稠密向量。

47.阅读理解解码器:将编码器输出的稠密向量解码生成预测的答案。

48.命名实体解码器:将编码器输出的稠密向量解码生成预测的命名实体。

49.词性解码器:将编码器输出的稠密向量解码生成每个词预测的词性。

50.样本文本:对阅读理解模型进行训练的文本。

51.损失值:模型输出的预测值与真实值的误差。

52.原文本:阅读理解模型根据原文本和问题,阅读理解模型输出问题的答案。

53.损失函数:是将随机事件或其有关随机变量的取值映射为非负实数以表示该随机事件的“风险”或“损失”的函数。

54.交叉熵损失函数(cross-entropy cost function):是用来衡量卷积神经网络的预测值与实际值的一种方式。与二次代价函数相比,它能更有效地促进卷积神经网络的训练。

55.在本技术中,提供了一种阅读理解模型的训练方法和装置、文本分析的方法和装置、计算设备以及计算机可读存储介质,在下面的实施例中逐一进行详细说明。

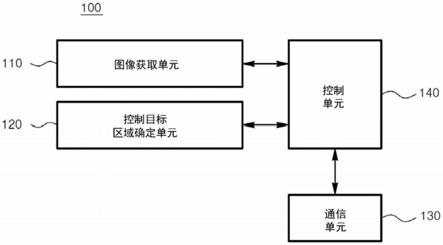

56.图1是示出了根据本说明书一实施例的计算设备100的结构框图。该计算设备100的部件包括但不限于存储器110和处理器120。处理器120与存储器110通过总线130相连接,数据库150用于保存数据。

57.计算设备100还包括接入设备140,接入设备140使得计算设备100能够经由一个或多个网络160通信。这些网络的示例包括公用交换电话网(pstn)、局域网(lan)、广域网(wan)、个域网(pan)或诸如因特网的通信网络的组合。接入设备140可以包括有线或无线的任何类型的网络接口(例如,网络接口卡(nic))中的一个或多个,诸如ieee802.11无线局域网(wlan)无线接口、全球微波互联接入(wi-max)接口、以太网接口、通用串行总线(usb)接口、蜂窝网络接口、蓝牙接口、近场通信(nfc)接口,等等。

58.在本说明书的一个实施例中,计算设备100的上述部件以及图1中未示出的其他部件也可以彼此相连接,例如通过总线。应当理解,图1所示的计算设备结构框图仅仅是出于示例的目的,而不是对本说明书范围的限制。本领域技术人员可以根据需要,增添或替换其

他部件。

59.计算设备100可以是任何类型的静止或移动计算设备,包括移动计算机或移动计算设备(例如,平板计算机、个人数字助理、膝上型计算机、笔记本计算机、上网本等)、移动电话(例如,智能手机)、可佩戴的计算设备(例如,智能手表、智能眼镜等)或其他类型的移动设备,或者诸如台式计算机或pc的静止计算设备。计算设备100还可以是移动式或静止式的服务器。

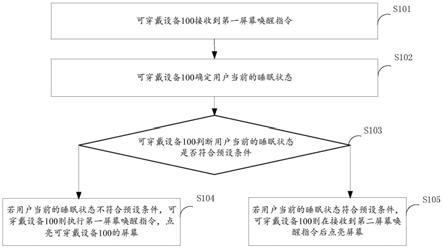

60.其中,处理器120可以执行图2所示方法中的步骤。图2是示出了根据本技术第一实施例的阅读理解模型的训练方法的示意性流程图,包括步骤202至步骤208。

61.步骤202:获取阅读理解训练数据集、命名实体训练数据集和词性训练数据集,生成至少一个组合训练数据集,其中,每个组合训练数据集包括阅读理解训练数据、命名实体训练数据和词性训练数据。

62.参见图3所示,所述阅读理解模型包括编码器和阅读理解解码器,所述编码器还分别与命名实体解码器和词性解码器连接。

63.所述阅读理解训练数据集可以为斯坦福发布的机器阅读理解数据集,当然,所述阅读理解训练数据集也可以为其它阅读理解数据集,比如,一条阅读理解训练数据的样本文本为

“‘

落霞与孤鹜齐飞,秋水共长天一色’出自王勃所作的《滕王阁序》”,样本问题包括“《滕王阁序》的作者是谁?”,阅读理解训练数据对应的标签包括答案存在信息“有答案”和样本答案“王勃”。

64.所述命名实体训练数据集中的样本文本中命名实体已完成标注,比如,所述命名实体训练数据的样本文本为“张三今天去北京的鸟巢参观了”,标注的命名实体“张三”、“北京”和“鸟巢”作为命名实体训练数据对应的标签。

65.所述词性训练数据集中的样本文本中各个词的词性已完成标注,比如所述词性训练数据集中的样本文本为“我吃苹果”,分别标注的“我”、“吃”和“苹果”的词性“代词”、“动词”和“名词”作为词性训练数据对应的标签。

66.所述组合训练数据集包括词性训练数据、阅读理解训练数据和命名实体训练数据,可以分别提取阅读理解训练数据集、命名实体训练数据集和词性训练数据集中的部分数据组合成一条组合训练数据集,一条组合训练数据集对阅读理解模型进行一次训练,确保下述步骤中阅读理解模型能够分别学习阅读理解、命名实体识别以及词性标注的知识。

67.步骤204:将所述组合训练数据集输入至编码器中进行编码,获得所述编码器输出的编码向量。

68.本步骤中阅读理解模型的编码器对组合训练数据集中所有的训练数据进行编码。

69.具体地,假设一条组合训练数据集中包括阅读理解训练数据a、命名实体训练数据b和词性训练数据c,组合训练数据集为[a、b、c]。

[0070]

在进行步骤202将至少一个组合训练数据集输入至编码器中进行编码之前,还包括:

[0071]

对所述组合训练数据集中的阅读理解训练数据、命名实体训练数据和词性训练数据分别设置对应标志。

[0072]

比如将阅读理解训练数据、命名实体训练数据和词性训练数据分别对应设置标志0、1和2。

[0073]

也就是一条组合训练数据集中阅读理解训练数据a对应的标志为0,命名实体训练数据b对应的标志为1,词性训练数据c对应的标志为2。

[0074]

将所述组合训练数据集[a、b、c]输入至编码器中进行编码,获得所述编码器输出的所述组合训练数据集对应的编码向量[a、b、c]。

[0075]

步骤206:将所述编码向量分别输入至阅读理解解码器、命名实体解码器和词性解码器进行解码,确定所述阅读理解解码器、命名实体解码器和词性解码器分别对应的损失值。

[0076]

具体地,确定具有阅读理解训练数据对应的标志“0”的阅读理解编码向量a,所述阅读理解解码器对具有阅读理解训练数据对应的标志“0”的阅读理解编码向量a进行解码。

[0077]

确定具有命名实体训练数据对应的标志“1”的命名实体编码向量b,所述命名实体解码器对具有命名实体训练数据对应的标志“1”的命名实体编码向量b进行解码。

[0078]

确定具有词性训练数据对应的标志“2”的词性编码向量c,所述词性解码器对具有词性训练数据对应的标志“2”的词性编码向量c进行解码。

[0079]

上述阅读理解解码器、命名实体解码器和词性解码器分别对所述编码向量进行解码是并列进行的,没有先后顺序。

[0080]

具体地,通过下述并列的步骤2062至步骤2066来确定所述阅读理解解码器、命名实体解码器和词性解码器分别对应的损失值。

[0081]

所述阅读理解训练数据集包括阅读理解训练数据对应的标签向量、命名实体训练数据集对应的标签向量和词性训练数据集对应的标签向量。

[0082]

步骤2062:将所述阅读理解编码向量输入至阅读理解解码器,所述阅读理解解码器对阅读理解编码向量进行解码并输出阅读理解解码向量,基于所述阅读理解解码向量和所述阅读理解训练数据对应的标签向量,确定所述阅读理解解码器对应的损失值。

[0083]

由于所述阅读理解训练数据可以为一条或者两条以上,在所述阅读理解训练数据可以为两条以上的情况下。

[0084]

基于单条所述阅读理解训练数据对应的标签向量以及该阅读理解训练数据对应的解码向量,确定所述组合训练数据集中每条阅读理解训练数据对应的所述阅读理解解码器输出的损失值,均化每条阅读理解训练数据对应的损失值得到均值作为所述阅读理解解码器对应的损失值。

[0085]

步骤2064:将所述命名实体编码向量输入至命名实体解码器,所述命名实体解码器对命名实体编码向量进行解码并输出命名实体解码向量,基于所述命名实体解码向量和所述命名实体训练数据对应的标签向量,确定所述命名实体解码器对应的损失值。

[0086]

基于单条所述命名实体训练数据对应的标签向量以及该命名实体训练数据对应的解码向量,确定所述组合训练数据集中每条命名实体训练数据对应的所述命名实体解码器输出的损失值,均化每条命名实体训练数据对应的损失值得到均值作为所述命名实体解码器对应的损失值。

[0087]

步骤2066:将所述词性编码向量输入至词性解码器,所述词性解码器对词性编码向量进行解码并输出词性解码向量,基于所述词性解码向量和所述词性训练数据对应的标签向量,确定所述词性解码器对应的损失值。

[0088]

基于单条所述词性训练数据对应的标签向量以及该词性训练数据对应的解码向

量,确定所述组合训练数据集中每条词性训练数据对应的所述词性解码器输出的损失值,均化每条词性训练数据对应的损失值得到均值作为所述词性解码器对应的损失值。

[0089]

上述确定所述阅读理解解码器、命名实体解码器和词性解码器分别对应的损失值通过交叉熵损失函数计算得到。

[0090]

最后,基于所述阅读理解解码器、命名实体解码器和词性解码器分别对应的损失值以及每个损失值对应的权重系数,确定所述编码器对应的权重损失值。

[0091]

比如,所述阅读理解解码器、命名实体解码器和词性解码器分别得到的损失值对应的权重系数为0.7、0.2和0.1,则计算得到所述编码器对应的权重损失值。

[0092]

步骤208:根据所述阅读理解解码器、命名实体解码器和词性解码器分别对应的损失值,调整所述阅读理解解码器、命名实体解码器、词性解码器和所述编码器的参数,完成当前次训练并进行下次训练直至达到训练停止条件。

[0093]

基于所述阅读理解解码器对应的损失值调整阅读理解解码器的参数,基于所述命名实体解码器对应的损失值调整命名实体解码器的参数,基于所述词性解码器对应的损失值调整词性解码器的参数,基于所述权重损失值调整所述编码器的参数。

[0094]

其中,所述训练停止条件可以包括权重损失值的变化率小于预设稳定阈值。

[0095]

本实施例中通过在编码器还分别连接命名实体解码器和词性解码器,并提取所述阅读理解训练数据集、命名实体训练数据集和词性训练数据集进行组合以生成至少一个组合训练数据集,实现阅读理解训练任务、命名实体识别训练任务以及词性识别训练任务,换言之基于阅读理解模型进行阅读理解训练任务的基础上,再加上预测命名实体识别训练任务和词性标注的训练任务,使得阅读理解模型能够学习命名实体识别以及词性标注的知识,最终根据所述阅读理解解码器、命名实体解码器和词性解码器分别对应的损失值,调整所述阅读理解解码器、命名实体解码器、词性解码器和所述编码器的参数,也就是使用多任务学习的方法增强阅读理解模型的语法知识,提高阅读理解模型的泛化效果,进而提高阅读理解模型在做机器阅读理解时的准确率。

[0096]

图4是示出了根据本技术第二实施例的阅读理解模型的训练方法的示意性流程图,包括步骤402至步骤424。

[0097]

步骤402:获取所述阅读理解训练数据集、命名实体训练数据集和词性训练数据集,根据所述阅读理解训练数据集、命名实体训练数据集和词性训练数据集的数据量确定数据提取比例。

[0098]

所述阅读理解模型包括编码器和阅读理解解码器,所述编码器还分别与命名实体解码器和词性解码器连接。

[0099]

假设确定所述阅读理解训练数据集、命名实体训练数据集和词性训练数据集的数据量分别为900m、200m和100m,所述阅读理解训练数据集、命名实体训练数据集和词性训练数据集的数据量的比例为9:2:1。

[0100]

步骤404:按所述数据提取比例提取阅读理解训练数据集、命名实体训练数据集和词性训练数据集数据并进行组合,生成至少一个组合训练数据集。

[0101]

其中,每个组合训练数据集包括至少一个阅读理解训练数据、至少一个命名实体训练数据和至少一个词性训练数据。

[0102]

上例中,则按照9:2:1的比例来分别提取阅读理解训练数据集、命名实体训练数据

集和词性训练数据集,比如在所述阅读理解训练数据集中提取900kb的阅读理解训练数据,在所述命名实体训练数据集中提取200kb的命名实体训练数据,在所述词性数据训练集中提取100kb的词性训练数据,组合900kb的阅读理解训练数据、200kb的命名实体训练数据和100kb的词性训练数据得到第一条组合训练数据集,再进行下一个组合训练数据集的提取,最终可以生成一千条,当然可以根据实际情况,也可以生成一定量的组合训练数据集,这样能够完全利用阅读理解训练数据集、命名实体训练数据集和词性训练数据集,确保阅读理解模型能够更好地进行训练。

[0103]

步骤406:对所述组合训练数据集中的阅读理解训练数据、命名实体训练数据和词性训练数据分别设置对应标志。

[0104]

比如将阅读理解训练数据、命名实体训练数据和词性训练数据分别对应设置标志0、1和2,当然,所述标志还可以为其它形式,只要能够分别标注阅读理解训练数据、命名实体训练数据和词性训练数据。

[0105]

一条组合训练数据集中阅读理解训练数据a对应的标志为0,命名实体训练数据b对应的标志为1,词性训练数据c对应的标志为2。

[0106]

将所述组合训练数据集[a、b、c]输入至编码器中进行编码,获得所述编码器输出的所述组合训练数据集对应的编码向量[a、b、c],确保阅读理解解码器、命名实体解码器和词性解码器能够分别解码对应的编码向量,保证阅读理解解码器、命名实体解码器和词性解码器能够准确地分别输出对应的损失值。

[0107]

步骤408:将所述组合训练数据集输入至编码器中进行编码,获得所述编码器输出的编码向量。

[0108]

将所述组合训练数据集整个输入至编码器中先进行编码,以此获得所述编码器输出的组合训练数据集对应的编码向量[a、b、c],编码向量[a、b、c]中分别对应有标志0、1和2,以此确保下述步骤能够对编码向量中具有标志0、1和2分别对应进行解码。

[0109]

下述步骤410、步骤414和步骤418是并列进行的,没有先后顺序,也就是所述阅读理解解码器、命名实体解码器和词性解码器分别对所述编码向量进行解码。

[0110]

步骤410:确定具有阅读理解训练数据对应的标志的阅读理解编码向量,所述阅读理解解码器对具有阅读理解训练数据对应的标志的阅读理解编码向量进行解码。

[0111]

本步骤中先确定具有阅读理解训练数据对应的标志“0”的阅读理解编码向量[a],这样阅读理解解码器对具有阅读理解训练数据对应的标志“0”的阅读理解编码向量[a

e1

]进行解码获得[a

d1

]。

[0112]

步骤412:基于单条所述阅读理解训练数据对应的标签向量以及该阅读理解训练数据对应的解码向量,确定所述组合训练数据集中每条阅读理解训练数据对应的所述阅读理解解码器输出的损失值,均化每条阅读理解训练数据对应的损失值得到均值作为所述阅读理解解码器对应的损失值。

[0113]

由于所述阅读理解训练数据可以为一条或者两条以上,在所述阅读理解训练数据为两条以上的情况下。

[0114]

沿用上例,第一条阅读理解训练数据对应的标志“0”的阅读理解编码向量[a

e1

]进行解码获得[a

d1

],第一条所述阅读理解训练数据对应的标签向量t

a1

通过交叉熵函数计算得到第一条阅读理解训练数据对应的损失值为l

a1

。

[0115]

第二条阅读理解训练数据对应的标志“0”的阅读理解编码向量[a

e2

]进行解码获得[a

d2

],第二条所述阅读理解训练数据对应的标签向量t

a2

通过交叉熵函数计算得到第二条阅读理解训练数据对应的损失值为l

a2

,以此类推,分别计算每条阅读理解训练数据对应的损失值,均化每条阅读理解训练数据对应的损失值得到均值作为所述阅读理解解码器对应的损失值l

a

。

[0116]

步骤414:确定具有命名实体训练数据对应的标志的命名实体编码向量,所述命名实体解码器对具有命名实体训练数据对应的标志的命名实体编码向量进行解码。

[0117]

本步骤中先确定具有命名实体训练数据对应的标志“1”的命名实体编码向量[b],这样阅读理解解码器对具有命名实体训练数据对应的标志“1”的命名实体编码向量[b

e1

]进行解码获得[b

d1

]。

[0118]

步骤416:基于单条所述命名实体训练数据对应的标签向量以及该命名实体训练数据对应的解码向量,确定所述组合训练数据集中每条命名实体训练数据对应的所述命名实体解码器输出的损失值,均化每条命名实体训练数据对应的损失值得到均值作为所述命名实体解码器对应的损失值。

[0119]

沿用上例,第一条命名实体训练数据对应的标志“1”的命名实体编码向量[b

e1

]进行解码获得[b

d1

],第一条所述命名实体训练数据对应的标签向量t

b1

通过交叉熵函数计算得到第一条命名实体训练数据对应的损失值为l

b1

。

[0120]

第二条命名实体训练数据对应的标志“1”的命名实体编码向量[b

e2

]进行解码获得[b

d2

],第二条所述命名实体训练数据对应的标签向量t

b2

通过交叉熵函数计算得到第二条命名实体训练数据对应的损失值为l

b2

,以此类推,分别计算每条命名实体训练数据对应的损失值,均化每条命名实体训练数据对应的损失值得到均值作为所述命名实体解码器对应的损失值l

b

。

[0121]

步骤418:确定具有词性训练数据对应的标志的词性编码向量,所述词性解码器对具有词性训练数据对应的标志的词性编码向量进行解码。

[0122]

本步骤中先确定具有词性训练数据对应的标志“2”的命名实体编码向量[c],这样词性解码器对具有词性训练数据对应的标志“2”的词性编码向量[c

e1

]进行解码获得[c

d1

]。

[0123]

步骤420:基于单条所述词性训练数据对应的标签向量以及该词性训练数据对应的解码向量,确定所述组合训练数据集中每条词性训练数据对应的所述词性解码器输出的损失值,均化每条词性训练数据对应的损失值得到均值作为所述词性解码器对应的损失值。

[0124]

沿用上例,第一条词性训练数据对应的标志“2”的词性编码向量[c

e1

]进行解码获得[c

d1

],第一条所述词性训练数据对应的标签向量t

c1

通过交叉熵函数计算得到第一条词性训练数据对应的损失值为l

c1

。

[0125]

第二条词性训练数据对应的标志“2”的词性编码向量[c

e2

]进行解码获得[c

d2

],第二条所述词性训练数据对应的标签向量t

c2

通过交叉熵函数计算得到第二条词性训练数据对应的损失值为l

c2

,以此类推,分别计算每条词性训练数据对应的损失值,均化每条词性训练数据对应的损失值得到均值作为所述词性解码器对应的损失值l

c

。

[0126]

步骤422:基于所述阅读理解解码器、命名实体解码器和词性解码器分别对应的损失值以及每个损失值对应的权重系数,确定所述编码器对应的权重损失值。

[0127]

最后,基于所述阅读理解解码器、命名实体解码器和词性解码器分别对应的损失值l

a

、l

b

和l

c

以及每个损失值对应的权重系数为0.7、0.2和0.1,确定所述编码器对应的权重损失值为l=0.7l

a

0.2l

b

0.1l

c

。保证下述步骤中能够更好地调整所述编码器的参数。

[0128]

步骤424:基于所述阅读理解解码器对应的损失值调整阅读理解解码器的参数,基于所述命名实体解码器对应的损失值调整命名实体解码器的参数,基于所述词性解码器对应的损失值调整词性解码器的参数,基于所述权重损失值调整所述编码器的参数。

[0129]

基于损失值l

a

、l

b

和l

c

分别调整阅读理解解码器、命名实体解码器和词性解码器的参数,并基于所述权重损失值l调整所述编码器的参数,完成当前次的训练,并向所述编码器输入第二条组合训练数据进行下一次训练。

[0130]

本实施例中通过在编码器还分别连接命名实体解码器和词性解码器,并提取所述阅读理解训练数据集、命名实体训练数据集和词性训练数据集进行组合以生成至少一个组合训练数据集,实现阅读理解训练任务、命名实体识别训练任务以及词性识别训练任务,换言之基于阅读理解模型进行阅读理解训练任务的基础上,再加上预测命名实体识别训练任务和词性标注的训练任务,使得阅读理解模型能够学习命名实体识别以及词性标注的知识,最终根据所述阅读理解解码器、命名实体解码器和词性解码器分别对应的损失值,调整所述阅读理解解码器、命名实体解码器、词性解码器和所述编码器的参数,也就是使用多任务学习的方法增强阅读理解模型的语法知识,提高阅读理解模型的泛化效果,进而提高阅读理解模型在做机器阅读理解时的准确率。

[0131]

第三实施例提供一种文本分析的方法,参见图5,包括步骤502至步骤504。

[0132]

步骤502:接收原文本和问题。

[0133]

所述原文本是阅读理解文本,所述问题是根据原文本待解答的问题,也就是阅读理解模需要根据原文本和问题来对答案进行预测。

[0134]

步骤504:将所述原文本和问题输入至阅读理解模型中,获取所述阅读理解模型输出的答案,其中,所述阅读理解模型通过上述阅读理解模型的训练方法训练得到的。

[0135]

将所述原文本和问题输入至阅读理解模型的编码器中获取所述编码器输出的编码向量,将所述编码向量输入至阅读理解模型的阅读理解解码器中,获得所述阅读理解解码器输出的解码向量。

[0136]

根据所述阅读理解解码器输出的解码向量,生成所述原文本和问题对应的答案。

[0137]

本实施例中利用的阅读理解模型是通过上述阅读理解模型的训练方法训练得到的,上述阅读理解模型根据所述阅读理解解码器、命名实体解码器和词性解码器分别对应的损失值,调整所述阅读理解解码器、命名实体解码器、词性解码器和所述编码器的参数,也就是使用多任务学习的方法增强阅读理解模型的语法知识,提高阅读理解模型的泛化效果,将接收原文本和问题输入至训练好的阅读理解模型,能够提高阅读理解模型输出答案的准确率。

[0138]

第四实施例提供一种阅读理解模型的训练装置,参见图6,所述阅读理解模型包括编码器和阅读理解解码器,所述编码器还分别与命名实体解码器和词性解码器连接;

[0139]

所述训练装置包括:

[0140]

提取模块602,被配置为获取阅读理解训练数据集、命名实体训练数据集和词性训练数据集,生成至少一个组合训练数据集,其中,每个组合训练数据集包括阅读理解训练数

据、命名实体训练数据和词性训练数据;

[0141]

编码模块604,被配置为将所述组合训练数据集输入至编码器中进行编码,获得所述编码器输出的编码向量;

[0142]

确定模块606,被配置为将所述编码向量分别输入至阅读理解解码器、命名实体解码器和词性解码器进行解码,确定所述阅读理解解码器、命名实体解码器和词性解码器分别对应的损失值;

[0143]

调整模块608,被配置为根据所述阅读理解解码器、命名实体解码器和词性解码器分别对应的损失值,调整所述阅读理解解码器、命名实体解码器、词性解码器和所述编码器的参数,完成当前次训练并进行下次训练直至达到训练停止条件。

[0144]

提取模块602,被进一步配置为获取阅读理解训练数据集、命名实体训练数据集和词性训练数据集;根据所述阅读理解训练数据集、命名实体训练数据集和词性训练数据集的数据量确定数据提取比例;按所述数据提取比例提取阅读理解训练数据集、命名实体训练数据集和词性训练数据集数据并进行组合,生成至少一个组合训练数据集。

[0145]

所述编码向量包括阅读理解编码向量、命名实体编码向量和词性编码向量;

[0146]

编码模块604,被进一步配置为将所述组合训练数据集输入至编码器中进行编码,获得所述编码器输出的所述组合训练数据集对应的阅读理解编码向量、命名实体编码向量和词性编码向量。

[0147]

所述阅读理解训练数据集包括阅读理解训练数据对应的标签向量、命名实体训练数据集对应的标签向量和词性训练数据集对应的标签向量;

[0148]

确定模块606,被进一步配置为将所述阅读理解编码向量输入至阅读理解解码器,所述阅读理解解码器对阅读理解编码向量进行解码并输出阅读理解解码向量,基于所述阅读理解解码向量和所述阅读理解训练数据对应的标签向量,确定所述阅读理解解码器对应的损失值;

[0149]

将所述命名实体编码向量输入至命名实体解码器,所述命名实体解码器对命名实体编码向量进行解码并输出命名实体解码向量,基于所述命名实体解码向量和所述命名实体训练数据对应的标签向量,确定所述命名实体解码器对应的损失值;

[0150]

将所述词性编码向量输入至词性解码器,所述词性解码器对词性编码向量进行解码并输出词性解码向量,基于所述词性解码向量和所述词性训练数据对应的标签向量,确定所述词性解码器对应的损失值。

[0151]

所述训练装置还包括:

[0152]

设置模块,被配置为对所述组合训练数据集中的阅读理解训练数据、命名实体训练数据和词性训练数据分别设置对应标志;

[0153]

确定模块606,被进一步配置为确定具有阅读理解训练数据对应的标志的阅读理解编码向量,所述阅读理解解码器对具有阅读理解训练数据对应的标志的阅读理解编码向量进行解码;

[0154]

确定具有命名实体训练数据对应的标志的命名实体编码向量,所述命名实体解码器对具有命名实体训练数据对应的标志的命名实体编码向量进行解码;

[0155]

确定具有词性训练数据对应的标志的词性编码向量,所述词性解码器对具有词性训练数据对应的标志的词性编码向量进行解码。

[0156]

确定模块606,被进一步配置为基于单条所述阅读理解训练数据对应的标签向量以及该阅读理解训练数据对应的解码向量,确定所述组合训练数据集中每条阅读理解训练数据对应的所述阅读理解解码器输出的损失值,均化每条阅读理解训练数据对应的损失值得到均值作为所述阅读理解解码器对应的损失值;

[0157]

基于单条所述命名实体训练数据对应的标签向量以及该命名实体训练数据对应的解码向量,确定所述组合训练数据集中每条命名实体训练数据对应的所述命名实体解码器输出的损失值,均化每条命名实体训练数据对应的损失值得到均值作为所述命名实体解码器对应的损失值;

[0158]

基于单条所述词性训练数据对应的标签向量以及该词性训练数据对应的解码向量,确定所述组合训练数据集中每条词性训练数据对应的所述词性解码器输出的损失值,均化每条词性训练数据对应的损失值得到均值作为所述词性解码器对应的损失值。

[0159]

调整模块608,被进一步配置为基于所述阅读理解解码器、命名实体解码器和词性解码器分别对应的损失值以及每个损失值对应的权重系数,确定所述编码器对应的权重损失值;

[0160]

基于所述阅读理解解码器对应的损失值调整阅读理解解码器的参数,基于所述命名实体解码器对应的损失值调整命名实体解码器的参数,基于所述词性解码器对应的损失值调整词性解码器的参数,基于所述权重损失值调整所述编码器的参数。

[0161]

所述训练停止条件包括:所述权重损失值的变化率小于预设稳定阈值。

[0162]

本实施例中通过在编码器还分别连接命名实体解码器和词性解码器,并提取所述阅读理解训练数据集、命名实体训练数据集和词性训练数据集进行组合以生成至少一个组合训练数据集,实现阅读理解训练任务、命名实体识别训练任务以及词性识别训练任务,换言之基于阅读理解模型进行阅读理解训练任务的基础上,再加上预测命名实体识别训练任务和词性标注的训练任务,使得阅读理解模型能够学习命名实体识别以及词性标注的知识,最终根据所述阅读理解解码器、命名实体解码器和词性解码器分别对应的损失值,调整所述阅读理解解码器、命名实体解码器、词性解码器和所述编码器的参数,也就是使用多任务学习的方法增强阅读理解模型的语法知识,提高阅读理解模型的泛化效果,进而提高阅读理解模型在做机器阅读理解时的准确率。

[0163]

第五实施例提供一种文本分析的装置,参见图7所示,包括:

[0164]

接收模块702,被配置为接收原文本和问题;

[0165]

获取模块704,被配置为将所述原文本和问题输入至阅读理解模型中,获取所述阅读理解模型输出的答案,其中,所述阅读理解模型通过上述阅读理解模型的训练方法训练得到的。

[0166]

所述获取模块704被进一步配置为将所述原文本和问题输入至阅读理解模型的编码器中获取所述编码器输出的编码向量,将所述编码向量输入至阅读理解模型的阅读理解解码器中,获得所述阅读理解解码器输出的解码向量;根据所述阅读理解解码器输出的解码向量,生成所述原文本和问题对应的答案。

[0167]

本实施例中利用的阅读理解模型是通过上述阅读理解模型的训练方法训练得到的,上述阅读理解模型根据所述阅读理解解码器、命名实体解码器和词性解码器分别对应的损失值,调整所述阅读理解解码器、命名实体解码器、词性解码器和所述编码器的参数,

也就是使用多任务学习的方法增强阅读理解模型的语法知识,提高阅读理解模型的泛化效果,将接收原文本和问题输入至训练好的阅读理解模型,能够提高阅读理解模型输出答案的准确率。

[0168]

本技术一实施例还提供一种计算设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机指令,所述处理器执行所述指令时实现如前所述阅读理解模型的训练方法或文本分析的方法的步骤。

[0169]

本技术一实施例还提供一种计算机可读存储介质,其存储有计算机指令,该指令被处理器执行时实现如前所述阅读理解模型的训练方法或文本分析的方法的步骤。

[0170]

上述为本实施例的一种计算机可读存储介质的示意性方案。需要说明的是,该存储介质的技术方案与上述阅读理解模型的训练方法或文本分析的方法的技术方案属于同一构思,存储介质的技术方案未详细描述的细节内容,均可以参见上述阅读理解模型的训练方法或文本分析的方法的技术方案的描述。

[0171]

所述计算机指令包括计算机程序代码,所述计算机程序代码可以为源代码形式、对象代码形式、可执行文件或某些中间形式等。所述计算机可读介质可以包括:能够携带所述计算机程序代码的任何实体或装置、记录介质、u盘、移动硬盘、磁碟、光盘、计算机存储器、只读存储器(rom,read-only memory)、随机存取存储器(ram,random access memory)、电载波信号、电信信号以及软件分发介质等。需要说明的是,所述计算机可读介质包含的内容可以根据司法管辖区内立法和专利实践的要求进行适当的增减,例如在某些司法管辖区,根据立法和专利实践,计算机可读介质不包括电载波信号和电信信号。

[0172]

需要说明的是,对于前述的各方法实施例,为了简便描述,故将其都表述为一系列的动作组合,但是本领域技术人员应该知悉,本技术并不受所描述的动作顺序的限制,因为依据本技术,某些步骤可以采用其它顺序或者同时进行。其次,本领域技术人员也应该知悉,说明书中所描述的实施例均属于优选实施例,所涉及的动作和模块并不一定都是本技术所必须的。

[0173]

在上述实施例中,对各个实施例的描述都各有侧重,某个实施例中没有详述的部分,可以参见其它实施例的相关描述。

[0174]

以上公开的本技术优选实施例只是用于帮助阐述本技术。可选实施例并没有详尽叙述所有的细节,也不限制该发明仅为所述的具体实施方式。显然,根据本说明书的内容,可作很多的修改和变化。本说明书选取并具体描述这些实施例,是为了更好地解释本技术的原理和实际应用,从而使所属技术领域技术人员能很好地理解和利用本技术。本技术仅受权利要求书及其全部范围和等效物的限制。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。