基于深度学习的彩色全息显微镜的系统和方法

1.相关申请

2.本技术要求2019年4月22日提交的美国临时专利申请号62/837,066的优先权,该申请的全部内容通过引用结合于此。根据美国法典第35编第119节和任何其他适用法规要求优先权。

3.关于联邦赞助的研究与开发的声明

4.本发明是在政府支持下由国家科学基金会授予的授予号eec 1648451的资助下完成的。政府对这项发明有一定的权利。

技术领域

5.技术领域通常涉及用于使用经训练的深度神经网络,使用单个超分辨的全息图来执行高保真彩色图像重建的方法和系统。具体而言,该系统和方法使用从样本获得的单个超分辨的全息图作为经训练的深度神经网络的输入,同时以多个不同的波长照明该样本,该深度神经网络输出样本的高保真彩色图像。

背景技术:

6.安装在载玻片上的固定薄组织切片的组织学染色是诊断各种医学状况所需的一个基本步骤。组织学染色用于通过增强细胞和亚细胞成分的比色对比度来突出组织组成部分,以进行显微镜检查。因此,染色病理切片的准确颜色表示是做出可靠和一致诊断的重要前提。与明场显微镜不同,另一种用于使用相干成像系统从样本中获取颜色信息的方法需要在可见光谱的红色、绿色和蓝色部分采集至少三个全息图,从而形成用于重建合成彩色图像的红

‑

绿

‑

蓝(rgb)颜色通道。然而,在相干成像系统中使用的这种彩色化方法存在颜色不准确的问题,并且对于组织病理学和诊断应用来说可能被认为是不可接受的。

7.为了使用相干成像系统提高颜色精度,可以使用计算超光谱成像方法。然而,这种系统通常需要工程照明,例如,可调谐激光器,以有效地对可见光波段进行采样。先前的贡献已经证明,为了生成准确的彩色图像,成功地减少了可见光波段所需采样位置的数量。例如,peercy等人演示了一种波长选择方法,该方法使用高斯求积或黎曼求和来重建在反射模式全息术中成像的样本的彩色图像,由此提出至少需要四个波长来生成自然物体的精确彩色图像。参见peercy等人的“真彩色全息术的波长选择”,应用光学33,6811

‑

6817(1994)。

8.后来,演示了一种基于维纳估计的方法来量化物体在四个固定波长下的光谱反射率分布,从而提高了自然物体的颜色精度。参见p.xia等人的“使用光谱估计技术的数字全息术”,display technol.,jdt10,235

‑

242(2014)。最近,zhang等人提出了一种基于最小均方误差估计的吸收光谱估计方法,专门用于利用同轴全息术创建病理切片的精确彩色图像。参见zhang等人的“利用组织化学染色的全息术和吸收光谱估计对病理切片进行精确的彩色成像”,journal of biophotonics e201800335(2018)。因为染色组织病理学载玻片内的颜色分布受到所用比色染料组合的限制,所以该方法成功地将所需的波长数减少到三个,同时仍然保持准确的颜色表示。然而,由于双像伪影引入的失真和单位放大率片上全息

系统的有限分辨率,实现了多高度相位恢复和像素超分辨率(psr)技术,以获得可接受的图像质量。在zhang等人的方法中,在四个不同的样本至传感器(z)距离处收集四个(或更多)超分辨全息图。这需要一个可移动台,该可移动台不仅允许用于获取psr图像的横向(x,y)运动,还需要在垂直或z方向上移动,以获取多高度图像。

技术实现要素:

9.在一个实施例中,公开了一种基于深度学习的精确彩色全息显微系统和方法,其使用在波长复用照明(即,同时照明)下获取的单个超分辨的全息图像。与相干成像系统中使用的传统超光谱成像方法相比,基于深度神经网络的彩色显微系统和方法显著简化了数据采集程序、相关的数据处理和存储步骤以及成像硬件。首先,这种技术只需要在同时照明下获得一个超分辨的全息图。正因为如此,该系统和方法实现了与zhang等人的最先进的吸收光谱估计方法相似的性能,该方法使用了在四个样本到传感器的距离上用顺序或多路复用的照明波长收集的四个超分辨的全息图,因此在数据吞吐量方面表现出超过四倍的增强。此外,不需要在z方向上移动的更复杂的可移动台,这增加了成本、设计的复杂性,并且花费额外的时间来获得彩色图像。

10.使用两种类型的病理学载玻片证明了该方法和系统的成功:用masson三色染色的肺组织切片和用苏木精和伊红(h&e)染色的前列腺组织切片,尽管应该理解,也可以使用其他染色和染料。使用结构相似性指数(ssim)和颜色距离,重建高保真度和颜色精确的图像,并与使用超光谱成像方法获得的黄金标准图像进行比较。还将所提出的框架的整体时间性能与传统的20

×

明场扫描显微镜进行了比较,从而证明了图像采集和处理的总时间是相同的。这种基于深度学习的彩色成像框架将有助于将相干显微技术用于组织病理学应用。

11.在一个实施例中,一种执行样本的单个超分辨的全息图像的彩色图像重建的方法包括通过在多个颜色通道同时照明,使用图像传感器获得样本的多个子像素移位的较低分辨率全息图像。然后,基于多个子像素移位的较低分辨率全息图像,数字生成多个颜色通道中的每一个的超分辨率的全息强度图像。利用图像处理软件将多个颜色通道中的每一个的超分辨的全息强度图像反向传播到物平面,以生成多个颜色通道中的每一个的样本的振幅输入图像和相位输入图像。提供经训练的深度神经网络,该深度神经网络由图像处理软件使用计算装置的一个或多个处理器来执行,并被配置为接收多个颜色通道中的每一个的样本的振幅输入图像和相位输入图像,并输出样本的彩色输出图像。

12.在另一实施例中,一种用于执行样本的超分辨全息图像的彩色图像重建的系统包括:计算装置,在计算装置上执行图像处理软件,该图像处理软件包括使用计算装置的一个或多个处理器执行的经训练的深度神经网络。利用来自样本图像的超分辨全息图的多个训练图像或图像块以及相应的基本事实或目标彩色图像或图像块来训练该经训练的深度神经网络。图像处理软件(即,经训练的深度神经网络)被配置为从通过以多个照明波长同时照明样本而获得的样本的多个低分辨率图像,接收由图像处理软件生成的样本的一个或多个超分辨的全息图像,并且输出样本的重建彩色图像。

13.在另一实施例中,一种用于对样本的一个或多个超分辨的全息图像执行彩色图像重建的系统包括:无透镜显微镜装置,包括用于保持样本的样本保持器、彩色图像传感器、以及耦合到相应不同颜色光源的一根或多根光纤或电缆,不同颜色光源被配置为同时发射

多个波长的光。显微镜装置包括可移动台和光源阵列中的至少一个,可移动台或光源阵列被配置为获得样本的子像素移位的较低分辨率全息强度图像。该系统还包括计算装置,在计算装置上执行图像处理软件,该图像处理软件包括使用计算装置的一个或多个处理器执行的经训练的深度神经网络,其中,利用来自样本图像的超分辨的全息图的多个训练图像或图像块以及从超光谱成像或明场显微术生成的相应的基本事实或目标彩色图像或图像块来训练该经训练的深度神经网络,经训练的深度神经网络被配置为从通过同时照明样本而获得的样本的子像素移位的较低分辨率全息强度图像,接收由图像处理软件生成的样本的一个或多个超分辨的全息图像,并且输出样本的重建彩色图像。

附图说明

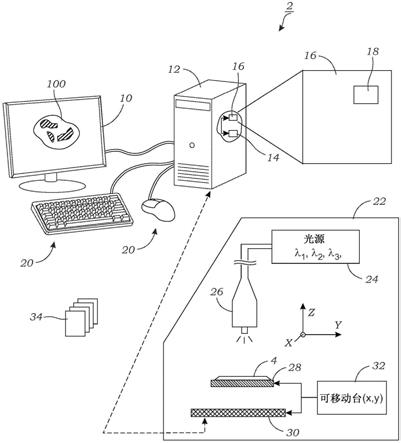

14.图1a示意性地示出了根据一个实施例的用于对样本的单个超分辨的全息图像执行彩色图像重建的系统;

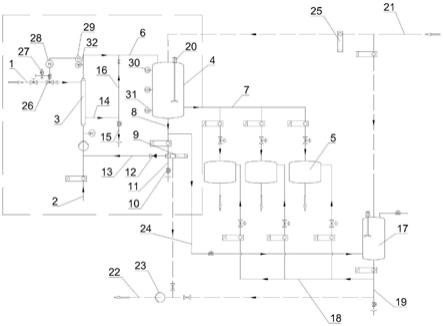

15.图1b示出了使用照明阵列来照明样本的替代实施例,照明阵列是可移动台的替代物;

16.图1c示出了根据一个实施例的用于对样本的单个超分辨的全息图像执行彩色图像重建的过程或方法;

17.图2示意性地示出了图像(数据)采集的过程,该过程用于生成输入到经训练的深度神经网络中的输入振幅和相位图像(使用例如红色、绿色、蓝色通道),该深度神经网络然后输出样本的重建彩色图像(示出了病理组织样本的彩色振幅图像);

18.图3a至图3c示出了传统超光谱成像(图3b)和基于神经网络的方法(图3c)之间的比较,用于重建样本的精确彩色图像,n

h

是执行相位恢复所需的样本到传感器高度的数量,n

w

是照明波长的数量,n

m

是每个照明条件(多路复用或顺序)的测量数量,l是用于执行像素超分辨率的横向位置的数量;图3a示出了传统超光谱成像和基于神经网络的方法所需的原始全息图数量;图3b示意性地示出了超光谱成像方法的高保真彩色图像重建过程;图3c示意性地示出了本文描述的基于神经网络的方法的高保真彩色图像重建过程,该方法仅使用样本的单个超分辨的全息图像;

19.图4是经训练的深度神经网络的生成器部分的示意图,六通道输入由处于三个照明波长(根据一个具体实施方式,450nm、540nm和590nm)的三个自由空间传播全息图的真实通道和虚拟通道组成,导致六通道输入,每个下行块由两个卷积层组成,当一起使用时,卷积层使系统信道的数量加倍,下行块是相反的,由两个卷积层组成,当一起使用时,具有系统信道的数量的一半;

20.图5示意性地示出了经训练的深度神经网络的鉴别器部分,卷积层的每个下行块由两个卷积层组成;

21.图6a和图6b示出了使用无透镜全息片上显微镜,对于450nm、540nm和590nm的多路复用照明,用masson三色染色的肺组织载玻片的基于深度学习的精确彩色成像;图6a是网络输出图像的大视场(具有两个roi);图6b是roi 1和2处的网络输入(振幅和相位图像)、网络输出和基本事实目标的放大比较;

22.图7a和图7b示出了使用无透镜全息片上显微镜,在450nm、540nm和590nm的多路复用照明下,用h&e染色的前列腺组织载玻片的基于深度学习的精确彩色成像;图7a是网络输

出图像的大视场(具有两个roi);图7b是在roi 1和2处的网络输入(振幅和相位图像)、网络输出和基本事实目标的放大比较;

23.图8示出了用h&e染色的肺组织切片的深度神经网络输出的数字缝合图像,其对应于图像传感器的视野,在缝合图像的外围是较大图像的各种roi,显示了来自经训练的深度神经网络的输出以及相同roi的基本事实目标图像;

24.图9a至图9j示出了对于用masson三色染色的肺组织样本,来自基于深度神经网络的方法的网络输出图像和利用像zhang等人的光谱估计方法的多高度相位恢复之间的视觉比较;图9a至图9h示出了使用不同数量的高度和不同照明条件的光谱估计方法的重建结果;图9i示出了经训练的深度神经网络的输出图像(即,网络输出);图9j示出了使用超光谱成像方法获得的基本事实目标图像;

25.图10a至图10j示出了对于用h&e染色的前列腺组织样本,基于深度神经网络的方法和利用zhang等人的光谱估计方法的多高度相位恢复之间的视觉比较;图10a至图10h示出了使用不同数量的高度和不同照明条件的光谱估计方法的重建结果;图10i示出了经训练的深度神经网络的输出图像(即,网络输出);图10j示出了使用超光谱成像方法获得的基本事实目标。

具体实施方式

26.图1a示意性地示出了用于生成样本4的重建彩色输出图像100的系统2。在一个实施例中,彩色输出图像100可以包括振幅(真实)彩色输出图像。振幅彩色图像通常用于例如组织病理学成像应用。输出彩色图像100在图1a中被示为以计算机监视器的形式显示在显示器10上,但是应当理解,彩色输出图像100可以在任何合适的显示器10上显示(例如,计算机监视器、平板计算机或pc、移动计算装置(例如,智能手机等))。系统2包括计算装置12和图像处理软件16,计算装置包含一个或多个处理器14,图像处理软件包含经训练的深度神经网络18(在一个实施例中,深度神经网络是生成对抗网络(gan)训练的深度神经网络)。在gan训练的深度神经网络18中,两个模型用于训练。使用生成模型(例如,图4),其捕捉数据分布并学习颜色校正和缺失相位相关伪像的消除,而第二鉴别器模型(图5)估计样本来自训练数据而不是来自生成模型的概率。

27.如本文所解释的,计算装置12可以包括个人计算机、远程服务器、平板电脑、移动计算装置等,尽管也可以使用其他计算装置(例如,包含一个或多个图形处理单元(gpu)或专用集成电路(asic)的装置)。图像处理软件16可以以任何数量的软件包和平台(例如,python、tensorflow、matlab、c 等)来实现。基于gan的深度神经网络18的网络训练可以在相同或不同的计算装置12上执行。例如,在一个实施例中,个人计算机(pc)12可以用于训练深度神经网络18,尽管这种训练可能花费相当多的时间。为了加速该训练过程,使用一个或多个专用gpu的计算装置12可以用于训练。一旦训练了深度神经网络18,就可以使用相同或不同的计算装置12来执行深度神经网络18。例如,可以在位于远处的计算装置12上进行训练,经训练的深度神经网络18(或其参数)被传送到另一计算装置12,以供执行。可以通过广域网(wan)进行传输,例如,互联网或局域网(lan)。

28.计算装置12可以可选地包括一个或多个输入装置20,例如,如图1a所示的键盘和鼠标。例如,输入装置20可以用于与图像处理软件16交互。例如,可以向用户提供图形用户

界面(gui),他或她可以与彩色输出图像100交互。gui可以向用户提供一系列工具或工具栏,这些工具或工具栏可以用于操纵样本4的彩色输出图像100的各个方面。这包括调整颜色、对比度、饱和度、放大率、图像剪切和复制等的能力。gui可以允许快速选择和查看样本4的彩色图像100。gui可以识别样本类型、染色剂或染料类型、样本id等。

29.在一个实施例中,该系统还包括显微镜装置22,该显微镜装置22用于采集样本4的图像,该图像被深度神经网络18用于重建彩色输出图像100。显微镜装置22包括多个光源24,这些光源用于用相干光或部分相干光照明样本4。多个光源24可以包括led、激光二极管等。如本文所解释的,在一个实施例中,至少一个光源24发射红色光,同时至少一个光源24发射绿色光,并且同时至少一个光源24发射蓝色光。如本文所解释的,光源24被同时供电,以使用适当的驱动电路或控制器来照明样本4。光源24可以连接到光纤电缆、光纤、波导26等,如图1a所示,用于将光发射到样本4上。样本4被支撑在样本保持器28上,样本保持器28可以包括光学透明的衬底等(例如,玻璃、聚合物、塑料)。样本4通常由光纤电缆、光纤、波导26照明,波导通常位于离样本4几厘米的地方。

30.可以使用显微镜装置22成像的样本4可以包括任何数量类型的样本4。样本4可以包括已经被化学染色或标记的哺乳动物或植物组织的一部分(例如,化学染色的细胞学载玻片)。样本可以是固定的,也可以是非固定的。示例性染色剂包括例如苏木精和伊红(h&e)染色剂、苏木精、伊红、琼斯银染色剂、masson三色染色剂、高碘酸希夫氏(pas)染色剂、刚果红染色剂、阿尔新蓝染色剂、蓝铁、硝酸银、三色染色剂、ziehlneelsen、高二氏乌洛托品银(gms)染色剂、革兰氏染色剂、酸性染色剂、碱性染色剂、银染色剂、nissl、weigert染色剂、高尔基染色剂、luxol快速蓝染色剂、甲苯胺蓝、genta、mallory三色染色剂、gomori三色、范基林、giemsa、苏丹黑、普鲁氏兰染色、贝斯特洋红染色、吖啶橙、免疫荧光染色、免疫组织化学染色、kinyoun

‑

冷染色、albert染色、鞭毛染色、内皮孔染色、nigrosin、或印度墨。样本4也可以包括非组织样本。这些包括无机或有机的小物体。这可以包括颗粒、灰尘、花粉、霉菌、孢子、纤维、毛发、螨虫、过敏原等。小生物也可以用彩色成像。这包括细菌、酵母、原生动物、浮游生物和多细胞生物。此外,在一些实施例中,样本4不需要被染色或标记,因为样本4的天然或天然颜色可以用于彩色成像。

31.仍然参考图1a,显微镜装置22获得多个低分辨率、子像素移位的图像,同时以不同波长照明(在本文描述的实验中使用三个)。如图1a和图2所示,三个不同的波长(λ1、λ2、λ3)同时照明样本4(例如,其上放置有病理样本的病理载玻片),并且用彩色图像传感器30捕捉图像。图像传感器30可以包括基于cmos的彩色图像传感器30。彩色图像传感器30位于样本4的与光缆、光纤、波导26相对的一侧。图像传感器30通常位于样本保持器28附近或非常靠近样本保持器28,并且距离小于样本4和光纤电缆、光纤、波导26之间的距离(例如,小于一厘米,并且可以是几毫米或更小)。

32.提供平移台32,平移台32在样本保持器28和图像传感器30之间的x和y平面(图1a和图2)中赋予相对运动,以获得子像素移位的图像。平移台32可以在x和y方向上移动图像传感器30或样本保持器28。当然,图像传感器30和样本28都可以移动,但是这可能需要更复杂的平移台32。在单独的替代方案中,光纤电缆、光纤、波导26可以在x、y平面中移动,以产生子像素偏移。平移台32以小的慢跑(例如,通常小于1μm)移动,以获得在不同的x、y位置获得的图像34的阵列,在每个位置获得单个低分辨率全息图。例如,6

×

6的位置网格可用于获

取总共三十六(36)个低分辨率图像34。虽然可以获得任意数量的低分辨率图像34,但是这通常可以小于40。

33.这些低分辨率图像34然后用于使用去马赛克像素超分辨率为三个颜色通道中的每一个数字地创建超分辨的全息图。使用移位加过程或算法来合成高分辨率图像。用于合成像素超分辨率全息图的移位加过程在例如greenbaum,a等人的“使用无透镜芯片显微术对病理切片进行宽域计算成像”中有所描述,science translational medicine 6,267ra175

‑

267ra175(2014),该文献通过引用结合于此。在该过程中,无需来自平移台32的任何反馈或测量或者使用基于迭代梯度的技术的设置,就可以对用于高分辨率全息图的精确合成的偏移进行精确估计。

34.该超分辨的全息图的三个强度彩色全息图通道(红、蓝、绿)然后被数字反向传播到物平面,以生成用于经训练的深度神经网络18的六个输入(图2)。这包括三(3)个振幅图像通道(50

r

、50

b

、50

g

)和三(3)个相位图像通道(52

r

、52

b

、52

g

),它们被输入到经训练的深度神经网络18,以生成重建的彩色输出图像40。像素超分辨率算法可以使用与用于执行经训练的深度神经网络18相同的图像处理软件16或不同的图像处理软件来执行。彩色输出图像100是高保真图像,该图像与使用作为多个样本到传感器距离(z)收集的多个超分辨的全息图获得的图像相比较(即,超光谱成像方法)。与超光谱成像的“黄金标准”方法相比,系统2和方法的数据密集度较低,并提高了整体时间性能或吞吐量。

35.图1b示出了使用光源阵列40的系统2的替代实施例。在该替代实施例中,具有不同颜色的光源阵列40排列在样本4和样本保持器28的x、y平面上。在该替代实施例中,不需要平移台32,因为子像素“移动”是通过用来自位于样本4上方的不同空间位置的阵列40的不同光源组照明样本4来实现的。这产生了必须移动图像传感器30或样本保持器28的相同效果。阵列40中不同组的红色、蓝色和绿色光源被选择性地照明,以生成用于合成像素超分辨的全息图的子像素位移。阵列40可以由一端耦合到光源(例如,led)的一束光纤形成,并且相对端包含在头部或歧管中,该头部或歧管以期望的阵列图案固定光纤的相对端。

36.图1c示出了用于执行样本4的单个超分辨的全息图像的彩色图像重建的过程或方法。参考操作200,显微镜装置22通过在多个颜色通道(例如,红色、蓝色、绿色)同时照明样本4,使用彩色图像传感器30获得样本4的多个子像素移位的较低分辨率全息强度图像。接下来,在操作210中,基于多个子像素移位的较低分辨率全息强度图像,数字生成多个颜色通道中的每一个的超分辨的全息强度图像(三个这样的超分辨的全息图,包括一个用于红色通道,一个用于绿色通道,一个用于蓝色通道)。接下来,在操作220中,用图像处理软件16将多个颜色通道中的每一个的超分辨的全息强度图像反向传播到样本4内的物平面,以生成多个颜色通道中的每一个的样本的振幅输入图像和相位输入图像,这导致总共六(6)个图像。由图像处理软件16使用计算装置12的一个或多个处理器14执行的经训练的深度神经网络18接收(操作230)多个颜色通道(例如,六个输入图像)中的每一个的样本4的振幅输入图像和相位输入图像,并输出(操作240)样本4的彩色输出图像100。彩色输出图像40是高保真图像,与使用作为多个样本至传感器距离收集的多个超分辨的全息图(即,超光谱成像方法)获得的图像相比较。该彩色输出图像100可以包括样本4的彩色振幅图像100。

37.与超光谱成像的“黄金标准”方法相比,系统2和方法的数据密集度较低,并提高了整体时间性能或吞吐量。系统2不需要获得在四个不同高度或样本到图像传感器距离收集

的多个(即四个)超分辨的全息图。这意味着可以更快地获得彩色输出图像100(以及更高的吞吐量)。单个超分辨的全息图的使用也意味着成像过程的数据密集程度降低;需要更少的存储和数据处理资源。

38.实验性

39.材料和方法

40.基于超光谱和深度神经网络的重建方法的概述

41.深度神经网络18被训练,以执行从单个超分辨的全息图获得的复数域到黄金标准图像(用超光谱成像方法获得)的图像变换,从n

h

×

n

m

超分辨的全息图获得黄金标准图像(n

h

是样本到传感器的距离的数量,n

m

是在一个特定照明条件下的测量数量)。为了使用超光谱成像方法生成黄金标准图像,使用了n

h

=8和n

m

=31的顺序照明波长(范围从400nm到700nm,步长为10nm)。下面详细介绍了用于生成黄金标准图像以及深度网络输入的过程。

42.超光谱成像方法

43.黄金标准超光谱成像方法通过首先使用psr算法执行分辨率增强来重建高保真彩色图像(下面在使用顺序照明在全息像素超分辨率中详细讨论)。随后,使用多高度相位恢复来消除缺失的相位相关伪像(下面在多高度相位恢复中更详细地讨论)。最后,使用三刺激色投影生成高保真彩色图像(下面在彩色三刺激投影中更详细地讨论)。

44.使用顺序照明的全息像素超分辨率

45.使用psr算法进行超光谱成像方法的分辨率增强,如greenbaum,a.等人在“使用无透镜芯片显微术对病理切片进行宽域计算成像”,science translational medicine 6,267ra175

‑

267ra175(2014)中所述,该文献在此通过引用结合于此。该算法能够从由rgb图像传感器30(imx081,索尼,像素大小为1.12μm,具有r、g1、g2和b颜色通道)收集的一组低分辨率图像34中数字合成高分辨率图像(像素大小约为0.37μm)。为了获取这些图像34,图像传感器30被编程为使用3d定位平台32(max606,thorlabs公司)通过6

×

6横向栅格光栅化,子像素间距约为0.37μm(即,像素尺寸的1/3)。在每个横向位置,记录一个低分辨率全息强度。图像传感器30的位移/偏移使用greenbaum等人的“使用基于多高度像素超分辨率的无透镜成像的致密样本的现场便携式宽视场显微术”,lab chip12,1242

‑

1245(2012)中介绍的算法精确估计,该文献通过引用结合于此。然后使用基于移位加的算法来合成高分辨率图像,如上文greenbaum等人(2014)所述。

46.因为这种超光谱成像方法使用顺序照明,所以psr算法在任何给定的照明波长下仅使用来自rgb图像传感器的一个颜色通道(r、g1或b)。根据拜耳rgb图像传感器的透射光谱响应曲线,蓝色通道(b)用于400

‑

470nm范围内的照明波长,绿色通道(g1)用于480

‑

580nm范围内的照明波长,红色通道(r)用于590

‑

700nm范围内的照明波长。

47.角谱传播

48.在超光谱成像方法中使用自由空间角谱传播来创建基本事实图像。为了在传播距离z处以数字方式获得光场u(x,y;z),傅立叶变换(ft)首先应用于给定的u(x,y;0),以获得角谱分布a(f

x

,f

y

;0)。光场u(x,y;z)的角谱a(f

x

,f

y

;z)可以使用以下公式计算:

49.a(f

x

,f

y

;z)=a(f

x

,f

y

;0)

·

h(f

x

,f

y

;z)

ꢀꢀꢀ

(1)

50.其中,h(f

x

,f

y

;z)被定义为,

[0051][0052]

其中,λ是照明波长,n是介质的折射率。最后,对a(f

x

,f

y

;z)傅里叶逆变换,得到u(x,y;z)。

[0053]

这种角谱传播方法首先用作自动聚焦算法的构建模块,该算法用于为每个获取的全息图估计样本到传感器的距离,如zhang等人的“鲁棒全息自动聚焦的边缘稀疏性标准”,opticsletters42,3824(2017)和tamamitsu等人的“基于复杂光学波前的边缘稀疏性的全息自动聚焦的gini指数和tamura系数的比较”,arxiv:1708.08055[physics.optics](2017)所述,这两个文献通过引用结合于此。在估计了精确的样本到传感器的距离之后,超光谱成像方法使用角谱传播作为迭代多高度相位恢复的额外构件。

[0054]

多高度相位恢复

[0055]

为了消除与缺失相位相关的空间图像伪影,超光谱成像方法应用了迭代相位检索算法。使用迭代相位恢复方法来恢复这种缺失的相位信息,其细节见greenbaum等人的“使用基于像素超分辨率的多高度无透镜片上显微术对致密样本进行无掩模成像”,opt.express,oe20,3129

‑

3143(2012),该文献通过引用结合于此。

[0056]

在数据采集步骤中收集了8个样本至传感器距离的全息图。该算法最初将零相位分配给物体的强度测量。算法的每次迭代都是从将复数域从第一个高度传播到第八高度开始,然后将其反向传播到第一高度。在每个高度更新振幅,而相位保持不变。该算法通常在10

‑

30次迭代后收敛。最后,复数域从任何一个测量平面反向传播到物平面,以检索振幅和相位图像。

[0057]

彩色三刺激投影

[0058]

通过以10nm步长在400nm至700nm范围内的三十一(31)个不同波长密集采样可见光波段,实现了更高的颜色精度。使用国际照明委员会(cie)的颜色匹配函数,将该光谱信息投影到彩色三刺激值。xyz颜色空间中的彩色三刺激值可以通过下式计算,

[0059][0060]

其中,λ为波长,和为cie配色函数,t(λ)为样本的透射光谱,e(λ)为cie标准光源d65。xyz值可以线性变换为标准的rgb值,以供显示。

[0061]

经由深度神经网络的高保真全息颜色重建

[0062]

以以下方式生成基于深度学习的颜色重建框架的输入复数域:通过去马赛克像素超分辨率算法(使用顺序照明描述的全息像素超分辨率)进行分辨率增强和串扰校正,随后经由角谱传播(角谱传播描述)进行物体的初始估计。

[0063]

使用多路复用照明的全息去马赛克像素超分辨率(dpsr)

[0064]

与超光谱成像方法类似,经训练的深度神经网络方法还使用了基于移位和加的算法,结合6

×

6低分辨率全息图,以提高全息图分辨率。使用三个多路复用波长,即同时用三个不同的波长照明样本4。为了校正rgb传感器中不同颜色通道之间的串扰误差,使用了dpsr算法,如wu等人的“多路复用全息彩色成像的去马赛克像素超分辨率”,scirep6,(2016)中所述,该文献通过引用结合于此。这种串扰校正可以通过以下等式来说明:

[0065][0066]

其中,u

r

‑

ori

、和u

b

‑

ori

表示由图像传感器收集的原始干涉图案,w是通过给定rgb图像传感器30的实验校准获得的3

×

4串扰矩阵,并且u

r

、u

g

和u

b

是解复用的(r、g、b)干涉图案。在此处,选择三个照明波长为450nm、540nm和590nm。使用这些波长,特定的组织染色类型(即h&e染色的前列腺和masson三色染色的肺,用于本研究)可以获得更好的颜色准确度。当然,应当理解,其他着色剂或染料类型可以使用不同的照明波长。

[0067]

深度神经网络输入形成

[0068]

按照去马赛克的像素超分辨率算法,三个强度全息图被数值反向传播到物平面,如本文“角谱传播”部分所述。在该反向传播步骤之后,三个彩色全息通道中的每一个将产生复波,表示为真实数据通道和虚拟数据通道(50

r

、50

b

、50

g

、52

r

、52

b

、52

g

)。这导致六通道张量用作深层网络的输入,如图2所示。与地面实况不同,在这种情况下,不执行相位恢复,因为只有单个测量可用。

[0069]

深度神经网络架构

[0070]

深度神经网络18是生成对抗网络(gan),其被实现为学习颜色校正并消除缺失的相位相关伪像。这种gan框架最近在超分辨率显微成像和组织病理学中得到应用,由鉴别器网络(d)和生成器网络(g)组成(图4和5)。d网络(图5)用于区分从超光谱成像获得的三通道rgb基本事实图像(z)和来自g的输出图像。因此,g(图4)用于学习从六通道全息图像(x)(即具有真实和虚拟分量的三个颜色通道)到相应的rgb基本事实图像的转换。

[0071]

鉴别器和生成器损失定义为:

[0072]

l

discriminator

=d(g(x))2 (1

‑

d(z))2ꢀꢀꢀ

(5)

[0073]

l

generator

=l2{z,g(x)} λ

×

tv{g(x)} α

×

(1

‑

d(g(x)))2ꢀꢀꢀ

(6)

[0074]

其中,

[0075][0076]

其中,n

channels

是图像中的通道数(例如,对于rgb图像,n

channels

=3),m和n是图像的每一侧的像素数,i和j是像素索引,n表示通道索引。tv表示适用于生成器输出的总变化正则化项,定义为:

[0077][0078]

将正则化参数(λ,α)设置为0.0025和0.002,使得总变化损失(λ

×

tv{g(x

input

)})为l2的约2%,鉴别器损失(α

×

(1

‑

d(g(x

input

)))2)为l

generator

的约15%。理想情况下,在训练阶段结束时,d(z

label

)和d(g(x

input

))都收敛到0.5。

[0079]

生成器网络架构(图4)是u型网络的一种改编形式。此外,鉴别器网络(图5)使用了一个简单的分类器,该分类器由一系列卷积层组成,这些卷积层缓慢地降低了维数,同时增加了信道数量,然后是两个完全连接的层来输出分类。对于清除缺失的相位伪影和对重建图像执行颜色校正来说,u网络是理想的。卷积滤波器大小设置为3

×

3,除最后一层之外的每个卷积层后面都有一个泄漏

‑

relu激活函数,定义如下:

[0080][0081]

深度神经网络训练过程

[0082]

在网络训练过程中,超光谱方法生成的图像用作网络标签,反向传播到样本平面的去马赛克超分辨全息图用作网络输入。生成器和鉴别器网络都使用128

×

128像素的块大小进行训练。卷积层和全连接层中的权重使用xavier初始化来初始化,而偏差被初始化为零。使用自适应矩估计(adam)优化器更新所有参数,生成器网络的学习速率为1

×

10

‑4,鉴别器网络的相应速率为5

×

10

‑5。网络的培训、验证和测试是在配备四核3.60ghz cpu、16gb ram和nvidia geforce gtx 1080ti gpu的电脑上进行的。

[0083]

明场成像

[0084]

为了比较成像吞吐量,获得了明场显微图像。使用了配备电动载物台和一套超全色物镜(olympus uplsapo 20

×

/0.75数值孔径(na),工作距离(wd)0.65)的olympus ix83显微镜。显微镜由metamorph高级数字成像软件(7.10.1.161版,)控制,自动聚焦算法设置为在z方向5μm范围内搜索,精度为1μm。启用了双像素装仓,并使用了扫描补片之间10%的重叠。

[0085]

量化度量

[0086]

选择量化度量并用于评估网络的性能:ssim用于比较输出图像和目标图像之间组织结构信息的相似性;δe*94用于比较两幅图像的颜色距离。ssim值的范围从0到1,其中,统一的值表示两幅图像相同,即,

[0087][0088]

其中,u和v分别表示一幅矢量化测试图像和一幅矢量化参考图像,μ

u

和μ

v

分别是u和v的平均值,分别是u和v的方差,σ

u,v

是u和v的协方差,当分母接近零时,包含常数c1和c2,以稳定除法。

[0089]

使用的第二度量δe*94输出介于0和100之间的数字。零值表示比较的像素共享完全相同的颜色,而值100表示两个图像具有相反的颜色(混合两种相反的颜色会相互抵消并产生灰度颜色)。该方法以逐像素的方式计算颜色距离,并且通过平均输出图像的每个像素

中的δe*94值来计算最终结果。

[0090]

样本制备

[0091]

从ucla translational pathology core laboratory获得去识别的h&e染色的人前列腺组织切片和masson的三色染色人肺组织切片。使用现有的和匿名的样本。未链接或无法检索主题相关信息。

[0092]

结果和讨论

[0093]

定性评估

[0094]

使用两种不同的组织染色组合来评估训练的深度神经网络18的性能:用h&e染色的前列腺组织切片和用masson三色染色的肺组织切片。对于两种类型的样本,深度神经网络18在来自不同患者的三个组织切片上训练,并且在来自第四患者的另一组织切片上盲目测试。用于训练和测试的每个组织切片的视野(fov)约为20mm2。

[0095]

分别在图6a至图6b、图7a和图7b中总结肺和前列腺样本的结果。训练的深度神经网络18的彩色输出的这些性能证明了从单个非相位检索和波长复用全息图重建高保真和颜色精确图像的能力。使用经训练的深度神经网络18,系统2能够在整个传感器的fov(即,约20mm2)上重建样本4的图像,如图8所示。

[0096]

为了进一步证明深度神经网络18的定性性能,图9a至图9j和图10a至图10j示出了深度神经网络18(图9i和图10i)对由吸收光谱估计方法根据所需测量次数创建的图像的重建结果。对于这种比较,光谱估计方法用于多高度相位恢复方法,并且经由在相同波长(即,450nm、540nm和590nm)的顺序(n

h

=8,n

m

=3)和多路复用(n

h

=8,n

m

=1)照明,从减少数量的波长重建彩色图像(图9a至图9h和图10a至图10h)。定性地,深度神经网络18的结果可与对于顺序和多路复用照明情况都用多于四个样本到传感器的距离获得的多高度结果相比较。下面描述的定量分析也证实了这一点。

[0097]

量化性能评估

[0098]

基于深度神经网络18的输出和由超光谱成像方法产生的黄金标准图像之间的ssim和色差(δe*94)的计算来评估网络的定量性能。如表1所列,随着不同样本至传感器距离处全息图数量的减少,或者当照明改变为多路复用时,光谱估计方法的性能降低(即ssim降低,δe*94增加)。这种定量比较表明,使用单个超分辨全息图的深度神经网络18的性能与使用≥4倍原始全息测量的最先进算法获得的结果相当。

[0099]

表1

[0100][0101]

使用两个、四个、六个和八个样本到传感器的高度和三个顺序/多路复用波长照明条件对深度神经网络18和各种其他方法之间的ssim和δe*94性能进行比较,用于两个组织样本(基于网络的方法和具有可比性能的其他方法用粗体突出显示)。

[0102]

吞吐量评估

[0103]

表2列出了使用不同方法测量的整个fov(~20mm2)的重建时间。对于深度神经网络18,总重建时间包括获取36个全息图(在多路复用照明中的6

×

6横向位置)、执行dpsr、角谱传播、网络推断和图像拼接。对于超光谱成像方法,总重建时间包括8928个全息图的集合(在6

×

6的横向位置、8个样本到传感器的距离和31个波长)、psr、多高度相位检索、彩色三刺激投影和图像拼接。对于常规明场显微镜(配备自动扫描台),总时间包括使用20

×

/0.75na显微镜扫描明场图像,在每个扫描位置执行自动聚焦和图像拼接。此外,还显示了使用四个样本到传感器距离的多高度相位恢复方法的时间,并且与基于深度学习的神经网络

方法具有最接近的性能。所有的相干成像相关算法都是用nvidia gtx 1080ti gpu和cuda c 编程加速的。

[0104]

表2

[0105][0106]

表2:与传统超光谱成像方法和标准明场显微样本扫描(其中,n/a代表“不适用”)相比,深度神经网络方法重建精确彩色图像的时间性能评估。

[0107]

基于深度神经网络的方法需要约7分钟来获取和重建20mm2的组织面积,这大约等于通过标准、通用、明场扫描显微镜使用20

×

物镜对同一区域成像所需的时间。通常,该方法能够在10分钟内重建至少10mm2的fov。当然,增加处理能力和样本4的类型可能会影响重建时间,但这通常在几分钟内完成。注意,这明显短于使用光谱估计方法时所需的约60分钟(具有四个高度和同时照明)。系统2和基于深度学习的方法也提高了数据效率。原始超分辨全息图数据大小从4.36gb减少到1.09gb,这与总共使用了577.13mb的明场扫描显微镜图像的数据大小更具可比性。

[0108]

系统2用于生成样本4的重建彩色输出图像100,样本包括组织学染色的病理切片。本文描述的系统2和方法显著简化了数据采集过程,降低了数据存储要求,缩短了处理时间,并提高了全息重建图像的颜色精度。值得注意的是,其他技术(例如,病理学中使用的载玻片扫描显微镜)可以很容易地以更快的速度扫描组织载玻片,尽管它们在资源有限的环境中使用相当昂贵。因此,无透镜全息成像硬件的替代方案(例如,使用照明阵列40来执行像素超分辨率)可以改善整体重建时间。

[0109]

虽然已经示出和描述了本发明的实施例,但是在不脱离本发明的范围的情况下,可以进行各种修改。例如,虽然本发明主要被描述为使用无透镜显微镜装置,但是本文描述的方法也可以用于基于透镜的显微镜装置。例如,要重建的输入图像可以包括从基于相干透镜的计算显微镜(例如,傅里叶层析显微镜)获得的图像。此外,虽然超光谱成像用于生成用于网络训练的黄金标准或目标彩色图像,但其他成像模式也可用于训练。这不仅包括计算显微镜(例如,相应的基本事实或目标彩色图像被数值模拟或计算),还包括明场显微镜图像。因此,除了所附权利要求及其等同物之外,本发明不应受到限制。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。