1.本发明涉及文本识别技术领域,特别是涉及一种文本类别识别方法、装置、电子设备及介质。

背景技术:

2.随着互联网技术的飞速发展,互联网中存储的文本的数量越来越多,然而各文本的内容所表示含义各不相同,对文本进行分类,可以方便用户从海量的文本中,获取需要的文本。

3.例如,对于新闻可以按照题材分类,分为财经、体育、军事、娱乐等;对于购物网站的商品评价,可以按照情感分类,分为正面情绪的好评和负面情绪的差评;对于邮件正文和主题,可以分为垃圾邮件和正常邮件。

4.目前对于文本分类的手段主要通过统计文本中各词语的出现频次,根据高频出现的词语,确定文本的类别。

5.然而,这种方法仅考虑高频出现的词语,不考虑低频出现的词语,由于低频出现的词语同样能够表现文本的类别,因此仅利用文本的部分特征,确定的文本类别的准确度较低。

技术实现要素:

6.本发明实施例的目的在于提供一种文本类别识别方法、装置、电子设备及介质,以实现提高确定文本类别的准确度。具体技术方案如下:

7.第一方面,本发明实施例提供了一种文本类别识别方法,所述方法包括:

8.按照词语和数码之间的预设对应关系,对待识别文本包括的词语进行文本编码,得到所述待识别文本的编码数组;

9.将所述编码数组的维度转换为预设维度,所述预设维度包括数组长度维度,所述编码数组的数组长度为所述编码数组包括的数码总数;

10.将所述预设维度的编码数组输入文本类别识别模型,确定所述文本类别识别模型识别的所述待识别文本的类别,所述文本类别识别模型为基于样本文本预设维度的编码数组以及样本文本对应的标准类别,训练得到的神经网络模型。

11.可选的,所述文本类别识别模型通过以下步骤训练获得:

12.获取多个样本文本以及每个样本文本对应的标准类别;

13.针对每个样本文本,根据所述预设对应关系,对所述样本文本包括的词语进行文本编码,得到所述样本文本的样本编码数组;

14.将所述样本编码数组的维度转换为预设维度;

15.将多个预设维度的样本编码数组输入神经网络模型,确定所述神经网络模型识别的多个样本文本的类别;

16.根据所述神经网络模型识别的多个样本文本的类别以及所述多个样本文本分别

对应的标准类别,计算损失值;

17.根据所述损失值判断所述神经网络模型是否收敛;

18.若所述神经网络模型收敛,则得到所述文本类别识别模型;

19.若所述神经网络模型未收敛,则调整所述神经网络模型包括的模型参数,进行下一次训练。

20.可选的,所述按照词语和数码之间的预设对应关系,对待识别文本包括的词语进行文本编码,得到所述待识别文本的编码数组,包括:

21.针对所述待识别文本包括的每个词语,按照所述预设对应关系,获取所述词语对应的数码;

22.当所述待识别文本包括的词语对应的数码组成的编码数组的数组长度小于预设长度时,对所述编码数组补零,获得所述预设长度的编码数组。

23.可选的,所述确定所述文本类别识别模型识别的所述待识别文本的类别,包括:

24.获得所述文本类别识别模型输出的所述待识别文本属于各类别的概率;

25.确定所述待识别文本的类别为:所述待识别文本属于各类别的概率中最高概率对应的类别。

26.可选的,所述文本类别识别模型的框架为机器学习框架coreml,所述预设维度为5维。

27.第二方面,本发明实施例提供了一种文本类别识别装置,所述装置包括:

28.编码模块,用于按照词语和数码之间的预设对应关系,对待识别文本包括的词语进行文本编码,得到所述待识别文本的编码数组;

29.转换模块,用于将所述编码模块获得的所述编码数组的维度转换为预设维度,所述预设维度包括数组长度维度,所述编码数组的数组长度为所述编码数组包括的数码总数;

30.确定模块,用于将所述转换模块转换的所述预设维度的编码数组输入文本类别识别模型,确定所述文本类别识别模型识别的所述待识别文本的类别,所述文本类别识别模型为基于样本文本预设维度的编码数组以及样本文本对应的标准类别,训练得到的神经网络模型。

31.可选的,所述装置还包括训练模块,所述训练模块用于:

32.获取多个样本文本以及每个样本文本对应的标准类别;

33.针对每个样本文本,根据所述预设对应关系,对所述样本文本包括的词语进行文本编码,得到所述样本文本的样本编码数组;

34.将所述样本编码数组的维度转换为预设维度;

35.将多个预设维度的样本编码数组输入神经网络模型,确定所述神经网络模型识别的多个样本文本的类别;

36.根据所述神经网络模型识别的多个样本文本的类别以及所述多个样本文本分别对应的标准类别,计算损失值;

37.根据所述损失值判断所述神经网络模型是否收敛;

38.若所述神经网络模型收敛,则得到所述文本类别识别模型;

39.若所述神经网络模型未收敛,则调整所述神经网络模型包括的模型参数,进行下

一次训练。

40.可选的,所述编码模块,具体用于:

41.针对所述待识别文本包括的每个词语,按照所述预设对应关系,获取所述词语对应的数码;

42.当所述待识别文本包括的词语对应的数码组成的编码数组的数组长度小于预设长度时,对所述编码数组补零,获得所述预设长度的编码数组。

43.可选的,所述确定模块,具体用于:

44.获得所述文本类别识别模型输出的所述待识别文本属于各类别的概率;

45.确定所述待识别文本的类别为:所述待识别文本属于各类别的概率中最高概率对应的类别。

46.可选的,所述文本类别识别模型的框架为机器学习框架coreml,所述预设维度为5维。

47.第三方面,本发明实施例提供了一种电子设备,包括处理器、通信接口、存储器和通信总线,其中,处理器,通信接口,存储器通过通信总线完成相互间的通信;

48.存储器,用于存放计算机程序;

49.处理器,用于执行存储器上所存放的程序时,实现上述任一文本类别识别方法的步骤。

50.第四方面,本发明实施例还提供了一种计算机可读存储介质,所述计算机可读存储介质内存储有计算机程序,所述计算机程序被处理器执行时实现上述任一文本类别识别方法的步骤。

51.第五方面,本发明实施例还提供了一种包含指令的计算机程序产品,当其在计算机上运行时,使得计算机执行上述任一文本类别识别方法。

52.本发明实施例的技术方案至少可以带来以下有益效果:本发明实施例可以对待识别文本包括的词语进行编码,得到编码数组。由于输入文本类别识别模型的数组的维度需要为预设维度,因此还可以将编码后得到的编码数组的维度转换为预设维度,再通过文本类别识别模型,确定待识别文本的类别。与利用部分特征对文本进行分类的方式相比,本发明实施例利用了待识别文本的整体特征,对待识别文本分类,确定的文本类别的准确度更高。

53.当然,实施本发明的任一产品或方法并不一定需要同时达到以上所述的所有优点。

附图说明

54.为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

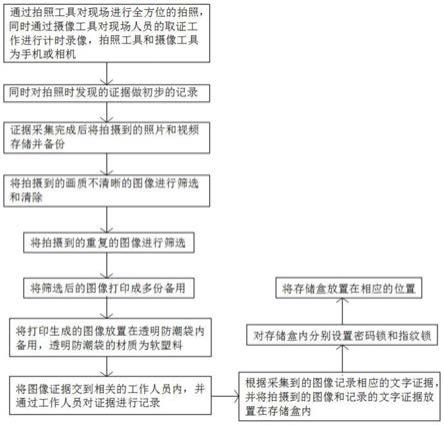

55.图1为本发明实施例提供的一种文本类别识别方法流程图;

56.图2为本发明实施例提供的一种文本类别识别模型的训练方法流程图;

57.图3为本发明实施例提供的另一种文本类别识别过程的示例性示意图;

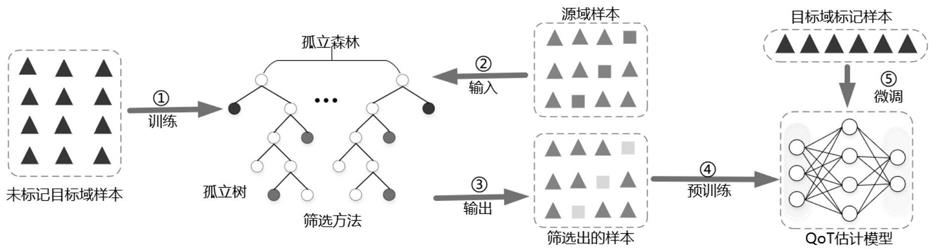

58.图4为本发明实施例提供的一种文本类别识别模型结构的示例性示意图;

59.图5为本发明实施例提供的一种文本类别识别装置结构示意图;

60.图6为本发明实施例提供的一种电子设备的结构示意图。

具体实施方式

61.下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

62.为了提高确定文本类别的准确度,本发明实施例提供了一种文本类别识别方法,该方法可以应用于电子设备,其中,电子设备可以是手机、计算机或者平板电脑等设备。如图1所示,该方法包括如下步骤。

63.步骤101,按照词语和数码之间的预设对应关系,对待识别文本包括的词语进行文本编码,得到待识别文本的编码数组。

64.步骤102,将编码数组的维度转换为预设维度。

65.其中,预设维度包括数组长度维度,编码数组的数组长度为编码数组包括的数码总数。

66.步骤103,将预设维度的编码数组输入文本类别识别模型,确定文本类别识别模型识别的待识别文本的类别。

67.其中,文本类别识别模型为基于样本文本预设维度的编码数组以及样本文本对应的标准类别,训练得到的神经网络模型。

68.本发明实施例的技术方案至少可以带来以下有益效果:本发明实施例可以对待识别文本包括的词语进行编码,得到编码数组。由于输入文本类别识别模型的数组的维度需要为预设维度,因此还可以将编码后得到的编码数组的维度转换为预设维度,再通过文本类别识别模型,确定待识别文本的类别。与利用部分特征对文本进行分类的方式相比,本发明实施例利用了待识别文本的整体特征,对待识别文本分类,确定的文本类别的准确度更高。

69.在本发明实施例中,当待识别文本为中文文本时,待识别文本包括的词语可以是一个字,也可以是多个字组成的词;当待识别文本为英文文本时,待识别文本包括的词语可以是字母,也可以是单词,还可以是词组等。以上两种仅为本发明实施例的示例,本发明实施例中的待识别文本还可以为其他语言编写的文本,本发明实施例对此不作具体限定。

70.可以理解的,数码可以是数字、字母、特殊符号或它们之间的组合。

71.可选的,上述步骤101得到待识别文本的编码数组的方式可以包括以下两个步骤。

72.步骤一,针对待识别文本包括的每个词语,按照预设对应关系,获取词语对应的数码。

73.步骤二,当待识别文本包括的词语对应的数码组成的编码数组的数组长度小于预设长度时,对编码数组补零,获得预设长度的编码数组。

74.本发明实施例的技术方案还可以带来以下有益效果:由于在编码数组的数组长度小于预设长度时,编码数组被补零,当设置的预设长度足够大时,可以使得各个文本的编码

数组长度统一,使得输入模型的数组长度统一,方便模型计算。

75.结合上述步骤一和步骤二举例如下。文本1为“今天是个好天气”,文本2为“今天是个坏天气”,词语和数码之间的预设对应关系如表一所示。

76.表一

77.词语今天是个天气好坏词语对应的数码01234

78.依据表一所示的预设对应关系,对文本1和文本2分别进行文本编码,得到文本1的编码数组1为[0,1,3,2],得到文本2的编码数组为[0,1,4,2]。

[0079]

假设预设长度为5,由于编码数组1包括4个数码,所以编码数组1的数组长度为4<5,对编码数组1补零后得到[0,1,3,2,0]。同理,由于编码数组2包括4个数码,所以编码数组2的数组长度为4<5,对编码数组2补零后得到[0,1,4,2,0]。

[0080]

补零后编码数组1和2的数组长度均为5,维度总数为1,编码数组1和2包括的维度为数组长度维度,而补零前编码数组1和2的数组长度为4,编码数组1和2的数组长度都可以表示为[4],表示数组长度为4。

[0081]

可选的,本发明实施例中的文本类别识别模型的框架可以为苹果公司的移动操作系统(iphone operation system,ios)中的机器学习框架(core machine learning,coreml),由于coreml能够处理的数据的维度可以是1维、3维或者5维,且文本类别识别模型能够处理的数组的维度至少为5维。因此,预设维度可以是5维,在输入文本类别识别模型之前,需要对待识别文本的编码数组的维度转换为5维。例如,文本类别识别模型可以是卷积神经网络(convolutional neural networks,cnn)模型。

[0082]

例如,预设维度为5维,文本1的编码数组1为[0,1,3,2],文本2的编码数组2为[0,1,4,2]。对编码数组1进行维度转换后得到编码数组1为[[[[[0]]]],[[[[1]]]],[[[[3]]]],[[[[2]]]]],其中,每一组方括号表示一个维度。对编码数组2进行维度转换后得到编码数组2为[[[[[0]]]],[[[[1]]]],[[[[4]]]],[[[[2]]]]]。

[0083]

例如,编码数组1的维度为[4,1,1,1,1],可以表示编码数组1的数组长度(sequence_length)为4,批量大小(batch_size)为1,通道(channel)为1,宽(width)为1,高(height)为1。

[0084]

本发明实施例中,对于预设维度的编码数组,除了编码数组的数组长度维度以外,其他维度没有实际含义,将编码数组的维度转换为预设维度的目的是:为了使得文本类别识别模型的输入数据能够满足文本类别识别模型以及coreml对于待处理数据的维度要求。因此本发明实施例对预设维度中除数组长度维度以外的其他维度的含义不作具体限定。

[0085]

可选的,如图2所示,本发明实施例中的文本类别识别模型可以通过以下步骤训练获得。

[0086]

步骤201,获取多个样本文本以及每个样本文本对应的标准类别。

[0087]

例如,样本文本对应的标准类别可以是对样本文本预先标注的类别,标准类别可以是论文、公文或者小说等。

[0088]

步骤202,针对每个样本文本,根据预设对应关系,对样本文本包括的词语进行文本编码,得到样本文本的样本编码数组。

[0089]

对样本文本进行文本编码的方法与上述步骤101相同,可以参考上述步骤101中的

描述,在此不再赘述。

[0090]

步骤203,将该样本编码数组的维度转换为预设维度。

[0091]

将样本编码数组的维度转换为预设维度的方法与上述步骤102相同,可以参考上述步骤102中的描述,在此不再赘述。

[0092]

步骤204,将多个预设维度的样本编码数组输入神经网络模型,确定神经网络模型识别的多个样本文本的类别。

[0093]

例如,每次迭代输入神经网络模型的样本编码数组的数量可以是500个。

[0094]

步骤205,根据神经网络模型识别的多个样本文本的类别以及多个样本文本分别对应的标准类别,计算损失值。

[0095]

例如,公式(1)为神经网络模型的损失函数,通过公式(1)计算损失值。

[0096]

e(t,y)=-∑

j

t

j

logy

j

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(1)

[0097]

其中,e(t,y)表示损失值,t

j

表示样本文本j对应的标准类别,y

j

表示神经网络模型识别的样本文本j的类别。

[0098]

步骤206,根据损失值判断神经网络模型是否收敛。若神经网络模型收敛,则执行步骤207;若神经网络模型未收敛,则执行步骤208。

[0099]

一种实施方式中,可以计算本次迭代计算的损失值与上一次迭代计算的损失值之间的差值是否小于预设差值;若是,则确定神经网络模型收敛;若否,则确定神经网络模型未收敛。

[0100]

另一种实施方式中,可以判断本次迭代计算的损失值是否小于预设损失值;若是,则确定神经网络模型收敛;若否,则确定神经网络模型未收敛。

[0101]

步骤207,得到文本类别识别模型。

[0102]

一种实施方式中,若神经网络模型收敛,则将本次迭代获得的神经网络模型作为文本类别识别模型。

[0103]

步骤208,调整神经网络模型包括的模型参数,进行下一次训练。

[0104]

一种实施方式中,若神经网络模型未收敛,则基于损失值调整神经网络模型包括的模型参数,并利用调整模型参数后的神经网络模型识别样本文本的类别,并计算损失值,直至神经网络模型收敛,得到文本类别识别模型。

[0105]

可以理解的,每次迭代过程中,输入神经网络模型的样本编码数组可以相同也可以不同。

[0106]

本发明实施例的技术方案还可以带来以下有益效果:本发明实施例可以利用样本文本以及样本文本对应的标准类别,训练神经网络模型,使得训练后获得的文本类别识别模型对于输入文本的识别结果接近于输入文本对应的标准类别,使得文本类别识别模型的识别结果更准确,进而使得本发明实施例通过文本类别识别模型获得的待识别文本的类别更准确。

[0107]

可选的,上述步骤103确定待识别文本的类别的方式,可以包括以下两个步骤。

[0108]

步骤一,获得文本类别识别模型输出的待识别文本属于各类别的概率。

[0109]

步骤二,确定待识别文本的类别为:待识别文本属于各类别的概率中最高概率对应的类别。

[0110]

例如,结合确定待识别文本的类别的步骤一、步骤二以及图3,假设待识别文本为

“

《一封陌生女人的来信》”,将待识别文件输入文本类别识别模型后,获得文本类别识别模型输出的待识别文本属于论文的概率为0.1,待识别文本属于简历的概率为0.1,待识别文本属于小说的概率为0.5,待识别文本属于公文的概率为0.1,待识别文本属于课本的概率为0.2。待识别文本属于小说的概率最高,因此将待识别文本的类别确定为小说。

[0111]

本发明实施例还可以对文本的感情色彩进行分类,例如,文本1为“今天是个好天气”,文本类别识别模型输出的文本1的感情色彩为积极的概率为0.8,文本1的感情色彩为消极的概率为0.2,确定文本1的感情色彩为积极。文本2为“今天是个坏天气”,文本类别识别模型输出的文本2的感情色彩为积极的概率为0.1,文本2的感情色彩为消极的概率为0.9,确定文本2的感情色彩为消极。

[0112]

示例性的,本发明实施例中的文本类别识别模型可以是cnn模型,如图4所示,文本经过第一重塑(reshape)层,将文本的维度转换为1维、3维或者5维。转换维度后的文本经过嵌入(embedding)层,获得文本的编码数组。编码数组再经过第二reshape层,将编码数组的维度转换为5维。维度为5的编码数组分别经过4个并联的卷积(convolutional)层和最大池化(maxpooling)层,得到4个池化后数据。将这4个池化后数据经过串联(concatenate)层,得到将这4个数据串联成一个的数据。然后将串联后的数据经过第三reshape层,将串联后的数据的维度转换为1维,再将1维数据经过退出(dropout)层和全连接(dense)层,得到文本类别识别模型输出的文本属于各个类别的概率。

[0113]

可以理解的,由于embedding层也在coreml框架下实现,输入embedding层的数据的维度需要为1维、3维或者5维,因此在embedding层之前设置第一reshape层。当输入文本的维度为1维、3维或者5维时,也可以不设置第一reshape层。

[0114]

由于经过卷积层和最大池化层输出的数据的维度不会改变,为5维,这5维数据中包括模型计算的输入文本属于各个类别的概率。为方便获得输入文本属于各个类别的概率,可以将维度为5的数据经过第三reshape层转换为维度为1的数据,使得维度为1的数据仅包括输入文本属于各个类别的概率。

[0115]

本发明实施例的技术方案还可以带来以下有益效果:由于长文本在进行文本编码后需要进行词嵌入,再输入模型,利用模型识别长文本的类别。然而文本经过词嵌入后,维度变为2,而coreml框架下支持处理的数据为1维、3维或者5维,使得词嵌入后的数据会被强制转换为1维、3维或者5维中的其中一个维度,当数据被强制转换为1维,会造成数据丢失。而单个字或者词不需要进行词嵌入,因此现有技术仅能识别单个字或者词的类别,无法识别长文本的类别。

[0116]

而在本发明实施例中,编码数组输入文本类别识别模型之前,先将编码数组的维度转换为文本类别识别模型能够处理的预设维度,使得本发明实施例可以识别长文本的类别。

[0117]

对词嵌入过程的举例如下:编码数组[0,1,3,2,0]经过词嵌入后得到的数组为:

[0118]

[[1,0,0,0,0],

[0119]

[0,1,0,0,0],

[0120]

[0,0,0,1,0],

[0121]

[0,1,0,0,0],

[0122]

[1,0,0,0,0]]

[0123]

数组的初始位置为0,词嵌入后得到的数组的每一行中元素为“1”的位置分别为0,1,3,2,0,分别对应词嵌入之前的数组包括的元素。词嵌入之后的数组维度为2,每个维度的数组长度为5。

[0124]

对应于上述方法实施例,本发明实施例提供了一种文本类别识别装置,如图5所示,该装置包括:编码模块501、转换模块502和确定模块503;

[0125]

编码模块501,用于按照词语和数码之间的预设对应关系,对待识别文本包括的词语进行文本编码,得到待识别文本的编码数组;

[0126]

转换模块502,用于将编码模块501获得的编码数组的维度转换为预设维度,预设维度包括数组长度维度,编码数组的数组长度为编码数组包括的数码总数;

[0127]

确定模块503,用于将转换模块502转换的预设维度的编码数组输入文本类别识别模型,确定文本类别识别模型识别的待识别文本的类别,文本类别识别模型为基于样本文本预设维度的编码数组以及样本文本对应的标准类别,训练得到的神经网络模型。

[0128]

可选的,装置还包括训练模块,训练模块用于:

[0129]

获取多个样本文本以及每个样本文本对应的标准类别;

[0130]

针对每个样本文本,根据预设对应关系,对样本文本包括的词语进行文本编码,得到样本文本的样本编码数组;

[0131]

将样本编码数组的维度转换为预设维度;

[0132]

将多个预设维度的样本编码数组输入神经网络模型,确定神经网络模型识别的多个样本文本的类别;

[0133]

根据神经网络模型识别的多个样本文本的类别以及多个样本文本分别对应的标准类别,计算损失值;

[0134]

根据损失值判断神经网络模型是否收敛;

[0135]

若神经网络模型收敛,则得到文本类别识别模型;

[0136]

若神经网络模型未收敛,则调整神经网络模型包括的模型参数,进行下一次训练。

[0137]

可选的,编码模块501,具体用于:

[0138]

针对待识别文本包括的每个词语,按照预设的编码规则,获取词语对应的数码;

[0139]

当待识别文本包括的词语对应的数码组成的编码数组的数组长度小于预设长度时,对编码数组补零,获得预设长度的编码数组。

[0140]

可选的,确定模块503,具体用于:

[0141]

获得文本类别识别模型输出的待识别文本属于各类别的概率;

[0142]

确定待识别文本的类别为:待识别文本属于各类别的概率中最高概率对应的类别。

[0143]

可选的,文本类别识别模型的框架为机器学习框架coreml,预设维度为5维。

[0144]

本发明实施例还提供了一种电子设备,如图6所示,包括处理器601、通信接口602、存储器603和通信总线604,其中,处理器601,通信接口602,存储器603通过通信总线604完成相互间的通信,

[0145]

存储器603,用于存放计算机程序;

[0146]

处理器601,用于执行存储器603上所存放的程序时,实现上述方法实施例中的方法步骤。

[0147]

上述电子设备提到的通信总线可以是外设部件互连标准(peripheral component interconnect,pci)总线或扩展工业标准结构(extended industry standard architecture,eisa)总线等。该通信总线可以分为地址总线、数据总线、控制总线等。为便于表示,图中仅用一条粗线表示,但并不表示仅有一根总线或一种类型的总线。

[0148]

通信接口用于上述电子设备与其他设备之间的通信。

[0149]

存储器可以包括随机存取存储器(random access memory,ram),也可以包括非易失性存储器(non-volatile memory,nvm),例如至少一个磁盘存储器。可选的,存储器还可以是至少一个位于远离前述处理器的存储装置。

[0150]

上述的处理器可以是通用处理器,包括中央处理器(central processing unit,cpu)、网络处理器(network processor,np)等;还可以是数字信号处理器(digital signal processing,dsp)、专用集成电路(application specific integrated circuit,asic)、现场可编程门阵列(field-programmable gate array,fpga)或者其他可编程逻辑器件、分立门或者晶体管逻辑器件、分立硬件组件。

[0151]

在本发明提供的又一实施例中,还提供了一种计算机可读存储介质,该计算机可读存储介质内存储有计算机程序,所述计算机程序被处理器执行时实现上述任一文本类别识别方法的步骤。

[0152]

在本发明提供的又一实施例中,还提供了一种包含指令的计算机程序产品,当其在计算机上运行时,使得计算机执行上述实施例中任一文本类别识别方法。

[0153]

在上述实施例中,可以全部或部分地通过软件、硬件、固件或者其任意组合来实现。当使用软件实现时,可以全部或部分地以计算机程序产品的形式实现。所述计算机程序产品包括一个或多个计算机指令。在计算机上加载和执行所述计算机程序指令时,全部或部分地产生按照本发明实施例所述的流程或功能。所述计算机可以是通用计算机、专用计算机、计算机网络、或者其他可编程装置。所述计算机指令可以存储在计算机可读存储介质中,或者从一个计算机可读存储介质向另一个计算机可读存储介质传输,例如,所述计算机指令可以从一个网站站点、计算机、服务器或数据中心通过有线(例如同轴电缆、光纤、数字用户线(dsl))或无线(例如红外、无线、微波等)方式向另一个网站站点、计算机、服务器或数据中心进行传输。所述计算机可读存储介质可以是计算机能够存取的任何可用介质或者是包含一个或多个可用介质集成的服务器、数据中心等数据存储设备。所述可用介质可以是磁性介质,(例如,软盘、硬盘、磁带)、光介质(例如,dvd)、或者半导体介质(例如固态硬盘solid state disk(ssd))等。

[0154]

需要说明的是,在本文中,诸如第一和第二等之类的关系术语仅仅用来将一个实体或者操作与另一个实体或操作区分开来,而不一定要求或者暗示这些实体或操作之间存在任何这种实际的关系或者顺序。而且,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、方法、物品或者设备不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、方法、物品或者设备所固有的要素。在没有更多限制的情况下,由语句“包括一个

……”

限定的要素,并不排除在包括所述要素的过程、方法、物品或者设备中还存在另外的相同要素。

[0155]

本说明书中的各个实施例均采用相关的方式描述,各个实施例之间相同相似的部分互相参见即可,每个实施例重点说明的都是与其他实施例的不同之处。尤其,对于装置实

施例而言,由于其基本相似于方法实施例,所以描述的比较简单,相关之处参见方法实施例的部分说明即可。

[0156]

以上所述仅为本发明的较佳实施例,并非用于限定本发明的保护范围。凡在本发明的精神和原则之内所作的任何修改、等同替换、改进等,均包含在本发明的保护范围内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。