1.本发明属于结构实验和智能控制技术领域,特别涉及一种基于强化学习的振动台前馈控制方法及控制系统。

背景技术:

2.地震模拟振动台的前馈补偿控制也称为数字迭代控制、迭代学习控制、频谱迭代控制、功率谱复现控制或时域波形复现控制,其原理是对目标波形和振动台台面反馈波形的傅里叶谱、功率谱或反应谱进行比较得到振动台系统等效传递函数或传递函数矩阵的非参数化模型,通过对非参数化模型取逆或直接比对目标波形和反馈波形的频谱差异进而对驱动信号的调整和修正,经过对驱动信号的多次迭代达到提升反馈波形再现精度的目的。但由于驱动信号的调整一般离线进行,当试验过程中系统特性发生非线性改变时,前馈补偿往往难以达到理想的效果,且在实际应用中,迭代过程往往比较耗时,迭代的收敛性还有可能变差甚至产生发散的现象,当迭代所采用的信号幅值较大时还有可能造成试件的损坏。

技术实现要素:

3.为了解决上述问题,本发明提供了一种基于强化学习的振动台前馈控制方法及控制系统,以解决现有前馈补偿算法耗时长且控制效果不理想的问题。

4.为实现上述目的,本发明提供了一种基于强化学习的振动台前馈控制方法,包括:

5.对振动台的系统特性进行系统辨识与模型构建,得到振动台深度网络模型;

6.建立前馈网络补偿器模型,并将前馈网络补偿器模型与振动台深度网络模型串联,得到补偿器和振动台的串联控制系统模型;

7.将串联控制系统模型的输入信号和输出信号的逼近作为目标,采用监督学习算法训练前馈网络补偿器模型,得到前馈网络补偿器训练模型;

8.建立强化学习代理器,并基于强化学习代理器对前馈网络补偿器训练模型进行强化学习,得到前馈网络补偿器训练模型的最优控制策略。

9.根据本发明的一个具体实施例,对振动台的系统特性进行系统辨识与模型构建,得到振动台深度网络模型进一步包括:

10.获取振动台系统的训练样本,并基于训练样本对振动台系统进行系统辨识,得到振动台系统特征数据,训练样本包括振动台系统的输入实测数据和输出实测数据;

11.基于振动台系统特征数据,采用lstm算法建立振动台深度网络模型,振动台深度网络模型的网络结构包括输入层,至少2个隐藏层,全连接层和输出层,隐藏层设置至少30个节点。

12.根据本发明的一个具体实施例,振动台深度网络模型以最小化损失函数为目标更新网络参数,参数优化算法采用adam,损失函数采用mse,损失函数的计算公式为:

[0013][0014]

式中,mse为损失函数,yi为期望输出,f(xi)为系统实际输出,m为训练样本数量。

[0015]

根据本发明的一个具体实施例,振动台深度网络模型的输入-输出信号与振动台系统的输入-输出信号一致。

[0016]

根据本发明的一个具体实施例,建立前馈网络补偿器模型,并将前馈网络补偿器模型与振动台深度网络模型串联,得到补偿器和振动台的串联控制系统模型进一步包括:

[0017]

采用lstm算法建立前馈网络补偿器模型,并将前馈网络补偿器模型与振动台深度网络模型串联,得到补偿器和振动台的串联控制系统,其中前馈网络补偿器模型的网络结构包括输入层,至少2个隐藏层,全连接层和输出层,隐藏层设置至少30个节点,参数优化算法采用adam,损失函数采用mse,损失函数的计算公式为:

[0018][0019]

式中,mse为损失函数,yi为期望输出,f(xi)为系统实际输出,m为训练样本数量。

[0020]

根据本发明的一个具体实施例,将串联控制系统模型的输入信号和输出信号的逼近作为目标,采用监督学习算法训练前馈网络补偿器模型,得到前馈网络补偿器训练模型包括:

[0021]

以最小化串联控制系统模型的输入和输出信号作为目标进行训练,训练过程中固定振动台深度网络模型的参数,仅更新前馈网络补偿器模型的参数,并将振动台深度网络模型的输出引入损失函数mse对前馈网络补偿器模型进行训练,得到前馈网络补偿器训练模型,其中损失函数的计算公式为:

[0022][0023]

式中,mse为损失函数,xi是期望输出,f(xi)为前馈网络补偿器模型的输出,g(f(xi))为振动台网络模型的输出,m为训练样本数量。

[0024]

根据本发明的一个具体实施例,建立强化学习代理器,并基于强化学习代理器对前馈网络补偿器训练模型进行强化学习,得到前馈网络补偿器训练模型的最优控制策略进一步包括:

[0025]

采用ddpg算法建立强化学习代理器;

[0026]

基于强化学习代理器对前馈网络补偿器训练模型进行自主探索训练以及更新模型的网络参数,得到前馈网络补偿器训练模型的最优控制策略;

[0027]

根据振动台的系统特性对最优控制策略进行在线调整和优化。

[0028]

根据本发明的一个具体实施例,强化学习代理器包括actor网络和critic网络,actor网络和critic网络均包括至少2个隐藏层,每个隐藏层包括至少40个节点。

[0029]

根据本发明的一个具体实施例,基于强化学习代理器对前馈网络补偿器训练模型进行自主探索训练以及更新模型的网络参数,得到前馈网络补偿器训练模型的最优控制策略包括:

[0030]

以振动台系统为环境,以振动台系统的反馈信号为状态,以前馈网络补偿器模型的网络参数的修正值为输出动作,以输入和输出信号的平方差为奖励值,以最大化输入和

输出波形的逼近程度作为模型的更新目标对前馈网络补偿器训练模型进行强化学习,得到前馈网络补偿器训练模型的最优控制策略。

[0031]

一种基于强化学习的振动台前馈控制系统,包括:系统输入端,系统输出端,地震模拟震动台,前馈补偿器,深度网络模型和强化学习代理器,系统输入端,前馈补偿器,深度网络模型和系统输出端依次连接,强化学习代理器的输入端与前馈补偿器的输入端相连接,强化学习代理器的输出端与深度网络模型的输出端相连接,地震模拟震动台的输入端与前馈补偿器的输入端相连接,地震模拟震动台的输出端与深度网络模型的输出端相连接,前馈补偿器的输出端与系统输出端相连接。

[0032]

与现有技术相比,本发明提供的一种基于强化学习的振动台前馈控制方法及控制系统,与传统的前馈补偿算法相比,将深度学习算法和强化学习算法相结合,通过建立强化学习代理器在前馈控制环节中可以基于系统特性在线调整和优化控制策略,提高了前馈控制的稳定性,并且基于强化学习的前馈补偿算法不需要进行离线迭代,大幅提升了前馈补偿环节的运行效率。

附图说明

[0033]

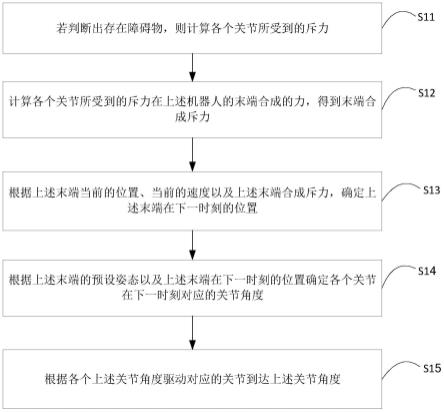

图1是根据本发明一实施例提供的基于强化学习的振动台前馈控制方法流程图。

[0034]

图2是根据本发明一实施例提供的振动台深度网络模型构建方法流程图。

[0035]

图3是根据本发明一实施例提供的振动台强化学习方法流程图。

[0036]

图4是根据本发明一实施例提供的基于强化学习的振动台前馈控制系统示意图。

[0037]

附图标记:

[0038]

1-系统输入端;2-系统输出端;3-地震模拟震动台;4-前馈补偿器;5-深度网络模型;6-强化学习代理器。

具体实施方式

[0039]

为了使本领域技术人员更加清楚地理解本发明的概念和思想,以下结合具体实施例详细描述本发明。应理解,本文给出的实施例都只是本发明可能具有的所有实施例的一部分。本领域技术人员在阅读本技术的说明书以后,有能力对下述实施例的部分或整体做出改进、改造、或替换,这些改进、改造、或替换也都包含在本发明要求保护的范围内。

[0040]

在本文中,术语“第一”、“第二”和其它类似词语并不意在暗示任何顺序、数量和重要性,而是仅仅用于对不同的元件进行区分。在本文中,术语“一”、“一个”和其它类似词语并不意在表示只存在一个事物,而是表示有关描述仅仅针对事物中的一个,事物可能具有一个或多个。在本文中,术语“包含”、“包括”和其它类似词语意在表示逻辑上的相互关系,而不能视作表示空间结构上的关系。例如,“a包括b”意在表示在逻辑上b属于a,而不表示在空间上b位于a的内部。另外,术语“包含”、“包括”和其它类似词语的含义应视为开放性的,而非封闭性的。例如,“a包括b”意在表示b属于a,但是b不一定构成a的全部,a还可能包括c、d、e等其它元素。

[0041]

在本文中,术语“实施例”、“本实施例”、“一实施例”、“一个实施例”并不表示有关描述仅仅适用于一个特定的实施例,而是表示这些描述还可能适用于另外一个或多个实施例中。本领域技术人员应理解,在本文中,任何针对某一个实施例所做的描述都可以与另外

一个或多个实施例中的有关描述进行替代、组合、或者以其它方式结合,替代、组合、或者以其它方式结合所产生的新实施例是本领域技术人员能够容易想到的,属于本发明的保护范围。

[0042]

实施例1

[0043]

本发明的实施方式的附加方面和优点将在下面的描述中部分给出,部分将从下面的描述中变得明显,或通过本发明的实施方式的实践了解到。结合图1-图3,本发明实施例提供了一种基于强化学习的振动台前馈控制方法,包括:

[0044]

s1:对振动台的系统特性进行系统辨识与模型构建,得到振动台深度网络模型。

[0045]

s2:建立前馈网络补偿器模型,并将前馈网络补偿器模型与振动台深度网络模型串联,得到补偿器和振动台的串联控制系统模型。

[0046]

s3:将串联控制系统模型的输入信号和输出信号的逼近作为目标,采用监督学习算法训练前馈网络补偿器模型,得到前馈网络补偿器训练模型。

[0047]

s4:建立强化学习代理器,并基于强化学习代理器对前馈网络补偿器训练模型进行强化学习,得到前馈网络补偿器训练模型的最优控制策略。

[0048]

强化学习是一种通过让智能体在与环境的交互中得以学习和进步的人工智能算法。与监督学习不同的是,强化学习不需要事先准备好的输出标签,即在训练时没有“正确答案”供模型参考。强化学习主要是利用在一步一步试错中获取的奖励值来调整自身参数,这种奖励值不同于监督学习事先给出的期望输出,它是根据人工制定的学习规则,在智能体做出行动后通过判定得到的。在本发明一实施例中,基于强化学习的振动台前馈控制方法的实现包括系统辨识、监督学习和强化学习三部分。首先基于深度学习对振动台系统进行辨识,利用振动台系统输入-输出的实测数据作为模型辨识的训练样本,获得与振动台系统特性一致的振动台深度网络模型;然后基于深度学习构造前馈网络补偿器模型与振动台深度网络模型串联,以整个控制系统输入-输出信号的逼近作为目标,通过监督学习训练前馈补偿器;最后在“前馈网络补偿器模型-振动台深度网络模型”的基础上,基于强化学习算法构造具备自主学习能力的强化学习代理器,利用前馈补偿智能代理程序进行自主探索训练以更新前馈补偿器的网络参数,从而搜寻前馈补偿器的最优控制策略。与传统的前馈补偿算法相比,强化学习代理器在前馈控制环节中可以基于系统特性在线调整和优化控制策略,明显提高了前馈控制的稳定性,并且基于强化学习的前馈补偿算法不需要进行离线迭代,因此能大幅提升了前馈补偿环节的运行效率。

[0049]

具体的,步骤s1对振动台的系统特性进行系统辨识与模型构建,得到振动台深度网络模型进一步包括:

[0050]

s11:获取振动台系统的训练样本,并基于训练样本对振动台系统进行系统辨识,得到振动台系统特征数据,训练样本包括振动台系统的输入实测数据和输出实测数据。

[0051]

获取振动台系统的训练样本其目的是确立振动台系统的数学模型参数,经过训练后,模型系统也确立了下来,利用振动台系统的输入-输出的实测数据作为模型辨识的训练样本,其目的是辨识地震模拟振动台系统特性,进而获取与振动台输入-输出保持一致的振动台深度网络模型。

[0052]

s12:基于振动台系统特征数据,采用lstm算法建立振动台深度网络模型,振动台深度网络模型的输入-输出信号与振动台系统的输入-输出信号一致。振动台深度网络模型

的网络结构包括输入层,至少2个隐藏层,全连接层和输出层,隐藏层设置至少30个节点。振动台深度网络模型以最小化损失函数为目标更新网络参数,参数优化算法采用adam,损失函数采用mse,损失函数的计算公式为:

[0053][0054]

式中,mse为损失函数,yi为期望输出,f(xi)为系统实际输出,m为训练样本数量。

[0055]

lstm算法的全称是long short-term memory(长短时记忆网络),是一种特定形式的循环神经网络,该算法通过增加输入门,遗忘门和输出门,使得自循环的权重是变化的,这样一来在模型参数固定的情况下,不同时刻的积分尺度可以动态改变,从而避免了梯度消失或者梯度膨胀的问题。采用长短时记忆网络(lstm算法)建立振动台深度网络模型,基于lstm算法搭建的振动台深度网络模型可设置2-4个隐藏层,每层采用30-60个节点,在本发明实施例中,振动台深度网络模型是基于python语言和pytorch深度学习框架进行模型的搭建,设计lstm模型的网络结构为输入层、两层隐藏层、全连接层和输出层,隐层分别设置30和60个节点,参数优化算法采用adam,损失函数采用mse,模型以最小化损失函数为目的更新网络参数。

[0056]

具体的,步骤s2建立前馈网络补偿器模型,并将前馈网络补偿器模型与振动台深度网络模型串联,得到补偿器和振动台的串联控制系统模型进一步包括:

[0057]

采用lstm算法建立前馈网络补偿器模型,并将前馈网络补偿器模型与振动台深度网络模型串联,得到补偿器和振动台的串联控制系统,其中前馈网络补偿器模型的网络结构包括输入层,至少2个隐藏层,全连接层和输出层,隐藏层设置至少30个节点,参数优化算法采用adam,损失函数采用mse,损失函数的计算公式为:

[0058][0059]

式中,mse为损失函数,yi为期望输出,f(xi)为系统实际输出,m为训练样本数量。

[0060]

在本发明实施例中针对步骤s2建立的前馈网络补偿器模型,其网络规模、结构、优化算法和损失函数与步骤s1建立的振动台深度网络模型保持一致,即网络结构设为输入层、两层隐藏层、全连接层和输出层,隐藏层分别设置30和60个节点,参数优化算法采用adam,损失函数采用mse。

[0061]

具体的,步骤s3将串联控制系统模型的输入信号和输出信号的逼近作为目标,采用监督学习算法训练前馈网络补偿器模型,得到前馈网络补偿器训练模型包括:

[0062]

以最小化串联控制系统模型的输入和输出信号作为目标进行训练,训练过程中固定振动台深度网络模型的参数,仅更新前馈网络补偿器模型的参数,并将振动台深度网络模型的输出引入损失函数mse对前馈网络补偿器模型进行训练,得到前馈网络补偿器训练模型,其中损失函数的计算公式为:

[0063][0064]

式中,mse为损失函数,xi是期望输出,f(xi)为前馈网络补偿器模型的输出,g(f(xi))为振动台网络模型的输出,m为训练样本数量。

[0065]

以最小化串联控制系统模型的输入和输出信号作为目标进行训练,即将振动台深度网络模型作为损失函数mse的一部分,以整个串联控制系统输入-输出信号的逼近作为目标,通过监督学习训练前馈补偿器。在损失函数mse中,xi即是期望输出,也是输入信号,f(xi)为前馈补偿器模型的输出,g(f(xi))为振动台网络模型的输出。在“前馈网络补偿器-振动台深度网络模型”的训练过程中,需固定振动台网络模型的参数,仅更新前馈补偿器模型的参数。

[0066]

具体的,步骤s4建立强化学习代理器,并基于强化学习代理器对前馈网络补偿器训练模型进行强化学习,得到前馈网络补偿器训练模型的最优控制策略进一步包括:

[0067]

s41:采用ddpg算法建立强化学习代理器。其中强化学习代理器包括actor网络和critic网络,actor网络和critic网络均包括至少2个隐藏层,每个隐藏层包括至少40个节点。

[0068]

actor网络和critic网络均可选用bp神经网络进行建模,每个网络可设置2-4个隐藏层,每层采用40-80个节点,采用深度确定性策略梯度算法(ddpg)建立强化学习代理器,强化学习前馈补偿智能代理程序具备自主学习能力,会在与控制系统的交互过程中得以学习和进步,最终辅助前馈补偿器搜寻到最优控制策略,并可以基于系统特性进行在线调整和优化控制策略。本发明实施例中actor网络和critic网络,每个网络设置2个隐藏层,第一层设置40个节点,第二层设置80个节点,将振动台系统输出的反馈信号设置为ddpg的输入,将前馈补偿器网络参数的修正值设置为ddpg的输出,并以输入-输出信号的平方差作为奖励值,促使ddpg以最大化输入-输出波形的逼近程度作为模型的更新目标。

[0069]

s42:基于强化学习代理器对前馈网络补偿器训练模型进行自主探索训练以及更新模型的网络参数,得到前馈网络补偿器训练模型的最优控制策略,具体包括:

[0070]

以振动台系统为环境,以振动台系统的反馈信号为状态,以前馈网络补偿器模型的网络参数的修正值为输出动作,以输入和输出信号的平方差为奖励值,以最大化输入和输出波形的逼近程度作为模型的更新目标对前馈网络补偿器训练模型进行强化学习,得到前馈网络补偿器训练模型的最优控制策略。

[0071]

强化学习代理器在交互过程中以振动台系统作为环境,以振动台系统的反馈信号作为状态,以前馈补偿器网络参数的修正值作为输出动作,并以输入-输出信号的平方差作为奖励值,奖励值会促使ddpg以最大化输入-输出波形的逼近程度作为模型的更新目标,利用强化学习代理器进行自主探索训练以更新前馈补偿器的网络参数,从而搜寻前馈补偿器的最优控制策略。

[0072]

s43:根据振动台的系统特性对最优控制策略进行在线调整和优化。

[0073]

在搜寻前馈补偿器的最优控制策略过程中,可根据振动台的系统特性对最优控制策略进行在线调整和优化,提高了前馈控制的稳定性,由于基于强化学习的前馈补偿算法不需要进行离线迭代,因此能大幅提升前馈补偿环节的运行效率。

[0074]

实施例2

[0075]

结合图4,本发明实施例提供了一种基于强化学习的振动台前馈控制系统,包括:

[0076]

系统输入端1,系统输出端2,地震模拟震动台3,前馈补偿器4,深度网络模型5和强化学习代理器6,系统输入端1,前馈补偿器4,深度网络模型5,系统输出端2依次相连接,强化学习代理器6的输入端与前馈补偿器4的输入端相连接,强化学习代理器6的输出端与深

度网络模型5的输出端相连接,地震模拟震动台3的输入端与前馈补偿器4的输入端相连接,地震模拟震动台3的输出端与深度网络模型5的输出端相连接,前馈补偿器4的输出端与系统输出端2相连接,该控制系统可根据振动台的系统特性对最优控制策略进行在线调整和优化,提高了前馈控制的稳定性,并且大幅提升前馈补偿环节的运行效率。

[0077]

综上所述,本发明提供的一种基于强化学习的振动台前馈控制方法,与传统的前馈补偿算法相比,将深度学习算法和强化学习算法相结合,通过建立强化学习代理器在前馈控制环节中可以基于系统特性在线调整和优化控制策略,提高了前馈控制的稳定性,并且基于强化学习的前馈补偿算法不需要进行离线迭代,大幅提升了前馈补偿环节的运行效率。

[0078]

以上结合具体实施方式(包括实施例和实例)详细描述了本发明的概念、原理和思想。本领域技术人员应理解,本发明的实施方式不止上文给出的这几种形式,本领域技术人员在阅读本技术文件以后,可以对上述实施方式中的步骤、方法、系统、部件做出任何可能的改进、替换和等同形式,这些改进、替换和等同形式应视为落入在本发明的范围内,本发明的保护范围仅以权利要求书为准。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。