1.本发明涉及安防及监狱的巡检机器人技术领域,具体涉及一种智能巡检机器人全景追踪及避障方法及系统。

背景技术:

2.城市安防及监狱管理,需要对区域环境进行定期巡检,以便及时发现异常危险情况,并进行及时的上报与应急处理,该方面需要大量的人工投入,智能巡检机器人是解决当前巡检问题的有效解决方式。

3.现有智能巡检机器人,基本为移动车体负载云台相机、危险气体传感器等,通过激光导航或视觉导航方式进行移动作业,例如申请号为cn202111173783.x的现有发明专利《一种巡检机器人行走路线追踪系统及方法》通过采集终端追踪巡检机器人的行走路线,同时,获取巡检机器人行走过程中前方物体的信息,其中,物体信息包括物体的影像、大小和与巡检机器人的距离,并上传至识别终端,识别终端识别物体的影像,并识别出障碍物,并将识别结果上传至规划终端,规划终端提取识别终端中障碍物的大小、与巡检机器人距离的信息,并以此规划出规避障碍物的实时行走路线,以及控制巡检机器人按照实时行走路线进行行走,进而避开障碍物。然而在人流较大的移动人群环境中,现有的巡检机器人对复杂环境下障碍物的识别,尤其是障碍物处于多个方向,部分有移动,不能有效投入使用。前述现有专利仅根据障碍物的识别结果,将与障碍物相对应的物体大小、距离、位置定位信息相关联等技术特征进行机器人路线规划及导航,缺乏应对多方向复杂场景下的规避策略,同时在发生人为意外情况下,尤其是出现多个危险人员时,通过机载的云台相机不能及时的将人员的面部特征、移动方向及位置进行全面捕捉及上传,上述情况均对智能巡检机器人的使用及发展带来困难。

4.综上,现有技术存在障碍识别准确率低、多人员追踪困难、规避功能单一的技术问题。

技术实现要素:

5.本发明所要解决的技术问题在于如何解决障碍识别准确率低、多人员追踪困难、规避功能单一的技术问题。

6.本发明是采用以下技术方案解决上述技术问题的:一种智能巡检机器人全景追踪及避障方法包括:

7.s1、以多角度全景固定相机模块采集获取实时全景视频图像;

8.s2、分类所述实时全景视频图像中的各相机采集数据,将所述各相机采集数据存储于实时视频分类数据库;

9.s3、分帧调取所述各相机采集数据中的视频数据,以得到分帧图像数据,矫正并去噪处理所述分帧图像数据,以得到图片处理数据;

10.s4、利用输入的n左摄像头匹配逻辑对所述图片处理数据进行轮廓匹配,以得到轮

廓匹配数据,对所述轮廓匹配数据进行yolo目标识别并进行目标类型判断,以得到障碍物识别数据,据以获取目标类型输出信息;

11.s5、利用n左右摄像头立体算法匹配处理所述障碍物识别数据,以获取目标深度y检测数据,基于n左摄像头目标x/z检测逻辑处理所述障碍物识别数据,以得到目标x/z检测数据,坐标转换所述目标深度y检测数据及所述目标x/z检测数据,以得到目标坐标输出信息,据以引导预置云台高清相机进行定向拍摄;

12.s6、处理所述目标类型输出信息及所述目标坐标输出信息,以得到目标状态信息、轮廓尺度信息、锚框尺度信息及障碍物坐标数据并上传至云服务端,据以结合预置激光雷达采集的激光导航数据引导机器人进行追踪及避障。

13.本发明通过多角度相全景固定相机模块对周围障碍物的无死角感知,并与激光导航一起,可实现在存在复杂障碍环境与移动障碍下的运动控制与避障,每一双目相机均具有人脸识别和目标定位等功能,使得机器人具有全景环境识别与定位、定向引导精准特征捕捉、障碍物移动环境下有效避障功能,多角度全景固定相机模块的识别与定位信息与激光导航模块搭配组合,实现智能巡检机器人的路径规划行走与避障,尤其是对较多移动障碍物环境中,完成有效的近距离运动行走与避障机器人具有整体结构简单、实用性强、智能程度高等优点。

14.在更具体的技术方案中,所述步骤s1中的多角度全景固定相机模块包括:不少于6个角度的双目相机,所述双目相机单元呈环形分布,各方向的所述双目相机与相邻所述双目相机的拍摄视野上具有预置重合区域。

15.本发明通过设置多角度相全景固定相机模块,由多个双目相机单元组成的全景固定相机模块,可对机器人周围环境信息进行无死角拍摄,相邻的双目相机的视野覆盖在相邻区域具有重合,保证了多角度全景固定相机模块对周围环境的无死角拍摄,对异常信息、障碍信息进行识别与定位,即周围出现障碍物或异常情况,可快速的捕捉,并在视频拼接与各相机单元位置标定下,对环境情况进行及时掌握。

16.在更具体的技术方案中,所述步骤s2中的所述实时视频分类数据库包括数目与所述多角度全景固定相机模块相适配的根目录文件夹,供分类存储各双目相机的所述各相机采集数据。

17.在更具体的技术方案中,所述步骤s3包括:

18.s31、从实时视频分类数据库中调取所述各相机采集数据;

19.s32、对调取的单目相机采集视频的左右相机做分帧处理,据以得到所述分帧图像数据,对所述分帧图像数据做定义,以得到分帧定义图像数据;

20.s33、对分帧定义图像数据做矫正和去噪处理,以得到图片处理数据。

21.在更具体的技术方案中,所述步骤s4包括:

22.s41、根据输入的0n编号左摄像头图片,利用yolov5网络模型进行轮廓识别,所述yolov5网络模型包括:输入端、backbone、nekc、prediction;

23.s42、反向更新自适应锚框,以识别目标物,据以取得适用锚框值,根据所述适用锚框值设定初始锚框;

24.s43、简化处理所述yolov5网络模型中(x,y,w,h)及置信度(c),据以粗识别障碍物;

25.s44、利用双目相机中的左相机图像识别判断目标障碍物,从高分辨率子网为第一阶段始,进行逐步阶段子网并行连接,以通过高分辨率表示估计关键点及关键模型,利用高分辨率网络hrnet构架识别移动目标;

26.s45、利用重复多尺度融合及feature map,使用3x3的卷积核,进行卷积,激活relu后,对不同尺度下目标进行尺度识别,以标定目标中心点,以最小外接矩形作为真实框标注采集图片中的目标物体,输出目标有/无状态数据的对应锚框尺度,据以作为目标轮廓尺度。

27.本发明通过多角度相全景固定相机模块中单个安装面的双目相机单元,可对拍摄视觉范围内的异常情况、障碍物进行特征识别与定位。通过视觉识别与定位方式,实现对该方向的角度、位置初步识别及障碍物的识别,通过该识别信息,通过云台控制系统可控制云台相机对异常情况进行快速准确地跟踪与识别判定。本发明对yolov5中(x,y,w,h)及置信度(c)进行简化处理,修改后输出维度为3x(5 1)=18,降低网络模型参数,减少对硬件处理配置依赖及识别时间周期。

28.本发明通过多角度相全景固定相机模块对周围异常情况的捕捉,本发明采用高分辨率网络(hrnet)构架,对识别过程中维护高分辨率表示,以识别移动目标,同时降低了识别缺失。尤其是发生异常情况下,如造成异常时存在多个人员,往多个方向逃散,多角度相全景固定相机模块可对多方向逃散人员的特征进行捕捉,不需要经过云台相机的移动即可实现其特征与逃跑方位的捕捉,便于后台采用天眼等系统对逃散人员继续追踪。

29.在更具体的技术方案中,所述步骤s43包括:

30.s431、搭建所述yolov5网络模型;

31.s432、基于pytorch框架使用adam优化器优化所述yolov5网络模型,以确定识别目标;

32.s433、根据实时训练场景制作采集图片样本库,根据采集图片样本库,利用下述损失函数训练所述yolov5网络模型:

[0033][0034][0035]

,其中,distance_c是最小外接矩形的对角线距离,distance_2是两个中心点的欧氏距离,i

ou

是预测框与真实框的交集和并集的比值,v是长宽相似比,w

gt

,h

gt

是真实框的宽和高,w

p

和h

p

则是预测框的宽和高。

[0036]

在更具体的技术方案中,所述步骤s44包括:

[0037]

s441、存储预置分类模型,将所述预置分类模型带入hrnet模型,将图片进行tensor的运算操作,并归一化所述图片;

[0038]

s442、将归一化的所述图片以下述逻辑带入所述hrnet模型:

[0039][0040]

本发明将分类的模型进行储存,再将分类模型带入到hrnet的网络当中,将图片进

行tensor的运算操作,接着调整图片参数,再通过transforms.normalize进行均值和标准差归一化一张图片,将归一化后的图片带入hrnet模型中,加快了模型的收敛速度。

[0041]

在更具体的技术方案中,所述步骤s45包括:

[0042]

s451、通过利用linear函数判断所述障碍物的形状,其中,所述linear函数包括:上层神经元个数in_features、本层神经元个数out_features、权重weight及偏置bias,

[0043]

s452、以所述上层神经元个数in_features及所述本层神经元个数out_features判断当前权重;

[0044]

s453、根据所述上层神经元个数in_features、所述本层神经元个数out_features、所述权重weight及所述偏置bias,以下述逻辑处理得网络输出形状数据:

[0045]

[n,*,in_features]*[out_features,in_features]

t

=[n,*,out_features]

[0046]

,其中,n,*,in_features为输入网络层形状、n为批量处理过程中每批数据的数量,“*”表示单个样本数据中间包含多维度,in_features为单个数据最后一个维度形状,

[0047]

s454、经所述网络层输出的形状为(n,*,out_features),取10帧图像,以每一帧的预测值为一个一维数组,通过argmax函数对运算结果进行以投票阈值判定受障碍物尺度大小及障碍状态,统计视频中每秒的障碍状态,据以判定障碍物。

[0048]

在更具体的技术方案中,所述步骤s5包括:

[0049]

s51、引用滑动窗口的目标检测算法检测获取目标x/z值;

[0050]

s52、基于当前相机的左右图像合成视差图,正向映射所述视差图,以得到目标深度y值;

[0051]

s54、坐标变换所述障碍物目标x/z值及所述目标深度y值以获取并整合目标障碍物坐标。

[0052]

本发明以视差方式识别目标轮廓位置与目标大小,输出包括目标轮廓深度距离与相对基准原点的水平中心坐标,以实现对云台移动控制单元、移动运动控制单元执行的引导,进而完成目标追踪、避障规划。

[0053]

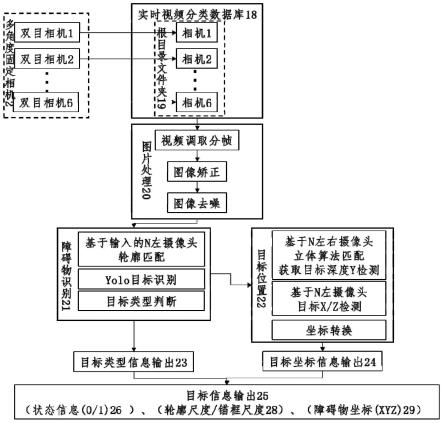

在更具体的技术方案中,一种智能巡检机器人全景追踪及避障系统包括:

[0054]

多角度全景固定相机模块,用以采集获取实时全景视频图像;

[0055]

实时视频分类数据库,用以分类所述实时全景视频图像中的各相机采集数据,将所述各相机采集数据存储于实时视频分类数据库,所述实时视频分类数据库与所述多角度全景固定相机模块连接;

[0056]

视觉控制模块,用以分帧调取所述各相机采集数据中的视频数据,以得到分帧图像数据,矫正并去噪处理所述分帧图像数据,以得到图片处理数据,所述视觉控制单元与所述实时视频分类数据库连接;

[0057]

障碍类型识别模块,用以利用输入的n左摄像头匹配逻辑对所述图片处理数据进行轮廓匹配,以得到轮廓匹配数据,对所述轮廓匹配数据进行yolo目标识别并进行目标类型判断,以得到障碍物识别数据,据以获取目标类型输出信息,所述障碍类型识别模块与所述视觉控制模块连接;

[0058]

坐标模块,利用n左右摄像头立体算法匹配处理所述障碍物识别数据,以获取目标深度y检测数据,基于n左摄像头目标x/z检测逻辑处理所述障碍物识别数据,以得到目标x/z检测数据,坐标转换所述目标深度y检测数据及所述目标x/z检测数据,以得到目标坐标输

出信息,据以引导预置云台高清相机进行定向拍摄,所述坐标模块与所述障碍类型识别模块连接;

[0059]

追踪避障模块,用以处理所述目标类型输出信息及所述目标坐标输出信息,以得到目标状态信息、轮廓尺度信息、锚框尺度信息及障碍物坐标数据并上传至云服务端,据以结合预置激光雷达采集的激光导航数据引导机器人进行追踪及避障,所述追踪避障模块与所述坐标模块连接。

[0060]

本发明相比现有技术具有以下优点:本发明通过多角度相全景固定相机模块对周围障碍物的无死角感知,并与激光导航一起,可实现在存在复杂障碍环境与移动障碍下的运动控制与避障,每一双目相机均具有人脸识别和目标定位等功能,使得机器人具有全景环境识别与定位、定向引导精准特征捕捉、障碍物移动环境下有效避障功能,多角度全景固定相机模块的识别与定位信息与激光导航模块搭配组合,实现智能巡检机器人的路径规划行走与避障,尤其是对较多移动障碍物环境中,完成有效的近距离运动行走与避障机器人具有整体结构简单、实用性强、智能程度高等优点。

[0061]

本发明通过设置多角度相全景固定相机模块,由多个双目相机单元组成的全景固定相机模块,可对机器人周围环境信息进行无死角拍摄,相邻的双目相机的视野覆盖在相邻区域具有重合,保证了多角度全景固定相机模块对周围环境的无死角拍摄,对异常信息、障碍信息进行识别与定位,即周围出现障碍物或异常情况,可快速的捕捉,并在视频拼接与各相机单元位置标定下,对环境情况进行及时掌握。

[0062]

本发明通过多角度相全景固定相机模块中单个安装面的双目相机单元,可对拍摄视觉范围内的异常情况、障碍物进行特征识别与定位。通过视觉识别与定位方式,实现对该方向的角度、位置初步识别及障碍物的识别,通过该识别信息,通过云台控制系统可控制云台相机对异常情况进行快速准确地跟踪与识别判定。本发明对yolov5中(x,y,w,h)及置信度(c)进行简化处理,修改后输出维度为3x(5 1)=18,降低网络模型参数,减少对硬件处理配置依赖及识别时间周期。

[0063]

本发明通过多角度相全景固定相机模块对周围异常情况的捕捉,本发明采用高分辨率网络(hrnet)构架,对识别过程中维护高分辨率表示,以识别移动目标,同时降低了识别缺失。尤其是发生异常情况下,如造成异常时存在多个人员,往多个方向逃散,多角度相全景固定相机模块可对多方向逃散人员的特征进行捕捉,不需要经过云台相机的移动即可实现其特征与逃跑方位的捕捉,便于后台采用天眼等系统对逃散人员继续追踪。

[0064]

本发明将分类的模型进行储存,再将分类模型带入到hrnet的网络当中,将图片进行tensor的运算操作,接着调整图片参数,再通过transforms.normalize进行均值和标准差归一化一张图片,将归一化后的图片带入hrnet模型中,加快了模型的收敛速度。

[0065]

本发明以视差方式识别目标轮廓位置与目标大小,输出包括目标轮廓深度距离与相对基准原点的水平中心坐标,以实现对云台移动控制单元、移动运动控制单元执行的引导,进而完成目标追踪、避障规划。本发明解决了现有技术中存在的障碍识别准确率低、多人员追踪困难、规避功能单一的技术问题。

附图说明

[0066]

图1为本发明实施例1的全景追踪及避障算法流程示意图;

[0067]

图2为本发明实施例1的多角度全景固定相机模块的组合视野范围示意图;

[0068]

图3为本发明实施例1的追踪及避障的原理图;

[0069]

图4为本发明实施例2的智能巡检机器人整体结构示例图。

具体实施方式

[0070]

为使本发明实施例的目的、技术方案和优点更加清楚,下面将结合本发明实施例,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有作出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0071]

实施例1

[0072]

如图1所示,本实施例提供一种智能巡检机器人全景追踪及避障方法:

[0073]

如图2所示,多角度全景固定相机模块2具有至少6个角度的双目相机单元9组成,呈环形分布,负责周圈各自排列方向的环境信息拍摄与定位识别,各方向的双目相机9与相邻的双目相机9在拍摄视野上具有重合,及每个双目相机9所对应的拍摄范围a、b、c、d、e、f均在视野相邻角度上具有重合,保障了在机器人本体3上,通过多角度全景固定相机模块2对机器人周围环境无死角拍摄与定位。

[0074]

所述的多角度全景固定相机2是多个双目相机9安装在不同角度的组合,以车体安装相机水平面位置的中心点为基准坐标原点16,对多个双目相机9模块建立组合坐标,每个相机9(取单摄像机左相机)相对基准坐标原点16位置存在水平两向(x0与y0)偏移值,进行对应坐标变换,单个双目相机9为左相机和右相机两个水平放置相机组成,通过三维测量视差原理,对双目相机前方目标进行拍摄识别其xyz坐标值。

[0075]

在本实施例中,多角度全景固定相机2采集信息经过视觉控制单元13进行图像分处理分析,其处理流程为:

[0076]

所述单个双目相机9依次与视觉控制单元13连接,采集视频信息在视觉控制单元13中的实时视频分类数据库18中存储,每个相机对应存储跟目录文件夹19,其命名对应,如单目相机9n对应根目录文件夹xxx-0n。

[0077]

在本实施例中,对存储视频信息进行调取(20),并对调取的单目相机采集视频的左右相机做分帧处理,分帧图片做xxx-0n-时间-左和做xxx-0n-时间-右命名定义。在本实施例中,对图片做矫正和去噪处理。

[0078]

在本实施例中,对完成图片处理的图片进行障碍物目标识别(21),以基于输入的0n编号左摄像头图片进行轮廓识别,基于yolov5网络模型,由输入端、backbone、nekc、prediction4个部分组成。对于目标物的识别,采用自适应锚框的反向更新,取得最佳锚框值(26),以适应不同尺度样本的窗口设定,设定初始锚框。对于内置分类器,本专利只针对有/无异物出现进行粗识别,即对yolov5中(x,y,w,h)及置信度(c)进行简化处理,修改后输出维度为3x(5 1)=18,降低网络模型参数,减少对硬件处理配置依赖及识别时间周期。

[0079]

如图3所示,在本实施例中,因相机采集图像具有重复性,因此选择双目相机(9)的单个摄像机(左相机)图像进行目标障碍物识别与判断,同时对具有移动目标识别,为降低识别缺失,以高分辨率网络(hrnet)构架,对识别过程中维护高分辨率表示。从高分辨率子网为第一阶段始,进行逐步阶段子网并行连接。通过高分辨率来表示估计关键点及关键模

型。对状态的判断,即有障碍(异物)/无障碍(异物),加入重复多尺度融合,通过feature map,使用3x3的卷积核,进行卷积,激活relu后,对不同尺度下目标进行尺度识别,标定目标中心点,输出目标有/无(0/1)级对应锚框尺度(26)作为目标轮廓尺度。

[0080]

在本实施例中,对图像识别后,具有目标识别出现障碍物(异物)情况图片,通过双目视差原理,对已经识别具有障碍物(异物)的图像,根据xxx-0n-时间-左和做xxx-0n-时间-右二者视差,完成目标障碍物深度信息y1的.同步以左相机平面图像,确定障碍物(异物)的x1、z1坐标,根据坐标变换,完成目标障碍物的坐标整合,即目标障碍物坐标(x,y,z)=(x0 x1,y0 y1,z0 z1)。

[0081]

在本实施例中,对于出现障碍物(异物)的图像,整合输出信息,包括状态信息1(27)、轮廓尺度(锚框尺度28)、障碍物(异物)坐标(x,y,z)(29)。对未出现障碍物(异物)图像,输出状态信息027,对此时该方位相机识别状态进行忽略。

[0082]

所示视觉控制单元13中的障碍目标识别,需进行模型的搭建与训练,通过对识别目标的确定,以运行环境中的人、车辆物体作为训练场景,制作采集图片样本库,利用labeling,对采集图片进行目标物体标注,标注时以最小外接矩形作为真实框。为降低处理周期,以人眼可识别到的尺度为下限,取20x20mm框为最小识别框,低于该框下,目标距离车体较远,待目标距离车体较近时,其目标框将处于设定限度内。

[0083]

所示视觉控制单元13的网络训练模型,其训练基于pytorch框架,使用adam优化器优化训练的网络模型。训练参数为1980x1080,总迭代张数≥5000张,网络深度为0.33,网络宽度为0.5,选用自动锚点。同时采用mosaic数据增强策略,初始学习率为0.01。网络模型的采用yolov5,考虑其存在的总损失函数为:类损失 位置损失 置信度损失。本损失函数以位置损失为主,采用以下公式评判:

[0084][0085][0086]

其中:distance_c是最小外接矩形的对角线距离;而distance_2则是两个中心点的欧氏距离;i

ou

是预测框与真实框的交集和并集的比值;v是长宽相似比;w

gt

,h

gt

是真实框的宽和高;而w

p

和h

p

则是预测框的宽和高。

[0087]

将调取的对应根目录内分帧处理过的xxx-0n-时间-左图片,图片输入的结构特征图为1980x1080px。将分类的模型进行储存,再将分类模型带入到hrnet的网络当中,将图片进行tensor的运算操作,接着将图片的大小除255,将0-255的图片改到0-1,再通过transforms.normalize进行均值和标准差归一化一张图片,将归一化后的图片带入hrnet模型中,使模型的收敛速度加快。得到较小mean和std,公式如下所示:

[0088][0089]

通过使用linear函数进行判断,linear函数包含四个属性:上层神经元个数(in_features)、本层神经元个数(out_features)、权重(weight)以及偏置(bias)。通过前两个来判断此时的权重。将上述四个属性带入其中,就可以得到一个公式,包含以下几点:输入

该网络层的形状(n,*,in_features);其中n为批量处理过成中每批数据的数量;“*”表示单个样本数据中间可以包含很多维度,但是单个数据的最后一个维度的形状一定是(in_features);经过该网络输出的形状为(n,*,out_features),运算的公式如下所示:

[0090]

[n,*,in_features]*[out_features,in_features]

t

=[n,*,out_features]

[0091]

因为状态判断的只有正常(normal)以及障碍(foreign)两种,采用out_features为2。取10帧图,每一张的预测值为一个一维数组,通过argmax函数对运算结果进行判断,以投票方式判定,受障碍物尺度大小,预若投票数大于4,判断该秒的状态为foreign,反之则为正常。最后将视频中的每一秒得出的结果进行统计,正常数大于等于障碍物数就判断此时为正常,反之则为障碍物。

[0092]

针对搭建的模型进行训练学习,经过≥500轮迭代,约5000张图片,在损失函数经过快速下降到损失值变化缓慢平稳,模型达到稳定状态,将训练模型由训练集转入测试集进行测试使用,开始对内设的人物、异物进行多个镜头采集图像的判别。

[0093]

针对目标的坐标识别,因已对图像内是否有目标物进行了判断,因此对其内部平面目标的x/z值,通过引用滑动窗口的目标检测算法,完成目标的x/z值,而对于深度信息,以基于当前相机的左右图像,以视差图合成,正向映射方式,完成对深度y值处理。

[0094]

最终对出现障碍图像,完成对目标信息的处理,最终输出状态信息1(27)、轮廓尺度(锚框尺度28)、障碍物(异物)坐标(x,y,z)(29)。

[0095]

所述的云台高清相机模块1安装在多角度全景固定相机模块2上方,其云台是包含水平驱动电机和上下角度调整电机,分别驱动可完成水平360

°

旋转和上下角度调整移动。多角度全景固定相机模块2对异常情况的识别与定位,引导云台高清相机1的云台移动位置及角度。

[0096]

所述的激光导航模块5与多角度全景固定相机模块2共同组成了机器人的导航定位及避障硬件。

[0097]

在本实施例中,所述的移动车体4为四轮独立驱动车体,通过车轮17驱动差速方式,实现移动车体4的水平移动、转向、水平位置角度调整。

[0098]

所述智能巡检机器人全景追踪及避障的方法及系统的端控制模块12包括视觉控制单元13、云台移动控制单元14、移动运动控制单元15,实现多角度全景固定相机模块2视频信息处理、障碍识别与定位、车体的移动控制、云台的运动控制,并通过收发模块6将机器人运动信息、位置信息、环境感知的视频信息、异常信息等上传至云服务端。

[0099]

所述的视觉控制单元13具有多路视频输入通道,分别对应多个双目相机9视频图像输入,单个双目相机9占用2个相邻输入通道,对每路视频图像进行实时分帧处理,其中单个双目相机9具有由1-6的对应编号,其采集信息首先进入视觉控制单元13的实时视频分类数据库18对应的根目录文件夹19中,如双目相机1,其采集信息进入根目录文件夹19编号为01文件夹,以此对没路双目采集信息进行分类。其次对每路存入信息进行依次调取,经图片处理20流程,进行障碍物识别21,实现对障碍物目标类型的识别判读,并进而输出目标类型信息23,对发现有障碍物出现的图片,经过目标位置22处理,以双目相机立体算法进行目标的匹配,获取目标相对单个采集双目相机9的坐标信息x/y/z值,通过该双目相机9相对车体坐标进行坐标转换,输出目标坐标信息24,最后通过信息整合,输出目标信息25以引导云台移动控制单元14、移动运动控制单元15执行对应目标追踪、避障规划。

[0100]

所述智能巡检机器人全景追踪及避障的方法及系统的端控制模块12中,由多角度全景固定相机模块2中的相机单元9获取的视频信息均通过视觉控制单元13进行实时处理,进行异常情况的特征识别与位置识别,并将该异常所在的角度范围与位置发送至云台移动控制单元13,对云台相机的水平角度与上下角度进行调节,以便对异常情况进行精准拍摄;

[0101]

在本实施例中,所述智能巡检机器人全景追踪及避障的方法及系统,由多角度全景固定相机模块2中的相机单元9获取的视频信息均通过视觉控制单元13进行实时处理,进行附近障碍物的特征识别与位置识别,将障碍信息所在的角度与位置,由激光雷达5对雷达前方进行激光扫描,判定是否存在障碍物以及障碍物的距离,激光雷达5感知的环境信息与视觉控制单元13处理的障碍物位置和距离信息一起发送至移动运动控制单元14,对移动车体4的运动路进行调整规划,实现对障碍物的实时有效避障。

[0102]

在本实施例中,所述智能巡检机器人全景追踪及避障的方法及系统还包括无线充电单元10,设置在在车体底部,对机器人的补电方式为通过在固定位置设置的地下无线充电桩,对机器人进行低电补电。

[0103]

实施例2

[0104]

如图4所示,一种智能巡检机器人全景追踪及避障系统包括自上而下依次设置安装的云台高清相机模块1、多角度全景固定相机模块2、机器人本体3、移动车体4,并在移动车体上安装有激光导航模块5、收发模块6、端控制模块12、供电模块11,其中端控制模块12与供电模块11均置于移动车体4内部。

[0105]

在本实施例中,所述的云台高清相机模块安装在多角度全景固定相机模块上方,其云台是包含水平驱动电机和上下角度调整电机,分别驱动可完成水平360

°

旋转和上下角度调整移动。多角度全景固定相机模块对异常情况的识别与定位,引导云台的移动位置及角度。

[0106]

在本实施例中,所述的激光导航模块与多角度全景固定相机模块共同组成了机器人的导航定位及避障硬件系统。

[0107]

在本实施例中,所述的移动车体为四轮独立驱动车体,通过车轮驱动差速方式,实现车体的水平移动、转向、水平位置角度调整。

[0108]

在本实施例中,所述智能巡检机器人全景追踪及避障的方法及系统的端控制模块包括视觉控制单元、云台移动控制单元、移动运动控制单元,实现多角度全景固定相机模块视频信息的拼接、异常识别与定位、车体的移动控制、云台的运动控制,并通过收发模块将机器人运动信息、位置信息、环境感知的视频信息、异常信息等上传至云服务端。

[0109]

在本实施例中,视觉控制单元具有多路视频输入通道,分别对应多个双目相机视频图像输入,单个双目相机占用2个相邻输入通道,对每路视频图像进行实时分帧处理,其中单个双目相机采用视差原理,对拍摄出现障碍物的轮廓进行目标轮廓识别,以视差方式识别目标轮廓位置与目标大小,输出包括目标轮廓深度距离与相对基准原点的水平中心坐标,以引导云台移动控制单元、移动运动控制单元执行对应目标追踪、避障规划。

[0110]

在本实施例中,所述智能巡检机器人全景追踪及避障的方法及系统端控制模块中,由多角度全景固定相机模块中的相机单元获取的视频信息均通过视觉控制单元进行实时处理,进行异常情况的特征识别与位置识别,并将该异常所在的角度范围与位置发送至云台移动控制单元,对云台相机的水平角度与上下角度进行调节,以便对异常情况进行精

准拍摄;

[0111]

在本实施例中,所述的智能巡检机器人全景追踪及避障的方法及系统,由多角度全景固定相机模块中的相机单元获取的视频信息均通过视觉控制单元进行实时处理,进行附近障碍物的特征识别与位置识别,将障碍信息所在的角度与位置,由激光雷达对雷达前方进行激光扫描,判定是否存在障碍物以及障碍物的距离,激光雷达感知的环境信息与视觉控制单元处理的障碍物位置和距离信息一起发送至移动运动控制单元,对移动车体的运动路进行调整规划,实现对障碍物的实时有效避障。

[0112]

在本实施例中,所述的智能巡检机器人全景追踪及避障的方法及系统还包括无线或有线充电单元,其中无线方式下在车体底部设置感应无线充电单元,对机器人的补电方式为通过在固定位置设置的地下无线充电桩,对机器人进行低电补电;对有限充电方式,机器人在移动车体侧方设置充电刷版,通过在固定位置设置的地面充电桩,对机器人进行低电补电。

[0113]

综上,本发明通过多角度相全景固定相机模块对周围障碍物的无死角感知,并与激光导航一起,可实现在存在复杂障碍环境与移动障碍下的运动控制与避障,每一双目相机均具有人脸识别和目标定位等功能,使得机器人具有全景环境识别与定位、定向引导精准特征捕捉、障碍物移动环境下有效避障功能,多角度全景固定相机模块的识别与定位信息与激光导航模块搭配组合,实现智能巡检机器人的路径规划行走与避障,尤其是对较多移动障碍物环境中,完成有效的近距离运动行走与避障机器人具有整体结构简单、实用性强、智能程度高等优点。

[0114]

本发明通过设置多角度相全景固定相机模块,由多个双目相机单元组成的全景固定相机模块,可对机器人周围环境信息进行无死角拍摄,相邻的双目相机的视野覆盖在相邻区域具有重合,保证了多角度全景固定相机模块对周围环境的无死角拍摄,对异常信息、障碍信息进行识别与定位,即周围出现障碍物或异常情况,可快速的捕捉,并在视频拼接与各相机单元位置标定下,对环境情况进行及时掌握。

[0115]

本发明通过多角度相全景固定相机模块中单个安装面的双目相机单元,可对拍摄视觉范围内的异常情况、障碍物进行特征识别与定位。通过视觉识别与定位方式,实现对该方向的角度、位置初步识别及障碍物的识别,通过该识别信息,通过云台控制系统可控制云台相机对异常情况进行快速准确地跟踪与识别判定。本发明对yolov5中(x,y,w,h)及置信度(c)进行简化处理,修改后输出维度为3x(5 1)=18,降低网络模型参数,减少对硬件处理配置依赖及识别时间周期。

[0116]

本发明通过多角度相全景固定相机模块对周围异常情况的捕捉,本发明采用高分辨率网络(hrnet)构架,对识别过程中维护高分辨率表示,以识别移动目标,同时降低了识别缺失。尤其是发生异常情况下,如造成异常时存在多个人员,往多个方向逃散,多角度相全景固定相机模块可对多方向逃散人员的特征进行捕捉,不需要经过云台相机的移动即可实现其特征与逃跑方位的捕捉,便于后台采用天眼等系统对逃散人员继续追踪。

[0117]

本发明将分类的模型进行储存,再将分类模型带入到hrnet的网络当中,将图片进行tensor的运算操作,接着调整图片参数,再通过transforms.normalize进行均值和标准差归一化一张图片,将归一化后的图片带入hrnet模型中,加快了模型的收敛速度。

[0118]

本发明以视差方式识别目标轮廓位置与目标大小,输出包括目标轮廓深度距离与

相对基准原点的水平中心坐标,以实现对云台移动控制单元、移动运动控制单元执行的引导,进而完成目标追踪、避障规划。本发明解决了现有技术中存在的障碍识别准确率低、多人员追踪困难、规避功能单一的技术问题。

[0119]

以上实施例仅用以说明本发明的技术方案,而非对其限制;尽管参照前述实施例对本发明进行了详细的说明,本领域的普通技术人员应当理解:其依然可以对前述各实施例所记载的技术方案进行修改,或者对其中部分技术特征进行等同替换;而这些修改或者替换,并不使相应技术方案的本质脱离本发明各实施例技术方案的精神和范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。