轨迹,加入重放缓冲区中;

18.步骤3:基于生成性对抗模仿学习通过占用度量匹配更新鉴别器

19.利用下式在专家演示区和重放缓冲区采样,得到在专家演示 区采样,得到(s

t

,a

t

)

e

;在重放缓冲区采样,得到(s

t

,a

t

)

r

;

[0020][0021]

生成性对抗模仿学习是通过占用度量匹配来学习参数化策略的一种方法,生成性 对抗模仿学习包括鉴别器和生成器,生成器产生一系列状态

‑

动作对,在步骤4中产生, 鉴别器d(s

t

,a

t

)是一个二进制分类器,试图区分状态

‑

动作对是来自专家还是来自经过 训练的策略。鉴别器参数可以通过下式更新:

[0022][0023]

其中h(π

β

)是熵正则项;

[0024]

步骤4:通过深度确定性策略梯度获得目标策略

[0025]

演员网络π

β

(s

t

)的目的是学习使动作价值函数最大的策略,用参数β控制;批评家 网络q

α

(s

t

,a

t

)的目的是评估当前状态下动作的价值,从而指导演员采取最佳行动,由 参数α控制;二者相互促进,最终获得目标策略;为了使学习过程稳定,采用参数分 别为α

′

和β

′

的批评家网络和演员网络作为目标网络;

[0026]

1)批评家网络参数更新

[0027]

通过最小化损失函数来更新批评家网络q

α

(s

t

,a

t

);批评家网络的损失函数为

[0028][0029]

其中,q

α

(s

t

,a

t

)为预测的动作价值函数,y为时间差分目标;y可由目标网络计算;

[0030]

y=r

t

γq

α

′

(s

t 1

,π

β

′

(s

t 1

))

[0031][0032]

γ是一个预定义的折扣因子,奖励r

t

由鉴别器奖励和额外的后 见之明奖励构成,k1和k2为其对应系数;

[0033]

因此可用下式更新批评家网络和目标网络:

[0034][0035]

α

′

=τα (1

‑

τ)α

′

[0036]

2)演员网络参数更新

[0037]

类似于批评家网络,演员网络π

β

(s

t

)也通过最小化损失函数来更新;演员网络的 损失函数为

[0038]

[0039]

其中,是用于加速学习的退火奖励;

[0040]

因此可用下式更新演员网络和目标网络:

[0041][0042]

β

′

=τβ (1

‑

τ)β

′

[0043]

获得期望结果通常需重复执行一定次数,需要重新采样并扩充重放缓冲区进行进 一步循环;循环若干次之后演员网络π

β

(s

t

)所代表的策略即为最终所得目标策略。

[0044]

所述的奖励函数r

t

设置为ζ为参数。

[0045]

所述的专家演示采用直接接触并引导、通过操纵杆引导或手工设计。

[0046]

有益效果

[0047]

本发明提出的一种超越专家演示的阻抗控制模仿学习训练方法,首先通过直接接 触并引导、通过操纵杆引导或手工设计等任意方式收集专家演示轨迹,放入专家演示 区;将专家演示轨迹和之后用策略重新采样得到的轨迹放入重放缓冲区;通过事后经 验重放,将演示数据的成功率提高;通过生成性对抗模仿学习,将训练出的策略和演 示数据之间的误差逐步缩小,最终得到期望的训练策略。有益效果如下:

[0048]

1、相对于参数不变的阻抗控制方式,通过根据不同任务阶段和环境约束调整阻抗 参数的变阻抗控制方法,提升了交互的安全性和稳定性;

[0049]

2、相对于其他基于训练的变阻抗控制,通过模仿学习方法,训练阻抗参数的训练 效率更高,更接近于人的行为,且不受设计者个人经验影响;

[0050]

3、通过事后经验重放的方法,在重放缓冲区提升了用来进行训练的演示的成功率, 进而使最终训练出的策略成功率提升,甚至达到可以超过专家演示的水平;

[0051]

4、通过生成性对抗模仿学习,减少演示数据和生成策略间的误差,使最终训练出 的策略成功率进一步提升。

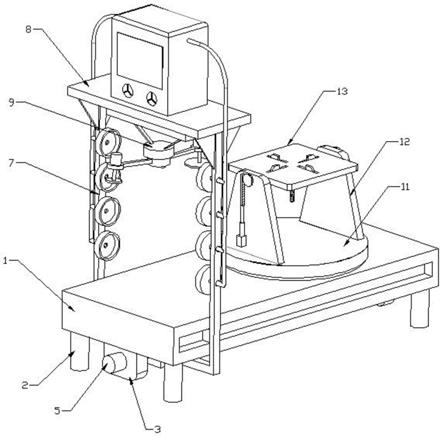

具体实施方式

[0052]

为了使本发明的目的、技术方案及优点更加清楚明白,以下结合实施例,对本发 明进行进一步详细说明。应当理解,此处所描述的具体实施例仅用以解释本发明,并 不用于限定本发明。此外,下面描述的本发明各个实施方式中所涉及到的技术特征只 要彼此之间未构成冲突就可以相互组合。

[0053]

本发明提出的一种超越专家演示的阻抗控制模仿学习训练方法,包括如下四个部 分:

[0054]

1、收集专家演示轨迹;

[0055]

2、建立重放缓冲区;

[0056]

3、基于生成性对抗模仿学习通过占用度量匹配更新鉴别器;

[0057]

4、通过深度确定性策略梯度获得目标策略。

[0058]

具体步骤如下:

[0059]

步骤一、收集专家演示轨迹

[0060]

阻抗控制模型表达式为

[0061][0062]

其中,e=x

‑

x0,x为实际位置,x0为初始位置,e、和分别为末端执行器的 位移、速度和加速度,m、b和k分别为惯性矩阵、阻尼矩阵和刚度矩阵,f为实际接 触力。

[0063]

定义s

t

为当前状态,即当前跟踪位置误差e

t

,速度跟踪误差和接触力f

t

,a

t

为当 前动作,即阻抗参数m,b,k的值。奖励函数r

t

可根据任务进行设置,如设置为可根据任务进行设置,如设置为

[0064]

将(s

t

,a

t

,r

t

,s

t 1

)定义为演示轨迹的一个点,专家演示轨迹即为若干个点组成的一 串连续轨迹。进行训练之前需要收集尽量多的专家演示轨迹。专家演示可以采用直接 接触并引导、通过操纵杆引导或手工设计等多种方式,且不要求演示具有较高成功率。

[0065]

步骤二、建立重放缓冲区

[0066]

将步骤一所获得的所有专家演示轨迹归入专家演示区e。建立重放缓冲区r,同样 将专家演示轨迹归入,即此时专家演示区与重放缓冲区相同。

[0067]

对于多目标设置,期望状态由目标g∈g描述,不同的轨迹可以有不同的目标,并 且每个目标对应一个声明f

g

,用来代表目标是否已经实现。所训练智能体的真正目标 即达到状态s

t 1

,使得f

g

(s

t 1

)=1。

[0068]

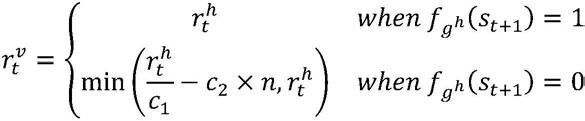

从目标集合g中采样目标g,并在目标为g的情况下应用当前策略π,获得若干采样 轨迹,加入重放缓冲区中。

[0069]

步骤三、基于生成性对抗模仿学习通过占用度量匹配更新鉴别器

[0070]

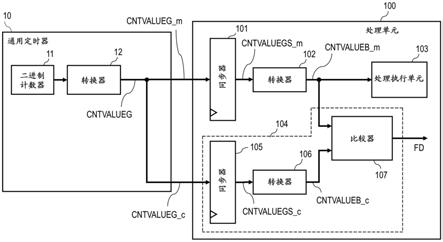

为了使最终得到的策略可以优于专家演示,需要提供额外的奖励函数。此处使用 事后经验重放,通过假设实际达到的状态为真实目标,将失败轨迹变为可用的成功轨 迹,进而提高演示的利用率。另外,此处对奖励值进行了设计,使得训练初期即使没 有完成任务也可以获得一定的奖励,进而鼓励策略进行广泛的探索。

[0071][0072]

利用上式在专家演示区和重放缓冲区采样,得到在专家演示 区采样,得到(s

t

,a

t

)

e

;在重放缓冲区采样,得到(s

t

,a

t

)

r

。

[0073]

生成性对抗模仿学习是通过占用度量匹配来学习参数化策略的一种方法。生成性 对抗模仿学习包括鉴别器和生成器,生成器产生一系列状态

‑

动作对,在步骤四中产生, 鉴别器d(s

t

,a

t

)是一个二进制分类器,试图区分状态

‑

动作对是来自专家还是来自经过 训练的策略。鉴别器参数可以通过下式更新:

[0074][0075]

其中h(π

β

)是熵正则项。基于生成性对抗模仿学习通过占用度量匹配更新鉴别器。

[0076]

为了使最终得到的策略可以优于专家演示,需要提供额外的奖励函数。此处使用 事后经验重放,通过假设实际达到的状态为真实目标,将失败轨迹变为可用的成功轨 迹,进而提高演示的利用率。另外,此处对奖励值进行了设计,使得训练初期即使没 有完成任

务也可以获得一定的奖励,进而鼓励策略进行广泛的探索。

[0077][0078]

利用上式在专家演示区和重放缓冲区采样,得到在专家演示 区采样,得到(s

t

,a

t

)

e

;在重放缓冲区采样,得到(s

t

,a

t

)

r

。

[0079]

生成性对抗模仿学习是通过占用度量匹配来学习参数化策略的一种方法。生成性 对抗模仿学习包括鉴别器和生成器,生成器产生一系列状态

‑

动作对,在步骤四中产生, 鉴别器d

μ

(s

t

,a

t

)是一个二进制分类器,试图区分状态

‑

动作对是来自专家还是来自经过 训练的策略。鉴别器参数可以通过下式更新:

[0080][0081]

其中h(π

β

)是熵正则项。取期望值。

[0082]

步骤四、通过深度确定性策略梯度获得目标策略

[0083]

深度确定性策略梯度是一种演员

‑

批评家方法。演员网络π

β

(s

t

)的目的是学习使动 作价值函数最大的策略,用参数β控制。批评家网络q

α

(s

t

,a

t

)的目的是评估当前状态 下动作的价值,从而指导演员采取最佳行动,由参数α控制。二者相互促进,最终获 得目标策略。为了使学习过程稳定,采用参数分别为α

′

和β

′

的批评家网络和演员网络 作为目标网络。

[0084]

1)批评家网络参数更新

[0085]

通过最小化损失函数来更新批评家网络q

α

(s

t

,a

t

)。批评家网络的损失函数为

[0086][0087]

其中,q

α

(s

t

,a

t

)为预测的动作价值函数,y为时间差分目标。y可由目标网络计算。

[0088]

y=r

t

γq

α

′

(s

t 1

,π

β

′

(s

t 1

))

[0089][0090]

γ是一个预定义的折扣因子,奖励r

t

由鉴别器奖励和额外的后 见之明奖励构成,k1和k2为其对应系数。

[0091]

因此可用下式更新批评家网络和目标网络:

[0092][0093]

α

′

=τα (1

‑

τ)α

′

[0094]

2)演员网络参数更新

[0095]

类似于批评家网络,演员网络π

β

(s

t

)也通过最小化损失函数来更新。演员网络的 损失函数为

[0096]

[0097]

其中,是用于加速学习的退火奖励。

[0098]

因此可用下式更新演员网络和目标网络:

[0099][0100]

β

′

=τβ (1

‑

τ)β

′

[0101]

获得期望结果通常需重复执行一定次数,需要重新采样并扩充重放缓冲区进行进 一步循环。循环若干次之后演员网络π

β

(s

t

)所代表的策略即为最终所得目标策略。

[0102]

以上所述,仅为本发明的具体实施方式,但本发明的保护范围并不局限于此,任 何熟悉本技术领域的技术人员在本发明公开的技术范围内,可轻易想到各种等效的修 改或替换,这些修改或替换都应涵盖在本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。