1.本发明涉及一种人群计数方法,具体涉及一种极度条件下的视听联合人群计数方法。

背景技术:

2.尽管基于视觉的人群计数方法非常成功,但是目前可能无法在极端条件下捕获信息特征,例如在夜间或遮挡下成像。基于卷积神经网络的人群计数方法已经取得了重大进展,但传统的单张图像计数存在两个问题:1)目标遮挡导致了人群估计的丢失;2)简单的基于rgb传感器的方法容易受到光强度,物体遮挡,可见度等的影响,为解决第一个问题,一些研究人员提出了多视角方法对人数进行计数,但是,在现实世界中同时携带多台具有特定参数和摄像机标定的摄像机并不容易;关于第二个问题,尽管一些文献试图通过引入深度信息来解决它,但是同时解决上述两个问题是不可行的。

3.联合视听学习有望从视觉和听觉的方式上同时学习学习模型的优点,早期的视听研究主要集中在语音识别,由于视觉信息被认为没有音频噪声,并且可以在嘈杂的条件下提供补充信息,所以通常可以通过联合建模面部/嘴巴动作的图像信号和相应的音频信号来实现一定的提升,在其他的识别任务中也可以发现类似的现象,例如情感识别和手势识别;最近,视听学习已经被进一步用于分析更一般的情况,有研究提议从音频模态中学到的迁移知识,以监督视觉识别模型的训练,如何将音频模态的优点应用到人群计数中的问题尤为重要。

技术实现要素:

4.本发明引入了视听人群计数的一项新任务,其中的方法整合了视觉和听觉信息,用于计数目的,旨在解决现有的极度条件下的人群计数的问题,并提出可行的实现方法。具体技术方案如下:本发明提供一种极度条件下的视听联合人群计数方法,包括步骤:s100,提取视觉特征,在给定的rgb图像上提取得到所述视觉特征vfeat;s200,提取音频特性,在给定的原始音频信号进行采样,然后进行短时傅立叶变换(stft),以生成视频图,再应用mel滤波器提取音频特征 ;s300,融合视听特征,基于提取的所述音频特征和所述视觉特性两个特征方向参数γ和β以分别在乘法和加法方面对这种交叉模态产生建模,公式如下所示:,其中表示个特征融合块,定义了第个空洞卷积层,和分别是激活函数和逐元素相乘。

5.进一步地,包括步骤:在融合视听特征,基于提取的所述音频特征和所述视觉特性两个特征方向参数γ和β以分别在乘法和加法方面对这种交叉模态产生建模时,还包括步骤:

我们使用全连接层通过以下两个方程式来学习和::在这两个方程中,表示平均池化,而。

6.进一步地,还包括步骤:s400,给定真实人群密度图y∈r

w

×

h

和预测密度图选择l2范数作为损失函 数,通过以下等式计算损失:

7.进一步地,在提取音频特性时,还包括:给定原始音频信号a

raw

={a1,a2,...,a

t

},先对a

raw

进行16khz的采样,后以hann窗口 进行短时傅立叶变换,以生成98

×

257视频图。

8.本发明的有益效果是:本发明通过联合视听学习从视觉和听觉的方式上结合学习模型的优点应用到人群计数中,为了使得人群计数从环境声音中受益,本发明设计了一种新颖的audiovisual counting(avc)网络,该网络由三个模块组成:视觉特征提取、音频特征提取和视听特征融合;与仅采用视觉信息的传统方法相比,本发明的网络具有第二和第三模块的特征;在低质量图像(例如低分辨率,低照度和强噪声)的情况下,通过听觉感知场景的网络也能够估计人数,从而计算得到的人数更加准确。

附图说明

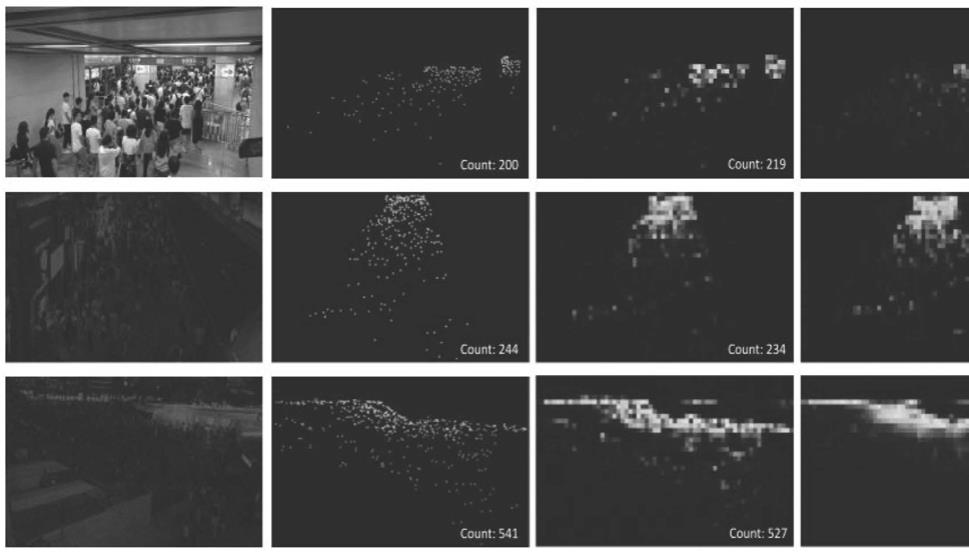

9.图1为本发明一种极度条件下的视听联合人群计数方法效果示意图。

具体实施方式

10.下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例;基于本发明中的实施例,本领域普通技术人员在没有作出创造性劳动前提下所获得的所有其它实施例,都属于本发明保护的范围。

11.参见附图1,将拍摄得到的图像

‑

音频对输入到本发明设计的audiocsrnet网络中,输出预测的密度图,在图1的第二列是真实的人群密度图,在第三列是由发明的方法得到的密度图和最终的人群数,最右侧是通过csrnet方法得到的人群密度图,可以看到本发明的方法在这种极度条件下(比如低光照)能够获得更好的性能。

12.本发明提供一种极度条件下的视听联合人群计数方法,包括步骤:s100,提取视觉特征,在给定的rgb图像上提取得到所述视觉特征vfeat;s200,提取音频特性,在给定的原始音频信号进行采样,然后进行短时傅立叶变换(stft),以生成视频图,再应用mel滤波器提取音频特征;

s300,融合视听特征,基于提取的所述音频特征和所述视觉特性两个特征方向参数γ和β以分别在乘法和加法方面对这种交叉模态产生建模,公式如下所示:,其中表示个特征融合块,定义了第个空洞卷积层,和分别是激活函数和逐元素相乘。

13.在本实施例中,为了使得人群计数从环境声音中受益,本发明设计了一种新颖的audiovisual counting(avc)网络,该网络由三个模块组成:第一模块,视觉特征提取;第二模块,音频特征提取;第三模块,视听特征融合。值得注意的是,与仅采用视觉信息的传统方法相比,本发明的网络具有第二和第三模块的特征;如前所述,本发明的动机之一是在低质量图像(例如低分辨率,低照度和强噪声)的情况下,仅凭视觉信息很难精确地计算人数,相比之下,在本发明的方法中,即使人员看不清晰,网络也能够估计人数,原因是我们能够通过听觉感知场景。为了模仿人的这种能力,在传统的计数框架中引入了音频模块,从而建立了audiovisual counting(avc)模型。

14.对于视觉特征提取,类似于csrnet [5],我们采用vgg16 [6]的前十层作为后端cnn来提取视觉特征。给定具有w

×

h空间大小的rgb图像,可以使用以下公式提取视觉特征vfeat:其中,c表示通道数。

[0015]

对于音频特征提取,给定原始音频信号,首先对进行16khz的采样,然后以hann窗口(窗口大小为400,跳长为160)进行短时傅立叶变换(stft),以生成98

×

257时频图。之后,应用mel滤波器,然后可以为每个原始音频信号获得96

×

64的表示形式。最后,利用类似于vgg的深度卷积神经网络[10]提取音频特征,如下所示:式中并且c = 512。

[0016]

优选的,包括步骤:在融合视听特征,基于提取的所述音频特征和所述视觉特性两个特征方向参数γ和β以分别在乘法和加法方面对这种交叉模态产生建模时,还包括步骤:我们使用全连接层通过以下两个方程式来学习和::在这两个方程中,表示平均池化,而。

[0017]

在本实施例中,对于视听特征融合,为了在人群计数中有效融合音频和视觉信息,本发明引入了一个新颖的融合模块,旨在通过转换后的音频能够自适应地调整视觉特征响应。具体地,基于提取的音频特征,学习两个特征方向参数γ和β以分别在乘法和加法方面对这种交叉模态产生建模。公式如下所示:

其中表示个特征融合块,定义了第个空洞卷积层。和分别是激活函数和逐元素相乘。显然,的范围是0到6,并且 = 。

[0018]

优选的,还包括步骤:s400,给定真实人群密度图y∈r

w

×

h

和预测密度图选择l2范数作为损失 函数,通过以下等式计算损失:

[0019]

优选的,在提取音频特性时,还包括:给定原始音频信号a

raw

={a1,a2,...,a

t

},先对a

raw

进行16khz的采样,后以hann窗口 进行短时傅立叶变换,以生成98

×

257视频图。

[0020]

以上显示和描述了本发明的基本原理、主要特征和本发明的优点。本行业的技术人员应该了解,本发明不受上述实施例的限制,上述实施例和说明书中描述的只是说明本发明的原理,在不脱离本发明精神和范围的前提下,本发明还会有各种变化和改进,这些变化和改进都落入要求保护的本发明范围内。本发明要求保护范围由所附的权利要求书及其等效物界定。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。