1.本发明属于机器人智能控制技术领域,涉及一种基于深度学习的刚软仿人手自主抓取方法。

背景技术:

2.作为机器人的末端执行器,灵巧手具有高自由度、控制复杂的特点.随着作业任务的精细化程度越来越高,对灵巧手的要求随之提高,实现灵巧手稳定可靠的抓取是机器人领域的主要挑战。与二指夹持器相比,欠驱动灵巧手具有较好抓取性能和一定的操作性能。与全驱动灵巧手相比,欠驱动灵巧手的驱动单元数目小于自由度,这使它只需简单的控制方法就能抓取形状各异的物体。欠驱动手易于实现强力抓取,但在建模分析、精确捏取和操作等问题上存在着许多研究难点。

3.数据驱动的机器学习方法在机器人抓取方向非常流行,并取得了积极的成果。相关技术人员制作物体抓取模式的rgb-d数据集,通过深度网络直接建立从物品图像到四种重要抓取模式的映射,实现假肢灵巧手对各种日常物品的“伸手捡拾”任务。不过其中物体的抓取定位是由人来进行判断的。相关方案使用物体抓取场景的rgb图像作为输入,通过训练深度神经网络来预测九种人类抓取的动作原语,利用触觉传感器完成机械臂和五指软体手的接近定位和抓取。相关技术针对24自由度的shadow灵巧手,利用视觉获取完整物体的三维模型,使用graspit!生成训练集,其中抓取物体包含多个可能的抓取姿态,并通过神经网络训练得到最优的抓取姿态该方法依赖于物体模型,抓取泛化能力有待提高。

4.由此可见,相关技术中存在的问题是:相关技术中技术方案无法实现抓取模式预测和抓取位姿估计。

技术实现要素:

5.本发明解决的问题是:相关技术中技术方案无法实现抓取模式预测和抓取位姿估计。

6.为解决上述问题,本发明采用的技术方案为:

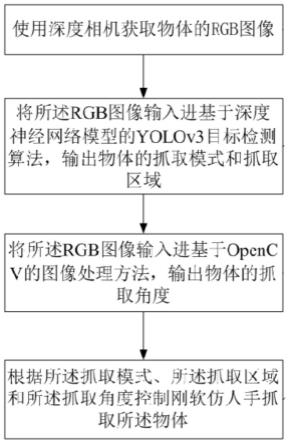

7.一种基于深度学习的刚软仿人手自主抓取方法,所述方法基于深度学习方法与欠驱动自适应抓取的互补性,利用深度学习网络学习不同物体抓取模式的分类,并通过物体检测和图像处理,识别了物体抓取模式、抓取区域和抓取角度,简化了仿人手的抓取规划与控制;所述方法基于获取模块、第一控制模块、第二控制模块、抓取模块实现,具体包括以下步骤。

8.第一步,使用深度相机获取物体的rgb图像,并对模型进行训练具体的:

9.1.1)获取模块用于使用深度相机获取物体的rgb图像,建立数据集;数据集的建立能够对yolov3目标检测算法进行有效地训练,使其能够满足识别物体抓取模式需求。

10.1.2)将数据集分为测试集和训练集,训练集用于训练yolov3目标检测算法识别抓取模式,测试集用于有效检测yolov3目标检测算法的训练成果。通过第一控制模块将rgb图

像输入进基于深度神经网络模型的yolov3目标检测算法,输出物体的抓取模式和抓取区域。

11.所述的步骤1.2)训练集训练yolov3目标检测算法识别抓取模式的具体过程为;

12.人手抓取模式丰富多样,主要可以分为强力抓取和精确抓取两大类,强力抓取是指在抓取过程中手指与手掌共同形成包络物体的形态,包括球形抓握、圆柱抓握和钩形抓握,抓取较为稳固。而精确抓取则意味着手指单独完成对物体的捏取,包括指尖捏取、三点捏取和侧向捏取,抓取较为灵活。这六种抓取模式构成了人在日常活动中使用的绝大多数抓握姿态。本专利将物体分为四种抓取模式,分别为柱形包络、球形包络、精细捏取和宽型捏取。柱形包络和球形包络属于强力抓取,适合抓取较厚的物体,由于柱形和球形的区别,对应拇指的摆动角度不同。而精细捏取和宽型捏取属于精确抓取,适合抓取较薄的物体,由于物体宽细的区别,对应拇指和其余四指的开合宽度不同。根据上述确定抓取模式后,结合目标检测算法进行训练。

13.在物体抓取模式的划分同时考虑了物体的形状和大小,具体划分参数有物体的厚度和宽度。当物体厚度小于30mm且宽度小于30mm时,物体属于精细捏取;当物体厚度小于30mm且宽度大于30mm时,物体属于宽型捏取;当物体厚度大于30mm且形状偏于柱形时,物体属于柱形包络;当物体厚度大于30mm且形状偏于球形时,物体属于球形包络。

14.训练分为两部份:一是使用卷积神经网络提取查的图片特征,输出特征图;二是原始得到的rgb图像划分为小方块并以每个小方块为中心分别生成一系列锚框,以锚框为基础生成预测框,设定锚框的中点为抓取点,并根据物体真实框的位置对其进行位置和类别标注。最后建立输出的特征图与预测框标签的关联,创建损失函数并完成训练,根据初始设定好的标准,得到相对应的抓取模式、抓取区域。

15.本专利在对第一步中测试训练完成后的yolov3物体检测算法进行测试,可以识别物体的抓取模式和抓取区域。为了验证算法的可靠性和适应性,除了对测试集中的一些已知物体进行检测外,还拍摄一些未知物体图片进行测试。

16.第二步,利用第二控制模块将第一步得到的rgb图像输入进opencv软件库,并基于opencv自有的图像处理方法对其进行处理,输出物体的抓取角度。

17.1)调节canny算子中的检测阈值实现对物体的边缘检测;

18.2)利用腐蚀、膨胀函数将物体的轮廓形状填充完整;

19.3)使用最小外接矩形函数包围物体的外轮廓,获取外接矩形;

20.4)区分外接矩形的长边和短边,输出长边抓取的矩形旋转角。

21.第三步,抓取模块根据第三步中所获取的抓取角度,第二步获取的抓取模式、抓取区域,通过电机控制刚软仿人手抓取物体,具体的:

22.3.1)在已设计完成的刚软仿人手空载的情况下进行初始化,设置电机的初始位置标记;

23.3.2)根据抓取区域和抓取角度,控制与刚软仿人手连接的机械臂运动到抓取点正上方20厘米处的准备位置;

24.3.3)控制电机的转动圈数,使刚软仿人手的手指达到预抓取位置;

25.3.4)根据抓取模式控制刚软仿人手做出预抓取模式构型,例如当抓取某一物体时,手部需要转动90度,此时需要刚软仿人手预先转动30度,实现预抓取模式构型;

26.3.5)根据抓取高度,控制机械臂竖直向下运动使刚软仿人手抓取末端点到达桌面;

27.3.6)刚软仿人手完成自适应抓取并保持抓握,机械臂向上运动抓起物体;其中,抓取高度通过深度相机获得。

28.本发明的有益效果为:

29.(1)通过深度学习实现了端到端的抓取模式识别,即抓取手势与之相对应物体的抓取模式识别,同时获取物体的抓取位置和抓取角度。主要优点为:与其它刚软仿人手抓取方法相比,本文方法同时实现了抓取模式预测和抓取位姿估计,避免了复杂的抓取规划并允许刚软仿人手与桌面发生轻微接触。

30.(2)采用yolov3目标检测算法对数据集进行训练和测试,yolov3是一个实现回归功能的深度卷积神经网络,相对于fast r-cnn目标检测模型中使用候选区域进行特征提取,yolov3则选择了对于图片的全局区域进行训练,速度加快的同时,能够更好地区分目标和背景。其主要改进之处是采用多尺度预测,以及更好的基础分类网络和分类器,具有通用性强,背景误检率低的特点。使用基于opencv的图像处理方法,能够准确快速地输出物体的抓取角度。

31.(3)基于深度学习方法在刚软仿人手抓取中的互补性,通过建立数据集和目标检测算法实现了抓取模式分类和抓取定位,训练后检测算法的抓取模式识别准确率对已知物体达98.7%,对未知物体达82.7%。而刚软仿人手抓取的自适应性一定程度上补偿了学习算法的不确定性,并且简化了抓取规划。在ur3e机械臂上搭载欠驱动灵巧手对已知物体和未知物体进行了抓取实验,针对这些不同形状和大小物体采用不同的抓取模式,实现了90.8%的抓取成功率,基于抓取模式识别的刚软仿人手自抓取方法具备实用性。

32.(4)可以实现对刚软仿人手的精确控制,使刚软仿人手能够准确有力地抓取物体。

附图说明

33.图1为本发明实施例的基于深度学习的刚软仿人手自主抓取方法的步骤流程图。

具体实施方式

34.为使本发明的上述目的、特征和优点能够更为明显易懂,下面结合附图对本发明的具体实施例做详细的说明。

35.【第一实施例】

36.本实施例提供一种基于深度学习的刚软仿人手自主抓取方法,包括:

37.s100:本方案考虑平面上物体抓取,将物体分为4类抓取模式:柱形包络、球形包络、精细捏取和宽型捏取。本方案考虑平面上物体抓取,将物体分为4类抓取模式:柱形包络、球形包络、精细捏取和宽型捏取。

38.s101:建立用于抓取模式的识别的数据集;

39.在本实施例中,采用深度学习算法来实现物体抓取模式的识别,需要在合适的数据集上进行训练和验证。本方案制作了一个用于物体抓取模式识别的数据集。

40.数据集一共选取了80个常见日用物体,其中有17个物体属于柱形包络,如易拉罐、水瓶等;有22个物体属于球形包络,如网球、苹果等;有14个物体属于精细捏取,如签字笔、

胶棒等;有27个物体属于宽型捏取,如眼镜盒、鼠标等。物体抓取模式的划分同时考虑了物体的形状和大小,具体划分参数有物体的厚度和宽度。当物体厚度小于30cm且宽度小于30cm时,物体属于精细捏取;当物体厚度小于30cm且宽度大于30cm时,物体属于宽型捏取;当物体厚度大于30cm且形状偏于柱形时,物体属于柱形包络;当物体厚度大于30cm且形状偏于球形时,物体属于球形包络。

41.将kinect v2深度相机固定于抓取平台上方,拍摄并存储单个物体的rgb图片。物体随机以不同位置和不同旋向平放于平台上,每个物体拍摄16张图片,个别物体除了平放还以横放姿态再拍摄了16张图片,共拍摄图片1344张。最后使用labelimg软件对图片进行抓取模式和抓取区域的标注。柱形包络被标注类别为“power1”,球形包络被标注类别为“power2”,精细捏取被标注类别为“precision1”,宽型捏取被标注类别为“precision2”。抓取区域的标注使用一个水平的矩形框,标注矩形框的中心与物体的重心位置大致重合,而矩形框的边框尽量包围住物体的轮廓。

42.s102:将数据集分为测试集和训练集;

43.本方案训练前首先从1344张图片的数据集中随机选择241张图片作为测试集,其余图片作为训练集。经过1000次训练后再使用测试集测试,识别的整体准确率达98.7%,其中柱形包络(power1)准确率99.5%,球形包络(power2)准确率99.5%,精细捏取(precision1)准确率96.6%,宽型捏取(precision2)准确率99.3%。此外拍摄一些未知物体图片进行测试,同样具有良好的检测效果,对24个未知物体的识别准确率达82.75%。

44.可以理解地,将数据集分为测试集和训练集分别对yolov3目标检测算法进行训练和测试,能够有效地检测yolov3目标检测算法的训练成果。

45.s103:使用训练集训练yolov3目标检测算法识别抓取模式;

46.s104:使用测试集测试yolov3目标检测算法识别抓取模式的准确率;

47.s105:使用深度相机获取物体的rgb图像;

48.s106:将rgb图像输入进基于深度神经网络模型的yolov3目标检测算法,输出物体的抓取模式和抓取区域;

49.本方案需要调节canny算子中的检测阈值实现对物体的边缘检测,利用腐蚀、膨胀函数将物体的轮廓形状填充完整,使用最小外接矩形函数包围物体的外轮廓,获取外接矩形,区分外接矩形的长边和短边,输出长边抓取的矩形旋转角。需要说明的是,本实施例可适用于不同颜色、形状的日常物体。

50.s107:根据抓取模式、抓取区域和抓取角度控制刚软仿人手抓取物体;

51.本方案根据抓取区域和抓取角度,控制电机的转动圈数,使刚软仿人手的手指达到预抓取位置;控制手指的弯曲速度,实现协调的抓取动作。在刚软仿人手空载的情况下进行初始化,设置电机的初始位置标记。控制与刚软仿人手连接的机械臂运动到抓取点正上方一定距离的准备位置。采用电流控制实现手指的制动,当电机的工作电流值超过设定阈值时,电机停转。根据抓取模式控制刚软仿人手做出预抓取模式构型。根据抓取高度控制机械臂竖直向下运动使刚软仿人手抓取末端点到达桌面。

52.s108:刚软仿人手完成自适应抓取并保持抓握,机械臂向上运动抓起物体。其中,抓取高度通过深度相机获得。

53.在本方案中,定义刚软仿人手的抓取末端点为精确捏取模式下中指与拇指指尖自

然抓取的交汇点。最后结合灵巧手的抓取末端点坐标,并考虑误差补偿,转换得到最终抓取位置的x、y、z坐标。

54.可以理解地,本方案可以实现对刚软仿人手的精确控制,使刚软仿人手能够准确有力地抓取物体。本方案基于深度学习方法在刚软仿人手抓取中的互补性,通过建立物体抓取模式数据集和目标检测算法实现了抓取模式分类和抓取定位,训练后检测算法的抓取模式识别准确率对已知物体达98.7%,对未知物体达82.7%。而刚软仿人手抓取的自适应性一定程度上补偿了学习算法的不确定性,并且简化了抓取规划。在ur3e机械臂上搭载欠驱动灵巧手对已知物体和未知物体进行了抓取实验,针对这些不同形状和大小物体采用不同的抓取模式,实现了90.8%的抓取成功率,基于抓取模式识别的刚软仿人手自抓取方法具备实用性。

55.本方案提供了一种刚软仿人手,其包括:处理器、存储器可读存储介质上存储程序或指令,程序或指令被处理器执行时实现如本发明任一实施例的基于深度学习的刚软仿人手自主抓取方法的步骤。及存储在存储器上并可在处理器上运行的程序或指令,程序或指令被处理器执行时实现如本发明任一实施例的基于深度学习的刚软仿人手自主抓取方法的步骤。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。