1.本文发明涉及跨摄像头行人跟踪技术领域,具体来讲是一种基于重识别和方位感知的实时跨摄像头行人跟踪方法。

背景技术:

2.跨摄像头行人跟踪是智能视频监控领域中的一个研究热点,旨在从多视角场景中识别出身份一致的行人,以便实现监控区域内行人的持续跟踪。然而,受限于不同摄像头下不一致的光照条件、变化的行人姿态以及不同的相机视角,使得开发一个可供实际使用的跨摄像头行人跟踪系统极具挑战性。

3.因此,为了解决这些问题,当前的研究者提出了几种离线方法。这些方法通常需要考虑整个视频序列,首先依次对每个摄像头执行行人跟踪,获得每个摄像头下的短轨迹,然后,使用重识别技术来执行跨摄像头的轨迹关联,通过执行全局优化获得最优的行人轨迹。尽管这些方法取得了优异的性能,但是由于高延迟和后处理要求,极大的限制了这些方法的实际应用。

技术实现要素:

4.本发明的目的是针对现有技术的不足,提供一种基于重识别和方位感知的实时跨摄像头行人跟踪方法。

5.本发明解决其技术问题所采用的技术方案如下:

6.步骤(1)利用行人重识别数据集训练行人重识别模型,该模型用于提取行人外观特征;

7.步骤(2)设计行人方位感知网络,构建行人方位数据集,用于训练行人方位感知网络;

8.步骤(3)捕获每个摄像头的输入视频流,开启多线程读取每个视频流的图像帧存储到队列中;每个线程读取一个视频流的图像帧;

9.步骤(4)逐帧读取队列中存储的图像,使用行人检测算法对每一张图像进行检测,得到行人的边界框信息;

10.步骤(5)利用步骤(1)中训练的行人重识别模型提取步骤(4)中每一个行人边界框的外观特征;

11.步骤(6)利用步骤(2)中训练的方位感知模型提取步骤(4)中每一个行人边界框的方位信息;

12.步骤(7)利用卡尔曼滤波预测每个行人的运动信息,运动信息结合行人重识别模型提取的外观特征共同完成单摄像头下的目标跟踪,得到单摄像头下行人的运动轨迹;

13.步骤(8)利用行人的方位信息对行人外观特征进行分类,将单摄像头下的运动轨迹进行跨摄像头轨迹关联,为同一行人在不同摄像头下的运动轨迹分配同一id,从而完成跨摄像头行人跟踪。

14.本发明通过基于深度学习的方位估计网络预测行人图像的方位,为行人重识别特征提供方位信息,减轻了由于摄像头视角、行人姿态造成的行人外观特征差距,同时,利用行人的空间信息,缩小了跨摄像头轨迹关联的搜索范围,并通过姿态估计获得了行人的方位信息,方位信息被用于对行人外观特征进行分类,提高了跨摄像头目标跟踪方法的实时性。

附图说明

15.图1是本发明的整体实施方案流程图

16.图2是本发明的行人方位示意图

具体实施方式

17.下面结合附图对本发明作进一步描述。

18.参照图1是本发明的整体实施方案流程图,涉及跨摄像头行人跟踪领域,包括以下步骤:(1)行人检测,(2)外观特征提取,(3)行人方位感知,(4)单摄像头目标跟踪,(5)基于层次聚类的跨摄像头轨迹关联。本发明通过基于深度学习的方位估计网络预测行人图像的方位,为行人重识别特征提供方位信息,减轻了由于摄像头视角、行人姿态造成的行人外观特征差距,同时,利用行人的空间信息缩小了跨摄像头轨迹关联时的搜索范围,提高了跨摄像头目标跟踪方法的实时性。

19.如图1和2所示,本发明一种基于重识别和方位感知的实时跨摄像头行人跟踪方法,包括以下步骤:

20.步骤(1)利用行人重识别数据集训练行人重识别模型,该模型用于提取行人外观特征;

21.步骤(2)设计行人方位感知网络,构建行人方位数据集,用于训练行人方位感知网络;

22.步骤(3)捕获每个摄像头的输入视频流,开启多线程读取每个视频流的图像帧存储到队列中;每个线程读取一个视频流的图像帧;

23.步骤(4)逐帧读取队列中存储的图像,使用行人检测算法对每一张图像进行检测,得到行人的边界框信息;

24.步骤(5)利用步骤(1)中训练的行人重识别模型提取步骤(4)中每一个行人边界框的外观特征;

25.步骤(6)利用步骤(2)中训练的方位感知模型提取步骤(4)中每一个行人边界框的方位信息;

26.步骤(7)利用卡尔曼滤波预测每个行人的运动信息,运动信息结合行人重识别模型提取的外观特征共同完成单摄像头下的目标跟踪,得到单摄像头下行人的运动轨迹;

27.步骤(8)利用行人的方位信息对行人外观特征进行分类,将单摄像头下的运动轨迹进行跨摄像头轨迹关联,为同一行人在不同摄像头下的运动轨迹分配同一id,从而完成跨摄像头行人跟踪。

28.进一步的,所述步骤(1)具体实现过程如下:

29.1-1为抑制图像中的背景杂波,以strong baseline行人重识别模型为基准,在模

型的各个阶段之间添加注意力模块,该注意力模块由通道注意力和空间注意力组成,表示为空间相关的注意力权重s和通道相关的注意力权重vc之间的张量乘法,计算过程如公式(1)所示。

30.v=s

×vc

ꢀꢀ

(1)

31.1-2使用market1501和dukemtmc-reid这两个行人重识别领域的基准数据集对行人重识别模型进行训练。模型训练中使用两类损失:困难三元组损失和交叉熵损失。

32.进一步的,所述步骤(2)具体实现过程如下:

33.2-1行人的姿态变化是导致同一个人外观特征不一致的主要原因,为克服这个问题,因此设计行人方位感知网络实现行人方位估计。如图2所示,将人的朝向分为正面、背面和侧面,将dukemtmc-reid数据集中的数据分为以上三类,以此构建行人方位数据集。

34.2-2使用alpha pose模型获取上半部分人体关键点信息,该模型能够得到上半部分的人体关键点信息f

body

={f

ls

,f

rs

,f

lh

,f

rh

}、耳朵关键点信息fe={f

le

,f

re

},以及人体关键点信息置信度和耳朵关键点信息置信度。

35.2-3将人体方位估计当做一个分类任务,设计一个行人方位估计模型,行人方位估计模型如表1所示,包括输入层、3个全连接层和输出层,并在输出层的后面加入softmax层,将输出结果转换为属于不同类别的可能性大小;以人体关键点信息f

body

、耳朵关键点信息fe、人体关键点信息置信度和耳朵关键点信息置信度作为输入,3个朝向状态作为输出,训练得到行人方位估计模型。

36.表1

[0037][0038]

进一步的,所述步骤(3)具体实现过程如下:

[0039]

3-1使用视频解码器ffmpeg,以30fps的帧率捕获每个摄像头下的视频流,并将图像帧存储到队列中。

[0040]

进一步的,所述步骤(4)具体实现过程如下:

[0041]

4-1依次读取摄像头视频流存储在队列中的每帧图像,使用ssd算法对图像进行行人检测,得到每一个行人的边界框b=[x,y,w,h],其中[x,y]为边界框左上角像素坐标,[w,h]为边界框宽度和高度。

[0042]

进一步的,所述步骤(5)具体实现过程如下:

[0043]

5-1使用步骤(4)中得到的行人边界框,在对应图像帧中截取行人图像1使用步骤(4)中得到的行人边界框,在对应图像帧中截取行人图像表示

第j个摄像头检测到的第i个行人图像。将行人图像输入到步骤(1)中得到的行人重识别模型,得到行人的外观特征模型,得到行人的外观特征表示第j个摄像头检测到的第i个行人的外观特征。

[0044]

进一步的,所述步骤(6)具体实现过程如下:

[0045]

6-1使用alpha pose模型获取步骤(5)中每一张行人图像的人体关键点信息f

body

、耳朵关键点信息fe、人体关键点信息置信度和耳朵关键点信息置信度,并将其输入步骤(2)中的得到的行人方位估计模型,获取每一张行人图像中行人的方位信息中行人的方位信息表示第j个摄像头检测到的第i个行人的方位信息。

[0046]

进一步的,所述步骤(7)具体实现过程如下:

[0047]

7-1使用一个基于常量速度模型和线性观测模型的标准卡尔曼滤波器进行目标运动状态的预测,预测结果为(u,p,r,h,vu,v

p

,vr,vh,),由行人边界框的中心坐标(u,p),边界框宽r,边界框高h,以及各自的速度变化值vu,v

p

,vr,vh组成;将预测结果表示为行人的运动状态信息。

[0048]

7-2采用马氏距离表示第m个检测目标和第n个轨迹之间的运动状态相似度,如公式(2)所示,其中dm表示第m个检测目标的运动信息,yn表示第n个轨迹的运动信息,sn是由卡尔曼滤波器预测得到的第n个轨迹在当前观测空间的协方差矩阵。除此之外为避免目标运动状态的不确定性导致的行人id变换,使用余弦距离计算第m个检测目标和第n个轨迹之间的外观特征相似度,如公式(3)所示,fm表示第m个检测目标的外观特征信息,fn表示第n个轨迹的外观特征信息。通过线性加权融合运动状态相似度v(n,m)和外观特征相似度f(n,m),构建检测目标和轨迹之间的代价矩阵d,如公式(4)所示,α是超参数,用于调整不同项的权重。最后采用匈牙利算法完成检测目标和轨迹之间的匹配任务,实现单摄像头下的目标跟踪。

[0049][0050]

f(n,m)=cos(fm,fn)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(3)

[0051]

d(n,m)=αv(n,m) (1-α)f(n,m)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(4)。

[0052]

进一步的,所述步骤(8)具体实现过程如下:

[0053]

8-1通过步骤(7)得到每个摄像头下的行人轨迹集合,将其定义为1通过步骤(7)得到每个摄像头下的行人轨迹集合,将其定义为表示第j个摄像头下的第i条轨迹,m表示每个摄像头下的行人运动轨迹总数。通过结合位置信息、外观特征以及行人方位信息进行层次聚类完成跨摄像头下的轨迹关联任务。

[0054]

8-2首先利用行人方位信息将行人轨迹中的行人特征进行分类,使用欧几里得距离度量不同轨迹之间同方位外观特征的距离,如公式(5)所示,f

t

表示第t条轨迹的外观特征信息。同时也计算每个轨迹当前图像帧的行人位置信息之间的空间距离,如公式(6)所示,loc

t

表示第t条轨迹的位置信息:

[0055]

d(t,t')=||f

t

,f

t'

)||2ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(5)

[0056]

e(t,t')=||loc

t

,loc

t'

)||2ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(6)

[0057]

8-3空间距离和摄像头id被用来对代价矩阵做一些约束。首先,对于空间距离很远

的轨迹,不可能属于同一个行人,如公式(7)所示,r表示最大关联半径,d(t,t')表示第t条轨迹和第t'条轨迹之间的外观特征差距。其次在当前图像帧中同一个摄像头拍摄到的不同轨迹,也不可能属于同一个行人,如公式(8)所示,c

t

表示第t条轨迹所属的摄像机id。经过公式(7)(8)计算,得到表示所有轨迹之间相似度的距离矩阵r。最后,使用层次聚类算法完成不同摄像头之间的轨迹关联,在聚类结果中,每一个簇中所有的轨迹被赋予同一身份id。

[0058][0059][0060]

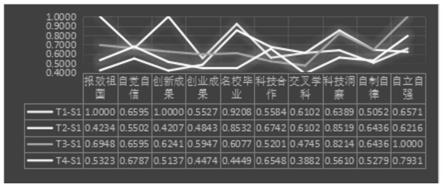

8-4为验证本发明的有效性,在epfl数据集上进行了相关实验,实验结果如表2所示。相较于现有的跨摄像头行人跟踪方法,本发明有较明显的性能提升。

[0061]

表2

[0062]

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。