1.本发明属于多智能体控制领域,特别涉及一种面向海空协同观测任务的多智能体控制方法。

背景技术:

2.中尺度涡是一种以长期封闭环流为主要特征,时间尺度在数天至数月,空间尺度在数十千米至数百千米之间的海洋现象,其对天气预测、海洋化学以及生物环境有着不可忽视的影响。推动中尺度涡的研究可以进一步推动该区域的海洋环境保障。传统的观测方法是在相关水域中投放一些浮标、波浪滑翔机等设备,数日后再进行集中收回。显而易见,这种方法并不能实时传信息。如果中途需要获取数据,只能派遣船只捞起观测设备,耗时且费力。此外,中尺度涡除了旋转运动,自身还在不断地“迁移”。因此,传统的固定点观测方法存在较大局限性,需要发展一种新的高精度且自动化的观测手段,这就需要基于任务需求制定合理的海空协同控制方法,协同无人艇(unmanned surface vehicle,usv)、无人机(unmanned aerial vehicle,uav)等多种智能设备,实现海空协同观测中尺度涡这类特定海洋现象的任务。

3.建设海空协同观测系统的主要目标是集成自主研发的智能体移动观测平台,研发海上多智能体协同算法,协同无人艇、无人机等多种智能设备,实现海空协同观测任务。通过对等温线的观测将有助于我们了解中尺度涡这类特定海洋现象的形成和传播,观测任务需要引导多艘无人艇与无人机协同观测中尺度涡的等温线数据。任务具体主要有以下2个:

4.任务1要求无人艇首先搜寻出等温线,并沿着等温线自主航行。

5.任务2要求无人机对无人艇的观测数据进行大规模数据的“抄表”。

6.而现有的控制方法过于依赖系统模型参数,未考虑到海上环境对模型的扰动影响,而且无人机、无人艇这类异构系统较为复杂,难以搭建起精确的数学模型。此外,由于场景不同、约束不同,现有的控制方法不适用于海空协同观测任务。

技术实现要素:

7.发明目的:中尺度涡的空间尺度在数十千米至数百千米之间,在实际观测任务中,一般需要数艘无人艇与数架无人机协同观测中尺度涡,一艘无人艇负责对水体的一条等温线循迹,找出它们的位置数据,集中通过无人机发送给服务器分析,构建中尺度涡观测模型。为了克服背景技术的不足,本发明公开了一种面向海空协同观测任务的多智能体控制方法,能够在环境受限、模型受限以及能量受限条件下,实现无人艇自主搜寻等温线,以及无人机对无人艇的观测数据进行大规模数据的采集任务。

8.技术方案:本发明所述的一种面向海空协同观测任务的多智能体控制方法,其具体的整体工作流程如下:

9.步骤1.建立初步的采样区域。先从太空卫星观测到海面上中尺度涡的生成,然后派出一艘无人艇从中尺度涡的最外侧沿着直线行驶至中心处,并沿途收集观测数据,建立

起初步的采样区域。本发明是以中尺度涡的水温变化举例,当然也可以根据实际科研考察需求,选择盐度、流量等作为参考;

10.步骤2.对采样区域进一步筛选。由于中尺度涡的分布空间很大,而无人艇的数量有限,因此在无人艇到达中尺度涡的中心时,把每个区域内所采样到的水温数据以梯度形式继续处理,由高向低排序。无人艇在按照步骤1行驶到中心过程中,搭载的温度传感器每隔一段时间采集一次水温,无人艇在按照步骤1行驶到达中心时,通过降序排列法筛选出水温变化梯度值大于阈值的区域,即具有观测价值区域;

11.步骤3.搜寻具有观测价值区域内的等温线。根据已有无人艇的数量确定具有观测价值区域的数量,一艘无人艇搜寻一个区域内的等温线,并记录等温线的位置数据。在搜寻过程中,采用数据驱动和深度确定性策略梯度算法对无人艇的航姿进行控制,已确保其始终行驶在等温线上;

12.步骤4.无人机对所有无人艇上观测数据进行采集,发送给服务器分析,构建中尺度涡观测模型。派遣无人机前往中尺度涡的中心,采用多智能体深度确定性策略梯度算法(multi

‑

agent deep deterministic policy gradient,maddpg)引导无人机与各艘无人艇在规定时间域内汇合,实现无人机一次飞行即可完成对所有无人艇上观测数据的采集任务。

13.进一步的,步骤2中所述水温变化梯度的表达式为:

[0014][0015]

其中,k

i

∈{k1,k2,

…

,k

n

}表示水温,n表示采样次数,为了方便计算,设定无人艇每隔一分钟采集一次水温,则水温变化梯度值为:

[0016][0017]

进一步的,步骤3中所述无人艇搜寻等温线算法的工作步骤如下:

[0018]

步骤3

‑

1.输入目标轨迹。根据已有的等温线数据集拟合出多条不规则形状的等温线,并作为目标航迹;

[0019]

步骤3

‑

2.利用ddpg算法对无人艇控制系统数据进行学习,训练出相关的数据驱动式ddpg控制器。与需要有大量样本数据的监督学习算法不同,ddpg算法不需要受控对象精准的数学模型,这对于未知环境下无人艇搜寻等温线的运动控制很有意义。

[0020]

步骤3

‑

3.输出实际轨迹。

[0021]

其中,步骤3

‑

2中ddpg算法的马尔可夫决策过程和网络结构如下:

[0022]

步骤a.马尔可夫决策模型包括状态空间、动作空间、回报函数:

[0023]

步骤a

‑

1.定义状态空间,选择的状态输入包括两部分,第一部分是无人艇的状态信息,即无人艇相对于地面坐标系的状态向量并进一步计算出与等温线夹角θ;第二部分是温度传感器返回的环境状态信息,即温度传感器采集当前位置的水温数据k,根据水温变化判断无人艇是否航行在等温线上,状态空间的定义如下:

[0024][0025]

其中,x、y、分别代表了无人艇在地面坐标系中的坐标和航向角;

[0026]

步骤a

‑

2.定义动作空间,考虑到无人艇的运动特性,假设在本次任务中无人艇在

航行过程中线速度保持不变,无人艇的动作即为角速度ω。此时,角速度的变化会导致无人艇航向的变化。同时,为了无人艇在一次控制过程中只能在一定范围内转弯,假设动作值的范围是

‑

60

°

(a1)到60

°

(a

13

),并以10

°

的增量变化。则动作空间的定义如下:

[0027]

a=[a1,a2,

…

,a

13

]

[0028]

步骤a

‑

3.定义回报函数,为了生成到达目标轨迹的最短路径,即保证其每一步的动作能够使得无人艇行驶在等温线上,本发明设计了以下的一组回报函数:

[0029][0030]

其中,r

arrive

=2为达到奖励函数,k0表示无人艇在出发点水域所采集到的温度,k

t

代表当前t时刻无人艇所在位置的水温;如果k

t

与k0的绝对差值小于等于阈值t

goal

,则说明无人艇在等温线搜寻范围之内,激活该函数;同时,为了引导无人艇不断朝向等温线航行,设置了一个转向函数:

[0031]

r

direction

=w1(θ

t

‑1‑

θ

t

) w2*|k

t

‑1‑

k

t

|

[0032]

其中,k

t

‑1代表了t

‑

1时刻无人艇所在区域的水温,θ

t

代表了当前无人艇航向与等温线的夹角,w1代表奖励系数,w2代表惩罚系数,两者值的大小均根据调参过程进行调整。若执行上一时刻的动作使得无人艇未行驶等温线上,调整惩罚系数进行惩罚;若执行上一时刻的动作使得无人艇行驶在等温线上,调整奖励系数给予一定的奖励。这就使得无人艇在探索过程中奖励不稀疏,加快算法收敛速度。

[0033]

步骤b.设计算法网络结构,结合以上的状态空间、动作空间以及回报函数,设计深度ddpg算法的策略网络和评价网络结构:

[0034]

步骤b

‑

1.策略网络采用一个输入与一个输出的深度卷积网络,其输入是环境状态信息,即水温变化梯度信息以及无人艇当前的运动状态信息,输出是无人艇的动作指令,即角速度,角速度的变化导致无人艇航向的变化。该结构具有两个隐藏层,第一层设置节点数为400,激活函数为softplus,第二层设置节点数是300,激活函数为tanh;

[0035]

步骤b

‑

2.评估网络采用两个输入与一个输出的深度卷积神经网络,其输入包括环境状态信息和策略网络输出的动作,输出则是当前策略的评价指标,即动作的q值。进一步来说,首先,将状态信息输入到评估网络中,该网络第二层设置的节点数为400,第三层设置的节点数为300,同时,将动作矩阵也输入到评价网络中,其第二层的神经元节点数为300,最后,将状态空间矩阵输入的网络的第三层神经元与动作矩阵输入的网络的第二层神经元节点合并,经过relu激活函数,得出输出值。此外,需要指出的是,网络中所有神经元节点之间的连接方式均为全连接方式。

[0036]

进一步的,步骤4中所述无人机对无人艇观测数据进行采集的工作步骤如下:

[0037]

步骤c.maddpg算法的马尔可夫决策过程:

[0038]

步骤c

‑

1定义状态空间:

[0039]

s={d

t

(usv1,uav),d

t

(usv2,uav),

…

,d

t

(usv

n

,uav)}

[0040]

其中,d

t

(usv

i

,uav)表示t时刻第i个无人艇与无人机之间的距离,n表示有n个无人艇;

[0041]

[0042]

其中,(x

goal

,y

goal

)当前时刻无人机的位置坐标,(x,y)表示无人艇的位置坐标为;步骤c

‑

2定义动作空间:

[0043][0044]

其中,a

t

表示表示t时刻第i个无人艇与无人机汇合的动作空间为:

[0045][0046]

其中,a

tuav

分别代表t时刻无人艇和无人机的线速度,两者线速度的变化将导致汇合时间的变化,进一步影响到其它无人艇与无人机的汇合时间。

[0047]

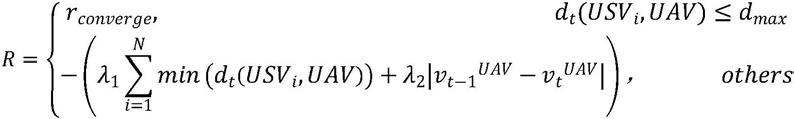

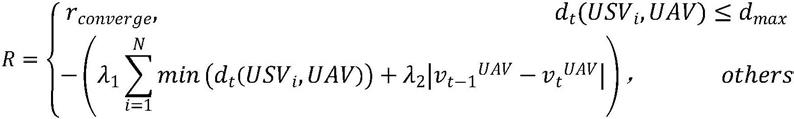

步骤c

‑

3.定义回报函数:

[0048][0049]

其中,r

converge

表示汇合奖励函数,是一个正值。无人艇与无人机成功汇合是完成观测数据采集任务的关键标准之一,d

max

表示无人机能够采集无人艇上观测数据的最大距离。当usv1与无人机之间的d

tusv1

距离小于等于d

max

时,即视为汇合成功,激活该函数。r

distance

表示距离奖励函数,其用于引导usv1和无人机以最短时间、最小能量损的汇合。当无人机、无人艇的距离越近,奖励越多,距离奖励函数表示为:

[0050]

r

distance

=λ1(d

t

‑1‑

d

t

)

‑

λ2|v

t

‑

1uav

‑

v

tuav

|

[0051]

其中,λ1表示距离奖励系数,d

t

表示当前采样获得的usv1与无人机的距离,d

t

‑1表示上一步的距离,将d

t

‑1与上d

t

做差,如果差值为正,则说明usv1与无人机的距离越来越小时,上一步的动作使得两者接近,通过调整奖励系数给予一定的奖励;反之,说明上一步的动作使得两者远离,通过调整惩罚系数给予一定的惩罚,λ2表示惩罚系数,v

tuav

表示t时刻无人机的线速度,当上一刻与当前的线速度变化大于预设阈值时,通过调整惩罚系数给与一定的惩罚,这是因为无人机线速度的变化会导致能量过多的损耗,不利于无人机达到最大航程飞行要求。

[0052]

步骤d.采用集中式训练、分布式执行的方式对多智能体系统进行训练:

[0053]

步骤d

‑

1.定义第i个智能体的随机策略梯度:

[0054][0055]

其中,j(

·

)表示总奖赏,ρ

π

(s)表示折现状态分布,θ

i

是表示第i个智能体策略的参数。s表示全局观测量,a

i

表示第i个智能体的动作,π

i

表示第i个智能体的控制策略,是第i个策略网络的参数,o

i

表示第i个智能体的观测值,即状态。表示关于贴现状态分布ρ(s)的期望值,是分值函数,π

i

(a

i

|o

n

)表示一个在状态o

n

对于各个动作a

i

的条件概率分布,表示所有智能体的状态动作值函数集合,该值的输出是通过将所有智能体的动作和全局环境状态输入策略网络和评价网络中得到的。

[0056]

步骤d

‑

2.定义n个智能体的确定性策略梯度:

[0057]

[0058]

其中,函数j是用于衡量一个确定性策略μ

i

的表现,θ

iμ

是第i个确定性策略网络的参数,用一个卷积神经网络对μ函数进行模拟,这个网络被称为策略网络。a

i

=μ

i

(o

i

)是一个观测值空间到动作值空间的映射。d表示经验回放池,用于存储所有智能体与环境交互的经验数据,每一条经验数据都是由一组(s,s

′

,a1,

…

,a

n

,r1,

…

,r

n

)组成;

[0059]

步骤d

‑

3.定义评价网络逼近的目标函数:

[0060][0061]

其中,r代表回报函数,s

′

表示s状态下执行动作a后的下个状态,γ是折扣因子,用于计算未来的累计回报期望。μ

j

、o

j

分别表示目标策略和目标观测值,是由θ

iμ

复制而来的目标策略网络参数。在集中式训练方式下,采用时间差分思想以及目标网络思想对评价网络参数进行更新;

[0062]

步骤d

‑

4.计算损失函数:

[0063][0064]

其中,a

′

表示智能体在状态s

′

下所执行的动作;

[0065]

步骤d

‑

5.定义最大化策略集合的整体回报:

[0066][0067]

其中,unif(1,k)是一个从1到k均匀分布的数值集合,第i个智能体的策略μ

i

是由k个子策略的集合组成,在每个回合的训练中只采用一个子策略并对每个子策略k再构建一组子经验回放池d

i(k)

。r

i

(s,a)表示全局奖励函数;

[0068]

步骤d

‑

6.定义每个子策略的更新梯度:

[0069][0070]

其中,表示动作值函数的梯度,输入所有智能体的动作a={a1,

…

,a

n

}以及环境状态量s,是子策略下观测值空间到动作值空间的映射。

[0071]

有益效果:与现有技术相比,本发明的技术方案具有以下有益效果:

[0072]

目前,已有的多智能体协同算法的设计过于依赖系统模型参数。同时,由于任务不同、约束不同,现有的协同算法不适用于本次海空协同观测任务。而本发明所提出的一种面向海空协同观测任务的多智能体控制方法,能够在环境受限、模型受限以及能量受限条件下,实现无人艇循迹等温线,以及无人机对无人艇的观测数据进行大规模数据的采集任务。

附图说明

[0073]

图1多无人艇协同搜索多条等温线任务示意图;

[0074]

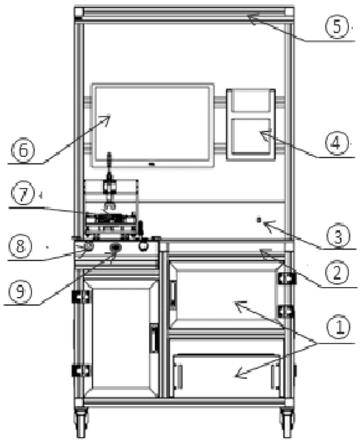

图2无人机对所有无人艇观测数据进行采集任务示意图;

[0075]

图3无人艇循迹等温线的原理框图;

[0076]

图4ddpg算法的网络结构图;

[0077]

图5无人艇与无人机的环境状态示意图;

[0078]

图6maddpg的网络训练过程图。

具体实施方式

[0079]

下面结合附图和实施例对本发明的技术方案作进一步的说明。

[0080]

如图1所示,本发明需要解决的任务1为解决多无人艇协同搜索多条等温线任务。以三艘无人艇集群编队为示范,任务1需要引导usv1、usv2、usv3搜寻各自区域内的等温线,并沿着等温线自主航行。;

[0081]

如图2所示,本发明需要解决的任务2无人机对所有无人艇观测数据的采集任务。任务2是所有无人艇、无人机基于各自与对方的距离、方向等信息调整自身的速度,以实现usv1、usv2、usv3分别在t1、t2、t3时刻与无人机汇合,方便了无人机每天一次飞行即可完成对所有观测数据的采集任务;

[0082]

如图3所示,本发明提出一种基于数据驱动式的深度确定性策略控制方法。利用ddpg算法强大的学习、决策能力对这些系统数据进行学习,训练出相关系统的数据驱动式ddpg控制器,以完成无人艇搜寻等温线的任务。本发明通过传感器技术采集无人艇运动的实时状态数据,建立完备的数据库。

[0083]

如图4所示,本发明提出ddpg算法的策略网络采用一个输入与一个输出的深度卷积网络,其输入是环境状态信息,即水温变化梯度信息以及无人艇当前的运动状态信息,输出是无人艇的动作指令,即角速度,角速度的变化导致无人艇航向的变化。本发明提出ddpg算法的评估网络采用两个输入与一个输出的深度卷积神经网络,其输入包括环境状态信息和策略网络输出的动作,输出则是当前策略的评价指标,即动作的q值。

[0084]

如图5所示,本发明在定义无人艇与无人机的环境状态时,需要考虑到两者相对的距离。同时,三艘无人艇分别沿着不同的等温线运动,航向是不会因为无人机而改变的。,由于无人机的最大航程有限,这就限制了无人机的航向是固定的,即始终向中尺度涡的中心飞行,并且线速度值的大小一定的范围内进行调整,这是因为线加速度和角加速度的变化都会损耗无人机的能量,不利于无人机一次飞行完成所有无人艇上观测数据的采集。因此,本发明无需考虑无人艇与无人机的相对角度因素。

[0085]

如图6所示,本发明针对ddpg算法在解决异构多智能体控制问题上的不足,提出了一种基于maddp算法的协同控制策略。对于每个智能体i,将其状态s

i

输入其策略网络,得到动作a

i

,在仿真环境中执行该动作到达新状态s

i

′

并获得回报r

i

。同时,该交互数据以元组<s

i

,a

i

,s

i

′

,r

i

>的形式存入其独享的经验池d

i

中。该智能体在新状态s

i

′

下会继续根据其当前的策略网络选择动作与环境交互,不断生成数据。以此类推,其它智能体同样与环境交互并将经验输入存入各自的经验池中。在更新网络时,以智能体i为例,先按批的大小以经验池的容量为最大值生成一串随机数,然后以随机数为索引从所有智能体的经验池中采样得到同样时刻的一批数据,并将其拼接得到一批元组<s,a,s

′

,r>,其中每个元组的s和s

′

是相同时刻所有智能体的组合状态,a是所有智能体的组合动作,而回报r仅仅选用智能体i的回报值。将s

′

输入到目标策略网络i得到动作a

′

,随后将s

′

与a

′

共同输入到目标评价网络i中得到对下一时刻估计的目标q值,根据公式计算当前时刻的目标q值。再使用评价网络得到实际的q值,利用td偏差来更新评价网络,用q值的策略梯度更新策略网络。其它智能体的网络

更新方式以此类推,主要区别在于输入。

[0086]

本发明所述的一种面向海空协同观测任务的多智能体控制方法,其具体的工作流程如下:

[0087]

步骤1.建立初步的采样区域。先从太空卫星观测到海面上中尺度涡的生成,然后派出一艘无人艇从中尺度涡的最外侧沿着直线行驶至中心处,并沿途收集观测数据,建立起初步的采样区域。本发明是以中尺度涡的水温变化举例,当然也可以根据实际科研考察需求,选择盐度、流量等作为参考;

[0088]

步骤2.对采样区域进一步筛选。由于中尺度涡的分布空间很大,而无人艇的数量有限,因此在无人艇到达中尺度涡的中心时,把每个区域内所采样到的水温数据以梯度形式继续处理,由高向低排序。无人艇在按照步骤1行驶到中心过程中,搭载的温度传感器每隔一段时间采集一次水温,无人艇在按照步骤1行驶到达中心时,通过降序排列法筛选出水温变化梯度值大于阈值的区域,即具有观测价值区域;

[0089]

步骤3.搜寻具有观测价值区域内的等温线。根据已有无人艇的数量确定具有观测价值区域的数量,一艘无人艇搜寻一个区域内的等温线,并记录等温线的位置数据。在搜寻过程中,采用数据驱动和深度确定性策略梯度算法对无人艇的航姿进行控制,已确保其始终行驶在等温线上;

[0090]

步骤4.无人机对所有无人艇上观测数据进行采集,发送给服务器分析,构建中尺度涡观测模型。派遣无人机前往中尺度涡的中心,采用多智能体深度确定性策略梯度算法(multi

‑

agent deep deterministic policy gradient,maddpg)引导无人机与各艘无人艇在规定时间域内汇合,实现无人机一次飞行即可完成对所有无人艇上观测数据的采集任务。

[0091]

进一步的,步骤2中所述水温变化梯度的表达式为:

[0092][0093]

其中,k

i

∈{k1,k2,

…

,k

n

}表示水温,n表示采样次数,为了方便计算,设定无人艇每隔一分钟采集一次水温,则水温变化梯度值为:

[0094][0095]

进一步的,步骤3中所述无人艇搜寻等温线算法的工作步骤如下:

[0096]

步骤3

‑

1.输入目标轨迹。根据已有的等温线数据集拟合出多条不规则形状的等温线,并作为目标航迹;

[0097]

步骤3

‑

2.利用ddpg算法对无人艇控制系统数据进行学习,训练出相关的数据驱动式ddpg控制器。与需要有大量样本数据的监督学习算法不同,ddpg算法不需要受控对象精准的数学模型,这对于未知环境下无人艇搜寻等温线的运动控制很有意义。

[0098]

步骤3

‑

3.输出实际轨迹。

[0099]

其中,步骤3

‑

2中ddpg算法的马尔可夫决策过程和网络结构如下:

[0100]

步骤a.马尔可夫决策模型包括状态空间、动作空间、回报函数:

[0101]

步骤a

‑

1.定义状态空间,选择的状态输入包括两部分,第一部分是无人艇的状态信息,即无人艇相对于地面坐标系的状态向量并进一步计算出与等温线夹角

θ;第二部分是温度传感器返回的环境状态信息,即温度传感器采集当前位置的水温数据k,根据水温变化判断无人艇是否航行在等温线上,状态空间的定义如下:

[0102][0103]

其中,x、y、分别代表了无人艇在地面坐标系中的坐标和航向角;

[0104]

步骤a

‑

2.定义动作空间,考虑到无人艇的运动特性,假设在本次任务中无人艇在航行过程中线速度保持不变,无人艇的动作即为角速度ω。此时,角速度的变化会导致无人艇航向的变化。同时,为了无人艇在一次控制过程中只能在一定范围内转弯,假设动作值的范围是

‑

60

°

(a1)到60

°

(a

13

),并以10

°

的增量变化。则动作空间的定义如下:

[0105]

a=[a1,a2,

…

,a

13

]

[0106]

步骤a

‑

3.定义回报函数,为了生成到达目标轨迹的最短路径,即保证其每一步的动作能够使得无人艇行驶在等温线上,本发明设计了以下的一组回报函数:

[0107][0108]

其中,r

arrive

=2为达到奖励函数,k0表示无人艇在出发点水域所采集到的温度,k

t

代表当前t时刻无人艇所在位置的水温;如果k

t

与k0的绝对差值小于等于阈值t

goal

,则说明无人艇在等温线搜寻范围之内,激活该函数;同时,为了引导无人艇不断朝向等温线航行,设置了一个转向函数:

[0109]

r

direction

=w1(θ

t

‑1‑

θ

t

) w2*|k

t

‑1‑

k

t

|

[0110]

其中,k

t

‑1代表了t

‑

1时刻无人艇所在区域的水温,θ

t

代表了当前无人艇航向与等温线的夹角,w1代表奖励系数,w2代表惩罚系数,两者值的大小均根据调参过程进行调整。若执行上一时刻的动作使得无人艇未行驶等温线上,调整惩罚系数进行惩罚;若执行上一时刻的动作使得无人艇行驶在等温线上,调整奖励系数给予一定的奖励。这就使得无人艇在探索过程中奖励不稀疏,加快算法收敛速度。

[0111]

步骤b.设计算法网络结构,结合以上的状态空间、动作空间以及回报函数,设计深度ddpg算法的策略网络和评价网络结构:

[0112]

步骤b

‑

1.策略网络采用一个输入与一个输出的深度卷积网络,其输入是环境状态信息,即水温变化梯度信息以及无人艇当前的运动状态信息,输出是无人艇的动作指令,即角速度,角速度的变化导致无人艇航向的变化。该结构具有两个隐藏层,第一层设置节点数为400,激活函数为softplus,第二层设置节点数是300,激活函数为tanh;

[0113]

步骤b

‑

2.评估网络采用两个输入与一个输出的深度卷积神经网络,其输入包括环境状态信息和策略网络输出的动作,输出则是当前策略的评价指标,即动作的q值。进一步来说,首先,将状态信息输入到评估网络中,该网络第二层设置的节点数为400,第三层设置的节点数为300,同时,将动作矩阵也输入到评价网络中,其第二层的神经元节点数为300,最后,将状态空间矩阵输入的网络的第三层神经元与动作矩阵输入的网络的第二层神经元节点合并,经过relu激活函数,得出输出值。此外,需要指出的是,网络中所有神经元节点之间的连接方式均为全连接方式。

[0114]

进一步的,步骤4中所述无人机对无人艇观测数据进行采集的工作步骤如下:

[0115]

步骤c.maddpg算法的马尔可夫决策过程:

[0116]

步骤c

‑

1定义状态空间:

[0117]

s={d

t

(usv1,uav),d

t

(usv2,uav),

…

,d

t

(usv

n

,uav)}

[0118]

其中,d

t

(usv

i

,uav)表示t时刻第i个无人艇与无人机之间的距离,n表示有n个无人艇;

[0119][0120]

其中,(x

goal

,y

goal

)当前时刻无人机的位置坐标,(x,y)表示无人艇的位置坐标为;

[0121]

步骤c

‑

2定义动作空间:

[0122][0123]

其中,a

t

表示表示t时刻第i个无人艇与无人机汇合的动作空间为:

[0124][0125]

其中,a

tuav

分别代表t时刻无人艇和无人机的线速度,两者线速度的变化将导致汇合时间的变化,进一步影响到其它无人艇与无人机的汇合时间。

[0126]

步骤c

‑

3.定义回报函数:

[0127][0128]

其中,r

converge

表示汇合奖励函数,是一个正值。无人艇与无人机成功汇合是完成观测数据采集任务的关键标准之一,d

max

表示无人机能够采集无人艇上观测数据的最大距离。当usv1与无人机之间的d

tusv1

距离小于等于d

max

时,即视为汇合成功,激活该函数。r

distance

表示距离奖励函数,其用于引导usv1和无人机以最短时间、最小能量损的汇合。当无人机、无人艇的距离越近,奖励越多,距离奖励函数表示为:

[0129]

r

distance

=λ1(d

t

‑1‑

d

t

)

‑

λ2|v

t

‑

1uav

‑

v

tuav

|

[0130]

其中,λ1表示距离奖励系数,d

t

表示当前采样获得的usv1与无人机的距离,d

t

‑1表示上一步的距离,将d

t

‑1与上d

t

做差,如果差值为正,则说明usv1与无人机的距离越来越小时,上一步的动作使得两者接近,通过调整奖励系数给予一定的奖励;反之,说明上一步的动作使得两者远离,通过调整惩罚系数给予一定的惩罚,λ2表示惩罚系数,v

tuav

表示t时刻无人机的线速度,当上一刻与当前的线速度变化大于预设阈值时,通过调整惩罚系数给与一定的惩罚,这是因为无人机线速度的变化会导致能量过多的损耗,不利于无人机达到最大航程飞行要求。

[0131]

步骤d.采用集中式训练、分布式执行的方式对多智能体系统进行训练:

[0132]

步骤d

‑

1.定义第i个智能体的随机策略梯度:

[0133][0134]

其中,j(

·

)表示总奖赏,ρ

π

(s)表示折现状态分布,θ

i

是表示第i个智能体策略的参数。s表示全局观测量,a

i

表示第i个智能体的动作,π

i

表示第i个智能体的控制策略,是第i个策略网络的参数,o

i

表示第i个智能体的观测值,即状态。表示关于贴现状态分布ρ(s)的期望值,是分值函数,π

i

(a

i

|o

n

)表示一个在状态o

n

对于各个动作a

i

的条件概率分布,表示所有智能体的状态动作值函数集合,该值的输出是通过将所有智能体的动作和全局环境状态输入策略网络和评价网络中得到的。

[0135]

步骤d

‑

2.定义n个智能体的确定性策略梯度:

[0136][0137]

其中,函数j是用于衡量一个确定性策略μ

i

的表现,θ

iμ

是第i个确定性策略网络的参数,用一个卷积神经网络对μ函数进行模拟,这个网络被称为策略网络。a

i

=μ

i

(o

i

)是一个观测值空间到动作值空间的映射。d表示经验回放池,用于存储所有智能体与环境交互的经验数据,每一条经验数据都是由一组(s,s

′

,a1,

…

,a

n

,r1,

…

,r

n

)组成;

[0138]

步骤d

‑

3.定义评价网络逼近的目标函数:

[0139][0140]

其中,r代表回报函数,s

′

表示s状态下执行动作a后的下个状态,γ是折扣因子,用于计算未来的累计回报期望。μ

j

、o

j

分别表示目标策略和目标观测值,是由θ

iμ

复制而来的目标策略网络参数。在集中式训练方式下,采用时间差分思想以及目标网络思想对评价网络参数进行更新;

[0141]

步骤d

‑

4.计算损失函数:

[0142][0143]

其中,a

′

表示智能体在状态s

′

下所执行的动作;

[0144]

步骤d

‑

5.定义最大化策略集合的整体回报:

[0145][0146]

其中,unif(1,k)是一个从1到k均匀分布的数值集合,第i个智能体的策略μ

i

是由k个子策略的集合组成,在每个回合的训练中只采用一个子策略并对每个子策略k再构建一组子经验回放池d

i(k)

。r

i

(s,a)表示全局奖励函数;

[0147]

步骤d

‑

6.定义每个子策略的更新梯度:

[0148][0149]

其中,表示动作值函数的梯度,输入所有智能体的动作a={a1,

…

,a

n

}以及环境状态量s,是子策略下观测值空间到动作值空间的映射。

[0150]

通过实现本发明,可以建设海空协同观测系统,具体完成以下具体2个任务。

[0151]

任务1要求无人艇首先搜寻出等温线,并沿着等温线自主航行。

[0152]

任务2要求无人机对无人艇的观测数据进行大规模数据的采集。

[0153]

从而,集成自主研发的智能体移动观测平台,协同无人艇、无人机等多种智能设备,实现海空协同观测任务。通过对等温线的观测,助于我们了解中尺度涡这类特定海洋现象的形成和传播。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。