1.本技术涉及计算机视觉技术领域,具体涉及多模态感知技术,尤其涉及一种自适应融合可见光和红外图像的双模态无人机识别方法。

背景技术:

2.随着无人机技术的发展,无人机已成为军事技术战中一种重要的新型作战武器。无人机在战场上的应用主要包括侦察监视、精确打击和集群作战。更重要的是,由于无人机结构简单、重量轻,正在以更高的效率和性能取代部分人工作业。无人机已广泛应用于民用领域,如探测、救援、侦察和快递,但无人机检测任务常常受到光照条件差、遮挡和噪点等影响。

3.目前,无人机检测方法主要包括音频信号分析、雷达数据分析、射频信号分析和计算机视觉技术。muhammad等人提出了一种新的机器学习框架,用于检测和分类噪声环境中的各种声音,使用声音检测无人机,这在噪音环境中不适用。cheng等人提出了一种雷达检测和跟踪方法,用于检测杂波环境中的无人机,但在雪霾天气,雷达的探测范围很短。liu等人从一种特殊无人机的角度出发,开发了一种基于yolov3的小目标检测方法,但是基于视觉的检测方法在光线较差的情况下会失败。sonain等人通过声音和图像信息检测和定位恶意无人机,这种方法计算量较大,不适合用于机载计算机。当前的目标检测算法主要分为2个阶段方法和一阶段方法。2个阶段方法首先生成区域建议,然后通过卷积神经网络对样本进行分类,常见的2个阶段目标检测算法如r-cnn、sppnet、fast r-cnn和r-fcn[19]等。一阶段方法直接通过卷积神经网络提取特征来预测目标分类和位置,包括yolo系列网络和ssd。但大多数检测算法的输入只有可见光图片,这意味着算法的效果十分依赖光照条件。由此可见,一个轻量高效、鲁棒性强的微小无人机检测算法是无人机应用发展的重要技术。

[0004]

如何构建一个轻型高效的双模态无人机检测网络,使无人机能够在复杂场景中稳定的完成任务,是亟需解决的问题。

技术实现要素:

[0005]

本技术提供了一种自适应融合可见光和红外图像的双模态无人机识别方法,其技术目的是提高小目标的检测能力,提高算法的鲁棒性,使无人机能够完成更复杂的任务。

[0006]

本技术的上述技术目的是通过以下技术方案得以实现的:

[0007]

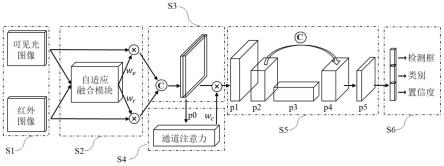

一种自适应融合可见光和红外图像的双模态无人机识别方法,该识别方法通过深度学习网络实现,该深度学习网络包括第一主干网络、第二主干网络、自适应融合模块、通道注意力模块和fpn结构,该方法包括:

[0008]

s1:获取无人机的可见光图像和红外图像,将可见光图像输入至第一主干网络,将红外图像输入至第二主干网络;

[0009]

s2:通过第一主干网络对可见光图像进行特征提取得到可见光特征图,通过第二主干网络对红外图像进行特征提取得到红外特征图,然后将可见光特征图和红外特征图输

入至自适应融合模块;

[0010]

s3:自适应融合模块根据可见光特征图和红外特征图的特征质量对可见光图像和红外图像进行权重分配,将可见光特征图和红外特征图分别与各自的权重相乘,并对赋权重的可见光特征图和红外特征图进行拼接得到特征图p0;

[0011]

s4:通过通道注意力模块在各通道对特征图p0赋权重wc,将wc与特征图p0相乘,得到特征图p1;

[0012]

s5:通过fpn结构对特征图p1进行多尺度特征融合操作,得到检测层p5;

[0013]

s6:由检测层p5得到无人机识别结果。

[0014]

本技术的有益效果在于:本技术所述的自适应融合可见光和红外图像的双模态无人机识别方法,利用可见光图像和红外图像的特性作为网络的输入;利用自适应融合模块为可见光图像和红外图像分配不同的权重,再通过fpn结构融合多尺度特征输出检测层,最后得到检测结果。

[0015]

该无人机识别方法,通过可见光图像和红外图像的自适应特征融合,不仅能够对微小目标实时检测,还能够在光照条件恶劣的环境下对无人机进行稳定的检测,有较好的应用前景。实验证明,本技术所提出的算法结构简单,计算量低,适用于小目标检测,且具有较强的鲁棒性。

附图说明

[0016]

图1为本技术所述方法的流程图;

[0017]

图2为自适应融合模块的示意图;

[0018]

图3为通道注意力模块的示意图;

[0019]

图4为识别网络的结构组成示意图。

具体实施方式

[0020]

下面将结合附图对本技术技术方案进行详细说明。

[0021]

本技术所述的自适应融合可见光和红外图像的双模态无人机识别方法,通过深度学习网络实现,该深度学习网络包括第一主干网络、第二主干网络、自适应融合模块、通道注意力模块和fpn结构。如图1所示,该方法包括:

[0022]

s1:获取无人机的可见光图像和红外图像,将可见光图像输入至第一主干网络,将红外图像输入至第二主干网络。

[0023]

s2:通过第一主干网络对可见光图像进行特征提取得到可见光特征图,通过第二主干网络对红外图像进行特征提取得到红外特征图,然后将可见光特征图和红外特征图输入至自适应融合模块。

[0024]

具体地,可见光图像由可见光相机得到,其宽*高*通道数为640*640*3;红外图像由红外相机得到,其宽*高*通道数为640*640*1,并将红外图像转换成三通道图像。最后经过主干网络得到尺寸均为640*640*8的可见光特征图和红外特征图。

[0025]

s3:自适应融合模块根据可见光特征图和红外特征图的特征质量对可见光图像和红外图像进行权重分配,将可见光特征图和红外特征图分别与各自的权重相乘,并对赋权重的可见光特征图和红外特征图进行拼接得到特征图p0。

[0026]

具体地,如图2所示,若自适应融合模块输入的是宽*高*通道数为w*h*3的特征图,对该特征图进行最大池化操作和平均池化操作,分别得到w*h*1的最大池化层和w*h*1的平均池化层,将w*h*1的最大池化层和w*h*1的平均池化层直接拼接形成w*h*2的特征图,再将w*h*2的特征图输入至人工卷积层得到w*h*1的空间特征图,将该空间特征图的最大值和平均值进行相加得到分数值,最后将该分数值传入sigmoid激活函数得到预权重ω。

[0027]

则可见光特征图的权重wv和红外特征图的权重wi分别表示为:

[0028][0029]

fd=conv(concat(maxpool(f),avgpool(f))));

[0030]

ω=sig(mean(fd) max(fd));

[0031]

其中,w1表示可见光特征图的预权重;w2表示红外特征图的预权重;ω表示预权重;fd表示空间特征图;f表示输入的可见光特征图或红外特征图;maxpool(f)表示对特征图进行最大池化操作;avgpool(f)表示对特征图进行平均池化操作;concat表示对最大池化操作和平均池化操作的特征图按某一维度进行拼接;conv表示卷积层;max(fd)表示空间特征图上的最大值;mean(fd)表示空间特征图的全局平均值;sig代表sigmoid激活函数。

[0032]

特征图p0是由可见光特征图与wv相乘和红外特征图与wi相乘拼接而成,其宽*高*通道数为w*h*2c。

[0033]

s4:通过通道注意力模块在各通道对特征图p0赋权重wc,将wc与特征图p0相乘,得到特征图p1。

[0034]

如图3所示,通道注意力模块能够对特征图的每个通道赋予不同的权重,具体的流程是对传入的特征图进行全局的最大池化操作和平均池化操作,再将2个新的特征图传入到共享感知机中生成2个个特征向量进行相加再通过通道sigmoid激活函数得到通道注意力权重wc,通道注意力的整个过程可以由下式表示:

[0035][0036]

wc=sig(mlp(avgpool(p0)) mlp(maxpool(p0)));

[0037]

其中,mlp表示多层感知机;wc即通道注意力模块的权重。

[0038]

s5:通过fpn结构对特征图p1进行多尺度特征融合操作,得到检测层p5。

[0039]

具体地,fpn结构共有11层,依次为conv层、c3层、conv层、c3层、conv层、c3层、sppf层、conv层、upsample层、concat层和c3层。

[0040]

图4中,整个识别网络共有16层,为了避免丢失小目标信息,整个网络采用8倍下采样,针对小目标检测采用一个检测层。特征金字塔fpn结构能够获得多层次融合的特征图,可以有效的减少中小目标的丢失。识别网络的主要模块包括conv模块、c3模块、sppf模块、concat模块、upsample模块和af模块。conv模块是最基本的模块,包括卷积层、批量归一化层和silu激活函数。c3模块的功能是学习剩余特性。sppf模块(单独一层)是空间金字塔池,能够从不同的规模获取特征。concat模块是对2个特征图按某一维度进行直接拼接。upsample模块为上采样模块,对特征图的尺寸进行上采样,以进行微小目标检测。af模块包括了自适应融合模块和通道注意力模块。

[0041]

s6:由检测层p5得到无人机识别结果。

[0042]

具体地,检测器在检测层上进行检测,通过识别网络的训练loss函数回归得到检

测结果,结果主要包括检测框位置、检测的类别和置信度。

[0043]

由于本技术所述的识别方法仅用于检测无人机一个分类,因此这里不考虑分类错误,则识别网络的损失函数表示为:

[0044][0045][0046][0047]

其中,l

eiou

表示一种有效的边界框回归损失;ρ2表示预测框中点和目标框中点之间的欧几里得距离,b表示预测框的中点;b

gt

表示目标框的中点;w表示预测框的宽度;w

gt

表示目标框的宽度;h表示预测框的高度;h

gt

表示目标框的高度;c表示覆盖两个检测框最小框的对角线距离;cw表示覆盖两个检测框最小框的宽度;ch表示覆盖两个检测框最小框的高度;l

boj

表示置信度损失;po表示预测框中的目标置信度分数;p

iou

表示预测框和对应的目标框的iou值;表示二分类交叉熵损失;w

obj

表示正样本的权重;

[0048]

k表示输出特征图,s2表示输出特征图的单元格,b表示每个单元格中的预测锚定框;代表第k个输出特征映射第i个单元格和第j个锚定框时是否为正样本;x

p

表示预测向量;x

gt

表示真值向量;α

box

表示位置误差的权重;α

obj

表示置信误差的权重。

[0049]

以上为本技术示范性实施例,本技术的保护范围由权利要求书及其等效物限定。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。