1.本发明属于计算机技术领域,更进一步涉及计算机视觉识别技术领域中的一种基于度量学习和时空双流网络的跨视角步态识别方法。本发明可用于从人体步态轮廓序列中提取丰富的时空运动信息以得到具有鲁棒性的跨视角步态特征,并根据所得到的跨视角步态特征进行步态识别完成人体身份鉴定。

背景技术:

2.步态识别技术是一种利用人的行走模式这一独特信息并从中提取人行走时的步态特征对人进行身份鉴定的生物识别技术。步态识别技术因其远距离识别、无需受试者配合和难隐蔽性等特点,在预防犯罪、司法鉴定和医疗健康等方面有着广泛的应用。在实际场景中,步态识别会受到诸如视角变化、穿衣条件和遮挡等复杂因素的影响,其中跨视角带来的视角变化是最常见的问题,会极大影响步态识别的准确率。

3.复旦大学在其拥有的专利技术“基于多任务生成对抗网络的跨视角步态识别方法”(申请号:cn201710373017.5授权公告号:cn107085716b)中公开了一种基于多任务生成对抗网络的跨视角步态识别方法。该方法的具体实现步骤为:对于原始的行人视频帧序列,首先对每帧图像进行预处理,并提取出周期能量图这一步态模版特征;然后通过神经网络将其编码为步态隐表示,并在隐空间中进行角度变换;再通过多任务生成对抗网络重构出其他视角的步态模版特征;最后使用步态隐表示进行识别。但是,该方法仍然存在不足之处是有两点,其一,由于该方法使用周期能量图作为步态模板,会丢失步态轮廓序列中的部分时间信息,无法得到精确的表示步态信息的时空运动特征。其二,该方法无法很好地解决复杂条件下的穿衣变化和遮挡问题和抵抗环境干扰因素的影响,导致在复杂条件下该方法的步态识别性能不高,难以满足实际场景下存在复杂条件的步态识别场景。

4.北京交通大学在其申请的专利文献“一种基于注意力机制的神经网络步态识别方法”(专利申请号:cn202010778327.7授权公告号:cn111967358b)公开了一种基于注意力机制的步态识别方法。该方法首先构建神经网络的训练集和测试集,通过迭代优化策略,利用样本及样本标签预训练步态特征提取模型,使得训练后的步态特征提取模型能从人体步态中提取出较好的特征;然后在前一阶段基础上在网络中嵌入时域注意力机制模块和空域注意力机制模块,重新训练网络;最后使用训练好的网络模型进行步态识别。但是,该方法仍然存在的不足之处是有两点,其一,该方法需要复杂的注意力计算过程,计算开销和占用显存比较大,不利于实际场景下的部署使用。其二,因为视角变化引起同类别样本之间差异增大导致识别难度增加,该方法在视角变化的鲁棒性不足和跨视角识别准确率不高,并且没有充分挖掘视频序列中的时间维度的步态运动信息,时空特征学习能力不足。

技术实现要素:

5.本发明的目的在于针对上述现有技术的不足,提出一种基于度量学习和时空双流网络的跨视角步态识别方法,旨在解决采用步态模板方法丢失部分时间信息和现有方法时

空特征学习能力不足,以及计算开销大和复杂条件下鲁棒性不足导致跨视角步态识别准确率不高的问题。

6.实现本发明目的的思路是,本发明使用预处理后的步态轮廓序列作为输入,保存原始的时间信息,以此解决现有技术的采用步态模板方法丢失部分时间信息的问题。本发明将构建好的外观运动双流子网络和特征映射子网络组成深度学习网络,其中外观运动双流子网络提取外观和运动特征,并通过特征融合的方式捕获外观和运动特征之间的关系,以此解决现有技术时空特征学习能力不足的问题;特征映射子网络对输入特征进行精炼压缩,学习不同粒度的人体部分特征,且无需复杂的注意力计算过程,以此解决现有技术计算开销与占用显存大,以及对噪声的鲁棒性不足的问题。本发明在训练深度学习网络中采用度量学习思想,设计包含三元组损失函数和多分类交叉熵损失函数的联合损失函数,学习更加鲁棒性的特征,以此解决现有技术在视角变化下提取特征鲁棒性不足的问题。最终利用训练好的深度学习网络进行跨视角步态识别。

7.实现本发明目的的技术方案包括如下:

8.步骤1,生成训练集:

9.步骤1.1,选取至少74个受试者的8140个步态轮廓序列;

10.步骤1.2,对每个步态轮廓序列进行预处理,得到行人头部位于图像的上边缘且脚部位于图像的下边缘的对齐后的步态轮廓序列;将对齐后的步态轮廓序列缩放成相同的图像大小64

×

64;

11.步骤1.3,将所有的数据样本组成训练集;

12.步骤2,构建外观运动双流子网络:

13.步骤2.1,构建外观流特征模块,其结构依次为:头部、第一外观卷积块、第二外观卷积块、第三外观卷积块、第四外观卷积块。第一至第四外观卷积块的结构相同,每个外观卷积块均由骨干分支和一个跳连分支组成;

14.所述头部由卷积层和池化层串联组成;

15.所述外观卷积块的骨干分支由第一卷积层、第一leakyrelu激活层、第二卷积层、第二leakyrelu激活层、第三卷积层串联组成。所述外观卷积块的跳连分支采用一个第四卷积层,使得跳跃连接的输出特征的通道数和骨干分支保持一致。外观卷积块的骨干分支和跳连分支通过逐位置加法器相连后再与第三leakyrelu激活层连接;

16.将头部中卷积层的卷积核大小设置为1

×3×

3,卷积核通道数设置为1,卷积核数量设置为32。将头部中池化层设置为最大池化层,池化核的大小设置为1

×3×

3;

17.将第一至第四外观卷积块中第一卷积层的卷积核大小均设置为1

×1×

1,第二至第四卷积层的卷积核大小均分别设置为1

×3×

3、1

×1×

1、1

×1×

1。将第一至第四卷积层的卷积核的通道数分别设置为32、32、32、32,卷积核的数量分别设置为32、32、128、128;第二外观卷积块中,第一至第四卷积层的卷积核的通道数分别设置为128、32、32、128,卷积核的数量分别设置为32、32、128、128;第三外观卷积块中,第一至第四卷积层的卷积核的通道数分别设置为128、64、64、128,卷积核的数量分别设置为64、64、256、256;第四外观卷积块中,第一至第四卷积层的卷积核的通道数分别设置为256、64、64、256,卷积核的数量分别设置为64、64、256、256;

18.步骤2.2,构建运动流特征模块结构依次:头部、第一运动卷积块、第二运动卷积

块、第三运动卷积块、第四运动卷积块。第一至第四运动卷积块的结构相同,每个运动卷积块均由骨干分支和一个跳连分支组成;

19.所述头部由卷积层和池化层串联组成;

20.所述运动卷积块结构和步骤2.1中所述外观卷积块的结构一致;

21.将头部中卷积层的卷积核大小设置为3

×3×

3,卷积核通道数设置为1,卷积核数量设置为32。将头部中池化层设置为最大池化层,池化核的大小设置为1

×3×

3;

22.将第一至第四运动卷积块中第一卷积层的卷积核大小均设置为3

×1×

1,第二至第四卷积层的卷积核大小均分别设置为1

×3×

3、1

×1×

1、1

×1×

1。将第一运动卷积块中,第一至第四卷积层的卷积核的通道数分别为32、32、32、32,卷积核的数量分别为32、32、128、128;第二运动卷积块中,第一至第四卷积层的卷积核的通道数分别为128、32、32、128,卷积核的数量分别为32、32、128、128;第三运动卷积块中,第一至第四卷积层的卷积核的通道数分别为128、64、64、128,卷积核的数量分别为64、64、256、256;第四运动卷积块中,第一至第四卷积层的卷积核的通道数分别为256、64、64、256,卷积核的数量分别为64、64、256、256;

23.步骤2.3,构建第一至第四特征融合模块,第一至第三特征融合模块的结构相同,每个特征融合模块均由卷积层和特征拼接块组成;

24.所述特征拼接块由特征拼接操作构成,对输入的外观特征和运动特征进行拼接,融合得到更加丰富的步态特征;

25.将第一至第三特征融合模块中卷积层的卷积核大小均设置为1

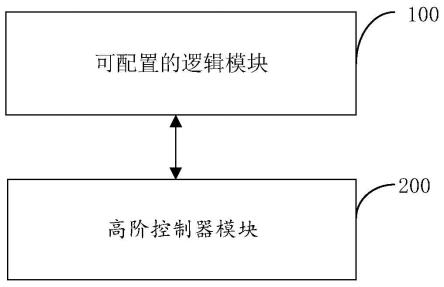

×1×

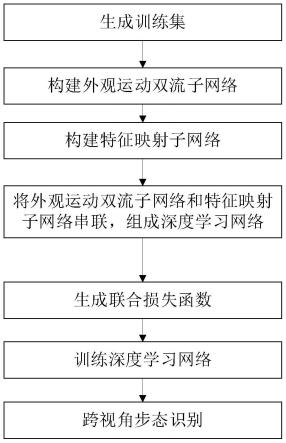

1,卷积核通道数分别设置为32、128、256,卷积核的个数分别设置为32、128、256;

26.将第一至第三特征融合模块中特征拼接层分别设置为按通道、按通道、按高度维度对特征进行拼接;

27.步骤2.4,构建外观流特征模块和运动流特征模块并联,并使用第一至第三特征融合模块连接外观流特征模块和运动流模块得到外观运动双流子网络;

28.将第一特征融合模块中卷积层与外观流特征模块中头部的池化层相连,卷积层的输出特征与运动流特征模块中头部的池化层输出特征,按通道维度进行拼接,再与外观流特征模块中第一运动卷积块相连;将第二特征融合模块中卷积层与外观流特征模块中的第二外观卷积块相连,卷积层的输出特征与运动流特征模块中第二运动卷积块的输出特征,按通道维度进行拼接,再与外观流特征模块中第三运动卷积块相连;将第三特征融合模块中卷积层与外观流特征模块中的第四外观卷积块相连,卷积层的输出特征与运动流特征模块中第四运动卷积块的输出特征,按通道维度进行拼接得到最终输出特征,其通道、高、宽大小为分别为256、64、22;完成外观运动双流子网络的构建;

29.步骤3,构建特征映射子网络:

30.步骤3.1,构建时域池化模块,其结构由时间维度的最大池化层组成;

31.将时域池化模块中的最大池化层的池化核大小设置为t1×1×

1,其中,t1为输入步态轮廓序列的长度;

32.步骤3.2,构建水平分割金字塔模块,采用6个尺度,其结构由第一尺度水平分割块、第二尺度水平分割块、第三水平分割块、第四水平分割块、第五水平分割块、第六水平分割块并联组成。第一至第六水平分割块的结构相同,每个水平分割块由特征水平分割层组

成;

33.所述特征水平分割层由高度维度的特征分割操作组成,将输入特征分割为多个条带;

34.将第一至第六水平分割层中的条带数分别设置为1、2、4、8、16、32,条带的高分别设置为64、32、16、8、4、2,宽均设置为22,共得到63条带,每个条带代表每个人体部分特征;

35.步骤3.4,构建广义平均池化模块结构依次为:第一广义池化块、第二广义池化块、第三广义池化块、第四广义池化块、第五广义池化块、第六广义池化块并联组成;

36.所述广义池化块由对每个条带第一次幂运算、平均池化层、对特征第二次幂运算串联组成;

37.将第一至第六广义池化块中第一次和第二次幂运算的指数均设置为可学习的参数p,第一次幂运算是对输入特征进行求p次幂,第二次幂运算是对输入特征求次幂,p默认设置为6.5,在利用反向传播算法进行训练时可以学习从而变化。将第一至第六广义池化块中平均池化层的池化核大小的高设置为64、32、16、8、4、2,宽均设置为22;

38.步骤3.4,构建特征投影模块结构依次为:独立全连接块、批量归一化层。

39.所述独立全连接块由63个并列的参数不同的全连接层构成;

40.将独立全连接块中63个全连接层参数,默认使用正态分布n(0,0.01)进行初始化。将批量归一化层设置用于一维特征向量的批量归一化,通道数量设置为256;

41.步骤3.5,将时域池化模块、水平分割金字塔模块、广义平均池化模块、特征投影模块依次串联组成的特征映射子网络;

42.步骤4,将外观运动双流子网络与特征映射子网络串联组成深度学习网络;

43.步骤5,生成联合损失函数如下:

44.l

total

=αl

triplet

βl

ce

λl

weight

45.其中,l

total

表示联合损失函数,l

triplet

表示三元组损失函数,l

ce

表示多分类交叉熵损失函数,l

weight

表示权重衰减损失函数,α表示三元组损失函数的系数,其取值为1,β表示多分类损失函数的系数,其取值为0.1,λ表示权重衰减损失函数的系数,其取值为0.00005;

46.步骤5,训练深度学习网络:

47.将训练集输入到深度学习网络中。使用联合损失函数计算得到总体损失值。在深度学习网络中反向传播总体损失值,利用梯度下降法更新各网络节点的权重参数,直到损失值收敛,得到训练好度学习网络;

48.步骤6,跨视角步态识别:

49.步骤6.1,将注册数据集合中样本,送入训练好的深度学习网络中得到一维向量输出,作为每个步态轮廓序列的特征向量表示,最终得到注册数据集的特征数据库;

50.步骤6.2,将待识别的查询数据集合中的样本送入训练好的深度学习网络,得到查询数据集合中样本的特征向量。将查询数据集合中的每一个样本的特征向量与注册数据集合中所有样本的特征向量进行欧式距离计算,最终将该查询样本识别为注册数据集合中与之欧式距离最小的特征向量的身份标签,输出查询样本的身份标签,完成跨视角识别。

51.本发明与现有技术相比具有以下优点:

52.第一,本发明通过构建外观运动双流子网络,以原始步态轮廓序列作为网络的输

入,克服现有技术丢失时间信息的问题和时空特征学习能力的不足,使得本发明提取到包含高级语义的丰富时空运动特征,相比于已有方法,具有保存时间信息和提高时空特征学习能力的优点。

53.第二,本发明构建的特征映射子网络,克服现有技术的注意力计算过程带来计算开销与占用显存大,以及对噪声的鲁棒性不足的缺陷,使得本发明具有利于实际情况下部署使用和提升复杂条件下对噪声鲁棒性的优点。

54.第三,本发明构建用于训练深度学习网络的联合损失函数,克服了现有技术提取的特征在视角变化下鲁棒性不足的缺点,使得本发明可以学习到更加通用、可鉴别性的特征,使得本发明具有对视角变化鲁棒性的优点和提高总体识别准确率的优点。

附图说明

55.图1是本发明的实现流程图;

56.图2是本发明中外观卷积块和运动卷积块的结构图;

57.图3是本发明中外观运动双流子网络的结构图;

58.图4是本发明中特征映射子网络的结构图;

59.图5是本发明构建的深度学习网络结构图。

具体实施方式

60.下面结合附图和实施例,对本发明做进一步的描述。

61.参照图1和实施例,本发明实现的具体步骤做进一步的描述。

62.步骤1,生成训练集。

63.步骤1.1,本发明的数据集是在互联网上,通过邮件向中科院自动化所申请casia-b数据集。该数据集涵盖视角全面,一个应用广泛的步态数据集,包含124名受试者的13640段视频。每个受试者有10个类型的步态轮廓序列,包括正常行走条件下采集的6个类型(索引为nm#01-06),携带背包条件下采集的2个类型(索引为bg#01-02),穿着外套大衣条件下采集的2个类型(索引为cl#01-02)。每个类型包括11个不同视角(0

°‑

180

°

间隔18

°

)的步态轮廓序列。

64.步骤1.2,对每个步态轮廓序列(每个步态轮廓序列都是一个步态轮廓视频,包含多张/多帧步态轮廓图)进行如下处理:

65.步骤1.2.1,读取每个步态轮廓序列,将包括行人的部分放置于每帧图像的中心,并对图像进行裁剪对齐,去除无用的黑色背景信息,使得行人头部位于图像的上边缘,脚部位于图像的下边缘,得到对齐后的步态轮廓序列;

66.步骤1.2.2,将对齐后的步态轮廓序列调整成相同的图像大小64

×

64,得到最终处理好的步态轮廓序列,作为外观运动双流子网络的输入。

67.步骤1.3,将前74名受试者的共8140个步态轮廓序列用作训练集。将剩下50名受试者的所有步态轮廓序列用作测试集,并且将正常条件下采样的6个类型的步态轮廓序列中前四个类型(即nm#01-04)作为注册数据集合,剩下的nm#05-06、bg#01-02和cl#01-02分别作为查询数据集合。

68.步骤2,构建外观运动双流子网络。

69.参照图3,对本发明构建外观运动双流子网络作进一步的详细描述。

70.步骤2.1,构建外观流特征模块,其结构依次为:头部、第一外观卷积块、第二外观卷积块、第三外观卷积块、第四外观卷积块。第一至第四外观卷积块的结构相同,每个外观卷积块均由骨干分支和一个跳连分支组成。

71.所述头部由卷积层和池化层串联组成。

72.所述外观卷积块的骨干分支由第一卷积层、第一leakyrelu激活层、第二卷积层、第二leakyrelu激活层、第三卷积层串联组成。所述外观卷积块的跳连分支采用一个第四卷积层,使得跳跃连接的输出特征的通道数和骨干分支保持一致。外观卷积块的骨干分支和跳连分支通过逐位置加法器相连后再与第三leakyrelu激活层连接。如图2(a)所示。

73.将头部中卷积层的卷积核大小设置为1

×3×

3,卷积核通道数设置为1,卷积核数量设置为32。将头部中池化层设置为最大池化层,池化核的大小设置为1

×3×

3。

74.将第一至第四外观卷积块中第一卷积层的卷积核大小均设置为1

×1×

1,第二至第四卷积层的卷积核大小均分别设置为1

×3×

3、1

×1×

1、1

×1×

1。将第一至第四卷积层的卷积核的通道数分别设置为32、32、32、32,卷积核的数量分别设置为32、32、128、128;第二外观卷积块中,第一至第四卷积层的卷积核的通道数分别设置为128、32、32、128,卷积核的数量分别设置为32、32、128、128;第三外观卷积块中,第一至第四卷积层的卷积核的通道数分别设置为128、64、64、128,卷积核的数量分别设置为64、64、256、256;第四外观卷积块中,第一至第四卷积层的卷积核的通道数分别设置为256、64、64、256,卷积核的数量分别设置为64、64、256、256。

75.步骤2.2,构建运动流特征模块结构依次:头部、第一运动卷积块、第二运动卷积块、第三运动卷积块、第四运动卷积块。第一至第四运动卷积块的结构相同,每个运动卷积块均由骨干分支和一个跳连分支组成。

76.所述头部由卷积层和池化层串联组成。

77.所述运动卷积块结构和步骤2.1中所述外观卷积块的结构一致,如图2(b)所示。

78.将头部中卷积层的卷积核大小设置为3

×3×

3,卷积核通道数设置为1,卷积核数量设置为32。将头部中池化层设置为最大池化层,池化核的大小设置为1

×3×

3。

79.将第一至第四运动卷积块中第一卷积层的卷积核大小均设置为3

×1×

1,第二至第四卷积层的卷积核大小均分别设置为1

×3×

3、1

×1×

1、1

×1×

1。将第一运动卷积块中,第一至第四卷积层的卷积核的通道数分别为32、32、32、32,卷积核的数量分别为32、32、128、128;第二运动卷积块中,第一至第四卷积层的卷积核的通道数分别为128、32、32、128,卷积核的数量分别为32、32、128、128;第三运动卷积块中,第一至第四卷积层的卷积核的通道数分别为128、64、64、128,卷积核的数量分别为64、64、256、256;第四运动卷积块中,第一至第四卷积层的卷积核的通道数分别为256、64、64、256,卷积核的数量分别为64、64、256、256。

80.步骤2.3,构建第一至第四特征融合模块。第一至第三特征融合模块的结构相同,每个特征融合模块均由卷积层和特征拼接块组成。

81.所述特征拼接块由特征拼接操作构成,对输入的外观特征和运动特征进行拼接,融合得到更加丰富的步态特征。

82.将第一至第三特征融合模块中卷积层的卷积核大小均设置为1

×1×

1,卷积核通

道数分别设置为32、128、256,卷积核的个数分别设置为32、128、256。

83.将第一至第三特征融合模块中特征拼接层分别设置为按通道、按通道、按高度维度对特征进行拼接。

84.步骤2.4,构建外观流特征模块和运动流特征模块并联,并使用第一至第三特征融合模块连接外观流特征模块和运动流模块得到外观运动双流子网络。

85.将第一特征融合模块中卷积层与外观流特征模块中头部的池化层相连,卷积层的输出特征与运动流特征模块中头部的池化层输出特征,按通道维度进行拼接,再与外观流特征模块中第一运动卷积块相连;将第二特征融合模块中卷积层与外观流特征模块中的第二外观卷积块相连,卷积层的输出特征与运动流特征模块中第二运动卷积块的输出特征,按通道维度进行拼接,再与外观流特征模块中第三运动卷积块相连;将第三特征融合模块中卷积层与外观流特征模块中的第四外观卷积块相连,卷积层的输出特征与运动流特征模块中第四运动卷积块的输出特征,按通道维度进行拼接得到最终输出特征,其通道、高、宽大小为分别为256、64、22。完成外观运动双流子网络的构建。

86.步骤3,构建特征映射子网络。

87.参照图3,对本发明构建特征映射子网络作进一步的详细描述。

88.步骤3.1,构建时域池化模块,其结构由时间维度的最大池化层组成。

89.将时域池化模块中的最大池化层的池化核大小设置为t1×1×

1,其中,t1为输入步态轮廓序列的长度。

90.步骤3.2,构建水平分割金字塔模块,采用6个尺度,其结构由第一尺度水平分割块、第二尺度水平分割块、第三水平分割块、第四水平分割块、第五水平分割块、第六水平分割块并联组成。第一至第六水平分割块的结构相同,每个水平分割块由特征水平分割层组成。

91.所述特征水平分割层由高度维度的特征分割操作组成,将输入特征分割为多个条带。

92.将第一至第六水平分割层中的条带数分别设置为1、2、4、8、16、32,条带的高分别设置为64、32、16、8、4、2,宽均设置为22,共得到63条带,每个条带代表每个人体部分特征。

93.步骤3.4,构建广义平均池化模块结构依次为:第一广义池化块、第二广义池化块、第三广义池化块、第四广义池化块、第五广义池化块、第六广义池化块并联组成。

94.所述广义池化块由对每个条带第一次幂运算、平均池化层、对特征第二次幂运算串联组成。

95.将第一至第六广义池化块中第一次和第二次幂运算的指数均设置为可学习的参数p,对输入特征进行求p次幂,p默认设置为6.5,在利用反向传播算法进行训练时可以学习从而变化。将第一至第六广义池化块中平均池化层的池化核大小的高设置为64、32、16、8、4、2,宽均设置为22。

96.步骤3.4,构建特征投影模块结构依次为:独立全连接块、批量归一化层。

97.所述独立全连接块由63个并列的参数不同的全连接层构成。

98.将独立全连接块中63个全连接层参数,默认使用正态分布n(0,0.01)进行初始化。将批量归一化层设置用于一维特征向量的批量归一化,通道数量设置为256。

99.步骤3.5,将时域池化模块、水平分割金字塔模块、广义平均池化模块、特征投影模

块依次串联组成的特征映射子网络,如图4所示。

100.步骤4,将外观运动双流子网络与特征映射子网络串联组成深度学习网络,如图5所示。

101.步骤5,生成联合损失函数如下:

102.l

total

=αl

triplet

βl

ce

λl

weight

103.其中,l

total

表示联合损失函数,l

triplet

表示三元组损失函数,l

ce

表示多分类交叉熵损失函数,l

weight

表示权重衰减损失函数,α表示三元组损失函数的系数,其取值为1,β表示多分类损失函数的系数,其取值为0.1,λ表示权重衰减损失函数的系数,其取值为0.00005;

104.所述三元组损失函数如下:

[0105][0106][0107]

其中,表示一个批次中三元组损失非零项的总数,parts表示所有尺度下部分特征的总数,s表示水平分割金字塔模块中多尺度总数,s表示尺度的索引,t表示部分特征的索引,anchors表示锚样本(表示当三元组样本对中首先选择的样本,作为锚点,正样本和锚样本的标签相同,负样本和锚样本的标签不同)集合,h、m分别表示一个批次中受试者数量和每个受试者的步态轮廓序列数,h、m分别表示受试者索引和步态轮廓序列的索引,pos表示和锚样本标签相同的正样本集合,a表示正样本的索引,negative表示和锚样本标签不同的负样本集合,b、c分别表示负样本集合中受试者的索引和步态轮廓序列的索引,v2表示将步态轮廓序列输入到深度学习网络后得到的样本的特征向量,ω是三元组损失的边界阈值margin,dist表示正样本对和负样本对之间的距离,[x]

表示对输入x和0取最大值,d(

·

)表示欧式距离函数,表示第h个受试者第m个步态轮廓序列第s个尺度的第t个部分特征,与类似。

[0108]

将三元组损失函数中多尺度数目s设置为6,h、m分别设置为12、4,ω设置为0.2,d设置为欧式距离计算函数。

[0109]

所述多分类交叉熵损失函数如下:

[0110][0111][0112]

将数据集合中受试者的身份标签作为分类任务的标签信息,使用独立全连接层和softmax函数对特征向量v2处理得到类别预测概率分布p,然后计算多分类交叉损失。

[0113]

其中,n是训练集中所有受试者类别的个数,表示h个受试者第m个步态轮廓序列属于第n个受试者类别的预测概率,表示h个受试者第m个步态轮廓序列属于第n个受试者类别的真实概率(以第φ个受试者为例子)。在测试阶段丢弃分类概率结果,仅使用特

emporal-scale 3d convolutional neural network”([c]//proceedings of the 28th acm international conference on multimedia.2020:3054-3062)中提出的基于3d卷积神经网络的方法。

[0136]

本发明的仿真实验所述跨视角步态识别的步骤是,第一步,对casia-b数据进行步态轮廓预处理,选取前74个受试者的步态轮廓序列生成训练集,剩下50个受试者生成测试集。第二步,将训练集数据输入到深度学习网络中进行训练。

[0137]

第三步,训练后,在测试集上进行跨视角步态识别。

[0138]

为了验证本发明仿真实验的效果,按照跨视角准确率计算公式,得到本发明深度学习网络和现有技术gaitse、gaitpart、mt3d三种跨视角识别方法的跨视角识别准确率(%)。

[0139]

在仿真实验中,跨视角准确率计算步骤如下:

[0140]

第一步,从视角集合a={0

°

,18

°

,36

°

,54

°

,72

°

,90

°

,108

°

,126

°

,144

°

,162

°

,180

°

}中选择一个查询视角和注册视角选取查询集合中视角下的待识别的样本以及注册集合中视角下的样本其中n

p

为视角下查询样本个数,ng为视角下的注册样本个数。

[0141]

第二步,对集合中一个待识别的样本计算其和注册集合中所有样本的相似度其中d(

·

)为欧氏距离计算函数,找出和样本距离最小的注册样本。

[0142]

第三步,若两者身份一致,则识别成功数n

correct

加一,否则识别失败。

[0143]

第四步,对视角下的剩下待识别的样本重复第二步至第三步过程。

[0144]

第五步,得到对应于视角的跨视角识别准确率

[0145]

第六步,重复步骤第一步至第五步得到11个查询视角对应11个注册视角下的跨视角识别准确率。

[0146]

第七步,进一步计算每个查询视角下的跨视角平均准确率,对除了当前视角下的其余10个视角的跨视角准确率进行求和平均得到当前查询视角的跨视角平均准确率。

[0147]

第八步,重复步骤第一步至第七步得到正常行走条件、携带背包和穿着大衣下11视角的跨视角识别准确率。

[0148]

按照以上跨视角准确率计算步骤,得到本发明仿真实验中本发明和现有技术gaitse、gaitpart、mt3d三种跨视角识别方法,三种不同行走条件下的11个视角下的跨视角识别准确率结果(%),如表示1所示。

[0149]

表1仿真实验中本发明和现有技术跨视角识别准确率结果

[0150][0151]

结合表1观察,其中跨视角准确率越高代表该方法的性能好。本发明方法在所有行走条件情况下,均达到了最好的识别性能。在正常行走条件下,本发明方法在除了36

°

视角的其余10个视角下的跨视角识别准确率都优于其他先进方法,平均准确率达到了97.2%;在携带背包行走条件下,本发明方法和mt3d在11个视角下跨视角识别准确率各有优势,但本发明方法平均准确率更胜一筹;在穿着大衣行走条件下,该条件存在较大的遮挡问题,导致识别准确率迅速下降,但本发明方法在除了36

°

视角下的其余10个视角下跨视角识别准确率都优于其他先进方法,平均准确率达到了83.9%取得明显优势。因此,现有方法相比,在跨视角识别准确率和复杂条件下的识别性能均有着明显提升。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。