1.本发明属于计算机视觉和人工智能等技术领域,具体涉及一种人机交互场景下多特征融合的沉浸度计算方法及系统。

背景技术:

2.人与机器人之间可以通过多种表达方式进行信息间的交流,如语音、自然语言、动作、表情等。其中语音是人与机器之间最直接和最丰富交流方式之一,是人机智能交互的重要接口。然而在实际的人机交互场景中复杂的环境噪声会干扰语音交互的性能,导致机器进行误唤醒和易打断,不利于机器人的智能交互,使得交互体验变差。沉浸度计算就是指通过不同的传感器及技术手段采集用户表达中不同模态的信息,并对人机交互过程中能够衡量用户沉浸度的多种特征信息进行分析,从而评估出用户的交互意愿。然而实际过程中语音易受环境的影响并且追踪困难,而视觉信息较为稳定。通过对用户的视觉行为进行分析来评估用户沉浸度高低,使机器人理解用户的交互的意愿,从而提供相关的服务。

3.在人机交互前,机器人通过对周围环境中用户沉浸度的评估,选取沉浸度高的用户并为其主动提供服务,有效的避免了机器人对不同沉浸度的用户做出相同的反应和在嘈杂环境中语音的误唤醒,提高了机器人主动交互的意愿;在人机交互中,机器人通过持续监控用户沉浸度来判断用户的交互意愿,根据用户沉浸度的高低来调整本身的交互程度,提高人机交互的自然度。当用户的沉浸度低时减少或者暂停机器本身的交互行为和意愿,从而避免无效的交互,提高机器人的工作效率。因此在人机交互场景下如何有效的计算用户沉浸度并判断其交互意愿是实现机器人智能化交互亟待解决的关键技术问题。

技术实现要素:

4.本发明要解决的技术问题:针对现有技术的上述问题,提供一种人机交互场景下多特征融合的沉浸度计算方法及系统,本发明能够实现人机交互场景下多特征融合的沉浸度计算,准确的评估人与机器人的交互意愿,可有效提升人机交互场景下的交互体验,且结合多种特征的时序信息,可有效提升用户的沉浸度计算的准确度。

5.为了解决上述技术问题,本发明采用的技术方案为:一种人机交互场景下多特征融合的沉浸度计算方法,包括:1)确定人机交互场景下从用户的实时图像提取得到的多种特征的序列,所述多种特征包含人机交互距离特征、人体姿态特征、头部姿态特征、面部姿态特征、眼部姿态特征以及唇部运动特征中的部分或者全部;2)对多种特征的序列进行联合表示,得到特征表示向量hde;3)将特征表示向量hde通过分类器进行分类,得到用户的沉浸度。

6.可选地,步骤2)包括:分别将多种特征的序列进行标准化处理,使其维度相同并被归一化,构成特征数据x;将特征数据x送入门控循环时序网络gru对各个特征的序列进行时序建模,然后通过注意力层att选取输入层特征向量,得到融合后的特征表示向量hde。

7.可选地,步骤3)中采用的分类器为多层感知机,其函数表达式为:p(y) =sigmoid(mlp(hde))上式中,p(y)为得到的用户的沉浸度,sigmoid为归一化指数函数,mlp为多层感知机将特征表示向量hde回归到应的置信度数值。

8.可选地,步骤1)中的多种特征包含人机交互距离特征,且人机交互距离特征的计算函数表达式为:,上式中,f(di)为第i个用户的人机交互距离特征,x

i,1

和y

i,1

分别为第i个用户的颈部特征点的三维空间坐标的x坐标和y坐标,x

i,2

和y

i,2

分别为第i个用户的左肩部特征点的三维空间坐标的x坐标和y坐标,x

i,5

和y

i,5

分别为第i个用户的右肩部特征点的三维空间坐标的x坐标和y坐标,所述颈部特征点、左肩部特征点和右肩部特征点均为对人机交互场景下从用户的实时图像进行人体姿势估计得到,所述颈部特征点、左肩部特征点和右肩部特征点的三维空间坐标为基于点坐标及深度进行图像坐标系变换得到。

9.可选地,步骤1)中的人体姿态特征包含人体方位角特征,且人体方位角特征的计算函数表达式为:,上式中,f(αi)为第i个用户的人体方位角特征,αi为第i个用户的人体方位角,x

i,1

和y

i,1

分别为颈部特征点的三维空间坐标的x坐标和y坐标,所述颈部特征点为对人机交互场景下从用户的实时图像进行人体姿势估计得到,所述颈部特征点的三维空间坐标为基于点坐标及深度进行图像坐标系变换得到。

10.可选地,步骤1)中的头部姿势特征的计算函数表达式为:,上式中,f(hi)为第i个用户的头部姿势特征,αi为第i个用户的人体方位角,βi为第i个用户的头部角度,x

i,1

和y

i,1

分别为颈部特征点的三维空间坐标的x坐标和y坐标,x

i,k

和y

i,k

分别为任意第k个鼻部特征点的三维空间坐标的x坐标和y坐标,所述颈部特征点、第k个鼻部特征点均为对人机交互场景下从用户的实时图像进行人体姿势估计得到,所述颈部特征点、第k个鼻部特征点的三维空间坐标为基于点坐标及深度进行图像坐标系变换得到。

11.可选地,步骤1)中的唇部运动特征的计算函数表达式为:,上式中,f(lari)为第i个用户的唇部运动特征,lari为第i个用户的唇部上下距离,σ为判断唇部运动特征的阈值,lari大于等于阈值σ时判定唇部为张开、唇部运动特征为1,反之判定唇部为闭合、且唇部运动特征为0,其中第i个用户的唇部上下距离为对人机交互场景下从用户的实时图像进行唇部关键特征点定位,并基于定位得到的唇部关键特征点坐标计算得到。

12.可选地,步骤3)之后还包括将用户的沉浸度与预设阈值进行比较的步骤,若用户的沉浸度小于设定阈值、且机器人当前处于人机交互状态,则暂停或退出机器人的人机交互状态;若用户的沉浸度大于或等于设定阈值、且机器人当前处于非人机交互状态,则首先判断检测到的用户数量,若用户数量大于1则选择沉浸度最高的用户作为目标用户,若用户数量等于1则选择该用户作为目标用户,然后唤醒机器人使其进入人机交互状态以用于与目标用户进行人机交互;机器人的传感系统在人机交互状态和非人机交互状态下均保持工作状态,机器人的运动系统仅在人机交互状态下处于工作状态、在非人机交互状态下处于非工作状态。

13.此外,本发明还提供一种人机交互场景下多特征融合的沉浸度计算系统,包括相互连接的微处理器和存储器,该微处理器被编程或配置以执行所述人机交互场景下多特征融合的沉浸度计算方法的步骤。

14.此外,本发明还提供一种计算机可读存储介质,所述计算机可读存储介质中存储有计算机程序,该计算机程序用于被微处理器编程或配置以执行所述人机交互场景下多特征融合的沉浸度计算方法的步骤。

15.和现有技术相比,本发明主要具有下述优点:1、考虑到在交互前和交互中评估用户的沉浸度可以提高用户的交互体验的问题,本发明可实现人机交互场景下多特征融合的沉浸度计算,可准确的评估人与机器人的交互意愿,可有效提升人机交互场景下的交互体验。

16.2、本发明包括确定人机交互场景下从用户的实时图像提取得到的多种特征的序列,多种特征的序列包含时序信息,通过多种特征的种类(人机交互距离特征、人体姿态特征、头部姿态特征、面部姿态特征、眼部姿态特征以及唇部运动特征中的部分或者全部),结合特征的时序信息,可有效提升用户的沉浸度计算的准确度。

附图说明

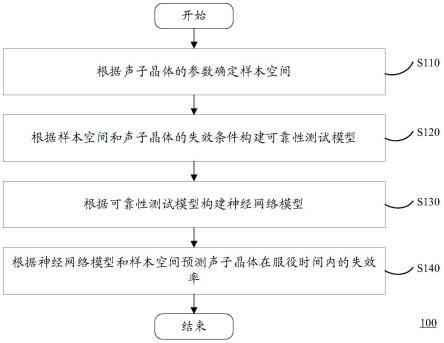

17.图1为本发明实施例方法的基本流程示意图。

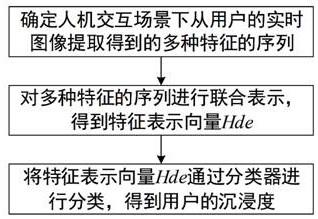

18.图2为本发明实施例方法的工作原理示意图。

19.图3为本发明实施例唇部采用的人体特征点示意图。

20.图4为本发明实施例中输入数据预处理和时序关系建模的示意图。

21.图5为本发明实施例中将沉浸度与预设阈值进行比较的流程图。

具体实施方式

22.如图1所示,本实施例人机交互场景下多特征融合的沉浸度计算方法包括:1)确定人机交互场景下从用户的实时图像提取得到的多种特征的序列,所述多种特征包含人机交互距离特征、人体姿态特征、头部姿态特征、面部姿态特征、眼部姿态特征以及唇部运动特征中的部分或者全部;2)对多种特征的序列进行联合表示,得到特征表示向量hde;3)将特征表示向量hde通过分类器进行分类,得到用户的沉浸度。

23.本实施例人机交互场景下的交互对象包括人和机器人,其中机器人可以为拟人的形态,也可以为非拟人形态,机器人包括运动系统和传感系统,其中传感系统包括传感器和

处理器,主要用于执行本实施例人机交互场景下多特征融合的沉浸度计算方法,例如本实施例中的传感器是指深度相机,但是需要说明的是,在可以满足获取多种特征的前提下,其也可以根据需要采用其他类型的传感器,或者多种传感器的组合。

24.参见图2,本实施例中步骤2)和步骤3)为用于对多种特征进行多特征融合的沉浸度计算的步骤。步骤2)对多种特征的序列进行联合表示目的是获得综合了多种特征的特征表示向量hde。因此,可根据需要采用的联合表示方法以及各类融合数据的方法,例如循环神经网络(rnn)、长短时记忆网络(lstm)、门控循环神经网络等。作为一种可选的实施方式,本实施例中步骤2)包括:分别将多种特征的序列进行标准化处理(即预处理),使其维度相同并被归一化处理到[0,1]范围内,构成特征数据x;将特征数据x送入门控循环时序网络gru对各个特征的序列进行时序建模,然后通过注意力层att选取输入层特征向量,得到融合后的特征表示向量hde,可表示为hde=att(gru(x))。由于门控循环时序网络gru比循环神经网络rnn和长短时记忆网络lstm具有更少的参数,有效缓解了序列建模中网络梯度消失和爆炸的问题,并且由于门控循环时序网络gru自身网络的参数量少,降低了模型的计算时间,实时性较高。然而模型的输入多种时序特征,注意力层att通过注意力机制可以对输入的特征赋予不同的权重,有效的选取了对沉浸度评估重要的特征序列,因此本实施例中的模型选取了门控注意力时序网络(门控循环时序网络gru和注意力层att)对不同特征进行表示和融合。需要说明的是,门控循环时序网络gru和注意力层att均为现有神经网络结构,本实施例中仅仅涉及门控循环时序网络gru和注意力层att的基本应用,并不涉及对门控循环时序网络gru和注意力层att的改进,故其实现细节在此不再详述。

[0025]

参见图4,步骤3)本质上是对特征表示向量hde进行时序关系建模的步骤。步骤3)中采用的分类器是为了实现特征表示向量hde、用户的沉浸度之间的映射,因此可根据需要采用可行的分类器模型。作为一种可选的实施方式,本实施例步骤3)中使用多层感知机将特征向量映射到输出值的维度空间,以实现实现特征表示向量hde、用户的沉浸度之间的映射,其函数表达式为:p(y) = sigmoid(mlp(hde)),上式中,p(y)为得到的用户的沉浸度,sigmoid为归一化指数函数,mlp为多层感知机将特征表示向量hde回归到应的置信度数值。需要说明的是,多层感知机为现有分类器模型,本实施例中仅仅涉及多层感知机的基本应用,并不涉及对多层感知机的改进,故其实现细节在此不再详述。

[0026]

需要说明的是,步骤1)确定人机交互场景下从用户的实时图像提取得到的多种特征的序列中的“确定”可以理解为选择或输入,即在步骤1)之前需要执行人机交互场景下从用户的实时图像提取得到的多种特征的序列的操作。

[0027]

本实施例中,人机交互场景下从用户的实时图像为采用深度相机拍摄得到的包含rgb图像ir和深度信息构成的深度图像id的待检测图像,在需要提取多种特征之前,需要将rgb图像ir和深度图像id进行对齐,得到具有深度信息的彩色图像is。此外也可以采用深度相机直接获取具有深度信息的彩色图像is。在此从基础上,利用在通过相机自身的成像模型及原理,利用图像变换可以得到各像素点相对于机器人所在坐标系的位置(三维空间坐标);然后,根据人体、头部、面部、眼部、唇部的特征点,即可提取得到人机交互距离特征、人体姿态特征、头部姿态特征、面部姿态特征、眼部姿态特征以及唇部运动特征。参见图2,作

为一种可选的实施方式,本实施例中具体采用了人机交互距离特征、人体方位角特征(人体姿态特征)、头部姿势特征和唇部运动特征四种特征,得到的将特征数据x可表示为x={ f(di), f(αi), f(hi), f(lari)},其中f(di)为第i个用户的人机交互距离特征,f(αi)为第i个用户的人体方位角特征,f(hi)为第i个用户的头部姿势特征,f(lari)为第i个用户的唇部运动特征。

[0028]

对于某时刻采集的图像帧序列is={i

sm

|m=,1,2,3,...,t},其中i

sm

为任意第m个图像帧,人机交互距离特征的具体表示为f(di)={( f(di))m|m=,1,2,3,...,t},( f(di))m为第m个图像帧i

sm

对应的人机交互距离特征,人体方位角特征的具体表示为f(αi)={( f(αi))m|m=,1,2,3,...,t},( f(αi))m为第m个图像帧i

sm

对应的人体方位角特征,头部姿势特征的具体表示为f(hi)={( f(hi))m|m=,1,2,3,...,t},( f(hi))m为第m个图像帧i

sm

对应的头部姿势特征,唇部运动特征的具体表示为f(lari)={( f(lari))m|m=,1,2,3,...,t},( f(lari))m为第m个图像帧i

sm

对应的唇部运动特征,其中t为图像帧的数量。

[0029]

本实施例中,步骤1)中的多种特征包含人机交互距离特征,且人机交互距离特征的计算函数表达式为:,上式中,f(di)为第i个用户的人机交互距离特征,x

i,1

和y

i,1

分别为第i个用户的颈部特征点的三维空间坐标的x坐标和y坐标,x

i,2

和y

i,2

分别为第i个用户的左肩部特征点的三维空间坐标的x坐标和y坐标,x

i,5

和y

i,5

分别为第i个用户的右肩部特征点的三维空间坐标的x坐标和y坐标,颈部特征点、左肩部特征点和右肩部特征点均为对人机交互场景下从用户的实时图像进行人体姿势估计得到,颈部特征点、左肩部特征点和右肩部特征点的三维空间坐标为基于点坐标及深度进行图像坐标系变换得到。f(di)越大时表明人与机器人的交互距离越,反之当f(di)越小时人机交互距离越小。

[0030]

本实施例中,具体采用了人体关键点检测框架lightweight openpose进行人体姿势估计,得到18个人体的关键点ha:ha={(u

ij

,v

ij

) | i=1,2,3,

…

,n;j=1,2,3,

…

,18},其中n代表用户的数量,j代表所提取的关键点数量。前文的颈部特征点、左肩部特征点和右肩部特征点,均为18个人体的关键点ha的关键点,具体地,分别为18个人体的关键点ha中的第1、2和5个关键点,其在rgb图像ir中的坐标分别可表示为:hc={(u

i1

,v

i1

),(u

i2

,v

i2

),(u

i5

,v

i5

)},通过图像坐标系变换得到的三维空间坐标分别为:hc={(x

i1

,y

i1

,z

i1

),(x

i2

,y

i2

,z

i2

),(x

i5

,y

i5

, z

i2

)}。

[0031]

本实施例中,步骤1)中的人体姿态特征包含人体方位角特征,且人体方位角特征的计算函数表达式为:,上式中,f(αi)为第i个用户的人体方位角特征,αi为第i个用户的人体方位角,x

i,1

和y

i,1

分别为颈部特征点的三维空间坐标的x坐标和y坐标,所述颈部特征点为对人机交互

场景下从用户的实时图像进行人体姿势估计得到,所述颈部特征点的三维空间坐标为基于点坐标及深度进行图像坐标系变换得到。

[0032]

头部姿势反应了用户的是否聚焦于机器人,从人脸特征点中选取鼻子上的特征点(鼻部特征点)进行头部姿势估计。本实施例中,步骤1)中的头部姿势特征的计算函数表达式为:,上式中,f(hi)为第i个用户的头部姿势特征,αi为第i个用户的人体方位角,βi为第i个用户的头部角度,x

i,1

和y

i,1

分别为颈部特征点的三维空间坐标的x坐标和y坐标,x

i,k

和y

i,k

分别为任意第k个鼻部特征点的三维空间坐标的x坐标和y坐标,所述颈部特征点、第k个鼻部特征点均为对人机交互场景下从用户的实时图像进行人体姿势估计得到,所述颈部特征点、第k个鼻部特征点的三维空间坐标为基于点坐标及深度进行图像坐标系变换得到。

[0033]

本实施例中,具体采用了开源人脸库dlib的人脸特征点检测模型进行人脸特征点检测,得到68个人脸特征点fa:fa={(u

ij

,v

ij

) | i=1,2,3,

…

,n;j=1,2,3,

…

,68},其中,n 表示用户的个数,i表示用户,j表示人脸特征点的序号。

[0034]

本实施例中,步骤1)中的唇部运动特征的计算函数表达式为:,上式中,f(lari)为第i个用户的唇部运动特征,lari为第i个用户的唇部上下距离,σ为判断唇部运动特征的阈值,lari大于等于阈值σ时判定唇部为张开、唇部运动特征为1,反之判定唇部为闭合、且唇部运动特征为0,其中第i个用户的唇部上下距离为对人机交互场景下从用户的实时图像进行唇部关键特征点定位,并基于定位得到的唇部关键特征点坐标计算得到。通过唇部的运动判断用户是否说话,反映了其与机器人的交互意图,本实施例中从人脸特征点中选取唇部区域8个关键点来计算唇部上下运动的距离,即:,上式中,fkk表示第k个人脸特征点,k取49,51,52,53,55,57,58,59,即选取唇部区域8个人脸特征点来计算唇部上下运动的距离。参见图3,其中k取49为左侧嘴角的人脸特征点、k取55为右侧嘴角的人脸特征点,k取51~53为上唇部中部的人脸特征点及其两侧的人脸特征点,k取57~59为下唇部中部的人脸特征点及其两侧的人脸特征点。唇部上下运动的距离即为人脸特征点fk

52

和fk

58

之间的带箭头线段所示;此外,唇部左右运动的距离即为人脸特征点fk

49

和fk

55

之间的带箭头线段所示,也可以作为一种可选的唇部运动特征。

[0035]

参见图4,本实施例中人机交互距离特征、人体方位角特征、头部姿势特征和唇部运动特征四种特征的序列分别记为x

1,1

~x

t,1

、x

1,2

~x

t,2

、x

1,3

~x

t,3

、x

1,4

~x

t,4

,其中的t表示序列的长度。分别将多种特征的序列进行标准化处理,使其维度相同并被归一化,例如图4中共生成构成了b组特征数据x1~xb;将特征数据x1~xb送入门控循环时序网络gru(gate recurrent unit)对各个特征的序列进行时序建模,然后通过注意力层att选取输入层特征向量,得到融合后的特征表示向量hde。最终,再通过多层感知机可获得对应的沉浸度。

[0036]

参见图2和图5,本实施例步骤3)之后还包括将用户的沉浸度与预设阈值进行比较

的步骤,若用户的沉浸度小于设定阈值、且机器人当前处于人机交互状态,则暂停或退出机器人的人机交互状态;若用户的沉浸度大于或等于设定阈值、且机器人当前处于非人机交互状态,则首先判断检测到的用户数量,若用户数量大于1则选择沉浸度最高的用户作为目标用户,若用户数量等于1则选择该用户作为目标用户,然后唤醒机器人使其进入人机交互状态以用于与目标用户进行人机交互;机器人的传感系统在人机交互状态和非人机交互状态下均保持工作状态,机器人的运动系统仅在人机交互状态下处于工作状态、在非人机交互状态下处于非工作状态。通过上述方式,在人机交互前,机器人通过对周围环境中用户沉浸度的评估,选取沉浸度高的用户并为其主动提供服务,有效的避免了机器人对不同沉浸度的用户做出相同的反应和在嘈杂环境中语音的误唤醒,提高了机器人主动交互的意愿;在人机交互中,机器人通过持续监控用户沉浸度来判断用户的交互意愿,当用户的沉浸度低时减少或者暂停机器本身的交互行为和意愿,从而避免无效的交互,提高机器人的工作效率、降低机器人的工作能耗。在复杂的人机交互场景下可以主动的判断用户沉浸度的高低来调整自身的交互状态,有效的提升了人机交互的自然度。

[0037]

综上所述,本实施例通过门控注意力时序网路对用户面部的多种特征进行建模、融合,评估交互场景下用户的沉浸度得分。进一步地,可在在人机交互前,机器人通过对周围环境中用户沉浸度的评估,选取沉浸度高的用户并为其主动提供服务,有效的避免了机器人对不同沉浸度的用户做出相同的反应和在嘈杂环境中语音的误唤醒,提高了机器人主动交互的意愿;在人机交互中,机器人通过持续监控用户沉浸度来判断用户的交互意愿,当用户的沉浸度低时减少或者暂停机器本身的交互行为和意愿,从而避免无效的交互,提高机器人的工作效率,降低机器人的工作能耗。

[0038]

此外,本实施例还提供一种人机交互场景下多特征融合的沉浸度计算系统,包括相互连接的微处理器和存储器,该微处理器被编程或配置以执行前述人机交互场景下多特征融合的沉浸度计算方法的步骤。进一步地,还可以将通过数据采集卡与微处理器相连的深度相机也视为沉浸度计算系统的一部分,使得机器人的传感系统实质上构成前述的沉浸度计算系统。进一步地,考虑到机器人系统包括相互连接的机器人的传感系统和机器人的运动系统,还可以将完整的机器人系统实质上构成前述的沉浸度计算系统。其中,机器人的运动系统包括带有驱动关节(例如舵机)的机器人本体,以及设于机器人本体中的控制单元,控制单元包括控制器和驱动电路板,驱动电路板与各个驱动关节的驱动电机相连。机器人本体的形态不做具体的限制,可为拟人形状,也可以为非拟人形状。

[0039]

此外,本实施例还提供一种计算机可读存储介质,所述计算机可读存储介质中存储有计算机程序,该计算机程序用于被微处理器编程或配置以执行前述人机交互场景下多特征融合的沉浸度计算方法的步骤。

[0040]

本领域内的技术人员应明白,本技术的实施例可提供为方法、系统、或计算机程序产品。因此,本技术可采用完全硬件实施例、完全软件实施例、或结合软件和硬件方面的实施例的形式。而且,本技术可采用在一个或多个其中包含有计算机可用程序代码的计算机可读存储介质(包括但不限于磁盘存储器、cd-rom、光学存储器等)上实施的计算机程序产品的形式。本技术是参照根据本技术实施例的方法、设备(系统)、和计算机程序产品的流程图和/或方框图来描述的。应理解可由计算机程序指令实现流程图和/或方框图中的每一流程和/或方框、以及流程图和/或方框图中的流程和/或方框的结合。可提供这些计算机程序

指令到通用计算机、专用计算机、嵌入式处理机或其他可编程数据处理设备的处理器以产生一个机器,使得通过计算机或其他可编程数据处理设备的处理器执行的指令产生用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的装置。这些计算机程序指令也可存储在能引导计算机或其他可编程数据处理设备以特定方式工作的计算机可读存储器中,使得存储在该计算机可读存储器中的指令产生包括指令装置的制造品,该指令装置实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能。这些计算机程序指令也可装载到计算机或其他可编程数据处理设备上,使得在计算机或其他可编程设备上执行一系列操作步骤以产生计算机实现的处理,从而在计算机或其他可编程设备上执行的指令提供用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的步骤。

[0041]

以上所述仅是本发明的优选实施方式,本发明的保护范围并不仅局限于上述实施例,凡属于本发明思路下的技术方案均属于本发明的保护范围。应当指出,对于本技术领域的普通技术人员来说,在不脱离本发明原理前提下的若干改进和润饰,这些改进和润饰也应视为本发明的保护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。