技术特征:

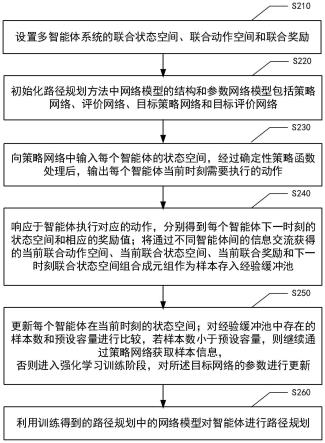

1.一种基于深度强化学习的多智能体路径规划方法,包括:设置多智能体系统的联合状态空间、联合动作空间;针对路径规划问题设计奖励函数,生成联合奖励;初始化路径规划方法中网络模型的结构和参数,所述网络模型包括策略网络、评价网络、目标策略网络和目标评价网络,其中所述目标策略网络和所述策略网络的结构相同但参数不同,所述目标评价网络和所述评价网络的结构相同但参数不同;向所述策略网络中输入每个所述智能体的状态空间,经过确定性策略函数处理后,输出每个所述智能体当前时刻需要执行的动作;响应于所述智能体执行了对应的动作,分别得到每个所述智能体下一时刻的状态空间和相应的奖励值;将通过不同所述智能体间的信息交流获得的当前联合动作空间、当前联合状态空间、当前联合奖励和下一时刻联合状态空间组合成元组作为样本存入经验缓冲池;更新每个所述智能体在当前时刻的状态空间;对所述经验缓冲池中存在的样本数和预设容量进行比较,若样本数小于预设容量,则继续采样,通过所述策略网络获取样本信息,否则进入强化学习训练阶段,通过多步回报方法对所述评价网络的参数进行更新;从所述经验缓冲池中随机抽取k批轨迹长度为多步回报值l的样本,对所述评价网络进行训练,输入未来时刻的联合状态空间、联合动作空间和奖励,输出相应的目标联合状态动作值;利用最小损失函数更新所述评价网络的参数;利用反向梯度下降法更新所述策略网络的参数;利用软更新方法更新所述目标策略网络和所述目标评价网络的参数;利用训练得到的所述路径规划中的网络模型对所述智能体进行路径规划。2.根据权利要求1所述的方法,其特征在于,所述设置智能体的联合状态空间、联合动作空间和联合奖励包括:构建用于多智能体路径规划的马尔科夫博弈模型,其中,所述马尔科夫模型用五元组<n,s,a,p,r>描述,其中n={1,...,n}表示多个智能体的集合;s表示联合状态空间;a表示联合动作空间;r表示联合奖励;p表示所有所述智能体在当前状态采取联合动作到达下一状态的概率值。3.根据权利要求1所述的方法,其中,在构建用于多智能体路径规划的马尔科夫博弈模型之前,所述方法还包括:获取多智能体系统的初始环境信息,其中,所述初始环境信息包括所述多智能体系统中智能体的数量,每个所述智能体的起始位置坐标和对应的目标点的位置坐标,障碍物的位置坐标;将所述多智能体系统中的智能体转化为质点模型,其中所述质点模型包括对应于多个所述智能体的多个质点,所述质点的当前坐标对应于所述智能体当前位置坐标,所述质点的终点坐标对应于所述智能体对应的目标点的位置坐标。4.根据权利要求1所述的方法,其中,所述策略网络为全连接神经网络,用于基于输入的所述智能体的与当前状态对应的状态空间,输出所述智能体在当前时刻需要执行的动作。5.根据权利要求1所述的方法,其中,所述评价网络为全连接神经网络,用于基于输入的所有所述智能体的联合状态空间向量和根据所有所述智能体自身各自的策略网络得到

的联合动作空间,输出所述智能体在当前时刻的联合状态动作值。6.根据权利要求1所述的方法,其中,所述输入未来时刻的联合状态空间、联合动作空间和奖励,输出相应的目标联合状态动作值包括:根据未来时刻的联合状态空间、联合动作空间和奖励,利用多步学习方法更新当前时刻所述智能体的目标联合状态动作值。7.根据权利要求6所述的方法,其中,根据未来时刻的联合状态空间、联合动作空间和奖励,利用多步学习方法更新当前时刻所述智能体的目标联合状态动作值包括:输入j时刻到j l时刻中各时刻上述智能体的奖励值、上述j l时刻的联合状态空间、联合动作空间和折扣系数,输出当前时刻的目标联合状态动作值,其中,上述目标联合状态动作值表征l步长中的累积奖励与j l时刻的目标联合状态动作值乘以上述折扣系数的和。8.一种电子设备,包括:至少一个处理器;以及与所述至少一个处理器通信连接的存储器;其中,所述存储器存储有可被所述至少一个处理器执行的指令,所述指令被所述至少一个处理器执行,以使所述至少一个处理器能够执行权利要求1-7中任一项所述的方法。9.一种存储有计算机指令的非瞬时计算机可读存储介质,其中,所述计算机指令用于使所述计算机执行根据权利要求1-7中任一项所述的方法。10.一种计算机程序产品,包括计算机程序,所述计算机程序在被处理器执行时实现根据权利要求1-7中任一项所述的方法。

技术总结

本公开提供了一种基于深度强化学习的多智能体路径规划方法,包括:设置多智能体系统的联合状态空间、联合动作空间;针对路径规划问题设计奖励函数,生成联合奖励;初始化路径规划方法中网络模型的结构和参数,将通过不同智能体间的信息交流获得的当前联合动作空间、当前联合状态空间、当前联合奖励和下一时刻联合状态空间组合成元组作为样本存入经验缓冲池;更新每个智能体在当前时刻的状态空间;对经验缓冲池中存在的样本数和预设容量进行比较,若样本数小于预设容量,则继续采样,否则进入强化学习训练阶段,通过多步回报方法对网络模型的参数进行更新;利用训练得到的网络模型实现多智能体路径规划。实现多智能体路径规划。实现多智能体路径规划。

技术研发人员:郑煜明 陈松 鲁华祥

受保护的技术使用者:中国科学技术大学

技术研发日:2022.04.29

技术公布日:2022/7/29

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。