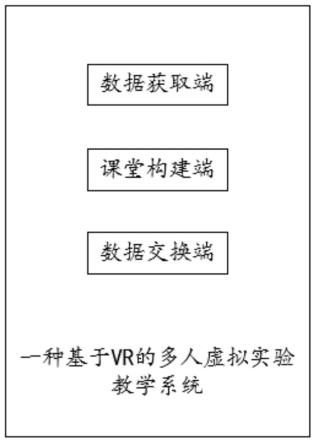

一种基于vr的多人虚拟实验教学系统

技术领域

1.本发明涉及虚拟现实技术领域,特别涉及一种基于vr的多人虚拟实验教学系统。

背景技术:

2.目前,vr技术是一种结合计算机图像学和传感器技术以及人工智能的新技术,目的是提高人机交换的功能,达到真实的视觉、触觉、听觉体验效果。目前由于信息技术的发展,在学校中已经存在很多线上异地教学的案例,但是现存的线上异地教学大多采用视频教学方式,或者在线视频通话方式进行教学,由于这种教学方式与传统教学方式相比,师生互动大大减少,而且不利于老师在线监控学生的上课实际状态,并且对于学生来说采用视频教学方式或者视频通话方式不同于在校上课视频的环境,从而使得上课积极性以及上课体验有所下降,从而导致教学效果差、学生学习效率不高。

3.因此,本发明提出一种基于vr的多人虚拟实验教学系统。

技术实现要素:

4.本发明提供一种基于vr的多人虚拟实验教学系统,用以基于vr技术构建出动态虚拟课堂,从而还原出传统实际教学课堂,实现多人异地参与教学过程,并且使得教学过程的体验更加真实和更具参与感,提高了教学效率。

5.本发明提出一种基于vr的多人虚拟实验教学系统,包括:

6.数据获取端,用于获取教师端和学生端感应到的传感数据;

7.课堂构建端,用于基于所述传感数据构建出动态虚拟课堂,并将所述动态虚拟课堂传输至所有在线教师端和在线学生端的vr设备中进行展示;

8.数据交换端,用于实时接收所述教师端和所述学生端输入的互动信息,并将所述互动信息同步于所有在线教师端和在线学生端的vr设备中进行展示。

9.优选的,所述数据获取端,包括:

10.数据感应模块,用于基于设置在用户身上的感应设备,获取所述感应设备之间的感应数据;

11.数据分析模块,用于实时分析所述感应数据获得对应用户的传感数据;

12.其中,所述用户包括:教师端用户和学生端用户。

13.优选的,所述课堂构建端,包括:

14.模型构建模块,用于基于所述传感数据构建出对应的用户虚拟动态模型;

15.数据融合模块,用于将所述用户虚拟动态模型与预设虚拟课堂空间进行融合,获得对应的动态虚拟课堂;

16.同步传输模块,用于将所述动态虚拟课堂同步于所有在线教师端和在线学生端的vr设备中进行展示。

17.优选的,所述数据融合模块,包括:

18.第一解析单元,用于解析所述用户虚拟动态模型获得对应的用户虚拟动态数据;

19.数据获取单元,用于获取所述预设虚拟课堂空间对应的课堂空间三维数据;

20.数据融合单元,用于将所述用户虚拟动态数据和所述课堂空间三维数据进行融合,获得对应的虚拟课堂动态三维数据;

21.虚拟构建单元,用于基于所述虚拟课堂动态三维数据构建出对应的动态虚拟课堂。

22.优选的,所述同步传输模块,包括:

23.特征获取单元,用于获取对应用户在当前佩戴方式下对应的瞳孔特征集合;

24.第一确定单元,用于获取对应用户的人眼图像,基于所述人眼图像和所述瞳孔特征集合分析出对应的视线角度,基于所述视线角度确定出对应的第一视野范围;

25.第二确定单元,用于基于所述传感数据确定出对应的第二视野范围;

26.第三确定单元,用于基于所述第一视野范围和所述第二视野范围确定出对应的最终视野范围;

27.画面确定单元,用于基于vr设备上的定位点三维数据与所述虚拟课堂动态三维数据,确定出对应的显示画面;

28.画面传输单元,用于将所述显示画面传输至对应用户端的vr设备中进行展示;

29.其中,所述用户端包括:在线教师端和在线学生端。

30.优选的,所述特征获取单元,包括:

31.展示子单元,用于向对应用户端的vr设备中展示包含预设个数的虚拟定位点的预设虚拟画面;

32.第一获取子单元,用于获取对应用户在当前佩戴方式下注视每个虚拟定位点时对应的人眼图像;

33.特征分析子单元,用于分析所述人眼图像获得对应的瞳孔特征,获得对应的瞳孔特征集合。

34.优选的,所述第一确定单元,包括:

35.第二获取子单元,用于实时获取对应用户端的实时人眼图像,分析所述实时人眼图像获得对应的实时瞳孔特征;

36.匹配子单元,用于计算出所述瞳孔特征集合中包含的每个瞳孔特征与所述实时瞳孔特征之间的匹配度,按照匹配度从大到小的顺序将所述瞳孔特征集合中的瞳孔特征进行排序,获得对应的瞳孔特征匹配集合;

37.筛选子单元,用于从所述瞳孔特征匹配集合中筛选出前第一数量个瞳孔特征,获得第一特征集合和对应的第一虚拟定位点集合,并确定出所述第一虚拟定位点集合中包含的每个第一虚拟定位点在所述预设虚拟画面中对应的第一坐标值;

38.第一计算子单元,用于基于所述第一坐标值计算出所述第一虚拟定位点在所述第一虚拟定位点集合中对应的集群度;

39.第一判断子单元,用于判断每个第一虚拟定位点对应的集群度是否都大于集群度阈值,若是,则基于所述第一虚拟定位点集合中包含的每个第一虚拟定位点对应的第一坐标值计算出当前视线终点对应的第二坐标值;

40.第二判断子单元,用于当存在所述第一虚拟定位点对应的集群度不大于集群度阈值时,则判断所述第一虚拟定位点集合中是否存在至少两个第一虚拟定位坐标点对应的第

一坐标值差值大于坐标差阈值;

41.第一确定子单元,用于当所述第一虚拟定位点集合中存在至少两个第一虚拟定位坐标点对应的第一坐标值差值大于坐标差阈值时,则基于第一坐标值差值大于坐标差阈值的一对第一虚拟定位坐标点确定两个子虚拟定位点集合,基于所述子虚拟定位点集合中包含的第二虚拟定位点对应的匹配度计算出所述子虚拟定位点集合对应的筛选权重值,基于较大筛选权重值对应的子虚拟定位点集合中包含的第二虚拟定位点对应的第一坐标值计算出当前视线终点对应的第二坐标值;

42.第二确定子单元,用于当所述第一虚拟定位点集合中不存在两个第一虚拟定位坐标点对应的第一坐标值差值大于坐标差阈值时,则删除所述第一虚拟定位点集合中的离群点,基于所述第一虚拟定位点集合中剩余保留的第三虚拟定位点对应的第一坐标值计算出当前视线终点对应的第二坐标值;

43.第三确定子单元,用于基于所述第二坐标值确定出对应的视线角度;

44.第四确定子单元,用于基于所述视线角度确定出对应的第一视野范围。

45.优选的,所述第二确定单元,包括:

46.第三获取子单元,用于获取设置在对应用户头部右侧的第一感应设备和设置在对应用户颈部的第二感应设备之间的第一头颈传感数据以及设置在对应用户头部左侧的第三感应设备和所述第二感应设备之间的第二头颈传感数据;

47.第四获取子单元,用于获取所述第一感应设备和对应vr设备之间的第二传感数据;

48.第五确定子单元,用于获取对应用户的第一预设头颈传感数据和第二预设头颈传感数据,基于所述第一预设头颈传感数据和所述第一头颈传感数据确定出对应的第一头部移动向量,基于所述第二预设头颈传感数据和所述第二头颈传感数据确定出对应的第二头部移动向量;

49.角度确定子单元,用于基于所述第一头部移动向量和所述第二头部移动向量确定出对应的头部移动角度;

50.第六确定子单元,用于获取预设设备传感数据,基于所述预设设备传感数据和所述第二传感数据确定出对应的设备偏移向量;

51.距离获取子单元,用于获取所述vr设备显示画面中心点与对应用户双眼视觉中心之间的第一距离;

52.第二计算子单元,用于基于所述设备偏移向量和所述第一距离计算出对应的设备偏移角度;

53.第三计算子单元,用于基于所述头部移动角度和所述设备偏移角度计算出对应的视野偏移角度;

54.第七确定子单元,用于基于vr设备的预设视觉范围和所述视野偏移角度,确定出对应的第二视野范围。

55.优选的,所述数据交换端,包括:

56.第一接收模块,用于接收所述教师端输入的第一互动信息;

57.资源投放模块,用于基于所述第一互动信息向所有在线学生端投放对应的教学资源;

58.第二接收模块,用于接收所述学生端输入的第二互动信息;

59.信息分析模块,用于分析评估所述第二互动信息,获得对应的反馈评估结果;

60.结果传输模块,用于将所述反馈评估结果传输至所述在线教师端和所述在线学生端的vr设备中进行展示;

61.其中,所述互动信息包括:第一互动信息和第二互动信息。

62.优选的,所述结果传输模块,包括:

63.第一传输单元,用于将所述反馈评估结果传输至对应在线学生端的vr设备中进行展示;

64.第二传输单元,用于将所有在线学生对应的反馈评估结果进行汇总,获得对应的评估汇总结果,将所述评估汇总结果传输至所述在线教师端的vr设备中进行展示。

65.本发明的其它特征和优点将在随后的说明书中阐述,并且,部分地从说明书中变得显而易见,或者通过实施本发明而了解。本发明的目的和其他优点可通过在所写的说明书、权利要求书、以及附图中所特别指出的结构来实现和获得。

66.下面通过附图和实施例,对本发明的技术方案做进一步的详细描述。

附图说明

67.附图用来提供对本发明的进一步理解,并且构成说明书的一部分,与本发明的实施例一起用于解释本发明,并不构成对本发明的限制。在附图中:

68.图1为本发明实施例中一种基于vr的多人虚拟实验教学系统示意图;

69.图2为本发明实施例中一种数据获取端示意图;

70.图3为本发明实施例中一种课堂构建端示意图;

71.图4为本发明实施例中一种数据融合模块示意图;

72.图5为本发明实施例中一种同步传输模块示意图;

73.图6为本发明实施例中一种特征获取单元示意图;

74.图7为本发明实施例中一种第一确定单元示意图;

75.图8为本发明实施例中一种第二确定单元示意图;

76.图9为本发明实施例中一种数据交换端示意图;

77.图10为本发明实施例中一种结果传输模块示意图。

具体实施方式

78.以下结合附图对本发明的优选实施例进行说明,应当理解,此处所描述的优选实施例仅用于说明和解释本发明,并不用于限定本发明。

79.实施例1:

80.本发明提出了一种基于vr的多人虚拟实验教学系统,参考图1,包括:

81.数据获取端,用于获取教师端和学生端感应到的传感数据;

82.课堂构建端,用于基于所述传感数据构建出动态虚拟课堂,并将所述动态虚拟课堂传输至所有在线教师端和在线学生端的vr设备中进行展示;

83.数据交换端,用于实时接收所述教师端和所述学生端输入的互动信息,并将所述互动信息同步于所有在线教师端和在线学生端的vr设备中进行展示。

84.该实施例中,教师端即为教师登录的客户端。

85.该实施例中,学生端即为学生登录的客户端。

86.该实施例中,传感数据即为分析基于设置在对应教师或者学生身上的感应设备获得的感应数据之间的关系获得的数据。

87.该实施例中,动态虚拟课堂即为包含教师和学生实时动态动作的vr虚拟课堂。

88.该实施例中,在线教师端即为当前在线的教师客户端。

89.该实施例中,在线学生端即为当前在线的学生客户端。

90.该实施例中,vr设备即为向对应用户展示虚拟空间画面的设备。

91.该实施例中,互动信息即为教师端或者学生端输入的信息。

92.以上技术的有益效果为:基于vr技术构建出动态虚拟课堂,从而还原出传统实际教学课堂,实现多人异地参与教学过程,并且使得教学过程的教学体验和上课体验更加真实和更具参与感,提高了教学效率。

93.实施例2:

94.在实施例1的基础上,所述数据获取端,参考图2,包括:

95.数据感应模块,用于基于设置在用户身上的感应设备,获取所述感应设备之间的感应数据;

96.数据分析模块,用于实时分析所述感应数据获得对应用户的传感数据;

97.其中,所述用户包括:教师端用户和学生端用户。

98.该实施例中,感应设备即为设置在用户人体固定位置上的用于互相感应的设备。

99.该实施例中,感应数据即为基于设置在用户身上的感应设备获取的感应设备之间相互感应的数据。

100.该实施例中,传感数据即为感应设备之间的感应数据的变化数据。

101.以上技术的有益效果为:基于设置在用户身上的感应设备可以获取对应用户的传感数据,进而为后续确定出对应用户的动作数据并构建出动态虚拟课堂提供了数据基础。

102.实施例3:

103.在实施例1的基础上,所述课堂构建端,参考图3,包括:

104.模型构建模块,用于基于所述传感数据构建出对应的用户虚拟动态模型;

105.数据融合模块,用于将所述用户虚拟动态模型与预设虚拟课堂空间进行融合,获得对应的动态虚拟课堂;

106.同步传输模块,用于将所述动态虚拟课堂同步于所有在线教师端和在线学生端的vr设备中进行展示。

107.该实施例中,用户虚拟动态模型即为基于传感数据构建出的对应用户的人体动态模型。

108.该实施例中,将所述用户虚拟动态模型与预设虚拟课堂空间进行融合,包括:基于对应用户在预设虚拟课堂空间中的基准点(例如用户臀部与座椅的接触点),将用户虚拟动态模型与预设虚拟课堂空间进行融合。

109.该实施例中,预设虚拟课堂空间即为预先准备的虚拟课堂三维空间。

110.以上技术的有益效果为:通过将用户对应的传感数据构建出对应的用户虚拟动态模型,将对应的用户虚拟动态模型与预设虚拟课堂空间进行融合,实现将所有实时获取的

在线学生和在先教师的人体动态模型融合在预设的虚拟课堂空间中,从而让课堂中的所有参与者都参与到虚拟课堂中,实现了多人异地同步课堂,提高了课堂体验。

111.实施例4:

112.在实施例3的基础上,所述数据融合模块,参考图4,包括:

113.第一解析单元,用于解析所述用户虚拟动态模型获得对应的用户虚拟动态数据;

114.数据获取单元,用于获取所述预设虚拟课堂空间对应的课堂空间三维数据;

115.数据融合单元,用于将所述用户虚拟动态数据和所述课堂空间三维数据进行融合,获得对应的虚拟课堂动态三维数据;

116.虚拟构建单元,用于基于所述虚拟课堂动态三维数据构建出对应的动态虚拟课堂。

117.该实施例中,用户虚拟动态数据即为解析获得的用户虚拟动态模型中的数据。

118.该实施例中,课堂空间三维数据即为预设虚拟课堂空间对应的三维空间数据。

119.该实施例中,将所述用户虚拟动态数据和所述课堂空间三维数据进行融合即为:基于对应用户在课堂空间三维数据中的基准点坐标值(例如用户臀部与座椅的接触点坐标值),将用户虚拟动态数据与课堂空间三维数据进行融合。

120.该实施例中,虚拟课堂动态三维数据即为将用户虚拟动态数据和课堂空间三维数据进行融合后获得的动态三维数据。

121.以上技术的有益效果为:基于将用户虚拟动态模型中对应的用户虚拟动态数据和用户虚拟动态数据进行融合,获得了虚拟课堂动态三维数据,基于虚拟课堂动态三维数据还原出了动态虚拟课堂,实现将所有实时获取的在线学生和在先教师的人体动态模型融合在预设的虚拟课堂空间中,从而让课堂中的所有参与者都参与到虚拟课堂中,实现了多人异地同步课堂,提高了课堂体验。

122.实施例5:

123.在实施例4的基础上,所述同步传输模块,参考图5,包括:

124.特征获取单元,用于获取对应用户在当前佩戴方式下对应的瞳孔特征集合;

125.第一确定单元,用于获取对应用户的人眼图像,基于所述人眼图像和所述瞳孔特征集合分析出对应的视线角度,基于所述视线角度确定出对应的第一视野范围;

126.第二确定单元,用于基于所述传感数据确定出对应的第二视野范围;

127.第三确定单元,用于基于所述第一视野范围和所述第二视野范围确定出对应的最终视野范围;

128.画面确定单元,用于基于vr设备上的定位点三维数据与所述虚拟课堂动态三维数据,确定出对应的显示画面;

129.画面传输单元,用于将所述显示画面传输至对应用户端的vr设备中进行展示;

130.其中,所述用户端包括:在线教师端和在线学生端。

131.该实施例中,瞳孔特征集合即为对应用户在当前佩戴方式下对应的瞳孔轮廓坐标点构成的集合。

132.该实施例中,人眼图像即为包含对应用户人眼的图像。

133.该实施例中,视线角度即为对应用户的视线与正前方视线之间的夹角。

134.该实施例中,第一视野范围即为基于对应用户的视线角度确定出的视野范围(用

角度范围表示)。

135.该实施例中,第二视野范围即为基于对应用户的传感数据确定出的视野范围。

136.该实施例中,最终视野范围即为所述第一视野范围对应的视野角度加上第二视野范围对应的视野角度的和对应的视野范围。

137.该实施例中,定位点三维数据即为vr设备在动态虚拟课堂对应的三维空间中的三维坐标点。

138.该实施例中,显示画面即为基于定位点三维坐标和虚拟课堂动态三维数据确定出在对应vr设备中显示的画面。

139.以上技术的有益效果为:通过基于瞳孔特征对对应用户视线角度进行计算以及基于传感数据确定出vr设备偏移造成的视野偏移范围,精准地确定出对应用户的视野范围,实现将动态虚拟课堂精准地同步传输至对应用户的vr设备中,使得课堂画面基于vr设备更加真实地还原到用户眼中,提高了课堂的参与性和体验感。

140.实施例6:

141.在实施例5的基础上,所述特征获取单元,参考图6,包括:

142.展示子单元,用于向对应用户端的vr设备中展示包含预设个数的虚拟定位点的预设虚拟画面;

143.第一获取子单元,用于获取对应用户在当前佩戴方式下注视每个虚拟定位点时对应的人眼图像;

144.特征分析子单元,用于分析所述人眼图像获得对应的瞳孔特征,获得对应的瞳孔特征集合。

145.该实施例中,预设个数具体根据预设虚拟画面的显示分辨率等参数确定。

146.该实施例中,虚拟定位点即为均匀分布在预设虚拟画面中的亮斑。

147.该实施例中,预设虚拟画面预先设置的在上课前在vr设备中显示的用于获取用户瞳孔特征集合的画面。

148.该实施例中,瞳孔特征即为对应用户在当前佩戴方式下注视对应虚拟定位点时对应的人眼图像中的瞳孔轮廓坐标点。

149.以上技术的有益效果为:通过获取对应用户在注视每个虚拟定位点时对应的瞳孔特征,可以获得对应用户在注视vr设备中显示画面不同位置时的瞳孔特征,进而为后续精准确定出对应用户的视野范围并确定出对应vr设备中的显示画面提供了重要基础。

150.实施例7:

151.在实施例5的基础上,所述第一确定单元,参考图7,包括:

152.第二获取子单元,用于实时获取对应用户端的实时人眼图像,分析所述实时人眼图像获得对应的实时瞳孔特征;

153.匹配子单元,用于计算出所述瞳孔特征集合中包含的每个瞳孔特征与所述实时瞳孔特征之间的匹配度,按照匹配度从大到小的顺序将所述瞳孔特征集合中的瞳孔特征进行排序,获得对应的瞳孔特征匹配集合;

154.筛选子单元,用于从所述瞳孔特征匹配集合中筛选出前第一数量个瞳孔特征,获得第一特征集合和对应的第一虚拟定位点集合,并确定出所述第一虚拟定位点集合中包含的每个第一虚拟定位点在所述预设虚拟画面中对应的第一坐标值;

155.第一计算子单元,用于基于所述第一坐标值计算出所述第一虚拟定位点在所述第一虚拟定位点集合中对应的集群度;

156.第一判断子单元,用于判断每个第一虚拟定位点对应的集群度是否都大于集群度阈值,若是,则基于所述第一虚拟定位点集合中包含的每个第一虚拟定位点对应的第一坐标值计算出当前视线终点对应的第二坐标值;

157.第二判断子单元,用于当存在所述第一虚拟定位点对应的集群度不大于集群度阈值时,则判断所述第一虚拟定位点集合中是否存在至少两个第一虚拟定位坐标点对应的第一坐标值差值大于坐标差阈值;

158.第一确定子单元,用于当所述第一虚拟定位点集合中存在至少两个第一虚拟定位坐标点对应的第一坐标值差值大于坐标差阈值时,则基于第一坐标值差值大于坐标差阈值的一对第一虚拟定位坐标点确定两个子虚拟定位点集合,基于所述子虚拟定位点集合中包含的第二虚拟定位点对应的匹配度计算出所述子虚拟定位点集合对应的筛选权重值,基于较大筛选权重值对应的子虚拟定位点集合中包含的第二虚拟定位点对应的第一坐标值计算出当前视线终点对应的第二坐标值;

159.第二确定子单元,用于当所述第一虚拟定位点集合中不存在两个第一虚拟定位坐标点对应的第一坐标值差值大于坐标差阈值时,则删除所述第一虚拟定位点集合中的离群点,基于所述第一虚拟定位点集合中剩余保留的第三虚拟定位点对应的第一坐标值计算出当前视线终点对应的第二坐标值;

160.第三确定子单元,用于基于所述第二坐标值确定出对应的视线角度;

161.第四确定子单元,用于基于所述视线角度确定出对应的第一视野范围。

162.该实施例中,实时人眼图像即为实时获取的对应用户的人眼图像。

163.该实施例中,实时瞳孔特征即为分析实时人眼图像获得的对应的瞳孔轮廓坐标集合。

164.该实施例中,计算出所述瞳孔特征集合中包含的每个瞳孔特征与所述实时瞳孔特征之间的匹配度,包括:

[0165][0166]

式中,j为第j个瞳孔特征,αj为第j个瞳孔特征与实时瞳孔特征之间的匹配度,i为实时瞳孔特征中的第i个像素点,n为实时瞳孔特征中包含的像素点总个数,x

ij

为第j个瞳孔特征中的第i个像素点对应的横坐标值,y

ij

第j个瞳孔特征中的第i个像素点对应的纵坐标值,x

is

为实时瞳孔特征中的第i个像素点对应的横坐标值,y

is

为实时瞳孔特征中的第i个像素点对应的纵坐标值;

[0167]

例如,瞳孔特征中包含两个像素点,坐标值依次是(4,4)、(5,6),实时瞳孔特征中包含两个像素点,坐标值依次是(3,4)、(5,6),则瞳孔特征与实时瞳孔特征之间的匹配度为0.9。

[0168]

该实施例中,瞳孔特征匹配集合即为按照匹配度从大到小的顺序将瞳孔特征集合中的瞳孔特征进行排序后获得的对应的瞳孔特征集合。

[0169]

该实施例中,第一特征集合即为从瞳孔特征匹配集合中筛选出前第一数量个瞳孔特征后获得的特征集合。

[0170]

该实施例中,第一虚拟定位点集合即为第一特征集合中包含的瞳孔特征对应的虚拟定位点构成的集合。

[0171]

该实施例中,第一虚拟定位点即为第一虚拟定位点集合中包含的虚拟定位点。

[0172]

该实施例中,第一坐标值即为第一虚拟定位点对应的坐标值。

[0173]

该实施例中,基于所述第一坐标值计算出所述第一虚拟定位点在所述第一虚拟定位点集合中对应的集群度,包括:

[0174][0175]

式中,β为第一虚拟定位点在第一虚拟定位点集合中对应的集群度,u为第一虚拟定位点集合的第u个第一虚拟定位点,v为第一虚拟定位点集合中的第一虚拟定位点集合总个数,xu为第u个第一虚拟定位点对应的横坐标值,yu为第u个第一虚拟定位点对应的纵坐标值,x0为第一坐标值中的横坐标值,y0为第一坐标值中的纵坐标值;

[0176]

例如,第一虚拟定位点集合中包含两个第一虚拟定位点,坐标值依次是(4,4)、(5,6),第一虚拟定位点的坐标值为(5,6),则第一虚拟定位点在第一虚拟定位点集合中对应的集群度为0.875。

[0177]

该实施例中,集群度阈值即为可以基于第一虚拟定位点集合中包含的每个第一虚拟定位点对应的第一坐标值计算出当前视线终点对应的第二坐标值时对应的第一虚拟定位点的最小集群度。

[0178]

该实施例中,基于所述第一虚拟定位点集合中包含的每个第一虚拟定位点对应的第一坐标值计算出当前视线终点对应的第二坐标值,包括:

[0179][0180][0181]

式中,xk为第二坐标值中的横坐标值,yk为第二坐标值中的纵坐标值,p为第一虚拟定位点集合中包含的第p个第一虚拟定位点,q为第一虚拟定位点集合中包含的第一虚拟定位点的总个数,x

p

为第一虚拟定位点集合中包含的第p个第一虚拟定位点对应的第一坐标值中的横坐标值,y

p

为第一虚拟定位点集合中包含的第p个第一虚拟定位点对应的第一坐标值中的纵坐标值;

[0182]

例如,第一虚拟定位点集合中包含两个第一虚拟定位点,坐标值依次是(4,4)、(5,6),则当前视线终点对应的第二坐标值为(4.5,5)。

[0183]

该实施例中,坐标差阈值即为可以基于第一坐标值差值大于坐标差阈值的一对第一虚拟定位坐标点确定两个子虚拟定位点集合,并基于子虚拟定位点集合中包含的第二虚拟定位点对应的匹配度计算出子虚拟定位点集合对应的筛选权重值,基于较大筛选权重值对应的子虚拟定位点集合中包含的第二虚拟定位点对应的第一坐标值计算出当前视线终

点对应的第二坐标值时,对应的最小坐标差值。

[0184]

该实施例中,基于第一坐标值差值大于坐标差阈值的一对第一虚拟定位坐标点确定两个子虚拟定位点集合,即为:确定出第一虚拟定位点集合中第一坐标值差值最大的一对第一虚拟定位坐标点作为第三虚拟定位点,计算出所述第一虚拟定位点集合中除第三虚拟定位点以外剩余的第一虚拟定位点与第三虚拟定位点之间的坐标差值,将较小差值对应的第三虚拟坐标点作为同一所属子虚拟定位点集合中的虚拟定位点,直至将所述第一虚拟定位点集合中的所有虚拟定位点确定完毕后,获得两个子虚拟定位点集合。

[0185]

该实施例中,子虚拟定位点集合即为基于第一坐标值差值大于坐标差阈值的一对第一虚拟定位坐标点将第一虚拟定位点划分获得的两个虚拟定位点集合。

[0186]

该实施例中,基于所述子虚拟定位点集合中包含的第二虚拟定位点对应的匹配度计算出所述子虚拟定位点集合对应的筛选权重值,即为:将子虚拟定位点集合中包含的第二虚拟定位点对应的匹配度归一化后的结果的平均值作为子虚拟定位点集合对应的筛选权重值。

[0187]

该实施例中,基于较大筛选权重值对应的子虚拟定位点集合中包含的第二虚拟定位点对应的第一坐标值计算出当前视线终点对应的第二坐标值,即为:将较大筛选权重值对应的子虚拟定位点集合中包含的所有第二虚拟定位点对应的横坐标值的平均值作为当前视线终点对应的第二坐标值对应的横坐标值,将较大筛选权重值对应的子虚拟定位点集合中包含的所有第二虚拟定位点对应的纵坐标值的平均值作为当前视线终点对应的第二坐标值对应的纵坐标值。

[0188]

该实施例中,基于所述第一虚拟定位点集合中剩余保留的第三虚拟定位点对应的第一坐标值计算出当前视线终点对应的第二坐标值,即为:将第一虚拟定位点集合中剩余保留的第三虚拟定位点对应的第一坐标值对应的横坐标值的平均值作为当前视线终点对应的第二坐标值对应的横坐标值,将第一虚拟定位点集合中剩余保留的第三虚拟定位点对应的第一坐标值对应的纵坐标值的平均值作为当前视线终点对应的第二坐标值对应的纵坐标值。

[0189]

该实施例中,基于所述第二坐标值确定出对应的视线角度,包括:确定出vr设备中显示画面的中心点坐标,计算出中心点坐标和第二坐标值之间的第二坐标差值,并确定出vr设备显示画面中心点与对应用户双眼视觉中心(两个瞳孔中心点的连线的中点位置)的第一距离,第二坐标差值和第一距离的比值的反正切值即为对应的视线角度。

[0190]

该实施例中,基于所述视线角度确定出对应的第一视野范围,包括:将视线角度加上人体标准视线范围即为对应的第一视野范围,例如,标准视线范围为[-60

°

,60

°

],视线角度为45

°

,则对应的第一视野范围为[-15

°

,105

°

]。

[0191]

以上技术的有益效果为:通过将实时获取的瞳孔特征与与预先获取的瞳孔特征集合进行匹配,根据匹配结果筛选出第一特征集合,基于集群度、坐标差对第一特征集合进行二次筛选和判断,基于经过二次筛选后获得的虚拟坐标点计算出用户当前视线终点对应的坐标值,基于用户当前视线终点对应的坐标值确定出第一视野范围,为准确确定出用户当前的视野范围提供了重要基础,进而为后续精准确定出对应用户的视野范围并确定出对应vr设备中的显示画面提供了重要基础。

[0192]

实施例8:

[0193]

在实施例1的基础上,所述第二确定单元,参考图8,包括:

[0194]

第三获取子单元,用于获取设置在对应用户头部右侧的第一感应设备和设置在对应用户颈部的第二感应设备之间的第一头颈传感数据以及设置在对应用户头部左侧的第三感应设备和所述第二感应设备之间的第二头颈传感数据;

[0195]

第四获取子单元,用于获取所述第一感应设备和对应vr设备之间的第二传感数据;

[0196]

第五确定子单元,用于获取对应用户的第一预设头颈传感数据和第二预设头颈传感数据,基于所述第一预设头颈传感数据和所述第一头颈传感数据确定出对应的第一头部移动向量,基于所述第二预设头颈传感数据和所述第二头颈传感数据确定出对应的第二头部移动向量;

[0197]

角度确定子单元,用于基于所述第一头部移动向量和所述第二头部移动向量确定出对应的头部移动角度;

[0198]

第六确定子单元,用于获取预设设备传感数据,基于所述预设设备传感数据和所述第二传感数据确定出对应的设备偏移向量;

[0199]

距离获取子单元,用于获取所述vr设备显示画面中心点与对应用户双眼视觉中心之间的第一距离;

[0200]

第二计算子单元,用于基于所述设备偏移向量和所述第一距离计算出对应的设备偏移角度;

[0201]

第三计算子单元,用于基于所述头部移动角度和所述设备偏移角度计算出对应的视野偏移角度;

[0202]

第七确定子单元,用于基于vr设备的预设视觉范围和所述视野偏移角度,确定出对应的第二视野范围。

[0203]

该实施例中,第一感应设备即为设置在对应用户头部右侧的感应设备。

[0204]

该实施例中,第二感应设备即为设置在对应用户颈部的感应设备。

[0205]

该实施例中,第一头颈传感数据即为第一感应设备和第二感应设备之间的传感数据。

[0206]

该实施例中,第三感应设备即为设置在对应用户头部左侧的感应设备。

[0207]

该实施例中,第二头颈传感数据即为第三感应设备和第二感应设备之间的传感数据。

[0208]

该实施例中,第二传感数据即为第一感应设备和对应vr设备之间的传感数据。

[0209]

该实施例中,第一预设头颈传感数据即为预先获取的对应用户在标准姿势下对应的第一感应设备和第二感应设备之间的传感数据。

[0210]

该实施例中,第二预设头颈传感数据即为预先获取的对应用户在标准姿势下对应的第三感应设备和第二感应设备之间的传感数据。

[0211]

该实施例中,基于所述第一预设头颈传感数据和所述第一头颈传感数据确定出对应的第一头部移动向量,包括:

[0212]

基于第一预设头颈传感数据和第一头颈传感数据的差值以及对应的第一预设传感数据差值(即第一预设头颈传感数据和第一头颈传感数据的差值)和位置变化的对应关系,确定出对应的第二头部移动向量。

[0213]

该实施例中,基于所述第二预设头颈传感数据和所述第二头颈传感数据确定出对应的第二头部移动向量,包括:

[0214]

基于第二预设头颈传感数据和第二头颈传感数据的差值以及对应的第二预设传感数据差值(即第二预设头颈传感数据和第二头颈传感数据的差值)和位置变化的对应关系,确定出对应的第二头部移动向量。

[0215]

该实施例中,基于所述第一头部移动向量和所述第二头部移动向量确定出对应的头部移动角度,即为:将第一头部移动向量和第二头部移动向量的夹角作为对应的头部移动角度。

[0216]

该实施例中,预设设备传感数据即为预先获取的对应用户在标准姿势下对应的第一感应设备和对应vr设备之间的传感数据。

[0217]

该实施例中,基于所述预设设备传感数据和所述第二传感数据确定出对应的设备偏移向量,包括:

[0218]

基于预设设备传感数据和第二传感数据的差值以及第三预设传感数据差值(即预设设备传感数据和所述第二传感数据)和位置变化的对应关系,确定出对应的设备偏移向量。

[0219]

该实施例中,第一距离即为vr设备显示画面中心点与对应用户双眼视觉中心之间的距离。

[0220]

该实施例中,基于所述设备偏移向量和所述第一距离计算出对应的设备偏移角度,即为:将设备偏移向量的绝对值与第一距离的比值的反正切值作为对应的设备偏移角度。

[0221]

该实施例中,基于所述头部移动角度和所述设备偏移角度计算出对应的视野偏移角度即为:将头部偏移角度和设备偏移角度的和作为对应的视野偏移角度。

[0222]

该实施例中,vr设备的预设视觉范围例如:[-90

°

,90

°

]。

[0223]

该实施例中,基于vr设备的预设视觉范围和所述视野偏移角度,确定出对应的第二视野范围,例如:预设视觉范围为[-90

°

,90

°

],视野偏移角度为30

°

,则第二视野范围为[-60

°

,120

°

]。

[0224]

以上技术的有益效果为:基于传感数据计算出用户当前头部移动向量以及设备偏移向量,基于确定出的头部移动向量以及设备偏移向量确定出对应的第二视野范围,为准确确定出用户当前的视野范围提供了重要基础,进而为后续精准确定出对应用户的视野范围并确定出对应vr设备中的显示画面提供了重要基础。

[0225]

实施例9:

[0226]

在实施例1的基础上,所述数据交换端,参考图9,包括:

[0227]

第一接收模块,用于接收所述教师端输入的第一互动信息;

[0228]

资源投放模块,用于基于所述第一互动信息向所有在线学生端投放对应的教学资源;

[0229]

第二接收模块,用于接收所述学生端输入的第二互动信息;

[0230]

信息分析模块,用于分析评估所述第二互动信息,获得对应的反馈评估结果;

[0231]

结果传输模块,用于将所述反馈评估结果传输至所述在线教师端和所述在线学生端的vr设备中进行展示;

[0232]

其中,所述互动信息包括:第一互动信息和第二互动信息。

[0233]

该实施例中,第一互动信息即为教师端输入的互动信息,例如资源投放指令。

[0234]

该实施例中,教学资源例如:教学课件、习题画面等教学资料。

[0235]

该实施例中,第二互动信息即为学生端输入的互动信息,例如有:针对老师投放的习题画面的习题答案等。

[0236]

该实施例中,反馈评估结果即为分析评估第二互动信息获得的对应的品谷结果,例如:分析评估学生输入的习题答案的正确性的结果。

[0237]

以上技术的有益效果为:通过接收教师端输入的第一互动信息并基于第一互动信息对学生端进行资源传输,同时,接收学生端输入的第二互动信息并分析第二互动信息获得反馈评估结果,将反馈评估结果共享至所有在线用户端,实现了对学生反馈结果的自动评估,减少了老师的批改审查压力,实现了虚拟课堂中老师和学生的多人在线互动以及信息交互。

[0238]

实施例10:

[0239]

在实施例9的基础上,所述结果传输模块,参考图10,包括:

[0240]

第一传输单元,用于将所述反馈评估结果传输至对应在线学生端的vr设备中进行展示;

[0241]

第二传输单元,用于将所有在线学生对应的反馈评估结果进行汇总,获得对应的评估汇总结果,将所述评估汇总结果传输至所述在线教师端的vr设备中进行展示。

[0242]

该实施例中,评估汇总结果即为将所有在线学生对应的反馈评估结果进行汇总后获得的结果。

[0243]

以上技术的有益效果为:实现了学生反馈评估结果的对应传输,也实现了将所有学生的反馈评估结果自动汇总并传输至教师端,保证了学生的隐私,也减少了老师的整理汇总工作量,提高了老师和学生双方的上课体验。

[0244]

显然,本领域的技术人员可以对本发明进行各种改动和变型而不脱离本发明的精神和范围。这样,倘若本发明的这些修改和变型属于本发明权利要求及其等同技术的范围之内,则本发明也意图包含这些改动和变型在内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。