1.本发明涉及计算机视觉和行为识别领域,具体涉及一种基于深度学习的学生课堂行为识别方法。

背景技术:

2.随着信息数字化的不断发展,在教学过程中使用多媒体技术进行教学以并录制上课视频已成为常态,教师可以根据录制的视频对学生课堂行为进行分析。学生课堂行为状态是评估教师教学水平的重要方式之一,教师也可以根据学生上课的状态得到反馈,调整教学方法与方式,以达到更好的教学效果。在传统的教学过程中,教师得到学生课堂行为反馈只能通过上课观察或课后回看上课视频的方式,上课观察的方式不能全面观察到每一位学生,而课后回看的方式需要消耗大量的时间以及精力,并且记录过程比较繁琐,在实际操作方面有很大困难。

3.对深度学习算法的深入研究,使其在教育教学领域也得到了广泛运用,如人脸识别、目标检测等,甚至在某些领域已经逐渐超越了人工方式。使用深度学习算法进行学生课堂行为识别可以大大减少教师课后需要投入的时间精力,在一定程度上有助于教师在其他方面改善教学方法,同时使学生了解自己的上课状态,进行及时调整,以提高学习成绩。

技术实现要素:

4.本发明的目的在于提供一种基于深度学习的学生课堂行为识别方法及系统,可以对获取的视频图像中学生课堂行为进行分析,有助于教师得到教学反馈,提高教学水平。

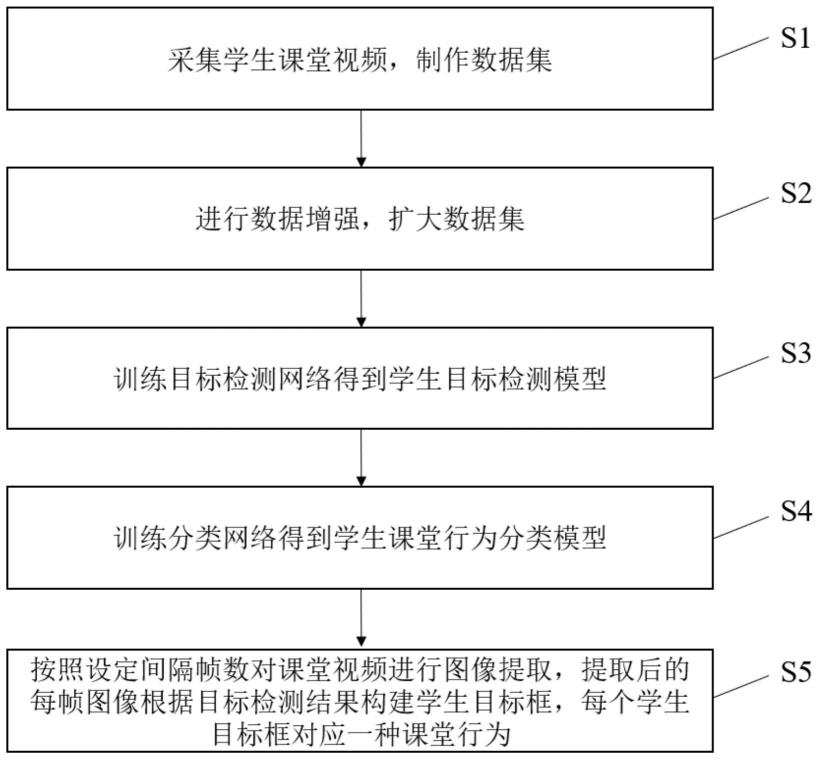

5.本发明的目的是通过以下技术方案实现的:一种基于深度学习的学生课堂行为识别方法,具体包括以下步骤:

6.s1:采集学生课堂视频,制作数据集;

7.s2:进行数据增强,扩大数据集;

8.s3:训练目标检测网络得到学生目标检测模型;

9.s4:训练分类网络得到学生课堂行为分类模型;

10.s5:按照设定间隔帧数对课堂视频进行图像提取,提取后的每帧图像根据目标检测结果构建学生目标框,每个学生目标框对应一种课堂行为。

11.进一步的,所述步骤s1中制作目标检测数据集的方法为:模拟上课情况录制学生课堂视频,学生做出常见课堂行为动作,按照设定间隔帧数对视频进行图像提取,对提取后的图像标记不同学生目标框;制作分类数据集的方法为:根据目标检测数据集中标记的学生目标框对学生图像进行截取,并确定相应课堂行为类别标签,包括正常状态、站立状态,趴桌状态、举手状态、转身状态。

12.进一步的,所述步骤s2中进行数据增强的方法包括:翻转变化、旋转变化、对比度变化,添加噪声。

13.进一步的,所述步骤s3中目标检测网络为yolov5,经过训练的目标检测模型可以

用于构建学生目标框,获取图像中学生所在位置信息。

14.进一步的,所述步骤s4中分类网络为经过改进的shufflenetv2,对shufflenetv2添加了se注意力机制模块,经过训练的分类模型可以用于对学生课堂行为进行分类。

15.进一步的,所述步骤s5每帧图像根据目标检测结果构建学生目标框,每个学生目标框对应一种课堂行为,该新算法将yolov5与改进的shufflenetv2相结合,把目标检测出的学生目标框截取下来直接送入分类网络进行分类。

16.进一步的,所述新算法检测后的学生目标框上直接显示学生课堂行为类别标签。

17.一种基于深度学习的学生课堂行为识别系统,其特征在于,包括:

18.上传模块,上传课堂视频;

19.识别模块,对学生课堂行为进行识别;

20.反馈模块,将学生本节课的行为状态反馈给教师。

21.综上所述,本发明的技术方案所带来的有益效果在于:

22.1.本发明通过模拟课堂情况录制视频,制作数据集,并使用数据增强的方法扩充数据集,解决了深度学习在课堂行为识别领域没有官方数据集的问题;

23.2.本发明使用yolov5目标检测算法和改进的shufflenetv2分类算法相结合的方式,对目标检测算法截取出的学生目标框直接进行分类,减少了无关信息的干扰。教师可以通过该算法获取学生上课情况,有助于教学水平的提高。

附图说明

24.图1为本发明提出的基于深度学习的学生课堂行为识别方法的流程图;

25.图2为本发明制作数据集的流程图;

26.图3为本发明提出的基于深度学习的学生课堂行为识别系统模块。

具体实施方式

27.下面结合附图对本发明做进一步的描述。

28.如图1所示,本发明提供了一种基于深度学习的学生课堂行为识别方法,其流程包括以下步骤:

29.s1:采集学生课堂视频,制作数据集,模拟上课情况录制视频,按照设定间隔提取图像作为数据集;

30.s2:进行数据增强,对进行分类网络训练时需要使用的课堂行为数据集进行翻转变化、旋转变化、对比度变化,添加噪声,扩大数据集;

31.s3:训练目标检测网络得到学生目标检测模型,目标检测使用yolov5网络,训练好的模型可以进行检测学生目标,构建学生目标框,并得到学生位置信息;

32.s4:训练分类网络得到学生课堂行为分类模型,分类网络为经过改进的shufflenetv2,对shufflenetv2添加了se注意力机制模块,经过训练的分类模型可以用于对学生课堂行为进行分类

33.s5:按照设定间隔帧数对课堂视频进行图像提取,提取后的每帧图像根据目标检测结果构建学生目标框,每个学生目标框对应一种课堂行为。

34.如图2所示,为制作数据集的流程图,其流程包括以下步骤:

35.(1)模拟上课状态录制视频,学生做出课堂常见行为动作;

36.(2)从录制的模拟课堂视频每隔1s提取一帧图像,用labelme对学生目标框进行标记作为目标检测数据集,用于后续学生目标检测网络的训练;

37.(3)根据目标检测数据集中标记的学生目标框对学生图像进行截取,并确定相应课堂行为类别标签,包括正常状态、站立状态,趴桌状态、举手状态、转身状态,作为分类数据集,用于学生课堂行为分类网络的训练。

38.对分类数据集进行数据增强,扩充了分类数据集。

39.对yolov5目标检测网络进行训练,得到目标检测模型,训练好的模型可以对输入的课堂图片检测学生目标,得到学生目标框,并得到学生的位置信息。

40.对改进的shufflenetv2分类网络进行训练,改进的shufflenetv2网络添加了注意力机制,其准确率比shufflenetv2高,训练好的模型可以对输入的学生图片进行课堂行为分类,得到学生课堂行为标签。

41.新算法将yolov5和改进的shufflenetv2相结合,输入一张课堂图片后,该算法先根据训练好的目标检测模型对图片上的学生目标进行检测,在图片上画出学生目标框,根据学生目标框的位置将学生图片截取下来,直接送入分类网络,训练好的分类网络模型对学生图片进行分析,得到学生课堂行为标签,展示在已经画好的学生目标框上,该算法可以直接在输入的图片上画出学生目标框及其课堂行为类别。

42.如图3所示,本发明提供了一种基于深度学习的学生课堂行为识别系统,包括以下模块:

43.上传模块,教师将待分析的课堂视频上传至该系统;

44.识别模块,系统按照教师设定频率,如10s/次,对上传视频进行图像提取,并进行学生课堂行为识别及标注,识别后的图像显示学生目标框及其行为标签,对识别结果进行记录保存;

45.反馈模块,系统将识别结果反馈给教师,教师可以获取不同学生课堂行为占比,了解学生课堂行为状态,以改善教学质量。

46.经过上述步骤,该方法能够成功识别学生目标及学生正常、站立、趴桌、举手、转身的行为,准确率达到了99.4%,达到了实际应用的水平。

47.以上所述仅是对本发明的具体解释,并不用于限制本发明的保护范围。本领域的技术人员凡在本技术的精神和原则之内,所作的任何显而易见的修改、替换、改进等,均应包含在本技术的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。