1.本发明涉及通讯软件交互技术领域,特别涉及一种基于云端人机交互技术的人脸情绪管理方法。

背景技术:

2.人的情绪分成7类基本表情,如平淡、生气、讨厌、恐惧、开心、悲伤、惊讶这7种基本表情的图像集上;目前基于这7种基本的情绪识别准确率》85%,但未广泛的使用于交互领域。如cn202010741026.7,公开了一种基于人脸识别reid技术的大数据分析系统,包括数据分析模块、运营商手机数据模块和人脸识别模块,数据分析模块包括检测模组、比对模组、数据库模组和跟踪模组;运营商手机数据模块包括关联模组、识别模组和终端信息库模组。本发明与现有技术相比的优点在于:采用大数据采集清洗、模型算法、机器学习等方式进行智能化大数据分析,打通顾客在场在店的各级账户,为商业体提供客流、支付相关的智能数据分析及可视化呈现,帮助购物中心逐步构建完整用户画像,全面认知客户,不断优化经营,提升效益,将运营数据价值转化为经营价值和收益。但其问题在于人脸获取的方式是采用主动获取,获取前并未获得用户的允许直接采集,同时其本身的运行框架是建立在大数据的挖掘,实际上客户是否真的喜欢并未进行分类规整,那么分类的准确率是建立在开发者的角度而非用户的角度,也无法实现情绪信息的追溯。

3.因此申请人提出一种基于云端人机交互技术的人脸情绪管理方法,站在用户的角度,解决现有技术中商用人脸情绪分类应用不足的问题,将情绪识别技术引入通讯软件,实现用户情绪的识别和追踪。

技术实现要素:

4.(一)技术方案

5.本发明通过如下技术方案实现:一种基于云端人机交互技术的人脸情绪管理方法,

6.s1:用户通过终端设备连入微信服务器获取第一交互信息;

7.s2:基于第一交互信息向终端设备发送权限信息获取请求;若允许则进入s3;否则返回s1;

8.s3:基于终端设备向用户发送至少一个第二交互信息,基于第二交互信息录制第一视频流,视频流传输至云端服务器并通过第二交互信息为视频流建立情绪标签;带情绪标签的视频流进行分类建立训练集,利用训练集建立用户个人机器学习模型;

9.s4:基于设备终端发送情绪检测请求,若允许则开始录制第二视频流;基于第二视频流导入个人机器学习模型生成第三交互信息;

10.s5:基于设备终端发送第三交互信息获取请求,若允许发送第三交互信息并将结果保存至云端服务器,同时发送第四交互信息;第三交互信息绑定用户id;用户通过设备终端可随时查阅历史第三交互信息。

11.作为上述方案的进一步说明,所述第一交互信息包括微信公众号交互信息、微信小程序交互信息。

12.作为上述方案的进一步说明,所述权限信息获取请求包括微信手机号信息获取请求、公开信息授权获取请求、设备终端摄像头授权使用请求。

13.作为上述方案的进一步说明,所述第二交互信息包括图案信息、声音信息;每个图案信息、声音信息附有情绪标签。

14.作为上述方案的进一步说明,所述s3具体的:

15.s31:用户通过设备终端确定是否接收第二交互信息,若允许则生成 3s倒计时;

16.s32:3s倒计时结束后基于设备终端显示至少一个第二交互信息,同时基于设备终端录制10s的第一视频流上传至云端服务器;

17.s33:利用视频分割技术分割第一视频流生成至少一个子视频流,并基于第二交互信息为子视频流建立情绪标签,并通过情绪标签为子视频流进行分类建立训练集;

18.s34:基于训练集建立用户个人机器学习模型。

19.作为上述方案的进一步说明,所述s34具体的:

20.s341:将子视频流按帧分割成若干个第一帧图像,并基于情绪标签对每帧图像进行分类;

21.s342:利用灰度处理、尺寸归一化处理对若干个第一帧图像进行预处理,并通过旋转、裁切、翻面进行数据增强处理获得数据集,将数据集按照3:7划分为训练集和测试集;

22.s343:提取帧图像中人脸表情的hog特征并输入svm分类器进行训练获得机器学习模型。

23.作为上述方案的进一步说明,所述s4具体的:

24.s41:用户允许情绪检测请求,基于设备终端开始录制10s的第二视频流;将第二视频流分割成若干个第二帧图像;

25.s42:利用灰度处理、尺寸归一化处理对若干个第二帧图像进行预处理,

26.s43:预处理后的图像提取hog特征;

27.s44:导入训练好的个人机器学习模型,输出第三交互信息。

28.作为上述方案的进一步说明,所述第三交互信息包括分类概率及结果报告。

29.作为上述方案的进一步说明,所述s5具体的:

30.s51:用户基于设备终端发送第三交互信息获取请求;

31.s52:反馈第三交互信息及第四交互信息;所述第四交互信息包括:分享激励请求、分享助力请求;

32.s53:若用户接受第四交互信息,则云端基于第四交互信息反馈激励结果及助力结果。

33.作为上述方案的进一步说明,所述情绪标签包括:平淡标签、生气标签、讨厌标签、恐惧标签、开心标签、悲伤标签、惊讶标签。

34.(三)有益效果

35.本发明相对于现有技术,具有以下有益效果:通过微信服务器建立情绪识别方法,采用人脸面部表情分析技术对用户的面部表情进行识别;通过在设备终端以及情绪标签、语音标签,采集用户的表情数据构建了用户面部表情识别数据集;在保证准确率的同时降

低对用户交互体验的不利的影响;经过本发明建立的方法,用户可以随时随地监测情绪变化情况,方便用户及时调整自身情绪,同时依托历史数据建立情绪信息数据追溯机制,通过用户表情,进行在线实时检测、分析其情绪变化,为用户心理健康提供辅助依据。

附图说明

36.通过阅读参照以下附图对非限制性实施例所作的详细描述,本发明新型的其它特征、目的和优点将会变得更明显:

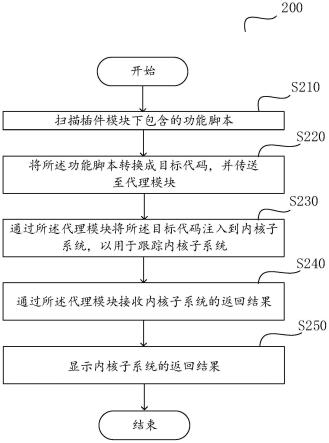

37.图1为发明方法流程示意图;

38.图2为实施例s1步骤中手机交互显示的示意图;

39.图3为实施例s1步骤中手机交互显示的示意图;

40.图4为实施例s1步骤中手机交互显示的示意图;

41.图5为实施例s2步骤中手机交互显示的示意图;

42.图6为实施例s2步骤中手机交互显示的示意图;

43.图7为实施例s2步骤中手机交互显示的示意图;

44.图8为实施例中情绪检测开始界面的手机交互显示示意图;

45.图9为实施例步骤s51中人机交互示意图;

46.图10为实施例步骤s52中人机交互示意图.

具体实施方式

47.实施例

48.请参阅图1,一种基于云端人机交互技术的人脸情绪管理方法,

49.s1:用户通过终端设备连入微信服务器获取第一交互信息;所述第一交互信息包括微信公众号交互信息、微信小程序交互信息。请参阅图2,图3,图4;具体的用户通过设备终端连入微信服务器,通过微信搜索“阅脸人工智能”公众号并关注,点击“表情体验”栏目即可进入小程序;或者在微信小程序里面直接搜索“阅脸表情识别”点击直接进入;

50.s2:基于第一交互信息向终端设备发送权限信息获取请求;若允许则进入s3;否则返回s1;所述权限信息获取请求包括微信手机号信息获取请求、公开信息授权获取请求、设备终端摄像头授权使用请求。具体的请参阅图5,图6,图7,点击“注册/登录”、“一键授权登录”此时跳出图7所示的微信手机号授权并允许、公开信息授权并允许、手机摄像头授权允许并开启,点击允许进入开始界面;开始界面如图8所示。

51.上述部分为微信公众号以及授权信息的获取步骤,为本实施例商用的前置步骤,为现有技术,此处不再进行过多的赘述。接下去将对人脸情绪管理方法的核心部分进行解释说明。

52.s3:基于终端设备向用户发送至少一个第二交互信息,基于第二交互信息录制第一视频流,视频流传输至云端服务器并通过第二交互信息为视频流建立情绪标签;带情绪标签的视频流进行分类建立训练集,利用训练集建立用户个人机器学习模型;需要进一步说明的是,情绪标签包括:平淡标签、生气标签、讨厌标签、恐惧标签、开心标签、悲伤标签、惊讶标签。具体的包括如下步骤:

53.s31:用户通过设备终端确定是否接收第二交互信息,若允许则生成 3s倒计时;在

完成s2后,用户会进入到图8的界面;若用户“点击开始”则确定用户通过设备终端接受第二交互信息,所述第二交互信息包括图案信息、声音信息;每个图案信息、声音信息附有情绪标签。如:开心,呈现开心图标并发出开心声音,图标和声音附有开心的情绪标签。同时用户“点击开始”,进入3s倒计时,给予用户调整自身状态的时间以及从云端传输第二交互信息的缓冲时间;

54.s32:3s倒计时结束后基于设备终端显示至少一个第二交互信息,同时基于设备终端录制10s的第一视频流上传至云端服务器;所述第二交互信息包括图案信息、声音信息;每个图案信息、声音信息附有情绪标签。如:开心,呈现开心图标并发出开心声音,图标和声音附有开心的情绪标签;悲伤,呈现悲伤图标并发出悲伤声音,图标和声音附有悲伤的情绪标签。需要进一步说明的是,10s的范围内需要出现多个第二交互信息,便于收集足够的表情数据,如带平淡标签的第二交互信息出现1s、带生气标签的第二交互信息出现1s、带讨厌标签的第二交互信息出现1s、带恐惧标签的第二交互信息出现1s、带开心标签的第二交互信息出现2s、带悲伤标签的第二交互信息出现2s、带惊讶标签的第二交互信息出现2s;视频流10帧-24帧,则每个第二交互信息可以至少获得10-24张图像;总共可以至少获得100-240张图像;需要进一步说明的是s32的步骤可以重复进行以求获得更多的数据用于后续的模型训练。

55.s33:利用视频分割技术分割第一视频流生成至少一个子视频流,并基于第二交互信息为子视频流建立情绪标签,并通过情绪标签为子视频流进行分类建立训练集;需要进一步说明的是,为了便于后续的数据训练,需要先将情绪标签进行划分,如如带平淡标签的第二交互信息出现1s、带生气标签的第二交互信息出现1s、带讨厌标签的第二交互信息出现1s、带恐惧标签的第二交互信息出现1s、带开心标签的第二交互信息出现2s、带悲伤标签的第二交互信息出现2s、带惊讶标签的第二交互信息出现2s;则需要先将整段10秒的视频分割成1s、1s、1s、1s、2s、2s、2s;同时每段视频根据标签建立分类。

56.s34:基于训练集建立用户个人机器学习模型。具体的:

57.s341:将子视频流按帧分割成若干个第一帧图像,并基于情绪标签对每帧图像进行分类;需要进一步说明的是,通过视频分隔技术将视频中的每一帧进行抽取,由于10s的视频内还需分类为7种情绪标签的数据,因此每一帧的图像都要列入数据集以保证数据量的充足。同时再根据7种情绪标签对所有的图像进行分类,便于后续的处理。

58.s342:利用灰度处理、尺寸归一化处理对若干个第一帧图像进行预处理,并通过旋转、裁切、翻面进行数据增强处理获得数据集,将数据集按照3:7划分为训练集和测试集;需要进一步说明的是,灰度处理的目的在于处理三个通道的数据比较复杂,先将图像进行灰度化处理,灰度化的过程就是将每个像素点的rgb值统一成同一个值。灰度化后的图像将由三通道变为单通道,单通道的数据处理,提升数据的处理效率,同时保证识别率大于85%。作为商用的交互追求的流量和速度,三通道的处理虽然能将识别率提高至95%以上,但是所耗的时间也成倍增长,不利于用户交互的效率;尺寸归一化的目的在于:使图像尺寸符合分类器的输入要求;数据增强的目的在于进一步增加数据量,提高泛化能力,避免过拟合。

59.s343:提取帧图像中人脸表情的hog特征并输入svm分类器进行训练获得机器学习模型。需要进一步说明的是hog特征和svm分类器的准确率和耗时达到一个相对平衡的状态,请参阅下表1:

60.表1特征与分类器组合的分类效果比较

61.特征和分类算法测试集准确率耗时hog svm85.73%6.32slbp svm90.32%50.89sgabor svm92.55%287.33scnn cnn95.67%397.46s

62.从上表可以知道hog特征与svm分类器的组合能够使得准确率和耗时达到一个相对平衡的状态。作为商用的交互追求的流量和速度,其他这虽然能将识别率提高至90%以上,但是所耗的时间也成倍增长,不利于用户交互的效率。作为用户需要的是立刻得到一个结果,一般而言用户在一个交互界面愿意等待的时间大致是5-10s这个区间范围内,因此其他算法虽然识别率高,但是实质上对用户交互体验带来了不利的影响。同时本实施例所要的是分类器输出概率而非输出结果,因此hog特征与svm分类器的组合是本实施例的最优选择。需要进一步说明的是,上述组合为本实施例的优选,并非是对权利要求的进一步限定。

63.s4:基于设备终端发送情绪检测请求,若允许则开始录制第二视频流;基于第二视频流导入个人机器学习模型生成第三交互信息;所述s4具体的:

64.s41:用户允许情绪检测请求,基于设备终端开始录制10s的第二视频流;将第二视频流分割成若干个第二帧图像;需要进一步说明的是, s3适用于收集用户的数据进行训练,在s4中才是考虑用户在当前场景下的情绪识别。同时设备终端录制10s视频时,并不会显示第二交互信息,第二交互信息的目的在于引导用户在某个时间段处于某个特定的情绪状态,而本步骤需要的是用户当前情况的情绪状态。

65.s42:利用灰度处理、尺寸归一化处理对若干个第二帧图像进行预处理;需要进一步说明的是,灰度处理的目的在于处理三个通道的数据比较复杂,先将图像进行灰度化处理,灰度化的过程就是将每个像素点的rgb 值统一成同一个值。灰度化后的图像将由三通道变为单通道,单通道的数据处理,提升数据的处理效率,同时保证识别率大于85%。作为商用的交互追求的流量和速度,三通道的处理虽然能将识别率提高至95%以上,但是所耗的时间也成倍增长,不利于用户交互的效率;尺寸归一化的目的在于:使图像尺寸符合分类器的输入要求;

66.s43:预处理后的图像提取hog特征;

67.s44:导入训练好的个人机器学习模型,输出第三交互信息。所述第三交互信息包括分类概率及结果报告。需要进一步说明的是本实施例输出分类概率,而不输出具体的分类结果,在步骤s3创建svm分类器时,在 scikit-learn中设置probability=true,训练完成后,算法将使用逻辑回归对svm分数进行校准,对训练数据额外进行5-折交叉验证的训练,从而在步骤s4是可以输出分类的概率值。同时本实施例也可以采用在 svm模型中引入核函数,使得svm模型考虑非线性空间特征转换,最后在步骤s4时输出分类概率。或者直接在逻辑回归中引入核函数,从而使得 svm模型能够考虑非线性空间特征转换的同时输出分类概率。具体的不再展开说明。此时生成的分类结果为分类概率,如开心80%,平淡10%,惊讶10%,在通过结果生成结果报告;如开心80%,平淡10%,惊讶10%,则结果报告显示分类概率的同时显示“当前状态下以开心为主”。同时需要进一步说明的是,步骤s4所录制的视频将会返回数据集进行保存,便于进一步提高分类器的精度。

68.s5:基于设备终端发送第三交互信息获取请求,若允许发送第三交互信息并将结果保存至云端服务器,同时发送第四交互信息;第三交互信息绑定用户id;用户通过设备终端可随时查阅历史第三交互信息。

69.所述s5具体的:

70.s51:用户基于设备终端发送第三交互信息获取请求,请参阅图9;此时用户界面会显示“点击生成报告”,若用点击则认为用户发送获取请求,进入步骤s52;

71.s52:反馈第三交互信息及第四交互信息;请参阅图10,所述第四交互信息包括:分享激励请求、分享助力请求;所述第三交互信息包括分类概率及结果报告。在本实施例中第四交互信息的用处在于利用微信的分享功能,将结果与好友进行分享。

72.s53:若用户接受第四交互信息,则云端基于第四交互信息反馈激励结果及助力结果。本步骤的目的在于激励用户将报告分享给好友,让好友为用户助力,助力成功,即可领取红包;用户助力可以是注册或者检测,本步骤的目的在于建立流量通道,基于用户进行宣传,拓宽流量通道。

73.需要进一步说明的是,用户通过用户连入微信服务器后,在用户界面的个人记录里面可以随时查看自己情绪变化情况,历史记录,分析未来走势,及时自我调整心情健康状况,请参阅图5,实现情绪信息数据可追溯。

74.以上显示和描述了本发明的基本原理和主要特征和本发明的优点,对于本领域技术人员而言,显然本发明不限于上述示范性实施例的细节,而且在不背离本发明的精神或基本特征的情况下,能够以其他的具体形式实现本发明。因此,无论从哪一点来看,均应将实施例看作是示范性的,而且是非限制性的,本发明的范围由所附权利要求而不是上述说明限定,因此旨在将落在权利要求的等同要件的含义和范围内的所有变化囊括在本发明内。不应将权利要求中的任何附图标记视为限制所涉及的权利要求。

75.此外,应当理解,虽然本说明书按照实施方式加以描述,但并非每个实施方式仅包含一个独立的技术方案,说明书的这种叙述方式仅仅是为清楚起见,本领域技术人员应当将说明书作为一个整体,各实施例中的技术方案也可以经适当组合,形成本领域技术人员可以理解的其他实施方式。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。