1.本发明涉及从文本生成图像技术,尤其涉及一种基于类别感知一致性的文本生成图像方法。

背景技术:

2.随着深度学习的快速发展,其中自然语言和视觉图像这两个重要模态得到了长足的进步。跨模态任务也逐渐成为热点研究方向,其中由文本生成图像(t2i)有着很广泛的应用,如图像编辑,机器辅助式绘图等。普通的图像生成任务只关注生成图像质量,然而t2i任务在根据文本信息生成相应的真实图片的同时,需要进行模态融合、模态对齐等操作,即生成与文本紧密相关的真实图片,更加具有挑战。

3.t2i任务不仅仅需要生成质量高的图片,还需要考虑文本和图像的对应关系,这需要不同模态之间有很好的交互对齐。当前t2i任务常采用多阶段结构,由低分辨率逐渐生成高分辨率图像;另一种就是单阶段结构,端到端生成高分辨率图像。由于跨模态数据流的在训练过程中具有不稳定性,研究者常常会引入额外的监督信息,如图像类别信息、目标的位置等。然而这些方法没办法限制图像生成中一些类别感知的具体部分,导致生成的图像可能会失去该物体主要特征、整体框架的偏移或者违反真实图片结构。而基于类别感知一致性的文本生成图像方法能够有效解决此类问题。

技术实现要素:

4.本发明的目的是针对现有技术的不足而提出的一种基于类别感知一致性的文本生成图像方法。本方法通过结合度量学习和图像分类网络获取每张图像的特征,再进行归类、聚合得到类别感知特征。将获取的类别感知特征作为训练过程中的监督信息,通过设计损失函数来约束图像生成过程中的数据流型能感知到类别相应的特征,从而生成更加完整、更具细节的图像。

5.实现本发明目的的具体技术方案是:一种基于类别感知一致性的文本生成图像方法,包括如下步骤:步骤1:获取数据集从网络中或者专有图库中通过爬虫获取到某种物体不同类别的图片,按照类别信息进行分类,之后人工对每张图片进行文本描述,得到图片与对应文本信息的数据集;数据集中有该物体数种类别的物体图片,每类有数十张的图片、每张图片对应有数条相应描述文本,将所述的数据集划分为80%的训练集和20%的测试集,用于之后模型训练;其中,所述训练集与测试集没有类别的交集;步骤2:获取类别感知特征结合度量学习,搭建基于cnn网络的图像编码器,对训练集图片进行编码,从而得到图像特征;在所述图像编码网络中,应用交叉熵损失函数,并引用tripletloss使得图像特征的类间距离变大、类内距离变小,两损失的比重分别为0.6和0.4;编码网络的主干由通

用的inception-v3网络组成,训练过程中保持固定;将所有图片通过该编码器进行编码,获得所有图片对应的图像特征,然后将所有图像特征进行归类,之后将每类物体下的多个图像特征通过平均、聚类算法,获得一个512维的特征,作为每个类别物体的类别感知特征;最后将获取的类别感知特征存储在文件中,作为先验知识参与训练;步骤3:类别感知特征参与训练,生成文本相应的真实图像加载数据集中图像对应的文本,经过通用的文本编码器进行编码,得到全局文本表示特征,与100维的高斯噪声拼接,然后输入到生成对抗网络(gan)的生成器中,得到256x256的生成图像ig;其中生成器网络由上采样层、卷积层和leakyrelu层组成;将所述图像i

g 输入到图像编码器中得到图像的特征表示,之后从文件中找到该类别对应的类别感知特征,最后采取一个基于余弦相似度距离的损失函数来作为额外的约束条件;通过在生成器损失函数中添加该约束条件,随着网路反向传播进行不断优化,使得数据流能够感知类别对应信息,生成更加完整,更具细节的图像。测试集文本编码过后,与随机噪声进行拼接后输入到训练好的生成器模型中,生成文本对应的图片。

6.本发明的有益效果在于: 本发明具有易行性,获取类别感知特征的完全依赖先验知识的数据集,不用额外去获取其他更多的数据,同时功能强大的预训练模型可以使得提取图像特征更加简单。本发明的有效性,相对于引用图像标签和目标位置作为监督信息,本发明能够有效的对生成图的类别相关特征进行约束,且不会引入大量计算复杂度。本发明的易拓展性,提前获取的类别感知特征作为监督信息,这些特征作为可以作为先验知识,能够轻易加入不同的网络结构中。

附图说明

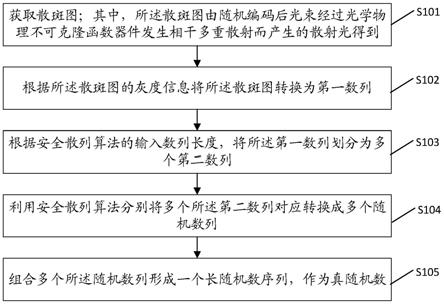

7.图1为本发明流程图;图2为本发明步骤2流程图;图3为本发明步骤3流程图;图4为本发明该实施例流程图。

8.具体实施方法式结合以下具体实施例和附图,对本发明作进一步的详细说明。实施本发明的过程、条件、实验方法等,除以下专门提及的内容之外,均为本领域的普遍知识和公知常识,本发明没有特别限制内容。

9.参阅图1,本发明具体操作按如下进行:步骤1:获取数据集从网络中或者专有图库中通过爬虫获取到某种物体不同类别的图片,按照类别信息进行分类,之后人工对每张图片进行文本描述,得到图片与对应文本信息的数据集;数据集中有该物体数种类别的物体图片,每类有数十张的图片、每张图片对应有数条相应描述文本,将所述的数据集划分为80%的训练集和20%的测试集,用于之后模型训练;其中,所述训练集与测试集没有类别的交集。

10.步骤2:获取类别感知特征参阅图2,结合度量学习,搭建基于cnn网络的图像编码器,对训练集图片进行编码,从而得到图像特征;在所述图像编码网络中,应用交叉熵损失函数,并引用tripletloss

使得图像特征的类间距离变大、类内距离变小,两损失的比重分别为0.6和0.4;编码网络的主干由通用的inception-v3网络组成,训练过程中保持固定;将所有图片通过该编码器进行编码,获得所有图片对应的图像特征,然后将所有图像特征进行归类,之后将每类物体下的多个图像特征通过平均、聚类算法,获得一个512维的特征,作为每个类别物体的类别感知特征;最后将获取的类别感知特征存储在文件中,作为先验知识参与训练;步骤3:类别感知特征参与训练,生成文本对应的真实图像参阅图3,加载数据集中图像对应的文本,经过通用的文本编码器进行编码,得到全局文本表示特征,与100维的高斯噪声拼接,然后输入到生成对抗网络(gan)的生成器中,得到256x256的生成图像ig;其中生成器网络由上采样层、卷积层和leakyrelu层组成;将所述图像i

g 输入到图像编码器中得到图像的特征表示,之后从文件中找到该类别对应的类别感知特征,最后采取一个基于余弦相似度距离的损失函数来作为额外的约束条件;通过在生成器损失函数中添加该约束条件,随着网路反向传播进行不断优化,使得数据流能够感知类别对应信息,生成更加完整,更具细节的图像。测试集文本编码过后,与随机噪声进行拼接后输入到训练好的生成器模型中,生成文本对应的图片。

实施例

11.参阅图4,本实施例以鸟为例,具体过程如下:步骤1:获取数据集从网络中获取到cub数据集,收集了200类的鸟类图片,每类有40张左右的图像,每张图片对应有10条相关描述文本。将不同的鸟类分别进行归类,构成数据集;将所述的数据集划分为80%的训练集和20%的测试集,用于模型训练;其中,所述训练集与测试集没有类别的交集;步骤2:获取类别感知特征对训练集先训练一个结合度量学习的图像编码器,然后对归类好的图片进行编码,再通过平均和聚类算法,得到类别感知特征,接着将该特征进行存储。

12.步骤3:类别感知特征参与训练,生成文本相应的真实图像之后,进行gan网络的训练。首先对文本进行编码,获得句子特征。之后,与高斯噪声进行拼接输入到生成器中,得到文本对应生成图。将生成图输入到训练好的图像编码器中得到生成图特征,之后与对应类别的类别感知特征做一个损失,该损失加入到生成器损失中进行反向传播。达到一定迭代次数,获得训练好的生成器和判别器模型。

13.加载测试集数据,把文本输入到文本编码器中,再拼接随机噪声输入到训练好的生成器模型,得到测试文本的生成图。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。