1.本公开内容涉及信息处理装置、信息处理方法和程序,并且具体地涉及能够在规划用作高速移动体的移动路径的轨迹时适当地规划可避开障碍物的轨迹的信息处理装置、信息处理方法和程序。

背景技术:

2.自主移动体在规划用作朝向目的地的移动路径的轨迹时规划轨迹以避开周围的障碍物。

3.作为规划这样的轨迹的方法,提出了检测周围状况、生成例如占用网格地图、识别障碍物的位置并且规划轨迹以避开障碍物的技术(参照专利文献1)。

4.引文列表

5.专利文献

6.专利文献1:日本专利申请公开第2005-092820号

技术实现要素:

7.本发明要解决的问题

8.然而,占用网格地图是在时间方向上的卷积的前提下生成的,并且因此,在识别出周围障碍物的位置之前,占用概率收敛需要时间。

9.因此,低速自主移动体能够适当地规划轨迹以避开障碍物,但是在一些情况下,高速自主移动体不能适当地规划轨迹以避开障碍物,因为占用网格地图的占用概率不能及时收敛。

10.本公开内容鉴于这样的情况而完成,并且具体地其目的在于使高速移动体适当地规划作为移动路径的轨迹以避开障碍物。

11.问题的解决方案

12.根据本公开内容的一个方面的信息处理装置和程序是包括以下单元的信息处理装置和程序:物体识别单元,其识别移动体的周围的图像中的物体;特征点提取单元,其与该物体识别单元的物体识别结果相关联地从图像中提取特征点;网格创建单元,其基于该物体识别结果,通过按照相同的每个物体连接特征点来创建表示障碍物的网格;以及动作规划单元,其基于由该网格创建单元创建的网格,规划该移动体的动作以避开该障碍物。

13.根据本公开内容的一个方面的信息处理方法是一种包括以下步骤的信息处理方法:识别移动体的周围的图像中的物体;与该物体的识别结果相关联地从图像中提取特征点;基于该物体的识别结果,通过按照相同的每个物体连接特征点来创建表示障碍物的网格;以及基于所创建的网格来规划移动体的动作以避开该障碍物。

14.在本公开内容的一个方面中,识别图像中的移动体周围的物体,与该物体识别结果相关联地从图像中提取特征点,基于物体识别结果针对每个相同物体连接特征点以创建表示障碍物的网格,并且基于所创建的网格来规划移动体的动作以避开该障碍物。

附图说明

15.图1示出了使用delaunay(狄洛尼)网格的轨迹规划。

16.图2示出了在使用狄洛尼网格的轨迹规划中没有适当规划轨迹的示例。

17.图3示出了在使用狄洛尼网格的轨迹规划中没有适当规划轨迹的示例。

18.图4示出了在使用狄洛尼网格的轨迹规划中没有适当规划轨迹的示例。

19.图5示出了在使用狄洛尼网格的轨迹规划中没有适当规划轨迹的示例。

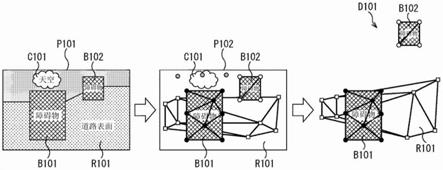

20.图6示出了本公开内容的概要。

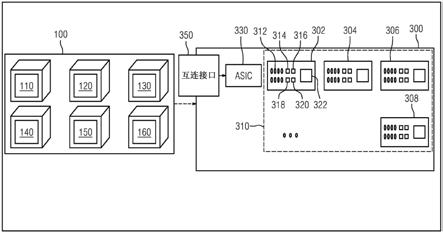

21.图7是示出了本公开内容的移动体的第一实施方式的配置示例的框图。

22.图8是示出了图7的轨迹规划单元的配置示例的框图。

23.图9示出了语义分割。

24.图10示出了将由深度传感器检测到的深度图像的坐标系转换为由摄像装置捕获的图像的坐标系。

25.图11示出了提取特征点的方法。

26.图12示出了生成二维狄洛尼网格的方法。

27.图13示出了将二维狄洛尼网格转换为三维狄洛尼网格的方法。

28.图14示出了选择轨迹候选的方法。

29.图15示出了根据障碍物的语义标签设置的余量。

30.图16示出了计算距离的评价值的方法。

31.图17是示出了由图8的轨迹规划单元进行的轨迹规划处理的流程图。

32.图18是示出了本公开内容的移动体的第二实施方式的配置示例的框图。

33.图19是示出了图18的轨迹规划单元的配置示例的框图。

34.图20是示出了图19的深度可靠性过滤单元的配置示例的框图。

35.图21是示出了由图19的轨迹规划单元进行的轨迹规划处理的流程图。

36.图22是示出了由图20的深度可靠性过滤单元进行的滤波处理的流程图。

37.图23示出了第三实施方式的概要,其中基于由偏振摄像装置捕获的偏振图像来估计法线方向,并且基于法线方向提取特征点。

38.图24是示出了本公开内容的移动体的第三实施方式的配置示例的框图。

39.图25是示了出图24的轨迹规划单元的配置示例的框图。

40.图26是示出了由图25的轨迹规划单元进行的轨迹规划处理的流程图。

41.图27示出了通用计算机的配置示例。

具体实施方式

42.在下文中,将参照附图详细描述本公开内容的优选实施方式。注意,在本说明书和附图中,具有基本相同功能配置的部件将被表示为相同的附图标记,并且将省略其重复描述。

43.在下文中,将描述用于执行本技术的模式。将按以下顺序提供描述。

44.1.本公开内容的概述

45.2.第一实施方式

46.3.第二实施方式

47.4.第三实施方式

48.5.软件执行的示例

49.《1.本公开内容的概述》

50.本公开内容使得即使是高速自主移动体也能够根据周围情况适当地规划作为移动路径的轨迹以避开障碍物。

51.首先,将描述本公开内容的概要。

52.在规划作为移动体的移动路径的轨迹中,一般生成占用网格地图,然后识别周围的障碍物的位置和距离,并且根据障碍物的位置和距离来规划轨迹。

53.然而,在时间方向上卷积的前提下形成占用网格地图,并且因此形成占用网格地图需要时间。

54.因此,在一些情况下,因为不能及时形成占用网格地图,所以高速自主移动体不能适当地规划轨迹以避开障碍物。

55.因此,提出了一种技术,即,基于周围的图像,从图像中提取特征点,形成以特征点为顶点的三角形表面的网格,识别由所形成的网格表示的障碍物,并且规划轨迹以避开所识别的障碍物。

56.更具体地,将描述例如如图1的图像p1(图1的左部)所示捕获其中出现具有云和障碍物b1和b2的天空c1的图像并且检测在相应视角的深度图像(距离图像)的情况。

57.此外,从这样的图像p1中提取特征点,如例如图像p2中的圆标记所示。

58.首先,通过形成具有由图像p2(图1的中心部分)中的圆标记指示的特征点作为顶点的三角形表面,由二维狄洛尼网格表示障碍物。

59.然后,基于特征点处的深度图像的像素的深度信息(距离信息)对由二维狄洛尼网格表示的障碍物进行三维化,并且因此由三维狄洛尼网格d1(图1的右部)表示,然后规划能够朝向目的地t移动的移动体f的轨迹以避开障碍物。

60.如图1所示,例如,在移动体f试图自主地朝向x标记所示的目的地t移动、且不存在由三维狄洛尼网格d1表示的障碍物的情况下,规划轨迹g1。同时,在识别出由三维狄洛尼网格d1所表示的障碍物时,例如,取代轨迹g1,而规划由虚线表示的轨迹g2以避开所识别出的障碍物。

61.由此,作为移动体到达目的地的轨迹,规划包括避开障碍物的移动路径的轨迹。

62.如上所述,通过仅使用图像p1的信息中的特征点处的深度信息来用三维狄洛尼网格d1表示障碍物,可以规划轨迹以避开障碍物。这使得可以以比形成占用网格地图更小的信息量(以更低的等待时间)高速地规划轨迹。

63.然而,在如上所述形成的三维狄洛尼网格中,如图2的图像p2和三维狄洛尼网格d1所示,例如,在最初不存在障碍物b1和b2的区域中形成表面m1和m2,从而形成好像存在要避开的障碍物的信息。

64.因此,如图3所示,尽管移动体f1可以经过障碍物b1,但绕行轨迹g11被规划为避开表面m1,因为表面m1被识别为障碍物。

65.此外,类似地,如图3所示,尽管移动体f2最初可以在障碍物b1与b2之间通过,可以规划绕行轨迹g12以避开障碍物b1与b2之间的表面m2,因为表面m2被识别为障碍物。

66.此外,在使用狄洛尼网格来规划轨迹时,仅基于障碍物的存在或不存在来规划轨

迹。因此,例如,如图4的左部分所示,用于避开诸如树t的即使偶然与移动体接触也不会移动并且几乎不受影响的障碍物的轨迹g21和用于避开诸如人h的可能移动并且一定不与移动体接触的障碍物的轨迹g22被规划为与障碍物具有相同的距离。

67.也就是说,移动体11可能由于风、雨等的影响而不能沿假定的轨迹移动,并且如果移动体显著偏离轨迹,则移动体可能与障碍物接触。

68.因此,在规划轨迹中,例如在即使与移动体接触也几乎不受影响的树t等是要避开的障碍物的情况下,可以在距障碍物相对短距离的位置处规划轨迹,但是在要避开的障碍物是在与移动体接触时受到很大影响的人h等的情况下,期望在相对远的位置处规划轨迹。

69.此外,如图5所示,在识别电线杆ps并且由于电线杆被识别为障碍物而规划用于避开电线杆ps的轨迹g31的情况下,移动体可能与可能存在于电线杆ps附近并且从图像中几乎不能识别的电线cb等接触。因此,考虑到从图像中识别的电线杆ps中估计电线cb的存在的范围,期望规划例如具有比距电线杆ps的预定余量大的余量(在比预定距离更远的位置处)的轨迹g32等。

70.也就是说,在仅考虑由三维狄洛尼网格表示的障碍物来规划轨迹的情况下,存在根据障碍物的类型在不考虑与障碍物的距离的情况下规划轨迹的可能性。因此,有时不能总是规划适当的轨迹,并且因此,在移动体移动时,有时引起危险的状态。

71.鉴于此,本公开内容对所捕获图像执行物体识别处理,根据识别结果形成针对存在相同类型物体的范围内的特征点的二维狄洛尼网格,然后通过使用深度信息对该二维狄洛尼网格进行三维化,以由此表示障碍物,并且规划轨迹。

72.作为更具体的情况,将描述其中存在天空c101、障碍物b101和b102以及道路表面r101的图6的图像p101被捕获并且在相同视角的深度图像被检测的情况。

73.在这种情况下,通过基于图像p101的物体识别处理来识别图像中的天空c101、障碍物b101和b102以及道路表面r101的区域。

74.此外,如图像p102所示,从图像p101中提取特征点。

75.此外,如图像p102中所示,通过连接由物体识别处理识别的物体的每个区域中的特征点,也就是说,在障碍物b101和b102以及道路表面r101的每个区域中的特征点,形成二维狄洛尼网格。

76.此时,因为天空不能成为障碍物,所以不提取天空c101的区域附近的特征点,从而防止形成狄洛尼网格。换句话说,对于每种类型障碍物,仅将存在于可能成为障碍物的区域附近的特征点连接起来以形成狄洛尼网格。

77.然后,基于深度图像,为每个物体,即,为障碍物b101和b102中的每一个以及道路表面r101生成三维狄洛尼网格d101。

78.如上所述,针对每种类型的识别物体连接特征点以形成狄洛尼网格,然后形成三维狄洛尼网格d101。因此,在不存在物体的空间中不形成网格。这使得能够适当地规划轨迹以避开障碍物。

79.此时,代替以诸如占用网格地图的时间方向的卷积为前提而执行的处理,仅通过使用特征点的处理,能够识别障碍物的位置。这使得能够在减轻处理负荷的同时,正确地识别障碍物的位置并且规划轨迹。因此,即使高速自主移动体的轨迹也能够被适当地规划。

80.此外,由于能够识别障碍物的类型,因此能够根据障碍物的类型考虑距障碍物的

距离来规划轨迹。这使得能够在确保基于障碍物的种类的安全性的同时,将轨迹作为移动路径进行规划。

81.《2.第一实施方式》

82.《移动体的配置示例》

83.接下来,将参照图7的框图描述应用本公开内容的技术的无人机等所表示的移动体的配置示例。

84.注意,在本说明书中将描述移动体是无人机的示例,但是移动体可以是任何可移动物体,例如,车辆、飞行物体、船或机器人。

85.图7的移动体11包括控制单元31、摄像装置32、深度传感器33、存储单元34和驱动单元35。

86.控制单元31包括处理器和存储器,读取存储在存储单元34等中的预定程序或数据,执行各种处理,并且控制移动体11的整体操作。

87.此外,控制单元31包括轨迹规划单元51和操作控制单元52。

88.轨迹规划单元51基于由摄像装置32捕获的图像(rgb图像)和由深度传感器33检测到的深度图像(点云)来规划移动体11的移动路径作为轨迹,并且将规划的轨迹输出到操作控制单元52。注意,稍后将参照图8详细描述轨迹规划单元51的详细配置。

89.操作控制单元52基于从轨迹规划单元51提供的关于用作移动体11的移动路径的轨迹的信息来控制驱动单元35,从而沿着规划的轨迹使移动体11移动。

90.摄像装置32包括例如诸如电荷耦合器件(charge coupled device,ccd)或互补金属氧化物半导体(complementary metal oxidesemiconductor,cmos)的图像传感器,捕获移动体11的周围的图像(rgb图像),并且将捕获的图像输出到控制单元31的轨迹规划单元51。

91.深度传感器33包括例如光检测和测距或激光成像检测和测距(laserimaging detection and ranging,lidar)或立体摄像装置,检测与摄像装置32的视角相对应的范围内的深度图像(点云),并且将检测到的深度图像输出到控制单元31的轨迹规划单元51。注意,在第一实施方式中,将在深度传感器33是lidar的假设下进行描述。

92.存储单元34包括例如硬盘驱动器(hard disc drive,hdd)、固态驱动器(solid state drive,ssd)等,并且由控制单元31控制以存储各种程序和数据并且提供程序和数据。

93.驱动单元35包括诸如无人机的移动体11的飞行所需的各种致动器和电动机的驱动机构,并且通过操作控制单元52控制以沿着用作规划的移动路径的轨迹操作。

94.注意,在移动体11是无人机的情况下,驱动单元35包括飞行所需的驱动机构,在移动体11是车辆的情况下,驱动单元35包括行驶所需的驱动机构,在移动体11是船舶的情况下,驱动单元35包括导航所需的驱动机构,在移动体11是机器人的情况下,驱动单元35包括步行或跑步所需的驱动机构。另外,驱动单元35包括根据移动体11的形式的驱动机构。

95.《轨迹规划单元的配置示例》

96.接下来,将参照图8的框图描述轨迹规划单元51的配置示例。

97.轨迹规划单元51包括图像校正处理单元71、语义分割处理单元72、存储单元73、位置校正处理单元74、存储单元75、特征点提取单元76、狄洛尼网格创建单元77、网格三维化

单元78、动作规划单元79以及存储单元80。

98.图像校正处理单元71对由摄像装置32捕获的图像执行一般的图像校正处理,例如去除由摄像装置32中包括的镜头引起的失真、去马赛克处理和伽马校正处理,并且将校正后的图像输出到语义分割处理单元72和特征点提取单元76。

99.注意,由图像校正处理单元71执行的处理期望地与在语义分割处理单元72中用于特定语义分割学习的处理相同,并且随着由图像校正处理单元71执行的处理更接近用于学习的处理,可以提高识别精度。

100.语义分割处理单元72通过使用例如通过学习预先存储在存储单元73中的学习神经网络,基于由摄像装置32捕获的rgb图像,通过语义分割,基于像素对被摄体的类型进行分类。

101.然后,语义分割处理单元72将图像分割成相同类型的区域,附加与分割结果相对应的语义标签作为语义分割的处理结果,并且将语义标签输出到特征点提取单元76。

102.注意,在语义分割中,例如,可以使用黑白图像来代替rgb图像。此外,可以执行将相同类型的区域进一步划分为物体区域的实例分割。

103.此外,存储单元73可以由例如图7的存储单元34的部分区域形成,或者可以单独形成。

104.位置校正处理单元74将从深度传感器33提供的深度图像(点云)的坐标系转换成由摄像装置32捕获的图像的坐标系,以便基于预先存储在存储单元75中的摄像装置/深度传感器相对位置校准信息执行位置校正,并且生成具有与由摄像装置32捕获的图像对应的坐标系的深度图像(点云)。

105.因此,将由深度传感器33检测的深度图像(点云)的每个像素的坐标系转换成由摄像装置32捕获的图像的坐标系,并且在与由摄像装置32捕获的rgb图像的像素对应的位置处生成其上叠加有距离信息的深度图像(点云),然后将其输出到特征点提取单元76和网格三维化单元78。

106.此外,存储单元75可以由例如图7的存储单元34的部分区域形成,或者可以单独形成。

107.特征点提取单元76基于从图像校正处理单元71提供的rgb图像、从语义分割处理单元72提供的语义分割的处理结果以及叠加在rgb图像上的深度图像(点云),提取用作形成二维狄洛尼网格的三角形的顶点的特征点,并且将提取的特征点输出到狄洛尼网格创建单元77。

108.此时,特征点提取单元76将对应的语义标签附加至每个特征点。

109.这里,这里使用的特征点可以是例如具有被转换到摄像装置32的坐标系中的深度图像中的深度信息的像素位置。

110.也就是说,这里,深度传感器33是lidar,并且具有由lidar检测到的深度信息的像素的密度小于由摄像装置32捕获的图像中的像素的密度,并且因此像素位置可以照原样被用作特征点。

111.注意,以下,将在特征点提取单元76提取与深度图像中具有深度信息的像素位置有关的信息作为特征点的假设下进行描述。然而,可以提取其他条件下的特征点。

112.狄洛尼网格创建单元77基于从特征点提取单元76提供的特征点形成以特征点作

为顶点的三角形表面,在图像中创建二维狄洛尼网格,并且将该二维狄洛尼网格输出到网格三维化单元78。

113.此时,狄洛尼网格创建单元77形成具有特征点的三角形表面,相同的语义标签被附加至所述特征点作为顶点,以创建二维狄洛尼网格。

114.网格三维化单元78基于从狄洛尼网格创建单元77提供的二维狄洛尼网格和从位置校正处理单元74提供的深度图像(点云)对二维狄洛尼网格进行三维化,生成三维狄洛尼网格,并且将三维狄洛尼网格输出至动作规划单元79。

115.此时,网格三维化单元78基于相应深度图像(点云)的深度信息(距离信息)对二维狄洛尼网格进行三维化,并且将三维狄洛尼网格输出至动作规划单元79,在狄洛尼网格中,具有附加了相同语义标签的特征点的三角形表面作为顶点被连接。注意,在三角形的一边的长度在三维距离上非常长的情况下,此时可以从网格中移除具有非常长的边的三角形。

116.动作规划单元79基于从网格三维化单元78提供的三维狄洛尼网格来规划作为移动体11的移动路径的轨迹,并且将所规划的轨迹输出到操作控制单元52。

117.此时,动作规划单元79通过使用存储单元80中存储的每个语义标签的距离的加权系数,设置与障碍物的距离,并且规划作为移动体11的移动路径的轨迹。

118.此外,存储单元80可以由例如图7的存储单元34的部分区域形成,或者可以单独形成。

119.《语义分割》

120.接下来,将参照图9描述语义分割处理单元72的语义分割。

121.例如,如图9的左部分中所示,摄像装置32以构图的视角z171捕获由rgb图像形成的图像p171,在该构图中,道路表面111存在于左固定结构112-1与右固定结构112-2之间的空间中,人114存在于道路表面111上,并且在该人的后面可以看到天空113。

122.语义分割处理单元72读取并使用存储在存储单元73中的通过诸如深度学习的机器学习预先学习的神经网络,基于由rgb图像形成的图像p171,基于像素对图像p171中的被摄体的类型进行分类,如图9的右上部分所示,并且将类型标记为语义标签。

123.在由图9的右上部分所示的rgb图像形成的图像p171的情况下,例如,通过语义分割对物体的类型进行分类,并且如图9的右下部分中的标记图像p181所示,基于分类结果来标记语义标签。

124.也就是说,在标记图像p181中,属于图像下部分的区域z111的像素被分类为道路表面111,属于区域z112-1和z112-2的像素分别被分类为左固定结构112-1和右固定结构112-2,属于区域z113的像素被分类为背面的天空113,并且属于区域z114的像素被分类为人114。

125.除了图9的示例之外,基于rgb图像和距离图像,语义分割处理单元72在rgb图像中基于像素识别例如道路表面、固定结构(墙壁、护栏、树、电线杆等)、车辆(汽车、卡车、公共汽车等)、两轮车辆(摩托车和自行车)、人、水平栏(十字路口、etc栏和停车场门栏)和天空,并且标记上述物体。

126.注意,语义分割可以通过仅使用rgb图像、仅使用深度图像或两者的组合的机器学习来对被摄体进行分类,因此可以通过其中的任何一个来实现。

127.《将用作深度传感器的测量结果的深度图像叠加在由摄像装置拍摄的图像上》

128.接下来,将参照图10描述位置校正处理单元74将具有关于由包括lidar、立体摄像装置等的深度传感器33测量的三维空间中的点集的信息的深度图像(点云)的每个像素叠加在由摄像装置32捕获的图像的坐标系的像素上并且生成深度图像的处理。

129.注意,这里,将在深度传感器33是lidar的假设下进行描述,但是将在深度传感器33是立体摄像装置等的假设下进行类似的描述。

130.例如,通过将lidar 33的每个光投影方向l

p

上的测距结果叠加在图10的左上部分中示出的摄像装置32的图像p151上来生成距离图像(深度图像)。

131.关于lidar 33和摄像装置32与图像中心之间的相对位置以及摄像装置302的焦距的信息被预先存储在存储单元75中,作为通过预备校准的摄像装置/深度传感器相对位置校准信息(预备信息)。因此,位置校正处理单元74使用存储在存储单元75中的摄像装置/深度传感器相对位置校准信息,通过以下计算来生成深度图像。

132.首先,位置校正处理单元74将包括lidar的深度传感器33的坐标系集成到摄像装置32的坐标系中。

133.也就是说,如图10的右上部分所示,用作包括lidar的深度传感器33的坐标系的坐标x

lidar

(=[x

l

,y

l

,z

l

]的转置矩阵)与摄像装置302在图像捕获表面d上的坐标系的坐标x

cam

(=[xc,yc,zc]的转置矩阵)之间的相对位置关系通过校准而被称为预备信息,并且例如从以下表达式(1)获得。

[0134]

x

cam

=ex

lidar

t

ꢀꢀꢀ

(1)

[0135]

这里,r表示通过校准预先已知的指示包括lidar的深度传感器33与摄像装置32之间的旋转矩阵,并且t表示也通过校准预先已知的平移向量。

[0136]

通过计算以上表达式(1),将作为关于包括lidar的深度传感器33的坐标系的信息而测量的测距结果的点x的坐标转换为摄像装置的坐标系。

[0137]

接下来,位置校正处理单元74将lidar 33的测距结果与摄像装置32在图像捕获表面上的坐标系相关联。

[0138]

也就是说,当获得由包括lidar的深度传感器33检测到的障碍物的坐标x

cam

(=[xc,yc,zc]转置)时,如图10的右下部分所示,可以从下面的表达式(2)获得图像捕获表面d上的障碍物在基于图像捕获表面d的图像中心pc的图像平面上的xi坐标。

[0139]

xi=f

×

xc/zcꢀꢀꢀ

(2)

[0140]

这里,f表示摄像装置32的焦距。

[0141]

此外,同样地,yi坐标可以从下面的表达式(3)获得。

[0142]

yi=f

×

yc/zcꢀꢀꢀ

(3)

[0143]

结果,可以识别障碍物在图像捕获表面d上的位置。

[0144]

也就是说,基于光投影方向,将由包括lidar的深度传感器33检测到的三维点的坐标x

lidar

(=[x

l

,y

l

,z

l

])转换为摄像装置32的坐标系中的三维点的坐标x

cam

(=[xc,yc,zc])。此外,基于摄像装置32的焦距f,根据表达式(2)和(3)计算以与摄像装置32的坐标系中的三维点的坐标x

cam

(=[xc,yc,zc])对应的图像捕获表面d为中心的图像捕获表面上的坐标(xi,yi)。

[0145]

通过该处理,位置校正处理单元74生成如图10的左下部分所示的距离图像p152。

[0146]

距离图像p152具有与摄像装置32的图像相同的像素布置。由于上述坐标系的转

换,在所有像素(xi,yi)中,像素在lidar 33的光投影方向上并且具有测距结果的情况下,与每个像素相关联地存储距离数据(图10的右下部分中的zc),而在像素不在光投影方向上或不具有测距结果的情况下,例如,0被存储作为距离数据。

[0147]

《特征点的提取》

[0148]

接下来,将参照图11描述在特征点提取单元76中提取特征点的方法。

[0149]

例如,将描述如图11的左部分所示的图像p201,其中障碍物b101和b102存在于道路表面r101上,并且天空c101在障碍物上方。

[0150]

由图10中的lidar 33在每个光投影方向l

p

上得到的测距结果被叠加在图像p201中的由圆标记指示的每个位置上。

[0151]

如图11的右上部分所示,例如,在各自包括由lidar33在每个光投影方向l

p

上的测距结果的圆标记的语义标签中,特征点提取单元76利用语义标签来标记具有不同于不能成为障碍物的天空c101的标记的圆标记的点,并且提取这些点作为特征点。

[0152]

如上所述,因为仅提取了用在移动体11移动时可能是障碍物的语义标签标记的特征点,所以可以在基于所提取的特征点要被识别为障碍物的物体存在的区域中形成狄洛尼网格。这使得可以规划轨迹以避开障碍物。

[0153]

此外,只需要提取特征点,使得可以在基于所提取的特征点要被识别为障碍物的物体存在的区域中形成狄洛尼网格,并且因此可以提取存在于存在可以是障碍物的物体的区域的边界上的特征点。

[0154]

也就是说,如图11的右下部分所示,在图11的左部分中的圆标记之中,特征点提取单元76可以提取存在于以下边界中的每一个上的圆标记作为特征点:道路表面r101、天空c101与障碍物b101之间的边界;道路表面r101、天空c101与障碍物b102之间的边界;以及道路表面r101与天空c101之间的边界。

[0155]

更具体地,特征点提取单元76可以在满足以下条件中的至少一个时提取特征点:如虚线所示的特征点周围的区域sl所示,对于每个圆标记(l

p

),在箭头所示的水平方向和垂直方向上邻接的圆标记具有不同的语义标签的条件;基于深度图像的深度信息(距离信息)的差大于预定值的条件;以及在相邻特征点之间存在边缘的条件。

[0156]

这使得可以使所提取的特征点更稀疏。因此,可以在进一步减少处理负荷的同时适当地识别障碍物的位置。

[0157]

《狄洛尼网格的创建》

[0158]

接下来,将参照图12描述狄洛尼网格创建单元77对二维狄洛尼网格的创建。

[0159]

狄洛尼网格创建单元77针对每个所附加的语义标签连接从特征点提取单元76提供的特征点,以创建具有三角形表面的二维狄洛尼网格。

[0160]

也就是说,例如,将描述如图12的图像p231所示的情况,其中,用黑色圆标记指示的障碍物b101的语义标签标记的特征点、用白色圆标记指示的障碍物b102的语义标签标记的特征点以及用白色正方形标记指示的道路表面r101的语义标签标记的特征点被分别提取为特征点。

[0161]

在这样的情况下,如图12的图像p232所示,狄洛尼网格创建单元77连接用黑色圆标记指示的障碍物b101的语义标签标记的特征点,以创建二维狄洛尼网格mb101。

[0162]

此外,狄洛尼网格创建单元77连接用白色圆标记指示的障碍物b102的语义标签标

记的特征点,以创建二维狄洛尼网格mb102。

[0163]

此外,狄洛尼网格创建单元77连接用道路表面r101的语义标签标记的特征点,以创建二维狄洛尼网格mr101。

[0164]

也就是说,在图像p231的情况下,狄洛尼网格创建单元77如图像p232中所示连接每个相同语义标签的特征点,以创建二维狄洛尼网格,其中障碍物b101的狄洛尼网格mb101、障碍物b102的狄洛尼网格mb102以及道路表面r101的狄洛尼网格mr101被组合。

[0165]

《狄洛尼网格的三维化》

[0166]

接下来,将参照图13描述网格三维化单元78对二维狄洛尼网格进行三维化的处理。

[0167]

基于深度图像(点云)中的深度信息,网格三维化单元78对从狄洛尼网格创建单元77提供的二维狄洛尼网格进行三维化,并且生成三维狄洛尼网格。

[0168]

例如,如图13的左部分所示,将说明提供与图12的图像p231对应的障碍物b101的狄洛尼网格mb101、障碍物b102的狄洛尼网格mb102以及道路表面r101的狄洛尼网格mr101组合而得到的二维狄洛尼网格的情况。

[0169]

在这种情况下,网格三维化单元78使用障碍物b101的狄洛尼网格mb101、障碍物b102的狄洛尼网格mb102和道路表面r101的狄洛尼网格mr101的每个特征点的深度信息(距离信息),以例如将特征点布置在与深度信息相对应的位置处,如图13的右部分所示,并且对狄洛尼网格进行三维化,从而生成狄洛尼网格d111。

[0170]

更具体地,在三维狄洛尼网格d111中,网格三维化单元78基于特征点的距离信息对障碍物b101的狄洛尼网格mb101进行三维化,从而生成三维狄洛尼网格tmb101。

[0171]

此外,网格三维化单元78基于特征点的距离信息对障碍物b102的狄洛尼网格mb102进行三维化,从而生成三维狄洛尼网格tmb102。

[0172]

此外,网格三维化单元78基于特征点的距离信息对道路表面r101的狄洛尼网格mr101进行三维化,从而生成三维狄洛尼网格tmr101。

[0173]

如上所述,网格三维化单元78对障碍物b101的二维狄洛尼网格mb101、障碍物b102的二维狄洛尼网格mb102以及道路表面r101的二维狄洛尼网格mr101进行三维化,并且生成并组合障碍物b101的三维狄洛尼网格tmb101、障碍物b102的三维狄洛尼网格tmb102以及道路表面r101的三维狄洛尼网格tmr101,从而生成三维狄洛尼网格d111。

[0174]

因为如上所述生成三维狄洛尼网格d111,所以没有通过连接不同障碍物的特征点来形成表面。因此,不会形成狄洛尼网格中的表面,该表面指示在没有障碍物的空间中是否存在障碍物。这使得可以适当地识别障碍物的位置。

[0175]

可以识别障碍物的类型并适当地识别障碍物的位置。

[0176]

《动作规划》

[0177]

接下来,将参照图14至16描述通过动作规划单元79规划包括移动体的移动路径的轨迹而获得的动作规划。

[0178]

动作规划单元79读出针对存储单元80中存储的每个语义标签设置的距离的加权系数,并且规划包括最佳移动路径的轨迹。

[0179]

更具体地,动作规划单元79将能够规划的从当前位置到目的地的轨迹作为轨迹候选进行规划。然后,动作规划单元79通过使用评价函数计算所规划的全部轨迹候选中的各

个轨迹候选的评价值,并且选择评价值最高的轨迹候选作为最佳轨迹。

[0180]

更具体地,首先,如图14所示,将说明动作规划单元79规划移动体11在当前位置移动到目的地tp的轨迹候选g51至g59的情况。

[0181]

动作规划单元79首先选择能够避开障碍物b121的轨迹候选。

[0182]

在选择能够避开障碍物b121的轨迹候选时,选择能够避开图14中由虚线围绕的障碍物b121周围的范围的轨迹候选,该范围具有根据障碍物b121的语义标签的距离余量。

[0183]

也就是说,在图14中,选择轨迹候选g51至g53和轨迹候选g57至g59。

[0184]

注意,根据障碍物b121的语义标签来设置余量。

[0185]

也就是说,如图15所示,在障碍物b131被标记有诸如树或建筑物的能够正确识别大小的语义标签,并且即使与移动体接触也难以受到影响的情况下,动作规划单元79例如将距离r1设置为余量,并且选择轨迹候选g71。

[0186]

同时,在障碍物b132被标记有例如人、动物或电线杆等(根据由摄像装置捕获的图像,无法以充分的识别精度识别电线杆等附近的电线等,在与移动体接触时受到较大影响)的语义标签的摄像装置情况下,动作规划单元79增大余量,例如设置距离r2(>r1),并且选择轨迹候选g72。

[0187]

通过根据障碍物的语义标签,也就是说,如上所述的障碍物的类型,改变余量的大小,可以考虑接触的影响来选择包括移动路径的轨迹候选。这使得可以考虑安全性来规划轨迹。

[0188]

另外,动作规划单元79基于能够避开障碍物的轨迹候选g51至g53以及轨迹候选g57至g59的各自的航向角θ、移动速度v以及距障碍物的距离d,通过使用由以下表达式(4)所表示的评价函数来计算评价值f。

[0189]

f=ω

θ

·eθ

ωv·ev

ωd·

edꢀꢀꢀ

(4)

[0190]

这里,ω

θ

、ωv、ωd分别表示航向角θ、移动速度v以及距障碍物的距离d的权重。

[0191]

此外,e

θ

表示航向角θ的评价函数,航向角θ是从当前移动体11到目的地的移动方向与直线方向之间的角度。随着相对于目的地的角度越小,也就是说,随着移动体越接近目的地,评价值越大,而随着移动体距目的地越远以绕道,评价值越小。

[0192]ev

表示移动速度v的评价值。随着移动速度v越快,评价值越大,而随着移动速度v越慢,也就是说,随着移动体花费更多时间到达目的地,评价值越小。

[0193]

ed表示距障碍物的距离d的估计值。随着距障碍物的距离越远,评价值越大,而随着距障碍物的距离越近,也就是说,接触的风险越高,评价值越小。

[0194]

这里,距障碍物的距离d的评价值ed被设置为在轨迹上的每个采样点处获得的并且由以下表达式(5)示出的最小评价值。

[0195]

ed=min(αs·

dist(s))

ꢀꢀꢀ

(5)

[0196]

这里,αs表示根据语义标签s预设的权重,dist(s)表示从每个轨迹上的每个采样点到语义标签s被设置到的障碍物的最短距离,并且,当针对语义标签s评估αs和dist(s)的乘积的值时,min表示其最小值的输出。最后,随着根据语义标签s设置的预设权重αs较小,倾向于选择离语义标签s的障碍物较远的轨迹。

[0197]

更具体地,如图16所示,在障碍物b151和b152存在、轨迹l151被规划并且样本点sp1至sp5被设置在轨迹上的情况下,从样本点sp1至sp5到障碍物b151和b152的最短距离被

获得为距离d151-1至d151-5和距离d152-1至d152-5。

[0198]

这里,距障碍物b151的最短距离是距离d151-5,并且距障碍物b152的最短距离是距离d152-4。

[0199]

因此,在障碍物b151的语义标签是lb151的情况下,障碍物b151针对图16的轨迹l151的评价值e

d_b151

是α

lb151

·

dist(lb151)=α

lb151

×

距离d151-5。这里,α

lb151

表示根据语义标签lb151预设的权重。

[0200]

此外,在障碍物b152的语义标签为lb152的情况下,障碍物b152的针对图16的轨迹l151的评价值e

d_b152

是α

lb152

·

dist(lb152)=α

lb152

×

距离d152-4,其中,α

lb152

表示根据语义标签lb152预设的权重。

[0201]

因此,图16的轨迹l151的评价值ed是基于评价值e

db_151

和评价值e

d_b152

获得的,并且被设置成例如评价值e

d_b151

和评价值e

d_b152

的最小值min(e

d_b151

,e

d_b152

)。此外,可以使用平均值来代替最小值。

[0202]

也就是说,动作规划单元79从能够避开障碍物的轨迹之中选择具有根据表达式(4)的评价函数计算出的最大评价值f的轨迹候选作为轨迹。

[0203]

图14示出了根据评价函数计算能够避开障碍物的轨迹候选g51至g53和轨迹候选g57至g59中的每一个的评价值f,选择评价值f最大的轨迹候选作为轨迹,并且例如,由长短交替的虚线所示的轨迹候选g53具有最大评价值并且被选择作为轨迹。

[0204]

《图8的轨迹规划单元的轨迹规划处理》

[0205]

接下来,将参照图17的流程图描述图8的轨迹规划单元的轨迹规划处理。

[0206]

在步骤s11中,摄像装置32捕获图像并且将该图像输出至图像校正处理单元71。

[0207]

在步骤s12中,图像校正处理单元71对由摄像装置32捕获的图像执行一般的图像校正处理,例如去除由摄像装置32中包括的镜头引起的失真、去马赛克处理和伽马校正处理,并且将校正后的图像输出到语义分割处理单元72和特征点提取单元76。

[0208]

在步骤s13中,语义分割处理单元72通过使用通过学习预先存储在存储单元73中的学习的神经网络,基于由摄像装置32捕获的rgb图像,通过语义分割,基于像素对被摄体的类型进行分类,根据与分类结果对应的语义标签,将图像划分为区域,并且将语义分割的处理结果输出到特征点提取单元76。

[0209]

在步骤s14中,深度传感器33检测包括摄像装置32的图像捕获范围的范围内的深度图像(点云),并且将该深度图像输出到位置校正处理单元74。

[0210]

在步骤s15中,位置校正处理单元74基于预先存储在存储单元75中的摄像装置/深度传感器相对位置校准信息,通过位置校正将从深度传感器33提供的深度图像(点云)的坐标系转换成由摄像装置32捕获的图像的坐标系,生成具有与由摄像装置32捕获的图像对应的坐标系的深度图像(点云),并且将所生成的深度图像输出到特征点提取单元76和网格三维化单元78。

[0211]

在步骤s16中,特征点提取单元76基于从图像校正处理单元71提供的rgb图像、从语义分割处理单元72提供的语义分割的处理结果(语义标签的区域划分结果)以及叠加在rgb图像上的深度图像(点云),提取用作形成狄洛尼网格的三角形的顶点的特征点,并且将提取的特征点输出到狄洛尼网格创建单元77。

[0212]

此时,特征点提取单元76将对应的语义标签附加至每个特征点。特征点是在rgb图

像上叠加深度信息(距离信息)的像素位置处的像素。

[0213]

在步骤s17中,狄洛尼网格创建单元77基于从特征点提取单元76提供的特征点,将特征点划分为针对每个相同语义标签以特征点作为顶点的三角形表面,在图像中创建二维狄洛尼网格,并且将该二维狄洛尼网格输出至网格三维化单元78。

[0214]

在步骤s18中,网格三维化单元78基于从狄洛尼网格创建单元77提供的二维狄洛尼网格和从位置校正处理单元74提供的深度图像(点云)对二维狄洛尼网格进行三维化,并且将三维狄洛尼网格输出至动作规划单元79。

[0215]

在步骤s19中,动作规划单元79基于三维狄洛尼网格为每个语义标签计算距障碍物的距离。此时,根据语义标签计算与障碍物的距离以包括余量。

[0216]

在步骤s20中,动作规划单元79规划朝向目的地的多个轨迹候选。

[0217]

在步骤s21中,动作规划单元79加入与语义标签对应的权重,通过利用评价函数计算每个轨迹候选的评价值,并且对轨迹候选进行评价。

[0218]

在步骤s22中,动作规划单元79从轨迹候选之中选择评价值最高的轨迹候选,并且将所选择的轨迹候选作为最佳轨迹输出到动作控制单元52。

[0219]

通过以上处理,为每个语义标签形成狄洛尼网格,并且基于深度图像(点云)进一步对其进行三维化。这使得可以适当地掌握障碍物的位置。

[0220]

由此,即使在区域内没有障碍物,也能够防止形成好像存在障碍物那样的网格。因此,能够防止生成避开没有障碍物的空间的不必要的绕行轨迹。

[0221]

此外,可以根据语义根据距障碍物的距离来设置余量。这使得可以根据障碍物的类型来规划以适当距离分开的轨迹。因此,可以在确保安全性的同时规划适当的轨迹。

[0222]

此外,可以基于评价函数根据航向角、移动速度和距障碍物的距离获得每个轨迹候选的评价值,并且基于获得的评价值选择最佳轨迹。

[0223]

注意,在上文中,已经描述了通过使用特征点由狄洛尼网格表示障碍物的示例。然而,网格可以通过狄洛尼网格之外的方法形成,因为只需要通过使用特征点来表示障碍物。

[0224]

《3.第二实施方式》

[0225]

在上文中,已经描述了通过使用由摄像装置32捕获的rgb图像和由深度传感器33检测的深度图像(点云)来生成三维狄洛尼网格以适当地识别障碍物的位置并规划轨迹的示例。

[0226]

然而,可以通过提供另一摄像装置,即,通过使用总共包括两个摄像装置而不是深度传感器33的立体摄像装置,来获取深度图像(点云)以规划轨迹。

[0227]

图18示出了移动体11的配置示例,其中,设置了另一摄像装置来代替深度传感器33,即,使用总共包括两个摄像装置的立体摄像装置来规划轨迹。

[0228]

注意,在图18的移动体11中,具有与图7的移动体11中的那些功能相同的功能的相同配置由相同的附图标记表示,并且将适当地省略其描述。

[0229]

也就是说,图18的移动体11与图7的移动体11的不同之处在于,代替摄像装置32和深度传感器33而设置立体摄像装置201。

[0230]

立体摄像装置201包括被设置成生成视差的摄像装置211-1和211-2,每个摄像装置捕获图像并且将图像输出到轨迹规划单元51。

[0231]

摄像装置211-1和211-2都是具有与摄像装置32相同功能的摄像装置。

[0232]

将由摄像装置211-1、211-2捕获的图像相互视为视差图像,并且轨迹规划单元51使用该视差,形成与由上述深度传感器33取得的深度图像(点云)对应的深度图像。

[0233]

因此,基本上,通过使用摄像装置211-1和211-2的图像中的一个作为参考并且使用从这两个图像获得的深度图像(点云),通过与图7的运动体11的处理类似的处理来形成三维狄洛尼网格并且规划轨迹。

[0234]

《图18的移动体中的轨迹规划单元的配置示例》

[0235]

接下来,将参照图19描述图18的移动体11中的轨迹规划单元51的配置示例。

[0236]

注意,在图19的轨迹规划单元51中,具有与图8的轨迹规划单元51中的功能相同的功能的配置由相同的附图标记表示,并且适当省略其说明。

[0237]

图19的轨迹规划单元51与图8的轨迹规划单元51的不同点在于,代替图像校正处理单元71、位置校正处理单元74、存储单元75设置图像校正处理单元231-1和231-2、存储单元232-1和232-2、视差估计单元233以及深度可靠性过滤单元234。

[0238]

图像校正处理单元231-1和231-2对由各个摄像装置211-1和211-2捕获的图像执行一般的图像校正处理,例如,去除由各个摄像装置211-1和211-2中所包括的镜头引起的失真、去马赛克处理和伽马校正处理。

[0239]

此外,图像校正处理单元231-1和231-2基于预先存储在存储单元232-1、232-2中的立体摄像装置校正信息,对图像进行校正,该立体摄像装置校正信息用于校正由具有视差的摄像装置211-1和211-2捕获的图像的相对位置关系。

[0240]

此外,图像校正处理单元231-1将校正后的图像输出到语义分割处理单元72和特征点提取单元76,并且还将校正后的图像输出到视差估计单元233。

[0241]

图像校正处理单元231-2将校正后的图像输出到视差估计单元233。

[0242]

注意,图19示出了与图8的轨迹规划单元51的摄像装置32对应的参考图像是轨迹规划单元51的摄像装置211-1捕获的图像的配置示例。然而,也可以使用摄像装置211-2捕获的图像作为参考。

[0243]

视差估计单元233估计从图像校正处理单元231-1和231-2提供的右图像和左图像两个的视差,生成深度图像(点云),并且将深度图像输出到深度可靠性过滤单元234。

[0244]

更具体地,视差估计单元233通过图案匹配等,参照从图像校正处理单元231-1提供的图像,获得从图像校正处理单元231-2提供的图像的视差(像素位移),并且基于所获得的视差生成深度图像。

[0245]

深度可靠性过滤单元234存储从视差估计单元233提供的深度图像(点云),并且基于自身位置在取得过去的深度图像的时刻的位移,将当前的深度图像作为过去的深度图像进行投影,获得深度差,该深度差是与基于像素的过去的深度图像的深度信息的差,并且基于该深度差获得基于像素的深度信息的可靠性。

[0246]

然后,深度可靠性过滤单元234基于针对每个像素获得的可靠性对要输出到后一级的深度信息进行过滤,生成仅具有可靠深度信息的深度图像(点云),并且将该深度图像输出到特征点提取单元76和网格三维化单元78。

[0247]

已知由立体摄像装置201获得的深度信息通常具有比使用lidar等的深度传感器33更高的环境依赖性,并且由于错误匹配而出现许多错误。

[0248]

因此,如果原样使用深度信息来创建狄洛尼网格,则狄洛尼网格的时间变化可能

由于错误匹配所引起的误差的影响而增加,这可能不利地影响轨迹规划。

[0249]

鉴于此,这里,评价深度信息的可靠性,并且过滤(去除)不可靠的深度信息。

[0250]

在上文中,已经描述了使用深度差作为可靠性滤波的指标的示例。然而,可以使用除以上指标之外的指标,并且例如,可以使用立体匹配时的匹配误差。

[0251]

此外,已知在用于视差评价的输入图像中,深度信息在纹理或边缘存在的范围中具有高精度。因此,纹理或边缘强度可以用作可靠性过滤的指标。

[0252]

此外,使用中值滤波器等的空间分布或时间稳定性可以用作可靠性过滤的指标。

[0253]

注意,稍后将参照图20详细描述深度可靠性过滤单元234的详细配置。

[0254]

自身位置位移检测单元235包括例如运动传感器等,检测从过去的深度图像的获取时刻到当前的深度图像的获取时刻之间的自身位置的位移,并且将检测出的位移输出到深度可靠性过滤单元234。

[0255]

《深度可靠性过滤单元的配置示例》

[0256]

接下来,将参照图20描述深度可靠性过滤单元234的配置示例。

[0257]

深度可靠性过滤单元234包括缓冲器251、投影单元252、深度差计算单元253和阈值比较单元254。

[0258]

缓冲器251存储提供的深度图像,并且每当提供新的深度图像时重写和存储提供的深度图像。此时,紧接在重写和存储新的深度图像之前,缓冲器251将先前存储的深度图像输出到深度差计算单元253。注意,关于是否更新缓冲器251的图像,通过使用自身位置位移信息,可以仅当特定距离或角度改变时更新缓冲器251的图像。

[0259]

当提供新的深度图像时,投影单元252从先前深度图像被提供给当前的时刻获取自身位置位移信息,基于自身位置位移信息在提供了过去深度图像的时刻将当前深度图像作为深度图像投影在自身位置处,并且将深度图像与获取的当前深度图像一起输出到深度差计算单元253。

[0260]

深度差计算单元253基于自身位置位移信息来计算深度差,并将该深度差与所获取的当前深度图像一起输出到阈值比较单元254,该深度差是在紧挨从缓冲器251提供新深度图像之前获取的过去深度图像与在过去时刻处作为深度图像投影的当前深度图像之间的基于像素的深度信息的差。

[0261]

阈值比较单元254基于像素将深度差与阈值进行比较,过滤具有大于阈值的深度差的不可靠深度信息,并且仅将具有深度差小于阈值的可靠深度信息的深度图像(点云)输出到特征点提取单元76和网格三维化单元78。

[0262]

注意,由视差估计单元233估计的深度图像被生成为具有比由包括lidar等的深度传感器生成的深度图像更密集的深度信息,并且因此,在由lidar等获得低密度深度信息的情况下,可以原样使用深度信息作为特征点,但是,当使用所有深度信息时,可能存在太多的特征点。

[0263]

鉴于此,深度可靠性过滤单元234的阈值比较单元254可以将例如深度差的阈值设置为接近0的值以增大稀疏比,使得仅将特别可靠的像素的深度信息原样用作特征点。

[0264]

《图19的轨迹规划单元的轨迹规划处理》

[0265]

接下来,将参照图21的流程图描述图19的轨迹规划单元的轨迹规划处理。

[0266]

注意,图21的流程图中的步骤s56至s62中的处理类似于图17的步骤s16至s22中的

处理,并且因此将省略其描述。

[0267]

具体地,在步骤s51中,立体摄像装置201的两个摄像装置211-1和211-2分别捕获图像并且将图像输出至图像校正处理单元231-1和231-2。

[0268]

在步骤s52中,图像校正处理单元231-1和231-2对由各个摄像装置211-1和211-2捕获的图像执行一般的图像校正处理,例如去除由摄像装置211-1和211-2中所包括的镜头引起的失真、去马赛克处理和伽马校正处理。

[0269]

此外,图像校正处理单元231-1和231-2基于存储在各个存储单元232-1和232-2中的立体摄像装置校准信息来执行处理。

[0270]

然后,图像校正处理单元231-1将处理后的图像输出到语义分割处理单元72、特征点提取单元76和视差估计单元233。

[0271]

此外,图像校正处理单元231-2将处理后的图像输出到视差估计单元233。

[0272]

在步骤s53中,语义分割处理单元72通过使用通过学习预先存储在存储单元73中的学习的神经网络,基于由摄像装置211-1捕获的rgb图像,通过语义分割,基于像素对被摄体的类型进行分类,根据对应于分类结果的语义标签,将图像划分为区域,并且将语义分割的处理结果输出到特征点提取单元76。

[0273]

在步骤s54中,视差估计单元233通过参照从图像校正处理单元231-1提供的图像对从图像校正处理单元231-2提供的图像执行模式匹配等,基于来自参考像素的视差获得深度信息,生成深度图像(点云),并且将深度图像输出到深度可靠性过滤单元234。

[0274]

在步骤s55中,深度可靠性过滤单元234执行滤波处理,以基于深度图像(点云)中的每条深度信息的可靠性来对深度信息进行过滤,生成仅具有可靠深度信息的深度图像(点云),并且将深度图像输出到特征点提取单元76和网格三维化单元78。

[0275]

注意,稍后将参照图22的流程图来描述滤波处理的细节。

[0276]

通过以上一系列处理,可以通过使用立体摄像装置201代替摄像装置32和深度传感器33来适当地规划包括移动体11的移动路径的轨迹。

[0277]

《过滤处理》

[0278]

接下来,将参照图22的流程图描述深度可靠性过滤单元234的过滤处理。

[0279]

在步骤s81中,深度差计算单元253读取紧挨在缓冲器251中缓冲之前获取的过去的深度图像。

[0280]

在步骤s82中,缓冲器251获取当前从视差估计单元233提供的深度图像,将该深度图像覆盖在过去的深度图像上,并且缓冲该深度图像。

[0281]

在步骤s83中,投影单元252从自身位置位移检测单元235获取自身位置变化信息,该自身位置变化信息是自身位置从过去的深度图像的获取时刻到当前的深度图像的获取时刻的位移。

[0282]

在步骤s84中,投影单元252基于自身位置位移信息将当前深度图像投影为先前获取的深度图像,并且将深度图像与当前深度图像一起输出到深度差计算单元253。

[0283]

在步骤s85中,深度差计算单元253基于自身位置变化信息获得深度差,并且将该深度差与当前深度图像一起输出到阈值比较单元254,该深度差是过去深度图像的像素与投影为过去深度图像的当前深度图像的像素之间的深度信息的差。

[0284]

在步骤s86中,阈值比较单元254将当前深度图像中未处理的像素设置为要处理的

像素。

[0285]

在步骤s87中,阈值比较单元254判断对应于要处理像素的深度差是否大于预定阈值。

[0286]

在步骤s87,在确定与要处理的像素对应的深度差大于预定阈值的情况下,也就是说,在前一深度图像与当前深度图像之间存在大的变化的情况下,处理进行到步骤s88。

[0287]

在步骤s88中,由于深度差值大且其变化大,因此阈值比较单元254确定与要处理的像素对应的深度信息不可靠,并且因此不输出深度信息。

[0288]

同时,在步骤s87中,在确定与要处理的像素对应的深度差小于预定阈值的情况下,也就是说,在前一深度图像与当前深度图像之间的变化小的情况下,处理进行到步骤s89。

[0289]

在步骤s89中,由于深度差值较小,并且其变化较小,因此阈值比较单元254确定与要处理像素对应的深度信息是可靠的,并且因此将该深度信息与像素位置相关联地缓存为要输出的深度信息。

[0290]

在步骤s90中,阈值比较单元254确定当前深度图像中是否存在未处理的像素,并且如果存在未处理的像素,则处理返回到步骤s86。

[0291]

也就是说,重复步骤s86至s90中的处理,直到确定不存在未处理的像素,并且基于深度差与阈值之间的比较来确定当前深度图像中的所有像素的可靠性,并且仅缓冲可靠的深度信息。

[0292]

然后,在步骤s90中确定不存在未处理的像素的情况下,处理进行到步骤s91。

[0293]

在步骤s91中,阈值比较单元254将具有已经被确定为可靠的缓冲深度信息的深度图像(点云)输出到特征点提取单元76和网格三维化单元78。

[0294]

通过以上处理,可以获得基于自身位置的位移而被投影为过去深度图像的当前深度图像与缓冲的过去深度图像之间的深度差,将具有大于阈值的深度差的当前深度信息过滤(去除)为不可靠的深度信息,并且输出仅具有其深度差小于阈值的可靠深度信息的深度图像(点云)。

[0295]

结果,可以抑制通过使用立体摄像装置获取的深度图像(点云)的可靠性降低,并且因此可以通过使用便宜的立体摄像装置而不是使用昂贵的lidar等来实现适当的轨迹规划。

[0296]

《4.第三实施方式》

[0297]

在上文中,已经描述了使用立体摄像装置201而不是摄像装置32和深度传感器33来进行轨迹规划的示例。然而,在摄像装置32和深度传感器33中,摄像装置32可以被偏振摄像装置代替,以捕获偏振图像,识别图像捕获表面上的法线方向,并且提取具有不同法线方向的相邻特征点。

[0298]

例如,如图23所示,在通过偏振摄像装置捕获柱状障碍物b301和矩形障碍物b302的图像时,如箭头所示,能够通过预定处理来检测法线方向。

[0299]

结果,可以仅选择性地提取满足以下条件中的至少一个的特征点:如图11的右下部分所示,相邻特征点具有不同语义标签的条件、相邻特征点之间的距离的差大于预定值的条件以及相邻特征点之间存在边缘的条件;以及相邻特征点具有不同法线方向的条件。

[0300]

这使得在柱状障碍物b301的情况下,能够提取上基底的弯曲侧表面sf1与盘表面

sf2之间的边界、以及下基底的弯曲侧表面sf1与盘表面sf3之间的边界附近的特征点。

[0301]

此外,在矩形障碍物b302的情况下,可以提取平坦表面sf11至sf13之间的边界附近的特征点。

[0302]

结果,可以仅有效地提取距离或形状改变的位置处的特征点,并且形成三维狄洛尼网格。这使得能够形成适当反映障碍物的位置和形状的狄洛尼网格。因此,能够适当地规划包括移动体的移动路径的轨迹,以便避开障碍物。

[0303]

图24示出了移动体11的配置示例,其中,捕获偏振图像,识别图像捕获表面上的法线方向,并且提取法线方向改变的位置处的特征点。

[0304]

在图24的移动体11中,具有与图7的移动体11中的那些功能相同的功能的配置由相同的附图标记表示,并且将适当地省略其描述。

[0305]

也就是说,图24的移动体11的配置与图7的移动体11的配置的不同之处在于,设置偏振摄像装置301来代替摄像装置32。

[0306]

偏振摄像装置301包括偏振透镜,捕获通过对由摄像装置32捕获的图像执行偏振处理而获得的偏振图像,并且将偏振图像输出到轨迹规划单元51。

[0307]

《使用偏振图像的轨迹规划单元的配置示例》

[0308]

接下来,将参照图25描述使用偏振图像的轨迹规划单元51的配置示例。

[0309]

注意,在图25的轨迹规划单元51中,具有与图8的轨迹规划单元51中的那些功能相同的功能的配置由相同的附图标记表示,并且将适当地省略其说明。

[0310]

也就是说,图25的轨迹规划单元51与图8的轨迹规划单元51的不同之处在于:设置图像校正处理单元311来代替图像校正处理单元71和特征点提取单元76;以及设置法线估计单元312和特征点提取单元313,该法线估计单元312基于偏振图像估计图像中的被摄体表面的法线方向。

[0311]

图像校正处理单元311在基本功能上与图像校正处理单元71相同,但是还将偏振图像输出到法线估计单元312。

[0312]

法线估计单元312基于从图像校正处理单元311提供的偏振图像来估计被摄体表面的法线方向,并且将估计的法线方向输出到特征点提取单元313。

[0313]

特征点提取单元313在基本功能上类似于特征点提取单元76,但是提取满足以下条件中的至少一个的特征点:相邻特征点具有不同语义标签的条件;相邻特征点之间的距离差大于预定值的条件;在相邻特征点之间存在边缘的条件;以及相邻特征点具有不同法线方向的条件。

[0314]

通过这样的配置,提取存在于法线方向变化的区域的特征点。

[0315]

《图25的轨迹规划单元的轨迹规划处理》

[0316]

接下来,将参照图26的流程图描述图25的轨迹规划单元的轨迹规划处理。

[0317]

注意,图26的流程图中的步骤s88至s93中的处理与图17的流程图中的步骤s17至s22中的处理类似,并且因此将省略其描述。

[0318]

也就是说,在步骤s81中,偏振摄像装置301捕获偏振图像,并且将偏振图像输出到图像校正处理单元311。

[0319]

在步骤s82中,图像校正处理单元311对偏振摄像装置301捕获的偏振图像执行一般图像校正,例如去除由偏振摄像装置301中包括的镜头引起的失真、去马赛克处理和伽马

校正处理,并且将校正后的图像输出到语义分割处理单元72和特征点提取单元313,并且还将偏振图像输出到法线估计单元312。

[0320]

在步骤s83中,法线估计单元312基于偏振摄像装置301捕获的偏振图像来估计图像中的被摄体表面的法线方向,并且将估计结果输出到特征点提取单元313。

[0321]

在步骤s84中,语义分割处理单元72通过使用通过学习预先存储在存储单元73中的学习的神经网络,基于由摄像装置32捕获的rgb图像,通过语义分割,基于像素对被摄体的类型进行分类,根据与分类结果对应的语义标签,将图像划分为区域,并且将语义分割的处理结果输出到特征点提取单元313。

[0322]

在步骤s85中,深度传感器33检测包括偏振摄像装置301的图像捕获范围的范围内的深度图像(点云),并且将深度图像输出到位置校正处理单元74。

[0323]

在步骤s86中,位置校正处理单元74基于预先存储在存储单元75中的摄像装置/深度传感器相对位置校准信息,通过位置校正将从深度传感器33提供的深度图像(点云)的坐标系转换成由摄像装置32捕获的图像的坐标系,生成具有与由摄像装置32捕获的图像对应的坐标系的深度图像(点云),并且将所生成的深度图像输出到特征点提取单元313和网格三维化单元78。

[0324]

在步骤s87中,特征点提取单元313基于从图像校正处理单元71提供的rgb图像、从语义分割处理单元72提供的语义分割(语义标签)的处理结果、叠加在rgb图像上的点云以及法线方向的估计结果,提取用作形成狄洛尼网格的三角形的顶点的特征点,并且将提取的特征点输出到狄洛尼网格创建单元77。

[0325]

通过上述一系列处理,可以有效地提取法线方向改变的位置处的特征点,即,距离或形状改变的位置处的特征点。这使得能够形成适当反映了障碍物的位置和形状的三维狄洛尼网格。因此,可以适当地规划包括移动体的移动路径的轨迹。

[0326]

《5.通过软件执行的示例》

[0327]

顺便提及,上述一系列处理可以通过硬件或软件执行。在通过软件执行一系列处理的情况下,从并入专用硬件中的计算机中的记录介质或者例如可以通过安装各种程序来执行各种功能的通用计算机等中的记录介质安装形成软件的程序。

[0328]

图27示出了通用计算机的配置示例。该个人计算机包括中央处理单元(central processing unit,cpu)1001。cpu 1001经由总线1004连接至输入/输出接口1005。总线1004连接至只读存储器(read only memory,rom)1002和随机存取存储器(random access memory,ram)1003。

[0329]

输入/输出接口1005连接至以下单元:输入单元1006,包括诸如键盘和鼠标的输入设备,用于用户输入操作命令;输出单元1007,向显示设备输出处理操作屏幕和处理结果的图像;存储单元1008,包括用于存储程序和各种数据的硬盘驱动器等;以及通信单元1009,包括局域网(local area network,lan)适配器等,并且经由由因特网表示的网络执行通信处理。此外,读取和写入数据的驱动器1010连接至诸如磁盘(包括软盘)、光盘(包括压缩盘-只读存储器(compact disc-read only memory,cd-rom)和数字多功能盘(digital versatile disc,dvd))、磁光盘(包括迷你盘(mini disc,md))或半导体存储器的可移除存储介质1011。

[0330]

cpu 1001根据存储在rom 1002中的程序或从安装在存储单元1008中的诸如磁盘、

光盘、磁光盘或半导体存储器的可移除存储介质1011读取的程序,执行各种处理,并且从存储单元1008加载到ram 1003中。ram 1003还适当地存储cpu 1001执行各种处理所需的数据等。

[0331]

在如上所述配置的计算机中,例如,通过cpu 1001经由输入/输出接口1005和总线1004将存储在存储单元1008中的程序加载到ram 1003中并且执行该程序,来执行上述一系列处理。

[0332]

由计算机(cpu 1001)执行的程序可以通过例如作为封装介质等记录在可移除存储介质1011上来提供。此外,可以经由诸如局域网、因特网或数字卫星广播的有线或无线传输介质来提供程序。

[0333]

在计算机中,通过将可移除存储介质1011安装到驱动器1010,可以经由输入/输出接口1005将程序安装在存储单元1008中。此外,程序可以经由有线或无线传输介质由通信单元1009接收,并且被安装在存储单元1008中。另外,程序也可以预先安装在rom 1002或存储单元1008中。

[0334]

注意,由计算机执行的程序可以是其中以本说明书中描述的顺序按时间序列执行处理的程序,或者可以是其中并行地或者在诸如进行调用时的必要时刻执行处理的程序。

[0335]

注意,图27的cpu 1001实现图7、图18和图24的控制单元31的功能。

[0336]

此外,在本说明书中,系统是指多个部件(装置、模块(部件)等)的集合,并且所有部件是否包括在同一壳体中并不重要。因此,包括在单独的壳体中并且经由网络连接的多个装置和在单个壳体中包括多个模块的单个装置都是系统。

[0337]

注意,本公开内容的实施方式不限于以上实施方式,并且可以在不脱离本公开内容的主旨的情况下进行各种修改。

[0338]

例如,本公开内容可以具有云计算的配置,其中单个功能由多个装置经由网络共享和联合处理。

[0339]

此外,以上流程图中描述的每个步骤可以由单个装置执行,或者可以由多个装置通过共享来执行。

[0340]

此外,在单个步骤包括多个处理的情况下,单个步骤中包括的多个处理可以由单个装置执行,或者可由多个装置以通过共享来执行。

[0341]

注意,本公开内容还可以具有以下配置。

[0342]

《1》一种信息处理装置,包括:

[0343]

物体识别单元,其识别移动体的周围的图像中的物体;

[0344]

特征点提取单元,其与所述物体识别单元的物体识别结果相关联地从所述图像中提取特征点;

[0345]

网格创建单元,其基于所述物体识别结果,通过按照相同的每个物体连接所述特征点来创建表示障碍物的网格;以及

[0346]

动作规划单元,其基于由所述网格创建单元创建的网格,规划所述移动体的动作以避开所述障碍物。

[0347]

《2》根据《1》所述的信息处理装置,其中,

[0348]

所述物体识别单元通过语义分割来识别所述图像中的物体,以及

[0349]

所述特征点提取单元与作为使用所述语义分割的所述物体识别结果的语义标签

相关联地从所述图像中提取所述特征点。

[0350]

《3》根据《2》所述的信息处理装置,其中,

[0351]

所述特征点提取单元基于所述语义标签,将可能是所述障碍物的物体的附近的特征点与所述语义标签相关联,并且从所述图像中提取所述特征点。

[0352]

《4》根据《2》所述的信息处理装置,其中,

[0353]

所述特征点提取单元将所述图像中的与深度图像中存在深度信息的位置对应的像素和所述语义标签相关联,并且提取所述像素作为所述特征点,其中,所述深度图像与所述图像对应。

[0354]

《5》根据《4》所述的信息处理装置,其中,

[0355]

所述特征点提取单元与作为使用所述语义分割的所述物体识别结果的语义标签相关联地从所述图像中提取所述特征点,并且还与所述语义标签相关联地从提取的特征点中选择性地提取满足以下条件中的至少一个的特征点:相邻特征点具有不同语义标签的条件;相邻特征点的深度信息与预定值显著不同的条件;以及在相邻特征点之间存在边缘的条件。

[0356]

《6》根据《4》所述的信息处理装置,其中,

[0357]

所述网格创建单元基于所述物体识别结果,通过按照具有相同语义标签的每个物体连接特征点来生成表示所述障碍物的二维网格。

[0358]

《7》根据《6》所述的信息处理装置,还包括

[0359]

三维化单元,其基于所述深度图像的深度信息对所述二维网格进行三维化,并且生成三维网格,其中,

[0360]

所述动作规划单元基于由所述三维化单元生成的所述三维网格,规划所述移动体的动作以避开所述障碍物。

[0361]

《8》根据《7》所述的信息处理装置,其中,

[0362]

所述动作规划单元对由所述三维网格表示的所述障碍物设置根据所述语义标签的距离的余量,并且规划所述移动体动作以避开所述障碍物的轨迹。

[0363]

《9》根据《8》所述的信息处理装置,其中,

[0364]

所述动作规划单元规划用于动作以避开所述障碍物的轨迹候选,计算用于评价各个轨迹候选的评价值,并且基于所述评价值从所述轨迹候选中选择所述轨迹。

[0365]

《10》根据《9》所述的信息处理装置,其中,

[0366]

所述动作规划单元通过使用评价函数来计算用于评价各个轨迹候选的评价值,并且基于所述评价值从所述轨迹候选中选择所述轨迹,所述评价函数包括用于计算从所述移动体到目的地的直线方向与所述移动体的移动方向之间的角度的方向评价值的项、用于计算所述移动体的移动速度的速度评价值的项以及用于计算所述移动体与所述障碍物之间的距离的距离评价值的项。

[0367]

《11》根据《10》所述的信息处理装置,其中,

[0368]

在所述评价函数中,对所述方向评价值、所述速度评价值、所述距离评价值中的每个设置权重,所述动作规划单元通过将所述方向评价值、所述速度评价值、所述距离评价值与所述方向评价值、所述速度评价值、所述距离评价值的权重的积相加来计算所述评价值,并且选择评价值最大的轨迹候选作为所述轨迹。

[0369]

《12》根据《10》所述的信息处理装置,其中,

[0370]

在用于计算所述距离评价值的项中设置根据所述语义标签的距离的权重。

[0371]

《13》根据《4》至《12》中任何一项所述的信息处理装置,其中,

[0372]

所述深度图像由lidar检测。

[0373]

《14》根据《4》至《12》中任何一项所述的信息处理装置,其中,

[0374]

所述深度图像是基于由立体摄像装置捕获的两个图像来生成的,以及

[0375]

所述图像由所述立体摄像装置中包括的摄像装置中的任何一个捕获。

[0376]

《15》根据《14》所述的信息处理装置,还包括

[0377]

视差估计单元,其基于由所述立体摄像装置捕获的两个图像来估计视差,并且基于估计的视差来生成所述深度图像。

[0378]

《16》根据《15》所述的信息处理装置,还包括

[0379]

过滤单元,其将深度差与预定阈值进行比较,以对具有大于所述预定阈值的深度差的深度信息进行过滤,所述深度差是基于由所述立体摄像装置捕获的两个图像生成的深度图像的时间序列深度图像之间的深度信息的差。

[0380]

《17》根据《14》所述的信息处理装置,其中,

[0381]

所述图像是由偏振摄像装置捕获的偏振图像,

[0382]

所述信息处理装置还包括法线估计单元,其基于所述偏振图像来估计所述偏振图像中的物体的表面的法线方向,以及

[0383]

所述特征点提取单元与所述物体识别单元的物体识别结果相关联地从所述图像中提取特征点,并且还与所述语义标签相关联地选择性地提取满足以下条件中的至少一个的特征点:相邻特征点具有不同的语义标签的条件;相邻特征点具有不同的深度信息的条件;在相邻特征点之间存在边缘的条件;以及相邻特征点处的法线方向改变的条件。

[0384]

《18》根据《1》至《17》中任何一项所述的信息处理装置,其中,

[0385]

所述网格创建单元基于所述物体识别结果,通过按照相同的每个物体连接所述特征点来形成以所述特征点作为顶点的三角形,来创建表示所述障碍物的狄洛尼网格。

[0386]

《19》一种信息处理方法,包括以下步骤:

[0387]

识别移动体的周围的图像中的物体;

[0388]

与所述物体的识别结果相关联地从所述图像中提取特征点;

[0389]

基于所述物体的识别结果,通过按照相同的每个物体连接所述特征点来创建表示障碍物的网格;以及

[0390]

基于创建的网格来规划所述移动体的动作以避开所述障碍物。

[0391]

《20》一种用于使计算机用作以下单元的程序:

[0392]

物体识别单元,其识别移动体的周围的图像中的物体;

[0393]

特征点提取单元,其与所述物体识别单元的物体识别结果相关联地从所述图像中提取特征点;

[0394]

网格创建单元,其基于所述物体识别结果,通过按照相同的每个物体连接所述特征点来创建表示障碍物的网格;以及

[0395]

动作规划单元,其基于由所述网格创建单元创建的网格,规划所述移动体的动作以避开所述障碍物。

[0396]

附图标记列表

[0397]

11 移动体

[0398]

31 控制单元

[0399]

32 摄像装置

[0400]

33 深度传感器

[0401]

34 存储单元

[0402]

35 驱动单元

[0403]

51 轨迹规划单元

[0404]

52 操作控制单元

[0405]

71 图像校正处理单元

[0406]

72 语义分割处理单元

[0407]

73 存储单元

[0408]

74 位置校正处理单元

[0409]

75 存储单元

[0410]

76 特征点提取单元

[0411]

77 狄洛尼网格创建单元

[0412]

78 网格三维化单元

[0413]

79 动作规划单元

[0414]

80 存储单元

[0415]

201 立体摄像装置

[0416]

211-1、211-2 摄像装置

[0417]

231-1、231-2 图像校正处理单元

[0418]

232-1、232-2 存储单元

[0419]

233 视差估计单元

[0420]

234 深度可靠性过滤单元

[0421]

235 自身位置变化检测单元

[0422]

251 缓冲器

[0423]

252 投影单元

[0424]

253 深度差计算单元

[0425]

254 阈值比较单元

[0426]

301 偏振摄像装置

[0427]

311 图像校正处理单元

[0428]

312 法线估计单元

[0429]

313 特征点提取单元

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。