1.本发明涉及计算机视觉领域,特别地涉及一种基于多粒度特征的多标签场景图生成方法。

背景技术:

2.场景图生成作为一种从图像中提取结构性自然语言信息的技术,常作为一些高层视觉任务的辅助信息,如视觉问答、图像字幕等。场景图生成的目标是给定一张图像,预测图像中每个物体的分类标签和每对物体之间的关系。场景图生成的关键因素主要包括物体对之间的关系数量不确定、数据集对关系的标注不完整等。传统方法一般将场景图生成任务看成一个对关系的单标签问题,尽管一些方法在召回率上取得了一些突破,但是其没有充分考虑物体之间关系的多样性。

3.现有的主流场景图生成方法为两阶段的学习框架,输入一张原始三通道颜色图像,先使用目标检测器检测出图像中的所有物体,再使用关系检测器检测出物体之间的关系,最后将物体的检测结果和关系的检测结果合并生成场景图。这些方法可以生成场景图,但是对场景图中物体之间的多关系现象没有足够的考虑,限制了现行方法的效果。

技术实现要素:

4.针对以上问题,本发明提供了一种基于多粒度特征的多标签场景图生成方法。本发明具体采用的技术方案如下:

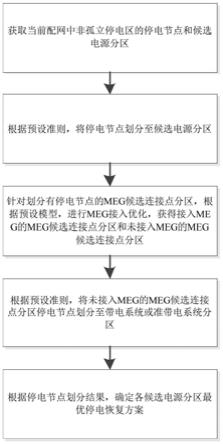

5.一种基于多粒度特征的多标签场景图生成方法,其包括以下步骤:

6.s1、获取用于训练场景图生成的带有数据集标签的训练数据集;

7.s2、对训练数据集中所有图像中的所有关系类别进行粗细粒度分类和统计,得到每个关系类别的所有共生关系并构建每个关系类别的共生标签,得到物体对的最大可能关系数;

8.s3、使用预训练的目标检测器,检测出训练数据集的图像中所有物体,并得到初始的物体类别预测;

9.s4、使用多粒度模块建立每张训练图像的多粒度特征,并对图像中的每个物体对构建多分类标签;

10.s5、利用多粒度特征作为输入,数据集标签、多分类标签、共生标签作为监督,训练关系检测器,使关系检测器能够输出图像中物体之间的关系预测,并对所述目标检测器输出的物体类别预测进行微调形成最终的物体类别预测结果;

11.s6、针对待生成多标签场景图的目标图像,利用所述预训练的目标检测器检测出目标图像中的所有物体并得到初始的物体类别预测,然后利用所述关系检测器输出目标图像中物体之间的关系预测结果,并对所述目标检测器针对目标图像输出的物体类别预测进行微调形成最终的物体类别预测结果,最后使用多标签场景图生成器将目标图像中的关系预测结果和物体类别预测结果转化为目标图像对应的多标签场景图。

12.作为优选,所述s1中的训练数据集包括若干训练图像i

train

,每一张训练图像i

train

均具有每一个物体的物体类别标签o

gt

和物体位置b

gt

以及物体对的关系类别标签p

gt

,整个训练数据集中含有的总关系类别数为q。

13.进一步的,所述s2包括以下子步骤:

14.s21、对于训练数据集中的所有关系类别,分别统计训练数据集中属于每一种关系类别的物体对占比,将占比最大且占比总和超过阈值的若干种关系类别作为粗粒度关系,剩余关系类别作为细粒度关系;然后遍历整个训练数据集中的所有物体对中的每一个关系类别,所有和当前遍历关系类别同时被标注在同一物体对中且粒度粗细类型与当前遍历关系类别相反的关系类别,都作为当前遍历关系类别的共生关系类别;

15.s22、分别针对每一种关系类别q构建q维向量形式的共生标签p

co

,共生标签p

co

中每一维元素分别对应一种关系类别,其中关系类别q对应的元素值为po,而关系类别q的所有共生关系类别的元素值均分剩余的(1-po),其他剩余的关系类别的元素值均为0;

16.s23、对于训练数据集中的所有物体对,查找到物体对上被标注的关系类别标签数量的最大值p

max

。

17.进一步的,所述s3包括以下子步骤:

18.s31、获取一个预训练的目标检测器objdet,所述目标检测器objdet包括图像特征提取网络和区域候选网络;

19.s32、对于训练数据集中每张训练图像i

train

,通过图像特征提取网络得到相应的图像特征图并通过区域候选网络得到目标检测结果

[0020][0021]

其中:包含物体位置预测和初始物体类别预测

[0022]

进一步的,所述s4包括以下子步骤:

[0023]

s41、对于目标检测器对单张训练图像给出的特征使用m个随机擦除率各自生成不同粒度下的特征,共得到m个多粒度特征同时将特征作为图像的整体特征

[0024]

s42、对于训练数据集中的每张训练图像i

train

中的每个物体对(ni,nj),分别构建该物体对的多分类标签p

multi

,所述多分类标签p

multi

为q维向量,其中每一维元素分别对应一种关系类别,标注在该物体对上的所有关系类别对应的元素值平分总和为1的概率,而其他关系类别的元素值均为0。

[0025]

进一步的,所述s5包括以下子步骤:

[0026]

s51、构建关系检测器reldet,其中每张训练图像i

train

的中的每一个使用关系检测器reldet得到所有物体对的关系预测并对中的物体类别预测进行微调得到

[0027][0028]

其中:中物体对(ni,nj)关于关系类别k的关系预测为

[0029]

再将每个物体对(ni,nj)关于每一种关系类别k的全部m 1个关系预测输出进行融合,得到关系检测概率结果为:

[0030][0031]

式中λ为权重值;

[0032]

将每张训练图像i

train

中的所有合并,得到并输出最终的关系预测同时,关系检测器reldet经过微调后,输出最终的物体类别预测

[0033]

s52、设置关系检测器reldet的损失函数为:

[0034][0035]

其中是交叉熵损失函数,是带有温度参数t的kl损失函数,p

co

为训练图像中共生标签p

co

的集合,p

multi

为训练图像中多分类标签p

multi

的集合;

[0036]

s53、使用sgd优化方法和反向传播算法通过损失函数来训练关系检测器reldet,直至损失函数收敛。

[0037]

进一步的,所述s6包括以下子步骤:

[0038]

s61、对于任意一张目标图像i

*

,先使用预训练的目标检测器objdet提取目标图像中的图像特征图和目标检测结果和目标检测结果包含物体位置预测和初始物体类别预测再针对目标图像使用关系检测器reldet得到物体之间的关系预测并微调得到最终的物体类别预测

[0039]

s62、基于多标签场景图生成器multigraphgen,对于目标图像中的每个物体对(ni,nj)取其的关系预测中置信度最大的前p

max

个关系预测作为结果,使用这p

max

个关系预测结果,结合经过微调的物体类别预测目标检测器输出的物体位置预测生成该目标图像对应的场景图g:

[0040][0041]

进一步的,所述s22中,po=0.5。

[0042]

进一步的,所述s41中,m=3,r1=0,r1=0.1,r2=0.2,r3=0.3。

[0043]

进一步的,所述s5中,λ=0.4,α=0.5,β=0.05。

[0044]

本方法基于深度神经网络,利用不同关系类之间的相互联系和每个物体的多粒度特征,对图像中的关系进行建模,能够更好地适应不同场景下的场景图生成。相比于传统场景图生成方法,本发明具有如下有益效果:

[0045]

首先,本发明的场景图生成方法指出了在场景图生成物体对之间有多个关系的问题,即每个物体对之间预测的关系不止一个。

[0046]

其次,本发明的场景图生成方法基于深度卷积神经网络,同时对物体特征和其多粒度特征进行建模,能够更好地表达视觉特征,提高了方法的最终效果。

[0047]

最后,本发明的场景图生成方法和多数二阶段的场景图生成模型中的关系检测器都兼容,可以一起使用,是一种便于推广的插件式方法。

附图说明

[0048]

图1为本发明的多标签场景图生成方法流程示意图;

[0049]

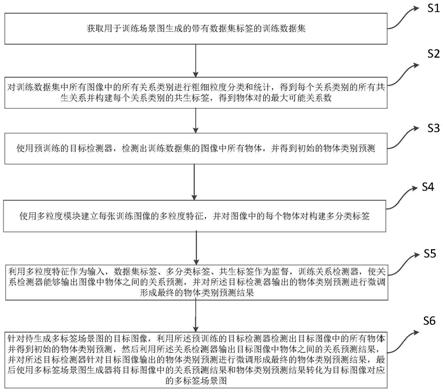

图2为模型结构示意图。

具体实施方式

[0050]

为了使本发明的目的、技术方案及优点更加清楚明白,以下结合附图及实施例,对本发明进行进一步详细说明。应当理解,此处所描述的具体实施例仅仅用以解释本发明,并不用于限定本发明。

[0051]

相反,本发明涵盖任何由权利要求定义的在本发明的精髓和范围上做的替代、修改、等效方法以及方案。进一步,为了使公众对本发明有更好的了解,在下文对本发明的细节描述中,详尽描述了一些特定的细节部分。对本领域技术人员来说没有这些细节部分的描述也可以完全理解本发明。

[0052]

参考图1,为本发明中一种基于多粒度特征的多标签场景图生成方法的流程图,其中的模型结构示意图如图2所示。下面对该方法的具体实现步骤进行详细展开描述,该方法具体包括以下步骤:

[0053]

s1、获取用于训练场景图生成的带有数据集标签的训练数据集。

[0054]

在本实施例中,上述步骤s1中的训练数据集包括若干训练图像i

train

,每一张训练图像i

train

均具有每一个物体的物体类别标签o

gt

和物体位置b

gt

以及物体对的关系类别标签p

gt

,整个训练数据集中含有的总关系类别数为q。

[0055]

当然,为了测试本发明的具体技术效果,除了上述训练数据集之外,还可以对应设置相应的测试数据集。本发明中,最终的算法目标为生成单张测试图像i

test

或者其他目标图像对应的场景图g。

[0056]

s2、对训练数据集中所有图像中的所有关系类别进行粗细粒度分类和统计,得到每个关系类别的所有共生关系并构建每个关系类别的共生标签,得到物体对的最大可能关系数。

[0057]

在本实施例中,上述步骤s2包括以下子步骤:

[0058]

s21、对于训练数据集中的所有关系类别,分别统计训练数据集中属于每一种关系类别的物体对占比,将占比最大且占比总和超过阈值的若干种关系类别作为粗粒度关系,剩余关系类别作为细粒度关系。也就是说,需要统计整个训练数据集中所有物体对上标注的关系类别,对于任意一个关系类别均需要统计标注了这个关系类别的物体对数量占训练数据集中所有物体对的占比比例,按照这个占比比例对所有关系类别进行排序,如果排序靠前的前n个关系类别的占比比例之和超过阈值而前n-1个关系类别的占比比例之和低于阈值,则将这前n个关系类别都作为粗粒度关系,剩余的关系类别都作为细粒度关系;然后遍历整个训练数据集中的所有物体对中的每一个关系类别,将遍历过程中的每一个关系类

别依次作为当前遍历类别,所有和当前遍历关系类别同时被标注在同一物体对中且粒度粗细类型与当前遍历关系类别相反的关系类别,都作为当前遍历关系类别的共生关系类别。而且该共生关系是相互的,即一种关系类别为另一种关系类别的共生关系,则另一种关系类别也是这一种关系类别的共生关系。

[0059]

s22、分别针对每一种关系类别q构建q维向量形式的共生标签p

co

,共生标签p

co

中每一维元素分别对应一种关系类别,其中关系类别q对应的元素值为po,而关系类别q的所有共生关系类别的元素值均分剩余的(1-po),其他剩余的关系类别的元素值均为0。一般而言,可以设置po=0.5。

[0060]

s23、对于训练数据集中的所有物体对,查找到物体对上被标注的关系类别标签数量的最大值p

max

,该最大值p

max

后续将用于多标签场景图生成器中。

[0061]

s3、使用预训练的目标检测器,检测出训练数据集的图像中所有物体,并得到初始的物体类别预测。

[0062]

在本实施例中,上述步骤s3包括以下子步骤:

[0063]

s31、获取一个预训练的目标检测器objdet,所述目标检测器objdet包括图像特征提取网络和区域候选网络。目标检测器objdet的具体网络结构形式不限,只要预先经过训练后,能够实现对于目标(即图像中的物体)的准确检测即可。

[0064]

s32、对于训练数据集中每张训练图像i

train

,通过图像特征提取网络得到相应的图像特征图并通过区域候选网络得到目标检测结果

[0065][0066]

其中:包含物体位置预测和初始物体类别预测

[0067]

s4、使用多粒度模块建立每张训练图像的多粒度特征,并对图像中的每个物体对构建多分类标签。

[0068]

在本实施例中,上述步骤s4包括以下子步骤:

[0069]

s41、对于目标检测器对单张训练图像给出的特征使用m个随机擦除率各自生成不同粒度下的特征,共得到m个多粒度特征同时将特征作为图像的整体特征一般而言,可以设置m=3,r1=0,r1=0.1,r2=0.2,r3=0.3。

[0070]

s42、对于训练数据集中的每张训练图像i

train

中的每个物体对(ni,nj),分别构建该物体对的多分类标签p

multi

,所述多分类标签p

multi

为q维向量,其中每一维元素分别对应一种关系类别,标注在该物体对上的所有关系类别对应的元素值平分总和为1的概率,而其他关系类别的元素值均为0。例如,某一个物体对中一共被人工标注了4关系类别,那么在其多分类标签中这4个关系类别的标签(即元素)值都是0.25,其他(q-4)种关系类别的标签值都为0。

[0071]

s5、利用多粒度特征作为输入,数据集标签、多分类标签、共生标签作为监督,训练关系检测器,使关系检测器能够输出图像中物体之间的关系预测,并对所述目标检测器输出的物体类别预测进行微调形成最终的物体类别预测结果。

[0072]

在本实施例中,上述步骤s5包括以下子步骤:

[0073]

s51、构建关系检测器reldet,其中每张训练图像i

train

的中的每一个

使用关系检测器reldet得到所有物体对的关系预测并对中的物体类别预测进行微调得到

[0074][0075]

其中:中物体对(ni,nj)关于关系类别k的关系预测为)关于关系类别k的关系预测为由一系列的组成;

[0076]

再将每个物体对(ni,nj)关于每一种关系类别k的全部m 1个关系预测输出进行融合,得到关系检测概率结果为:

[0077][0078]

式中λ为权重值,一般而言,可以设置λ=0.4;

[0079]

将每张训练图像i

train

中的所有合并,得到并输出最终的关系预测同时,关系检测器reldet经过微调后,输出最终的物体类别预测

[0080]

s52、设置关系检测器reldet的损失函数为:

[0081][0082]

其中是交叉熵损失函数,是带有温度参数t的kl损失函数,p

co

为训练图像中共生标签p

co

的集合,p

multi

为训练图像中多分类标签p

multi

的集合。一般而言,可以设置α=0.5,β=0.05;

[0083]

s53、使用sgd优化方法和反向传播算法通过损失函数来训练关系检测器reldet,直至损失函数收敛。

[0084]

s6、针对待生成多标签场景图的目标图像,利用所述预训练的目标检测器检测出目标图像中的所有物体并得到初始的物体类别预测,然后利用所述关系检测器输出目标图像中物体之间的关系预测结果,并对所述目标检测器针对目标图像输出的物体类别预测进行微调形成最终的物体类别预测结果,最后使用多标签场景图生成器将目标图像中的关系预测结果和物体类别预测结果转化为目标图像对应的多标签场景图。

[0085]

在本实施例中,上述步骤s6包括以下子步骤:

[0086]

s61、对于任意一张目标图像i

*

,先使用预训练的目标检测器objdet提取目标图像中的图像特征图和目标检测结果和目标检测结果包含物体位置预测和初始物体类别预测再针对目标图像使用关系检测器reldet得到物体之间的关系预测并微调得到最终的物体类别预测

[0087]

需要注意的是,此处预训练的目标检测器objdet、关系检测器reldet中的具体输入、输出和内部处理方式与前述s3~s5步骤基本一致,区别仅在于将训练图像替换为目标图像,为了以示区分在训练图像对应的各输出上加上标*进行区分,记为目标图像对应的输出。

[0088]

s62、基于多标签场景图生成器multigraphgen,对于目标图像中的每个物体对(ni,nj)取其的关系预测中置信度最大的前p

max

个关系预测作为结果,使用这p

max

个关系预测结果,结合经过微调的物体类别预测目标检测器输出的物体位置预测生成该目标图像对应的场景图g,其用公式表示如下:

[0089][0090]

下面将上述s1~s6所示的一种基于多粒度特征的多标签场景图生成方法,应用于一个具体实例中,以展示其具体技术效果。

[0091]

实施例

[0092]

本实施例的实现方法如前s1~s6所述,不再详细阐述具体的步骤,下面仅针对案例数据展示其效果。本发明在一个具有真值标注的数据集上实施,分别为:

[0093]

vg数据集:该数据集包含10807张图像,有150类物体标签和50类关系标签,平均每张图38类物体标签和22类关系标签。

[0094]

本实例在vg数据集的训练集上训练,测试集上测试,具体流程如图1所示。图中,mgm是生成多粒度特征的模块,objdet是目标检测器,reldet是关系检测器,p

co

是共生标签,p

multi

是多分类标签。

[0095]

本实施例在predcls任务(输入图片和图片中物体的位置和分类,输出完整场景图)检测结果的检测精度如下表所示,主要采用平均召回率(r@k)、分类平均召回率(mr@k)以及无训练样本平均召回率(zr@k)三个指标进行比较。其中平均召回率(r@k)指标是指每张测试图像在给出k个候选(物体1,关系,物体2)组的情况下,涵盖了多少比例的人工标注(物体1,关系,物体2)组。分类平均召回率(mr@k)指标是指每张测试图像在给出k个候选(物体1,关系,物体2)组的情况下,先计算每个关系的平均召回率,然后所有关系的平均召回率再做一个算术平均。无训练样本平均召回率(zr@k)指标是指每张测试图像在给出k个候选(物体1,关系,物体2)组的情况下,仅对测试集中没有在训练集出现过的(物体1,关系,物体2)组进行评估,看有多少比例的人工标注、没有在训练集出现过的(物体1,关系,物体2)组被召回。

[0096]

方法r@20r@50r@100motifs58.4665.1867.01motifs oursmulti67.19( 8.73)81.47( 16.29)88.56( 21.55)imp54.3461.0563.06imp oursmulti62.62( 8.28)77.60( 16.55)85.13( 22.07)transformer59.0665.5567.29transformer oursmulti67.65( 8.59)82.12( 16.57)89.05( 21.76)

[0097]

方法mr@20mr@50mr@100motifs11.6714.7916.08

motifs oursmulti21.22( 9.55)34.31( 19.52)44.47( 28.39)imp8.8510.9711.77imp oursmulti16.87( 8.02)28.42( 17.45)38.10( 26.33)transformer12.7716.3017.63transformer oursmulti23.27( 10.50)38.22( 21.92)49.56( 31.93)

[0098]

方法zr@20zr@50zr@100motifs1.083.245.36motifs oursmulti4.01( 2.93)13.12( 9.88)25.74( 20.38)imp12.1717.6620.25imp oursmulti15.39( 3.22)28.54( 10.88)40.12( 19.87)transformer1.353.635.64transformer oursmulti6.09( 4.74)16.83( 13.20)30.28( 24.64)

[0099]

如上三张表,我们分别测试了和三种不同关系检测器motifs、imp和transformer的结合,带有 oursmulti的结果是一种基于多粒度特征的多标签场景图生成方法的最终结果,可以看到,在所有指标和所有关系检测器上一种基于多粒度特征的多标签场景图生成方法都具有显著提升。

[0100]

上述实施例中,本发明的基于多粒度特征的多标签场景图生成方法首先对所有关系类别之间的联系进行建模。在此基础上,将原属于单标签分类的关系预测问题转化为多标签分类问题,并和多种基于深度神经网络建立的关系预测模型可以联合使用。最后,利用训练好的场景图生成模型来生成测试图像对应的场景图。

[0101]

通过以上技术方案,本发明实施例基于深度学习技术发展了一种基于多粒度特征的多标签场景图生成方法。本发明充分利用关系类别之间的联系,并采用多粒度视觉特征对物体进行建模,能够更好地适应真实的场景图生成任务。

[0102]

以上所述仅为本发明的较佳实施例而已,并不用以限制本发明,凡在本发明的精神和原则之内所作的任何修改、等同替换和改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。