1.本发明属于智能交互技术领域,更具体地,涉及一种手势操控方法和系统。

背景技术:

2.传统的视频指挥调度系统的交互方式多为传统的有线鼠标、键盘等触摸式人机交互方式。这种经典的交互方式具有一定的局限性,固定操作人员在一定范围内操作,灵活性不强。

3.目前,流行的交互方式多为手势操控及语音操控。手势是人类本能的身体语言,具有简单性、易学性和语义丰富性等优点,因此以手势交互的人机交互方式越来越受欢迎。手势交互可以分为裸手手势交互和可穿戴式、体感手势交互。其中,可穿戴式、体感手势交互是指需要介质的手势交互,这种手势交互方式依赖外部设备,如数据手套数据腕带等,具有一定的局限性。裸手手势交互不需要依赖可穿戴式、体感手势设备,操作起来更加方便灵活。

4.深度学习网络是机器学习领域中一个新的研究方向,它被引入机器学习使其更接近于最初的目标

‑‑

人工智能,深度学习是学习样本数据的内在规律和表示层次,这些学习过程中获得的信息对诸如文字,图像和声音等数据的解释有很大的帮助。它的最终目标是让机器能够像人一样具有分析学习能力,能够识别文字、图像和声音等数据。2d u-net全卷积神经网络和3d u-net全卷积神经网络都属于深度学习网络。2d u-net全卷积神经网络是一种端到端、像素到像素的对象识别与定位网络,它可以对每个像素都产生一个预测,最后输出一张已标记好的图片,效率高且结果比较直观。3du-net全卷积神经网络考虑到时间维度的帧间运动信息,能更好的捕获视频中的时间和空间的特征信息。

5.综上,现有技术虽然能实现通过手势进行人机交互,但仍有不足。因此,提供一种不需要依赖任何可穿戴式、体感设备,也不需要专用的高性能计算处理设备,只需要通过普通摄像头采集手势动作即可完成控制操作的手势操控方法和系统,成为了智能交互技术领域的当务之急。

技术实现要素:

6.针对现有技术的缺陷,本发明提供了一种手势操控方法和系统,旨在解决现有技术依赖可穿戴式设备或体感设备,需要高性能计算处理设备导致成本高昂,无法大面积推广的问题。

7.为实现上述目的,本发明提供了一种手势操控方法,包括如下步骤:

8.(1)手势识别步骤:手势采集模块采集含有手势动作的图像帧序列,将图像帧序列中各图像帧分别输入到手势跟踪模型和训练好的手势检测模型,手势跟踪模型对各图像帧进行处理,得到各图像帧中手势区域的位置信息,将其输入到训练好的手势检测模型,得到各图像帧的手势类别和手势检测框中心点的坐标值;

9.(2)指令执行步骤:将各图像帧中手势检测框中心点的坐标值转换到终端节点和

终端节点投影后的显示模块的相应位置,将各图像帧的手势类别和自定义的手势语义集进行匹配,得到手势类别对应的语义,将所述语义转化为指令,根据指令对终端节点和终端节点投影后的显示模块的相应位置进行操作;

10.(3)指令执行结果查看步骤:查看终端节点和显示模块的相应位置操作结果并将其反馈给用户进行参考。

11.在一个可选的实施例中,所述训练好的手势检测模型,具体为:

12.手势采集模块在近肤色背景和不同光照条件下采集不同手势动作的图像帧,所有手势动作的图像帧组成手势样本库,将手势样本库中各图像帧进行标注;

13.对手势样本库中各图像帧进行预处理操作,包括:颜色转换和尺寸缩放;

14.利用深度学习网络对预处理后的各图像帧进行训练,得到训练好的手势检测模型。

15.在一个可选的实施例中,所述将手势样本库中各图像帧进行标注,具体为:

16.将手势样本库中的各图像帧标注为四种手势类别中的一种,所述四种手势类别包括:单手掌、拳头、单手指和双手掌。

17.在一个可选的实施例中,所述利用深度学习网络对预处理后的各图像帧进行训练,得到训练好的手势检测模型,具体为:

18.利用2d u-net全卷积神经网络对预处理后的各图像帧进行初步检测,快速识别和定位各图像帧的手势区域;

19.将同一手势类别的图像帧输入到3d u-net全卷积神经网络中,利用3du-net全卷积神经网络对各图像帧中的手势区域进行识别,得到训练好的手势检测模型。

20.在一个可选的实施例中,所述手势识别步骤,包括如下子步骤:

21.(1.1)采集含有手势动作的图像帧序列,对图像帧序列间隔若干帧采样一次,得到采样后的图像帧数据集;

22.(1.2)对采样后的图像帧数据集中各图像帧进行预处理操作,得到预处理后的图像帧数据集,所述预处理操作包括:颜色转换和尺寸缩放;

23.(1.3)将预处理后的图像帧数据集中若干连续图像帧分别输入到手势跟踪模型;

24.(1.4)手势跟踪模型对所述若干连续图像帧进行处理,得到各图像帧中手势区域的位置信息;

25.(1.5)将得到的各图像帧中手势区域的位置信息输入到训练好的手势检测模型,得到各图像帧的手势类别以及手势检测框中心点的坐标值,计算所述若干连续图像帧的手势类别属于同一手势类别的概率,若其大于等于设定的阈值,则可以确定所述若干连续图像帧的手势类别。

26.在一个可选的实施例中,所述指令执行步骤中将各图像帧中手势检测框中心点的坐标值转换到终端节点和终端节点投影后的显示模块的相应位置,具体为:

27.采用坐标放大方法将各图像帧中手势检测框中心点的坐标值转换到终端节点屏幕上相应的位置。

28.在一个可选的实施例中,所述指令执行步骤中自定义的手势语义集,具体为:

29.若输入的手势类别为单手掌,代表移动输出画面;

30.若输入的手势类别为拳头,代表旋转输出画面;

31.若输入的手势类别为单手指,代表在画面之间进行切换;

32.若输入的手势类别为双手掌,代表等比例缩放输出画面。

33.在一个可选的实施例中,所述若输入的手势类别为单手指,代表在画面之间进行切换,具体为:

34.若终端节点的屏幕上同时存在若干个画面,即出现图层的情况时,对各个画面进行切换,对切换后的画面执行后续指令。

35.在一个可选的实施例中,所述指令执行步骤中终端节点投影后的显示模块,具体为:

36.所述终端节点投影后的显示模块为几块小显示屏拼接而成的大显示屏。

37.本发明的另一目的在于提供一种手势操控系统,包含如下单元:

38.(1)手势识别单元:手势采集模块采集含有手势动作的图像帧序列,将图像帧序列中各图像帧分别输入到手势跟踪模型和训练好的手势检测模型,手势跟踪模型对各图像帧进行处理,得到各图像帧中手势区域的位置信息,将其输入到训练好的手势检测模型,得到各图像帧的手势类别和手势检测框中心点的坐标值;

39.(2)指令执行单元:将各图像帧中手势检测框中心点的坐标值转换到终端节点和终端节点投影后的显示模块的相应位置,将各图像帧的手势类别和自定义的手势语义集进行匹配,得到手势类别对应的语义,将所述语义转化为指令,根据指令对终端节点和终端节点投影后的显示模块的相应位置进行操作;

40.(3)指令执行结果查看单元:查看终端节点和显示模块的相应位置操作结果并将其反馈给用户进行参考。

41.通过本发明构思的以上技术方案与现有技术相比,具有以下有益效果:

42.本发明提供一种手势操控方法和系统,采集含有手势动作的图像帧序列,将图像帧序列中各图像帧分别输入到手势跟踪模型和训练好的手势检测模型,在实际操作中,手势动作会不断移动,采集的图像帧中手势区域的位置也不是固定的,手势跟踪模型可以捕捉连续的图像帧中手势区域的位置信息,将得到各图像帧中手势区域的位置信息输入到训练好的手势检测模型,利用深度学习网络对图像帧进行处理,得到各图像帧的手势类别和手势检测框中心点的坐标值;

43.另一方面,本发明提供了一种自定义的手势语义集,将得到的手势类别和自定义的手势语义集进行匹配,得到手势类别对应的语义,并将所述语义转化为指令,根据指令对终端节点和终端节点投影后的显示模块的相应位置进行操作。

44.本发明提供的手势操控方法和系统不需要依赖任何穿戴式、体感设备,提供用户使用的便利性,同时,手势采集模块支持对图像帧序列的直接处理,不需要将图像帧上传到后台高性能计算处理设备进行计算和分析,减少了图像帧序列处理的时延,提高了手势识别效率的同时降低了采购成本。

附图说明

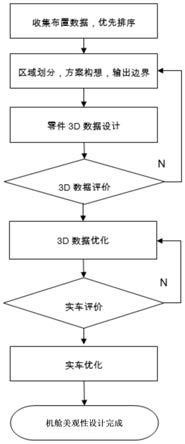

45.图1为本发明实施例的流程图;

46.图2为本发明实施例的手势样本库训练单元框图;

47.图3为本发明实施例的手势识别单元框图。

具体实施方式

48.为了使本发明的目的、技术方案及优点更加清楚明白,以下结合附图及实施例,对本发明进行进一步详细说明。应当理解,此处所描述的具体实施例仅仅用以解释本发明,并不用于限定本发明。

49.本发明的手势操控方法,包括如下步骤:

50.(1)手势识别步骤:手势采集模块采集含有手势动作的图像帧序列,将图像帧序列中各图像帧分别输入到手势跟踪模型和训练好的手势检测模型,手势跟踪模型对各图像帧进行处理,得到各图像帧中手势区域的位置信息,将其输入到训练好的手势检测模型,得到各图像帧的手势类别和手势检测框中心点的坐标值;

51.(2)指令执行步骤:将各图像帧中手势检测框中心点的坐标值转换到终端节点和终端节点投影后的显示模块的相应位置,将各图像帧的手势类别和自定义的手势语义集进行匹配,得到手势类别对应的语义,将所述语义转化为指令,根据指令对终端节点和终端节点投影后的显示模块的相应位置进行操作;

52.(3)指令执行结果查看步骤:查看终端节点和显示模块的相应位置操作结果并将其反馈给用户进行参考。

53.具体地,本发明提供的手势操控方法,以下是详细的技术方案,如图1是本发明实施例的流程图,包括如下步骤:

54.(1)手势识别步骤。

55.(1.1)获取手势样本库子步骤。

56.使用网络摄像头在近肤色背景和不同光照条件下采集含有不同手势动作的图像帧,作为手势样本库。将手势样本库中的图像帧标注为四种手势类别中的一种,所述四种手势类别包括:单手掌、拳头、单手指和双手掌。

57.(1.2)获取训练好的手势检测模型子步骤。

58.将手势样本库中四种手势类别的图像帧各取30帧进行预处理操作,包括:颜色转换和尺寸缩放;

59.将经过预处理操作的同一手势类别的30帧图像帧输入深度学习网络中进行处理,所述深度学习学习卷积神经网络包括:2d u-net全卷积神经网络和3du-net全卷积神经网络。

60.2d u-net全卷积神经网络对输入的图像帧进行初步检测,将各图像帧中出现手势的目标区域标记出来,得到预测图像,对预测图像采用二值化、去噪声处理,使用形态学方法得到各图像帧中手势检测框中心点的坐标值,通过所有图像帧中手势检测框中心点的坐标值的欧氏距离将所有图像帧中出现手势的目标区域合并,得到合并后的图像帧,计算合并后的图像帧中目标区域中所有手势检测框中心点的坐标值的平均值,作为手势检测框中心点的新坐标值。

61.将合并后的图像帧输入到3d u-net全卷积神经网络,对出现手势的目标区域进行分类,确定手势类别。

62.通过2d u-net全卷积神经网络和3d u-net全卷积神经网络,得到训练好的手势检测模型。

63.(1.3)获取图像帧数据集子步骤。

64.使用网络摄像头采集含有手势动作的图像帧序列,对图像帧序列间隔30帧采样一次,得到采样后的图像帧数据集;

65.(1.4)获取手势类别和手势检测框中心的的坐标值子步骤。

66.对采样后的图像帧数据集中各图像帧进行预处理操作,得到预处理后的图像帧数据集,所述预处理操作包括:颜色转换和尺寸缩放;

67.将预处理后的图像帧数据集中连续50帧的图像帧分别输入到手势跟踪模型和训练好的手势检测模型;

68.手势跟踪模型对所述连续50帧图像帧进行处理,得到各图像帧中手势区域的位置;

69.依次将所述连续50帧图像帧中手势区域的位置输入到训练好的手势检测模型,得到各图像帧中手势类别以及手势检测框中心点的坐标值,计算所述连续50帧图像帧中手势类别属于同一手势类别的概率,若其大于等于设定的阈值,则可以确定所述连续50帧图像帧中手势类别。

70.本实施例中,采用网络摄像头采集含有手势动作的图像帧序列,所述网络摄像头携带hi3531dv200海思嵌入式图像处理芯片(下文简称hi3531dv200芯片),所述hi3531dv200芯片可以实现对图像帧序列的直接处理,减少了图像帧上传到高性能计算处理设备的时间,同时减少了对计算资源的消耗,提高了手势识别效率。hi3531dv200芯片内置的nnie引擎支持深度学习网络所需加速处理的硬件单元,且支持现有大部分图像识别、图像分割和图像定位算法。实时采集的图像帧序列通过网络摄像头的以太网接口实现远程数据交互。这种边缘计算设备能够节省通信带宽,降低网络延迟、减少数据通信量,以及更少依赖存储和算力资源,可以提高系统的可靠性和控制力。

71.(2)指令执行操作步骤。

72.(2.1)手势检测框中心点坐标值转换到终端节点鼠标坐标系和显示模块坐标系的坐标值子步骤。

73.在实际操作中,终端节点屏幕上可能存在若干画面,需要选择所述若干画面中任一一副进行操作,此时,需要在终端节点屏幕上显示手势位置来方便用户进行操作,由于终端节点通常为便携式电脑或平板电脑,屏幕较小,不方便用户进行观察和操作,本实施例将终端节点上的画面投影到显示模块上,方便用户更加直观的进行观察和操作。为了实现上述目的,本发明实施例将得到各图像帧中手势检测框中心点的坐标值转换到终端节点鼠标坐标系和显示模块坐标系的坐标值。

74.其中,所述显示模块为几块小显示屏拼接而成的大显示屏。

75.手在移动的过程中会产生抖动现象,若直接进行坐标系转换,转换后的坐标会不停地抖动。本实施例采用放大跟踪显示框坐标系的方法来消除抖动,具体方式如下所述:

76.a(x

center

,y

center

)分别代表手势检测框中心点在跟踪显示框坐标系的坐标值,所述跟踪显示框为网络摄像头采集的图像帧在终端节点屏幕上形成的矩形框,其中,x

center

和y

center

分别代表手势检测框中心点在跟踪显示框坐标系x轴和y轴上的坐标值。

77.a(x

mouse

,y

mouse

),a(x

monitor

,y

monitor

)分别代表手势检测框中心点坐标值转换到终端节点鼠标坐标系和显示模块坐标系的坐标值。其中,x

mouse

和y

mouse

分别代表终端节点鼠标坐标系中x轴和y轴的坐标值;x

monitor

和y

monitor

分别代表显示模块坐标系中x轴和y轴的坐标值。

78.手势检测框中心点的坐标值转换到终端节点鼠标坐标系的坐标值公式如下:

[0079][0080]

其中,max_x和max_y分别代表跟踪显示框坐标系x轴和y轴可移动的最大距离,width和height分别代表终端节点鼠标坐标系的长和宽。

[0081]

终端节点鼠标坐标系与显示模块坐标系转换公式如下:

[0082][0083]

在显示模块坐标系中,限制坐标系x轴和y轴的坐标值范围为0~65535。

[0084]

(2.2)手势类别和自定义的手势语义集匹配子步骤。

[0085]

具体地,本发明方法给出了一种自定义的手势语义集,如表1所示:

[0086]

表1:自定义的手势语义集

[0087]

手势类别语义单手掌移动输出画面拳头旋转输出画面单手指在输出的多个画面间切换双手掌等比例缩放输出画面

[0088]

将得到的各图像帧中手势类别和自定义的手势语义集进行匹配,得到各图像帧中手势类别对应的语义,将得到语义转化为指令后对终端节点和显示模块相应位置进行操作。

[0089]

(3)指令执行结果查看步骤。

[0090]

查看终端节点和显示模块相应位置的操作结果并将其反馈给用户进行参考。

[0091]

具体地,本发明还提供了手势操控系统,包括如下单元:

[0092]

(1)手势识别单元:手势采集模块采集含有手势动作的图像帧序列,将图像帧序列中各图像帧分别输入到手势跟踪模型和训练好的手势检测模型,手势跟踪模型对各图像帧进行处理,得到各图像帧中手势区域的位置信息,将其输入到训练好的手势检测模型,得到各图像帧的手势类别和手势检测框中心点的坐标值;

[0093]

(2)指令执行单元:将各图像帧中手势检测框中心点的坐标值转换到终端节点和终端节点投影后的显示模块的相应位置,将各图像帧的手势类别和自定义的手势语义集进行匹配,得到手势类别对应的语义,将所述语义转化为指令,根据指令对终端节点和终端节点投影后的显示模块的相应位置进行操作;

[0094]

(3)指令执行结果查看单元:查看终端节点和显示模块的相应位置操作结果并将其反馈给用户进行参考。

[0095]

图2为本发明实施例的手势样本库训练单元框图,手势采集模块采集含有不同手势动作的图像帧,作为手势样本库,将手势样本库中各图像帧输入到深度学习网络进行训练,得到训练好的手势检测模型。

[0096]

图3为本发明实施例的手势识别单元框图,手势采集模块采集含有手势动作的图像帧序列,将图像帧序列中各图像帧分别输入到手势跟踪模型和训练好的手势检测模型,手势跟踪模型对各图像帧进行处理,得到各图像帧中手势区域的位置信息,将其输入到训练好的手势检测模型,得到检测结果。

[0097]

本领域的技术人员容易理解,以上所述仅为本发明的较佳实施例而已,并不用以限制本发明,凡在本发明的精神和原则之内所作的任何修改、等同替换和改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。