1.本发明涉及图像处理方法和图像处理装置。

背景技术:

2.内窥镜被广泛用于医疗领域和工业领域。在医疗领域中使用的内窥镜被插入到体内,取得体内的各种部位的图像。通过使用该图像,来实施观察对象的诊断和观察对象的处置(治疗)。在工业领域中使用的内窥镜被插入到工业产品内,取得工业产品内的各种部位的图像。通过使用该图像,来实施观察对象的检查和观察对象的处置(异物的去除等)。

3.正在开发具有内窥镜且显示立体图像(3d图像)的内窥镜装置。该内窥镜基于相互具有视差的多个光学像来取得多个图像。内窥镜装置的监视器基于多个图像而显示立体图像。观察者能够从立体图像中得到深度方向的信息。因此,操作者能够使用处置器具容易地对患部实施处置。在使用内窥镜的领域以外的领域也得到该优点。该优点在观察者一边观察图像一边使用器具实施处置的领域中是共同的。例如,即便在使用由显微镜取得的图像的情况下,也得到该优点。

4.器具大多位于观察对象与观察光学系统之间。即,在立体图像中,器具大多位于观察对象的近前。尤其是立体图像被显示为,器具的根部在观察者侧突出。因此,会聚角变大,观察者的眼睛容易疲劳。会聚角是在左眼的视线的中心轴与右眼的视线的中心轴交叉时由2根中心轴形成的角度。

5.专利文献1中公开了用于显示观察者容易观察的立体图像的技术。专利文献1所公开的内窥镜装置对映现出接近内窥镜的光学系统的位置的被摄体的区域的图像进行加工,使得从图像中看不到该区域。在显示出立体图像时,映现在看不到的区域的被摄体不被显示。

6.现有技术文献

7.专利文献

8.专利文献1:日本特开2004-187711号公报

技术实现要素:

9.发明要解决的问题

10.在专利文献1所公开的技术中,图像的一部分变得完全看不到,因此,观察者不容易使用器具。例如,存在观察者一边通过内窥镜取得图像一边使用处置器具的情况。通过使用专利文献1所公开的技术,处置器具的根部变得看不到,因此,观察者不容易判断处置器具的行进方向。

11.本发明的目的在于,提供一种能够在不损害器具的使用容易度的情况下减轻器具的图像使观察者的眼睛产生的疲劳的图像处理方法和图像处理装置。

12.用于解决问题的手段

13.根据本发明的第1方案,图像处理方法具有图像取得步骤和图像处理步骤。在所述

图像取得步骤中,处理器从输出相互具有视差的第1图像和第2图像的第1装置中取得所述第1图像和所述第2图像。所述第1图像和所述第2图像是观察对象和对所述观察对象实施处置的器具的图像。所述第1图像和所述第2图像分别包含第1区域和第2区域。所述第1图像的所述第1区域包含所述第1图像的中心。所述第2图像的所述第1区域包含所述第2图像的中心。所述观察对象的至少一部分映现在所述第1区域。所述第1图像的所述第2区域包含所述第1图像的至少1个端部。所述第2图像的所述第2区域包含所述第2图像的至少1个端部。所述器具的至少一部分映现在所述第2区域。在所述图像处理步骤中,所述处理器对所述第1图像和所述第2图像中的至少一方的包含所述第2区域的处理区域实施图像处理,变更所述处理区域的视差量。

14.根据本发明的第2方案,在第1方案中也可以是,在所述图像处理步骤中,所述处理器以在基于所述第1图像和所述第2图像而显示的立体图像中视点与所述器具的光学像之间的距离变大的方式变更所述处理区域的视差量。

15.根据本发明的第3方案,在第1方案中也可以是,在基于在所述图像取得步骤中取得的所述第1图像和所述第2图像而显示的立体图像中,所述观察对象的大部分位于交叉点的里侧。

16.根据本发明的第4方案,在第1方案中也可以是,所述第1区域的形状是圆、椭圆以及多边形中的任意1种。

17.根据本发明的第5方案,在第1方案中也可以是,在所述图像处理步骤中,所述处理器变更所述视差量,使所述处理区域的光学像成为平面。

18.根据本发明的第6方案,在第1方案中也可以是,所述处理区域包含2个以上的像素。也可以是,在所述图像处理步骤中,所述处理器变更所述视差量,使与所述2个以上的像素对应的光学像的2个以上的点向远离视点的方向移动。也可以是,所述2个以上的点所移动的距离彼此相等。

19.根据本发明的第7方案,在第1方案中也可以是,所述处理区域包含2个以上的像素。也可以是,在所述图像处理步骤中,所述处理器变更所述视差量,使与所述2个以上的像素对应的光学像的2个以上的点向远离视点的方向移动。也可以是,所述2个以上的像素中的各像素与所述第1区域之间的距离越大,则所述2个以上的点中的各点移动的距离越大。

20.根据本发明的第8方案,在第1方案中也可以是,所述处理区域包含2个以上的像素。也可以是,在所述图像处理步骤中,所述处理器变更所述视差量,使视点与光学像的2个以上的点中的各点之间的距离成为规定值以上,所述光学像的2个以上的点对应于所述2个以上的像素。

21.根据本发明的第9方案,在第1方案中也可以是,所述图像处理方法还具有区域设定步骤。也可以是,在所述图像处理步骤之前,在所述区域设定步骤中,所述处理器基于图像生成装置的种类、所述器具的种类以及摄像倍率中的至少一项来设定所述处理区域,其中,所述图像生成装置具有生成所述第1图像和所述第2图像的摄像元件。

22.根据本发明的第10方案,在第1方案中也可以是,所述图像处理方法还具有器具检测步骤和区域设定步骤。也可以是,在所述图像处理步骤之前,在所述器具检测步骤中,所述处理器从所述第1图像和所述第2图像中的至少一方检测所述器具。也可以是,在所述图像处理步骤之前,在所述区域设定步骤中,所述处理器将检测到所述器具的区域设定为所

述处理区域。

23.根据本发明的第11方案,在第1方案中也可以是,所述图像处理方法还具有区域设定步骤。也可以是,在所述图像处理步骤之前,在所述区域设定步骤中,所述处理器基于图像生成装置的种类、所述器具的种类以及摄像倍率中的至少一项来判断所述第1区域的位置,并且将去掉所述第1区域后的区域设定为所述处理区域,其中,该图像生成装置具有生成所述第1图像和所述第2图像的摄像元件。

24.根据本发明的第12方案,在第1方案中也可以是,所述图像处理方法还具有观察对象检测步骤和区域设定步骤。也可以是,在所述图像处理步骤之前,在所述观察对象检测步骤中,所述处理器从所述第1图像和所述第2图像中的至少一方检测所述观察对象。也可以是,在所述图像处理步骤之前,在所述区域设定步骤中,所述处理器将检测到所述观察对象的区域看作是所述第1区域,并且将去掉所述第1区域后的区域设定为所述处理区域。

25.根据本发明的第13方案,在第1方案中也可以是,所述图像处理方法还具有区域设定步骤。也可以是,在所述图像处理步骤之前,在所述区域设定步骤中,所述处理器基于由观察者输入到输入装置的信息来判断所述第1区域的位置,并且将去掉所述第1区域后的区域设定为所述处理区域。

26.根据本发明的第14方案,在第1方案中也可以是,所述图像处理方法还具有第1图像输出步骤。也可以是,在所述第1图像输出步骤中,所述处理器将包含变更了所述处理区域的所述视差量的图像的所述第1图像和所述第2图像向显示装置和通信装置中的一方输出,其中,该显示装置基于所述第1图像和所述第2图像而显示立体图像,该通信装置向所述显示装置输出所述第1图像和所述第2图像。

27.根据本发明的第15方案,在第14方案中也可以是,所述图像处理方法还具有模式选择步骤和第2图像输出步骤。也可以是,在所述模式选择步骤中,所述处理器选择第1模式和第2模式中的一方。也可以是,在所述第2图像输出步骤中,所述处理器将在所述图像取得步骤中取得的所述第1图像和所述第2图像向所述显示装置和所述通信装置中的一方输出。也可以是,在所述模式选择步骤中所述处理器选择了所述第1模式的情况下,所述处理器执行所述图像处理步骤和所述第1图像输出步骤。在所述模式选择步骤中所述处理器选择了所述第2模式的情况下,所述处理器不执行所述图像处理步骤而执行所述第2图像输出步骤。

28.根据本发明的第16方案,在第15方案中也可以是,在所述模式选择步骤中,所述处理器基于由观察者输入到输入装置的信息来选择所述第1模式和所述第2模式中的一方。

29.根据本发明的第17方案,在第15方案中也可以是,所述图像处理方法还具有第1运动检测步骤。也可以是,在所述第1运动检测步骤中,所述处理器检测生成所述第1图像和所述第2图像的摄像元件的运动的状态。也可以是,在所述模式选择步骤中,所述处理器基于所述状态而选择所述第1模式和所述第2模式中的一方。

30.根据本发明的第18方案,在第15方案中也可以是,所述图像处理方法还具有搜索步骤。也可以是,在搜索步骤中,所述处理器在所述第1图像和所述第2图像中的至少一方搜索所述器具。也可以是,在所述搜索步骤中所述处理器从所述第1图像和所述第2图像中的至少一方检测到所述器具的情况下,所述处理器在所述模式选择步骤中选择所述第1模式。也可以是,在所述搜索步骤中所述处理器没能从所述第1图像和所述第2图像中的至少一方

检测到所述器具的情况下,所述处理器在所述模式选择步骤中选择所述第2模式。

31.根据本发明的第19方案,在第15方案中也可以是,所述图像处理方法还具有第2运动检测步骤。也可以是,在所述第2运动检测步骤中,所述处理器检测所述器具的运动的状态。也可以是,在所述模式选择步骤中,所述处理器基于所述状态而选择所述第1模式和所述第2模式中的一方。

32.根据本发明的第20方案,图像处理装置具有处理器。所述处理器从输出相互具有视差的第1图像和第2图像的第1装置取得所述第1图像和所述第2图像。所述第1图像和所述第2图像是观察对象和对所述观察对象实施处置的器具的图像。所述第1图像和所述第2图像分别包含第1区域和第2区域。所述第1图像的所述第1区域包含所述第1图像的中心。所述第2图像的所述第1区域包含所述第2图像的中心。所述观察对象的至少一部分映现在所述第1区域。所述第1图像的所述第2区域包含所述第1图像的至少1个端部。所述第2图像的所述第2区域包含所述第2图像的至少1个端部。所述器具的至少一部分映现在所述第2区域。所述处理器对所述第1图像和所述第2图像中的至少一方的包含所述第2区域的处理区域实施图像处理,变更所述处理区域的视差量。

33.发明的效果

34.根据上述的各方案,图像处理方法和图像处理装置能够在不损害器具的使用容易度的情况下减轻器具的图像使观察者的眼睛产生的疲劳。

附图说明

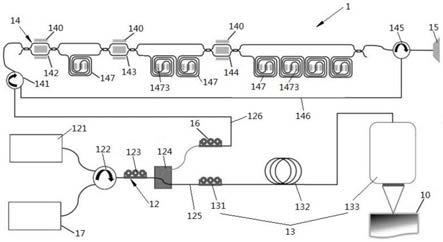

35.图1是示出具有本发明的第1实施方式的图像处理装置的内窥镜装置的结构的图。

36.图2是示出本发明的第1实施方式的内窥镜装置所具有的前端部的结构的图。

37.图3是示出本发明的第1实施方式的图像处理装置的结构的框图。

38.图4是示出本发明的第1实施方式的图像处理装置与监视器的其他连接例的图。

39.图5是示出由本发明的第1实施方式的内窥镜装置取得的图像的图。

40.图6是示出由本发明的第1实施方式的内窥镜装置取得的图像的图。

41.图7是示出在本发明的第1实施方式中显示的立体图像中的被摄体的光学像的位置的图。

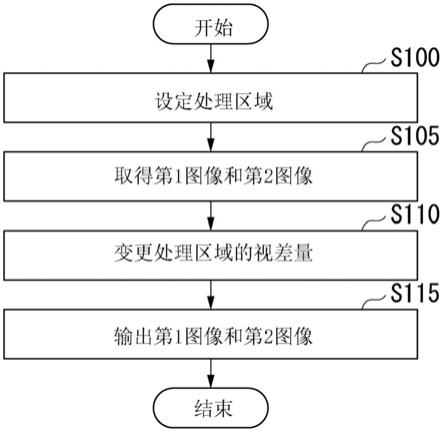

42.图8是示出本发明的第1实施方式的图像处理装置具有的处理器所执行的处理的步骤的流程图。

43.图9是示出在本发明的第1实施方式中显示的立体图像中的被摄体的光学像的位置的图。

44.图10是示出在本发明的第1实施方式的第1变形例中显示的立体图像中的被摄体的光学像的位置的图。

45.图11是示出在本发明的第1实施方式的第2变形例中显示的立体图像中的被摄体的光学像的位置的图。

46.图12是示出在本发明的第1实施方式的第3变形例中显示的立体图像中的被摄体的光学像的位置的图。

47.图13是示出本发明的第1实施方式的第4变形例中的区域信息的图。

48.图14是示出本发明的第1实施方式的第4变形例中的图像的图。

49.图15是示出本发明的第2实施方式的图像处理装置具有的处理器所执行的处理的步骤的流程图。

50.图16是示出在本发明的第2实施方式中显示的立体图像中的被摄体的光学像的位置的图。

51.图17是示出本发明的第2实施方式的第1变形例中的视差信息的曲线图。

52.图18是示出本发明的第3实施方式的图像处理装置具有的处理器所执行的处理的步骤的流程图。

53.图19是示出本发明的第4实施方式的图像处理装置具有的处理器所执行的处理的步骤的流程图。

54.图20是示出本发明的第4实施方式中的区域信息的图。

55.图21是示出本发明的第4实施方式的变形例中的区域信息的图。

56.图22是示出本发明的第5实施方式的图像处理装置具有的处理器所执行的处理的步骤的流程图。

57.图23是示出本发明的第6实施方式的变形例中的区域信息的图。

58.图24是示出本发明的第7实施方式的图像处理装置具有的处理器所执行的处理的步骤的流程图。

59.图25是示出本发明的第7实施方式的第1变形例的图像处理装置具有的处理器所执行的处理的步骤的流程图。

60.图26是示出本发明的第7实施方式的第2变形例的图像处理装置具有的处理器所执行的处理的步骤的流程图。

61.图27是示出本发明的第7实施方式的第3变形例的图像处理装置具有的处理器所执行的处理的步骤的流程图。

62.图28是示出本发明的第7实施方式的第4变形例的图像处理装置具有的处理器所执行的处理的步骤的流程图。

63.图29是示出本发明的第7实施方式的第5变形例的图像处理装置的周边的结构的框图。

64.图30是示出本发明的第7实施方式的第5变形例的图像处理装置具有的处理器所执行的处理的步骤的流程图。

65.图31是示出本发明的第7实施方式的第6变形例的图像处理装置具有的处理器所执行的处理的步骤的流程图。

66.图32是示出本发明的第8实施方式的图像处理装置具有的处理器所执行的处理的步骤的流程图。

67.图33是示出本发明的第8实施方式的变形例的图像处理装置具有的处理器所执行的处理的步骤的流程图。

具体实施方式

68.参照附图对本发明的实施方式进行说明。以下对具有图像处理装置的内窥镜装置的例子进行说明。内窥镜装置具备的内窥镜也可以为医疗用内窥镜和工业用内窥镜中的任意一方。本发明的实施方式不限于内窥镜装置。本发明的实施方式也可以为显微镜等。在观

察者一边观察立体图像一边利用器具对观察对象实施处置的情况下,能够使用本发明的各方案的图像处理方法和图像处理装置。观察者是医生、技术人员、研究人员或者装置管理人员等。

69.(第1实施方式)

70.图1示出本发明的第1实施方式的内窥镜装置1的结构。图1所示的内窥镜装置1具有电子内窥镜2、光源装置3、图像处理装置4以及监视器5。

71.电子内窥镜2具有摄像元件12(图2),取得被摄体的图像。光源装置3具有向电子内窥镜2供给照明光的光源。图像处理装置4对由电子内窥镜2的摄像元件12取得的图像进行处理,生成影像信号。监视器5基于从图像处理装置4输出的影像信号来显示图像。

72.电子内窥镜2具有前端部10、插入部21、操作部22以及通用缆线23。插入部21细长地构成且具有柔软性。前端部10配置在插入部21的前端。前端部10为硬质。操作部22配置在插入部21的后端。通用缆线23从操作部22的侧部伸出。连接器部24配置在通用缆线23的端部。连接器部24构成为能够向光源装置3装配和从光源装置3拆卸。连接线25从连接器部24伸出。电连接器部26配置在连接线25的端部。电连接器部26构成为能够向图像处理装置4装配和从图像处理装置4拆卸。

73.图2示出前端部10的概要结构。内窥镜装置1具有第1光学系统11l、第2光学系统11r、摄像元件12以及处置器具13。第1光学系统11l、第2光学系统11r以及摄像元件12配置在前端部10的内部。

74.第1光学系统11l对应于左眼。第2光学系统11r对应于右眼。第1光学系统11l的光轴与第2光学系统11r的光轴相互离开了规定距离。因此,第1光学系统11l和第2光学系统11r相互具有视差。第1光学系统11l和第2光学系统11r分别具有物镜等光学部件。摄像元件12是图像传感器。

75.第1光学系统11l和第2光学系统11r在前端部10的端面形成有用于取入来自被摄体的光的窗。在电子内窥镜2为双眼类型的内窥镜的情况下,在前端部10的端面形成有2个窗。2个窗的一方形成在第1光学系统11l的前方,并且2个窗的另一方形成在第2光学系统11r的前方。在电子内窥镜2为单眼类型的内窥镜的情况下,1个窗在前端部10的端面形成于第1光学系统11l和第2光学系统11r的前方。

76.处置器具13被插入到插入部21的内部。处置器具13为激光光纤或钳子等器具。用于使处置器具13通过的空间(通道)形成在插入部21的内部。处置器具13从前端部10的端面向前方伸出。处置器具13能够向前方行进或者能够向后方后退。也可以将2个以上的通道形成在插入部21中,并且将2个以上的处置器具插入到插入部21。

77.由光源装置3生成的照明光被照射到被摄体。由被摄体反射后的光向第1光学系统11l和第2光学系统11r入射。通过了第1光学系统11l的光在摄像元件12的摄像面上形成被摄体的第1光学像。通过了第2光学系统11r的光在摄像元件12的摄像面上形成被摄体的第2光学像。

78.摄像元件12基于第1光学像而生成第1图像,并且基于第2光学像而生成第2图像。第1光学像和第2光学像同时形成在摄像元件12的摄像面上,摄像元件12生成包含第1图像和第2图像的图像(摄像信号)。第1图像和第2图像是观察对象和器具的图像。第1图像和第2图像相互具有视差。摄像元件12连续地执行摄像,并且生成动态图像。该动态图像包括2个

以上的帧的第1图像和第2图像。摄像元件12输出所生成的图像。

79.第1光学像和第2光学像也可以依次形成在摄像元件12的摄像面上。例如,前端部10具有遮挡通过第1光学系统11l和第2光学系统11r中的一方的光的挡板。挡板能够在第1位置与第2位置之间移动。在将挡板配置于第1位置时,挡板遮挡通过第2光学系统11r的光。此时,第1光学像形成在摄像元件12的摄像面上,摄像元件12生成第1图像。在将挡板配置于第2位置时,挡板遮挡通过第1光学系统11l的光。此时,第2光学像形成在摄像元件12的摄像面上,摄像元件12生成第2图像。摄像元件12依次输出第1图像和第2图像。

80.在上述的例子中,由通过了第1光学系统11l的光形成第1光学像。基于第1光学像而生成第1图像。此外,在上述的例子中,由通过了第2光学系统11r的光形成第2光学像。基于第2光学像而生成第2图像。也可以基于第2光学像而生成第1图像,并且基于第1光学像而生成第2图像。

81.从摄像元件12输出的图像被向图像处理装置4传输。在图2中,省略了前端部10以外的插入部21、操作部22、通用缆线23、连接器部24、连接线25以及电连接器部26。图像处理装置4对从摄像元件12输出的图像所包含的第1图像和第2图像进行处理。图像处理装置4将处理后的第1图像和第2图像作为影像信号向监视器5输出。

82.监视器5是基于第1图像和第2图像而显示立体图像(三维图像)的显示装置。例如,监视器5是液晶显示器(lcd)、有机el显示器(oled)或者等离子显示器等这样的平板显示器。监视器5也可以是将图像投影到屏幕上的投影仪。作为显示立体图像的方法,能够利用圆偏振光方式或者主动快门等。在这些方法中使用专用眼镜。在圆偏振光方式中,能够使用不需要同步的轻量的专用眼镜。

83.图3示出图像处理装置4的结构。图3所示的图像处理装置4具有处理器41和rom(read only memory:只读存储器)42。

84.例如,处理器41是cpu(central processing unit)、dsp(digital signal processor:数字信号处理器)或者gpu(graphics processing unit)等。处理器41也可以由asic(application specific integrated circuit:专用集成电路)或者fpga(field-programmable gate array)等构成。图像处理装置4能够包括一个或多个处理器41。

85.第1图像和第2图像从摄像元件12被输出并输入到处理器41。处理器41在图像取得步骤中从摄像元件12(第1装置)取得第1图像和第2图像。从摄像元件12输出的第1图像和第2图像也可以存储在图3中未示出的存储装置中。处理器41也可以从该存储装置取得第1图像和第2图像。处理器41为了调整在立体图像中显示器具的光学像的位置,在图像处理步骤中对第1图像和第2图像中的至少一方进行处理。之后详细叙述处理器41所执行的图像处理。处理器41在第1图像输出步骤中将处理后的第1图像和第2图像向监视器5输出。

86.操作部22是具有由观察者(操作者)操作的部件的输入装置。例如,该部件是按钮或开关等。观察者通过对操作部22进行操作,能够输入用于控制内窥镜装置1的各种信息。操作部22将输入到操作部22的信息向处理器41输出。处理器41基于输入到操作部22的信息,对摄像元件12、光源装置3以及监视器5等进行控制。

87.rom42保持包含用于规定处理器41的动作的命令的程序。处理器41从rom42读入程序,并且执行所读入的程序。处理器41的功能能够由软件实现。上述的程序例如也可以由闪存这样的“计算机可读取的记录介质”提供。也可以从保持该程序的计算机经由传输介质或

者通过传输介质中的传输波而向内窥镜装置1传输该程序。传输程序的“传输介质”是具有传输信息的功能的介质。具有传输信息的功能的介质包括因特网等网络(通信网)和电话线路等通信线路(通信线)。上述的程序也可以实现上述功能的一部分。此外,上述的程序也可以是差分文件(差分程序)。已经记录在计算机中的程序与差分程序的组合也可以实现上述的功能。

88.在图2和图3所示的例子中,摄像元件12和图像处理装置4由通过插入部21等的信号线连接。摄像元件12和图像处理装置4也可以以无线的方式连接。即,摄像元件12也可以具有以无线的方式发送第1图像和第2图像的发送器,图像处理装置4也可以具有以无线的方式接收第1图像和第2图像的接收器。摄像元件12与图像处理装置4之间的通信也可以经由lan(local area network:局域网)等网络而执行。该通信也可以经由云上的设备而执行。

89.在图1和图3所示的例子中,图像处理装置4和监视器5通过信号线而连接。图像处理装置4和监视器5也可以以无线的方式连接。即,图像处理装置4也可以具有以无线的方式发送第1图像和第2图像的发送器,监视器5也可以具有以无线的方式接收第1图像和第2图像的接收器。图像处理装置4与监视器5之间的通信也可以经由lan等网络而执行。

90.在图3所示的例子中,处理器41将第1图像和第2图像向监视器5(显示装置)输出。处理器41也可以不将第1图像和第2图像直接向监视器5输出。图4示出图像处理装置4与监视器5的其他连接例。处理器41将第1图像和第2图像向接收装置6(通信装置)输出。接收装置6接收从图像处理装置4输出的第1图像和第2图像。接收装置6将接收到的第1图像和第2图像向监视器5输出。图像处理装置4和接收装置6可以通过信号线而连接,或者也可以以无线的方式连接。接收装置6和监视器5可以通过信号线而连接,或者也可以以无线的方式连接。接收装置6也可以被置换为硬盘驱动器或闪存等这样的存储装置。

91.参照图5对第1图像和第2图像进行说明。2个图像相互具有视差,但2个图像的构图不会有较大不同。图5示出第1图像的例子。以下说明的事项同样能够应用于第2图像。

92.图5所示的第1图像200是观察对象210和处置器具13的图像。观察对象210是观察者所关注的区域(关注区域)。例如,观察对象210是生物体内的部位(脏器或血管等)的患部。例如,患部是癌等肿瘤。患部有时被称为病变部。观察对象210的周边是该部位(被摄体)的一部分。处置器具13显示在被摄体上。处置器具13对观察对象210实施处置。处置器具13具有钳子130和护套131。钳子130与观察对象210接触,并且对观察对象210实施处置。护套131是支承钳子130的支承部。钳子130被固定于护套131。处置器具13除了钳子130以外也可以具有圈套器或it刀等。

93.第1图像200包含第1区域r10和第2区域r11。虚线l10表示第1区域r10与第2区域r11的边界。第1区域r10是虚线l10的内侧的区域,第2区域r11是虚线l10的外侧的区域。第1区域r10包含第1图像200的中心c10。观察对象210映现在第1区域r10。第2区域r11包括第1图像200的至少1个端部。在图5所示的例子中,第2区域r11包括第1图像200的4个端部。处置器具13映现在第2区域r11。处置器具13映现在包含第1图像200的下侧的端部在内的区域。

94.也可以是处置器具13的一部分映现在第1区域r10。在图5所示的例子中,处置器具13的前端部(钳子130)映现在第1区域r10,处置器具13的根部侧的部分(护套131)映现在第2区域r11。钳子130位于观察对象210的近前,遮挡了观察对象210的一部分。第1图像200中

的处置器具13的根部是映现在第1图像200的下侧的端部的护套131的部分。观察对象210的一部分也可以映现在第2区域r11。即,也可以是,观察对象210的一部分映现在第1区域r10,并且观察对象210的剩余部分映现在第2区域r11。

95.第2图像与第1图像200同样地包含第1区域和第2区域。第2图像的第1区域包含第2图像的中心。观察对象映现在第2图像的第1区域。第2图像的第2区域包含第2图像的至少1个端部。处置器具13映现在第2图像的第2区域。

96.第1区域和第2区域是为了区分映现出观察对象的区域与映现出处置器具13的区域而定义的区域。不限于通过图5所示的虚线l10那样的具有固定形状的线而明确地定义第1区域和第2区域。

97.第1图像和第2图像也可以包含与第1区域和第2区域均不同的第3区域。也可以是,与观察对象不同的某个被摄体映现在第3区域。观察对象或处置器具13的一部分也可以映现在第3区域。第3区域也可以为第1区域与第2区域之间的区域。第3区域也可以包含与映现出处置器具13的图像的端部不同的端部。第3区域也可以包含映现出处置器具13的图像的端部的一部分。

98.处置器具13经由插入部21而插入到体内。处置器具13以外的处置器具也可以不经由供处置器具13插入的插入部21而插入到体内。图6示出第1图像的其他例。图6所示的第1图像201是观察对象210、处置器具14以及处置器具15的图像。处置器具14和处置器具15不经由插入部21而插入到体内。例如,内窥镜装置1除了处置器具13之外还具有处置器具14和处置器具15中的至少一方。也可以是与图1所示的内窥镜装置1不同的内窥镜装置具有处置器具14和处置器具15中的至少一方。由处置器具14和处置器具15实施的处置的种类也可以互不相同。内窥镜装置1也可以不具有处置器具13。

99.在图5所示的例子中,1个处置器具映现在图像中,在图6所示的例子中,2个处置器具映现在图像中。也可以是3个以上的处置器具映现在图像中。也可以是处置器具14及处置器具15中的至少一方和处置器具13映现在图像中。

100.参照图7对立体图像中的被摄体的光学像的位置进行说明。图7示出在基于第1图像和第2图像而将立体图像显示于监视器5时由观察者视觉识别的被摄体的光学像的位置。在图7所示的例子中,设想处理器41对从摄像元件12输出的第1图像和第2图像不实施视差量的变更。之后叙述视差量的变更。

101.视点vl对应于观察者的左眼。视点vr对应于观察者的右眼。观察者通过视点vl和视点vr来捕捉被摄体的光学像。也可以将视点vl与视点vr的中间的点vc定义为观察者的视点。在以下的例子中,将观察者的视点与被摄体的光学像之间的距离定义为点vc与被摄体的光学像之间的距离。

102.第1光学系统11l的光轴与第2光学系统11r的光轴交叉的点被称为交叉点。交叉点有时被称为聚集点或零点等。在交叉点上的被摄体的区域,第1图像与第2图像之间的视差量为0。在显示立体图像的情况下,交叉点的位置被设定为使得观察者容易观察立体图像。例如,如图7所示,交叉点cp设定在屏幕面sc上。屏幕面sc有时被称为显示器面、监视器面或零平面等。屏幕面sc对应于监视器5的画面5a(图1)。在图7所示的例子中,屏幕面sc是包含交叉点cp且与观察者的视点正对的平面。交叉点cp也可以不是屏幕面sc上的位置。交叉点cp也可以是屏幕面sc的近前侧的位置或者屏幕面sc的里侧的位置。

103.在图7所示的例子中,在观察者能够视觉确认的区域存在物体ob1的光学像和物体ob2的光学像。物体ob1的光学像位于交叉点cp的里侧的区域r20(屏幕面sc的里侧的区域)。例如,物体ob1是观察对象。观察者的视点与物体ob1的光学像之间的距离为d1。观察对象的大部分位于区域r20。例如,观察对象的50%以上位于区域r20。观察对象也可以全部位于区域r20。

104.物体ob2的光学像位于交叉点cp的近前侧的区域r21(屏幕面sc的近前侧的区域)。物体ob2的光学像位于观察者的视点与屏幕面sc之间。例如,物体ob2是处置器具13的根部侧的部分。观察者的视点与物体ob2的光学像之间的距离为d2。距离d2小于距离d1。也有时全部的物体的光学像位于区域r20。

105.映现出在立体图像中位于交叉点cp的里侧的物体的第1图像和第2图像的区域被定义为具有正的视差量。例如,在第1图像中映现出物体ob1的区域与在第2图像中映现出物体ob1的区域之间的视差量为正值。在物体ob1为观察对象210的情况下,图5所示的第1图像200的第1区域r10的至少一部分与第2图像的第1区域的至少一部分之间的视差量为正值。观察者的视点与物体ob1的光学像之间的距离d1越大,则视差量的绝对值变得越大,并且物体ob1的光学像越远离观察者的视点。

106.映现出在立体图像中位于交叉点cp的近前侧的物体的第1图像和第2图像的区域被定义为具有负的视差量。例如,在第1图像中映现出物体ob2的区域与在第2图像中映现出物体ob2的区域之间的视差量为负值。在物体ob2为处置器具13的根部侧的部分的情况下,图5所示的第1图像200的第2区域r11的至少一部分与第2图像的第2区域的至少一部分之间的视差量为负值。观察者的视点与物体ob2的光学像之间的距离d2越小,则视差量的绝对值变得越大,并且物体ob2的光学像越接近观察者的视点。在物体ob2的光学像接近观察者的视点的情况下,观察者观察到物体ob2大幅突出。在该情况下,会聚角较大,观察者的眼睛容易疲劳。

107.对处理器41所执行的视差量的变更进行说明。处理器41对第1图像和第2图像中的至少一方的包含第2区域的处理区域实施图像处理,变更处理区域的视差量,使得在基于第1图像和第2图像而显示的立体图像中观察者的视点与器具的光学像之间的距离变大。该立体图像是在处理器41执行了视差量的变更之后基于第1图像和第2图像而显示的立体图像。例如,处理器41设定图5所示的第1图像200的包含第2区域r11的处理区域,并且变更该处理区域的视差量。

108.例如,在处理器41执行视差量的变更之前,观察者的视点与物体ob2的光学像之间的距离为d2。处理器41对第1图像和第2图像中的至少一方实施图像处理,使处理区域的视差量向正方向变化。在映现出处置器具13的第2区域的视差量为负值的情况下,处理器41使包含第2区域的处理区域的视差量增加。处理器41也可以将处理区域的视差量变更为0,或者还可以将处理区域的视差量变更为正值。在处理器41执行了视差量的变更之后,观察者的视点与物体ob2的光学像之间的距离大于d2。其结果是,会聚角变小,减轻了观察者的眼睛的疲劳。

109.参照图8,对处理器41所执行的处理进行说明。图8示出处理器41所执行的处理的步骤。

110.处理器41设定包含第2区域的处理区域(步骤s100)。详细说明步骤s100。第1图像

和第2图像各自的整体大小是已知的。在执行步骤s100之前,表示第2区域的位置的区域信息被存储于图3中未示出的存储器。区域信息也可以包含表示第2区域的大小和形状中的至少一方的信息。处理器41在步骤s100中从存储器读出区域信息。处理器41基于区域信息来判断第2区域的位置。处理器41设定包含第2区域的处理区域。处理区域包含2个以上的像素。例如,处理区域与第2区域相同,第1区域不包含在处理区域中。处理器41也可以设定2个以上的处理区域。处理器41通过保持处理区域的信息来设定处理区域。处理器41也可以从与内窥镜装置1不同的装置取得区域信息。

111.在步骤s105之后,处理器41从摄像元件12取得第1图像和第2图像(步骤s105(图像取得步骤))。步骤s105和步骤s100被执行的顺序也可以与图8所示的顺序不同。即,也可以在执行步骤s105之后执行步骤s100。

112.在步骤s100之后,处理器41通过变更第1图像和第2图像中的至少一方的处理区域的图像数据来变更视差量(步骤s110(图像处理步骤))。处理器41也可以仅变更第1图像中的处理区域的视差量。处理器41也可以仅变更第2图像中的处理区域的视差量。处理器41也可以变更第1图像和第2图像各自的处理区域的视差量。

113.详细说明步骤s110。例如,处理器41以处理区域的光学像成为平面的方式变更处理区域的视差量。由此,处理器41以处置器具13的光学像成为平面的方式变更处理区域的视差量。具体而言,处理器41将第1图像中的处理区域所包含的各像素的数据置换为与第1图像的各像素对应的第2图像所包含的各像素的数据。因此,2个图像的相同像素具有相同数据。处理器41也可以将第2图像中的处理区域所包含的各像素的数据置换为与第2图像的各像素对应的第1图像所包含的各像素的数据。

114.图9示出在基于第1图像和第2图像而将立体图像显示于监视器5时由观察者视觉识别的被摄体的光学像的位置。省略与图7所示的部分相同的部分的说明。

115.图9示出映现在处理区域的处置器具13的光学像。映现在第1区域的处置器具13的光学像在图9中被省略。图9示出在第1图像和第2图像中在图像的中心的右侧映现出处置器具13的例子。

116.在处理器41变更第1图像中的处理区域的视差量之前,映现在处理区域的处置器具13的光学像13a显示于屏幕面sc的近前侧。在处理器41变更了第1图像中的处理区域的视差量之后,该处理区域与对应于该处理区域的第2图像的区域之间的视差量为0。映现在处理区域的处置器具13的光学像13b在立体图像中被显示为包含交叉点cp的平面。例如,光学像13b显示在屏幕面sc内。光学像13b远离观察者的视点。

117.在处理器41变更了第1图像中的处理区域的视差量之后,在处理区域与该处理区域以外的区域的边界产生视差量的不连续。即,在第1区域与第2区域的边界产生视差量的不连续。处理器41为了消除该不连续,也可以执行使该边界的周边的数据的变化变得平滑这样的图像处理。由此,该边界变得不再显眼,图像看起来变得自然。

118.处理器41也可以变更处理区域的视差量,并且变更第1图像和第2图像中的至少一方的第1区域的视差量。变更第1区域的视差量的方法与变更处理区域的视差量的方法不同。例如,处理器41也可以以观察对象的光学像向交叉点的里侧远离的方式变更第1区域的视差量。在变更第1区域的视差量的情况下,第1区域的视差量的变更量也可以小于处理区域的视差量的变更量的最大值。

119.在步骤s110之后,处理器41将包含变更了处理区域的视差量的图像的第1图像和第2图像向监视器5输出(步骤s115(第1图像输出步骤))。例如,处理器41将在步骤s110中变更了处理区域的视差量的第1图像和在步骤s105中取得的第2图像向监视器5输出。

120.在步骤s105、步骤s110以及步骤s115中,对动态图像所包含的对应于1帧的图像进行处理。处理器41通过重复执行步骤s105、步骤s110以及步骤s115而对动态图像进行处理。在设定了应用于最开始的帧的处理区域之后,也可以将处理区域应用于剩余的1个以上的帧。在该情况下,将步骤s100执行1次,将步骤s105、步骤s110以及步骤s115执行2次以上。

121.处理器41基于区域信息来设定处理区域,因此,处理区域的位置被固定。处理器41能够容易地设定处理区域。

122.区域信息也可以表示第1区域的位置。区域信息除了包含表示第1区域的位置的信息之外,也可以包含表示第1区域的大小和形状中的至少一方的信息。处理器41也可以基于区域信息来判断第1区域的位置,并且将图像中除了第1区域的区域看作是第2区域。在第1区域包含观察对象的整体的情况下,观察对象不受处理区域的视差量的变更的影响。因此,观察者容易使用处置器具13对观察对象实施处置。

123.在图5所示的例子中,第1区域r10的形状为圆。在第1图像和第2图像的形状为圆且第1区域的形状为圆的情况下,观察者不容易对图像感觉到不适感。第1区域的形状也可以为椭圆或多边形。多边形具有4个以上的顶点。第1区域的形状也可以为具有8个以上的顶点的多边形。

124.在第1实施方式中,处理器41以立体图像中的观察者的视点与器具的光学像之间的距离变大的方式变更包含第2区域的处理区域的视差量。因此,图像处理装置4能够在不损害器具的使用容易度的情况下减轻器具的图像使观察者的眼睛产生的疲劳。

125.(第1实施方式的第1变形例)

126.对本发明的第1实施方式的第1变形例进行说明。说明以处置器具13的光学像成为平面的方式变更视差量的其他方法。

127.处理器41在步骤s110中,使第1图像中的处理区域所包含的各像素的数据的位置向规定的方向偏移。由此,处理器41变更处理区域的视差量。规定的方向是与图像的水平方向平行的方向。规定的方向是负的视差量向正方向变化的方向。在第1图像对应于被第1光学系统11l捕捉的光学像的情况下,规定的方向为左方向。在第1图像对应于被第2光学系统11r捕捉的光学像的情况下,规定的方向为右方向。

128.处理器41在步骤s110中,以使处理区域所包含的各像素中的被摄体的光学像向与屏幕面离开了距离a1的位置移动的方式使各像素的数据的位置偏移。处理器41通过执行该处理,将处理区域所包含的各像素的视差量变更b1。处理器41能够基于距离a1来计算视差量的变更量b1。

129.说明使各像素的数据的位置偏移的方法。处理器41利用向与规定的方向相反的方向离开了距离c1的像素的数据来置换处理区域所包含的各像素的数据。距离c1可以与视差量的变更量b1相同,或者也可以基于视差量的变更量b1来计算距离c1。在向与规定的方向相反的方向与第1图像的像素离开了距离c1的位置不包含在第1图像中的情况下,处理器41对该像素的数据进行插值。例如,在向第1图像的像素的右方向离开了距离c1的位置不包含在第1图像中的情况下,处理器41通过使用与该位置对应的第2图像的像素的数据来对数据

进行插值。在向规定的方向与第1图像的像素离开了距离c1的位置不包含在第1图像中的情况下,处理器41不生成该位置的数据。处理器41也可以使第2图像中的处理区域所包含的各像素的数据的位置向规定的方向偏移。

130.图10示出在基于第1图像和第2图像将立体图像显示于监视器5时由观察者视觉识别的被摄体的光学像的位置。省略与图7所示的部分相同的部分的说明。

131.图10示出映现在处理区域的处置器具13的光学像。映现在第1区域的处置器具13的光学像在图10中被省略。图10示出在第1图像和第2图像中处置器具13映现在图像的中心的右侧的例子。

132.在处理器41变更第1图像中的处理区域的视差量之前,映现在处理区域的处置器具13的光学像13a显示在屏幕面sc的近前侧。在处理器41变更了第1图像中的处理区域的视差量之后,映现在处理区域的处置器具13的光学像13b显示在与屏幕面sc离开了距离a1的假想的平面pl1上。平面pl1与观察者的视点正对。光学像13b远离观察者的视点。

133.在图10所示的例子中,平面pl1位于屏幕面sc的里侧。平面pl1也可以位于屏幕面sc的近前侧。

134.在执行步骤s110之前,表示距离a1的信息也可以存储于图3中未示出的存储器。处理器41也可以在步骤s110中从存储器读出该信息。处理器41也可以从与内窥镜装置1不同的装置取得该信息。

135.处理器41也可以基于第1图像和第2图像中的至少一方来计算距离a1。例如,距离a1也可以与第1区域的最靠外侧的像素的被摄体的光学像与屏幕面之间的距离相同。在该情况下,不容易产生处理区域与该处理区域以外的区域的边界处的视差量的不连续。即,不容易产生第1区域与第2区域的边界处的视差量的不连续。因此,该边界变得不再显眼,图像看起来变得自然。

136.观察者也能够指定距离a1。例如,观察者也可以对操作部22进行操作,输入距离a1。处理器41也可以使用输入到操作部22的距离a1。

137.在处理器41变更了处理区域的视差量之后,映现在处理区域的处置器具13的光学像在立体图像中显示为与屏幕面离开了距离a1的平面。因此,图像处理装置4能够在不损害器具的使用容易度的情况下减轻器具的图像使观察者的眼睛产生的疲劳。在器具的光学像显示于屏幕面的里侧的情况下,减轻目的疲劳的效果提高。

138.(第1实施方式的第2变形例)

139.对本发明的第1实施方式的第2变形例进行说明。说明以处置器具13的光学像远离观察者的视点的方式变更视差量的其他方法。

140.处理区域包含2个以上的像素。处理器41在图像处理步骤中以与该2个以上的像素对应的光学像的2个以上的点向远离观察者的视点的方向(朝向屏幕面的方向)移动的方式变更视差量。2个以上的点所移动的距离彼此相等。

141.处理器41在步骤s110中,使第1图像中的处理区域所包含的各像素的数据的位置向规定的方向偏移。由此,处理器41变更处理区域的视差量。规定的方向与在第1实施方式的第1变形例中说明的方向相同。

142.处理器41在步骤s110中,以使处理区域所包含的各像素中的被摄体的光学像从各光学像的位置移动到向里侧离开了距离a2的位置的方式,使各像素的数据的位置偏移。处

理器41通过执行该处理,将处理区域所包含的各像素的视差量变更b2。由此,处理区域所包含的全部像素中的被摄体的光学像移动相同的距离a2。处理器41能够基于距离a2来计算视差量的变更量b2。

143.例如,处理区域包括第1像素和第2像素。第1像素中的被摄体的光学像所移动的距离a2与第2像素中的被摄体的光学像所移动的距离a2相同。

144.说明使各像素的数据的位置偏移的方法。处理器41将处理区域所包含的各像素的数据置换为向与规定的方向相反的方向离开了距离c2的像素的数据。距离c2可以与视差量的变更量b2相同,或者也可以基于视差量的变更量b2来计算距离c2。处理器41通过使用与在第1实施方式的第1变形例中说明的方法同样的方法而将各像素的数据置换为其他像素的数据。处理器41也可以使第2图像中的处理区域所包含的各像素的数据的位置向规定的方向偏移。

145.图11示出在基于第1图像和第2图像而将立体图像显示于监视器5时由观察者视觉识别的被摄体的光学像的位置。省略与图7所示的部分相同的部分的说明。

146.图11示出映现在处理区域的处置器具13的光学像。映现在第1区域的处置器具13的光学像在图11中被省略。图11示出在第1图像和第2图像中处置器具13映现在图像的中心的右侧的例子。

147.在处理器41变更第1图像中的处理区域的视差量之前,映现在处理区域的处置器具13的光学像13a显示在屏幕面sc的近前侧。在处理器41变更了第1图像中的处理区域的视差量之后,映现在处理区域的处置器具13的光学像13b显示在从光学像13a向里侧离开了距离a2的位置。光学像13b远离观察者的视点。

148.在图11所示的例子中,处置器具13的光学像13b包含位于屏幕面sc的里侧的部分和位于屏幕面sc的近前侧的部分。也可以是,光学像13b的整体位于屏幕面sc的里侧或屏幕面sc的近前侧。

149.在执行步骤s110之前,表示距离a2的信息也可以存储于在图3中未示出的存储器。处理器41也可以在步骤s110中从存储器读出该信息。处理器41也可以从与内窥镜装置1不同的装置取得该信息。

150.观察者也能够指定距离a2。例如,观察者也可以对操作部22进行操作,输入距离a2。处理器41也可以使用输入到操作部22的距离a2。

151.在处理器41变更了处理区域的视差量之后,映现在处理区域的处置器具13的光学像在立体图像中显示在从实际的位置向里侧离开了距离a2的位置。因此,图像处理装置4能够在不损害器具的使用容易度的情况下减轻器具的图像使观察者的眼睛产生的疲劳。

152.处理区域所包含的全部像素中的被摄体的光学像移动相同的距离a2。因此,在处理区域中维持了相对的深度的信息。其结果是,观察者容易操作处置器具13。

153.(第1实施方式的第3变形例)

154.对本发明的第1实施方式的第3变形例进行说明。说明以处置器具13的光学像远离观察者的视点的方式变更视差量的其他方法。

155.处理区域包含2个以上的像素。处理器41在图像处理步骤中以与该2个以上的像素对应的光学像的2个以上的点向远离观察者的视点的方向(朝向屏幕面的方向)移动的方式变更视差量。2个以上的像素中的各像素与第1区域之间的距离越大,则2个以上的点中的各

点移动的距离越大。

156.处置器具13与第1区域之间的距离越大,处置器具13越具有向近前大幅突出的趋势。因此,处置器具13越远离第1区域,则处置器具13从实际的位置向里侧移动的距离越需要变大。也可以是,2个以上的像素中的各像素与图像的端部之间的距离越小,则处置器具13的光学像的2个以上的点中的各点移动的距离越大。

157.处理器41在步骤s110中使第1图像中的处理区域所包含的各像素的数据的位置向规定的方向偏移。由此,处理器41变更处理区域的视差量。规定的方向与在第1实施方式的第1变形例中说明的方向相同。

158.处理器41在步骤s110中计算处理区域所包含的各像素中的被摄体的光学像所移动的距离a3。距离a3是与各像素和第1区域的基准位置之间的二维距离相应的值。例如,基准位置是与处理区域所包含的各像素最近的第1区域的像素。第1区域的其他像素位于第1区域的端部。基准位置也可以是第1区域的中心或第1图像的中心。处理器41以使处理区域所包含的各像素中的被摄体的光学像从各光学像的位置移动到向里侧离开了距离a3的位置的方式,使各像素的数据的位置偏移。处理器41通过执行该处理,将处理区域所包含的各像素的视差量变更b3。由此,处理区域所包含的各像素中的被摄体的光学像移动与各像素的位置相应的距离a3。处理器41能够基于距离a3来计算视差量的变更量b3。

159.例如,处理区域包含第1像素和第2像素。第2像素与第1区域之间的距离大于第1像素与第1区域之间的距离。第2像素中的被摄体的光学像所移动的距离a3大于第1像素中的被摄体的光学像所移动的距离a3。

160.包含在处理区域中并且与第1区域相接的像素中的被摄体的光学像所移动的距离a3也可以为0。在处理区域所包含的像素接近第1区域的情况下,该像素中的被摄体的光学像所移动的距离a3也可以非常小。距离a3也可以基于处理区域所包含的像素与第1区域之间的距离呈指数函数地增加。

161.说明使各像素的数据的位置偏移的方法。处理器41将处理区域所包含的各像素的数据置换为向与规定的方向相反的方向离开了距离c3的像素的数据。距离c3可以与视差量的变更量b3相同,或者还可以基于视差量的变更量b3来计算距离c3。处理器41通过使用与在第1实施方式的第1变形例中说明的方法同样的方法,将各像素的数据置换为其他像素的数据。处理器41也可以使第2图像中的处理区域所包含的各像素的数据的位置向规定的方向偏移。

162.图12示出在基于第1图像和第2图像而将立体图像显示于监视器5时由观察者视觉识别的被摄体的光学像的位置。省略与图7所示的部分相同的部分的说明。

163.图12示出映现在处理区域的处置器具13的光学像。映现在第1区域的处置器具13的光学像在图12中被省略。图12示出在第1图像和第2图像中处置器具13映现在图像的中心的右侧的例子。

164.在处理器41变更第1图像中的处理区域的视差量之前,映现在处理区域的处置器具13的光学像13a显示在屏幕面sc的近前侧。在处理器41变更了第1图像中的处理区域的视差量之后,映现在处理区域的处置器具13的光学像13b显示在从光学像13a向里侧离开的位置。与第1区域最远的光学像13a的点移动距离a3a。与第1区域最近的光学像13a的点不移动。该点也可以移动比距离a3a小的距离。光学像13b远离观察者的视点。

165.在图12所示的例子中,处置器具13的光学像13b位于屏幕面sc的近前侧。光学像13b的至少一部分也可以位于屏幕面sc的里侧。

166.在执行步骤s110之前,表示距离a3的信息也可以存储于图3中未示出的存储器。处理器41也可以在步骤s110中从存储器读出该信息。处理器41也可以从与内窥镜装置1不同的装置取得该信息。

167.在处理器41变更了处理区域的视差量之后,映现在处理区域的处置器具13的光学像在立体图像中显示于从实际的位置向里侧离开了距离a3的位置。因此,图像处理装置4能够在不损害器具的使用容易度的情况下减轻器具的图像使观察者的眼睛产生的疲劳。

168.在包含于处理区域且与第1区域相接的像素中的被摄体的光学像不移动的情况下,在第1区域与处理区域的边界处不容易产生视差量的不连续。因此,观察者不容易感觉到不适感。处理器41也可以不执行使第1区域与处理区域的边界的周边的数据的变化变得平滑这样的图像处理。

169.(第1实施方式的第4变形例)

170.对本发明的第1实施方式的第4变形例进行说明。在图像处理步骤之前,处理器41在区域设定步骤中基于图像生成装置的种类与器具的种类中的至少一方来设定处理区域。图像生成装置是具有生成第1图像和第2图像的摄像元件12的装置。在图1所示的例子中,图像生成装置是电子内窥镜2。

171.处置器具13映现在图像中的位置根据插入部21中的通道的数量和位置而不同。该通道的数量和位置大多根据电子内窥镜2的种类而不同。此外,有时插入到通道的处置器具13的种类被固定。处置器具13的大小或形状等大多根据处置器具的种类而不同。因此,处置器具13映现在图像中的位置大多根据电子内窥镜2的种类和处置器具13的种类而不同。

172.例如,在执行步骤s100之前,将电子内窥镜2的种类、处置器具13的种类以及处理区域的位置关联起来的区域信息被存储于图3中未示出的存储器。处理器41在步骤s100中从存储器读出区域信息。处理器41也可以从与内窥镜装置1不同的装置取得区域信息。

173.图13示出区域信息的例子。区域信息包含信息e1、信息e2以及信息e3。信息e1表示电子内窥镜2的种类。信息e2表示处置器具13的种类。信息e3表示处理区域的位置。信息e3也可以包含表示处理区域的大小和形状中的至少一方的信息。在处理区域的大小始终被固定的情况下,信息e3也可以不包含表示处理区域的大小的信息。在处理区域的形状始终被固定的情况下,信息e3也可以不包含表示处理区域的形状的信息。

174.在图13所示的例子中,电子内窥镜f1、处置器具g1以及处理区域h1被关联起来。在图13所示的例子中,电子内窥镜f2、处置器具g2以及处理区域h2被关联起来。在图13所示的例子中,电子内窥镜f3、处置器具g3、处置器具g4以及处理区域h3被关联起来。在图13所示的例子中,电子内窥镜f3的插入部21具有2个通道。处置器具g3被插入到一方的通道,处置器具g4被插入到另一方的通道。在使用电子内窥镜f3的情况下,也可以设定映现出处置器具g3的第1处理区域与映现出处置器具g4的第2处理区域。

175.区域信息也可以仅包含信息e1和信息e3。或者,区域信息也可以仅包含信息e2和信息e3。

176.处理器41判断所使用的电子内窥镜2的种类和所使用的处置器具13的种类。例如,观察者也可以对操作部22进行操作,输入表示电子内窥镜2的种类和处置器具13的种类的

信息。处理器41也可以基于该信息来判断电子内窥镜2的种类和处置器具13的种类。

177.在连接了电子内窥镜2与图像处理装置4时,处理器41也可以从电子内窥镜2取得表示电子内窥镜2的种类和处置器具13的种类的信息。内窥镜装置1也可以具有读码器,读码器读取二维码,并且处理器41从读码器取得该二维码的信息。该二维码表示电子内窥镜2的种类和处置器具13的种类。该二维码也可以粘贴在电子内窥镜2的表面上。

178.处理器41从区域信息提取与所使用的电子内窥镜2及处置器具13的组合对应的处理区域的信息。例如,在使用电子内窥镜f2和处置器具g2的情况下,处理器41提取处理区域h2的信息。处理器41基于提取出的信息来设定处理区域。

179.图14示出第1图像的例子。图14所示的第1图像202是观察对象210和处置器具13的图像。第1图像202包含第1区域r12和第2区域r13。虚线l11表示第1区域r12与第2区域r13的边界。第1区域r12是虚线l11的上侧的区域,第2区域r13是虚线l11的下侧的区域。第1区域r12包含第1图像202的中心c11。观察对象210映现在第1区域r12。第2区域r13包含第1图像202的下侧的端部。处置器具13映现在第2区域r13。处理器41将第2区域r13设定为处理区域。

180.在使用特定种类的电子内窥镜2的情况下,处置器具13仅映现在第1图像202的下侧的区域。在该情况下,处理器41能够代替图5所示的第2区域r11而将图14所示的第2区域r13设定为处理区域。第2区域r13小于第2区域r11。

181.处理器41能够设定适合于电子内窥镜2的种类和处置器具13的种类的处理区域。因此,处理区域变小,变更视差量的处理中的处理器41的负荷减少。

182.(第2实施方式)

183.对本发明的第2实施方式进行说明。在第2实施方式中,处理区域包含第1区域和第2区域。例如,处理区域是第1图像的整体或第2图像的整体。

184.处理区域包含2个以上的像素。处理器41以观察者的视点与和该2个以上的像素对应的光学像的2个以上的点的每个点之间的距离成为规定值以上的方式变更处理区域的视差量。

185.参照图15,对处理器41所执行的处理进行说明。图15示出处理器41所执行的处理的步骤。省略与图8所示的处理相同的处理的说明。

186.处理器41不执行图8所示的步骤s100。在步骤s105之后,处理器41变更第1图像和第2图像中的至少一方的处理区域的视差量(步骤s110a(图像处理步骤))。在步骤s110a之后,执行步骤s115。

187.步骤s110a与图8所示的步骤s110不同。详细说明步骤s110a。以下,说明处理器41变更第1图像的视差量的例子。处理器41也可以通过使用与以下的方法同样的方法来变更第2图像的视差量。

188.处理器41计算第1图像所包含的各像素的视差量。处理器41对第1图像所包含的全部像素执行该处理。例如,处理器41通过使用立体匹配来计算各像素的视差量。

189.处理器41对第1图像所包含的全部像素执行以下的处理。处理器41对像素的视差量与规定量b4进行比较。在像素的视差量小于规定量b4的情况下,观察者的视点与该像素中的被摄体的光学像之间的距离小于a4。观察者观察到该被摄体大幅突出。在第1图像所包含的像素的视差量小于规定量b4的情况下,处理器41将该像素的视差量变更为规定量b4。

在第1图像所包含的像素的视差量为规定量b4以上的情况下,处理器41不变更该像素的视差量。处理器41能够基于距离a4来计算视差的规定量b4。处理器41通过执行上述的处理,以观察者的视点与处置器具13的光学像之间的距离成为规定值以上的方式变更处理区域的视差量。

190.处理器41使第1图像所包含的全部像素的至少一部分的数据的位置向规定的方向偏移。由此,处理器41变更处理区域的视差量。规定的方向与在第1实施方式的第1变形例中说明的方向相同。

191.在第1图像所包含的像素的视差量小于规定量b4的情况下,处理器41将该像素的数据置换为向与规定的方向相反的方向离开了距离c4的像素的数据。距离c4可以与该像素的视差量和规定量b4之差相同,或者也可以基于该差来计算距离c4。处理器41通过使用与在第1实施方式的第1变形例中说明的方法同样的方法,将各像素的数据置换为其他像素的数据。处理器41也可以使第2图像中的处理区域所包含的各像素的数据的位置向规定的方向偏移。

192.包含观察对象的第1区域所包含的像素的视差量大多为规定量b4以上。第1区域的一部分所包含的像素的视差量有时小于规定量b4。在该情况下,处理器41通过执行上述的处理来变更第1区域所包含的像素的视差量。该视差量的变更量小于第2区域所包含的像素的视差量的变更量的最大值。

193.图16示出在基于第1图像和第2图像而将立体图像显示于监视器5时由观察者视觉识别的被摄体的光学像的位置。省略与图7所示的部分相同的部分的说明。图16示出在第1图像和第2图像中处置器具13映现在图像的中心的右侧的例子。

194.在处理器41变更第1图像的视差量之前,观察者的视点与处置器具13的光学像13a的一部分之间的距离小于a4。在处理器41变更了第1图像的视差量之后,观察者的视点与处置器具13的光学像13b之间的距离的最小值成为a4。在观察者的视点侧大幅突出的处置器具13的光学像13a的区域显示在从观察者的视点向里侧离开了距离a4的位置。

195.在图16所示的例子中,与距离a4对应的视差量的规定量b4为正值。因此,处置器具13的光学像13b位于屏幕面sc的里侧。规定量b4也可以为负值。在该情况下,光学像13b的至少一部分位于屏幕面sc的近前侧。规定量b4也可以为0。在该情况下,光学像13b的至少一部分位于包含交叉点cp的平面(屏幕面sc)内。

196.在执行步骤s110a之前,表示距离a4的信息也可以存储于图3中未示出的存储器。处理器41也可以在步骤s110a中从存储器读出该信息。处理器41也可以从与内窥镜装置1不同的装置取得该信息。

197.观察者也能够指定距离a4。例如,观察者也可以对操作部22进行操作,输入距离a4。处理器41也可以使用输入到操作部22的距离a4。

198.在处理器41变更了处理区域的视差量之后,处置器具13的光学像在立体图像中显示在从观察者的视点向里侧离开了距离a4以上的位置。因此,图像处理装置4能够在不损害器具的使用容易度的情况下减轻器具的图像使观察者的眼睛产生的疲劳。

199.未变更视差量的区域中的处置器具13的光学像不移动。在该区域中维持了相对的深度的信息。其结果是,观察者容易操作处置器具13。

200.(第2实施方式的第1变形例)

201.对本发明的第2实施方式的第1变形例进行说明。说明以观察者的视点与处置器具13的光学像之间的距离成为规定值以上的方式变更处理区域的视差量的其他方法。

202.在执行步骤s110a之前,表示视差量的变更量的视差信息存储于图3中未示出的存储器。图17示出视差信息的例子。在图17中,视差信息通过曲线图而示出。视差信息示出第1视差量与第2视差量之间的关系。第1视差量是在处理器41变更视差量之前各像素所具有的视差量。第2视差量是在处理器41变更了视差量之后各像素所具有的视差量。在第1视差量为a4a以上的情况下,第1视差量与第2视差量相同。在第1视差量小于a4a的情况下,第2视差量与第1视差量不同。在第1视差量小于a4a的情况下,第2视差量为b4以上。

203.图17所示的第2视差量b4为正值。因此,处置器具13的光学像显示在屏幕面的里侧。第2视差量b4也可以为负值。

204.处理器41在步骤s110a中从存储器读出视差信息。处理器41基于视差信息来变更第1图像所包含的各像素的视差量。处理器41对第1图像所包含的全部像素执行该处理。处理器41也可以基于视差信息来变更第2图像所包含的各像素的视差量。处理器41也可以从与内窥镜装置1不同的装置取得视差信息。

205.例如,在图17所示的第1视差量小于a4a的区域,曲线图以曲线示出。在该情况下,与在第2实施方式中说明的方法相比,观察者不容易对图像感觉到不适感。

206.(第2实施方式的第2变形例)

207.对本发明的第2实施方式的第2变形例进行说明。在图像处理步骤之前,处理器41在区域设定步骤中基于图像生成装置的种类和器具的种类中的至少一方来设定处理区域。图像生成装置是具有生成第1图像和第2图像的摄像元件12的装置。在图1所示的例子中,图像生成装置是电子内窥镜2。

208.处理器41设定处理区域的方法与在第1实施方式的第4变形例中说明的方法相同。处理器41以观察者的视点与处置器具13的光学像之间的距离成为规定值以上的方式变更处理区域的视差量。

209.处理器41能够设定适合于电子内窥镜2的种类和处置器具13的种类的处理区域。因此,处理区域变小,变更视差量的处理中的处理器41的负荷减少。

210.(第3实施方式)

211.对本发明的第3实施方式进行说明。在图像处理步骤之前,处理器41在器具检测步骤中从第1图像和第2图像中的至少一方检测处置器具13。在图像处理步骤之前,处理器41在区域设定步骤中将检测到处置器具13的区域设定为处理区域。

212.参照图18来说明处理器41所执行的处理。图18示出处理器41所执行的处理的步骤。省略与图8所示的处理相同的处理的说明。

213.处理器41不执行图8所示的步骤s100。在步骤s105之后,处理器41从第1图像和第2图像中的至少一方检测处置器具13(步骤s120(器具检测步骤))。在步骤s120之后,处理器41将检测到处置器具13的区域设定为处理区域(步骤s100a(区域设定步骤))。在步骤s100a之后,执行步骤s110。

214.在执行步骤s120之前,处置器具13的2个以上的图像存储于图3中未示出的存储器。处置器具13以各种角度映现在各图像中。观察者也可以在过去由摄像元件12生成的图像中指定映现出处置器具13的区域。该区域的图像也可以存储在存储器中。

215.处理器41在步骤s120中从存储器读出处置器具13的各图像。处理器41对照第1图像与处置器具13的各图像。或者,处理器41对照第2图像与处置器具13的各图像。由此,处理器41确定在第1图像或第2图像中映现出处置器具13的区域。处理器41在步骤s100a中,仅将映现出处置器具13的区域设定为处理区域。

216.处理器41能够通过使用在第1实施方式及其各种变形例中说明的方法来执行步骤s110。或者,处理器41能够通过使用在第2实施方式及其各种变形例中说明的方法来执行步骤s110。

217.处理器41将映现出处置器具13的区域设定为处理区域,并且变更该区域的视差量。处理器41不将未映现出处置器具13的区域设定为处理区域,并且不变更该区域的视差量。因此,观察者不容易对立体图像中未映现出处置器具13的区域感觉到不适感。

218.(第3实施方式的第1变形例)

219.对本发明的第3实施方式的第1变形例进行说明。处理器41在器具检测步骤中从第1图像和第2图像中的至少一方检测处置器具13。处理器41在区域设定步骤中在检测到处置器具13的区域检测包含处置器具13的前端的前端区域。处理器41将从检测到处置器具13的区域去掉前端区域后的区域设定为处理区域。

220.处理器41通过使用上述的方法,在步骤s120中,确定在第1图像或第2图像中映现出处置器具13的区域。此外,处理器41在该区域中检测包含处置器具13的前端的前端区域。例如,前端区域是处置器具13的前端与从该前端朝向根部离开了规定的距离的位置之间的区域。前端区域也可以是仅包含钳子130的区域。处理器41将从映现出处置器具13的区域去掉前端区域后的区域设定为处理区域。处理区域也可以为仅包含护套131的区域。

221.在第1图像或第2图像中不变更处置器具13的前端侧的区域的视差量。因此,在该区域维持了相对的深度的信息。其结果是,观察者容易操作处置器具13。

222.(第3实施方式的第2变形例)

223.对本发明的第3实施方式的第2变形例进行说明。处理器41在区域设定步骤中基于图像生成装置的种类和器具的种类中的至少一方来设定处理区域。图像生成装置是具有生成第1图像和第2图像的摄像元件12的装置。在图1所示的例子中,图像生成装置是电子内窥镜2。

224.处理器41不执行步骤s120。处理器41在步骤s100a中基于将电子内窥镜2的种类、处置器具13的种类以及处理区域的位置关联起来的区域信息来设定处理区域。处理区域是从处置器具13的整体去掉包含处置器具13的前端的前端区域后的区域。处理区域也可以为仅包含护套131的区域。处理器41设定处理区域的方法与在第1实施方式的第4变形例中说明的方法相同。

225.处理器41无需从第1图像或第2图像中检测处置器具13。因此,与处理器41执行用于检测处置器具13的图像处理的情况相比,处理器41的负荷减少。

226.(第3实施方式的第3变形例)

227.对本发明的第3实施方式的第3变形例进行说明。处理器41在器具检测步骤中从第1图像和第2图像中的至少一方检测去掉包含处置器具13的前端的前端区域后的处置器具13的区域。处理器41在区域设定步骤中将检测到的区域设定为处理区域。

228.例如,除掉了处置器具13的前端区域而得到的处置器具13的部分具有规定的颜

色。规定的颜色与脏器或血管等这样的被摄体的颜色不同,并且与观察对象的颜色不同。例如,护套131的包含根部的部分具有规定的颜色。护套131的整体也可以具有规定的颜色。处理器41在步骤s120中在第1图像和第2图像中的至少一方检测具有规定的颜色的区域。处理器41在步骤s100a中将检测到的区域设定为处理区域。

229.也可以对去掉处置器具13的前端区域后的处置器具13的部分附加标记。标记的形状可以是任意形状。标记也可以是文字或记号等。也可以附加2个以上的标记。处理器41也可以在第1图像和第2图像中的至少一方检测标记,并且将包含检测到的标记的区域设定为处理区域。

230.也可以对去掉处置器具13的前端区域后的处置器具13的部分附加规定的花纹。处置器具13也可以具有包含根部且附加花纹的部分和未附加花纹的部分。处置器具13也可以具有包含根部且附加第1花纹的部分、和附加与第1花纹不同的第2花纹的部分。附加花纹的部分也可以是护套131的整体或一部分。处理器41也可以在第1图像和第2图像中的至少一方检测规定的花纹,并且将包含检测到的花纹的区域设定为处理区域。

231.去掉处置器具13的前端区域后的处置器具13的部分构成为能够与处置器具13的其他部分区分。因此,处理器41检测设定为处理区域的处置器具13的区域的精度提高。

232.(第4实施方式)

233.对本发明的第4实施方式进行说明。处理器41判断根据观察的状况而不同的第1区域的位置。

234.例如,在图像处理步骤之前,处理器41在区域设定步骤中基于生成第1图像和第2图像的图像生成装置的种类来判断第1区域的位置。处理器41将去掉第1区域后的区域设定为处理区域。图像生成装置是具有生成第1图像和第2图像的摄像元件12的装置。在图1所示的例子中,图像生成装置是电子内窥镜2。

235.观察对象的位置有时根据作为被摄体的部位而不同。部位的种类与能够插入到该部位的电子内窥镜2的种类大多被固定。因此,观察对象的位置大多根据电子内窥镜2的种类而不同。

236.参照图19来说明处理器41所执行的处理。图19示出处理器41所执行的处理的步骤。省略与图8所示的处理相同的处理的说明。

237.处理器41不执行图8所示的步骤s100。处理器41判断第1区域的位置,并且将去掉第1区域后的区域设定为处理区域(步骤s125(区域设定步骤))。在步骤s125之后,执行步骤s105。步骤s125和步骤s105被执行的顺序也可以与图8所示的顺序不同。即,也可以在执行步骤s105之后执行步骤s125。

238.详细说明步骤s125。在执行步骤s125之前,将电子内窥镜2的种类与第1区域的位置关联起来的区域信息被存储于图3中未示出的存储器。处理器41在步骤s125中从存储器读出区域信息。处理器41也可以从与内窥镜装置1不同的装置取得区域信息。

239.图20示出区域信息的例子。区域信息包含信息e1和信息e4。信息e1表示电子内窥镜2的种类。信息e4表示第1区域的位置。信息e4也可以包含表示第1区域的大小和形状中的至少一方的信息。在第1区域的大小始终被固定的情况下,信息e4也可以不包含表示第1区域的大小的信息。在第1区域的形状始终被固定的情况下,信息e4也可以不包含表示第1区域的形状的信息。

240.在图20所示的例子中,电子内窥镜f1和第1区域i1被关联起来。在图20所示的例子中,电子内窥镜f2和第1区域i2被关联起来。在图20所示的例子中,电子内窥镜f3和第1区域i3被关联起来。

241.处理器41通过使用在第1实施方式的第4变形例中说明的方法来判断所使用的电子内窥镜2的种类。处理器41从区域信息提取与所使用的电子内窥镜2对应的第1区域的信息。例如,在使用电子内窥镜f2的情况下,处理器41提取第1区域i2的信息。处理器41将提取出的信息所示的位置看作是第1区域的位置,并且将去掉第1区域后的区域设定为处理区域。

242.处理器41能够通过使用在第1实施方式及其各种变形例中说明的方法来执行步骤s110。或者,处理器41能够通过使用在第2实施方式及其各种变形例中说明的方法来执行步骤s110。

243.处理器41能够基于根据电子内窥镜2的种类而不同的第1区域的位置,将处理区域设定到适当的位置。

244.(第4实施方式的变形例)

245.对本发明的第4实施方式的变形例进行说明。说明判断第1区域的位置的其他方法。

246.处理器41在区域设定步骤中基于图像生成装置的种类和摄像倍率来判断第1区域的位置。处理器41将去掉第1区域后的区域设定为处理区域。

247.如上所述,观察对象的位置大多根据电子内窥镜2的种类而不同。此外,观察对象的大小根据摄像倍率而不同。当摄像倍率较高时,观察对象较大地映现在图像中。当摄像倍率较低时,观察对象较小地映现在图像中。

248.例如,在执行步骤s125之前,将电子内窥镜2的种类、摄像倍率以及第1区域的位置关联起来的区域信息被存储于图3中未示出的存储器。处理器41在步骤s125中从存储器读出区域信息。处理器41也可以从与内窥镜装置1不同的装置取得区域信息。

249.图21示出区域信息的例子。区域信息包含信息e1、信息e5以及信息e4。信息e1表示电子内窥镜2的种类。信息e5表示摄像倍率。信息e4表示第1区域的位置。例如,信息e4包含表示根据摄像倍率而不同的第1区域的外周的位置的信息。信息e4也可以包含表示第1区域的形状的信息。在第1区域的形状始终被固定的情况下,信息e4也可以不包含表示第1区域的形状的信息。

250.在图21所示的例子中,电子内窥镜f1、摄像倍率j1以及第1区域i4被关联起来。在图21所示的例子中,电子内窥镜f1、摄像倍率j2以及第1区域i5被关联起来。在图21所示的例子中,电子内窥镜f2、摄像倍率j1以及第1区域i6被关联起来。在图21所示的例子中,电子内窥镜f2、摄像倍率j2以及第1区域i7被关联起来。

251.区域信息除了包含图21所示的信息之外,也可以包含表示处置器具13的种类的信息。区域信息也可以不包含表示电子内窥镜2的种类的信息而包含表示处置器具13的种类的信息和摄像倍率。处理器41在区域设定步骤中,也可以基于图像生成装置的种类、器具的种类以及摄像倍率中的至少一方来判断第1区域的位置。处理器41也可以仅基于图像生成装置的种类、器具的种类以及摄像倍率中的任意一方来判断第1区域的位置。处理器41也可以基于图像生成装置的种类、器具的种类以及摄像倍率中的任意2个的组合来判断第1区域

的位置。处理器41也可以基于图像生成装置的种类、器具的种类以及摄像倍率中的全部来判断第1区域的位置。

252.在第1实施方式的第4变形例或第2实施方式的第2变形例中,处理器41在区域设定步骤中也可以基于图像生成装置的种类、器具的种类以及摄像倍率中的至少一方来设定处理区域。处理器41也可以仅基于图像生成装置的种类、器具的种类以及摄像倍率中的任意一方来设定处理区域。处理器41也可以基于图像生成装置的种类、器具的种类以及摄像倍率中的任意2个的组合来设定处理区域。处理器41也可以基于图像生成装置的种类、器具的种类以及摄像倍率中的全部来设定处理区域。

253.处理器41通过使用在第1实施方式的第4变形例中说明的方法来判断所使用的电子内窥镜2的种类。此外,处理器41从摄像元件12取得所使用的摄像倍率的信息。

254.处理器41从区域信息提取与所使用的电子内窥镜2和摄像倍率对应的第1区域的信息。例如,在使用电子内窥镜f2和摄像倍率j1的情况下,处理器41提取第1区域i6的信息。处理器41将提取出的信息所示的位置看作是第1区域的位置,并且将去掉第1区域后的区域设定为处理区域。

255.处理器41能够基于根据电子内窥镜2的种类和摄像倍率而不同的第1区域的位置,将处理区域设定为适当的位置。

256.(第5实施方式)

257.对本发明的第5实施方式进行说明。说明基于第1区域的位置来设定处理区域的其他方法。

258.在图像处理步骤之前,处理器41在观察对象检测步骤中,从第1图像和第2图像中的至少一方检测观察对象。在图像处理步骤之前,处理器41在区域设定步骤中,将检测到观察对象的区域看作是第1区域,并且将去掉第1区域后的区域设定为处理区域。

259.参照图22对处理器41所执行的处理进行说明。图22示出处理器41所执行的处理的步骤。省略与图8所示的处理相同的处理的说明。

260.处理器41不执行图8所示的步骤s100。在步骤s105之后,处理器41从第1图像和第2图像中的至少一方检测观察对象(步骤s130(观察对象检测步骤))。详细说明步骤s130。处理器41计算第1图像所包含的各像素的视差量。处理器41对第1图像所包含的全部像素执行该处理。例如,处理器41通过使用立体匹配来计算各像素的视差量。

261.处理器41基于各像素的视差量来检测映现出观察对象的像素。例如,在观察对象为凸部或凹部的情况下,映现出观察对象的像素的视差量与映现出观察对象的周边的被摄体的像素的视差量不同。处理器41基于第1图像所包含的全部像素的视差量的分布来检测映现出观察对象的像素。处理器41也可以基于仅包含在第1图像的去掉周边部后的区域中的像素的视差量的分布来检测映现出观察对象的像素。

262.处理器41将包含检测到的像素的区域看作是第1区域。例如,第1区域包含映现出观察对象的区域和其周边的区域。例如,观察对象的周边的区域包含位于从观察对象的外周起规定的距离以内的像素。

263.处理器41也可以基于上述的视差量的分布来检测映现出处置器具13的像素。映现出处置器具13的像素的视差量与映现出处置器具13的周边的被摄体的像素的视差量不同。由于处置器具13位于观察对象的近前,因此,映现出处置器具13的像素的视差量与映现出

观察对象的周边的被摄体的像素的视差量之差较大。因此,处理器41能够区分观察对象与处置器具13。处理器41也可以从第1区域去掉映现出处置器具13的像素。

264.当处置器具13没有从前端部10的端面突出时,处置器具13没有映现在第1图像和第2图像中。此时,处理器41也可以从第1图像中检测观察对象。处理器41也可以通过执行与上述的处理同样的处理,从第2图像中检测观察对象。

265.在步骤s130之后,处理器41将去掉第1区域后的区域设定为处理区域(步骤s100b(区域设定步骤))。在步骤s100b之后,执行步骤s110。

266.处理器41能够通过使用在第1实施方式及其各种变形例中说明的方法来执行步骤s110。或者,处理器41能够通过使用在第2实施方式及其各种变形例中说明的方法来执行步骤s110。

267.处理器41检测观察对象,并且基于观察对象的位置来设定处理区域。处理器41能够设定适合于观察对象的处理区域。

268.(第5实施方式的第1变形例)

269.对本发明的第5实施方式的第1变形例进行说明。说明检测观察对象的其他方法。

270.处理器41在观察对象检测步骤中生成第1图像所包含的全部像素的颜色的分布。观察对象的色调大多与观察对象的周边的被摄体的色调不同。处理器41基于所生成的分布来检测映现出观察对象的像素。处理器41也可以基于仅包含在第1图像的去掉周边部后的区域中的像素的颜色的分布,来检测映现出观察对象的像素。

271.处理器41也可以基于上述的颜色的分布来检测映现出处置器具13的像素。在处置器具13具有与观察对象的颜色不同的规定的颜色的情况下,处理器41能够区分观察对象与处置器具13。处理器41也可以从第1区域去掉映现出处置器具13的像素。处理器41也可以通过执行与上述的处理同样的处理,从第2图像中检测观察对象。

272.处理器41基于图像中的颜色的信息来检测观察对象。与处理器41基于视差量的分布来检测观察对象的情况相比,检测观察对象的处理中的处理器41的负荷减少。处理器41能够从第1区域去掉映现出处置器具13的像素。

273.(第5实施方式的第2变形例)

274.对本发明的第5实施方式的第1变形例进行说明。说明检测观察对象的其他方法。

275.内窥镜装置1具有特殊光观察的功能。内窥镜装置1向生物体的粘膜组织照射包含规定窄幅的波长的波段的光(窄带光)。内窥镜装置1得到在生物体组织中位于所希望的深度的组织的信息。例如,在特殊光观察中观察对象为癌组织的情况下,向粘膜组织照射适合于组织表层的观察的蓝色的窄带光。此时,内窥镜装置1能够详细观察组织表层的微细血管。

276.在执行步骤s105之前,光源装置3的光源产生蓝色的窄带光。例如,蓝色的窄带的中心波长为405nm。摄像元件12拍摄被照射窄带光的被摄体,生成第1图像和第2图像。处理器41在步骤s105中,从摄像元件12取得第1图像和第2图像。在执行步骤s105之后,光源装置3也可以产生白色光。

277.在执行步骤s130之前,表示作为观察对象的患部的血管图案的图案信息被存储于图3中未示出的存储器。处理器41在步骤s130中从存储器读出图案信息。处理器41也可以从与内窥镜装置1不同的装置取得图案信息。

278.当癌症发症时,在患部的微细血管等中产生在健康部位看不到的特有的血管。由于癌症而生成的血管的形状具有与癌症的进展程度相应的特有的图案。图案信息表示这样的图案。

279.处理器41在步骤s130中从第1图像中检测具有与图案信息所示的图案相似的图案的区域。处理器41将检测到的区域看作是观察对象。处理器41也可以通过执行与上述的处理同样的处理,从第2图像中检测观察对象。

280.处理器41基于患部的血管图案来检测观察对象。因此,处理器41能够高精度地检测观察对象。

281.(第6实施方式)

282.对本发明的第6实施方式进行说明。说明基于第1区域的位置来设定处理区域的其他方法。在图像处理步骤之前,处理器41在区域设定步骤中,基于由观察者输入到操作部22的信息来判断第1区域的位置,并且将去掉第1区域后的区域设定为处理区域。

283.参照上述的图19来说明处理器41所执行的处理。省略与图8所示的处理相同的处理的说明。

284.观察者对操作部22进行操作,输入第1区域的位置。观察者除了输入第1区域的位置之外也可以输入第1区域的大小或形状。在第1区域的位置被固定的情况下,观察者也可以仅输入第1区域的大小或形状。观察者也可以通过对操作部22以外的部分进行操作来输入需要的信息。例如,在内窥镜装置1具有触摸屏幕的情况下,观察者也可以操作该触摸屏幕。在图像处理装置4具有操作部的情况下,观察者也可以操作该操作部。

285.处理器41在步骤s125中基于输入到操作部22的信息来判断第1区域的位置。在观察者输入了第1区域的位置的情况下,处理器41将输入的位置看作是第1区域的位置。在第1区域的大小和形状被固定的情况下,处理器41能够判断为第1区域位于由观察者指定的位置。

286.在观察者输入了第1区域的位置和大小的情况下,处理器41将输入的位置看作是第1区域的位置,并且将输入的大小看作是第1区域的大小。在第1区域的形状被固定的情况下,处理器41能够判断为第1区域位于由观察者指定的位置并且具有由观察者指定的大小。

287.在观察者输入了第1区域的位置和形状的情况下,处理器41将输入的位置看作是第1区域的位置,并且将输入的形状看作是第1区域的形状。在第1区域的大小被固定的情况下,处理器41能够判断为第1区域位于由观察者指定的位置并且具有由观察者指定的形状。

288.处理器41通过使用上述的方法来判断第1区域的位置。处理器41将去掉第1区域后的区域设定为处理区域。

289.处理器41在步骤s125中,也可以基于输入到操作部22的信息来判断第1区域的大小。例如也可以是,观察者仅输入第1区域的大小,处理器41将输入的大小看作是第1区域的大小。在第1区域的位置和形状被固定的情况下,处理器41能够判断为第1区域具有由观察者指定的大小。

290.处理器41在步骤s125中,也可以基于输入到操作部22的信息来判断第1区域的形状。例如也可以是,观察者仅输入第1区域的形状,处理器41将输入的形状看作是第1区域的形状。在第1区域的位置和大小被固定的情况下,处理器41能够判断为第1区域具有由观察者指定的形状。

291.观察者能够输入的信息不限于位置、大小以及形状。也可以是,观察者能够输入在上述的说明中为示出的项目。

292.在执行步骤s125之前,处理器41也可以从摄像元件12取得第1图像和第2图像,并且将第1图像和第2图像向监视器5输出。观察者也可以在显示出的立体图像中确认第1区域的位置,并且向操作部22输入该位置。

293.处理器41基于输入到操作部22的信息来判断第1区域的位置,并且基于该位置来设定处理区域。处理器41能够设定适合于观察者的期望或观察的状况的处理区域。处理器41能够以观察者容易实施处置的方式对图像进行处理。

294.(第6实施方式的变形例)

295.对本发明的第6实施方式的变形例进行说明。说明基于由观察者输入到操作部22的信息来判断第1区域的位置的其他方法。

296.观察者对操作部22进行操作,输入各种信息。例如,观察者输入体内的部位、患部的种类、患者的年龄、以及患者的性别。处理器41取得输入到操作部22的信息。

297.例如,在执行步骤s125之前,将体内的部位、患部的种类、患者的年龄、患者的性别以及第1区域的位置关联起来的区域信息被存储于图3中未示出的存储器。处理器41在步骤s125中从存储器读出区域信息。处理器41也可以从与内窥镜装置1不同的装置取得区域信息。

298.图23示出区域信息的例子。区域信息包含信息e6、信息e7、信息e8、信息e9、以及信息e4。信息e6表示包含观察对象的部位。信息e7表示作为观察对象的患部的种类。信息e8表示患者的年龄。信息e9表示患者的性别。信息e4表示第1区域的位置。信息e4也可以包含表示第1区域的大小和形状中的至少一方的信息。在第1区域的大小始终被固定的情况下,信息e4也可以不包含表示第1区域的大小的信息。在第1区域的形状始终被固定的情况下,信息e4也可以不包含表示第1区域的形状的信息。

299.在图23所示的例子中,部位k1、患部的种类l1、患者的年龄m1、患者的性别n1以及第1区域i8被关联起来。在图23所示的例子中,部位k2、患部的种类l2、患者的年龄m2、患者的性别n1以及第1区域i9被关联起来。在图23所示的例子中,部位k3、患部的种类l3、患者的年龄m3、患者的性别n2以及第1区域i10被关联起来。

300.处理器41从区域信息中提取与输入到操作部22的信息对应的第1区域的信息。例如,在将部位k2、患部的种类l2、患者的年龄m2以及患者的性别n1输入到操作部22的情况下,处理器41提取第1区域i9的信息。处理器41基于提取出的信息来判断第1区域的位置。处理器41将去掉第1区域后的区域设定为处理区域。

301.观察者能够输入的信息不限于图23所示的信息。也可以是,观察者能够输入在上述的说明中未示出的项目。

302.处理器41基于输入到操作部22的各种信息来判断第1区域的位置,并且基于该位置来设定处理区域。处理器41能够设定适合于观察的状况的处理区域。即便在观察者不习惯电子内窥镜2的操作的情况下或者在观察者不习惯使用处置器具13的处置的情况下,处理器41也能够以观察者容易实施处置的方式对图像进行处理。

303.(第7实施方式)

304.对本发明的第7实施方式进行说明。第7实施方式的图像处理装置4具有2个图像处

理模式。图像处理装置4以疲劳减轻模式(第1模式)和通常模式(第2模式)中的任意一方进行动作。处理器41在模式选择步骤中选择疲劳减轻模式和通常模式中的一方。在以下的例子中,处理器41基于由观察者输入到操作部22的信息来选择疲劳减轻模式和通常模式中的一方。

305.参照图24来说明处理器41所执行的处理。图24示出处理器41所执行的处理的步骤。省略与图8所示的处理相同的处理的说明。例如,当内窥镜装置1的电源接通时,处理器41执行图24所示的处理。

306.处理器41选择通常模式(步骤s140(模式选择步骤))。表示通常模式的信息被存储于图3中未示出的存储器。处理器41按照该信息来执行在通常模式中规定的处理。

307.在步骤s140之后,处理器41从摄像元件12取得第1图像和第2图像(步骤s145(图像取得步骤))。

308.在步骤s145之后,处理器41将在步骤s145中取得的第1图像和第2图像向监视器5输出(步骤s150(第2图像输出步骤))。处理器41也可以将第1图像和第2图像向图4所示的接收装置6输出。在处理器41在步骤s140中选择了通常模式的情况下,执行步骤s145和步骤s150。处理器41不变更处理区域的视差量。

309.步骤s140和步骤s145被执行的顺序也可以与图24所示的顺序不同。即,也可以在执行步骤s145之后执行步骤s140。

310.观察者能够通过对操作部22进行操作而输入表示图像处理模式的变更的信息。例如,当将插入部21插入到体内并将前端部10配置于观察对象的附近时,观察者为了开始处置而向操作部22输入表示图像处理模式的变更的信息。操作部22将输入的信息向处理器41输出。

311.在步骤s150之后,处理器41监视操作部22,并且判断是否指示了图像处理模式的变更(步骤s155)。在表示图像处理模式的变更的信息被输入到操作部22的情况下,处理器41判断为指示了图像处理模式的变更。在表示图像处理模式的变更的信息没有被输入到操作部22的情况下,处理器41判断为没有指示图像处理模式的变更。

312.在处理器41在步骤s155中判断为没有指示图像处理模式的变更的情况下,执行步骤s145。在处理器41在步骤s155中判断为指示了图像处理模式的变更的情况下,处理器41选择疲劳减轻模式(步骤s160(模式选择步骤))。表示疲劳减轻模式的信息被存储于图3中未示出的存储器。处理器41按照该信息,执行在疲劳减轻模式中规定的处理。在步骤s160之后,执行步骤s100。在处理器41在步骤s160中选择了疲劳减轻模式的情况下,执行步骤s100、步骤s105、步骤s110以及步骤s115。

313.步骤s160、步骤s100以及步骤s105被执行的顺序也可以与图24所示的顺序不同。即,也可以在执行步骤s105之后执行步骤s160和步骤s100。

314.例如,当使用处置器具13的处置结束时,观察者为了拉拔插入部21而向操作部22输入表示图像处理模式的变更的信息。操作部22将输入的信息向处理器41输出。

315.在步骤s115之后,处理器41监视操作部22,并且判断是否指示了图像处理模式的变更(步骤s165)。步骤s165与步骤s155相同。

316.在处理器41在步骤s165中判断为没有指示图像处理模式的变更的情况下,执行步骤s105。在处理器41在步骤s165中判断为指示了图像处理模式的变更的情况下,执行步骤

s140。处理器41在步骤s140中选择通常模式。

317.在上述的例子中,观察者通过对操作部22进行操作,向图像处理装置4指示图像处理模式的变更。观察者也可以通过使用与上述的方法不同的方法,向图像处理装置4指示图像处理模式的变更。例如,观察者也可以通过使用声音输入,向图像处理装置4指示图像处理模式的变更。

318.图24所示的步骤s100、步骤s105以及步骤s110也可以置换为图15所示的步骤s105和步骤s110a。图24所示的步骤s100和步骤s105也可以置换为图18所示的步骤s105、步骤s120以及步骤s100a。图24所示的步骤s100也可以置换为图19所示的步骤s125。图24所示的步骤s100和步骤s105也可以置换为图22所示的步骤s105、步骤s130以及步骤s100b。

319.在处理器41选择了疲劳减轻模式的情况下,处理器41执行处理区域的视差量的变更。因此,减轻了观察者的眼睛所产生的疲劳。在处理器41选择了通常模式的情况下,处理器41不执行处理区域的视差量的变更。因此,观察者能够将习惯观看的图像用于观察。仅在需要变更处理区域的视差量时,处理器41变更处理区域的视差量。因此,处理器41的负荷减少。

320.(第7实施方式的第1变形例)

321.对本发明的第7实施方式的第1变形例进行说明。处理器41在模式选择步骤中,自动地选择疲劳减轻模式和通常模式中的一方。

322.内窥镜装置1具有2个显示模式。内窥镜装置1以3d显示模式和2d显示模式中的一方显示图像。3d显示模式是将立体图像(三维图像)显示于监视器5的模式。2d显示模式是将二维图像显示于监视器5的模式。在内窥镜装置1以3d显示模式进行动作的情况下,处理器41选择疲劳减轻模式。在内窥镜装置1以2d显示模式进行动作的情况下,处理器41选择通常模式。

323.参照图25来说明处理器41所执行的处理。图25示出处理器41所执行的处理的步骤。省略与图24所示的处理相同的处理的说明。例如,当内窥镜装置1的电源接通时,处理器41执行图25所示的处理。此时,内窥镜装置1以2d显示模式开始进行动作。

324.在步骤s145之后,处理器41将在步骤s145中取得的第1图像向监视器5输出(步骤s150a)。监视器5显示第1图像。

325.处理器41也可以在步骤s150a中将第2图像向监视器5输出。在该情况下,监视器5显示第2图像。处理器41也可以在步骤s150a中将第1图像和第2图像向监视器5输出。在该情况下,例如监视器5沿横向或纵向并排地显示第1图像和第2图像。

326.在摄像元件12依次输出第1图像和第2图像的情况下,处理器41也可以在步骤s145中取得第1图像,并且在步骤s150a中将第1图像向监视器5输出。或者,处理器41也可以在步骤s145中取得第2图像,并且在步骤s150a中将第2图像向监视器5输出。

327.观察者能够通过对操作部22进行操作而输入表示显示模式的变更的信息。例如,在将插入部21插入到体内并将前端部10配置于观察对象的附近时,观察者为了开始进行使用立体图像的观察而向操作部22输入表示显示模式的变更的信息。操作部22将输入的信息向处理器41输出。

328.在步骤s150a之后,处理器41判断显示模式是否变更为3d模式(步骤s155a)。在表示显示模式的变更的信息被输入到操作部22的情况下,处理器41判断为显示模式变更为3d

模式。在表示显示模式的变更的信息没有被输入到操作部22的情况下,处理器41判断为显示模式没有变更为3d模式。

329.在处理器41在步骤s155a中判断为显示模式没有变更为3d模式的情况下,执行步骤s145。在处理器41在步骤s155a中判断为显示模式变更为3d模式的情况下,执行步骤s160。

330.例如,在使用处置器具13的处置结束时,观察者为了开始进行使用二维图像的观察而向操作部22输入表示显示模式的变更的信息。操作部22将输入的信息向处理器41输出。

331.在步骤s115之后,处理器41判断显示模式是否变更为2d模式(步骤s165a)。在表示显示模式的变更的信息被输入到操作部22的情况下,处理器41判断为显示模式变更为2d模式。在表示显示模式的变更的信息没有被输入到操作部22的情况下,处理器41判断为显示模式没有变更为2d模式。

332.在处理器41在步骤s165a中判断为显示模式没有变更为2d模式的情况下,执行步骤s105。在处理器41在步骤s165a中判断为显示模式变更为2d模式的情况下,执行步骤s140。

333.在上述的例子中,观察者通过对操作部22进行操作而向内窥镜装置1指示显示模式的变更。观察者也可以通过使用与上述的方法不同的方法向内窥镜装置1指示显示模式的变更。例如,观察者也可以通过使用声音输入向内窥镜装置1指示显示模式的变更。

334.图25所示的步骤s100、步骤s105以及步骤s110也可以置换为图15所示的步骤s105和步骤s110a。图25所示的步骤s100和步骤s105也可以置换为图18所示的步骤s105、步骤s120以及步骤s100a。图25所示的步骤s100也可以置换为图19所示的步骤s125。图25所示的步骤s100和步骤s105也可以置换为图22所示的步骤s105、步骤s130以及步骤s100b。

335.处理器41基于显示模式的设定,来选择疲劳减轻模式和通常模式中的一方。因此,处理器41能够在适当的定时切换图像处理模式。

336.(第7实施方式的第2变形例)

337.对本发明的第7实施方式的第2变形例进行说明。说明切换疲劳减轻模式和通常模式的其他方法。

338.处理器41在第1运动检测步骤中检测摄像元件12的运动的状态。处理器41在模式选择步骤中基于摄像元件12的运动的状态来选择疲劳减轻模式和通常模式中的一方。

339.在选择了通常模式的情况下,观察者能够观察习惯观看的图像。观察者在使用使眼睛疲劳的处置器具13实施处置时,需要疲劳减轻模式。仅在需要疲劳减轻模式时,处理器41选择疲劳减轻模式。当插入部21被固定在体内时,观察者使用处置器具13实施处置的可能性高。当插入部21被固定在体内时,摄像元件12相对于被摄体相对地静止。当摄像元件12静止时,处理器41将图像处理模式从通常模式切换为疲劳减轻模式。

340.在使用处置器具13的处置完成之后,观察者拉拔插入部21的可能性高。因此,插入部21在体内移动的可能性高。当插入部21在体内移动时,摄像元件12相对于被摄体相对地移动。当摄像元件12开始了移动时,处理器41将图像处理模式从疲劳减轻模式切换为通常模式。

341.参照图26来说明处理器41所执行的处理。图26示出处理器41所执行的处理的步

骤。省略与图24所示的处理相同的处理的说明。

342.在步骤s145之后,处理器41检测摄像元件12的运动的状态(步骤s170(第1运动检测步骤))。详细说明步骤s170。例如,处理器41计算连续的2帧的第1图像或第2图像之间的运动量。该运动量表示摄像元件12的运动的状态。在摄像元件12运动的情况下,该运动量较大。在摄像元件12静止的情况下,该运动量较小。处理器41也可以计算规定时间内的运动量的合计。在步骤s170之后,执行步骤s150。

343.步骤s170和步骤s150被执行的顺序也可以与图26所示的顺序不同。即,也可以在执行步骤s150之后执行步骤s170。

344.在步骤s150之后,处理器41判断摄像元件12是否静止(步骤s175)。在步骤s170中计算出的运动量小于规定量的情况下,处理器41判断为摄像元件12静止。在该情况下,实施使用处置器具13的处置的可能性高。在步骤s170中计算出的运动量为规定量以上的情况下,处理器41判断为摄像元件12运动。在该情况下,未实施使用处置器具13的处置的可能性高。例如,规定量是能够区分摄像元件12静止的状态与摄像元件12运动的状态的较小的正值。也可以仅在在步骤s170中计算出的运动量为规定量以上的状态持续了规定时间以上的情况下,处理器41判断为摄像元件12静止。

345.在处理器41在步骤s175中判断为摄像元件12运动的情况下,执行步骤s145。在处理器41在步骤s175中判断为摄像元件12静止的情况下,执行步骤s160。

346.在步骤s105之后,处理器41检测摄像元件12的运动的状态(步骤s180(第1运动检测步骤))。步骤s180与步骤s170相同。在步骤s180之后,执行步骤s110。

347.步骤s180和步骤s110被执行的顺序也可以与图26所示的顺序不同。即,也可以在执行步骤s110之后执行步骤s180。步骤s180和步骤s115被执行的顺序也可以与图26所示的顺序不同。即,也可以在执行步骤s115之后执行步骤s180。

348.在步骤s115之后,处理器41判断摄像元件12是否运动(步骤s185)。在步骤s180中计算出的运动量大于规定量的情况下,处理器41判断为摄像元件12运动。在该情况下,未实施使用处置器具13的处置的可能性高。在步骤s180中计算出的运动量为规定量以下的情况下,处理器41判断为摄像元件12静止。在该情况下,实施使用处置器具13的处置的可能性高。例如,在步骤s185中使用的规定量与在步骤s175中使用的规定量相同。

349.在处理器41在步骤s185中判断为摄像元件12静止的情况下,执行步骤s105。在处理器41在步骤s185中判断为摄像元件12运动的情况下,执行步骤s140。

350.在上述的例子中,处理器41基于第1图像和第2图像中的至少一方来检测摄像元件12的运动的状态。处理器41也可以通过使用与上述的方法不同的方法来检测摄像元件12的运动的状态。例如,也可以将检测前端部10的加速度的加速度传感器配置于前端部10的内部。处理器41也可以基于由加速度传感器检测到的加速度来检测摄像元件12的运动的状态。插入部21有时从配置在患者的嘴中的接口管(mouthpiece)向体内插入。也可以在供插入部21插入的接口管等中配置检测插入部21的运动的编码器。处理器41也可以基于由编码器检测到的插入部21的运动来检测摄像元件12的运动的状态。

351.图26所示的步骤s100、步骤s105以及步骤s110也可以置换为图15所示的步骤s105和步骤s110a。图26所示的步骤s100和步骤s105也可以置换为图18所示的步骤s105、步骤s120以及步骤s100a。图26所示的步骤s100也可以置换为图19所示的步骤s125。图26所示的

步骤s100和步骤s105也可以置换为图22所示的步骤s105、步骤s130以及步骤s100b。

352.处理器41基于摄像元件12的运动的状态来选择疲劳减轻模式和通常模式中的一方。因此,处理器41能够在适当的定时切换图像处理模式。

353.(第7实施方式的第3变形例)

354.对本发明的第7实施方式的第3变形例进行说明。说明切换疲劳减轻模式和通常模式的其他方法。

355.处理器41在搜索步骤中,在第1图像和第2图像中的至少一方搜索处置器具13。在处理器41在搜索步骤中从第1图像和第2图像中的至少一方检测到了处置器具13的情况下,处理器41在模式选择步骤中选择疲劳减轻模式。在处理器41在搜索步骤中无法从第1图像和第2图像中的至少一方检测到处置器具13的情况下,处理器41在模式选择步骤中选择通常模式。

356.在通过处置器具13实施处置时,插入部21有时需要移动。因此,即便在摄像元件12运动的情况下,也可能持续实施处置。处理器41根据处置器具13是否映现在第1图像或第2图像中来切换图像处理模式。

357.参照图27来说明处理器41所执行的处理。图27示出处理器41所执行的处理的步骤。省略与图24所示的处理相同的处理的说明。

358.在处置器具13中在包含处置器具13的前端的前端区域附加有标记。标记的形状可以是任意形状。标记也可以是文字或记号等。也可以附加2个以上的标记。

359.在步骤s145之后,处理器41在第1图像和第2图像中的至少一方搜索处置器具13(步骤s190(搜索步骤))。例如,处理器41在步骤s190中,在第1图像中搜索附加于处置器具13的标记。处理器41也可以在第2图像中搜索该标记。在步骤s190之后执行步骤s150。

360.步骤s190和步骤s150被执行的顺序也可以与图27所示的顺序不同。即,也可以在执行步骤s150之后执行步骤s190。

361.在步骤s150之后,处理器41判断在图像中是否检测到处置器具13(步骤s195)。例如,在附加于处置器具13的标记映现在第1图像中的情况下,处理器41判断为在图像中检测到处置器具13。在该情况下,准备使用处置器具13的处置或者实施该处置的可能性高。

362.也可以是,在附加于处置器具13的标记映现在第2图像中的情况下,处理器41判断为在图像中检测到处置器具13。也可以是,在该标记映现在第1图像和第2图像中的情况下,处理器41判断为在图像中检测到处置器具13。

363.在附加于处置器具13的标记没有映现在第1图像中的情况下,处理器41判断为在图像中没有检测到处置器具13。在该情况下,未使用处置器具13的可能性高。也可以是,在附加于处置器具13的标记没有映现在第2图像中的情况下,处理器41也可以判断为在图像中没有检测到处置器具13。也可以是,在该标记没有映现在第1图像和第2图像中的情况下,处理器41判断为在图像中没有检测到处置器具13。

364.在处理器41在步骤s195中判断为在图像中没有检测到处置器具13的情况下,执行步骤s145。在处理器41在步骤s195中判断为在图像中检测到处置器具13的情况下,执行步骤s160。

365.在步骤s105之后,处理器41在第1图像和第2图像中的至少一方搜索处置器具13(步骤s200(搜索步骤))。步骤s200与步骤s190相同。在步骤s200之后,执行步骤s110。

366.在步骤s115之后,处理器41判断在图像中是否检测到处置器具13(步骤s205)。步骤s205与步骤s195相同。在使用处置器具13的处置结束之后,观察者大多将处置器具13返回到插入部21内。因此,处置器具13不会映现在图像中。

367.在处理器41在步骤s205中判断为在图像中检测到处置器具13的情况下,执行步骤s105。在该情况下,实施使用处置器具13的处置的可能性高。因此,处理器41继续进行疲劳减轻模式中的处理。在处理器41在步骤s205中判断为在图像中没有检测到处置器具13的情况下,执行步骤s140。在该情况下,使用处置器具13的处置已经结束的可能性高。因此,处理器41在步骤s140中开始进行通常模式中的处理。

368.在上述的例子中,处理器41在第1图像和第2图像中的至少一方搜索附加于处置器具13的标记。处置器具13的前端区域也可以具有规定的颜色。规定的颜色与脏器或血管等这样的被摄体的颜色不同。处理器41也可以在第1图像和第2图像中的至少一方搜索规定的颜色。也可以在处置器具13的前端区域附加有规定的花纹。处理器41也可以在第1图像和第2图像中的至少一方搜索附加于处置器具13的花纹。处理器41也可以在第1图像和第2图像中的至少一方搜索钳子130的形状。

369.图27所示的步骤s100、步骤s105以及步骤s110也可以置换为图15所示的步骤s105和步骤s110a。图27所示的步骤s100和步骤s105也可以置换为图18所示的步骤s105、步骤s120以及步骤s100a。图27所示的步骤s100也可以置换为图19所示的步骤s125。图27所示的步骤s100和步骤s105也可以置换为图22所示的步骤s105、步骤s130以及步骤s100b。

370.处理器41基于第1图像和第2图像中的至少一方的处置器具13的状态来选择疲劳减轻模式和通常模式中的一方。当实施使用处置器具13的处置时,处理器41能够可靠地选择疲劳减轻模式。

371.(第7实施方式的第4变形例)

372.对本发明的第7实施方式的第4变形例进行说明。说明切换疲劳减轻模式和通常模式的其他方法。

373.处理器41在距离计算步骤中计算第1图像和所述第2图像中的一方的基准位置与处置器具13之间的距离。处理器41在模式选择步骤中,基于该距离来选择疲劳减轻模式和通常模式中的一方。

374.当设定了疲劳减轻模式时,处置器具13的光学像在立体图像中显示在比实际的位置靠里侧的位置。因此,观察者有时不容易判断处置器具13的实际的位置。在设定了疲劳减轻模式的情况下,观察者有时不容易使处置器具13接近观察对象。在处置器具13充分接近了观察对象的情况下,处理器41选择疲劳减轻模式。

375.参照图28来说明处理器41所执行的处理。图28示出处理器41所执行的处理的步骤。省略与图24所示的处理相同的处理的说明。

376.在处置器具13中在包含处置器具13的前端的前端区域附加有标记。标记的形状无关。标记也可以是文字或记号等。也可以附加2个以上的标记。

377.在步骤s145之后,处理器41计算第1图像或第2图像中的基准位置与处置器具13之间的距离(步骤s210(距离计算步骤))。例如,该基准位置是第1图像或第2图像的中心。处理器41在步骤s210中,在第1图像中检测附加于处置器具13的标记,并且计算第1图像的基准位置与该标记之间的二维距离。处理器41也可以在步骤s210中,在第2图像中检测附加于处

置器具13的标记,并且计算第2图像的基准位置与该标记之间的二维距离。在步骤s210之后,执行步骤s150。

378.步骤s210和步骤s150被执行的顺序也可以与图28所示的顺序不同。即,也可以在执行步骤s150之后执行步骤s210。

379.在步骤s150之后,处理器41判断处置器具13是否接近了观察对象(步骤s215)。例如,在步骤s210中计算出的距离小于规定值的情况下,处理器41判断为处置器具13接近了观察对象。在该情况下,实施使用处置器具13的处置的可能性高。在步骤s210中计算出的距离为规定值以上的情况下,处理器41判断为处置器具13没有接近观察对象。在该情况下,未使用处置器具13的可能性高。例如,规定值是能够区分摄像元件12接近观察对象的状态与摄像元件12远离观察对象的状态的较小的正值。

380.在处置器具13没有映现在第1图像和第2图像中的情况下,处理器41在步骤s210中无法计算距离。在该情况下,处理器41在步骤s215中也可以判断为处置器具13没有接近观察对象。

381.在处理器41在步骤s215中判断为处置器具13没有接近观察对象的情况下,执行步骤s145。在处理器41在步骤s215中判断为处置器具13接近了观察对象的情况下,执行步骤s160。

382.在步骤s105之后,处理器41计算第1图像或第2图像中的基准位置与处置器具13之间的距离(步骤s220(距离计算步骤))。步骤s220与步骤s210相同。在步骤s220之后执行步骤s110。

383.在步骤s115之后,处理器41判断处置器具13是否远离了观察对象(步骤s225)。例如,在步骤s220中计算出的距离大于规定值的情况下,处理器41判断为处置器具13远离了观察对象。在该情况下,未实施使用处置器具13的处置的可能性高。在步骤s220中计算出的距离为规定值以下的情况下,处理器41判断为处置器具13没有远离观察对象。在该情况下,正在实施使用处置器具13的处置的可能性高。例如,在步骤s225中使用的规定值与在步骤s215中使用的规定值相同。

384.在处置器具13没有映现在第1图像和第2图像中的情况下,处理器41在步骤s220中无法计算距离。在该情况下,处理器41在步骤s225中也可以判断为处置器具13远离了观察对象。

385.在处理器41在步骤s225中判断为处置器具13没有远离观察对象的情况下,执行步骤s105。在处理器41在步骤s225中判断为处置器具13远离了观察对象的情况下,执行步骤s140。

386.在上述的例子中,处理器41在第1图像或第2图像中检测附加于处置器具13的标记。此外,处理器41计算检测到该标记的区域与基准位置之间的距离。

387.处置器具13的前端区域也可以具有规定的颜色。规定的颜色与脏器或血管等这样的被摄体的颜色不同。处理器41也可以在第1图像或第2图像中检测规定的颜色。处理器41也可以计算检测到规定的颜色的区域与基准位置之间的距离。

388.也可以在处置器具13的前端区域附加规定的花纹。处理器41也可以在第1图像或第2图像中检测附加于处置器具13的花纹。处理器41也可以计算检测到该花纹的区域与基准位置之间的距离。

389.处理器41也可以在第1图像或第2图像中检测钳子130的形状。处理器41也可以计算钳子130的前端与基准位置之间的距离。

390.图28所示的步骤s100、步骤s105以及步骤s110也可以置换为图15所示的步骤s105和步骤s110a。图28所示的步骤s100和步骤s105也可以置换为图18所示的步骤s105、步骤s120以及步骤s100a。图28所示的步骤s100也可以置换为图19所示的步骤s125。图28所示的步骤s100和步骤s105也可以置换为图22所示的步骤s105、步骤s130以及步骤s100b。

391.处理器41基于第1图像和第2图像中的一方的基准位置与处置器具13之间的距离来选择疲劳减轻模式和通常模式中的一方。当处置器具13接近观察对象时,处理器41能够可靠地选择疲劳减轻模式。

392.(第7实施方式的第5变形例)

393.对本发明的第7实施方式的第5变形例进行说明。说明切换疲劳减轻模式和通常模式的其他方法。

394.图29示出图像处理装置4的周边的结构。省略与图3所示的结构相同的结构的说明。

395.内窥镜装置1还具有编码器16。编码器16配置在插入部21的内部。编码器16检测护套131沿着插入部21的轴向的运动。例如,编码器16通过以规定的时间间隔检测护套131的移动距离,从而检测护套131的速度。编码器16将检测到的速度向处理器41输出。

396.处理器41在第2运动检测步骤中检测处置器具13的运动的状态。处理器41在模式选择步骤中,基于处置器具13的运动的状态来选择疲劳减轻模式和通常模式中的一方。

397.参照图30来说明处理器41所执行的处理。图30示出处理器41所执行的处理的步骤。省略与图24所示的处理相同的处理的说明。例如,在将处置器具13插入到插入部21内的通道时,处理器41执行图30所示的处理。处理器41能够基于由编码器16检测到的护套131的速度,检测处置器具13向通道的插入。

398.在步骤s145之后,处理器41从编码器16取得护套131的速度(步骤s230(第2运动检测步骤))。在步骤s230之后,执行步骤s150。

399.步骤s230和步骤s145被执行的顺序也可以与图30所示的顺序不同。即,也可以在执行步骤s230之后执行步骤s145。步骤s230和步骤s150被执行的顺序也可以与图30所示的顺序不同。即,也可以在执行步骤s150之后执行步骤s230。

400.在步骤s150之后,处理器41判断处置器具13是否静止(步骤s235)。在步骤s230中取得的护套131的速度小于规定值的情况下,处理器41判断为处置器具13静止。在该情况下,处置器具13充分接近观察对象,实施处置的可能性高。在步骤s230中取得的护套131的速度为规定值以上的情况下,处理器41判断为处置器具13运动。在该情况下,未实施使用处置器具13的处置的可能性高。例如,规定值是能够区分处置器具13静止的状态与处置器具13运动的状态的较小的正值。

401.在处理器41在步骤s235中判断为处置器具13运动的情况下,执行步骤s145。在处理器41在步骤s235中判断为处置器具13静止的情况下,执行步骤s160。

402.在步骤s105之后,处理器41从编码器16取得护套131的速度(步骤s240(第2运动检测步骤))。步骤s240与步骤s230相同。在步骤s240之后,执行步骤s110。

403.步骤s240和步骤s105被执行的顺序也可以与图30所示的顺序不同。即,也可以在

执行步骤s240之后执行步骤s105。步骤s240和步骤s110被执行的顺序也可以与图30所示的顺序不同。即,也可以在执行步骤s110之后执行步骤s240。步骤s240和步骤s115被执行的顺序也可以与图30所示的顺序不同。即,也可以在执行步骤s115之后执行步骤s240。

404.在步骤s115之后,处理器41判断处置器具13是否运动(步骤s245)。在步骤s240中取得的护套131的速度大于规定值的情况下,处理器41判断为处置器具13运动。在该情况下,未实施使用处置器具13的处置的可能性高。在步骤s240中取得的护套131的速度为规定值以下的情况下,处理器41判断为处置器具13静止。在该情况下,实施使用处置器具13的处置的可能性高。例如,在步骤s245中使用的规定值与在步骤s235中使用的规定值相同。

405.在处理器41在步骤s245中判断为处置器具13静止的情况下,执行步骤s105。在处理器41在步骤s245中判断为处置器具13运动的情况下,执行步骤s140。

406.在上述的例子中,处理器41基于由编码器16检测到的护套131的速度来检测处置器具13的运动的状态。处理器41也可以通过使用与上述的方法不同的方法来检测处置器具13的运动的状态。例如,处理器41也可以从第1图像和第2图像中的至少一方检测处置器具13。处理器41也可以通过计算连续的2帧以上的处置器具13的运动量来检测处置器具13的运动的状态。

407.图30所示的步骤s100、步骤s105以及步骤s110也可以置换为图15所示的步骤s105和步骤s110a。图30所示的步骤s100和步骤s105也可以置换为图18所示的步骤s105、步骤s120以及步骤s100a。图30所示的步骤s100也可以置换为图19所示的步骤s125。图30所示的步骤s100和步骤s105也可以置换为图22所示的步骤s105、步骤s130以及步骤s100b。

408.处理器41基于处置器具13的运动的状态来选择疲劳减轻模式和通常模式中的一方。因此,处理器41能够在适当的定时切换图像处理模式。由于编码器16检测护套131的速度,因此,处理器41无需为了检测处置器具13而执行图像处理。因此,处理器41的负荷减少。

409.(第7实施方式的第6变形例)

410.对本发明的第7实施方式的第6变形例进行说明。说明切换疲劳减轻模式和通常模式的其他方法。

411.当设定了疲劳减轻模式时,处置器具13的光学像在立体图像中显示在比实际的位置靠里侧的位置。因此,观察者有时不容易判断处置器具13的实际的位置。在设定了疲劳减轻模式的情况下,观察者有时不容易使处置器具13接近观察对象。当观察者使处置器具13接近观察对象时,图像处理模式也可以为通常模式。另一方面,当处置器具13远离观察对象时,图像的观察容易度不容易对操作造成影响。此时,图像处理模式也可以为疲劳减轻模式。在以下的例子中,在处置器具13接近观察对象时和在处置器具13远离观察对象时,用于切换图像处理模式的条件不同。

412.参照图31来说明处理器41所执行的处理。图31示出处理器41所执行的处理的步骤。省略与图24所示的处理相同的处理的说明。例如,当内窥镜装置1的电源接通时,处理器41执行图31所示的处理。此时,内窥镜装置1以2d显示模式开始进行动作。

413.在步骤s145之后,处理器41计算第1图像或第2图像中的基准位置与处置器具13之间的距离(步骤s210)。图31所示的步骤s210与图28所示的步骤s210相同。

414.在步骤s150之后,处理器41判断处置器具13是否接近了观察对象(步骤s215)。图31所示的步骤s215与图28所示的步骤s215相同。

415.在处理器41在步骤s215中判断为处置器具13没有接近观察对象的情况下,执行步骤s145。在处理器41在步骤s215中判断为处置器具13接近了观察对象的情况下,执行步骤s160。

416.观察者在使处置器具13接近观察对象之后,对操作部22进行操作,将显示模式变更为3d模式。之后,观察者使用处置器具13来实施处置。在处置完成之后,观察者对操作部22进行操作,将显示模式变更为2d模式。

417.在步骤s115之后,处理器41判断显示模式是否变更为2d模式(步骤s165a)。图31所示的步骤s165a与图25所示的步骤s165a相同。

418.在处理器41在步骤s165a中判断为显示模式没有变更为2d模式的情况下,执行步骤s105。在处理器41在步骤s165a中判断为显示模式变更为2d模式的情况下,执行步骤s140。

419.图31所示的步骤s100、步骤s105以及步骤s110也可以置换为图15所示的步骤s105和步骤s110a。图31所示的步骤s100和步骤s105也可以置换为图18所示的步骤s105、步骤s120以及步骤s100a。图31所示的步骤s100也可以置换为图19所示的步骤s125。图31所示的步骤s100和步骤s105也可以置换为图22所示的步骤s105、步骤s130以及步骤s100b。

420.当处置器具13接近了观察对象时,处理器41选择疲劳减轻模式。当显示模式从3d模式变更为2d模式时,处理器41选择通常模式。因此,平衡良好地实现了处置器具13的操作容易度和观察者的眼睛的疲劳的减轻。

421.(第8实施方式)

422.对本发明的第8实施方式进行说明。处理器41对处理区域进行处理,使得在基于第1图像和第2图像而显示的立体图像中,处理区域中的被摄体的光学像模糊。

423.参照图32来说明处理器41所执行的处理。图32示出处理器41所执行的处理的步骤。省略与图8所示的处理相同的处理的说明。

424.在步骤s105之后,处理器41使第1图像和第2图像中的至少一方的处理区域模糊(步骤s250(图像处理步骤))。在步骤s250之后,执行步骤s115。

425.详细说明步骤s250。例如,处理器41将第1图像的处理区域所包含的各像素的颜色平均化。具体而言,处理器41计算对象像素的周边的2个以上的像素的信号值的平均,并且将该对象像素的信号值置换为该平均。处理器41对第1图像的处理区域所包含的全部像素执行该处理。处理器41通过执行与上述的处理同样的处理,而使第2图像的处理区域所包含的各像素的颜色平均化。

426.处理器41也可以在使第1图像的处理区域所包含的各像素的颜色平均化之后,将第2图像的处理区域所包含的各像素的信号值置换为第1图像的处理区域所包含的各像素的信号值。处理器41也可以在使第2图像的处理区域所包含的各像素的颜色平均化之后,将第1图像的处理区域所包含的各像素的信号值置换为第2图像的处理区域所包含的各像素的信号值。

427.图15所示的步骤s110a也可以置换为步骤s250。图18、图19、图22、图24、图25、图26、图27、图28、图30以及图31所示的步骤s110也可以置换为步骤s250。

428.在处理器41使处理区域模糊之后,观察者不容易合焦于映现在处理区域的处置器具13的光学像。因此,减轻了观察者的眼睛的疲劳。与处理器41变更视差量的情况相比,处

理器41的负荷减少。

429.(第8实施方式的变形例)

430.对本发明的第8实施方式的变形例进行说明。处理器41对处理区域实施马赛克处理。

431.参照图33来说明处理器41所执行的处理。图33示出处理器41所执行的处理的步骤。省略与图8所示的处理相同的处理的说明。

432.在步骤s105之后,处理器41对第1图像和第2图像中的至少一方的处理区域实施马赛克处理(步骤s255(图像处理步骤))。在步骤s255之后,执行步骤s115。

433.详细说明步骤s255。例如,处理器41将第1图像的处理区域分割为2个以上的部分区域。例如,部分区域包含9个或16个像素。部分区域所包含的像素的数量不限于9或16。例如,部分区域的形状为正方形。部分区域的形状不限于正方形。处理器41使1个部分区域所包含的全部像素的颜色成为相同的颜色。即,处理器41使1个部分区域所包含的全部像素的信号值成为相同值。处理器41也可以计算1个部分区域所包含的全部像素的信号值的平均,并且将该部分区域所包含的全部像素的信号值置换为该平均。处理器41对全部的部分区域执行上述的处理。处理器41通过执行与上述的处理同样的处理,对第2图像的处理区域实施马赛克处理。

434.处理器41也可以在对第1图像的处理区域实施马赛克处理之后,将第2图像的处理区域所包含的各像素的信号值置换为第1图像的处理区域所包含的各像素的信号值。处理器41也可以在对第2图像的处理区域实施马赛克处理之后,将第1图像的处理区域所包含的各像素的信号值置换为第2图像的处理区域所包含的各像素的信号值。

435.图15所示的步骤s110a也可以置换为步骤s255。图18、图19、图22、图24、图25、图26、图27、图28、图30以及图31所示的步骤s110也可以置换为步骤s255。

436.在处理器41对处理区域实施马赛克处理之后,观察者不容易合焦于映现于处理区域的处置器具13的光学像。因此,减轻了观察者的眼睛的疲劳。与处理器41变更视差量的情况相比,处理器41的负荷减少。

437.(附记)

438.上述的全部的实施方式能够包含以下的内容。内窥镜装置1具有特殊光观察的功能。在通过处置器具13实施处置之前,光源装置3的光源产生窄带光。例如,窄带的中心波长为630nm。摄像元件12拍摄被照射了窄带光的被摄体,生成第1图像和第2图像。处理器41在步骤s105中从摄像元件12取得第1图像和第2图像。

439.当向观察对象照射了窄带光时,穿过粘膜下层或固有肌层的血管在第1图像和第2图像中被强调。当基于第1图像和第2图像显示出立体图像时,观察者容易识别该血管。因此,观察者容易使用处置器具13来实施处置。

440.以上,说明了本发明的优选实施方式,但本发明不限定于这些实施方式及其变形例。在不脱离本发明的主旨的范围内,能够进行结构的附加、省略、置换以及其他的变更。此外,不通过上述的说明来限定本发明,而是仅通过附带的权利要求的范围来限定本发明。

441.产业利用性

442.根据本发明的各实施方式,图像处理方法和图像处理装置能够在不损害器具的使用容易度的情况下减轻器具的图像使观察者的眼睛产生的疲劳。

443.标号说明

444.1 内窥镜装置

445.2 电子内窥镜

446.3 光源装置

447.4 图像处理装置

448.5 监视器

449.6 接收装置

450.10 前端部

451.11l 第1光学系统

452.11r 第2光学系统

453.12 摄像元件

454.13、14、15 处置器具

455.16 编码器

456.21 插入部

457.22 操作部

458.23 通用缆线

459.24 连接器部

460.25 连接线

461.26 电连接器部

462.41 处理器

463.42 rom

464.130 钳子

465.131 护套

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。