1.本发明属于资源分配技术领域,具体涉及为一种边缘计算环境中的任务的双重迁移方法。

背景技术:

2.随着云技术的发展,用户可以在不同地方随时登陆到网络并享受云端服务。边缘计算通过将任务部署在靠近基站等接入点的位置来降低接入时延、节省带宽、提高吞吐量。但是,早先的边缘计算架构只分配同一服务器来面向所有用户,而不考虑用户的实际地理位置的变换。当用户处于移动状态时,用户与服务器之间的距离会越来越远,造成网络传输路径变长、网络延迟增加,使得整体的云计算的服务质量降低。

3.另外,公开号为cn111274031a的中国发明专利申请,公开了一种端-云协同的边缘服务动态迁移认证的方法及装置。当需要实现在终端移动下的边缘服务数据迁移认证时,第一边缘向移动终端发送进行服务迁移的通知和时间戳信息,然后移动终端通过云端获取可提供服务的第二边缘,移动终端与第二边缘建立连接,移动终端通知第一边缘执行将服务迁移到第二边缘,第一边缘向第二边缘执行服务迁移,第二边缘向移动终端发送迁移完毕确认信息,第二边缘与移动终端建立边缘服务。在边缘计算服务场景下,移动终端能够安全快速的在不同边缘服务器之间实现服务数据迁移的认证。在该方案存在两部不足:上述专利方案,在服务前移的过程中,移动终端与边缘端始终处于通信连接的状态。而真实的使用环境中,移动终端在与第一边缘端通信之后下线了,过了一段时间之后再其他地区上线并与第二边缘端通信连接,此时,第二边缘要为用户提供连续性的云端服务。上述专利方案无法满足真实环境下中断通信后的云端任务迁移。

技术实现要素:

4.鉴于上述现有技术的不足之处,本发明的目的在于提供一种边缘计算环境中的任务的双重迁移方法。

5.一种边缘计算环境中的任务的双重迁移方法,包括以下步骤:步骤s1,建立边缘计算平台:所述边缘计算平台包括至少2个均与云端通信连接的区域网络;每个区域网络中,设置有光纤骨干;所述光纤骨干连接有1个储存区域网络和至少2个边缘服务器;区域网络中的每个边缘服务器均可访问储存区域网络上的存储;所述储存区域网络内设至少2个存储服务器;所述边缘服务器部署于基站附近;步骤s2,用户设备定期向与其通信连接的边缘服务器传送心跳信息,心跳信息包括:用户设备的识别号、纬度、经度、当前连线的基站名称和局域网地址、心跳发送时间;步骤s3,边缘服务器主动侦测用户设备是否登出;当边缘服务器侦测到用户设备登出时,执行中断状态迁徙,通过预测用户设备常出现的地理位置,把用户设备的任务信息放在用户设备可能登入的边缘服务器所对应的储存区域网络设备中,并在用户设备再次登入后,让用户设备从最近的边缘服务器存取云端服务;否则进行下一步;

步骤s4,边缘服务器主动侦测用户设备是否移动:当边缘服务器侦测到用户设备移动时,执行连续状态迁移,用户在移动的同时持续使用云端服务,始终维持在登录状态,通过换手程序进行任务信息转换和连接通道转换,将用户设备的任务信息迁移至与用户最近的边缘服务器所对应的存储服务器,并由与用户设备最近的边缘服务器向用户设备提供云端服务;否则返回步骤s3。

6.进一步,步骤s3还包括:步骤s301,任务信息转换:云端从边缘服务器获取用户设备的所有心跳信息,计算用户设备在各边缘服务器覆盖区域的登入概率,并根据该登入概率将用户设备的任务信息分散储存在边缘服务器相对应的存储服务器中,此时,用户设备在边缘服务器覆盖区域登入平台的概率,等同于该边缘服务器所对应的存储服务器具有的任务信息量占任务信息总量的百分比;步骤s302,连接通道转换:用户设备送出云端系统的登录请求;与用户设备建立通信连接的基站,将登录请求引导至边缘服务器群组中,并使用任意播送的方式找到最近的边缘服务器作为目标服务器;当目标服务器接收到任意播送基站的登入请求后,目标服务器将执行虚拟机器开启程序并载入用户设备的任务信息,同时回应用户设备的登入请求,向用户设备发送包含有目标服务器单点播送位址的回应封包;用户设备与目标服务器建立连接通道之后,用户设备与目标服务器之间以单点播送方式传送信息。

7.进一步,步骤s4还包括:步骤s401:边缘服务器主动侦测用户设备是否位移;边缘服务器接收到用户设备定期传送的心跳信息,根据用户设备连线基站的局域网地址位置来判断用户设备是否移动:当用户设备移动时会转换连线基站,连线的基站局域网地址就会改变,就表示用户设备已经位移;当用户设备位移时,根据连线的基站局域网地址确定新基站;步骤s402:旧基站向新基站发起换手程序,旧基站发送切换请求信息给新基站,切换请求信息包括新的用户设备识别号;接着,新基站回复切换确认信息,告知旧基站新的用户设备的识别号和存取通道;此时,仍由旧基站提供用户设备云端服务;同时进行步骤s403和步骤s406;步骤s403:旧基站发送迁移信息给旧边缘服务器,迁移请求信息包括新基站的信息、用户设备正在使用的服务类型以及所需的虚拟硬件资源;与用户设备建立通信连接的新基站,使用任意播送的方式找到最近的边缘服务器作为新边缘服务器;步骤s404:旧边缘服务器发送迁移请求信息给新边缘服务器,迁移请求信息告知新边缘服务器用户设备正在使用的服务类型以及所需的虚拟硬件资源;新边缘服务器根据迁移请求信息,在完成新的虚拟机开启程序后,回传迁移确认信息给旧边缘服务器;步骤s405:此时用户设备仍然经由旧基站从旧边缘服务器取得云端服务,所以,旧边缘服务器调取与其相对应的存储服务器中的用户设备当前使用的任务信息,同时将该任务信息向前传送给新边缘服务器,并留存于与新边缘服务器相对应的存储服务器,完成任务信息转换;然后转步骤s407;步骤s406:当旧基站收到切换确认信息后,向前传送无线重构信息给用户设备,无线重构信息包括新的用户设备识别号和存取通道;旧基站传送识别号转移信息给新基站;

然后转步骤s407;步骤s407:开始第二层的换手程序,旧基站和新边缘服务器同时将暂存资料向前传送给新基站,新边缘服务器和旧边缘服务器达到同步;步骤s408:用户设备发送无线连接完成信息给新基站;步骤s409:新基站将暂存资料传送给用户设备,新基站和用户设备建立连接通道,完成连接通道转换,此时由新边缘服务器提供用户设备云端服务。

8.本方案使用双重迁移方法,考虑到用户的中断状态迁徙和连续状态迁移,其思路是不论用户在何时何地登入云端服务,都由与用户最近的服务器存取云端服务。本方案,一方面,通过对用户的地理位置的持续监测,让用户设备不论在何时何地使用云服务,都能与最近的服务器取得通信连接,缩短服务器与使用者之间的传输路径,有效减少传输延迟时间,另一方面,通过任务内容的迁移,将任务预载于最近的服务器,使用户能继续从最近的服务器上存取云端服务,从而保证了任务迁移前后的云端服务质量。

9.中断状态迁徙:用户移动到不同的地点,再次登入云端系统时,继续使用上次云服务。传统方案中,由于上次云服务的信息保存在先前服务器,不论用户第二次登录在什么地方,云端都分配先前的服务器给用户使用,当先前服务器与用户距离较远时,就难以维持高质量的云服务。本方案中,用户设备登出云端系统,通过预测用户设备常出现的地理位置,把用户设备的任务信息放在用户设备可能登入的边缘服务器所对应的储存区域网络设备中,缩短服务器下次载入用户私有资料的时间。并通过任意播送或中介服务器找出距离用户最近的服务器,让用户设备从最近的边缘服务器存取云端服务,缩短服务器与使用者之间的传输路径。

10.连续状态迁移:用户在移动的同时持续使用云端服务,始终维持在登录状态,重点关注用户的当前位置,通过换手程序进行任务信息转换和连接通道转换,将用户设备的任务信息迁移至与用户最近的边缘服务器所对应的存储服务器,并由与用户最近的边缘服务器向用户设备提供云端服务。通过在换手程序中,增加任务信息的同步,使得新边缘服务器和旧边缘服务器达到同步,从而缩短服务的中断时间,短时间内就可以新旧边缘服务器的切换。用户设备始终与距离最近的边缘服务器对接,用户设备和边缘服务器之间始终相距一个跳跃数。

附图说明

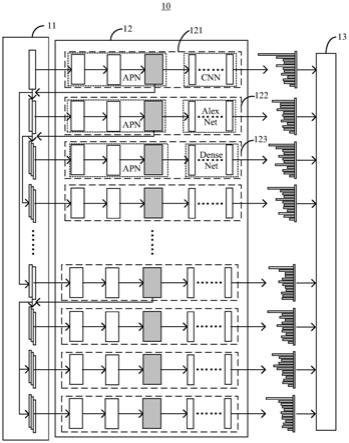

11.图1为本发明的结构示意图;图2为本发明的连续状态迁移的程序图。

具体实施方式

12.下面结合附图,对本发明作进一步详细说明。

13.一种边缘计算环境中的任务的双重迁移方法,包括以下步骤:步骤s1:建立边缘计算平台:如图1所示,所述边缘计算平台包括至少2个均与云端通信连接的区域网络;每个区域网络中,设置有光纤骨干;所述光纤骨干连接有1个储存区域网络和至少2个边缘服务器;所述储存区域网络内设至少2个存储服务器;所述边缘服务器部署于基站附近。

14.本方案的边缘服务器,使用虚拟机(virtual machine)技术,将一台服务器分割成多个虚拟机,以最大化的效率共享硬件、软件许可证以及管理资源。

15.储存区域网络(san):与边缘服务器连接,为边缘服务器提供一个共享的存储空间池。区域网络中的每个边缘服务器均可访问储存区域网络上的存储,且储存区域网络内的存储服务器彼此之间独立又相互连通,方便扩充设备和备份资料。

16.存储服务器:是连接在储存区域网络上,具备资料存储功能的服务器。

17.步骤s2:用户设备定期向与其通信连接的边缘服务器传送心跳信息,心跳信息包括:用户设备的识别号、纬度、经度、当前连线的基站名称和局域网地址、心跳发送时间。

18.本方案,将用户设备的信息,传送至边缘服务器,由边缘服务器来掌握用户设备的动向以及调整服务部署等。相对于将用户设备的信息传送至云端的集中式管理的模式,本方案降低了网络延迟。相对于当有需要时才将用户设备的信息传送至边缘服务器或云端的自主式管理的模式,本方案能系统地掌握用户设备的动向并实时调整用户的需求。

19.本方案采用心跳传送机制,使得边缘服务器能够掌握用户设备信息及动向。边缘服务器收到心跳信息后记录并分析,如果用户设备登出,则进行中断状态迁徙;如果用户设备位移,则进行连续状态迁移。

20.步骤s3:边缘服务器主动侦测用户设备是否登出;当边缘服务器侦测到用户设备登出时,执行中断状态迁徙,否则进行下一步。

21.中断状态迁徙,将用户设备的任务信息迁移到离用户设备最近的存储服务器中,从而减少边缘服务器从储存区域网络载入任务信息的时间,并让最近的边缘服务器向用户设备提供云端服务,以缩短传输路径。

22.中断状态迁徙,过程如下:步骤s301:任务信息转换:云端从边缘服务器获取用户设备的所有心跳信息,计算用户设备在各边缘服务器覆盖区域的登入概率,并根据该登入概率将用户设备的任务信息分散储存在边缘服务器相对应的存储服务器中,此时,用户设备在边缘服务器覆盖区域登入平台的概率,等同于该边缘服务器所对应的存储服务器具有的任务信息量占任务信息总量的百分比。

23.本方案的任务信息转换,在用户设备登出之后,预测用户设备下次登入的位置,根据登入概率将任务信息分配于储存区域网络中的存储服务器,因此每台存储服务器所拥有的任务信息量不尽相同,登入概率最高的区域的边缘服务器所对应的储存服务器将被存储最高比例的任务信息,从而缩短任务信息的传输路径,减少边缘服务器从储存区域网络其他较远设备下载的资料量,保证了边缘计算的服务品质。

24.将本方案与任务信息平均分配的方式做个分析对比。

25.任务信息平均分配的方式中,用户设备从任一个边缘服务器登入时的平均任务信息迁移量d:。

26.m,表示用户设备的任务信息总量。

27.n,表示边缘服务器的总数。

28.pi,表示用户设备在第i个边缘服务器覆盖区域登入平台的概率,1≤i≤n。

29.本方案的任务信息转换后,用户设备从任一个边缘服务器登入时的平均任务信息迁移量dm:。

30.di,表示第i个边缘服务器所对应的存储服务器具有的任务信息量占任务信息总量的百分比。

31.本方案,根据登入概率pi将用户设备的任务信息分散储存在边缘服务器相对应的存储服务器中,即pi=di。因此,。

32.边缘服务器与其所对应的存储服务器的对应方式,采用距离的方式,即默认与边缘服务器最接近的存储服务器为该边缘服务器所对应的存储服务器。

33.当用户设备登入第i个边缘服务器时,任务信息平均分配的方式所需下载任务信息量与本方案的任务信息转换所需下载任务信息量的差值xi:。

34.当时,xi为正数,表示任务信息平均分配的方式所需下载任务信息量较大,此时,表示本方案的任务信息转换的改善了任务信息的传输效能。反之,当时,xi为负数,表示任务信息平均分配的方式所需下载任务信息量较小,但是,由于此时pi较小,本方案的任务信息转换所造成的损失并不大。因此,整体而言,在任务信息的传输效能上,本方案的任务信息,是优于任务信息平均分配的方式。

35.举个简单的实例,用以观察任务信息的传输效能。在本实例中,共有3个边缘服务器,分别为边缘服务器a、边缘服务器b、边缘服务器c;用户设备移动登入4次,登录的边缘服务器分别为:边缘服务器a、边缘服务器b、边缘服务器a、边缘服务器a。

36.在任务信息平均分配的方式中,由于每个边缘服务器上的任务信息量均为1/3,所以,每次登录,无论登录在哪个边缘服务器,所需的任务信息迁移量d均为2/3。

37.本方案的任务信息转换,用户设备第一次登入时,边缘服务器a相对应的存储服务器存储有所有任务信息量。当用户设备第二次登入时,地理位置与第一次登入时并不相同,此时,用户设备在两个地理位置出现的概率均为1/2,因此,当用户设备登出时,将任务信息量平均分成两份,分别存放于边缘服务器a对应的存储服务器和边缘服务器b对应的存储服务器,此时,用户设备第三次登入任一边缘服务器时,平均任务信息迁移量dm为4/9。假设用户设备第三次登入的地理位置对应于边缘服务器a,此时发现边缘服务器a所对应的存储服务器已经存储有1/2的任务信息量,只需要下载另外的1/2的任务信息量。当用户设备再次登出时,对于登入概率,边缘服务器a为2/3,边缘服务器b为1/3,边缘服务器c为0;根据登入概率分配任务信息,此时,用户设备第四次登入任一边缘服务器时,平均任务信息迁移量dm为3/8。

38.可见,dm均小于d,本方案的任务信息转换所需的任务信息迁移量较少。

登入次数边缘服务器a,任务信息量边缘服务器b,任务信息量边缘服务器c,任务信息量任务信息平均分配的方式,平均任务信息迁移量d本方案的任务信息转换,平均任务信息迁移量dm11

☆

002/3021/21/2

☆

02/31/232/3

☆

1/302/34/943/4

☆

1/402/33/8

39.表1为本方案的任务信息转换的实例(

☆

表示登入的边缘服务器)。

40.在本方案中,用户设备的移动范围可以局限于区域网络(例如图1中,左侧区域网络中的内部箭头),实现在区域网络内部的任务信息的流转,也可以跨越区域网络(例如图1中,左侧区域网络和右侧区域网络之间的箭头),在广域网路中实现任务信息的传输。

41.步骤s302:连接通道转换:用户设备送出云端系统的登录请求;与用户设备建立通信连接的基站,将登录请求引导至边缘服务器群组中,并使用任意播送的方式找到最近的边缘服务器作为目标服务器。

42.当目标服务器接收到任意播送基站的登入请求后,目标服务器将执行虚拟机器开启程序并载入用户设备的任务信息,同时回应用户设备的登入请求,向用户设备发送包含有目标服务器单点播送位址的回应封包;用户设备与目标服务器建立连接通道之后,用户设备与目标服务器之间以单点播送方式传送信息。

43.任意播送:某组中任意发送方对应拓朴结构中几个最接近的接收方之间的通信。每当一个数据包被发送到该任播地址时,它就会被发送到距离最近的提供因特网访问的基站上。本方案采用通用的任意播送方式,不再赘叙。

44.步骤s4:边缘服务器主动侦测用户设备是否移动:当边缘服务器侦测到用户设备移动时,执行连续状态迁移,否则返回步骤s3。

45.连续状态迁移:用户在移动的同时持续使用云端服务,始终维持在登录状态,重点关注用户的当前位置,通过换手程序进行任务信息转换和连接通道转换,将用户设备的任务信息迁移至与用户最近的边缘服务器所对应的存储服务器,并由与用户设备最近的边缘服务器向用户设备提供云端服务。

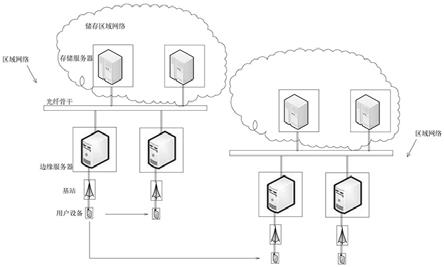

46.参考图2,对步骤4进一步分析。

47.步骤s401:边缘服务器主动侦测用户设备是否位移;边缘服务器接收到用户设备定期传送的心跳信息,根据用户设备连线基站的局域网地址位置来判断用户设备是否移动:当用户设备移动时会转换连线基站,连线的基站局域网地址就会改变,就表示用户设备已经位移;当用户设备位移时,根据连线的基站局域网地址确定新基站。

48.步骤s402:旧基站向新基站发起换手程序,旧基站发送切换请求信息(handover request)给新基站,切换请求信息包括新的用户设备识别号;接着,新基站回复切换确认信息(handover acknowledge),告知旧基站新的用户设备的识别号和存取通道。

49.此时,仍由旧基站提供用户设备云端服务。

50.同时进行步骤s403和步骤s406。旧基站会在步骤s406中将新的用户设备的识别号和存取通道转交给用户设备,从而缩短换手程序的时间。

51.步骤s403:旧基站发送迁移信息(migration information)给旧边缘服务器,迁移请求信息包括新基站的信息、用户设备正在使用的服务类型以及所需的虚拟硬件资源;与用户设备建立通信连接的新基站,使用任意播送的方式找到最近的边缘服务器作为新边缘服务器。

52.步骤s404:旧边缘服务器发送迁移请求信息(migration request)给新边缘服务器,迁移请求信息告知新边缘服务器用户设备正在使用的服务类型以及所需的虚拟硬件资源;新边缘服务器根据迁移请求信息,在完成新的虚拟机开启程序后,回传迁移确认信息(migration acknowledge)给旧边缘服务器。

53.步骤s405:此时用户设备仍然经由旧基站从旧边缘服务器取得云端服务,所以,旧边缘服务器调取与其相对应的存储服务器中的用户设备当前使用的任务信息,同时将该任务信息向前传送给新边缘服务器,并留存于与新边缘服务器相对应的存储服务器,完成任务信息转换;然后转步骤s407。

54.步骤s406:当旧基站收到切换确认信息(handover acknowledge)后,向前传送无线重构信息(radio resource control connection reconfiguration)给用户设备,无线重构信息包括新的用户设备识别号和存取通道;旧基站传送识别号转移信息(sequence number status transfer)给新基站,将用户设备上传和下载的pdcp(packet data convergence protocol)的识别号状态信息告诉新基站;然后转步骤s407。

55.步骤s407:开始第二层的换手程序,旧基站和新边缘服务器同时将暂存资料向前传送给新基站,新边缘服务器和旧边缘服务器达到同步,以缩短云端服务的中断时间。

56.步骤s408:用户设备发送无线连接完成信息(radio resource control connection reconfiguration complete)给新基站。

57.步骤s409:新基站将暂存资料传送给用户设备,新基站和用户设备建立连接通道,完成连接通道转换,此时由新边缘服务器提供用户设备云端服务。

58.连续状态迁移过程中,在尚未进入到第二层换手程序时,用户设备仍然从用旧边缘服务器获取云端服务。旧边缘服务器需要将任务信息向前传输给新边缘服务器,直到新边缘服务器和旧边缘服务器达到同步之后,才由新边缘服务器提供用户设备云端服务。

59.本方案,通过在换手程序中,增加任务信息的同步,使得新边缘服务器和旧边缘服务器达到同步,从而缩短服务的中断时间,短时间内就可以新旧边缘服务器的切换。当需要同步的任务信息较小时,任务信息的同步可以在换手程序结束之前完成,从不并不会延长换手程序的完成时间。理论上,换手程序的完成时间为55毫秒,时间极短。

60.利用ns2做模拟,设定光纤骨干频宽为1g,接入基站半径为250m,背景流量率为100mbps,测试本方案对传输延迟时间的影响。

61.传统架构中,不论用户设备接取的基站为何,用户设备仍然从最初的边缘服务器存取,因此,用户设备和边缘服务器之间的跳跃数会随着用户设备的移动而增加。

62.本方案中,用户设备始终与距离最近的边缘服务器对接,用户设备和边缘服务器之间始终相距一个跳跃数。

63.对于中断时间:不论用户设备需要迁徙的任务信息的大小,在新旧边缘服务器达成同步前,都会由旧边缘服务器提供用户设备云端服务,当新旧边缘服务器同步后,才切换至新边缘服务器。因此不管用户设备需要迁徙的任务信息的档案大小,所需的中断时间均不会改变。中断时间为旧服务器通过一消息通知用户设备,约为1rtt。

64.对于同步时间:我们只需要同步用户设备的任务信息,而不是迁移整个虚拟机,因此,缩短了同步的内容。当任务信息为1k时,同步时间为12.7毫秒;当任务信息为100m时,同步时间为26秒。可见,随着任务信息的增大,同步时间也增大。当然,提升光纤骨干的频宽,

可有效缩短同步时间。

65.对所公开的实施例的上述说明,使本领域专业技术人员能够实现或使用本发明。对这些实施例的多种修改对本领域的专业技术人员来说将是显而易见的,本文中所定义的一般原理可以在不脱离本发明的精神或范围的情况下,在其它实施例中实现。因此,本发明将不会被限制于本文所示的这些实施例,而是要符合与本文所公开的原理和新颖特点相一致的最宽的范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。