1.本发明属于机器学习、图像识别和双目视觉技术领域,具体为一种基于机器学习的工件自动抓取系统及方法。

背景技术:

2.工件自动抓取技术的任务是完成对指定类别工具的识别,并向机械抓取手臂提供目标工件的深度信息、抓取点信息,同时能够对工件库中所有的工件类别有效识别,并且识别的种类能够按需管理。

3.现阶段,工件自动抓取技术主要依赖于目标特征提取、特征匹配等手段进行分类和定位,同时对工件深度信息的测定一般采用激光测距或多图三角测量的方式,存在以下不足:

4.一是部分自动抓取技术中对工件的空间定位采用主动视觉场景测量法,视觉组件通过向外发射激光实现对三维空间的构建,利用激光传感器形成的点云图像获取工件空间定位,导致系统复杂,硬件要求高;

5.二是:对工件的目标检测采用特征匹配以及轻量级神经网络的方式,导致目标分类和定位的效果不佳、可识别工件种类扩展困难、多目标检测能力弱;

6.三是:对工件的抓取普遍采用几何引导法,导致在动态条件下,对工件的抓取效率低下。

技术实现要素:

7.针对目前工件自动抓取在应用过程中存在系统组成复杂、工件类别识别不准确、可抓取目标种类难以扩展、不高效、不精准等问题,本发明提供了一种基于机器学习的工件自动抓取系统及方法。

8.为了达到上述目的,本发明采用了下列技术方案:

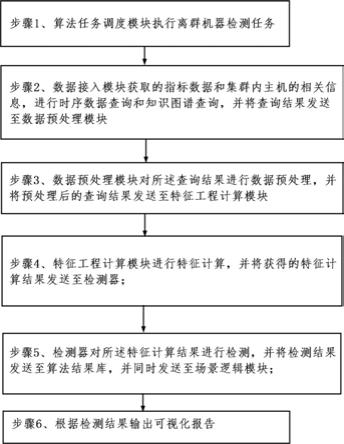

9.本发明提供一种基于机器学习的工件自动抓取方法,包括以下步骤:

10.步骤1,图像的采集及预处理;

11.步骤2,对深度卷积神经网络net1进行训练;

12.步骤3,采用k

‑

fold交叉验证步骤2训练获得的深度卷积神经网络net1的权重;

13.步骤4,对工件目标进行实时检测;

14.步骤5,对工件进行空间定位;

15.步骤6,对相应工件完成抓取任务。

16.进一步,所述步骤1中图像采集的具体过程为:双目视觉组件搭载左右两个高清摄像头,通过左摄像头采集工件在不同环境下,多种姿态图像。

17.进一步,所述步骤1中图像预处理是在数据预处理框架中进行的,具体的过程为:采用图像分割的方法对采集的图像中不同的目标进行标注,标签为人工标注的工件类别信息,得到数据集以及对应的标签,同时为使深度卷积神经网络能够顺利实现对多类工件的

准确识别,将数据集按1:5随机分为训练集和验证集;所述数据预处理框架还可以对工件类别进行管理。

18.进一步,所述步骤2对深度卷积神经网络net1进行训练,采用的数据集为工件库种类采集图像数据集,标签为人工标注的工件类别信息,具体过程包括以下步骤:

19.(1)设置深度卷积神经网络net1的输入层为可见光图像,图像的尺寸为w*h,采用多种类型的卷积核进行卷积操作并通过调整卷积步长对特征图像下采样,激励函数为relu函数,通过特征池化金字塔fpn网络以及卷积层,在三尺度下完成对目标的检测;该过程可以将图像映射为目标检测信息一维向量。

20.(2)定义深度卷积神经网络net1的损失函数为:

21.l

c

(o,c,o,c,l,g)=λ1l

conf

(o,c) λ2l

cla

(o,c) λ3l

loc

(l,g)

22.式中,l

conf

(o,c)、l

cla

(o,c)、l

loc

(l,g)分别为置信度损失、分类损失和定位损失,λ1、λ2、λ3分别为三部分损失之间的平衡系数;

23.(3)对深度卷积神经网络net1的训练收敛以l

c

最小化为目的,计算优化卷积神经网络的参数即最小化损失函数对深度卷积神经网络参数的梯度式中,ω是神经网络参数,为求偏导符号;

24.(4)采用adam优化器对卷积神经网络的权值进行更新,adam优化器,可以自适应学习率,在参数更新效果上有了进一步的提升:

25.m

t

=β1·

m

t

‑1 (1

‑

β1)

·

g(ω

t

)

26.ν

t

=β2·

ν

t

‑1 (1

‑

β2)

·

g(ω

t

)

·

g(ω

t

)

[0027][0028][0029]

其中,m

t

为一阶动量,m

t

‑1是网络权重更新前的一阶动量,β1(0.9)、β2(0.999)为控制衰减系数,g(ω

t

)为t时刻对参数ω

t

的损失梯度,ν

t

为二阶动量,ν

t

‑1是网络权重更新前的二阶动量,α为学习率,ε(10

‑7)为防止分母为零的小数,ω

t

是网络更新前的权重参数,ω

t 1

是网络更新后的权重参数,是两个计算中间值。

[0030]

(5)重复步骤(3)和(4),根据连续n次优化以后损失函数变化小于阈值η,使深度卷积神经网络net1收敛。

[0031]

进一步,所述步骤4对工件进行实时检测的具体过程为:在动态条件下,将双目视觉组件的左摄像头采集的实时视频图像输入步骤3验证后的深度卷积神经网络net1,对工件所处环境进行实时目标检测,输出目标检测信息。

[0032]

进一步,所述步骤5中对工件进行空间定位的具体过程为:双目视觉组件通过信息传送流程获取步骤4输出的所要抓取工件的目标检测信息,利用相关性匹配算法和三角测量原理对双目视觉组件左右两个摄像头采集的图像信息进行处理,计算出工件的空间深度信息。

[0033]

进一步,所述步骤6对相应工件完成抓取任务的具体过程为:在实时检测的状态下,通过信息传送流程将步骤5计算出的工件空间深度信息传送到机械臂控制组件,机械臂控制组件根据工件的空间深度信息完成对相应工件的实时抓取。

[0034]

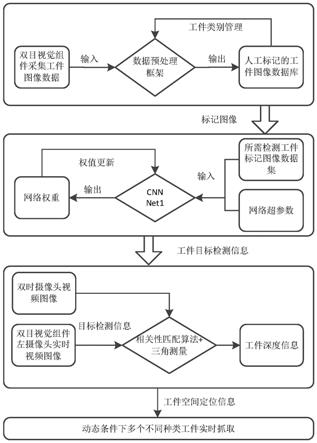

本发明还提供一种基于机器学习的工件自动抓取系统,包括双目视觉组件、数据预处理框架、深度卷积神经网络和信息流程;其中,双目视觉组件搭载左右两个高清摄像头,用于采集工件在不同环境下、多种姿态的图像;数据预处理框架首先针对多类型工件进行图像数据整合,并使用人工标注方式为各类工件建立图像数据集,同时为使深度神经网络能够顺利实现对多类工件的准确识别,数据预测理框架能够完成对数据集的随机抽取形成训练集、验证集,并且该框架能够完成对工件库类别的管理;深度卷积神经网络进行工件目标检测;信息流程将深度卷积神经网络获得的目标检测信息应用于双目视觉组件对工件的空间定位,解决了工件类别识别不准确、可抓取目标种类难以扩展、不高效、不精准等问题,通过信息流程将深度卷积神经网络输出的目标检测信息与双目视觉组件左右两个摄像头的图像信息进行了融合,成功降低了工件抓取系统的复杂程度,使该系统能够更加适应复杂情况。

[0035]

与现有技术相比本发明具有以下优点:

[0036]

1、本发明提供了一种基于机器学习的工件自动抓取系统,该系统包括一个双目视觉组件、一个数据预处理框架、一个深度卷积神经网络和一个信息流程;该系统通过信息流程将深度卷积神经网络输出的目标检测信息与双目视觉组件左右两个摄像头的图像信息进行了融合,成功降低了工件抓取系统的复杂程度,使该系统能够更加适应复杂情况。

[0037]

2、本发明提供了一种基于机器学习的工件自动抓取方法,采用数据预处理框架和深度卷积神经网络的结合使用的方法:数据预测理框架完成对数据集的随机抽取形成训练集、验证集,同时完成对工件库类别的管理,深度神经网络实现对多类工件的识别。能够以更高的效率、更易于扩展的系统、更精准的分类和定位,完成对工件的自动抓取任务。

附图说明

[0038]

图1为本发明方法流程图。

具体实施方式

[0039]

下面结合本发明实施例和附图,对本发明实施例中的技术方案进行具体、详细的说明。应当指出,对于本领域的普通技术人员来说,在不脱离本发明原理的前提下,还可以做出若干变型和改进,这些也应视为属于本发明的保护范围。

[0040]

一种基于机器学习的工件自动抓取系统,包括双目视觉组件、数据预处理框架、深度卷积神经网络和信息流程;

[0041]

其中,双目视觉组件搭载左右两个高清摄像头,用于采集工件在不同环境下、多种姿态的图像;

[0042]

数据预处理框架首先针对多类型工件进行图像数据整合,并使用人工标注方式为各类工件建立图像数据集,同时为使深度神经网络能够顺利实现对多类工件的准确识别,数据预测理框架能够完成对数据集的随机抽取形成训练集、验证集,并且该框架能够完成对工件库类别的管理;

[0043]

深度卷积神经网络进行工件目标检测;

[0044]

信息流程将深度卷积神经网络获得的目标检测信息应用于双目视觉组件对工件的空间定位,解决了工件类别识别不准确、可抓取目标种类难以扩展、不高效不精准等问题。

[0045]

结合附图1说明,本发明将工件自动抓取系统中视觉组件对工件进行空间定位的过程解析为工件目标在实时视频中的检测问题和双目视觉组件对工件深度信息的获取问题,通过构建深度卷积神经网络,对左摄像头实时视频中的工件进行实时目标检测,在通过信息流程将检测信息传送给双目视觉组件,该组件结合目标检测信息,并对左右摄像头实时视频图像进行相关性匹配和三角测量,实时输出所需检测工件的实时空间位置。具体涉及到深度神经网络的构建、网络训练优化以及工件空间定位;

[0046]

(1)训练一个多类型工件识别的深度神经网络,网络记为net1,该网络类型为卷积神经网络;

[0047]

(1

‑

1)设置识别网络net1:网络的结构为cnn网络,输入层为可见光图像,图像的尺寸为w*h,采用多种类型的卷积核进行卷积操作并通过调整卷积步长对特征图像下采样,激励函数为relu函数,通过特征池化金字塔fpn网络以及卷积层,在三尺度下完成对目标的检测,该过程物理意义是将图像映射为目标检测信息一维向量;

[0048]

(1

‑

2)双目视觉组件搭载左右两个高清摄像头,通过左摄像头采集工件在不同环境下,多种姿态图像,采用图像分割的方法对不同的目标进行标注。得到数据集d={d1,d2,...d

n

},对应的标签s={[s

11

,s

12

...],[s

21

,s

22

...],...[s

n1

,s

n2

...]};

[0049]

(1

‑

3)定义对工件目标进行实分类和定位的net1深度卷积神经网络损失函数为l

c

(o,c,o,c,l,g)=λ1l

conf

(o,c) λ2l

cla

(o,c) λ3l

loc

(l,g),其中三个组成部分分别为置信度损失、分类损失和定位损失,λ1、λ2、λ3为三部分损失之间的平衡系数。对深度神经网络的训练收敛以lc最小化为目的,计算优化卷积神经网络的参数(最小化损失函数对卷积神经网络参数的梯度);

[0050]

(1

‑

4)采用adam优化器对卷积神经网络的权值进行更新,adam优化器,可以自适应学习率,在参数更新效果上有了进一步的提升:

[0051]

m

t

=β1·

m

t

‑1 (1

‑

β1)

·

g(ω

t

)

[0052]

ν

t

=β2·

ν

t

‑1 (1

‑

β2)

·

g(ω

t

)

·

g(ω

t

)

[0053][0054][0055]

其中,m

t

为一阶动量,m

t

‑1是网络权重更新前的一阶动量,β1(0.9)、β2(0.999)为控制衰减系数,g(ω

t

)为t时刻对参数ω

t

的损失梯度,ν

t

为二阶动量,ν

t

‑1是网络权重更新前的二阶动量,α为学习率,ε(10

‑7)为防止分母为零的小数,ω

t

是网络更新前的权重参数,ω

t 1

是网络更新后的权重参数,是两个计算中间值;

[0056]

(1

‑

5)重复步骤1

‑

3到1

‑

4,根据连续n次优化以后损失函数变化小于阈值η,net1网

络收敛;

[0057]

(2)采用k

‑

fold交叉验证策略优化迭代深度神经网络权重;

[0058]

(3)在动态条件下,将双目视觉组件的左摄像头采集的实时视频图像输入深度卷积神经网络net1,对工件所处环境进行实时目标检测,输出目标检测信息;

[0059]

(4)双目视觉组件通过信息传送流程获取所要抓取工件的目标检测信息,利用相关性匹配算法和三角测量原理对双目视觉组件左右两个摄像头采集的图像信息进行处理,计算出工件的空间深度信息;

[0060]

(5)在实时检测的状态下,通过信息传送流程将工件空间深度信息传送到机械臂控制组件,完成对相应工件的实时抓取。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。